平均背景建模法

实验结果分析

3.4.2实验结果分析为验证算法的效果,用本文算法对一些序列进行了测试,并与基于多帧jF均法的算法、基于混合高斯模型的算法以及基于码本模型的算法进行比较。

(1)第一组实验分辨率为352×288的halI序列:图3.8给出了运动目标检测算法的试验结果对比,采用的方法分别是:帧差法、基于多帧平均的背景建模、基于码本的背景建模以及本文提出的背景建模方法。

可见帧差法的效果最差,其获取的目标只有轮廓,而且非常不完整;多帧平均法的结果比帧差法略好,但其内部空洞仍旧比较大,严重时目标出现了断裂的情况;码本算法的结果比较好,其检测到的目标不含有阴影,噪声较少,但也造成了其目标在腿部等细节部分出现断裂的情况。

本文算法提取的目标虽然含有微小噪声,但其提取的目标完整,内部空洞少,而且对于微小的噪声,通过形态学滤波后,能够顺利去除。

藕藏溉藏魔(a一3)50帧(a-4)55 I帧(a)原始序列(f-2)45 I帧(f-3)50帧(1"-4)55帧ff)Jr≥态学处理后的分割结果訇3.8 4种不同方法的检测结果表3.1 halI序4,-0结果检测方法帧差法多帧平均法码本算法本文I平均耗时(ms) 0.8ms 4Ins l 5nls 1 C(2)第二组实验分辨率为768x 576的自拍序列,含有摆动的树叶以及水波:图3.9给出了运动目标检测算法的试验结果对比,采用的方法分别是:基于混合高斯模型的检测方法、基于码本的背景建模以及本文提出的背景建模方法。

可以看出:基于混合高斯模型的检测方法对于抖动的树叶以及水波的抗干扰性差,误将其检测为运动目标;码本算法的结果比较好,其检测到的目标不含有很大的噪声,但其并不能消除全部的干扰,而且其目标在腿部、等细节部分出现了断裂的情况。

相比较而言,本文算法提取的目标虽然含有微小的噪声,但其对于抖动的树叶以及水波能够将其作为背景提取出来,而且其提取的目标完整,内部空洞少,对于微小的噪声,通过形态学滤波后,能够顺利去除。

详细介绍上述背景建模的原理和作用。

详细介绍上述背景建模的原理和作用。

背景建模是图像处理和计算机视觉领域中的一个关键技术,它可以将图像中的前景和背景分离出来,是很多应用的基础,如视频监控、运动检测、基于内容的图像检索等。

在背景建模中,首先需要将一个场景中的静态背景建模出来。

这个过程中需要一系列的框架和算法来进行图像的处理和分析。

最初的背景建模方法可以被理解为几个阶段的连续处理,首先将一个视频序列的每个像素的值当做时间序列数据,然后对于像素序列使用统计方法(如高斯混合模型、均值移动等)对数据建模,并估计出每个像素点的背景模型。

之后,使用更新的算法来调整原有算子,以使得该算法可以跟踪物体的运动轨迹,进而完成功能和目标的跟踪。

背景建模的过程中,需要依靠一些假设和前提。

首先需要假设场景中的物体并不是彻底的静止不动的,背景建模的过程中,我们可以接受在场景中运动的一些物体,但是我们假定背景应该是一个静态的部分。

这个假设是默认成立的。

第二个假设是场景中的物体的底部有部分是与背景相同的,因此,在背景建模中,我们可以将底部设定为接近于背景的部分,然后我们可以在这个基础上对其他的物体进行关注。

通过这么做,背景建模就可以忽略掉底部部分的影响,直接从图像中筛选出目标物体,然后进行进一步的图像分析和处理。

背景建模的作用是将场景中的静态背景和动态前景进行有效的区分和提取,为后续的目标检测、跟踪、分割等任务提供了基础。

通过背景建模技术,我们可以消除光照变化、天气变化等因素对图像的干扰,使得我们对于物体的目标分析更加准确、清晰。

此外,背景建模还可以将场景中的多个目标进行分离,提高了视觉系统的识别能力。

然而,背景建模的精度和效率仍然面临许多挑战。

例如,场景中出现的相似物体容易产生干扰,不稳定的光照和天气变化也会对背景建模的精度造成影响。

因此,未来,需要不断优化和改进背景建模方法和算法,提高背景建模的性能和鲁棒性。

视频检测和运动目标跟踪方法总结

视频检测和运动目标跟踪方法总结目前常用的视频检测方法可分为如下几类:光流法,时域差分法,背景消减法,边缘检测法,运动矢量检测法[2]。

一、光流法光流法[1]是一种以灰度梯度基本不变或亮度恒定的约束假设为基础对运动目标进行检测的有效方法。

光流是指图像中灰度模式运动的速度,它是景物中可见的三维速度矢量在成像平面上的投影,表示了景物表面点在图像中位置的瞬时变化,一般情况下,可以认为光流和运动场没有太大区别,因此就可以根据图像运动来估计相对运动。

优点:光流不仅携带了运动目标的运动信息,而且还携带了有关景物三维结构的丰富信息,它能够检测独立运动的对象,不需要预先知道场景的任何信息,并且能够适用于静止背景和运动背景两种环境。

缺点:当目标与背景图像的对比度太小,或图像存在噪音时,单纯地从图像灰度强度出发来探测目标的光流场方法将会导致很高的虚警率。

且计算复杂耗时,需要特殊的硬件支持。

二、时域差分法时域差分法分为帧差法和改进的三帧双差分法。

1.帧差法帧差法[8]是在图像序列中的相邻帧采用基于像素点的时间差分, 然后阈值化来提取出运动区域。

视频流的场景具有连续性,在环境亮度变化不大的情况下,图像中若没有物体运动,帧差值会很小;反之若有物体运动则会引起显著的差值。

优点:时域相邻帧差法算法简单,易于实现,对背景或者光线的缓慢变化不太敏感,具有较强的适应性,能够快速有效地从背景中检测出运动目标。

缺点:它不能完全提取运动目标所有相关像素点,在运动实体内部不容易产生空洞现象。

而且在运动方向上被拉伸,包含了当前帧中由于运动引起的背景显露部分,这样提取的目标信息并不准确。

2.三帧双差分法三帧双差分法与相邻帧差法基本思想类似,但检测运动目标的判决条件上有所不同。

三帧双差分较两帧差分提取的运动目标位置更为准确。

三、背景消减法背景消减法[4]是将当前帧与背景帧相减,用阈值T判断得到当前时刻图像中偏离背景模型值较大的点,若差值大于T则认为是前景点(目标);反之,认为是背景点,从而完整的分割出目标物体。

背景建模算法

背景建模算法1 基本原理视频图像中运动目标检测的一种方法,其基本思想是对图像的背景进行建模。

一旦背景模型建立,将当前的图像与背景模型进行某种比较,根据比较结果确定前景目标(需要检测的运动目标)。

2 难点(1)环境光照的变化(光照突然性的变化和缓慢的变化)(2)背景的多模态性(背景中存在的细微的运动将影响前景目标检测的结果)(3)运动物体的阴影(4)图像噪声(5)新的不动的物体进入到背景中(如何快速适应背景的变化)3 分类背景建模方法可以分为两类,颜色背景模型和纹理背景模型。

3.1 颜色背景模型颜色背景模型其思想是对图像中每个像素的颜色值(灰度或彩色)进行建模。

如果当前图像坐标(x,y)上的像素颜色值与背景模型中(x,y)上的像素颜色值有较大差异时,当前像素被认为是前景,否则为背景。

颜色背景模型的一个最明显的缺点是对阴影敏感,即将阴影误检测为运动目标。

在特定场合下,需要在检测后对阴影进行抑制和消除。

3.1.1 平均背景模型平均背景模型(Average Background Model)是一种简单、计算速度快但对环境光照变化和背景的多模态性比较敏感的一种背景建模算法。

其基本思想是:计算每个像素的平均值作为它的背景模型。

检测当前帧时,只需要将当前帧像素值I(x,y)减去背景模型中相同位置像素的平均值u(x,y),得到差值d(x,y),将d(x,y)与一个阈值TH进行比较,那么得到输出图像output的值如下:(3-1)(3-2)这里TH可以采用自适应算法进行确定,需要计算每个像素的帧间差的平均值和标准差。

公式如下:令代表t时刻的图像中(x,y)处的像素值,inter代表两帧之间的间隔,通常设置为3,令如下:(3-3)(3-4)(3-5)M通常要足够大(>30+inter)来保证和的精确性。

得到了和后TH可以这样确定:TH = + (3-6)其中一般设置为2。

为了提高算法的鲁棒性,可以在检测完之后要对背景模型进行更新,对于所有像素(x,y),令,,更新后分别为,,:(3-7)(3-8)(3-9)这里为学习率(0~1),越大,对背景变化的适应速度越快。

前景检测算法_1(codebook和平均背景法)

前景检测算法_1(codebook和平均背景法)前景分割中一个非常重要的研究方向就是背景减图法,因为背景减图的方法简单,原理容易被想到,且在智能视频监控领域中,摄像机很多情况下是固定的,且背景也是基本不变或者是缓慢变换的,在这种场合背景减图法的应用驱使了其不少科研人员去研究它。

但是背景减图获得前景图像的方法缺点也很多:比如说光照因素,遮挡因素,动态周期背景,且背景非周期背景,且一般情况下我们考虑的是每个像素点之间独立,这对实际应用留下了很大的隐患。

这一小讲主要是讲简单背景减图法和codebook法。

一、简单背景减图法的工作原理。

在视频对背景进行建模的过程中,每2帧图像之间对应像素点灰度值算出一个误差值,在背景建模时间内算出该像素点的平均值,误差平均值,然后在平均差值的基础上+-误差平均值的常数(这个系数需要手动调整)倍作为背景图像的阈值范围,所以当进行前景检测时,当相应点位置来了一个像素时,如果来的这个像素的每个通道的灰度值都在这个阈值范围内,则认为是背景用0表示,否则认为是前景用255表示。

下面的一个工程是learning opencv一书中作者提供的源代码,关于简单背景减图的代码和注释如下:avg_background.h文件:1//////////////////////////////////////////////////////////////////// ///////////////////////////////////////////////2// Accumulate average and ~std (really absolute difference) image and use this to detect background and foreground3//4// Typical way of using this is to:5// AllocateImages();6////loop for N images to accumulate background differences7// accumulateBackground();8////When done, turn this into our avg and std model with high and low bounds9// createModelsfromStats();10////Then use the function to return background in a mask (255 == foreground, 0 == background)11// backgroundDiff(IplImage *I,IplImage *Imask, int num);12////Then tune the high and low difference from average image background acceptance thresholds13// float scalehigh,scalelow; //Set these, defaults are 7 and 6. Note: scalelow is how many average differences below average14// scaleHigh(scalehigh);15// scaleLow(scalelow);16////That is, change the scale high and low bounds for what should be background to make it work.17////Then continue detecting foreground in the mask image18// backgroundDiff(IplImage *I,IplImage *Imask, int num);19//20//NOTES: num is camera number which varies from 0 ... NUM_CAMERAS - 1. Typically you only have one camera, but this routine allows21// you to index many.22//23 #ifndef AVGSEG_24#define AVGSEG_252627 #include "cv.h"// define all of the opencv classes etc.28 #include "highgui.h"29 #include "cxcore.h"3031//IMPORTANT DEFINES:32#define NUM_CAMERAS 1 //This function can handle an array of cameras33#define HIGH_SCALE_NUM 7.0 //How many average differences from average image on the high side == background34#define LOW_SCALE_NUM 6.0 //How many average differences from average image on the low side == background3536void AllocateImages(IplImage *I);37void DeallocateImages();38void accumulateBackground(IplImage *I, int number=0);39void scaleHigh(float scale = HIGH_SCALE_NUM, int num = 0);40void scaleLow(float scale = LOW_SCALE_NUM, int num = 0);41void createModelsfromStats();42void backgroundDiff(IplImage *I,IplImage *Imask, int num = 0);4344#endifavg_background.cpp文件:1// avg_background.cpp : 定义控制台应用程序的入口点。

客流统计方案--上海汇纳

v1.0 可编辑可修改IPVA客流系统设计方案目录一、企业概况 (3)汇纳简介 (3)分支机构介绍 (3)汇纳团队 (4)汇纳科技现为: (4)二、客流系统设计 (5)系统设计 (5)项目概况 (5)设备配置 (6)三、汇纳客流系统介绍 (7)汇纳客流系统介绍 (7)客流系统工作流程 (8)算法原理 (9)汇纳客流系统组网方式 (10)四、汇纳主要部件产品和品牌 (11)摄像机 (11)嵌入式分析终端 (11)数据/报表服务器 (12)五、汇纳客流系统特点 (13)基本特点 (13)软件系统特点 (17)汇纳客流分析系统优势及特性 (28)汇纳客流系统技术响应 (29)六、我们的客户 (30)一、企业概况汇纳简介上海汇纳网络信息科技有限公司(简称汇纳科技)成立于2004年7月,目前拥有2家子公司,1家分公司,4个业务部,在19个城市设立客户服务部,并在全国范围内拥有30多支工程实施队伍。

汇纳科技主要从事商业、交通、安全、能源等领域信息化产品的研发、生产、销售及增值服务。

汇纳科技自主研发的IPVA智能视频客流分析系统已经在全国(含香港、台湾地区)实施店铺数量超过2000家,实施统计点位数量超过25000个。

是中国最大的商业客流统计分析系统和服务提供商,被誉为行业知名品牌。

目前,汇纳科技正致力于中国商圈客流指数体系和平台的建设和推广工作,并获得国家相关权威机构的合作支持。

汇纳科技是国家高新技术企业,公司成立以来获得了国家及上海市多项科技项目奖励。

截止2011年,公司已获得国家专利十余项和多项著作权。

分支机构介绍1)总公司:上海汇纳网络信息科技有限公司2)子公司(2家)-深圳汇纳科技有限公司-上海汇纳智能控制科技有限公司3)分公司(1家):北京分公司4)业务部(4个):•东北业务部(沈阳)•西北业务部(西安)•西南业务部(成都)•华中业务部(武汉)5)客户服务部(19个):成都、西安、沈阳、呼和浩特、包头、长春、大庆、石家庄、天津、济南、武汉、厦门、泰州、福州、宁波、襄阳、宜昌、重庆、合肥汇纳团队汇纳科技现拥有员工200与人。

人员密度 算法

人员密度算法人员密度算法通常用于计算一个区域内的人数,这在视频监控、人流分析、智能交通等领域有广泛的应用。

以下是一些常见的人员密度算法:1.背景建模和运动检测:背景建模:首先,对于视频中的背景进行建模,得到一个背景图像。

这可以通过采用滑动平均、高斯混合模型等技术来实现。

运动检测:将当前帧与背景图像进行比较,检测出移动的对象(人)。

运动检测算法可以采用帧间差分、光流法等。

2.人脸检测和追踪:使用计算机视觉技术进行人脸检测,可以通过预训练的人脸检测器(如Haar 级联检测器、深度学习模型)来实现。

通过追踪算法,可以在视频序列中跟踪检测到的人脸,从而实现人员密度的计算。

3.深度学习方法:利用深度学习模型,如卷积神经网络(CNN),进行人员密度估计。

这可以通过在大规模数据集上训练模型,使其能够直接估计人员密度。

常见的深度学习模型包括CSRNet、MCNN(Multi-column CNN)等。

4.特征提取和分类:通过提取图像中的特征,如纹理、颜色、形状等,然后使用分类器(如支持向量机、决策树)对图像中的人进行分类。

这种方法的关键是选择有效的特征,以便能够准确地表示人员的存在。

5.全局与局部方法:全局方法考虑整个图像的信息,通过对整体进行建模来估计人员密度。

局部方法关注图像中局部区域的密度,通过分块或网格化的方式进行估计,然后综合得到全局估计。

6.传感器数据融合:结合不同传感器的数据,如视频、红外感应器等,进行综合分析,提高对人员密度的准确性。

实际选择何种算法取决于具体的应用场景、数据的特点以及对准确性和实时性的要求。

深度学习方法在人员密度估计领域取得了显著的成就,但在一些特定场景下,传统的计算机视觉方法仍然是有效的。

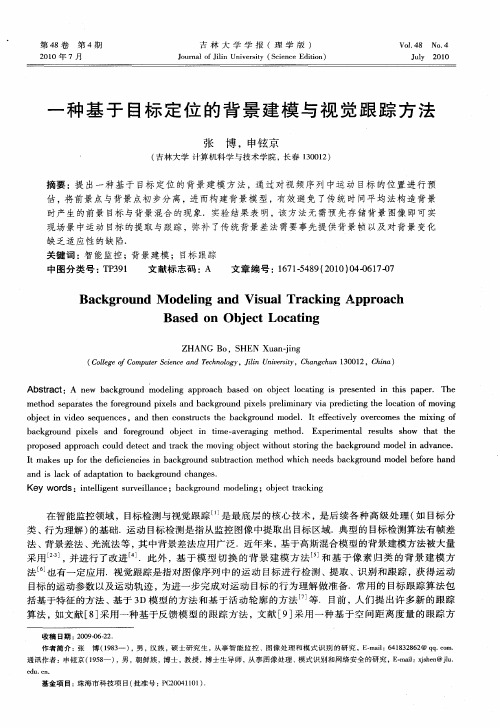

一种基于目标定位的背景建模与视觉跟踪方法

第 4期

吉 林 大 学 学 报 (理 学 版 )

Ju n l f i n U i ri ( ce c d in o ra o l nv s y S in eE io ) Ji e t t

Vo . 8 No. 14 4

21 0 0年 7月

Jl 2 0 uy 01

ojc i ie eu ne , n e o s ut teb c go n o e.I e et e vro e emi n f bet nvdosq e cs a dt ncnt cs h ak ru d m d1 t f ci l o ecm st x go h r f v y h i bc go n ie ad f eru d o jc i t —vrgn eh d E p r na rsl h w ta te ak ru d pxl n o gon bet n i aea ig m to . x ei t eut so ht h s r me me l s

一

种 基 于 目标 定 位 的 背 景 建 模 与 视 觉 跟 踪 方 法

张 博 ,申铉 京

( 吉林大 学 计算机科学 与技术学 院 , 长春 10 1 ) 30 2

摘 要 :提 出一 种 基 于 目标 定 位 的 背景 建 模 方 法 ,通 过 对 视 频 序 列 中运 动 目标 的位 置 进 行 预 估 ,将前 景 点 与背 景 点初 步分 离 ,进 而构 建 背 景模 型 ,有 效 避 免 了传 统 时 间平 均 法构 造 背 景

K ywod :it l e t uv ia c ;b cgo n o eig o jc t c ig e rs ne i n rel n e ak ru d m d l ; bet r kn lg s l n a

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

have one camera, but this routine allows

//

you to index many.

//

#ifndef AVGSEG_

#define AVGSEG_

#include "cv.h" #include "highgui.h" #include "cxcore.h"

// define all of the opencv classes etc.

#endif

// avg_background.cpp : 定义控制台应用程序的入口点。 //

#include "stdafx.h" #include "avg_background.h"

//GLOBALS

IplImage

*IavgF[NUM_CAMERAS],*IdiffF[NUM_CAMERAS],

work.

////Then continue detecting foreground in the mask image

// backgroundDiff(IplImage *I,IplImage *Imask, int num);

//

//NOTES: num is camera number which varies from 0 ... NUM_CAMERAS - 1. Typically you only

*IprevF[NUM_CAMERAS],

*IhiF[NUM_CAMERAS], *IlowF[NUM_CAMERAS];

IplImage *Iscratch,*Iscratch2,*Igray1,*Igray2,*Igray3,*Imaskt;

IplImage

*Ilow1[NUM_CAMERAS],*Ilow2[NUM_CAMERAS],*Ilow3[NUM_CAMERAS],*Ihi1[NUM_CAMERA

Ilow1[i] = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Ilow2[i] = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Ilow3[i] = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Ihi1[i] = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Ihi2[i] = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Ihi3[i] = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); cvZero(IavgF[i] ); cvZero(IdiffF[i] ); cvZero(IprevF[i] ); cvZero(IhiF[i] ); cvZero(IlowF[i] ); Icount[i] = 0.00001; //Protect against divide by zero } Iscratch = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 3 ); Iscratch2 = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 3 ); Igray1 = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Igray2 = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Igray3 = cvCreateImage( cvGetSize(I), IPL_DEPTH_32F, 1 ); Imaskt = cvCreateImage( cvGetSize(I), IPL_DEPTH_8U, 1 );

// Accumulate the background statistics for one more frame

// We accumulate the images, the image differences and the count of images for the

// the routine createModelsfromStats() to work on after we're done accumulating N frames.

background and foreground

//

// Typical way of using this is to:

// AllocateImages();

////loop for N images to accumulate background differences

// accumulateBackground();

//This function can handle an array of cameras //How many average differences from average

//How many average differences from average image on

void AllocateImages(IplImage *I); void DeallocateImages(); void accumulateBackground(IplImage *I, int number=0); void scaleHigh(float scale = HIGH_SCALE_NUM, int num = 0); void scaleLow(float scale = LOW_SCALE_NUM, int num = 0); void createModelsfromStats(); void backgroundDiff(IplImage *I,IplImage *Imask, int num = 0);

// I

Background image, 3 channel, 8u

// number Camera number

void accumulateBackground(IplImage *I, int number)

{

static int first = 1;

cvCvtScale(I,Iscratch,1,0); //To float;#define cvCvtScale cvConvertScale #define cvScale

cvZero(Iscratch); cvZero(Iscratch2 ); }

void DeallocateImages() {

for(int i=0; i<NUM_CAMERAS; i++){ cvReleaseImage(&IavgF[i]); cvReleaseImage(&IdiffF[i] ); cvReleaseImage(&IprevF[i] ); cvReleaseImage(&IhiF[i] ); cvReleaseImage(&IlowF[i] ); cvReleaseImage(&Ilow1[i] ); cvReleaseImage(&Ilow2[i] ); cvReleaseImage(&Ilow3[i] ); cvReleaseImage(&Ihi1[i] ); cvReleaseImage(&Ihi2[i] ); cvReleaseImage(&Ihi3[i] );

avg_background.h 文件:

//////////////////////////////////////////////////////////////////////////////////////////////////////

/////////////

// Accumulate average and ~std (really absolute difference) image and use this to detect

average differences below average

// scaleHigh(scalehigh);

// scaleLow(scalelow);

////That is, change the scale high and low bounds for what should be background to make it

////When done, turn this into our avg and std model with high and low bounds

// createModelsfromStats();

////Then use the function to return background in a mask (255 == foreground, 0 == background)

// backgroundDiff(IplImage *I,IplImage *Imask, int num);

////Then tune the high and low difference from average image background acceptance

thresholds

// float scalehigh,scalelow; //Set these, defaults are 7 and 6. Note: scalelow is how many

cvConvertScale

if (!fiavgF[number]);// 将 2 幅 图 像 相 加 :

IavgF[number]=IavgF[number]+Iscratch,IavgF[]里面装的是时间序列图片的累加