信源的信息熵是概率分布Px

信源熵

I ( y j ) I ( y j | xi ) I ( y j )

19

条件互信息量

条件互信息量: 在给定 zk 的条件下,xi 与 y j 之间的互信

I ( xi ; y j ) 0 后验概率 先验概率,X 与 Y 统计独立

I ( xi ; y j ) 0 后验概率 先验概率:由于信道受到干扰, 信宿收到 y j 后不但未使 xi 的不确定度 减少,反而增大了 xi 的不确定度 两个消息之间的互信息不大于其中任一消息的自信息 I ( xi ; y j ) I ( xi ) I ( x i | y j ) I ( x i )

符号从平均意义上表征信源总体特性的一个量对于特定的信源其熵只有一个1log?niiipxpx????1logniiipxpx????信息熵的物理含义信源输出前表征信源的平均不确定度信源输出后表征信源发出的每个消息所能提供的平均信息量是一个统计量反映了随机变量x的随机性22统计热力学中熵是表示分子混乱程度的一个物理量在孤立系统中进行的自发过程总是沿着熵增加的方向进行它是不可逆的平衡态相应于熵取最大值的状态即熵增加原理香农借用热力学中熵来描述信源的平均不确定度在信息论中有用的信息熵只会减少不会增加所以信息熵也被称为负热熵ijxyxy

2

信源的分类

信源输出以符号形式出现的具体消息,其分类如下: 按发送消息的时间和取值空间的分布 离散信源 单符号离散信源 连续信源 信源发出的 按发出符号之间的关系 消息是离散的、 无记忆信源 有限的或无限可 列的符号,且一 有记忆信源 个符号代表一条 按发送一条消息所需要的符号数 完整的消息 单个符号信源 符号序列信源

三种表达形式等效

log log p( x i y j ) p( x i ) p( y j ) p( y j | x i ) p( y j )

信息论基础——熵

信息论基础——熵

熵、联合熵与条件熵

所以

H(XY) p (x iy j)I(x iy j) p (x iy j)lo p (x ig y j)

i,j

i,j

p(xiyj)lop(g yj)p(xi/yj)

i,j

p (x iy j)lo p (y g j) p (x iy j)lo p (x g i/y j)

说明:

从数学角度: H(P)= pi ·log pi 中的和式满足交换率;

从随机变量的角度:熵只与随机变量的总体统计特性有关。

信息论基础——熵

信息熵的基本性质

一个例子:

P ( x x ) 1 a / 1 3 1 a / 2 6 1 a / 3 2 , P ( y y ) 1 a / 1 6 1 a / 2 2 1 a / 3 3 , P ( z z ) 1 a / 1 3 1 a / 2 2 1 a / 3 6 H(X)H(1,1,1)1.45(B9/iSt ym ) bol 362 H(Y)H(1,1,1)1.45(B9/iSt ym ) lob H (X )H (Y)H (Z) 623 H(Z)H(1,1,1)1.45 (B9/iSt ym ) bol 326

由熵联合熵与条件熵ijijixypxpyxp?jijyxpyp??ijjiyxpiixp???j?jyphxyhyhxy所以?xyh?iyjy?ixix??jjijijjijiyxpyxpyxiyxplogloglogxxppyyppyypp?i????熵联合熵与条件熵ijjjlogjjjypyp?h??logjijijiyxpyxp??yxhy??loglogjijijijijjiyxpyxpypyxp????例例某一二维离散信源某一二维离散信源其发出的符号只与前一个符号有关其发出的符号只与前一个符号有关即可用联合概率xxjj给出它们的关联程度给出它们的关联程度如下表所示如下表所示即可用联合概率pxpxii14194361121031??????????????????iipxpxpxpxiixxjjjjxi??求信源的熵求信源的熵hxhx条件熵条件熵hxhx22xx11和联合熵和联合熵hxhx11xx22

信源熵的名词解释

信源熵的名词解释信源熵(Source Entropy)是信息论中一个重要的概念,用于衡量信息源的不确定性和信息的平均编码长度。

在信息论中,信息可以被看作是从一个信源中获取的,而信源熵用来描述这个信源的不确定性大小。

信源熵的计算方法是根据信源可能产生的符号的概率分布来进行的。

具体来说,如果一个信源有n个可能取值(符号)S1,S2,...,Sn,并且每个符号出现的概率分别为P1,P2,...,Pn,那么信源的熵H(S)可以通过下面的公式计算得出:H(S) = -P1log(P1) - P2log(P2) - ... - Pnlog(Pn)其中,log是以2为底的对数,P1,P2,...,Pn是概率分布。

信源熵的含义是,对于一个不确定性较大的信源,需要更长的编码长度来表示每一个符号,所以熵值越大,说明信息的平均编码长度越长。

相反,当一个信源的不确定性较小,即各个符号出现的概率分布较平均时,信息的平均编码长度较短,熵值较小。

以一个简单的例子来说明信源熵的概念。

假设有一个只有两个符号的信源,分别记为S1和S2,它们出现的概率分别为P1和P2。

如果这两个符号的概率分布相等(即P1 = P2 = 0.5),那么信源的熵就是最大的,因为这两个符号的不确定性相同,需要同样长度的编码来表示它们。

而如果其中一个符号的概率接近于1,另一个符号的概率接近于0,那么信源的熵就是最小的,因为其中一个符号的信息是确定的,只需要很短的编码来表示它。

这个例子可以帮助我们理解信源熵与不确定性之间的关系。

除了信源熵,信息论中还有一个重要的概念是条件熵(Conditional Entropy)。

条件熵是在已知一定的背景条件下,信源的不确定性大小,即在给定前提条件下的平均编码长度。

条件熵可以通过信源和条件之间的联合概率分布来计算,其公式为:H(S|T) = -ΣΣP(s, t)log(P(s|t))其中,P(s, t)表示符号s和条件t联合发生的概率。

信息论与编码期末考试题

信息论与编码期末考试题信息论与编码期末考试题(一)一、判断题.1.当随机变量和相互独立时,条件熵等于信源熵.()2.由于构成同一空间的基底不是唯一的,所以不同的基底或生成矩阵有可能生成同一码集.()3.一般情况下,用变长编码得到的平均码长比定长编码大得多.()4.只要信息传输率大于信道容量,总存在一种信道编译码,可以以所要求的任意小的误差概率实现可靠的通信.()5.各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件.()6.连续信源和离散信源的熵都具有非负性.()7.信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确定性就越小,获得的信息量就越小.8.汉明码是一种线性分组码.()9.率失真函数的最小值是.()10.必然事件和不可能事件的自信息量都是.()二、填空题1、码的检、纠错能力取决于.2、信源编码的目的是;信道编码的目的是.3、把信息组原封不动地搬到码字前位的码就叫做.4、香农信息论中的三大极限定理是、、.5、设信道的输入与输出随机序列分别为和,则成立的条件..6、对于香农-费诺编码、原始香农-费诺编码和哈夫曼编码,编码方法惟一的是.7、某二元信源,其失真矩阵,则该信源的= .三、计算题.1、某信源发送端有2种符号,;接收端有3种符号,转移概率矩阵为.(1)计算接收端的平均不确定度;(2)计算由于噪声产生的不确定度;(3)计算信道容量以及最佳入口分布.2、一阶马尔可夫信源的状态转移图如右图所示,信源的符号集为.(1)求信源平稳后的概率分布;(2)求此信源的熵;(3)近似地认为此信源为无记忆时,符号的概率分布为平稳分布.求近似信源的熵并与进行比较.3、设码符号为,信源空间为试构造一种三元紧致码.4、设二元线性分组码的生成矩阵为.(1)给出该码的一致校验矩阵,写出所有的陪集首和与之相对应的伴随式;(2)若接收矢量,试计算出其对应的伴随式并按照最小距离译码准则试着对其译码.(二)一、填空题1、信源编码的主要目的是,信道编码的主要目的是2、信源的剩余度主要来自两个方面,一是,二是3、三进制信源的最小熵为,最大熵为4、无失真信源编码的平均码长最小理论极限制为5、当时,信源与信道达到匹配。

DSP复习

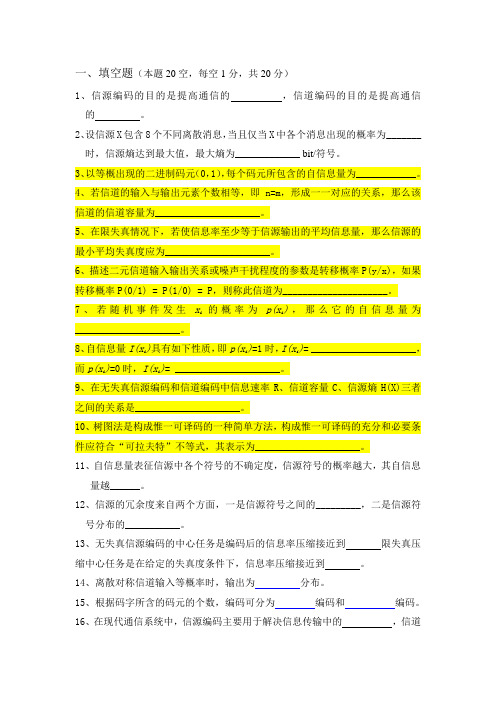

一、填空题(本题20空,每空1分,共20分)1、信源编码的目的是提高通信的,信道编码的目的是提高通信的。

2、设信源X包含8个不同离散消息,当且仅当X中各个消息出现的概率为_______时,信源熵达到最大值,最大熵为_____________ bit/符号。

3、以等概出现的二进制码元(0,1),每个码元所包含的自信息量为____________。

4、若信道的输入与输出元素个数相等,即n=m,形成一一对应的关系,那么该信道的信道容量为_____________________。

5、在限失真情况下,若使信息率至少等于信源输出的平均信息量,那么信源的最小平均失真度应为_____________________。

6、描述二元信道输入输出关系或噪声干扰程度的参数是转移概率P(y/x),如果转移概率P(0/1) = P(1/0) = P,则称此信道为_____________________。

7、若随机事件发生x i的概率为p(x i),那么它的自信息量为_____________________。

8、自信息量I(x i)具有如下性质,即p(x i)=1时,I(x i)= _____________________,而p(x i)=0时,I(x i)= _____________________。

9、在无失真信源编码和信道编码中信息速率R、信道容量C、信源熵H(X)三者之间的关系是_____________________。

10、树图法是构成惟一可译码的一种简单方法,构成惟一可译码的充分和必要条件应符合“可拉夫特”不等式,其表示为_____________________。

11、自信息量表征信源中各个符号的不确定度,信源符号的概率越大,其自信息量越______。

12、信源的冗余度来自两个方面,一是信源符号之间的_________,二是信源符号分布的___________。

13、无失真信源编码的中心任务是编码后的信息率压缩接近到限失真压缩中心任务是在给定的失真度条件下,信息率压缩接近到。

信息熵与概率分布

5

三、方差为固定值的约束条件:

归一化条件: 1 f (x)dx N

方差约束条件: 2 (x )2 f (x)dx

可获得概率分布函数:

f (x)=e10 ek k Fk e e 10 k ( x )2

把该式带入以上两个约束条件, 可求解参数λ0 λk

信息熵与概率分布信息熵信息熵公式信息熵的定义信息熵理论信息熵的计算公式互信息熵信息熵的计算图像信息熵信息熵计算公式

信息熵与概率分布

1

一、信息熵

信息是个很抽象的概念。我们常常说信息很多, 或者信息较少,但却很难说清楚信息到底有多少。

比如一本五十万字的中文书到底有多少信息量。 直到 1948 年,香农提出了“信息熵”(shāng) 的

6

f (x)=e10 ek (x)2

类比

f (x)

1

1( x )2

e2

2

结论: 对于确定的标准差,随机变量可以有很 多分布函数,但是信息熵最大的分布只 可能是正态分布。

7

四、可导出其它分布的约束条件:

归一化是所有分布都要求的。 对数正态分布:变量对数的算数平均值是固定值。

a (ln x) f (x)dx

概念,才解决了对信息的量化度量问题。 信息论 之父 C. E. Shannon 第一次用数学语言阐明了概 率与信息冗余度的关系。 熵的理解非常困难、模糊,可简单理解为系统的 混乱程度。2ຫໍສະໝຸດ 信息熵的定义:H

n i1

pi

ln

pi

离散型

这里: log2 pi 称为第 i 事件的信息量

H f (x) ln f (x)dx 连续型

变量的对数的方差为固定值。

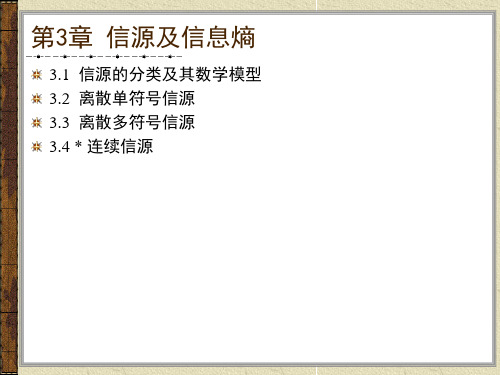

信息论第3章信源及信息熵

举例

数学描述

离散信源 (数字信源)

连续信号

文字、数据、 离散化图象

离散随机变量 序列

跳远比赛的结果、语音 连续随机变量

信号抽样以后

序列

波形信源 (模拟信源)

语音、音乐、热噪声、 图形、图象

不常见

随机过程

表3.1 信源的分类

3.1 信源的分类及其数学模型

我们还可以根据各维随机变量的概率分布是否随时间的推移 而变化将信源分为平稳信源和非平稳信源,根据随机变量间 是否统计独立将信源分为有记忆信源和无记忆信源。

定义3.2 随机变量序列中,对前N个随机变量的联合熵求平

均:

HN

(X)

1 N

H ( X1X 2

XN)

称为平均符号熵。如果当N

时上式极限存在,则

lim

N

H

N

(X)

称为熵率,或称为极限熵,记为

def

H

lim

N

H

N

(

X

)

3.3.1 离散平稳无记忆信源

离散平稳无记忆信源输出的符号序列是平稳随机序列,并且

H(X ) H(X1X2 XN ) H ( X1) H ( X2 | X1) H ( X3 | X1X 2 ) H ( X N | X1X 2 X N1)

定理3.1 对于离散平稳信源,有以下几个结论:

(1)条件熵 H (X N | X1X 2 X N1) 随N的增加是递减的;

(2)N给定时平均符号熵大于等于条件熵,即

s1

si p(s j

| si )

s q

m

状态空间由所有状态及状态间的状态转移概率组成。通过引

入状态转移概率,可以将对马尔可夫信源的研究转化为对马 尔可夫链的研究。

概率分布的熵

概率分布的熵概率分布的熵是信息论中一个重要的概念,用于衡量一个概率分布的不确定性或者信息量的平均值。

在信息论中,熵被定义为概率分布中所有可能事件的信息量的期望值的负数。

熵越大,表示概率分布越不确定,信息量越大。

概率分布的熵在各个领域都有广泛的应用。

在通信领域,熵被用来衡量信息的压缩和传输的效率。

在统计学中,熵被用来评估模型的复杂度和预测的准确性。

在物理学中,熵被用来描述系统的混乱程度和热力学性质。

在信息论中,概率分布的熵由概率分布的概率值计算得出。

对于一个离散的概率分布,熵的计算公式为:H(X) = -∑P(x)log₂P(x)其中,H(X)表示概率分布X的熵,P(x)表示事件x发生的概率,log₂表示以2为底的对数。

概率分布的熵有几个重要的性质。

首先,当概率分布是均匀分布时,熵达到最大值。

这是因为均匀分布中,所有事件发生的概率都是相等的,没有任何一种事件更可能发生,因此概率分布最不确定,熵最大。

其次,当概率分布是确定性分布时,即只有一个事件发生的概率为1,其他事件发生的概率为0时,熵为0。

因为只有一个事件发生,概率分布是确定的,没有不确定性。

概率分布的熵还可以用于比较不同概率分布的不确定性。

如果两个概率分布的熵相等,那么它们具有相同的不确定性。

如果一个概率分布的熵大于另一个概率分布的熵,那么前者比后者更不确定。

因此,熵可以用来量化不同概率分布之间的差异。

在实际应用中,概率分布的熵经常被用来优化问题。

例如,在机器学习中,熵被用来衡量分类模型的纯度。

对于一个分类问题,如果一个模型的熵较大,表示模型的预测结果更不确定,纯度较低。

相反,如果一个模型的熵较小,表示模型的预测结果更确定,纯度较高。

因此,通过最大化或最小化熵,可以得到更好的分类模型。

概率分布的熵是信息论中的一个重要概念,用于衡量概率分布的不确定性或者信息量的平均值。

熵越大,表示概率分布越不确定,信息量越大。

概率分布的熵在通信、统计学和物理学等领域有广泛的应用,可以用来衡量信息的压缩和传输的效率,评估模型的复杂度和预测的准确性,描述系统的混乱程度和热力学性质。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

a2 1/ 6

a3 1/ 2

,

Y P

a1 1/ 6

a2 1/ 2

a3 1/ 3

,

Z P

b1 1/ 3

b2 1/ 2

b3 1/ 6

差别:信源X与Y同一消息的概率不同,X与Z的具体信息不同,但 它们的信息熵相同,表示三个信源总的统计特性相同,它们的信 息数和总体结构是相同的。即:

i 1

j 1

Hn ( p1,, pn ) Hm (q1,, qm )

电子信息工程学院

信息论

2.3 信息熵的基本性质

可加性是熵函数的一个重要特性,正因为具有可加性,所 以可以证明熵函数的形式是唯一的,不可能有其他的形式存 在。

(6)强可加性:H(XY) H(X ) H(Y | X )

当信源消息集的个数q 给定时,信源的信息熵是概率分布 P(x)的函数,概率分布用概率矢量P来表示:

P (P(a1), P(a2 ),, P(aq )) ( p1, p2,, pq )

电子信息工程学院

信息论

2.3 信息熵的基本性质

这样,信息熵 H (X是) 概率矢量P或它的分量 的 q 元1函数

nm

piq j log pi

piq j log q j

i1 j 1

i1 j 1

m

n

n

m

q j ( pi log pi ) pi ( q j log q j )

j 1

i 1

i 1

j 1

n

m

H ( XY ) pi log pi q j log q j

H ( p1, p2,, pq ) H ( p2, p3,, pq , p1) H ( pq , p1,, pq1)

电子信息工程学院

信息论

2.3 信息熵的基本性质

该性质表明:熵只与随机变量的总体结构有关,即与信源的总

体的统计特性有关。

X 如: P

a1 1/ 3

(各分量

p1, p满2,足, pq

q

,所以独Pi立变1量只有

元)。

一般式q可写1 为:

i 1

q

q

H ( X ) P(ai ) logP(ai ) pi lo1, p2,, pq ) H (P)

H (P)是概率矢量P的函数,称为熵函数

该性质是非常明显的,因为随机变量X的所有取值的概率 分布满足0 pi 时 1,熵是正值的,只有当随机变量是确知量 时,其熵等于零。

这种非负性对于离散信源而言是正确的,但对于连续信源 来说这一性质就不一定存在。以后可以看到,在差熵的概 念下,可能出现负值。

电子信息工程学院

信息论

2.3 信息熵的基本性质

pi

log

pi

0

。而其余分量

pi

0(i

j),

lim

p j 0

pj

log

pj

0

该性质说明:信源虽然有不同的输出符号,但只有一个消息几

乎必然出现,而其它符号则是几乎不可能出现,那么这个信源

是确知信源,其熵等于零。

电子信息工程学院

信息论

2.3 信息熵的基本性质

(3)非负性:

q

H (P) H ( p1, p2,, pq ) pi log pi 0 i 1

统计独立信源X和Y的联合信源的熵等于分别的熵之和。

两个随机变量X和Y,相互独立,X概率分布为: ( p1, p2 ,, pn ) , Y的概率分布为 (q1, q2 ,, qm ) 。

n

m

nm

则: pi 1

p j 1

piq j 1

i 1

j 1

i 1 j 1

H(1 , 1 , 1) H(1 , 1 , 1) H(1 , 1 , 1)

362

623

326

电子信息工程学院

信息论

2.3 信息熵的基本性质

(2)确定性:

H1,0 H1,0,0 H1,0,0,0 0

因为在概率矢量 P ( p1, p2,, pq ) 中,当分量 pi 1 时有

根据熵函数表达式有:

电子信息工程学院

信息论

2.3 信息熵的基本性质

H ( XY ) Hnm ( p1q1, p1q2 ,, p1qm , p2q1,, p2qm ,, pnq1,, pnqm )

故:

nm

piq j log piq j

i1 j 1

nm

两个互相关联的信源X和Y的联合信源的熵等于信源X的熵加上 信源X已知条件下信源Y的条件熵。

设两个随机变量X和Y,互相关联,X概率分布为:( p1, p2 ,, pn ) Y的概率分布为 : (q1, q2 ,, qm )

信息论

2.3 信息熵的基本性质

设离散信源X的概率空间为:

X P(

x)

a1, P(a1

),

a2 , P(a2 ),

, ,

aq P(aq

),

,

q i1

P(ai

)

1

信息熵是信源概率空间的一种特殊矩函数,这个函数的大小 与信源的消息数及其概率分布有关。

电子信息工程学院

信息论

2.3 信息熵的基本性质

熵函数也是一种特殊的函数,它的函数形式为:

q

H (P) H ( p1, p2 ,, pq ) pi log pi i 1

它具有下列一些性质。

(1)对称性:当变量 p1, p2,任, p意q 变换时,熵函数的

值不变,即:

(4)扩展性

lim Hq1( p1, p2 ,...,pq , ) Hq ( p1, p2 ,...,pq )

0

因为:

lim

0

Hq1(

p1,

p2 , ,

pq

,

)

q 1

lim {

0 i1

pi

log

pi

( pq

)log(

pq

)

log }

q

pi log pi Hq ( p1, p2, , pq )

i 1

说明:信源的消息数增多时,若这些消息对应的概率很小(接

近于零),则信源的熵不变。

电子信息工程学院

信息论

2.3 信息熵的基本性质

(5)可加性:H(XY) H(X ) H(Y)