粒子群算法(C++版)

粒子群算法以及应用原理

粒子群算法介绍优化问题是工业设计中经常遇到的问题,许多问题最后都可以归结为优化问题. 为了解决各种各样的优化问题,人们提出了许多优化算法,比较著名的有爬山法、遗传算法等.优化问题有两个主要问题:一是要求寻找全局最小点,二是要求有较高的收敛速度. 爬山法精度较高,但是易于陷入局部极小. 遗传算法属于进化算法( Evolutionary Algorithms) 的一种,它通过模仿自然界的选择与遗传的机理来寻找最优解. 遗传算法有三个基本算子:选择、交叉和变异. 但是遗传算法的编程实现比较复杂,首先需要对问题进行编码,找到最优解之后还需要对问题进行解码,另外三个算子的实现也有许多参数,如交叉率和变异率,并且这些参数的选择严重影响解的品质,而目前这些参数的选择大部分是依靠经验.1995 年Eberhart 博士和kennedy 博士提出了一种新的算法;粒子群优化(Partical Swarm Optimization -PSO) 算法 . 这种算法以其实现容易、精度高、收敛快等优点引起了学术界的重视,并且在解决实际问题中展示了其优越性.粒子群优化(Partical Swarm Optimization - PSO) 算法是近年来发展起来的一种新的进化算法( Evolu2tionary Algorithm - EA) .PSO 算法属于进化算法的一种,和遗传算法相似,它也是从随机解出发,通过迭代寻找最优解,它也是通过适应度来评价解的品质. 但是它比遗传算法规则更为简单,它没有遗传算法的“交叉”(Crossover) 和“变异”(Mutation) 操作. 它通过追随当前搜索到的最优值来寻找全局最优 .粒子群算法1. 引言粒子群优化算法(PSO)是一种进化计算技术(evolutionary computation),有Eberhart博士和kennedy博士发明。

源于对鸟群捕食的行为研究PSO同遗传算法类似,是一种基于叠代的优化工具。

粒子群算法

粒子群算法原理及简单案例[ python ]介绍粒子群算法(Particle swarm optimization,PSO)是模拟群体智能所建立起来的一种优化算法,主要用于解决最优化问题(optimization problems)。

1995年由 Eberhart和Kennedy 提出,是基于对鸟群觅食行为的研究和模拟而来的。

假设一群鸟在觅食,在觅食范围内,只在一个地方有食物,所有鸟儿都看不到食物(即不知道食物的具体位置。

当然不知道了,知道了就不用觅食了),但是能闻到食物的味道(即能知道食物距离自己是远是近。

鸟的嗅觉是很灵敏的)。

假设鸟与鸟之间能共享信息(即互相知道每个鸟离食物多远。

这个是人工假定,实际上鸟们肯定不会也不愿意),那么最好的策略就是结合自己离食物最近的位置和鸟群中其他鸟距离食物最近的位置这2个因素综合考虑找到最好的搜索位置。

粒子群算法与《遗传算法》等进化算法有很多相似之处。

也需要初始化种群,计算适应度值,通过进化进行迭代等。

但是与遗传算法不同,它没有交叉,变异等进化操作。

与遗传算法比较,PSO的优势在于很容易编码,需要调整的参数也很少。

一、基本概念与遗传算法类似,PSO也有几个核心概念。

粒子(particle):一只鸟。

类似于遗传算法中的个体。

1.种群(population):一群鸟。

类似于遗传算法中的种群。

2.位置(position):一个粒子(鸟)当前所在的位置。

3.经验(best):一个粒子(鸟)自身曾经离食物最近的位置。

4.速度(velocity ):一个粒子(鸟)飞行的速度。

5.适应度(fitness):一个粒子(鸟)距离食物的远近。

与遗传算法中的适应度类似。

二、粒子群算法的过程可以看出,粒子群算法的过程比遗传算法还要简单。

1)根据问题需要,随机生成粒子,粒子的数量可自行控制。

2)将粒子组成一个种群。

这前2个过程一般合并在一起。

3)计算粒子适应度值。

4)更新种群中每个粒子的位置和速度。

粒子群算法求解最小值

粒子群算法求解最小值

(实用版)

目录

一、粒子群算法概述

二、粒子群算法求解最小值的原理

三、粒子群算法在 MATLAB 中的实现

四、粒子群算法求解最小值的应用实例

五、总结

正文

一、粒子群算法概述

粒子群算法(Particle Swarm Optimization, PSO)是一种基于群体智能的优化算法,于 1995 年由美国社会心理学家 James Kennedy 和电气工程师 Russell Eberhart 共同提出。

该算法的提出是受对鸟类群体行为进行建模与仿真的研究结果的启发。

粒子群优化算法通过个体间的协作与竞争,实现复杂空间最优解的搜索。

将群体中的个体视为 d 维空间中的粒子,该粒子以一定的速度在解空间运动,并向自身历史最优解和全局最优解靠拢。

二、粒子群算法求解最小值的原理

粒子群算法求解最小值主要通过以下步骤实现:

1.初始化粒子群:在解空间中随机分布一定数量的粒子,每个粒子包含四个变量(x, y, z, w),表示粒子在解空间中的位置。

2.评估适应度:根据粒子位置计算目标函数值,得到每个粒子的适应度。

3.更新个体最优解和全局最优解:比较当前粒子的适应度与其历史最

优解的适应度,如果当前适应度更优,则更新个体最优解。

同时,比较全局最优解与当前粒子的适应度,如果当前适应度更优,则更新全局最优解。

4.更新粒子速度和位置:根据个体最优解、全局最优解和当前位置,计算每个粒子的新速度和新位置。

5.检查停止条件:如果达到预设的最大迭代次数或全局最优解的适应度变化小于设定阈值,则停止迭代。

6.返回全局最优解:输出全局最优解及其对应的最小值。

用c语言或matlab语言求解墨西哥草帽函数最小值的粒子群算法程序

用c语言或matlab语言求解墨西哥草帽函数最小值的粒子群算法程序以下是一种用C语言实现的基本粒子群算法程序,用于求解墨西哥草帽函数的最小值。

#include <stdio.h>#include <stdlib.h>#include <math.h>#define SWARM_SIZE 50 // 粒子群规模#define MAX_ITERATION 1000 // 最大迭代次数#define DIMENSION 2 // 问题维度#define INERTIA_WEIGHT 0.7 // 惯性权重#define COGNITIVE_WEIGHT 1.4 // 认知权重#define SOCIAL_WEIGHT 1.4 // 社会权重#define LOWER_BOUND -10.0 // 自变量下界#define UPPER_BOUND 10.0 // 自变量上界void evaluateFitness(double* positions, double* fitness);double mexicanHatFunction(double* x);double randDouble(double min, double max);int randInt(int min, int max);int maindouble swarm[SWARM_SIZE][DIMENSION]; // 粒子群位置double velocity[SWARM_SIZE][DIMENSION]; // 粒子群速度double bestPosition[DIMENSION]; // 全局最优位置double bestFitness = __DBL_MAX__; // 全局最优适应度double fitness[SWARM_SIZE]; // 粒子适应度//初始化粒子群for (int i = 0; i < SWARM_SIZE; i++)for (int j = 0; j < DIMENSION; j++)swarm[i][j] = randDouble(LOWER_BOUND, UPPER_BOUND);velocity[i][j] = 0.0;}evaluateFitness(swarm[i], &fitness[i]);if (fitness[i] < bestFitness)bestFitness = fitness[i];for (int k = 0; k < DIMENSION; k++)bestPosition[k] = swarm[i][k];}}//迭代求解for (int iter = 0; iter < MAX_ITERATION; iter++)for (int i = 0; i < SWARM_SIZE; i++)for (int j = 0; j < DIMENSION; j++)double r1 = randDouble(0.0, 1.0);double r2 = randDouble(0.0, 1.0);velocity[i][j] = INERTIA_WEIGHT * velocity[i][j] + COGNITIVE_WEIGHT * r1 * (bestPosition[j] - swarm[i][j]) + SOCIAL_WEIGHT * r2 * (bestPosition[j] - swarm[i][j]); swarm[i][j] += velocity[i][j];if (swarm[i][j] < LOWER_BOUND)swarm[i][j] = LOWER_BOUND;else if (swarm[i][j] > UPPER_BOUND)swarm[i][j] = UPPER_BOUND;}evaluateFitness(swarm[i], &fitness[i]);if (fitness[i] < bestFitness)bestFitness = fitness[i];for (int k = 0; k < DIMENSION; k++)bestPosition[k] = swarm[i][k];}}}printf("Best position: ");for (int i = 0; i < DIMENSION; i++)printf("%.4f ", bestPosition[i]);printf("\n");printf("Best fitness: %f\n", bestFitness);return 0;void evaluateFitness(double* positions, double* fitness)*fitness = mexicanHatFunction(positions);double mexicanHatFunction(double* x)double result = 0.0;result = -(pow(x[0], 2) + pow(x[1], 2)) + 2 * exp(-(pow(x[0], 2) + pow(x[1], 2)) / 2);return result;double randDouble(double min, double max)return min + ((double)rand( / RAND_MAX) * (max - min);int randInt(int min, int max)return min + rand( % (max - min + 1);这个程序使用经典的粒子群算法来求解墨西哥草帽函数的最小值。

粒子群算法介绍

1.介绍:粒子群算法(Particle Swarm Optimization, PSO)最早是由Eberhart 和Kennedy于1995年提出,它的基本概念源于对鸟群觅食行为的研究。

设想这样一个场景:一群鸟在随机搜寻食物,在这个区域里只有一块食物,所有的鸟都不知道食物在哪里,但是它们知道当前的位置离食物还有多远。

那么找到食物的最优策略是什么呢?最简单有效的就是搜寻目前离食物最近的鸟的周围区域。

经过实践证明:全局版本的粒子群算法收敛速度快,但是容易陷入局部最优。

局部版本的粒子群算法收敛速度慢,但是很难陷入局部最优。

现在的粒子群算法大都在收敛速度与摆脱局部最优这两个方面下功夫。

其实这两个方面是矛盾的。

看如何更好的折中了。

粒子群算法主要分为4个大的分支:(1)标准粒子群算法的变形在这个分支中,主要是对标准粒子群算法的惯性因子、收敛因子(约束因子)、“认知”部分的c1,“社会”部分的c2进行变化与调节,希望获得好的效果。

惯性因子的原始版本是保持不变的,后来有人提出随着算法迭代的进行,惯性因子需要逐渐减小的思想。

算法开始阶段,大的惯性因子可以是算法不容易陷入局部最优,到算法的后期,小的惯性因子可以使收敛速度加快,使收敛更加平稳,不至于出现振荡现象。

经过本人测试,动态的减小惯性因子w,的确可以使算法更加稳定,效果比较好。

但是递减惯性因子采用什么样的方法呢?人们首先想到的是线型递减,这种策略的确很好,但是是不是最优的呢?于是有人对递减的策略作了研究,研究结果指出:线型函数的递减优于凸函数的递减策略,但是凹函数的递减策略又优于线型的递减,经过本人测试,实验结果基本符合这个结论,但是效果不是很明显。

对于收敛因子,经过证明如果收敛因子取0.729,可以确保算法的收敛,但是不能保证算法收敛到全局最优,经过本人测试,取收敛因子为0.729效果较好。

对于社会与认知的系数c2,c1也有人提出:c1先大后小,而c2先小后大的思想,因为在算法运行初期,每个鸟要有大的自己的认知部分而又比较小的社会部分,这个与我们自己一群人找东西的情形比较接近,因为在我们找东西的初期,我们基本依靠自己的知识取寻找,而后来,我们积累的经验越来越丰富,于是大家开始逐渐达成共识(社会知识),这样我们就开始依靠社会知识来寻找东西了。

群体智能与优化算法

群体智能与优化算法群体智能(Swarm Intelligence)是一种模拟自然界群体行为的计算方法,借鉴了群体动物或昆虫在协作中展现出来的智能。

在群体智能中,个体之间相互通信、相互协作,通过简单的规则和局部信息交流来实现整体上的智能行为。

而优化算法则是一类用于解决最优化问题的数学方法,能够在大量搜索空间中找到最优解。

在现代计算领域,群体智能和优化算法常常结合使用,通过模拟自然界群体行为,寻找最佳解决方案。

接下来将分析几种典型的群体智能优化算法。

1. 蚁群算法(Ant Colony Optimization):蚁群算法源于对蚂蚁寻找食物路径行为的模拟。

蚁群算法通过模拟蚁群在环境中的寻找和选择过程,来寻找最优解。

算法中蚂蚁在搜索过程中会释放信息素,其他蚂蚁则根据信息素浓度选择路径,最终形成一条最佳路径。

2. 粒子群算法(Particle Swarm Optimization):粒子群算法源于对鸟群觅食过程的模拟。

在算法中,每个“粒子”代表一个潜在的解,粒子根据自身经验和周围最优解的经验进行位置调整,最终寻找最优解。

3. 遗传算法(Genetic Algorithm):遗传算法源于对生物进化过程的模拟。

通过模拟自然选择、交叉和变异等操作,来搜索最优解。

遗传算法在优化问题中有着广泛的应用,能够在复杂的搜索空间中找到较好的解决方案。

4. 蜂群算法(Artificial Bee Colony Algorithm):蜂群算法源于对蜜蜂群食物搜寻行为的模拟。

在算法中,蜜蜂根据花粉的量和距离选择食物来源,通过不断地试探和挑选来找到最佳解。

总体来说,群体智能与优化算法的结合,提供了一种高效且鲁棒性强的求解方法,特别适用于在大规模、高维度的优化问题中。

通过模拟生物群体的智能行为,这类算法能够在短时间内找到全局最优解或者较好的近似解,应用领域覆盖机器学习、数据挖掘、智能优化等多个领域。

群体智能与优化算法的不断发展,将进一步推动计算领域的发展,为解决实际问题提供更加有效的方法和技术。

粒子群算法粒子群算法简介

粒子群算法(1)----粒子群算法简介二、粒子群算法的具体表述上面罗嗦了半天,那些都是科研工作者写论文的语气,不过,PSO的历史就像上面说的那样。

下面通俗的解释PSO算法。

PSO算法就是模拟一群鸟寻找食物的过程,每个鸟就是PSO中的粒子,也就是我们需要求解问题的可能解,这些鸟在寻找食物的过程中,不停改变自己在空中飞行的位置与速度。

大家也可以观察一下,鸟群在寻找食物的过程中,开始鸟群比较分散,逐渐这些鸟就会聚成一群,这个群忽高忽低、忽左忽右,直到最后找到食物。

这个过程我们转化为一个数学问题。

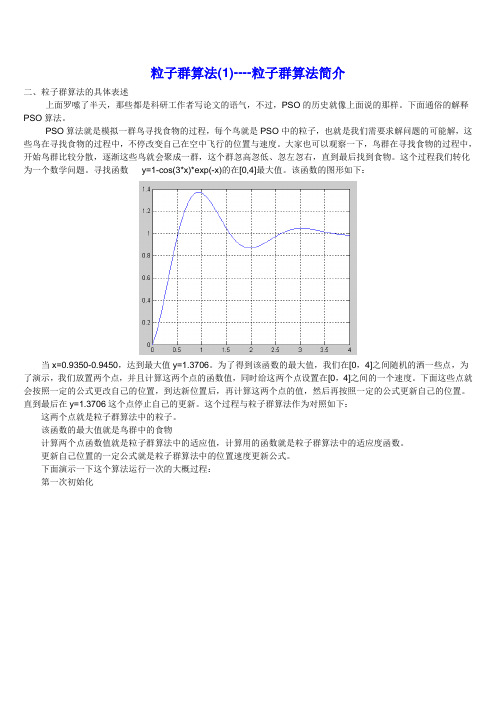

寻找函数y=1-cos(3*x)*exp(-x)的在[0,4]最大值。

该函数的图形如下:当x=0.9350-0.9450,达到最大值y=1.3706。

为了得到该函数的最大值,我们在[0,4]之间随机的洒一些点,为了演示,我们放置两个点,并且计算这两个点的函数值,同时给这两个点设置在[0,4]之间的一个速度。

下面这些点就会按照一定的公式更改自己的位置,到达新位置后,再计算这两个点的值,然后再按照一定的公式更新自己的位置。

直到最后在y=1.3706这个点停止自己的更新。

这个过程与粒子群算法作为对照如下:这两个点就是粒子群算法中的粒子。

该函数的最大值就是鸟群中的食物计算两个点函数值就是粒子群算法中的适应值,计算用的函数就是粒子群算法中的适应度函数。

更新自己位置的一定公式就是粒子群算法中的位置速度更新公式。

下面演示一下这个算法运行一次的大概过程:第一次初始化第一次更新位置第二次更新位置第21次更新最后的结果(30次迭代)最后所有的点都集中在最大值的地方。

粒子群算法(2)----标准的粒子群算法在上一节的叙述中,唯一没有给大家介绍的就是函数的这些随机的点(粒子)是如何运动的,只是说按照一定的公式更新。

这个公式就是粒子群算法中的位置速度更新公式。

下面就介绍这个公式是什么。

在上一节中我们求取函数y=1-cos(3*x)*exp(-x)的在[0,4]最大值。

多目标最优化的粒子群算法

多目标最优化的粒子群算法多目标最优化问题是指在一个问题中同时优化多个目标函数,这些目标函数通常是相互冲突的,无法通过改变一个目标而不影响其他目标。

粒子群优化算法(Particle Swarm Optimization, PSO)是一种基于群体智能的优化算法,它受到鸟群觅食行为的启发,通过模拟鸟群中的个体在解空间中的和信息交流来寻找问题的最优解。

在多目标最优化问题中,粒子群优化算法也可以被扩展为多目标优化版本,即多目标粒子群优化算法(Multi-Objective Particle Swarm Optimization, MOPSO)。

多目标粒子群优化算法的核心思想是利用非支配排序将种群中的个体划分为多个不同的前沿(Pareto Front),每个前沿上的解都是最优解的候选。

根据个体之间的支配关系和拥挤度,确定前沿上的个体,并通过粒子群算法进行和优化。

为了保持种群的多样性,采用了一个外部存档来存储过去迭代中的非支配解,以避免陷入局部最优。

多目标粒子群优化算法的步骤如下:1.初始化种群:设定种群规模、粒子的初始位置和速度,以及其他算法参数。

2.非支配排序:根据个体之间的支配关系对种群中的解进行排序。

3.拥挤度计算:计算种群中个体的拥挤度,通过衡量个体周围解的密度来保持前沿上的均匀分布。

4.外部存档更新:根据非支配排序和拥挤度计算结果,更新外部存档中的非支配解。

5.速度和位置更新:根据粒子群算法的速度和位置更新规则,更新每个粒子的速度和位置。

6.达到停止条件:判断是否满足停止条件,如达到最大迭代次数或找到满意的近似解。

7.重复步骤2至6,直到满足停止条件。

多目标粒子群优化算法相比单目标版本有以下几个特点:1.非支配排序:非支配排序用于划分种群中的解为多个前沿。

支配关系的判断通常使用帕累托支配方法。

2.拥挤度计算:拥挤度计算用于保持前沿上的均匀分布,避免解集中在其中一区域。

3.外部存档更新:外部存档用于存储过去迭代中的非支配解,保证多样性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

//#pragma comment (linker, "/STACK:16777216")

//HEAD

#include <cstdio>

#include <ctime>

#include <cstdlib>

#include <cstring>

}

getFitness();

UpdateVal();

}

}

void solve()

{

init();

evolution();

printf("answer %lf:\n", vPgd);

printf("solution \n");

for (int i = 0; i < cityNum; i++)

{

if (i) printf(" ");

{

int j = 0;

double vj = fitness[0];

for (int i = 0; i < scale; i++)

{

if (vPd[i] > fitness[i])

{

vPd[i] = fitness[i];

copyArray(Pd[i], oPop[i], cityNum);///???

copyArray(Pd[i], oPop[i], cityNum);

}

bestNum = 0;

vPgd = fitness[0];

bestGen = 0;

for (int i = 0; i < scale; i++) if (vPgd > fitness[i])

{

vPgd = fitness[i];

}

if (vj > fitness[i])

{

vj = fitness[i];

j = i;

}

}

if (vj < vPgd)

{

bestGen = nowGen;///

bestNum = j;///

vPgd = vj;

copyArray(Pgd, oPop[j], cityNum);

}

}

void changeTo(int a[], vector<SO> v)///

{

int cn = pv.size();

for (int i = 0; i < cn; i++)

for (int j = i + 1; j < cn; j++)

{

d[i][j] = d[j][i] = getDist(pv[i], pv[j]);

}

}

int main ()

{

srand((unsigned long)time(0)); ///设置时间种子

vector<SO> v;

v.clear();

int lvn = w * listV[is].size();

addTo(v, listV[is], lvn);

vector<SO> a = minus(Pd[is], oPop[is]);

int an = randomD() * a.size();

addTo(v, a, an);

{

int vn = v.size();

for (int i = 0; i < vn; i++)

{

int x = v[i].x, y = v[i].y;

swap(a[x], a[y]);

}

}

vector<SO> minus(int a[], int b[])///

{

int c[MAX_CITY], d[MAX_CITY];

#include <cstdlib>

using namespace std;

typedef long long LL;

const double MAX_VAL = (double)1e18;

const int MAX_GEN = 30;///最大迭代次数

const int MAX_SCALE = 3000;///最大种群规模

inline double getDist(Point a, Point b)

{

return sqrt((a.x - b.x) * (a.x - b.x) + (a.y - b.y) * (a.y - b.y));

}

struct PSO{

double w;

int scale;

int cityNum;

{

s.x = i, s.y = c[a[i]];

swap(d[s.x], d[s.y]);

v.push_back(s);

}

}

return v;

}

void addTo(vector<SO> &v, vector<SO> a, int vn)

{

for (int i = 0; i < vn; i++)

v.push_back(a[i]);

for (int i = 0; i < cityNum; i++) d[i] = b[i];

for (int i = 0; i < cityNum; i++) c[a[i]] = i;

vector<SO> v;

SO s;

for (int i = 0; i < cityNum; i++)

{

if (d[i] != a[i])

SO so(x, y);

listV[i].push_back(so);

// cout << so.x << "*" << so.y << ' ';

}

// cout <<endl;

}

getFitness();

for (int i = 0; i < scale; i++)

{

vPd[i] = fitness[i];

vector<SO> listV[MAX_SCALE];///每科粒子的初始交换序列

int Pd[MAX_SCALE][MAX_CITY];///一颗粒子历代中出现最好的解,

double vPd[MAX_SCALE];///解的评价值

int Pgd[MAX_CITY];///整个粒子群经历过的的最好的解,每个粒子都能记住自己搜索到的最好解

printf("%d\n", Pgd[i]);

}

cout << bestGen << ' ' << bestNum << endl;

puts("");

}

};

int cn;

vector<Point> pv;

double d[MAX_CITY][MAX_CITY];

void pre(vector<Point> pv)

for (int j = 0; j < cityNum; j++)

dist[i][j] = d[i][j];

}

void copyArray(double a[], double b[], int n)

{

for (int i = 0; i < n; i++) a[i] = b[i];

}

void copyArray(int a[], int b[], int n)

{

// cout << i << " :" << endl;

int vn = randomI(cityNum) + 1;

for (int j = 0; j < vn; j++)

{

int x = randomI(cityNum);

int y = randomI(cityNum);

while (x == y) y = randomI(cityNum);

while (cin >> cn)

{

pv.clear();

for (int i = 0; i < cn; i++)

{

Point p;

p.read();

pv.push_back(p);

}

pre(pv);

PSO solver(MAX_SCALE, cn, MAX_GEN, W_VAL, d);

cout << "***************************************************" << endl;

vector<SO> b = minus(Pgd, oPop[is]);

int bn = randomD() * b.size();

addTo(v, b, bn);

listV[is] = v;changeTo(oPo源自[is], listV[is]);

// cout << listV[is].size() << endl;

#include <queue>

#include <string>