半监督学习综述

掌握机器学习中的半监督学习原理

掌握机器学习中的半监督学习原理半监督学习是机器学习领域中的一个重要分支,它主要关注的是在有限标记样本的情况下,利用未标记样本进行模型训练。

相比于传统的监督学习和无监督学习,半监督学习更加贴近现实场景,并且可以在数据稀缺或者成本高昂的情况下得到更好的效果。

本文将从半监督学习的原理入手,介绍其在机器学习中的重要性和应用。

一、半监督学习原理1.1半监督学习简介半监督学习是介于监督学习和无监督学习之间的一种学习方式。

在监督学习中,我们通常会有大量的标记样本来训练模型,而在无监督学习中,我们只能利用未标记样本来学习数据的分布和结构。

而半监督学习则是在有限标记样本的情况下,通过未标记样本的信息来提高模型的准确性和泛化能力。

1.2半监督学习原理半监督学习的原理主要有两个方面:一是通过利用未标记样本提高模型的泛化能力,二是通过利用半监督学习算法来挖掘未标记样本中的信息。

在半监督学习中,我们通常会将未标记样本利用到模型训练中,以提高模型对未知数据的适应能力。

1.3半监督学习的关键问题在实际应用中,半监督学习面临的主要问题是如何有效地利用未标记样本来提高模型的性能。

这主要包括如何选择合适的半监督学习算法和如何有效地利用未标记样本的信息。

同时,还需要解决标记样本和未标记样本之间的偏差问题,确保模型能够在未知数据上取得良好的泛化能力。

二、半监督学习的应用2.1图像识别在图像识别领域,标记样本往往难以获得,因此半监督学习可以大幅提高模型的性能。

通过利用未标记样本中的信息,可以提高模型对未知图像的识别能力,从而在实际应用中取得更好的效果。

2.2文本分类在文本分类领域,大规模标记文本的获取成本很高,因此半监督学习可以通过利用未标记文本中的信息来提高模型的性能。

例如,可以利用未标记文本中的语义信息来学习词向量或者句子表示,从而提高模型对文本的分类准确性。

2.3异常检测在异常检测领域,未标记样本往往占据绝大部分,因此半监督学习可以通过挖掘未标记样本中的信息来提高模型的性能。

计算机视觉中的半监督学习方法研究综述

计算机视觉中的半监督学习方法研究综述计算机视觉是人工智能领域中一个重要的研究方向,旨在使计算机能够获取、处理和理解数字图像或视频。

在计算机视觉中,数据标注是一个耗时且昂贵的过程。

为了解决这个问题,学者们提出了半监督学习方法,利用部分标注的数据和大量未标注的数据来训练模型。

本文将对计算机视觉中的半监督学习方法进行综述,介绍最新研究进展、关键思想和应用领域。

一、半监督学习方法的基本原理半监督学习是介于监督学习和无监督学习之间的一种学习方法。

在计算机视觉中,传统的监督学习方法通常需要大量标注的数据,在实际场景中很难得到。

而无监督学习方法则没有使用任何标注数据进行训练,其性能通常不如监督学习方法。

半监督学习方法的核心思想是结合部分标注的数据和大量未标注的数据,通过学习模型的分布特性,提高模型的泛化能力和性能。

常用的半监督学习方法包括自训练、半监督支持向量机、图半监督学习等。

这些方法通过利用标注数据的信息和未标注数据的分布特性来优化模型的训练过程。

二、半监督学习方法的应用领域半监督学习方法在计算机视觉领域有着广泛的应用。

以下是一些常见的应用领域:1. 图像分类:半监督学习方法可以通过利用未标注数据的特征分布来提高图像分类的准确性。

通过学习图像的分布特性,模型可以更好地进行分类。

2. 目标检测:在目标检测中,半监督学习方法可以利用未标注数据的空间分布特征,辅助模型进行目标的定位和识别。

3. 图像分割:半监督学习方法可以利用未标注数据的像素分布特性,辅助模型进行图像分割任务。

4. 行为识别:在视频行为识别任务中,半监督学习方法可以利用未标注视频的空间和时间分布特性,提高模型对行为识别的准确性。

三、计算机视觉中的半监督学习方法研究进展目前,计算机视觉领域对半监督学习方法的研究已取得了一系列重要的进展。

以下是一些主要研究方向:1. 核方法:核方法可以将半监督学习问题转化为无监督学习问题来解决。

通过合理选择核函数,可以将高维数据映射到特征空间中进行优化。

有监督、无监督与半监督学习【总结】

有监督、⽆监督与半监督学习【总结】概念有监督学习:训练数据既有特征(feature)⼜有标签(label),通过训练,让机器可以⾃⼰找到特征和标签之间的联系,在⾯对只有特征没有标签的数据时,可以判断出标签。

⽆监督学习(unsupervised learning):训练样本的标记信息未知,⽬标是通过对⽆标记训练样本的学习来揭⽰数据的内在性质及规律,为进⼀步的数据分析提供基础,此类学习任务中研究最多、应⽤最⼴的是"聚类" (clustering),其他⽆监督算法还有:密度估计(densityestimation)、异常检测(anomaly detection) 等。

半监督学习:训练集同时包含有标记样本数据和未标记样本数据,不需要⼈⼯⼲预,让学习器不依赖外界交互、⾃动地利⽤未标记样本来提升学习性能,就是半监督学习。

主动学习:有的时候,有类标的数据⽐较稀少⽽没有类标的数据很多,但是对数据进⾏⼈⼯标注⼜⾮常昂贵,这时候,学习算法可以主动地提出⼀些标注请求,将⼀些经过筛选的数据提交给专家进⾏标注,这个筛选过程也就是主动学习主要研究的地⽅了。

注:半监督学习与主动学习属于利⽤未标记数据的学习技术,只是其基本思想不同。

内容1、监督学习监督学习从训练数据集合中训练模型,再对测试据进⾏预测,训练数据由输⼊和输出对组成,通常表⽰为:测试数据也由相应的输⼊输出对组成。

输⼊变量与输出变量均为连续的变量的预测问题称为回归问题,输出变量为有限个离散变量的预测问题称为分类问题,输⼊变量与输出变量均为变量序列的预测问题称为标注问题。

监督算法常见的有:线性回归,神经⽹络,决策树,⽀持向量机,KNN等。

2、⽆监督学习聚类聚类试图将数据集中的样本划分为若⼲个通常是不相交的⼦集,每个⼦集称为⼀个"簇" (cluster).。

通过这样的划分,每个簇可能对应于⼀些潜在的概念(类别) ,这些概念对聚类算法⽽⾔事先是未知的,聚类过程仅能⾃动形成簇结构,簇所对应的概念语义需由使⽤者来把握和命名。

半监督学习——精选推荐

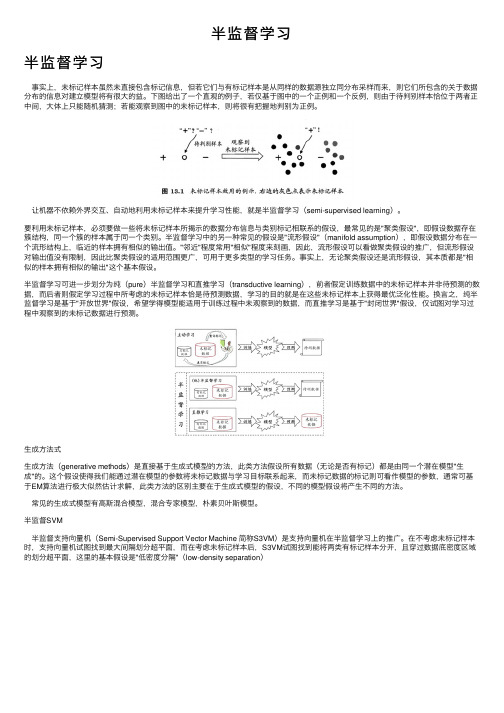

半监督学习半监督学习事实上,未标记样本虽然未直接包含标记信息,但若它们与有标记样本是从同样的数据源独⽴同分布采样⽽来,则它们所包含的关于数据分布的信息对建⽴模型将有很⼤的益。

下图给出了⼀个直观的例⼦,若仅基于图中的⼀个正例和⼀个反例,则由于待判别样本恰位于两者正中间,⼤体上只能随机猜测;若能观察到图中的未标记样本,则将很有把握地判别为正例。

让机器不依赖外界交互、⾃动地利⽤未标记样本来提升学习性能,就是半监督学习(semi-supervised learning)。

要利⽤未标记样本,必须要做⼀些将未标记样本所揭⽰的数据分布信息与类别标记相联系的假设,最常见的是"聚类假设",即假设数据存在簇结构,同⼀个簇的样本属于同⼀个类别。

半监督学习中的另⼀种常见的假设是"流形假设"(manifold assumption),即假设数据分布在⼀个流形结构上,临近的样本拥有相似的输出值。

"邻近"程度常⽤"相似"程度来刻画,因此,流形假设可以看做聚类假设的推⼴,但流形假设对输出值没有限制,因此⽐聚类假设的适⽤范围更⼴,可⽤于更多类型的学习任务。

事实上,⽆论聚类假设还是流形假设,其本质都是"相似的样本拥有相似的输出"这个基本假设。

半监督学习可进⼀步划分为纯(pure)半监督学习和直推学习(transductive learning),前者假定训练数据中的未标记样本并⾮待预测的数据,⽽后者则假定学习过程中所考虑的未标记样本恰是待预测数据,学习的⽬的就是在这些未标记样本上获得最优泛化性能。

换⾔之,纯半监督学习是基于"开放世界"假设,希望学得模型能适⽤于训练过程中未观察到的数据,⽽直推学习是基于"封闭世界"假设,仅试图对学习过程中观察到的未标记数据进⾏预测。

⽣成⽅法式⽣成⽅法(generative methods)是直接基于⽣成式模型的⽅法,此类⽅法假设所有数据(⽆论是否有标记)都是由同⼀个潜在模型"⽣成"的。

深度学习中的半监督学习算法研究

深度学习中的半监督学习算法研究随着人工智能的兴起,深度学习已成为研究热点之一。

与传统的监督学习相比,半监督学习可以利用少量的标记数据和丰富的非标记数据进行训练,从而取得更好的表现。

在深度学习中,半监督学习算法研究也引起了研究者的广泛关注。

一、半监督学习概览半监督学习是介于监督学习和无监督学习之间的学习方式。

在半监督学习中,只有少量的数据是带有标记的,而大部分数据是不带标记的。

半监督学习的目标是通过利用标记数据和非标记数据来解决监督学习和无监督学习中的问题。

在传统的监督学习中,需要用到大量的标记数据来训练模型。

但是,标记数据的获取成本通常较高,并且在某些领域中可能很难获得足够的标记数据。

与之相反,在无监督学习中,不需要使用标记数据,但是由于数据缺乏标记,所以无法准确地区分不同类别的数据。

因此,半监督学习提供了一种有效的方法来解决这些问题。

半监督学习可以利用少量的标记数据来增强模型的表现,同时利用丰富的非标记数据来提高数据的覆盖率和多样性。

二、半监督学习的应用半监督学习广泛应用于图像分类、文本分类、语音识别和异常检测等领域。

下面将从图像分类、文本分类和语音识别三个方面来介绍半监督学习的应用。

1. 图像分类图像分类是计算机视觉中的重要应用之一。

通过半监督学习,可以利用大量未标记的图像来增强模型的表现。

一些经典的半监督图像分类方法包括自动化标注、图像生成和图像迁移学习等。

自动化标注是一种基于标记的半监督图像分类方法。

它利用大量的未标记图像和少量的标记图像来生成新的标记数据,从而提高模型的分类性能。

图像生成是一种基于生成模型的半监督图像分类方法。

它利用少量的标记数据和大量的未标记数据来训练生成模型,然后通过生成模型来生成新的标记数据,从而提高模型的分类性能。

图像迁移学习是一种基于迁移学习的半监督图像分类方法。

它从已有的不同数据集中学习到一些通用的特征,然后将这些特征应用于新的未标记的数据集中,从而提高模型的分类性能。

半监督学习算法的综述

半监督学习算法的综述半监督学习是一种介于有监督学习和无监督学习之间的学习方式,兼具有监督学习的准确性和无监督学习的灵活性。

相对于有监督学习需要大量标记数据和无监督学习需要复杂的聚类或分类算法,半监督学习可以在少量标记数据的情况下,同时结合无监督学习算法,使得模型拟合效果更好,适用范围更广。

现实应用中,标记数据不仅数量有限,而且经常会存在噪声和不准确性,此时半监督学习能够利用未标记数据和有标记数据的关系优化模型,在数据稀缺和复杂的情况下,半监督学习具有重要的应用价值。

下面对半监督学习的一些常见算法进行综述:1. 图半监督学习图半监督学习是半监督学习中较为常用的方法之一。

该方法将数据看作图中的节点,通过连接节点的边表示节点之间的关系,然后通过有标记数据作为种子节点,将图中所有节点分为已标记节点和未标记节点,并寻找未标记节点与已标记节点之间的关系,在此基础上通过传播算法将标签传递给未标记节点,最终得到整个图的标签。

2. 深度半监督学习在深度学习领域中,深度半监督学习是一种比较新兴的方法,该方法利用神经网络模型对未标记数据进行预测,同时利用有标记数据对模型进行微调,从而达到半监督学习的目的。

深度半监督学习可以应用在图像识别、文本分类等领域,是一个非常有效的学习方式。

3. 半监督聚类聚类是无监督学习领域中的常见算法,而半监督聚类则是将有标记数据和未标记数据进行组合,进行聚类得到的结果更加准确和鲁棒。

半监督聚类主要应用在图像分割、文本聚类等领域,能够有效利用未标记数据提升聚类的准确性和鲁棒性。

总的来说,半监督学习通过结合有监督和无监督学习的方法,能够提高模型的拟合效果和应用范围,具有重要的应用价值。

未来,半监督学习算法的研究将会越来越深入,在更多的领域得到广泛的应用。

半监督学习概论

当前半监督学习面临的问题

第一, 半监督学习分类算法的现实价值 半监督学习从诞生以来,主要用于处理人工合成数据、只在实验室试 用,还没办法在某个现实领域得到应用,也就是说,其现实意义没体 现出来;因此,半监督学习的实际应用价值问题值得更多的研究。 第二,新假设的提出 文中前面叙述到的各种半监督分类算法的假设,提出新的模型假设可 能会改进半监督分类算法。 所以对半监督学习分类算法的模型假设的 研究将是十分有价值的。 第三,半监督学习的抗干扰性比较弱 无噪声干扰的样本数据是当前大部分半监督学习方法使用的数据,而 在实际生活中用到的数据却大部分不是无干扰的 ,通常都比较难以得 到纯样本数据。 上面谈论的三个基本假设显然是有效的,不过过于简 约,这些假设没能把噪声干扰下未标记样本数据分布的不确定性以及 它的复杂性充分的考虑全。

半监督学习的常用算法

半监督学习算法按照不同的模型假设,可以大致将现有

的半监督学习算法分为五类: 自学习(Self-training) 基于生成模型的方法(EM with generative mixture models) 协同训练(Co-training) 直推式支持向量机 (Transductive Support Vector Machines) 基于图的方法(Graph-based methods)

直推式支持向量机

定义: 直推式支持向量机(TSVM)是标准型支持向量算法 在未标记样本上的一种推广。对于二分类问题而言, 标准SVM是利用已标记的数据在样本空间中寻找一个 最优超平面,使两类样本间的分类间隔最大;TSVM 则同时利用标记和未标记的样本来寻找最优分类边界, 来得到原始数据中两类样本的最大分类间隔。 直推式方法是一种非参数的方法,不同于基于生 成模型的参数方法,其对初始分类器的优化过程只与 上一次拟合时已标记样本在特征空间中的位置有关。

半监督深度学习图像分类方法研究综述

半监督深度学习图像分类方法研究综述吕昊远+,俞璐,周星宇,邓祥陆军工程大学通信工程学院,南京210007+通信作者E-mail:*******************摘要:作为人工智能领域近十年来最受关注的技术之一,深度学习在诸多应用中取得了优异的效果,但目前的学习策略严重依赖大量的有标记数据。

在许多实际问题中,获得众多有标记的训练数据并不可行,因此加大了模型的训练难度,但容易获得大量无标记的数据。

半监督学习充分利用无标记数据,提供了在有限标记数据条件下提高模型性能的解决思路和有效方法,在图像分类任务中达到了很高的识别精准度。

首先对于半监督学习进行概述,然后介绍了分类算法中常用的基本思想,重点对近年来基于半监督深度学习框架的图像分类方法,包括多视图训练、一致性正则、多样混合和半监督生成对抗网络进行全面的综述,总结多种方法共有的技术,分析比较不同方法的实验效果差异,最后思考当前存在的问题并展望未来可行的研究方向。

关键词:半监督深度学习;多视图训练;一致性正则;多样混合;半监督生成对抗网络文献标志码:A中图分类号:TP391.4Review of Semi-supervised Deep Learning Image Classification MethodsLYU Haoyuan +,YU Lu,ZHOU Xingyu,DENG XiangCollege of Communication Engineering,Army Engineering University of PLA,Nanjing 210007,ChinaAbstract:As one of the most concerned technologies in the field of artificial intelligence in recent ten years,deep learning has achieved excellent results in many applications,but the current learning strategies rely heavily on a large number of labeled data.In many practical problems,it is not feasible to obtain a large number of labeled training data,so it increases the training difficulty of the model.But it is easy to obtain a large number of unlabeled data.Semi-supervised learning makes full use of unlabeled data,provides solutions and effective methods to improve the performance of the model under the condition of limited labeled data,and achieves high recognition accuracy in the task of image classification.This paper first gives an overview of semi-supervised learning,and then introduces the basic ideas commonly used in classification algorithms.It focuses on the comprehensive review of image classification methods based on semi-supervised deep learning framework in recent years,including multi-view training,consistency regularization,diversity mixing and semi-supervised generative adversarial networks.It summarizes the common technologies of various methods,analyzes and compares the differences of experimental results of different methods.Finally,this paper thinks about the existing problems and looks forward to the feasible research direction in the future.Key words:semi-supervised deep learning;multi-view training;consistency regularization;diversity mixing;semi-supervised generative adversarial networks计算机科学与探索1673-9418/2021/15(06)-1038-11doi:10.3778/j.issn.1673-9418.2011020基金项目:国家自然科学基金(61702543)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Figure: An example of unidentifiable models. Even if we known p(x) (top) is a mixture of two uniform distributions, we cannot uniquely identify the two components. For instance, the mixtures on the second and third line give the same p(x), but they classify x = 0.5 differently.

2 自训练(Self-training)

定义:首先利用已标记的样本训练分类器,然后利 用已有未标记训练样本建立的模型标记,使用分类 器选出置信度高的样本加入训练集中重新训练,迭 代这个过程,得到一个比较理想的分类器。 适用:用监督学习分类器时很复杂或者是很难修正 优点:简单 、容易实现 。 缺点:误差也同时会自我迭代放大。

一般认为,半监督学习的研究始于B. Shahshahani和D. Landgrebe的 工作,最早是在这篇文章当中提到的。

B. Shahshahani, D. Landgrebe. The effect of unlabeled samples in reducing the small sample size problem and mitigating the hughes phenomenon. IEEE Transactions on Geoscience and Remote Sensing, 1994, 32(5): 1087-1095.

优点:算法构思很简单,并且在数学上有很严格的理论基础 缺点:计算量过大,对生成模型的依赖较大。

返回

12

Figure: If the model is wrong, higher likelihood may lead to lower classification accuracy. For example, (a) is clearly not generated from two Gaussian. If we insist that each class is a single Gaussian, (b) will have higher probability than (c). But (b) has around 50% accuracy, while (c) is much better.

优点:考虑无标签样本对分类器的影响,并且结合SVM算法实现的一 种高效的分类算法。

适用:能够用SVM的地方,自然想到用转导支持向量机能够获得更好 的效果 缺点:时间复杂度比较高,需要预先设置正负比例等的不足。

返回

20ຫໍສະໝຸດ 5 基于图的方法

定义:通过相似度度量将标记和未标记数据放在联 系起来的图当中。实际当中,很多基于图的方法就 是基于图估计一个函数 f 这个函数需满足下面两个 前提假设。 对于已标记样本点 , f 尽可能的接近标记 yL ,表 为在损失函数(loss function)的选择。 在整个图上函数要比较平缓,表现为正交器 regularizer。 适用:具有相似特征的点往往被分在同一类当中

2

半监督学习的过程

4

半监督学习背景

传统机器学习算法需要利用大量有标记的样本进行 学习。 随着信息技术的飞速发展,收集大量未标记的 (unlabeled)样本已相当容易,而获取大量有标记的示 例则相对较为困难,因为获得这些标记可能需要耗费大 量的人力物力。 如何利用大量的未标记样本来改善学习性能成为当 前机器学习研究中备受关注的问题。 优点:半监督学习(Semi-supervised Learning)能够充 分利用大量的未标记样本来改善学习机的性能,是目前 利用未标记样本进行学习的主流技术。

返回

15

3 协同训练(Co-training)

背景:最早是1998年由A.Blum和T.Mitchell在Combining labeled and unlabeled data with co-training. In: Proceedings of the 11th Annual Conference on Computational Learning Theory (COLT’98), Wisconsin, MI, 1998, 92-100.提出来的,在当时来说可谓是半监 督学习的核心主流算法。

D.J. Miller和H.S. Uyar 认为,半监督学习的研究起步相对较晚,可能是因

6

半监督学习的应用领域

在进行Web网页推荐时,需要用户标记出哪些网页是 他感兴趣的,很少会有用户愿意花大量的时间来提 供标记,因此有标记的网页示例比较少,但Web上存 在着无数的网页,它们都可作为未标记示例来使用。 这类问题直接来自于实际应用:例如,大量医学影 像,医生把每张片子上的每个病灶都标出来再进行 学习,是不可能的,能否只标一部分,并且还能利 用未标的部分?

最大期望(EM算法) 自训练(Self-training) 协同训练(Co-training) 转导支持向量机(Transductive Support Vector Machines ) 基于图的方法(graph-based methods)

现状与展望

9

1. 最大期望(EM算法)

背景 :期望最大化(EM)方法和朴素贝叶斯方法有 着共同的理论基础。期望最大化是一种基于循环过程 的最大似然参数估计方法,用于解决带缺失数据的参 数估计问题。是最早的半监督学习方法。

16

Figure: Co-Training: Conditional independent assumption on feature split. With this assumption the high confident data points in x1 view, represented by circled labels, will be randomly scattered in x2 view. This is advantageous if they are to be used to teach the classifier in x2 view.

为在当时的主流机器学习技术(例如前馈神经网络)中考虑未标记示例相对 比较困难。随着统计学习技术的不断发展,以及利用未标记示例这一需求的 日渐强烈,半监督学习才在近年来逐渐成为一个研究热点。

D. J. Miller, H. S. Uyar. A mixture of experts classifier with learning based on both labelled and unlabelled data. In: M. Mozer, M. I. Jordan, T. Petsche, eds. Advances in Neural Information Processing Systems 9, Cambridge, MA: MIT Press, 1997, 571-577

7

半监督学习应用实例

语音识别(Speech recognition) 文本分类(Text categorization) 词义解析(Parsing) 视频监控(Video surveillance) 蛋白质结构预测(Protein structure prediction)

8

半监督学习的主要方法

5

半监督学习的发展历程

未标记示例的价值实际上早在上世纪80年代末就已经被一些研究者意 识到了。

R. P. Lippmann. Pattern classification using neural networks. IEEE Communications, 1989, 27(11): 47-64 .

定义:假设特征能够分成两个集,这两个数据集是独立同分布 的。每个子特征集能够训练一个很好的分类器。每个分类器把 未标记的样本分出来给另一个分类器,选择出置信度高的新的 为标记样本进行标记,重复上面的过程。 适用:特征能够很好的分成两类。 缺点:大多数的问题并不具有“充分大”的属性集,而且随机 划分视图这一策略并非总能奏效,

11

1.2 EM算法的具体步骤(解决方法)

1、设定初值 0 2、(E-步骤)对 n 0

(n)

,令 X

(n)

En ( X | Y )

3、(M-步骤)(修正的估计)取使之满足:

log f (n1, X

) max log f (, X

( n)

)

其中E-步骤为取条件期望(expectation),而M-步骤 为取最大(maximum)。这种交替的方法称为EM方法。

半监督学习综述

(Semi-supervised Learning )

1

机器学习

有监督的学习:学习器通过对大量有标记的训练例 进行学习,从而建立模型用于预测未见示例的标记 (label)。很难获得大量的标记样本。 无监督的学习:无训练样本,仅根据测试样本的在 特征空间分布情况来进行标记,准确性差。 半监督的学习:有少量训练样本,学习机以从训练 样本获得的知识为基础,结合测试样本的分布情况 逐步修正已有知识,并判断测试样本的类别。

M. Collins和Y. Singer 进行名实体识别时,也同时使 用了名实体的拼写信息及名实体出现的上下文信息。

返回

19

4 转导支持向量机(TSVM)

背景:TSVM是为了改进SVM在文本分类中本已出色的表现而做的更 一步改进.使用SVM 进行文本分类一个问题是难于建造出那么多的标记 文档,要么是可用的训练数据本身就少,或者是用人工方法把无标记 的文档分类为有标记的文档所花费的功夫无法承受。这样就引出了 TSVM。 定义:是标准SVM在半监督学习当中的拓展,是通过加入约束项使得 未标记数据落在Margin之外,即使得分类的超平面避开数据密度高的 区域 。这里的未标记样本的特点就是使得决策面避开样本的密集区。