【CN109993151A】一种基于多模块全卷积网络的三维视频视觉注意力检测方法【专利】

一种基于三维卷积网络的暴力视频检测方法

^^^^^n C t in f o s e c u r it y --------------------v国技术研究2017年第12期维卷积网络的暴力视频检测方法---------------------宋伟、张栋梁、齐振国2,郑男1 -----------------------(1.中央民族大学信息工程学院,北京100081 ; 2.北京交通大学电子信息工程学院,北京100044.)摘要:随着内容分发网络和视频转码技术的发展,网络流量呈现视频化趋势,互联网中充斥着各种非法特殊视频,危害社会公共安全,急需有效的检测算法。

为探索深度学习理论在 特殊视频检测上的应用,文章提出采用三维卷积网络框架进行暴力视频检测。

相比于传统手工 特征和2D 卷积网络,该方法可以较好地保护视频帧序列在时间维度上运动信息的完整性,实 现对暴力视频时空信息的有效表征。

在暴力视频数据集H ockey 上进行实验,取得了 98.96%的 准确率。

实验结果表明该方法能够有效地检测暴力视频内容。

关键词:暴力视频检测;三维卷积网络;特殊视频中图分类号:TP 309.1 文献标识码:A 文章编号:1671-1122 ( 2017 ) 12-0054-07中文引用格式:宋伟,张栋梁,齐振国,等.一种基于三维卷积网络的暴力视频检测方法[J].信息网络安全,2017 ( 12): 54-60.■ doi ;10.3969/j.issn.1671-1122.2017.12.010一种基于三英文引用格式:SONG Wei, ZHANG Dongliang,QI Zhenguo, et al. A Violent Video Detection Method Based on 3D Convolutional Networks[J]. Netinfo Security, 2017(12):54-60.A Violent Video Detection Method Based on 3D ConvolutionalNetworksSONG Wei1, ZHANG Dongliang1, QI Zhenguo2, ZHENG Nan 1(l.School of I nformation Engineering, Minzu University of C hina, Beijing100081, China, 2. School of E lectronicInformation Engineering, Beijing Jiaotong University, Beijing100044, China)Abstract : With the development of content distribution network and video transcoding technolog }^network traffic has a trend of being dominated by the video , and there are varieties of illegal special videos flooded the internet , endangering the social public securit }^ so the effective detection algorithm is of great necessity . In order to explore the application of deep learning theory on special video detection , this paper proposes the use of 3D convolutional networks for violence video detection . Compared with traditional manual features and 2D convolutional networks , this method can well protect the motion information integrity of video frames m the time dimension , and realize the efficient characterization of spatio-temporal information . The experiment was carried out on the violent video dataset Hockey,achieving 98.96〇/〇 accuracy . The results show that the method can effectively detect the violent contents of video .Key words : violent video detection ; 3D convolutional networks ; special video收稿日期:2017-9-1基金项目:囯家自然科学基金[61503424]作者简介:宋伟( 1983—),男,湖北,讲师,博士,主要研究方向为图像处理、视频内容识别;张栋梁(1991—),男,山东,硕士研究生,主 要研究方向为视频内容检测、视频行为识别;齐振囯( 1989—),男,山西,博士研究生,主要研究方向为信号处理、机器学习;郑男( 1994—), 女,山西,硕士研究生,主要研究方向为图像处理。

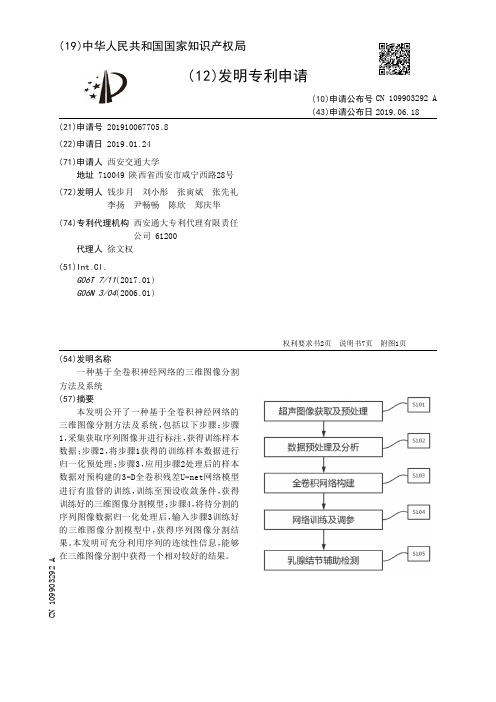

【CN109903292A】一种基于全卷积神经网络的三维图像分割方法及系统【专利】

本发明公开了一种基于全卷积神经网络的 三维图 像分割方法及系统 ,包括以 下步骤 :步骤 1,采集获取序列图像并进行标注,获得训练样本 数 据 ;步骤2 ,将步骤1获得的 训练样本数 据进行 归一化预处理 ;步骤3 ,应 用步骤2处理 后的 样本 数据对预构建的3-D全卷积残差U-net网络模型 进行有监督的 训练 ,训练至预设收 敛条件 ,获得 训练好的三维图像分割模型 ;步骤4 ,将待分割的 序列图 像数 据归一化处理 后 ,输入步骤3 训练好 的三维图像分割模型中 ,获得序列图像分割结 果。本发明可充分 利 用序列的 连续性 信息 ,能 够 在三维图像分割中获得一个相对较好的结果。

2

CN 109903292 A

权 利 要 求 书

2/2 页

U-net网络模型进行有监督的 训练 ,训练至预设收 敛条件 ,获得 训练好的 三维图 像分 割模 型;归一化处理 后 ,输入模型分 割模块 训练 好的三维图像分割模型中,并输出序列图像分割结果。

权利要求书2页 说明书7页 附图1页

CN 109903292 A

CN 109903292 A

权 利 要 求 书

1/2 页

1 .一种基于全卷积神经网络的三维图像分割方法,其特征在于,包括以下步骤: 步骤1,采集获取序列图像并进行标注,获得训练样本数据; 步骤2,将步骤1获得的训练样本数据进行归一化预处理; 步骤3,应用步骤2处理后的样本数据对预构建的3-D全卷积残差U-net网络模型进行有 监督的训练,训练至预设收敛条件,获得训练好的三维图像分割模型; 步骤4 ,将待分 割的 序列图 像数 据归一化处理 后 ,输入步骤3 训练好的 三维图 像分 割模 型中,获得序列图像分割结果。 2 .根据权利要求1所述的一种基于全卷积神经网络的三维图像分割方法,其特征在于, 步骤1中 ,使 用图 像 勾画工具 ,将感兴趣区域从整张 序列图 像中画出来 ,作为机器学习的标 签;在二维平面上对序列图像进行标注,全部标注完成后,再将其合并为三维图像。 3 .根据权利要求1所述的一种基于全卷积神经网络的三维图像分割方法,其特征在于, 步骤2的归一化预处理具体包括: (1)从原始序列图像中获取三维图像灰度矩阵 ; (2)将三维图像灰度矩阵的像素灰度值归一化在0-1之间; (3)将步骤2归一化后的图像的三维像素间距都归一化至预设值。 4 .根据权利要求1所述的一种基于全卷积神经网络的三维图像分割方法,其特征在于, 步骤3中构建的3-D全卷积残差U-net网络模型分为编码器、解码器和注意力连接三个模块; 其中包括卷积、池化、ReLU、批标准化和反卷积操作。 5 .根据权利要求4所述的一种基于全卷积神经网络的三维图像分割方法,其特征在于, 步骤3中构建的3-D全卷积残差U-net网络模型共有8个残差块;编码器阶段包括4个下采样 残差块 ,每一次卷积操作后特征图的 大小不变 ,每一次 池化操作后特征图的 大小变为原来 的1/2,使用ReLU作为非线性激活函数,用于增加网络的非线性表达能力;加入批正则化,用 于加速网络收敛且 用于防 止网络太深时 梯度爆炸或 消失 ;解码器阶段包括4个上采样残差 块,每一次反卷积操作后特征图的大小变为原来的2倍;使用注意力连接机制将编码器中的 低维信息与解码器中的高维信息拼接起来,用于获取为分割提供更加精细的特征。 6 .根据权利要求1所述的一种基于全卷积神经网络的三维图像分割方法,其特征在于, 在步骤3进行有监督的模型训练过程中,加入随机剪切、翻转、随机平移、对比度增强以及弹 性变换中的一种或多种数据增广操作; 在训练过程中,使用Adam方法更新参数,损失函数选择交叉熵函数,并加入难例挖掘。 7 .根据权利要求1所述的一种基于全卷积神经网络的三维图像分割方法,其特征在于, 还包括: 步骤5,使用条件随机场方法对获得的分割结果进行优化处理。 8 .根据权利要求7所述的一种基于全卷积神经网络的三维图像分割方法,其特征在于, 步骤5具体包括:使用条件随机场方法对分割结果进行平滑去噪处理,最后将分割结果在序 列图像中框取出来,并确定分割结果的中心点坐标以及长、宽、高。 9 .一种基于全卷积神经网络的三维图像分割系统,其特征在于,包括: 样本采集模块,用于采集获取序列图像并进行标注,获得训练样本数据; 归一化预处理模块,用于将样本采集模块获得的训练样本数据进行归一化预处理; 模型分 割模块 ;应 用归一化预处理模块处理 后的 样本数 据对预构建的 3-D全卷积残差

一种基于卷积神经网络的三维立体图识别系统[发明专利]

![一种基于卷积神经网络的三维立体图识别系统[发明专利]](https://img.taocdn.com/s3/m/708c10cf0722192e4436f681.png)

专利名称:一种基于卷积神经网络的三维立体图识别系统专利类型:发明专利

发明人:王子彤,姜凯,秦刚,李朋

申请号:CN201910653153.9

申请日:20190719

公开号:CN110363168A

公开日:

20191022

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于卷积神经网络的三维立体图识别系统,属于人工智能数据处理技术领域。

本发明的基于卷积神经网络的三维立体图识别系统包括输入图像缓存模块、流程控制模块、参数分发模块、卷积与上采样基本单元和深景图像处理模块;所述流程控制模块用于给出控制信号,控制系统工作状态;参数分发模块用于存储并分发卷积神经网络计算所需参数;输入图像缓存模块用于对输入的三维立体图像进行逐像素存储。

该发明的基于卷积神经网络的三维立体图识别系统能够充分提取三维立体图像的深度信息和广度信息,并对原图像中的每个像素分类,达到分离出深景图像的目的,具有很好的推广应用价值。

申请人:山东浪潮人工智能研究院有限公司

地址:250100 山东省济南市高新区浪潮路1036号浪潮科技园S05楼北六层

国籍:CN

代理机构:济南信达专利事务所有限公司

代理人:姜明

更多信息请下载全文后查看。

【CN109829398A】一种基于三维卷积网络的视频中的目标检测方法【专利】

步骤23 ,构建检测网络 ,检测网络由分类子网络和回归子网络构成 ,分类子网络和回归 子网络的结构均为全连接层,使用随机初始化的权值作为初始权值;

步骤24 ,使 用步骤1中得到的 N个立方体结构和对应标签 ,对步骤22得到的 候选区 域生 成网络和步骤21得到的三维卷积特征提取网络进行 训练 ,训练的 损失函数为Lrpn=LP+Lreg , 其中LP为候选区 域生成网络输出的 是否存在目 标的 概率与标签真实值的 交叉熵 ,Lreg为候 选区域生成网络输出的候选区域坐标偏移量与标签中目标区域坐标偏移量的平方和;

代理人 安丽 邓治平

(51)Int .Cl . G06K 9/00(2006 .01) G06N 3/04(2006 .01) G06N 3/08(2006 .01)

(10)申请公布号 CN 109829398 A (43)申请公布日 2019.05.31

( 54 )发明 名称 一种基于三维卷积网络的视频中的目标检

权利要求书3页 说明书7页 附图1页

CN 109829398 A

CN 109829398 A

权 利 要 求 书

中的目标检测方法,其特征在于,包括如下步骤: 步骤1,读取数据库中训练样本的视频及对应标签,将训练样本的视频分解成连续的N ' 帧图像序列,对于图像序列中的每一帧图像,取其前后相邻的若干帧进行堆叠,得到N个立 方体结构,N '=N; 步骤2,构建三维卷积特征提取网络、候选区域生成网络、检测网络,使用步骤1得到的N 个立方体结构和对应标签 ,使 用交叉 训练的 方法对进行三维卷积特征提取网络 、候选区域 生成网络、目标检测网络融合训练,得到用于视频中目标检测的三维卷积特征提取网络、候 选区域生成网络、检测网络; 步骤3,读取待检测的视频,将待检测的视频分解成连续的M '帧图像,并对每一帧图像 取其前后的若干帧进行堆叠,得到M个立方体结构,M '=M;分解成连续的M帧图像,并对每一 帧图像取其前后的若干帧进行堆叠,得到M个立方体结构; 步骤4 ,取步骤3得到的 M个立方体结构其中之一 ,使 用三维卷积网络特征提取网络 ,提 取立方体结构的特征 ,得到对应的特征图 ; 步骤5 ,将步骤4得到的 特征图 输入到候选区域生成网络中 ,预 测可能存在目标的 候选 区域,得到候选区域的坐标xp ,yp ,wp ,hp以及是否存在目标的概率Pis ,Pnot,Pis为是目标的概 率,Pnot为不是目标的概率,xp ,yp为候选区域中心点的横纵坐标,wp ,hp为候选区域的长和 宽;区域边界框坐标以及是否存在目标的可能性Pis ,Pnot; 步骤6 ,设定存在目标的概率Pis的阈值P_threshold ,将存在目标的概率Pis大于设定阈 值P_threshold的区域映射到步骤4得到的的特征图上; 步骤7 ,将步骤6得到的映 射到特征图 上的区域进行区 域标准池化 ,把不同 大小的 候选 区域池化为固定大小的特征图 ; 步骤8,对于步骤7得到的各个固定大小的特征图 ,使用检测网络对各个固定大小的特 征图进行分类与边界框的回归微调,得到目标的分类类别、目标属于该类别的概率P和目标 的边界框的坐标,P为目标属于该类别的概率,x ,y为目标的边界框的中心点横纵坐标,w ,h 为目标的边界框的宽和高; 步骤9,采用非最大抑制对检测到的重叠度较高的目标进行过滤,对于检测到的每一类 目标 ,计算目标所在区域交集部分面积与并集部分面积的比 例 ,当交集部分面积与并集部 分面积的比 例超过规定的阈值IOU_threshold时 ,则仅保留目标属于该类别概率P最大的检 测结果,而对其他的检测结果进行过滤; 步骤10 ,对步骤3中得到的 M个立方体结构 ,重复步骤4至步骤9的 过程 ,分 别进行检 测 , 得到视频中图像序列每一帧的检测结果。 2 .根据权利要求1所述的一种基于三维卷积网络的视频中的目标检测方法,其特征在 于:所述步骤1中,立方体结构的获取方法如下: 将训练样本的视频分解成连续的N '帧图像序列,对于N '帧图像序列的每一帧图像,取 其向前的l帧图像和向后的l帧图像,从而接受一定的时间上下文信息,将这2l+1帧图像进 行堆叠,构成大小为W×H×(2l+1)的立方体结构,其中,W为图像的宽,H为图像的高,2l+1表 示堆叠图 片的帧数 ;在图 像序列的开始和末端 ,向前或向 后的图 像帧数小于l帧时 ,使 用补 零的方法使立方体的大小仍为W×H× (2l+1) ,得到N个大小为W×H× (2l+1)的立方体结构, N '=N。

一种基于全卷积网络的三维腹部CT图像多器官配准方法[发明专利]

![一种基于全卷积网络的三维腹部CT图像多器官配准方法[发明专利]](https://img.taocdn.com/s3/m/67302e69bf23482fb4daa58da0116c175e0e1e4d.png)

(19)中华人民共和国国家知识产权局(12)发明专利申请(10)申请公布号 (43)申请公布日 (21)申请号 202010821503.0(22)申请日 2020.08.15(71)申请人 中南大学地址 410083 湖南省长沙市岳麓区麓山南路932号自动化学院(72)发明人 赵于前 杨少迪 张帆 杨振 廖苗 (51)Int.Cl.G06T 7/11(2017.01)G06T 7/00(2017.01)G06T 7/33(2017.01)G06K 9/62(2006.01)(54)发明名称一种基于全卷积网络的三维腹部CT图像多器官配准方法(57)摘要本发明公开了一种基于全卷积网络的三维腹部CT图像多器官配准方法。

首先,获取腹部CT图像数据集。

然后,引入注意力机制模块,构建基于全卷积的网络模型,对该网络模型进行训练并获得初步分割结果,再引入全连接条件随机场,进一步优化分割结果,以实现腹部CT序列多器官区域的提取。

其次,构建腹部CT序列多器官区域图像对以及基于局部相关系数数据项和空间正则化项的相似性度量函数。

最后,采用交替方向乘子法最小化相似性度量函数,实现腹部多器官区域CT图像对配准。

本发明采用先分割再配准的两步法策略,消除了外部灰度信息和噪声对腹部目标器官区域配准的干扰,时间消耗少,配准精度高,鲁棒性强。

权利要求书2页 说明书6页 附图3页CN 111968135 A 2020.11.20C N 111968135A1.一种基于全卷积网络的三维腹部CT图像多器官配准方法,其特征在于包括以下步骤:(1)获取三维腹部CT图像数据集:在公开数据库SLIVER07、LiTS和BTCV中随机读取N个腹部CT序列分类标签信息,获取并补齐相应的肝、左肾、右肾和脾的分割掩膜,组成样本训练集和测试集;(2)提取三维腹部CT序列多器官区域,具体包括以下步骤:(2-a)引入注意力机制模块,构建基于全卷积网络的分割模型:改进的全卷积网络共包含四个部分,其中第一部分包含下采样、密集卷积块、注意力机制模块各1个,激活函数3个;第二部分包含下采样、密集卷积块、注意力机制模块、上采样各1个,激活函数3个;第三部分包含下采样、密集卷积块、注意力机制模块、上采样各1个,激活函数2个;第四部分包含融合、卷积层、激活函数、上采样各1个;其中第一至第四部分上、下采样操作主要是对图像进行缩放,并通过缩放比s来控制感受野的大小,以获得图像在不同分辨率下的特征信息;第一至第三部分注意力机制模块通过压缩比r来减少特征学习的通道数量,使之成为轻量级模块;第一、第二、第三部分分别提取不同分辨率层的特征信息后并行输出作为第四部分的输入,密集卷积块由多个密集卷积层组成,每个卷积层的输入由前面所有层的输出拼接而成;(2-b)训练网络模型,获得三维腹部多器官分割掩膜:采用步骤(2-a)构建的网络模型对步骤(1)所得的样本训练集进行训练,以获得样本测试集的腹部CT序列多器官分割掩膜结果;(2-c)优化步骤(2-b)所得分割结果,实现腹部CT序列多器官区域的最终提取;(3)构建腹部CT序列多器官区域图像对(浮动图像与固定图像):根据样本测试集中每个序列相应的多器官提取结果,随机抽取1个序列图像作为参考,并将剩余序列图像依次与其配对,获得多组腹部CT序列多器官区域图像对;(4)构建配准相似性度量函数:其中,I0为固定图像(参考图像),I1为浮动图像,T为形变向量场,Sim为配准数据项,Reg 为空间正则化项,λ为平衡数据项和正则化项之间误差的常数;(5)采用交替方向乘子法最小化相似性度量函数,实现腹部多器官区域CT图像对的配准。

一种基于多模态卷积神经网络的视频检索方法[发明专利]

![一种基于多模态卷积神经网络的视频检索方法[发明专利]](https://img.taocdn.com/s3/m/369c17eade80d4d8d05a4fb0.png)

专利名称:一种基于多模态卷积神经网络的视频检索方法专利类型:发明专利

发明人:周玲强,英天煜,吴茂英,厉晓华,王亮,周永广,吕佳颖,林珊珊,王敏娴

申请号:CN201611106368.1

申请日:20161206

公开号:CN106682108A

公开日:

20170517

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于多模态卷积神经网络的视频检索方法,包括:步骤1,针对视频数据库中的视频,利用各视频中相邻帧的色彩信息特征,将各视频分割为多个子视频片段;步骤2,提取每个子视频片段的关键帧;步骤3,针对视频数据库中的视频,提取视频的视频特征;步骤4,将子视频片段、关键帧和视频特征作为输入,对标准卷积神经网络模型进行训练,得到多模态卷积神经网络;步骤5,针对待检索视频,提取关键帧和视频特征并作为输入,利用步骤4的多模态卷积神经网络进行相似性判断,得到检索结果。

本发明基于多模态卷积神经网络,同时充分考虑视频的本质特征,能够克服因视频亮度模糊、亮度整体漂移、再编辑视频等导致检索准确度不高的问题。

申请人:浙江大学

地址:310027 浙江省杭州市浙大路38号

国籍:CN

代理机构:杭州求是专利事务所有限公司

代理人:忻明年

更多信息请下载全文后查看。

一种利用卷积多层注意力网络机制生成面向查询的视频摘要的方法[

专利名称:一种利用卷积多层注意力网络机制生成面向查询的视频摘要的方法

专利类型:发明专利

发明人:赵洲,许亦陈,肖舒文

申请号:CN201911266940.4

申请日:20191211

公开号:CN110933518A

公开日:

20200327

专利内容由知识产权出版社提供

摘要:本发明公开了一种利用卷积多层注意力网络机制生成面向查询的视频摘要的方法。

1)针对一组视频,切割构建视频片段。

利用全卷积神经网络,提取视频每个镜头的视觉特征。

2)利用局部自注意力机制,学习视频片段中所有镜头之间的语义关系,并生成视频镜头的视觉特征。

3)利用查询相关的全局注意力机制,学习视频不同片段之间的语义关系,并生成面向查询的视频镜头的视觉特征。

4)计算视频镜头和用户查询之间的相似度得分,用来生成查询相关的视频摘要。

相比于一般视频摘要解决方案,本发明利用卷积多层注意力机制,能够更准确地反映查询相关的视频视觉特征,产生更加符合的视频摘要。

本发明在视频摘要中所取得的效果相比于传统方法更好。

申请人:浙江大学

地址:310058 浙江省杭州市西湖区余杭塘路866号

国籍:CN

代理机构:杭州求是专利事务所有限公司

代理人:郑海峰

更多信息请下载全文后查看。

一种基于三维卷积神经网络的视频分类方法[发明专利]

![一种基于三维卷积神经网络的视频分类方法[发明专利]](https://img.taocdn.com/s3/m/5df0e332d15abe23492f4d5f.png)

专利名称:一种基于三维卷积神经网络的视频分类方法专利类型:发明专利

发明人:孙建德,赵冬,李静

申请号:CN201510380973.7

申请日:20150630

公开号:CN104966104A

公开日:

20151007

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于三维卷积神经网络的视频分类的方法,属于视频处理技术领域。

此方法将视频等间隔采样为多个视频段,扩增了视频数据库,将三维视频段直接输入到3D CNN中,同时提取视频的时域和空域特征,改善了传统视频分类方法因人工选取视频特征及视频建模方式的局限性。

并行分布式3D CNN多分类模型降低了3D CNN学习的复杂度,同时使得分类系统更方便的实现分布式并行计算。

基于3D CNN多分类系统能够仅用较少的视频段就达到较高的识别率,并能够将不属于任意类别的视频分类为新增类别,避免了对新增类别的分类错误。

申请人:孙建德

地址:250100 山东省济南市历城区山大南路27号山东大学信息科学与工程学院

国籍:CN

更多信息请下载全文后查看。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(19)中华人民共和国国家知识产权局

(12)发明专利申请

(10)申请公布号 (43)申请公布日 (21)申请号 201910300859.7

(22)申请日 2019.04.15

(71)申请人 方玉明

地址 330013 江西省南昌市江西财经大学

麦庐园校区信息管理学院

(72)发明人 方玉明 黄汉秦 左一帆 温文媖

万征

(74)专利代理机构 北京科亿知识产权代理事务

所(普通合伙) 11350

代理人 汤东凤

(51)Int.Cl.

G06K 9/00(2006.01)

G06K 9/32(2006.01)

G06N 3/04(2006.01)

(54)发明名称一种基于多模块全卷积网络的三维视频视觉注意力检测方法(57)摘要本发明涉及一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:首先利用图片数据集训练静态全卷积网络(S -FCN)来获取空间特征,从而求得三维视频帧的空间显著性;其次利用二维视频数据集训练动态全卷积网络(T -FCN)并结合其相应的S -FCN结果来获取运动信息,从而求得三维视频帧的时间显著性;最后利用三维视频数据集训练深度全卷积网络(D -FCN)并结合对应的T -FCN结果来获取深度信息,从而求得三维视频最终的视觉关注图。

实验结果在三维视频的视觉关注图中展现了良好的

效果。

权利要求书2页 说明书7页 附图2页CN 109993151 A 2019.07.09

C N 109993151

A

1.一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:首先利用静态全卷积网络(S -FCN)提取空间特征,从而求得三维视频帧的空间显著性;其次利用动态全卷积网络(T -FCN)提取运动信息,从而求得三维视频帧的时间显著性;最后利用深度全卷积网络(D -FCN)提取深度信息,求得三维视频帧的最终视觉关注图。

2.根据权利要求1所述的一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:还包括视觉特征,视觉特征包含:空间特征、运动特征、深度特征。

3.根据权利要求2所述的一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:先利用图片数据集训练好静态全卷积网络(S -FCN),然后分别用三维视频的左右视图去测试S -FCN,得到各自带有空间特征的显著图。

4.根据权利要求2所述的一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:利用二维视频数据集以及视频帧对应的S -FCN结果去训练动态全卷积网络(T -FCN),然后分别用三维视频的左右视图去测试T -FCN,得到各自带有运动特征的显著图;利用三维视频数据集以及视频帧对应的T -FCN结果去训练深度全卷积网络(D -FCN),最终用三维视频的左视图去测试D -FCN,得到最终的三维视频视觉关注图。

5.根据权利要求3或4所述的一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:

在各个子网络训练过程中的损失函数可由式(1)来表达:

y i 代表训练数据集中的标签图,y i ∈(y 1,y 2,...,y N );N代表输入数据的数量;y`i 代表网络计算出来的显著图。

6.根据权利要求3或4所述的一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:

各个子网络的激活函数Relu可由式(2)来表达:

x代表激活函数的输入。

7.根据权利要求3或4所述的一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:

各个子网络的优化算法Adam可由式(3)来表达:

m t 和v t 分别为一阶动量项和二阶动量项;β1、β2

为动力值大小通常分别取0.9和0.999;分别为各自的修正值;W t 表示t时刻即第t迭代模型的参数;g t =ΔJ(W t )表示t次迭代代价函数关于W的梯度大小;∈是一个取值很小的数,为1e -8。

8.根据权利要求1所述的一种基于多模块全卷积网络的三维视频视觉注意力检测方法,其特征在于:网络框架包含三个子网络,它们分别是:用于计算空间显著性的静态全卷积网络(S -FCN),用于估计时间显著性的动态全卷积网络(T -FCN),以及用于估计深度显著性的深度全卷积网络(D -FCN);在三个子网络中,它们的网络结构类似:在上采样的过程中,包含13个卷积层;在下采样的过程中,包含4个反卷积层和7个卷积层。

权 利 要 求 书1/2页2CN 109993151 A。