jieba分词原理

jieba库用法(一)

jieba库用法(一)jieba库的用法jieba库是一款常用的中文分词工具,可以将文本按照词语进行切分,帮助开发者进行中文文本处理。

本文介绍了jieba库的几个常用用法。

安装jieba库使用pip命令可以很方便地安装jieba库:pip install jieba安装完成后,即可在Python中使用jieba库的功能。

分词功能jieba库最主要的功能就是对中文文本进行分词,将文本切分成一个个独立的词语。

可以通过以下代码实现分词功能:import jiebasentence = "这是一段中文文本"words = (sentence)for word in words:print(word)上述代码中,首先导入jieba库,然后定义一个中文文本sentence。

通过调用jieba的cut()函数对文本进行分词,返回一个可迭代的词语列表。

最后通过for循环逐个输出分词结果。

分词模式jieba提供了不同的分词模式,可以根据需要进行选择。

精确模式精确模式是默认的分词模式,试图将句子最精确地切分成词语。

可以使用()函数的默认参数来实现。

import jiebasentence = "我来到北京清华大学"words = (sentence)print("/ ".join(words))上述代码中,使用了精确模式对句子进行分词,并将切分结果使用"/ "连接成字符串输出。

全模式全模式会对句子中所有可能的词语进行切分,速度非常快,但可能会产生一些冗余的词语。

可以使用()函数的cut_all参数设为True 来启用全模式。

import jiebasentence = "我来到北京清华大学"words = (sentence, cut_all=True)print("/ ".join(words))上述代码中,通过将cut_all参数设为True,启用了全模式。

python中jieba的用法

python中jieba的用法Python中的jieba是一个中文分词库,可以将中文文本分割成一个一个的词语,方便进行文本处理和分析。

jieba的使用非常简单,只需要安装jieba库并导入即可。

安装jieba库在命令行中输入以下命令即可安装jieba库:pip install jieba分词示例下面是一个简单的分词示例:import jiebatext = "我爱自然语言处理"words = jieba.cut(text)print("/".join(words))输出结果为:我/爱/自然语言处理可以看到,jieba将文本分割成了三个词语,并用“/”将它们连接起来。

分词参数jieba的cut函数有一些可选参数,可以用于控制分词的行为。

下面是一些常用的参数:- cut_all:是否采用全模式分词,默认为False,表示采用精确模式分词。

- HMM:是否使用隐马尔可夫模型,默认为True。

- user_dict:自定义词典文件路径,可以加入一些特定的词语。

下面是一个使用参数的示例:import jiebatext = "我爱自然语言处理"words = jieba.cut(text, cut_all=True)print("/".join(words))输出结果为:我/爱/自然/自然语言/语言/处理可以看到,使用全模式分词后,jieba将文本分割成了更多的词语。

自定义词典jieba可以使用自定义词典来增加一些特定的词语。

自定义词典是一个文本文件,每行包含一个词语和它的词频,用空格隔开。

下面是一个自定义词典文件的示例:自然语言处理 100中文分词 50可以看到,每行包含一个词语和它的词频,用空格隔开。

使用自定义词典的示例:import jiebajieba.load_userdict("user_dict.txt")text = "我爱自然语言处理"words = jieba.cut(text)print("/".join(words))输出结果为:我/爱/自然语言处理可以看到,使用自定义词典后,jieba将“自然语言处理”作为一个词语进行了分割。

python结巴(jieba)分词

python结巴(jieba)分词 python结巴(jieba)分词⼀、特点1、⽀持三种分词模式: (1)精确模式:试图将句⼦最精确的切开,适合⽂本分析。

(2)全模式:把句⼦中所有可以成词的词语都扫描出来,速度⾮常快,但是不能解决歧义。

(3)搜索引擎模式:在精确模式的基础上,对长词再次切分,提⾼召回率,适合⽤于搜索引擎分词。

2、⽀持繁体分词3、⽀持⾃定义词典⼆、实现结巴分词的实现原理主要有⼀下三点:(1)基于Trie树结构实现⾼效的词图扫描,⽣成句⼦中汉字所有可能成词情况所构成的有向⽆环图(DAG)。

(2)采⽤了动态规划查找最⼤概率路径, 找出基于词频的最⼤切分组合。

(3)对于未登录词,采⽤了基于汉字成词能⼒的HMM模型,使⽤了Viterbi算法。

三、应⽤我们来演⽰⼀下结巴分词的主要功能1、分词1 #-*- coding:utf-8 -*-234 import jieba5678 '''9 cut⽅法有两个参数10 1)第⼀个参数是我们想分词的字符串11 2)第⼆个参数cut_all是⽤来控制是否采⽤全模式12 '''1314 #全模式15 word_list = jieba.cut("今天天⽓真好。

亲爱的,我们去远⾜吧!",cut_all=True)16 print "全模式:","|".join(word_list)17 #精确模式 , 默认就是精确模式18 word_list = jieba.cut("今天天⽓真好。

亲爱的,我们去远⾜吧!",cut_all=False)19 print "精确模式:","|".join(word_list)20 #搜索引擎模式21 word_list = jieba.cut_for_search("今天天⽓真好。

jieba用法及总结

jieba用法及总结

jieba是一种中文分词工具,它可以帮助用户将中文文本进行

分词处理,将连续的中文字符序列切分成具有语义的词语。

使用

jieba分词的基本步骤包括导入jieba库、初始化分词器、调用分

词函数对文本进行分词处理,最后得到分词结果。

具体来说,使用jieba分词的步骤如下:

1. 导入jieba库,在Python中,可以使用import jieba语句

导入jieba库。

2. 初始化分词器,使用jieba库的初始化函数进行初始化,例

如jieba.initialize()。

3. 调用分词函数,使用jieba库的分词函数对文本进行分词处理,例如jieba.cut()。

4. 获取分词结果,对分词函数的输出进行处理,获取分词结果。

总结来说,jieba是一种方便实用的中文分词工具,通过简单

的几个步骤即可对中文文本进行分词处理,得到有用的语义信息。

使用jieba分词可以帮助用户进行中文文本处理、信息检索、自然语言处理等任务。

结巴分词详细讲解

结巴分词详细讲解特点⽀持三种分词模式:全模式,把句⼦中所有的可以成词的词语都扫描出来, 速度⾮常快,但是不能解决歧义;精确模式,试图将句⼦最精确地切开,适合⽂本分析;搜索引擎模式,在精确模式的基础上,对长词再次切分,提⾼召回率,适合⽤于搜索引擎分词。

⽀持繁体分词⽀持⾃定义词典MIT 授权协议算法基于前缀词典实现⾼效的词图扫描,⽣成句⼦中汉字所有可能成词情况所构成的有向⽆环图 (DAG)采⽤了动态规划查找最⼤概率路径, 找出基于词频的最⼤切分组合对于未登录词,采⽤了基于汉字成词能⼒的 HMM 模型,使⽤了 Viterbi 算法主要功能1. 分词jieba.cut⽅法接受三个输⼊参数: 需要分词的字符串;cut_all 参数⽤来控制是否采⽤全模式;HMM 参数⽤来控制是否使⽤ HMM 模型jieba.cut_for_search⽅法接受两个参数:需要分词的字符串;是否使⽤ HMM 模型。

该⽅法适合⽤于搜索引擎构建倒排索引的分词,粒度⽐较细待分词的字符串可以是 unicode 或 UTF-8 字符串、GBK 字符串。

注意:不建议直接输⼊ GBK 字符串,可能⽆法预料地错误解码成 UTF-8jieba.cut以及jieba.cut_for_search返回的结构都是⼀个可迭代的 generator,可以使⽤ for 循环来获得分词后得到的每⼀个词语(unicode),或者⽤jieba.lcut以及jieba.lcut_for_search直接返回 listjieba.Tokenizer(dictionary=DEFAULT_DICT)新建⾃定义分词器,可⽤于同时使⽤不同词典。

jieba.dt为默认分词器,所有全局分词相关函数都是该分词器的映射import jiebaseg_list = jieba.cut("我来到北京清华⼤学", cut_all=True)#print ("Full Mode: " + "/ ".join(seg_list))#全模式seg_list = jieba.cut("我来到北京清华⼤学", cut_all=False)print("Default Mode: " + "/ ".join(seg_list))#精确模式seg_list = jieba.cut("他来到了⽹易杭研⼤厦")#默认是精确模式print(", ".join(seg_list))seg_list = jieba.cut_for_search("⼩明硕⼠毕业于中国科学院计算所,后在⽇本京都⼤学深造")#搜索引擎模式print(", ".join(seg_list))【全模式】Full Mode: 我/ 来到/ 北京/ 清华/ 清华⼤学/ 华⼤/ ⼤学【精确模式】Default Mode: 我/ 来到/ 北京/ 清华⼤学【新词模式】他, 来到, 了, ⽹易, 杭研, ⼤厦注:(此处,“杭研”并没有在词典中,但是也被Viterbi算法识别出来了)【搜索引擎模式】⼩明, 硕⼠, 毕业, 于, 中国, 科学, 学院, 科学院, 中国科学院, 计算, 计算所, ,, 后, 在, ⽇本, 京都, ⼤学, ⽇本京都⼤学, 深造2. 添加⾃定义词典载⼊词典开发者可以指定⾃⼰⾃定义的词典,以便包含 jieba 词库⾥没有的词。

6.5-模块5-jieba库的使用v2

Python语言程序设计模块5: jieba 库的使用嵩天北京理工大学jieba库基本介绍CC BY-NC-SA 4.0 嵩天jieba库概述jieba是优秀的中文分词第三方库-中文文本需要通过分词获得单个的词语-jieba是优秀的中文分词第三方库,需要额外安装-jieba库提供三种分词模式,最简单只需掌握一个函数jieba库的安装(cmd命令行) pip install jiebajieba分词的原理jieba 分词依靠中文词库PY01B30 贯综-利用一个中文词库,确定中文字符之间的关联概率-中文字符间概率大的组成词组,形成分词结果-除了分词,用户还可以添加自定义的词组jieba库使用说明CC BY-NC-SA 4.0 嵩天jieba分词的三种模式精确模式、全模式、搜索引擎模式-精确模式:把文本精确的切分开,不存在冗余单词-全模式:把文本中所有可能的词语都扫描出来,有冗余-搜索引擎模式:在精确模式基础上,对长词再次切分函数描述jieba.lcut(s)精确模式,返回一个列表类型的分词结果>>>jieba.lcut("中国是一个伟大的国家")['中国', '是', '一个', '伟大', '的', '国家']jieba.lcut(s, cut_all=True)全模式,返回一个列表类型的分词结果,存在冗余>>>jieba.lcut("中国是一个伟大的国家",cut_all=True) ['中国', '国是', '一个', '伟大', '的', '国家']函数描述jieba.lcut_for_search(s)搜索引擎模式,返回一个列表类型的分词结果,存在冗余>>>jieba.lcut_for_search(“中华人民共和国是伟大的") ['中华', '华人', '人民', '共和', '共和国', '中华人民共和国', '是', '伟大', '的']jieba.add_word(w)向分词词典增加新词w>>>jieba.add_word("蟒蛇语言")jieba分词要点jieba.lcut(s)。

jieba分词归纳总结

jieba分词归纳总结

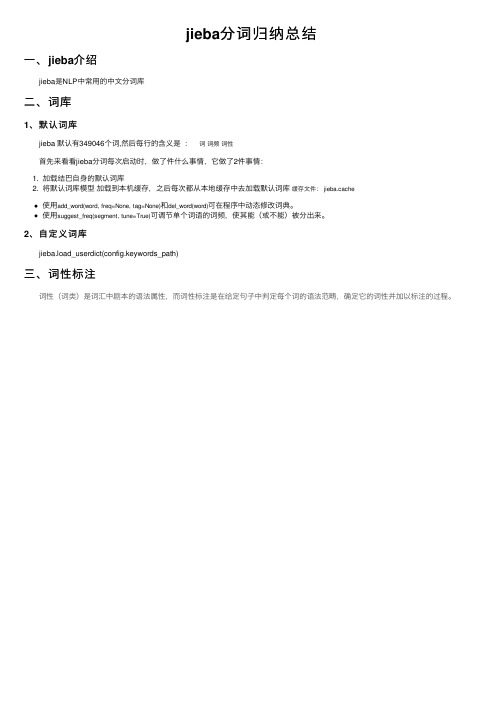

⼀、jieba介绍

jieba是NLP中常⽤的中⽂分词库

⼆、词库

1、默认词库

jieba 默认有349046个词,然后每⾏的含义是: 词词频词性

⾸先来看看jieba分词每次启动时,做了件什么事情,它做了2件事情:

1. 加载结巴⾃⾝的默认词库

2. 将默认词库模型加载到本机缓存,之后每次都从本地缓存中去加载默认词库缓存⽂件: jieba.cache

使⽤add_word(word, freq=None, tag=None)和del_word(word)可在程序中动态修改词典。

使⽤suggest_freq(segment, tune=True)可调节单个词语的词频,使其能(或不能)被分出来。

2、⾃定义词库

jieba.load_userdict(config.keywords_path)

三、词性标注

词性(词类)是词汇中剧本的语法属性,⽽词性标注是在给定句⼦中判定每个词的语法范畴,确定它的词性并加以标注的过程。

参考。

Jieba分词介绍

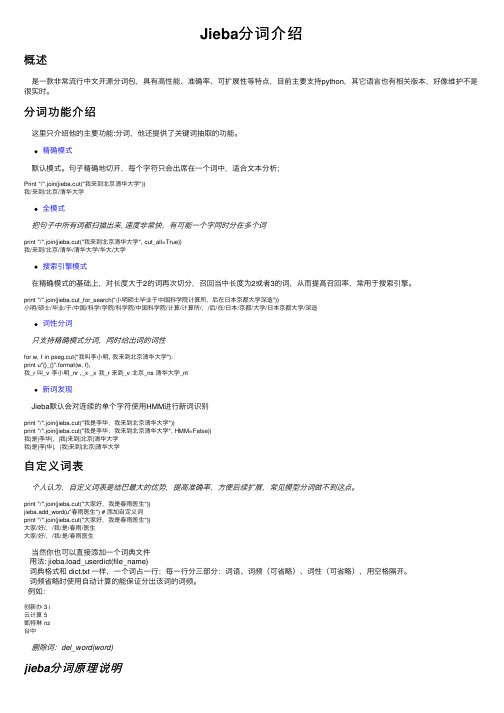

Jieba分词介绍概述是⼀款⾮常流⾏中⽂开源分词包,具有⾼性能、准确率、可扩展性等特点,⽬前主要⽀持python,其它语⾔也有相关版本,好像维护不是很实时。

分词功能介绍这⾥只介绍他的主要功能:分词,他还提供了关键词抽取的功能。

精确模式默认模式。

句⼦精确地切开,每个字符只会出席在⼀个词中,适合⽂本分析;Print "/".join(jieba.cut("我来到北京清华⼤学"))我/来到/北京/清华⼤学全模式把句⼦中所有词都扫描出来, 速度⾮常快,有可能⼀个字同时分在多个词print "/".join(jieba.cut("我来到北京清华⼤学", cut_all=True))我/来到/北京/清华/清华⼤学/华⼤/⼤学搜索引擎模式在精确模式的基础上,对长度⼤于2的词再次切分,召回当中长度为2或者3的词,从⽽提⾼召回率,常⽤于搜索引擎。

print "/".join(jieba.cut_for_search("⼩明硕⼠毕业于中国科学院计算所,后在⽇本京都⼤学深造"))⼩明/硕⼠/毕业/于/中国/科学/学院/科学院/中国科学院/计算/计算所/,/后/在/⽇本/京都/⼤学/⽇本京都⼤学/深造词性分词只⽀持精确模式分词,同时给出词的词性for w, f in pseg.cut("我叫李⼩明, 我来到北京清华⼤学"):print u"{}_{}".format(w, f),我_r 叫_v 李⼩明_nr ,_x _x 我_r 来到_v 北京_ns 清华⼤学_nt新词发现Jieba默认会对连续的单个字符使⽤HMM进⾏新词识别print "/".join(jieba.cut("我是李华,我来到北京清华⼤学"))print "/".join(jieba.cut("我是李华,我来到北京清华⼤学", HMM=False))我|是|李华|,|我|来到|北京|清华⼤学我|是|李|华|,|我|来到|北京|清华⼤学⾃定义词表个⼈认为,⾃定义词表是结巴最⼤的优势,提⾼准确率,⽅便后续扩展,常见模型分词做不到这点。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

jieba分词原理

jieba分词是一种基于统计和规则的中文分词工具。

它采用了基于前缀词典实现高效词图扫描的方法,同时利用了HMM模型进行未登录词识别,并通过了Viterbi算法实现中文分词。

jieba分词的算法步骤如下:

1. 构建前缀词典:jieba首先会生成一个前缀词典,将词库中的词按照字的前缀进行切分。

这可以大幅提高后续词图扫描的效率。

2. 生成词图:将待分词的文本转化为有向无环图(DAG),其中每个节点都代表了具体的片段。

这个图的目的是为了在后续步骤中进行词的组合。

3. 动态规划引擎:jieba使用了动态规划算法(Viterbi算法)来对词图进行路径搜索,找出最有可能的词组合。

这个算法同时也考虑了词的概率和语义等因素。

4. HMM模型:为了识别未登录词,jieba还采用了隐马尔可夫模型(HMM)进行标注。

它通过训练大量的中文语料库,学习词的出现概率和词性等信息,从而提高分词的准确性和鲁棒性。

5. 词性标注和歧义处理:jieba还可以对分词结果进行词性标注和歧义处理。

它可以根据具体需求,将分词结果进一步细分为名词、动词、形容词等不同的词性,并通过上下文信息来消

除歧义。

总的来说,jieba分词利用前缀词典、词图、动态规划引擎和HMM模型等技术手段,实现了高效、准确的中文分词。

它在许多中文文本处理任务中都被广泛应用,如信息检索、自然语言处理等。