基于XML和DOM技术的Web信息抽取模型

基于XML的Web信息采集系统设计与实现

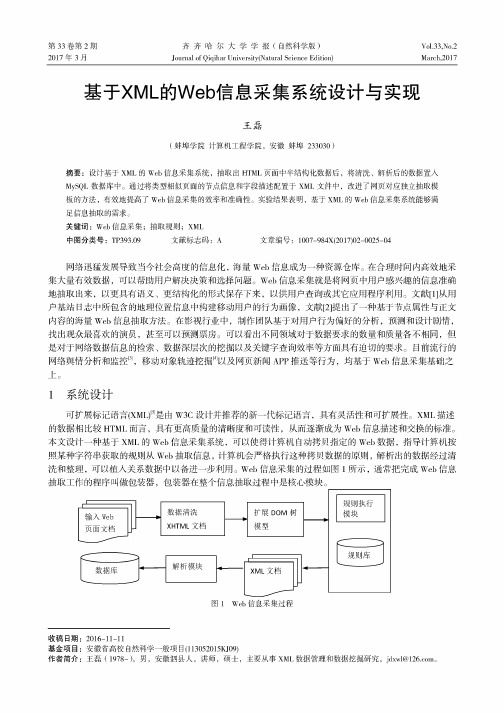

第33卷第2期2017年3月齐齐哈尔大学学报(自然科学版)Journal of Qiqihar University(Natural Science Edition)Vol.33,No.2March,2017基于XML的Web信息采集系统设计与实现王磊(蚌埠学院计算机工程学院,安徽蚌埠233030)摘要:设计基于X M L的W eb信息采集系统,抽取出H T M L页面中半结构化数据后,将清洗、解析后的数据置入M ySQ L数据库中。

通过将类型相似页面的节点信息和字段描述配置于X M L文件中,改进了网页对应独立抽取模板的方法,有效地提高了W eb信息采集的效率和准确性。

实验结果表明,基于X M L的W eb信息采集系统能够满足信息抽取的需求。

关键词:W eb信息采集;抽取规则;XML中图分类号:TP393.09 文献标志码:兴文章编号:1007-984X(2017)02-0025-04网络迅猛发展导致当今社会高度的信息化,海量Web信息成为一种资源仓库。

在合理时间内高效地采 集大量有效数据,可以帮助用户解决决策和选择问题。

W eb信息采集就是将网页中用户感兴趣的信息准确 地抽取出来,以更具有语义、更结构化的形式保存下来,以供用户查询或其它应用程序利用。

文献[1]从用 户基站日志中所包含的地理位置信息中构建移动用户的行为画像,文献[2]提出了一种基于节点属性与正文 内容的海量W eb信息抽取方法。

在影视行业中,制作团队基于对用户行为偏好的分析,预测和设计剧情,找出观众最喜欢的演员,甚至可以预测票房。

可以看出不同领域对于数据要求的数量和质量各不相同,但 是对于网络数据信息的检索、数据深层次的挖掘以及关键字查询效率等方面具有迫切的要求。

目前流行的 网络舆情分析和监控[3],移动对象轨迹挖掘[4]以及网页新闻A PP推送等行为,均基于W eb信息采集基础之 上。

1系统设计可扩展标记语言(X M L f是由W3C设计并推荐的新一代标记语言,具有灵活性和可扩展性。

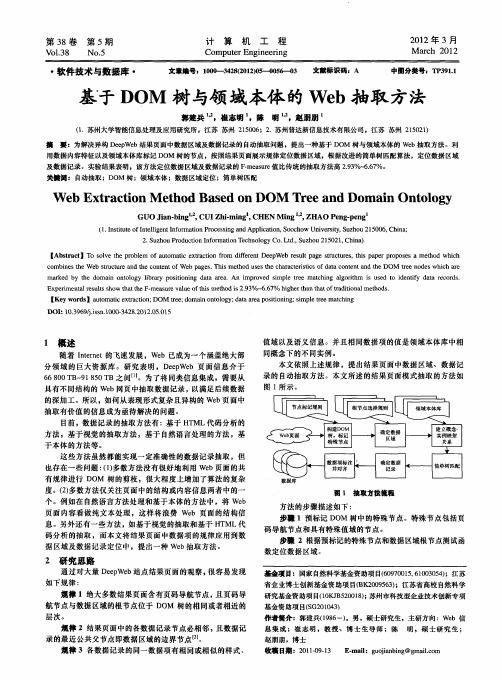

基于DOM树与领域本体的Web抽取方法

分领 域 的巨大资源库 。研究表 明,D eW b 页面信息介 于 ep e 6 0 B 9 5 B之间 J 680T - 1 0T 8 。为了将 同类信息集成 ,需要从

[ ywod iatmaie t c o ; OM e ; o i noo y d tae oio ig s lt e thn Ke r s uo t xr t n D c ai l f e dma o tlg ;aa rap s nn ;i e e c ig n i t mp ma r DOI 1 . 6 /i n10 —4 82 1 .5 1 : 03 9js .0 03 2 . 20 . 5 9 .s 0 0

关奠诃 : 自 动抽取 ;D M 树 ;领域本体 ;数据区域定位 ;简单树匹配 O

W e t a to e h d Ba e n Do M r ea d Do a n On o o y b Ex r c i n M t o s d 0 T e n m i t l g

c mbi e h e tu t r n h o t n fW e a e . i t o e e c a a tr s c fd t o t n n e DOM e o e ih a e o n st e W b sr c u e a d t e c n e to b p g s Th sme h d us s t h r c e it so a a c n e ta d t h i h r t e n d swh c r ma k d b t o i n o o y l r r o i on n a a a e .An i r v d s mp e te thi g a g rt m s u e o i e tf a a r c r s r e y he d ma n o t l g i a y p st i g d t a b i r mp o e i l r e ma c n l o i h i s d t d n y d t e o d . i Ex e m e t l e ul h w a e F me s r l e o i t o 9 % - . 7 h g e a a fta ii n lme h d . pr i n a s t s o t t — a u evau f sme d i 2.3 r s h t h h t h s 6 6 % i h r n t t d to a t o s h t h o r

基于VTD-XML的Web数据提取框架说明书

A Framework For Extracting InformationFrom Web Using VTD-XML‘s XPathC. SubhashiniEducation & ResearchInfosysMysore, India.************************Dr.Arti AryaMaster of Computer ApplicationsPES School of Engineering, BangaloreBangalore, India****************Abstract — The exponential growth of WWW (World Wide Web) is the cause for vast pool of information as well as several challenges posed by it, such as extracting potentially useful and unknown information from WWW. Many websites are built with HTML, because of its unstructured layout, it is difficult to obtain effective and precise data from web using HTML. The advent of XML (Extensible Markup Language) proposes a better solution to extract useful knowledge from WWW. Web Data Extraction based on XML Technology solves this problem because XML is a general purpose specification for exchanging data over the Web. In this paper, a framework is suggested to extract the data from the web. Here the semi-structured data in the web page is transformed into well-structured data using standard XML technologies and the new parsing technique called extended VTD-XML (Virtual Token Descriptor for XML) along with Xpath implementation has been used to extract data from the well-structured XML document.Keywords- VTD-XML, Web Content Mining, Web Data extraction, Web Data Mining, XML, Xpath.I.I NTRODUCTIONWorld Wide Web is the comprehensive information pool, but the data available on internet is unstructured or semi-structured and there is a need for extracting useful information from it. World Wide Web is too huge and structures of web pages are complex and it is tough to find the essential data and information. This poses a great challenge how to extract useful information from the web, mostly which is in the form of semi-structured. Moreover, extracting useful information from World Wide Web is necessary, which can lead to the best decision-making [1]. Web information is usually described in the form of HTML. Since it has unstructured layout and it is not suitable for database application [3], it is difficult to process HTML document for extracting data, so it is better to take the full advantages of XML for analyzing and processing the data on the web [2] and XML also separates data structure from layout which gives more suitable data representation [3]. In this paper, a framework is suggested to extract useful information from the web based on XML technologies.The components of the proposed framework include data acquisition, data preprocessing, data conversion, data integration, data extraction and data storage. The paper is organized as follows: Section 2 provides the literature review of all possible data extraction based on XML, Section 3 focuses the related technologies for web data extraction; Section 4 gives the overview of the proposed framework. Section 5 presents the final conclusion and future scope of the proposed framework.II.L ITERATURE S URVEYWeb Data extraction is usually carried out in a documents that is made up of markup language such as HTML or XML. This document represents their inner structure. Web data extraction methods mainly focus onthe text representation or document tree structure. Web data extraction can be divided into two categories, i. Pattern matching, ii. Structure matching [3].In Pattern matching document is accessed as a text and text based approaches (pattern matching, regular expression) are used to access the documents. It accesses only the individual lines of the document not the whole document.Structure matching access the documents as a tree like structure and uses path and relation based approaches between the nodes. This approach access the document as a whole or individual sub-tree, which is in interest of extraction [3].Many researches are available in the literature how extract useful information from the HTML page, which is in Semi-Structured format.Yan Hu. et. al [16] have proposed a generic XML-based Web information extraction solution. This method proposes two key technologies: the XML-based Web data conversion technology which converts the HTML into XHTML document according to XML grammars, builds the XMLDOM tree and DOM-based XPath [18] generation algorithm is developed to generate XPath expression for the desired information nodes when the user marks the information points. Then XSLT template rules are applied to extract the user’s interested information from the XHTML documents and the extraction results are expressed in XML.Hanyang Luo et.al [17] has proposed a wrapper based on XBRL (eXtensible Business Reporting Language)-GL taxonomy to extract financial data from the web. In this, the user extracts information by using XPath as extraction rules and then the information collected are attached with tags using XBRL to generate XBRL instance document that enable the further data mining.Siti Z.Z. Abidin et.al [4] has proposed a prototype tool to extract and classify unstructured data. The prototype architecture includes six important components such as Web - a collection of web pages, Generator that is used to request web services from the target web and also to retrieve data from the web, User Specifies input data to the generator and classifies the results of the data extraction , Converter that converts data from a XML documents to a Multimedia database or from a generator to XML document, XML document act as structured storage for data classification and Multimedia data bases stores different types of data like text, audio and video.Cheng Zheng et. al [2] has used XML technology to convert the HTML pages into XML through XSL transformations[20]. An XSL transformation (XSLT) is a language for transforming XML documents to HTML or XHTML documents. Then these converted XML documents are integrated and then the data extracted from the integrated XML documents are stored to the database through Virtual Token Descriptor (VTD).Jussi Myllymaki [5] has proposed ANDES (A Nifty Data Extraction System), a crawler-based web data extraction framework. It uses XML technologies such as XHTML, XSLT for data extraction and also provides deep web access. It extracts data from the targeted web page as well as navigational web page with the help of manual navigation and extraction rules.Jussi Myllyamaki et. al [6] described a methodology for creating Xpath expressions to extract data virtually from any HTML page. They also specified categories of extraction rules based on their dependence on content, structural or formatting features.In this paper a new extended edition of VTD-XML combining with 64-bit JVM(Java Virtual Machine), which supports XPath-based XML processing has been proposed to extract data from XML documents. This extended edition of VTD-XML makes possible to process giant XML documents (up to 256 GB) in size [10].III.R ELATED T ECHNOLOGIESA. TidyTidy is a HTML syntax checker and pretty printer [14]. It is a freely available product and it corrects common mistakes in HTML documents and produces equivalent documents that are well-formed. Tidy can also be used to render these documents in XHTML (Extensible Hypertext Markup Language), a subset of XML [13].B. XSLT, XPath and XMLXSLT (Extensible Style Sheet Language Transformation) provides the mechanism for converting one data structure into another. This is achieved by applying an XSLT style sheet to the XML document. The style sheet specifies the conversion rules for accessing and transforming the input XML document to a different output format. An XSLT processor is applies the rules defined in the style sheet to the input XML document [15].The XML Path Language (XPath) is a standard for creating expressions and the expression can be used to find specific pieces of information within an XML document [15]. XPath uses path expressions to navigate in XML documents [18].XML is the standard way for exchanging data over the Internet. The motive for choosing XML technology is that, it is most widely adopted technology for information representation and exchange on the WWW [7].C. XML Parsing Theory Based On VTD-XML ModelVTD-XML is a new open source XML processing model. It centers on a "non-extractive" XML processing technique called "Virtual Token Descriptor” [8]. “Non-extractive“ means, the original XML document is read into the memory in binary way and then analyzes the position of every element in this byte array and records some information; the followed traversal operation will be on these records. This VTD-XML is contrast to "extractive" parsing such as DOM, SAX and other old XML processing, which extracts part of the original document, and then creates objects in memory. DOM parses each event using these objects and builds the structure [9].VTD-XML parses the XML document and creates 64-bit binary format VTD record (token) for each event. Through the list of VTD records, the application program may access any desired element. VTD-XML provides higher performance and requires lower resource compared with DOM (VTD-XML only need memory of about 1.3~1.5 times of the original XML document size, compared with DOM’s 5~10 times of that) [11]. VTD-XML provides random access capability and also performs rapid analysis and traversal [9]. The extended edition of VTD-XML combines with 64-bit JVM (Java Virtual Machine) to support XPath-based XML processing to extract data from large XML documents (up to 256 GB) in size [10].IV.P ROPOSED F RAMEWORKThe algorithm used in the proposed framework is as follows.WDE-XML (Web Data Extraction based on XML):Step 1: Data Acquisition: Identify the data source.Step 2: Data Preprocessing: Map it to XHTML through Tidy tool.Step 3: Data Conversion: Find the reference points within the XHTML document and Map the data to XML through XSLTStep 4: Data Integration: Merge the results through XSLTStep 5:Data Extraction: Extract the data using VTD-XML and Xpath‘s implementation.In this paper, only for the last step implementation is provided with the sample xml file.The proposed framework is depicted in Fig 1.Figure. 1 An Overview of proposed frameworkA. Data AcquisitionThe first step is to obtain the web page for data extraction. The data source for extraction can be a data on local disk or data on the network [2].B. Data PreprocessingThe web page in the HTML format is not well-formed because it does not conform to HTML specification. That is, in HTML ignoring closing tag will not give any error message. Therefore first it must be converted into well-structured XHTML format. Tidy is used to repair the broken syntax and produces well-formed XHTML.C. Data ConversionXSL (eXtensible Style Sheet language) is used to convert the XHTML to XML. The conversion is needed because of poor structural of XHTML documents. Even though it is based on the XML syntax structure, still it contains a lot of HTML vocabulary. So an XSL file has to be designed to convert the XHTML to XML. Next to extract information, it is necessary to find the reference point which contains the actual content.D. Data IntegrationData integration allows the users to operate on data effectively. The web site may contain several pages and hyperlinks, so a merging method based on XSLT for several XML has to be designed. First, create a merge document and the sub element in the document states the name of the XML document to be merged. Next, define a style sheet for the corresponding XML document and then apply it to the merge document.E.Data Extraction with extended VTD-XML and XpathData extraction step extracts useful data form the integrated XML document. The technology of extended VTD-XML and XPath has been used for analyzing and processing the XML document. Because VTD-XML is the fastest and only XML parser that allows Xpath to process 256 GB XML document [20]. Using XPath, application can binds only the relevant data items, which avoids wasteful object creation. The XPath-based code can be understood easily and simple to write and debug [12]. But XPath can be applied to parsed tree of XML. So VTD-XML is used to build a tree-like table .There is Java API for VTD-XML which is present at the top level and consists of three components.∙VTDGen (VTD generator) encapsulates the parsing routine that produces the internal parsed representation of XML.∙VTDNav (VTD navigator) is a cursor-based API that allows for DOM-like random access to the hierarchical structure of XML.∙Autopilot is the class that allows for document-order element traversal [19].To use Extended VTD-XML and Xpath, application needs to include com.ximpleware.extended and need 64-bit JVM to take full advantage of extended VTD. The code for VTD-XML’s Xpath implementation is shown Fig.2.import com.ximpleware.extended.*;public class Xpath{public static void main(String[] args)throws Exception{VTDGenHuge vg=new VTDGenHuge();if(vg.parseFile("D:/Sample/input.xml",true,VTDGenHuge.MEM_MAPPED)){VTDNavHuge vnh=vg.getNav();AutoPilotHuge aph=new AutoPilotHuge(vnh);aph.selectXPath("/Employees/Employee/Empname/text()");int i=0;System.out.println("Employee Name");System.out.println("=============");while((i=aph.evalXPath())!=-1){System.out.println(vnh.toString(i));}}}}Figure. 2 Code for VTD-XML Xpath’s ImplementationV.C ONCLUSION AND FUTURE SCOPEThis paper explains how to extract data from the largest source of information World Wide Web. World Wide Web is a huge source of unstructured information. The web pages in the HTML format is converted into XHTML using Tidy which further are processed using XSLT to form well formatted XML documents. Then the XML documents are integrated based on merge method using XSLT. Finally, extended VTD-XML and Xpath has been applied to integrated XML document to extract useful data. A new extended edition of VTD-XML with 64-bit JVM, which supports Xpath-based XML processing, is used. This extended edition of VTD-XML is able to process huge XML documents up to 256 GB in size. Future work includes systematically generating the Xpath expression, when the user marks the interested node, extracting the attributes present in the xml document and storing the extracted data into the databases, which may be analyzed for decision making purposes. This is an ongoing research wherein this technique can be used in actual web pages.R EFERENCES[1]Li L. , Rong Q., “Research of Web Mining Technology based on XML, International Conference on Networks Security, WirelessCommunications and Trusted Computing, 2009, pp.653-656[2]Cheng Z., Yong F.Y.S. : The Implementation of the Web Mining based on XML technology, International Conference onComputational Intelligence and Security,2009 Page(s):84-87[3]Rudy AG.Gultom., “Implemeting Web Data Extraction and Making Mashup with Xtractorz.[4]Siti Z.Z. Abidin., “ Extraction and Classification of Unstructured Data in WebPages for Structured Multimedia[5]Database via XML.[6]Jussi Myllymaki., “Effective Web Data Extraction with Standard XML Technologies.[7]Jussi Myllymaki., “ Robust Web Data Extraction with XML Path Expressions”.[8]Yasser K. ,Katsuhiko G. ,Web Mining Applications and Techniques:, Tokyo Institute of Technology, XML Semantics, pp:169-188.[9]VTD-XML: XML Processing for the Future (Part I),/KB/cs/vtd-xml_examples.aspx[10]Lan X. , Su J., Cai J. VTD-XML-based Design and Implementation of GML Parsing Project.[11]VTD-XML ,/wiki/VTD-XML[12]Chee C., Faisal M.Y., Azhar K. M. :RBStreX: HardwareXML Parser for Embedded System.[13]S CHEMA LESS C#-XML DATA BINDING WITH VTD-XML,/KB/XML/SCHEMALESS_BINDING.ASPX[14]W EB-BASED DATA MINING, /DEVELOPERWORKS/LIBRARY/WA-WBDM/JT IDY O PEN S OURCE S OFTWARE W RITTENI N J AVA, /OPENSOURCE/OPENSOURCESOFTWARE.PHP?ID=407[15]XML and Web services, Unleashed. Pearson Education.[16]Yan H., Yanyan X., Research on Web Information Extraction Based on XML, In Second Intl. Conf. on Genetic and EvolutionaryComputing, Sept. 2008, pp:401-404.[17]Hanyang L., Jinling G., "Web Data Extraction Based on XBRL-GL Taxonomy," In Proc. of 2009 Asia-Pacific Conference onInformation Processing, 2009, vol. 1, pp.358-361,[18]/XPath/xpath_intro.asp.[19]/xml/Article/22219/1954.[20]/。

Web信息抽取技术研究

Web信息抽取技术研究Web信息抽取技术是当前互联网发展中的一个重要研究领域。

在人工智能、大数据时代的今天,信息抽取已经成为获取和处理信息的重要手段。

在众多的信息抽取技术中,Web信息抽取技术占据了十分重要的地位。

本文将围绕这一主题展开。

I. Web信息抽取技术简介Web信息抽取技术是一种自动化信息处理技术,通过网络爬虫、HTML解析、信息提取等技术手段,将Web上的非结构化信息转换为结构化的信息,从而实现对关键信息的提取、分析和应用。

Web信息抽取技术的应用涉及各个领域,如搜索引擎、电子商务、社交网络分析等等。

Web信息抽取技术并不是一个完整的技术体系,而是由多个技术模块组成的集合体。

其中,网络爬虫模块用于获取Web页面,HTML解析模块用于解析Web页面的HTML代码,信息提取模块用于提取目标信息并对其进行分析。

这些技术模块的协同工作,最终实现对Web页面信息的抽取和分析。

II. Web信息抽取技术的应用Web信息抽取技术在各个领域都有广泛的应用。

以下是一些常见的应用场景:1. 搜索引擎搜索引擎是Web信息抽取技术最常见的应用领域之一。

搜索引擎的核心就是对Web页面的信息进行抽取和分析,从而实现搜索引擎对关键词的匹配和检索。

2. 电子商务电子商务领域对Web信息抽取技术的应用非常广泛。

通过对电商网站的产品信息进行抽取和分析,可以实现商品信息的分类、推荐等功能,从而提高电商网站的用户体验。

3. 社交网络分析社交网络分析是近年来发展迅速的一个领域,其中Web信息抽取技术也发挥了重要的作用。

通过对社交网络上用户的信息进行抽取和分析,可以实现社交网络的用户聚类、社区发现等功能。

III. Web信息抽取技术的挑战Web信息抽取技术的应用具有广泛性和复杂性,在应用过程中,面临着一些挑战:1. Web页面结构多样性Web页面的结构十分复杂,有些页面可能包含多个嵌套的表格、DIV等元素,这些元素的层级关系和结构差异非常大,因此Web信息抽取技术需要能够适应各种类型的Web页面结构。

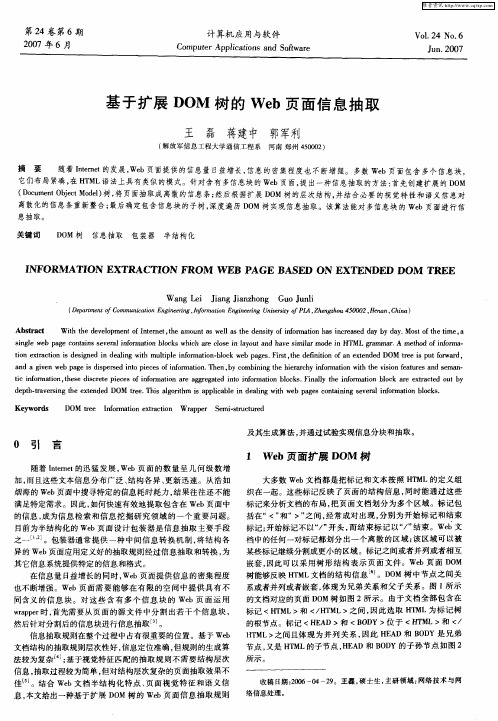

基于扩展DOM树的Web页面信息抽取

( 解放军信息工 程大学通信工程 系 河南 郑州 4 0 0 ) 5 0 2

摘

要 随着 ltme 的发展 , b页面提供 的信息量 日益增长 , ne t We 信息 的密集程度也 不断增 强 多数 We b页面包含 多个信 息块 , 它们布局紧凑, H ML语法上具有类似 的模式。针对含有 多信息块 的we 在 T b页面 提 出一种信息抽取的方法 : 首先创建扩展 的 D M 0 ( ou e t bet d1树 , D cm n jc Moe) 将页面抽取成离散的信息条 ; O 然后根 据扩展 D M树 的层 次结构, O 并结合必要 的视 觉特 性和 语义信息对

Ab t a t sr c W i h e eo me t f n e t t e a u ta e l st e d n i f no ma in h s i ce e a y d y Mo t ft et t t e d v lp n t me , mo n sw l a h e s y o fr t a n r a d d y b a . s o i , h oI h t i o s h me a

sn l e a e c n an e e a no ma in b o k h c r l s a o t n a esmi rmo ei ML  ̄a r . me h f no a i ge w b p g o t is s v r l f r t lc s w ih a eco e i ly u d h v i l d n HT i o n a a mma A t o o r — d i m f t n e ta t n i d sg e n d ai g w t l p e i fr ain b o k w b p g s F rt t e d f i o fa xe d d D0M r e i p tfr a d, i x r ci s e in d i e l i mut l no o o n h i m t - l c e a e . is ,h e nt n o n e tn e o i i te s u o w r a d a g v n w b p g ip re no p e e f n o a in T e b o ii gt e h e a c y i o ain wi h iin fa u e n e n n ie e a e i ds e d i t ic so r t . h n, y c mb n n i rr h n r t t t e vso e t r sa d s ma - s s i m f o h f m o h

基于WEB资源的信息抽取技术

基于WEB资源的信息抽取技术郭志红(上海交通大学情报研究所,上海200030)摘要 web资源含有大量的有效信息,但由于它们欠结构化,不能为传统的数据库型查询系统所利用。

如何将这些信息抽掏出来,转化成结构化信息,供其它信息集成系统所利用,成为该顶域的研究热点。

本文介绍了一个简单的web信息抽取模型,对基于该模型的wrapper归纳技术进行了探讨,并描述了一个wrapper 自动生成系统的原型。

关键词信息抽取 wrapper归纳技术自动生成原型系统The Technology of Information Extraction for WEBResourceGuo Zhihong(Information Research Institute, Shanghai Jiaotong university, Shanghai 200030)Abstract There is plenty of useful information in web resource. Itcan't be used by the traditional database query system because it is notwell-structured. Recently considerable attention has been received on how to extract it from web resource and transfer it to structured information that can be used by other information integration systems. This paper presents a simple web information extraction model, discusses the technology of wrapper induction based on the model and describes automatic generation prototype system of wrapper.Keywords information extraction wrapper induction automatic generation prototype system引言Internet是一个庞大的信息资源库,它上面有着各类各样的在线信息:天气预报,股票价钱,商品目录,政府法规和税收政策,个人爱好,研究报告等等。

用DoM完成XML数据提取示例

c h i l d n o d e s ( j ) . t e x t % >

b z = l e n d i f

ne xt

单, 并保存在所定义 的变量中:

D I M I v n ] S e t I v n ] =g e t E l e m e n t s B Y T a g N a m e ( “ 元 素” ) 注 :[ v n ] 是 自己定 义 的变 量 :“ 元素” 是 指 所加 载 的x M L 文

据存 储系 统 、 复 杂 文 件 和 相 对 不 定 结 构 文 件的 数 据 存 储中 , X M L

换, 同时X M L 也 是数 据库之间传送 数据的首选方 法。 另外, 在数 据结构相对不固定的情况下, x M 嗄 成 为数据存储的理想方式。 获取X M L 数据 的方 法有多种, 但在 大多数据情况下,以D O M ( D o c u m e n t O b j e c t M o d e 1 ) 即文档对象模型来处理X M L 文件是 非常可取 的。 一般情况下, 用D o M 对x M L 皮 档进行处理 过程包括 以下几个步骤:

3 创建X ML 文档的元素结点清单

因 为所 创 建 X M L 文 档 的 元 素 结 点 清 单 要 保 存 起 来 以备 使 用 ,所 以要 先 定 义 一 个 变 量 ,然 后 用 D 0M的 g e t E l e m e n t s B Y T a g N a m e 0方法 创建所加载 的x M I 皮 档元 素的清

还是倍受 青睐 。 因为 以X M L 存储 的方 式可 以方便地实现平台转 v a l u e = 确

1 创 建DOM实例

创建一个D 0 M 实例通常可以采用下述方法 :

基于DOM的Web信息抽取

基于DOM的Web信息抽取

崔继馨;张鹏;杨文柱

【期刊名称】《河北农业大学学报》

【年(卷),期】2005(28)3

【摘要】为解决因Web信息量巨大且具有动态性、不规则性,Web信息查询和Web信息集成存在很大困难,研究了对HTML格式的 Web文档的信息抽取,提出了一种基于DOM的Web信息抽取方法.该方法通过附加语义、样本学习生成基于DOM路径的抽取规则,利用遍历DOM树实现信息抽取.本方法可用于Web查询,也可用于信息集成系统中包装器的构造.

【总页数】4页(P90-93)

【作者】崔继馨;张鹏;杨文柱

【作者单位】河北工程学院,河北,邯郸,056000;河北工程学院,河北,邯郸,056000;河北大学,数学与计算机学院,河北,保定,071002

【正文语种】中文

【中图分类】TP391.1

【相关文献】

1.基于本体和DOM相结合的Web信息抽取器 [J], 柳佳刚;陈山;贺令亚

2.基于单DOM树特征预分类的自适应Web信息抽取方法 [J], 彭艳兵;谢馨庭

3.基于DOM树的可适应性Web信息抽取 [J], 李朝;彭宏;叶苏南;张欢;杨亲遥

4.基于DOM的Web信息抽取方法 [J], 邓箴

5.基于时间频率加权DOM的Web信息抽取方法 [J], 马瑞民;钱浩

因版权原因,仅展示原文概要,查看原文内容请购买。

基于XML的Web半结构化信息抽取

S m i—S r t r d W e n o m a i n Ex r c i n Pr c s s d o e t uc u e b I fr to t a to o e s Ba e n XM L

信息 抽取是 近 十几 年发 展起 来 的新 领域 ,它起 源于文本 理解 ,是 自然语 言处理 领域 中 比较 重要 的

一

个子领 域 。We b信 息 抽 取 承 接 了传 统 信 息 抽 取

图 1 信 息抽 取 及数 据 处 理 流 程

Fg 1 If r t n e t cin a d d t a de po e s i. no mai xr t n aa h n l rc s o a o

Absr c : As a d v lp n fe ta t n t c n lg n B/S f l ta t e eo me to xr c i e h o o y i o i d,we n omai n e ta to s a un— e b i fr to xr cin i i v ra p lc t n frt e p r o eo trn n ere ig i c e sn tms o a a es la p ia i o h u p s fso ig a d r t vn n r a i g ie rd t .Ta i g W e a e s o i k n b p g sa o ii a a a r s u c s, Se —Sr cur d W e no ain Exr c in P o e sBa e n XML d s rb d rgn ld t e o r e mi tu t e b I f r t ta t r c s s d o m o o ec e i i i p r man y r s a c e i lme t f t e r c s ie i fr ai n xr c in, g n r t n o r n t s pa e il e e r h d mp e n s o h e e sv n o h m t e ta t o o e e ai fmo e o

基于DOM的网页主题信息的抽取

基于DOM的网页主题信息的抽取

刘军;张净

【期刊名称】《计算机应用与软件》

【年(卷),期】2010(027)005

【摘要】随着Internet的发展,Web页面信息量不断加大,信息密集程度不断加强.但Web页面的主题信息通常不太明确,抽取主题信息也比较困难.针对这一难题,提

出一种算法:构建文档对象模型DOM(Document Object Model)树,然后针对HTML半结构特征的不足,为DOM添加显示、语义(链接数、非链接文字数、高度、宽度)等属性,并提出一种聚类规则来对其进行分块,最后对其进行剪枝,删除掉无用

的信息,提取主题信息.实验表明,该方法能够准确抽取主题信息.

【总页数】3页(P188-190)

【作者】刘军;张净

【作者单位】武汉理工大学计算机科学与技术学院,湖北,武汉,430070;武汉理工大

学计算机科学与技术学院,湖北,武汉,430070

【正文语种】中文

【相关文献】

1.基于DOM的动态网页信息抽取方法 [J], 王平根

2.基于DOM和网页模板的Web信息抽取 [J], 王丽;唐建雄

3.基于DOM和网页模板的Web信息抽取 [J], 王丽;唐建雄

4.基于DOM树和视觉特征的网页信息自动抽取 [J], 黄武冠;朱明;尹文科

5.基于DOM的半结构化网页信息抽取算法 [J], 李卫东

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

于X ML技术 的 We b信 息 抽 取 方 法 . 该 方 法 利 用

当今 流行 的 H T ML 、 X ML解 析技术 , 对从 互联 网 中 获得 的半 结构 化 的 We b页面 进行解 析 , 使 之成 为 类似于 X M L的 X H T M L文 档 , 并且 融 合 D O M、

第3 4卷 第 3期 2 0 1 3年 6月

大 连 交 通 大 学 学 报

J 0UR NAL OF D AL I AN J I AO T ONG U NI VE RS I T Y

Vo 1 . 3 4 No . 3

J u n . 2 01 3

文章编号 : 1 6 7 3 — 9 5 9 0 ( 2 0 1 3 ) 0 3 — 0 0 9 6 0 5

要思 想 : 利 用爬 虫 程序 从 网上下 载 具 有 相关 主 题

大多数 We b页 面 是 由半 结 构 化 的 H T ML语 言 所 写, 具 有很 大的异 构性 , 所 以很 难被 计算机 归 纳和 分 析.2 0世 纪 8 O年 代 , We b信 息 抽 取 ( I n f o r ma .

t i o n E x t r a c t i o n , I E ) 技术 就是 在这 种背 景下 应运 而

的 We b页面作 为样本 页面 , 利用 H T M L解 析器 对

页 面不规则 的标 签 以及非 主题 元 素进 行 清 理 , 使 之成 为符 合 X ML规范 的 X H T ML文档 . 使用 X ML 解析 器 对 文 档 进 行 解 析 , 获得 对应 的 X ML D O M 树. 利用 J A V A的 J T r e e组 件显 示 文 档 , 方 便 用 户 对感 兴 趣 的节 点 进 行标 注 , 通过 X p a t h路 径 算 法 获得 节 点 的 X p a t h路径 , 与转换语言 X S L T相 结

X P a t h 、 X S L T以及 J T r e e技 术 构 造 We b信 息 抽 取

模块 , 建立 一 个 简 易通 用 的 We b信 息 抽 取模 型 , 实现 对 We b信 息 的半 自动化 抽取 .

1 We b信 息抽 取 模 型

基于 X ML和 D O M 技 术 的 We b信 息 抽 取 主

基于 X ML和 DOM 技 术 的 We b信 息 抽 取 模 型

李文 , 郑邦 习, 邓武

( 大连交通大学 软件学院 , 辽 宁 大连 1 1 6 0 2 8 ) 米 摘 要 : 将X M L技术应用 于搜索 引擎 , 提出一种基 于 X ML和 D O M技术的 We b 信 息抽取模 型, 对模 型的

米 收 稿 日期 : 2 0 1 2 - 0 9 — 1 8

基金项 目: 武汉大学软件工程 国家重点实验室开放基金资助项 目( S K L S E 2 0 1 2— 9— 2 7 ) ; 四川 省重点实验基 金资

助 项 目( G K 2 0 1 2 0 2 ) ; 广 西 混 杂 计 算 与 集 成 电路 设 计 分 析 重 点 实 验室 基 金 资助 项 目

合, 最终 获 得抽 取 规 则模 板 . 通 过反 复 的实 验 , 将 得 到 的规 则加 入抽 取 规则 库 中 , 利 用 它 对用 户 请 求 的页 面进 行 抽 取. 基于 X ML技 术 的 We b信 息

抽取 模 型 , 如图 1 所示 .

信 息 自动 抽 取 方 法 , 该 方 法 依 据 页 面 信 息 构 造 S T U . D O M, 并通过 比较 页 面 主题 的相关 度 去 除 和 主题信 息不一 致 的噪声 节点 ,然 而缺乏 良好 的通

数据采集 、 页面优 化 处理 、 抽取 规 则 生 成 和信 息 抽 取 四 个 阶段 进 行 了详 细 分 析 , 讨 论 了 网页爬 虫 、 N e k o H T ML 、 X e r c e s _ J 、 J T r e e 、 X p a t h以及 X S L T技术在 We b 信息抽取 中的应用 , 实现 了 We b信息抽取 的半

自动 化 .

关键词 : 信息抽取 ; X M L技术 ; D O M技 术 ; We b 页 面

文献标识码 : A

0 引 言

当前是 一个 信 息爆 炸 时 代 , 互 联 网 中充 斥 着 海 量 的纷乱芜 杂 的数据 , 人 们 想 从 如此 巨大 的信 息 库 中查询 到 自己所要 的信息 , 如 同大海 捞针 , 既 耗 时又 耗力 . 人们 提 出搜 索 引擎技 术 , 即通过输 入 关 键字 而得 到相 关 信 息 的页 面链 接 . 该 技 术 在 很 大程度 上解决 了信 息搜 索 所 带来 的无 尽 苦恼 , 但

作者简介 : 邓武 ( 1 9 7 6一) , 男, 副教授 , 博士 , 主要从事人工智 能 、 信息抽取 的研究

E - ma i l : d w 7 6 8 9 @Ct . . e d u . c n .

生 了.国内外 对 We b信 息 抽 取 已经 进 行 大 量 相 关 研究 , 提 出 了许 多 的 We b信 息 抽取 方 法 ¨ 剖 这

些 方法 如果按 照 自动化 程 度 分 为手 工 、 半 自动 和

全 自动 ; 按原 理可分 为基 于包装 器 归纳 、 基 于 自然

语 言理解 、 基于 O n t o l o g y方 法 和基 于 H T ML方 法 等 J . 王琦 等 提 出 了基 于语 义 D O M 树 的 We b