基于代价敏感的朴素贝叶斯不平衡数据分类研究_蒋盛益 (1)

数据挖掘原理与实践蒋盛益版期末复习

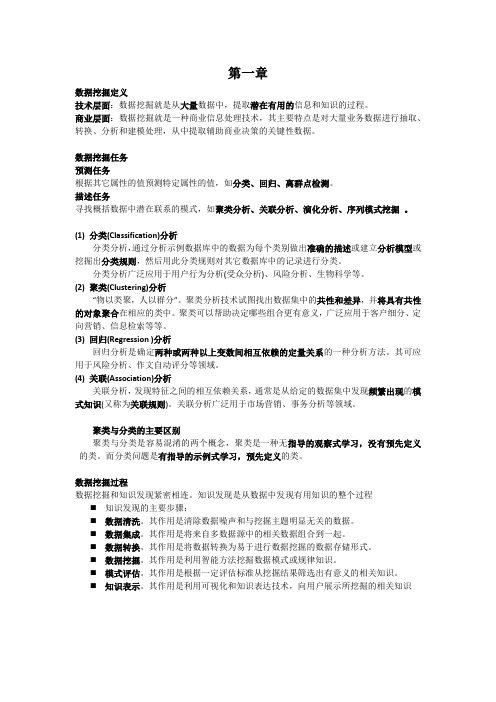

第一章数据挖掘定义技术层面:数据挖掘就是从大量数据中,提取潜在有用的信息和知识的过程。

商业层面:数据挖掘就是一种商业信息处理技术,其主要特点是对大量业务数据进行抽取、转换、分析和建模处理,从中提取辅助商业决策的关键性数据。

数据挖掘任务预测任务根据其它属性的值预测特定属性的值,如分类、回归、离群点检测。

描述任务寻找概括数据中潜在联系的模式,如聚类分析、关联分析、演化分析、序列模式挖掘。

(1) 分类(Classification)分析分类分析,通过分析示例数据库中的数据为每个类别做出准确的描述或建立分析模型或挖掘出分类规则,然后用此分类规则对其它数据库中的记录进行分类。

分类分析广泛应用于用户行为分析(受众分析)、风险分析、生物科学等。

(2) 聚类(Clustering)分析“物以类聚,人以群分”。

聚类分析技术试图找出数据集中的共性和差异,并将具有共性的对象聚合在相应的类中。

聚类可以帮助决定哪些组合更有意义,广泛应用于客户细分、定向营销、信息检索等等。

(3) 回归(Regression )分析回归分析是确定两种或两种以上变数间相互依赖的定量关系的一种分析方法。

其可应用于风险分析、作文自动评分等领域。

(4) 关联(Association)分析关联分析,发现特征之间的相互依赖关系,通常是从给定的数据集中发现频繁出现的模式知识(又称为关联规则)。

关联分析广泛用于市场营销、事务分析等领域。

聚类与分类的主要区别聚类与分类是容易混淆的两个概念,聚类是一种无指导的观察式学习,没有预先定义的类。

而分类问题是有指导的示例式学习,预先定义的类。

数据挖掘过程数据挖掘和知识发现紧密相连。

知识发现是从数据中发现有用知识的整个过程⏹知识发现的主要步骤:⏹数据清洗。

其作用是清除数据噪声和与挖掘主题明显无关的数据。

⏹数据集成。

其作用是将来自多数据源中的相关数据组合到一起。

⏹数据转换。

其作用是将数据转换为易于进行数据挖掘的数据存储形式。

机器学习中数据不平衡问题的解决方案

机器学习中数据不平衡问题的解决方案机器学习是一种通过数据来训练模型,使得计算机能够进行智能决策和预测的技术。

然而,在实际应用中,我们常常会遇到数据不平衡的问题。

数据不平衡指的是在训练集中正例和负例的数量出现明显不均衡的情况,这可能会导致模型训练的不准确性和偏差。

解决数据不平衡问题是机器学习中的一个重要挑战,下面我们将介绍一些解决方案。

1. 重新采样重新采样是一种常见的解决数据不平衡问题的方法。

它包括过采样和欠采样两种策略。

过采样指的是增加少数类样本的数量,而欠采样则是减少多数类样本的数量。

过采样的方法包括随机复制、SMOTE(合成少数类过采样技术)等,而欠采样的方法包括随机删除、Tomek链接等。

重新采样能够使得正负样本的数量更加均衡,有利于模型的训练。

2. 使用不平衡学习算法不平衡学习算法是专门针对数据不平衡问题设计的算法。

它们能够在模型训练阶段考虑到数据不平衡的情况,通过改变损失函数或者样本权重等方式来平衡正负样本之间的影响。

常见的不平衡学习算法包括SMOTEBoost、RUSBoost、EasyEnsemble等。

这些算法能够有效地提高模型对于少数类样本的识别能力,从而解决数据不平衡问题。

3. 使用代价敏感学习算法代价敏感学习算法是一种考虑不同类别样本代价的学习算法。

它通过给不同类别的样本分配不同的代价,使得模型在训练过程中更加关注少数类样本。

代价敏感学习算法能够有效地解决数据不平衡问题,提高模型的泛化能力。

常见的代价敏感学习算法包括Cost-sensitive SVM、AdaCost等。

4. 使用集成学习集成学习是一种通过结合多个模型来提高整体性能的方法。

在处理数据不平衡问题时,可以使用集成学习来结合多个不同模型,以弥补单一模型的不足。

常见的集成学习方法包括Bagging、Boosting、Stacking等。

通过使用集成学习,可以有效地提高模型对于少数类样本的识别能力,从而解决数据不平衡问题。

基于csd-elm的不平衡数据分类算法

摘要:基于代价 学习的极限学习机(ELM)算法在处理不平衡数据 问题时,

不同

本的 i

点同

中各样本的 性

的影响#为,提基于样本数量比例的

子设置方

法,并基于Mini-batch k-means申

离测度设计

内样本 确定方案#在 基础上,构 区 、负类

的隐含层 矩阵,根据训练样本数与ELM隐含层节点数间的关系,分2 情况计算ELM隐含层

constrain+d optimi eation th+ory DOI: 10. 19678//. issn. 1000-3428.0054988

0概述

极限学习机(Extreme Learning Machine,ELM)

单隐含层前

网络(1]o ELM可随机

层与隐含层间的

隐含层各节

点的偏置值,并采用解析方法求解隐含层

positive and negative categories. According to the relationship between the size of training samples and the number of nodes in the ELM hidden layer,we calculate the connection weights between the hidden layer and the output layer of ELM in two conditionF, thuFreducing the time complexity ofthealgorithm.ExperimentalreFult Fhow thatcompared with ELM,WELM and other algorithms,the proposed algorithm has higher G-meen and F1 classification performance index. + Key words] imbalanced data; ExWeme Learning Machine (ELM) ; cost-sensitive learning; Mini-batch k-means clusteri法的 网

基于贝叶斯的多窗口数据流分类研究

很好 地利用历史数据 。2 0 年 , n 0 3 Wag等人 提出了数据 流集成分类器m 的方法 . 它使 用多个分类器来 代替单个

的实际分布情况

并将 X指派到具有最大后验概率 的类 这等价于

将 X指 派 到 P XI ) ( 最 大 的类 。 假 定 属 性 之 间是 ( C P C) 相 互 独 立 的 , 们有 : 我

2 基 于 贝 叶斯 的 多 窗 口数 据 流 分 类 模 型

假 定数 据流 被划分 成连 续 的时间 窗 口 T : W, ,

类 速 度

现代社会 中 。 据流[ 数 1 ] 的应用越 来越广泛 , 例如 : 互 联 网 中的 I P数据包 、 传感 器网络等 。这些 数据 随着时 间的更迭而不 断产生 .其数据量大 且数据分布也 在发 生变化 ( 即概念漂 移 )这使 得传统 的数据分类模 型 . 不 能很好胜任 20 0 0年 . o igs D mn o 等人 提出 了一种高效 的增 量决 策树算法 V DI. F '1 l 它通 过 H e dn 边界来 保证用 于构 4 of ig 造每一棵子树所 使用 的数据拥有 足够 的信息 .选 择信 息增益最大 的属性进行分裂 . 逐渐 构造决策树 :V D CFT

基 于贝叶斯 的 多窗 口数 据流分类研究

陈 猛 , 王 春 喜

( 南大学软件学院 , 州 400 ) 河 郑 50 8

摘

不平衡数据分类方法及其在入侵检测中的应用研究

Ab s t r a c t Th e t r a d i t i o n a l c l a s s i f i c a t i o n a l g o r i t h ms a l wa y s h a v e l o w c l a s s i f i c a t i o n a c c u r a c y r a t e e s p e c i a l l y{ o r t h e mi n o r i t y c l a s s wh e n t h e y a r e d i r e c t l y e mp l o y e d o n c l a s s i f y i n g i mb a l a n c e d d a t a s e t s . A K- S s t a t i s t i c b a s e d n e w c l a s s i f i c a t i o n me t h — o d f o r i mb a l a n c e d d a t a wa s p r o p o s e d t O e n h a n c e t h e p e r f o r ma n c e o f mi n o r i t y c l a s s r e c o g n i t i o n .At f i r s t , t h e K_ S s t a t i s t i c wa s e mp l o y e d a s a c o r r e l a t i o n me a s u r e t o r e mo v e r e d u n d a n t v a r i a b l e s . Th e n a K- S b a s e d d e c i s i o n t r e e wa s b u i l t t o s e g — me n t t h e t r a i n i n g d a t a i n t o s e v e r a l s u b s e t s . Fi n a l l y , t wo - wa y r e s a mp l i n g me t h o d s , f o r wa r d a n d b a c k wa r d , we r e u s e d t o

不平衡数据的集成分类算法综述_李勇

。然而在实际应用中, 少数类样例被误分的代价要比多

数类被误分的代价大。例如在软件缺陷预测中 , 有缺陷的样本 数要远远小于无缺陷样本数 , 但分类的目标是识别出有缺陷的 少数类样例; 类似的还有医疗诊断、 石油泄漏监测、 网络入侵监 测、 信用卡欺诈等领域

[4 ]

两种

类型。类间不平衡是指类之间呈现了不相等的数据分布 , 如图 1 ( a) ( b) 所示。在一些实际应用中, 数据呈现了极端的类与类 之间的数据 不 平 衡, 不 平 衡 率 有 些 能 达 到 1000 ∶ 1 或 者 更 高

y1 ) , …, ( xm , ym ) } , 输入: 训练数据集{ ( x1 , 其中 x i 是输入空间 X y i 是输出分类 Y 中相应的分类标签, Y = { - 1, + 1} 。 中的实例, 初始化 D1 ( i) = 1 / m; 2, …, T 对于 t = 1 , a) 使用 D t 训练基分类器 h_t→Y; b) 计算权值参数 α t ; c) 更新训练数据集的权值 D ( t + 1 ) ( i) = D t ( i ) exp ( - α t y i h t ( x i ) ) / Zt , Z t 为规范化因子, Z t = ∑ i D t ( i) exp( - α t y i h t ( x i ) ) ; 输出: 最终分类器 H( x) = sing( ∑ T ( t = 1 ) α t h t ( x) ) 。

第 31 卷第 5 期 2014 年 5 月

计 算 机 应 用 研 究 Application Research of Computers

Vol. 31 No. 5 May 2014

不平衡数据的集成分类算法综述