sklearn、knn、朴素贝叶斯、决策树

【好程序员】机器学习Sklearn全套教程课件PPT模板

3

法入门

1-4KNN鸢尾花分类KNN

鸢尾花分类

4

1-5郭福斌分享数据库郭

5

福斌分享数据库

1-6KNN算法调参数KNN

算法调参数

6

第1章【好程序员】机器学习sklearn全套教程

1-9柴金虎分享柴金虎 分享

1-8knn手写数字识别 (二)knn手写数字识别

(二)

1-7knn手写数字识别 (一)knn手写数字识别

1-15sklearn中数据拆分sklearn中数 据拆分

1-16str类型的数据的转变与训练预测 str类型的数据的转变与训练预测

1-17谷孟帅分享谷孟帅分享

1-18sklearn-str类型的数据量化操作 sklearn-str类型的数据量化操作

第1章【好程序员】机 器学习sklearn全套教 程

(一)

1-10knn鸢尾花分类 knn鸢尾花分类

1-11knn参数 cross_val_score调参knn参 数cross_val_score调参

1-12knn症诊断knn症 诊断

第1章【好程序员】机器学习sklearn 全套教程

ห้องสมุดไป่ตู้

1-13KNN模型评价指标KNN模型评价 指标

1-14KNN数据归一化操作KNN数据归 一化操作

1-19决策树的熵原理决策树的熵 原理

1-20决策树熵原理(二)决策树 熵原理(二)

感谢聆听

【好程序员】机器学习 sklearn全套教程

演讲人

2 0 2 x - 11 - 11

01

第1章【好程序员】机器学习 sklearn全套教程

第1章【好程序员】机器学习sklearn全套教程

1-1算法模型框架介绍算

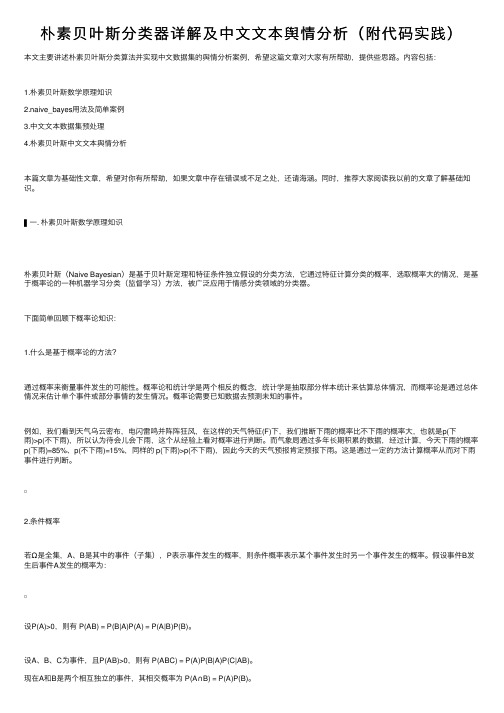

朴素贝叶斯分类器详解及中文文本舆情分析(附代码实践)

朴素贝叶斯分类器详解及中⽂⽂本舆情分析(附代码实践)本⽂主要讲述朴素贝叶斯分类算法并实现中⽂数据集的舆情分析案例,希望这篇⽂章对⼤家有所帮助,提供些思路。

内容包括:1.朴素贝叶斯数学原理知识2.naive_bayes⽤法及简单案例3.中⽂⽂本数据集预处理4.朴素贝叶斯中⽂⽂本舆情分析本篇⽂章为基础性⽂章,希望对你有所帮助,如果⽂章中存在错误或不⾜之处,还请海涵。

同时,推荐⼤家阅读我以前的⽂章了解基础知识。

▌⼀. 朴素贝叶斯数学原理知识朴素贝叶斯(Naive Bayesian)是基于贝叶斯定理和特征条件独⽴假设的分类⽅法,它通过特征计算分类的概率,选取概率⼤的情况,是基于概率论的⼀种机器学习分类(监督学习)⽅法,被⼴泛应⽤于情感分类领域的分类器。

下⾯简单回顾下概率论知识:1.什么是基于概率论的⽅法?通过概率来衡量事件发⽣的可能性。

概率论和统计学是两个相反的概念,统计学是抽取部分样本统计来估算总体情况,⽽概率论是通过总体情况来估计单个事件或部分事情的发⽣情况。

概率论需要已知数据去预测未知的事件。

例如,我们看到天⽓乌云密布,电闪雷鸣并阵阵狂风,在这样的天⽓特征(F)下,我们推断下⾬的概率⽐不下⾬的概率⼤,也就是p(下⾬)>p(不下⾬),所以认为待会⼉会下⾬,这个从经验上看对概率进⾏判断。

⽽⽓象局通过多年长期积累的数据,经过计算,今天下⾬的概率p(下⾬)=85%、p(不下⾬)=15%,同样的 p(下⾬)>p(不下⾬),因此今天的天⽓预报肯定预报下⾬。

这是通过⼀定的⽅法计算概率从⽽对下⾬事件进⾏判断。

2.条件概率若Ω是全集,A、B是其中的事件(⼦集),P表⽰事件发⽣的概率,则条件概率表⽰某个事件发⽣时另⼀个事件发⽣的概率。

假设事件B发⽣后事件A发⽣的概率为:设P(A)>0,则有 P(AB) = P(B|A)P(A) = P(A|B)P(B)。

设A、B、C为事件,且P(AB)>0,则有 P(ABC) = P(A)P(B|A)P(C|AB)。

朴素贝叶斯分类数据集

朴素贝叶斯分类数据集

朴素贝叶斯分类是一种基于贝叶斯定理的简单概率分类器。

它假设特征之间是相互独立的(即朴素)。

以下是一个使用朴素贝叶斯分类器的数据集示例:

数据集名称:Iris 数据集

数据集来源:Iris 数据集是一个常用的机器学习数据集,包含了150 个样本,每个样本有4 个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和3 个类别标签(山鸢尾、杂种鸢尾和维吉尼亚鸢尾)。

数据集格式:通常以CSV 格式存储,第一列是标签,后面几列是特征。

数据集示例:

```

标签,花萼长度,花萼宽度,花瓣长度,花瓣宽度

山鸢尾,5.1,3.5,1.4,0.2

杂种鸢尾,4.9,3.0,1.7,0.2

维吉尼亚鸢尾,5.6,3.9,5.1,1.8

...

```

这个数据集可以用Python 的Scikit-learn 库来加载和使用,其中包含了高斯朴素贝叶斯分类器、多项式朴素贝叶斯分类器和伯努利朴素贝叶斯分类器等不同的分类器模型。

例如,使用高斯朴素贝叶斯分类器进行分类的代码示例如下:

```python

from sklearn.datasets import load_iris

from sklearn.naive_bayes import GaussianNB

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 创建高斯朴素贝叶斯分类器对象gnb = GaussianNB()

# 使用训练数据训练分类器gnb.fit(X, y)

# 对测试数据进行预测

y_pred = gnb.predict(X)

```。

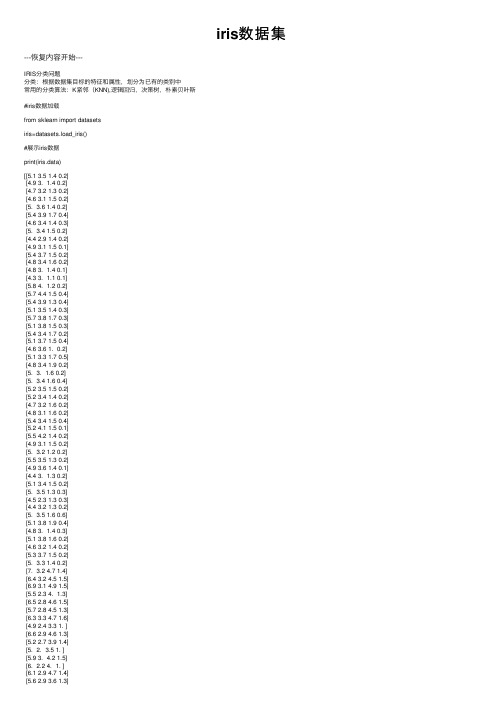

iris数据集

iris数据集---恢复内容开始---IRIS分类问题分类:根据数据集⽬标的特征和属性,划分为已有的类别中常⽤的分类算法:K紧邻(KNN),逻辑回归,决策树,朴素贝叶斯#iris数据加载from sklearn import datasetsiris=datasets.load_iris()#展⽰iris数据print(iris.data)[[5.1 3.5 1.4 0.2][4.9 3. 1.4 0.2][4.7 3.2 1.3 0.2][4.6 3.1 1.5 0.2][5. 3.6 1.4 0.2][5.4 3.9 1.7 0.4][4.6 3.4 1.4 0.3][5. 3.4 1.5 0.2][4.4 2.9 1.4 0.2][4.9 3.1 1.5 0.1][5.4 3.7 1.5 0.2][4.8 3.4 1.6 0.2][4.8 3. 1.4 0.1][4.3 3. 1.1 0.1][5.8 4. 1.2 0.2][5.7 4.4 1.5 0.4][5.4 3.9 1.3 0.4][5.1 3.5 1.4 0.3][5.7 3.8 1.7 0.3][5.1 3.8 1.5 0.3][5.4 3.4 1.7 0.2][5.1 3.7 1.5 0.4][4.6 3.6 1. 0.2][5.1 3.3 1.7 0.5][4.8 3.4 1.9 0.2][5. 3. 1.6 0.2][5. 3.4 1.6 0.4][5.2 3.5 1.5 0.2][5.2 3.4 1.4 0.2][4.7 3.2 1.6 0.2][4.8 3.1 1.6 0.2][5.4 3.4 1.5 0.4][5.2 4.1 1.5 0.1][5.5 4.2 1.4 0.2][4.9 3.1 1.5 0.2][5. 3.2 1.2 0.2][5.5 3.5 1.3 0.2][4.9 3.6 1.4 0.1][4.4 3. 1.3 0.2][5.1 3.4 1.5 0.2][5. 3.5 1.3 0.3][4.5 2.3 1.3 0.3][4.4 3.2 1.3 0.2][5. 3.5 1.6 0.6][5.1 3.8 1.9 0.4][4.8 3. 1.4 0.3][5.1 3.8 1.6 0.2][4.6 3.2 1.4 0.2][5.3 3.7 1.5 0.2][5. 3.3 1.4 0.2][7. 3.2 4.7 1.4][6.4 3.2 4.5 1.5][6.9 3.1 4.9 1.5][5.5 2.3 4. 1.3][6.5 2.8 4.6 1.5][5.7 2.8 4.5 1.3][6.3 3.3 4.7 1.6][4.9 2.4 3.3 1. ][6.6 2.9 4.6 1.3][5.2 2.7 3.9 1.4][5. 2. 3.5 1. ][5.6 3. 4.5 1.5][5.8 2.7 4.1 1. ][6.2 2.2 4.5 1.5] [5.6 2.5 3.9 1.1][5.9 3.2 4.8 1.8][6.1 2.8 4. 1.3] [6.3 2.5 4.9 1.5] [6.1 2.8 4.7 1.2] [6.4 2.9 4.3 1.3] [6.6 3. 4.4 1.4] [6.8 2.8 4.8 1.4] [6.7 3. 5. 1.7] [6. 2.9 4.5 1.5] [5.7 2.6 3.5 1. ] [5.5 2.4 3.8 1.1] [5.5 2.4 3.7 1. ][5.8 2.7 3.9 1.2][6. 2.7 5.1 1.6][5.4 3. 4.5 1.5][6. 3.4 4.5 1.6] [6.7 3.1 4.7 1.5] [6.3 2.3 4.4 1.3] [5.6 3. 4.1 1.3] [5.5 2.5 4. 1.3][5.5 2.6 4.4 1.2][6.1 3. 4.6 1.4] [5.8 2.6 4. 1.2] [5. 2.3 3.3 1. ] [5.6 2.7 4.2 1.3] [5.7 3. 4.2 1.2][5.7 2.9 4.2 1.3][6.2 2.9 4.3 1.3] [5.1 2.5 3. 1.1][5.7 2.8 4.1 1.3][6.3 3.3 6. 2.5] [5.8 2.7 5.1 1.9] [7.1 3. 5.9 2.1] [6.3 2.9 5.6 1.8][6.5 3. 5.8 2.2][7.6 3. 6.6 2.1] [4.9 2.5 4.5 1.7] [7.3 2.9 6.3 1.8][6.7 2.5 5.8 1.8][7.2 3.6 6.1 2.5] [6.5 3.2 5.1 2. ] [6.4 2.7 5.3 1.9] [6.8 3. 5.5 2.1] [5.7 2.5 5. 2. ][5.8 2.8 5.1 2.4][6.4 3.2 5.3 2.3][6.5 3. 5.5 1.8][7.7 3.8 6.7 2.2] [7.7 2.6 6.9 2.3] [6. 2.2 5. 1.5] [6.9 3.2 5.7 2.3] [5.6 2.8 4.9 2. ] [7.7 2.8 6.7 2. ] [6.3 2.7 4.9 1.8][6.7 3.3 5.7 2.1][7.2 3.2 6. 1.8] [6.2 2.8 4.8 1.8] [6.1 3. 4.9 1.8][6.4 2.8 5.6 2.1][7.2 3. 5.8 1.6] [7.4 2.8 6.1 1.9] [7.9 3.8 6.4 2. ] [6.4 2.8 5.6 2.2] [6.3 2.8 5.1 1.5][6.1 2.6 5.6 1.4][7.7 3. 6.1 2.3] [6.3 3.4 5.6 2.4] [6.4 3.1 5.5 1.8] [6. 3. 4.8 1.8] [6.9 3.1 5.4 2.1] [6.7 3.1 5.6 2.4] [6.9 3.1 5.1 2.3][5.8 2.7 5.1 1.9][6.8 3.2 5.9 2.3] [6.7 3.3 5.7 2.5]In [3]:#打印出属性名称print(iris.feature_names)['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)'] In [4]:#打印输出的结果print(iris.target)[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 00 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 11 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 12 2 2 2 2 2 2 2 2 2 22 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 22 2]In [5]:#结果的含义print(iris.target_names)['setosa' 'versicolor' 'virginica']In [6]:#确认数据类型print(type(iris.data))<class 'numpy.ndarray'>In [7]:print(type(iris.target))<class 'numpy.ndarray'>In [8]:#确认输⼊的数据维度,⾏列print(iris.data.shape)(150, 4)In [9]:#确认输出数据的维度,只有1列print(iris.target.shape)(150,)In [10]:#x输⼊数据赋值,y输出数据赋值x=iris.datay=iris.targetIn [11]:#确认xprint(x)[[5.1 3.5 1.4 0.2][4.9 3. 1.4 0.2][5.4 3.7 1.5 0.2] [4.8 3.4 1.6 0.2] [4.8 3. 1.4 0.1][4.3 3. 1.1 0.1][5.8 4. 1.2 0.2] [5.7 4.4 1.5 0.4] [5.4 3.9 1.3 0.4] [5.1 3.5 1.4 0.3] [5.7 3.8 1.7 0.3] [5.1 3.8 1.5 0.3] [5.4 3.4 1.7 0.2] [5.1 3.7 1.5 0.4][4.6 3.6 1. 0.2][5.1 3.3 1.7 0.5][4.8 3.4 1.9 0.2][5. 3. 1.6 0.2] [5. 3.4 1.6 0.4] [5.2 3.5 1.5 0.2] [5.2 3.4 1.4 0.2] [4.7 3.2 1.6 0.2][4.8 3.1 1.6 0.2][5.4 3.4 1.5 0.4] [5.2 4.1 1.5 0.1] [5.5 4.2 1.4 0.2][4.9 3.1 1.5 0.2][5. 3.2 1.2 0.2] [5.5 3.5 1.3 0.2] [4.9 3.6 1.4 0.1][4.4 3. 1.3 0.2][5.1 3.4 1.5 0.2] [5. 3.5 1.3 0.3] [4.5 2.3 1.3 0.3][4.4 3.2 1.3 0.2][5. 3.5 1.6 0.6] [5.1 3.8 1.9 0.4][4.8 3. 1.4 0.3][5.1 3.8 1.6 0.2][4.6 3.2 1.4 0.2][5.3 3.7 1.5 0.2] [5. 3.3 1.4 0.2] [7. 3.2 4.7 1.4] [6.4 3.2 4.5 1.5] [6.9 3.1 4.9 1.5][5.5 2.3 4. 1.3][6.5 2.8 4.6 1.5][5.7 2.8 4.5 1.3][6.3 3.3 4.7 1.6] [4.9 2.4 3.3 1. ] [6.6 2.9 4.6 1.3] [5.2 2.7 3.9 1.4] [5. 2. 3.5 1. ][5.9 3. 4.2 1.5][6. 2.2 4. 1. ] [6.1 2.9 4.7 1.4][5.6 2.9 3.6 1.3][6.7 3.1 4.4 1.4] [5.6 3. 4.5 1.5][5.8 2.7 4.1 1. ][6.2 2.2 4.5 1.5] [5.6 2.5 3.9 1.1][5.9 3.2 4.8 1.8][6.1 2.8 4. 1.3] [6.3 2.5 4.9 1.5] [6.1 2.8 4.7 1.2] [6.4 2.9 4.3 1.3] [6.6 3. 4.4 1.4] [6.8 2.8 4.8 1.4] [6.7 3. 5. 1.7] [6. 2.9 4.5 1.5] [5.7 2.6 3.5 1. ] [5.5 2.4 3.8 1.1] [5.5 2.4 3.7 1. ][5.8 2.7 3.9 1.2][6. 2.7 5.1 1.6][5.4 3. 4.5 1.5][6. 3.4 4.5 1.6][5.6 2.7 4.2 1.3][5.7 3. 4.2 1.2][5.7 2.9 4.2 1.3][6.2 2.9 4.3 1.3][5.1 2.5 3. 1.1][5.7 2.8 4.1 1.3][6.3 3.3 6. 2.5][5.8 2.7 5.1 1.9][7.1 3. 5.9 2.1][6.3 2.9 5.6 1.8][6.5 3. 5.8 2.2][7.6 3. 6.6 2.1][4.9 2.5 4.5 1.7][7.3 2.9 6.3 1.8][6.7 2.5 5.8 1.8][7.2 3.6 6.1 2.5][6.5 3.2 5.1 2. ][6.4 2.7 5.3 1.9][6.8 3. 5.5 2.1][5.7 2.5 5. 2. ][5.8 2.8 5.1 2.4][6.4 3.2 5.3 2.3][6.5 3. 5.5 1.8][7.7 3.8 6.7 2.2][7.7 2.6 6.9 2.3][6. 2.2 5. 1.5][6.9 3.2 5.7 2.3][5.6 2.8 4.9 2. ][7.7 2.8 6.7 2. ][6.3 2.7 4.9 1.8][6.7 3.3 5.7 2.1][7.2 3.2 6. 1.8][6.2 2.8 4.8 1.8][6.1 3. 4.9 1.8][6.4 2.8 5.6 2.1][7.2 3. 5.8 1.6][7.4 2.8 6.1 1.9][7.9 3.8 6.4 2. ][6.4 2.8 5.6 2.2][6.3 2.8 5.1 1.5][6.1 2.6 5.6 1.4][7.7 3. 6.1 2.3][6.3 3.4 5.6 2.4][6.4 3.1 5.5 1.8][6. 3. 4.8 1.8][6.9 3.1 5.4 2.1][6.7 3.1 5.6 2.4][6.9 3.1 5.1 2.3][5.8 2.7 5.1 1.9][6.8 3.2 5.9 2.3][6.7 3.3 5.7 2.5][6.7 3. 5.2 2.3][6.3 2.5 5. 1.9][6.5 3. 5.2 2. ][6.2 3.4 5.4 2.3][5.9 3. 5.1 1.8]]In [12]:#确认yprint(y)[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 00 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 11 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 12 2 2 2 2 2 2 2 2 2 2#使⽤scikit-learn建模四步骤#1,模型调⽤from sklearn.neighbors import KNeighborsClassifierIn [14]:#2,创建实例knn=KNeighborsClassifier(n_neighbors=1)In [15]:print(knn)KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski', metric_params=None, n_jobs=None, n_neighbors=1, p=2, weights='uniform')In [16]:#3,模型训练knn.fit(x,y)Out[16]:KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski', metric_params=None, n_jobs=None, n_neighbors=1, p=2, weights='uniform')In [18]:#4,模型对⼀个样本的预测knn.predict([[1,2,3,4]])In [19]:#模型对多个样本的预测x_test=[[1,2,3,4],[2,4,1,2]]knn.predict(x_test)Out[19]:array([2, 0])In [20]:#设定⼀个新的k值进⾏KNN建模knn_5=KNeighborsClassifier(n_neighbors=5)knn_5.fit(x,y)knn.predict(x_test)Out[20]:array([2, 0])In [21]:#确认模型结构print(knn_5)KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski', metric_params=None, n_jobs=None, n_neighbors=5, p=2, weights='uniform')In [ ]:---恢复内容结束---。

朴素贝叶斯模型的类别

朴素贝叶斯模型的类别全文共四篇示例,供读者参考第一篇示例:朴素贝叶斯模型的分类主要分为三类:高斯朴素贝叶斯、多项式朴素贝叶斯和伯努利朴素贝叶斯。

接下来分别介绍这三种不同类型的朴素贝叶斯模型及其应用场景。

一、高斯朴素贝叶斯高斯朴素贝叶斯模型假设特征的分布服从高斯分布,即特征的概率密度函数为高斯分布。

这种模型适用于连续型特征,例如数值型数据。

在实际应用中,高斯朴素贝叶斯模型通常用于处理连续型数据的分类问题,如人脸识别、手写数字识别等。

二、多项式朴素贝叶斯多项式朴素贝叶斯模型假设特征的分布服从多项式分布,即特征是离散型的且取值范围有限。

这种模型适用于文本分类等问题,其中特征通常是单词或短语的出现次数或权重。

在实际应用中,多项式朴素贝叶斯模型常用于文本分类、垃圾邮件过滤等问题。

朴素贝叶斯模型是一种简单且高效的分类算法,具有快速的训练速度和较好的分类性能。

不同类型的朴素贝叶斯模型适用于不同类型的特征分布和问题类型,可以根据具体情况选择合适的模型来解决分类问题。

在实际应用中,朴素贝叶斯模型被广泛应用于文本分类、垃圾邮件过滤、情感分析等领域,并取得了不错的效果。

第二篇示例:朴素贝叶斯是一种被广泛使用的机器学习分类算法,其原理简单但却非常有效。

它的原理基于贝叶斯定理,通过对已知数据集的特征进行概率推断来对未知数据进行分类。

朴素贝叶斯模型最初是由英国数学家托马斯·贝叶斯提出的,它的核心思想是基于特征之间的独立性假设。

朴素贝叶斯模型的类别主要可以分为三种:高斯朴素贝叶斯、多项式朴素贝叶斯和伯努利朴素贝叶斯。

1. 高斯朴素贝叶斯高斯朴素贝叶斯是一种适用于连续型数据的分类算法。

在高斯朴素贝叶斯中,假设特征的概率符合高斯分布,通过计算每个特征在每个类别下的概率密度函数来进行分类。

因为高斯分布在实际数据中很常见,因此高斯朴素贝叶斯在实际应用中有着广泛的应用。

伯努利朴素贝叶斯也适用于离散型数据的分类问题,但与多项式朴素贝叶斯不同的是,伯努利朴素贝叶斯适用于二值型数据,即特征只有两种取值。

监督学习算法基础知识整理

第三章监督学习算法监督学习又称为分类(Classification)或者归纳学习(Inductive Learning)。

几乎适用于所有领域,包括文本和网页处理。

给出一个数据集D,机器学习的目标就是产生一个联系属性值集合A和类标集合C的分类/预测函数(Classification/Prediction Function),这个函数可以用于预测新的属性集合的类标。

这个函数又被称为分类模型(Classification Model)、预测模型(Prediction Model)。

这个分类模型可以是任何形式的,例如决策树、规则集、贝叶斯模型或者一个超平面。

在监督学习(Supervised Learning)中,已经有数据给出了类标;与这一方式相对的是无监督学习(Unsupervised Learning),在这种方式中,所有的类属性都是未知的,算法需要根据数据集的特征自动产生类属性。

其中算法中用于进行学习的数据集叫做训练数据集,当使用学习算法用训练数据集学习得到一个模型以后,我们使用测试数据集来评测这个模型的精准度。

机器学习的最基本假设:训练数据的分布应该与测试数据的分布一致。

训练算法:训练算法就是给定一组样本,我们计算这些参数的方法。

本节简要介绍以下几种常用的机器学习算法,比如决策树,朴素贝叶斯,神经网络,支持向量机,线性最小平方拟合,kNN,最大熵等。

3.1 两类感知器见课本3.2 多类感知器见课本3.3 决策树算法决策树学习算法是分类算法中最广泛应用的一种技术,这种算法的分类精度与其他算法相比具有相当的竞争力,并且十分高效。

决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。

树中每个节点表示某个对象属性,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值(类别)。

决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。

时间序列分类算法

时间序列分类算法

时间序列分类是指将时间序列数据分为不同的类别或标签。

以下是几种常用的时间序列分类算法:

1.K-近邻算法(K-NN):这是一种无参数算法,通过计算样本之间的距离来对样本进行分类。

KNN算法通过选取与当前样本距离最近的K个样本的多数投票来预测该样本的分类。

该算法适用于简单分类问题,但对于大规模数据集会面临计算时间和空间方面的问题。

2.支持向量机(SVM):SVM尝试找到一个分隔面来将两个不同的类分开。

通常使用核技巧来处理非线性分类任务。

该算法适用于复杂分类问题和数据集较小时的问题。

3.决策树:决策树通过从样本数据中学习规则来判断分类。

学习过程基于信息熵等度量标准运作。

每个决策树节点考虑一个属性,并将样本分成子集,树的分支根据属性值来分配。

分类树是最常见的决策树。

4.随机森林:随机森林是一种基于决策树构建的集成学习算法。

在随机森林分类器中,许多决策树构成了一个固定大小的森林。

其随机性来自于每个子树使用的样本和属性数量,属性被随机选择。

5.神经网络模型:神经网络模型是一种非常灵活和可扩展的模型,因其设计灵活性和能够在大数据集上进行训练而受到广泛关注。

在时间序列分类任务中,循环神经网络(RNNs)和卷积神经网络(CNNs)是最常用的神经网络模型之一。

RNNs可以对序列数据建模,而CNNs可以对时间序列进行滚动卷积操作,以捕捉局部模式和全局模式。

这些算法可用于分类各种时间序列数据,如股票、气象、心电图等数据。

选择哪个算法最适用于特定任务取决于数据集的特点和应用场景。

人工智能岗位招聘笔试题与参考答案(某大型国企)2025年

2025年招聘人工智能岗位笔试题与参考答案(某大型国企)(答案在后面)一、单项选择题(本大题有10小题,每小题2分,共20分)1、以下哪项不是人工智能领域常用的算法?A、决策树算法B、支持向量机算法C、神经网络算法D、遗传算法E、牛顿迭代法2、以下哪个概念不属于人工智能的范畴?A、机器学习B、自然语言处理C、人机交互D、量子计算E、数据挖掘3、以下哪项不是人工智能常见的应用领域?A、自动驾驶B、自然语言处理C、基因编辑D、云计算4、在机器学习算法中,以下哪种算法属于监督学习?A、K-means聚类B、决策树C、朴素贝叶斯D、Apriori算法5、以下哪个算法属于无监督学习算法?A. 决策树B. K最近邻(KNN)C. 朴素贝叶斯D. 主成分分析(PCA)6、以下哪个指标用于评估分类模型?A. 精确率(Precision)B. 召回率(Recall)C. F1值(F1 Score)D. 真正例率(True Positive Rate)7、在以下哪种情况下,使用深度学习模型进行图像识别的效果最佳?A. 图像分辨率非常低,仅有几像素B. 图像分辨率较高,但存在大量噪声C. 图像分辨率中等,且清晰无噪声D. 图像分辨率极高,但只有一张图片8、以下哪个不是人工智能领域的常见监督学习算法?A. 支持向量机(SVM)B. 决策树C. 随机森林D. 遗传算法9、题干:在以下人工智能技术中,哪项技术通常用于实现自然语言处理中的情感分析?A. 深度学习B. 机器学习C. 支持向量机D. 专家系统 10、题干:以下哪项不是人工智能在制造业中常见的应用场景?A. 智能机器人进行生产线上的装配工作B. 利用人工智能进行产品质量检测C. 通过人工智能技术实现生产线自动化控制D. 在办公室内进行文件归档和管理二、多项选择题(本大题有10小题,每小题4分,共40分)1、以下哪些技术属于人工智能领域的前沿技术?()A. 深度学习B. 自然语言处理C. 机器人技术D. 虚拟现实E. 量子计算2、以下关于人工智能伦理原则的说法,正确的是?()A. 人工智能系统应确保用户隐私保护B. 人工智能系统应避免歧视性决策C. 人工智能系统应具备自我意识D. 人工智能系统应保证其决策过程的透明度E. 人工智能系统应优先考虑经济效益3、以下哪些技术或方法属于人工智能领域?()A、机器学习B、自然语言处理C、深度学习D、云计算E、区块链4、以下关于人工智能伦理问题的描述,正确的是?()A、人工智能应尊重人类价值观和道德规范B、人工智能不应侵犯个人隐私C、人工智能系统应具备公平性,避免歧视D、人工智能的决策过程应透明可追溯E、人工智能的发展不应以牺牲环境为代价5、以下哪些是人工智能领域中常用的算法?()A. 深度学习B. 支持向量机C. 遗传算法D. 聚类算法E. 神经网络6、以下哪些是人工智能在工业自动化领域的应用?()A. 自动化机器人B. 智能监控系统C. 无人驾驶汽车D. 智能制造系统E. 传统制造业的自动化改造7、以下哪些技术属于人工智能的核心技术?()A. 机器学习B. 深度学习C. 自然语言处理D. 计算机视觉E. 云计算8、以下关于人工智能伦理的描述,正确的是?()A. 人工智能应遵循公平、公正、公开的原则B. 人工智能的发展不应损害人类的利益和尊严C. 人工智能系统应具备自我保护能力D. 人工智能的决策过程应完全透明9、以下哪些技术是人工智能领域中常用的自然语言处理(NLP)技术?()A. 机器翻译B. 语音识别C. 情感分析D. 深度学习 10、以下哪些算法在人工智能领域中常用于图像识别?()A. 支持向量机(SVM)B. 卷积神经网络(CNN)C. 决策树D. 随机森林三、判断题(本大题有10小题,每小题2分,共20分)1、人工智能系统在处理复杂问题时,其性能会随着问题规模的增加而线性下降。

基于weka的数据分类分析实验报告

基于weka的数据分类分析实验报告1实验基本内容本实验的基本内容是通过使用weka中的三种常见分类方法(朴素贝叶斯,KNN和决策树)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理格式转换方法原始数据是excel文件保存的xlsx格式数据,需要转换成Weka支持的arff文件格式或csv文件格式。

由于Weka对arff格式的支持更好,这里我们选择arff格式作为分类器原始数据的保存格式。

转换方法:在excel中打开“”,选择菜单文件->另存为,在弹出的对话框中,文件名输入“total_data”,保存类型选择“CSV(逗号分隔)”,保存,我们便可得到“”文件;然后,打开Weka的Exporler,点击Open file按钮,打开刚才得到的“total_data”文件,点击“save”按钮,在弹出的对话框中,文件名输入“total_data”,文件类型选择“Arff data files(*.arff)”,这样得到的数据文件为“”。

如何建立数据训练集,校验集和测试集数据的预处理过程中,为了在训练模型、评价模型和使用模型对数据进行预测能保证一致性和完整性,首先要把和合并在一起,因为在生成arff文件的时候,可能会出现属性值不一样的情况,否则将为后来的测试过程带来麻烦。

通过统计数据信息,发现带有类标号的数据一共有100行,为了避免数据的过度拟合,必须把数据训练集和校验集分开,目前的拆分策略是各50行。

类标号为‘female’的数据有21条,而类标号为‘male’的数据有79条,这样目前遇到的问题是,究竟如何处理仅有的21条female数据?为了能在训练分类模型时有更全面的信息,所以决定把包含21条female类标号数据和29条male类标号数据作为模型训练数据集,而剩下的另49条类标号类male的数据将全部用于校验数据集,这是因为在校验的时候,两种类标号的数据的作用区别不大,而在训练数据模型时,则更需要更全面的信息,特别是不同类标号的数据的合理比例对训练模型的质量有较大的影响。

分类数据展示实验报告(3篇)

第1篇一、实验目的本实验旨在通过实践操作,掌握分类数据展示的基本方法,了解不同展示方式的特点和适用场景,并学会使用相关工具进行数据可视化。

通过对实验数据的分类与展示,加深对分类数据理解和分析能力。

二、实验环境1. 操作系统:Windows 102. 数据分析工具:Python3.8、NumPy、Pandas、Matplotlib、Seaborn3. 数据集:Iris数据集(鸢尾花数据集)三、实验步骤1. 数据导入与预处理- 使用Pandas库读取Iris数据集,并将数据存储为DataFrame对象。

- 检查数据是否存在缺失值,并对缺失值进行处理。

- 对数据进行类型转换,确保数据格式正确。

2. 数据探索- 使用Pandas库中的描述性统计函数,对数据进行基本统计分析,了解数据的分布情况。

- 绘制数据分布图,如直方图、箱线图等,观察数据的分布特征。

3. 数据分类- 使用决策树、支持向量机、朴素贝叶斯等分类算法对数据进行分类。

- 调整模型参数,选择最优模型。

4. 数据展示- 使用Matplotlib和Seaborn库,绘制不同类型的图表,如散点图、柱状图、折线图、热力图等。

- 展示不同分类结果,对比不同算法的性能。

5. 结果分析- 分析不同展示方式的特点和适用场景。

- 对比不同算法的性能,总结优缺点。

四、实验结果与分析1. 数据探索- 通过描述性统计和图表,我们发现Iris数据集包含4个特征:花萼长度、花萼宽度、花瓣长度、花瓣宽度。

- 通过散点图,我们可以观察到不同类别在特征空间中的分布情况。

2. 数据分类- 使用决策树算法对数据进行分类,准确率为0.977。

- 使用支持向量机算法对数据进行分类,准确率为0.988。

- 使用朴素贝叶斯算法对数据进行分类,准确率为0.987。

3. 数据展示- 使用散点图展示不同类别在特征空间中的分布情况。

- 使用柱状图展示不同特征的分布情况。

- 使用热力图展示特征之间的相关性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

问题

1、女神喜欢的概率?

2、职业是程序员并且体型匀称的概率? 3、在女神喜欢的条件下,职业是程序员的概率? 4、在女神喜欢的条件下,职业是产品,体重是超重的概率?

联合概率和条件概率

P(文档类别1|文档特征值)

P(文档类别2|文档特征值)

… …

朴素贝叶斯-贝叶斯公式

公式分为三个部分:

训练集统计结果(指定统计词频):

来源:KNN算法最早是由Cover和Hart提出的一种分类算法

计算距离公式

两个样本的距离可以通过如下公式计算,又叫欧式距离 比如说,a(a1,a2,a3),b(b1,b2,b3)

结合我们之前讲的约会数据例子,在计算两个样本数据的距 离时特征有什么影响?需要对数据做些什么?

sklearn k-近邻算法API

Sklearn 朴素贝叶斯,决策树

课程第二天

1、sklearn数据集与估计器 2、分类算法-k近邻算法 3、k-近邻算法实例 4、分类模型的评估 5、分类算法-朴素贝叶斯算法 6、朴素贝叶斯算法实例 7、模型的选择与调优 8、决策树与随机森林

sklearn数据集

1、数据集划分 2、sklearn数据集接口介绍 3、 sklearn分类数据集 4、 sklearn回归数据集

实例流程

1、数据集的处理 2、分割数据集 3、对数据集进行标准化 4、estimator流程进行分类预测

问题

1、k值取多大?有什么影响? k值取很小:容易受异常点影响 k值取很大:容易受最近数据太多导致比例变化 2、性能问题?

k-近邻算法优缺点

• 优点: • 简单,易于理解,易于实现,无需估计参数,无需训练

sklearn机器学习算法的实现-估计器

在sklearn中,估计器(estimator)是一个重要的角色,分类器和回归器 都属于estimator,是一类实现了算法的API

1、用于分类的估计器:

• sklearn.neighbors

k-近邻算法

• sklearn.naive_bayes 贝叶斯

• sklearn.linear_model.LogisticRegression

逻辑回归

2、用于回归的估计器: • sklearn.linear_model.LinearRegression • sklearn.linear_model.Ridge 岭回归

线性回归

估计器的工作流程

分类算法-k近邻算法

你的“邻居”来推断出你的类别

分类算法-k近邻算法(KNN)

定义:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近) 的样本中的大多数属于某一个类别,则该样本也属于这个类别。

• x 数据集的特征值 • y 数据集的标签值 • test_size 测试集的大小,一般为float • random_state 随机数种子,不同的种子会造成不同的随机 采样结果。相同的种子采样结果相同。

• return 训练集特征值,测试集特征值,训练标签,测试标签 (默认随机取)

用于分类的大数据集

如果拿到的数据全部都用来训练一个模型?

数据集划分

机器学习一般的数据集会划分为两个部分: 训练数据:用于训练,构建模型 测试数据:在模型检验时使用,用于评估模型是否有效

sklearn数据集划分API

sklearn.model_selection.train_test_split

结合后面的数据集再做演示

classification_report

• sklearn.metrics.classification_report(y_true, y_pred, target_names

• y_true:真实目标值 • y_pred:估计器预测目标值 • target_names:目标类别名称 • return:每个类别精确率与召回率

• sklearn.datasets.fetch_20newsgroups(data_home=None,subset= • subset: 'train'或者'test','all',可选,选择要加载的数据集. 训练集的“训练”,测试集的“测试”,两者的“全部”

• datasets.clear_data_home(data_home=None) • 清除目录下的数据

分类算法-朴素贝叶斯算法

1、概率基础 2、朴素贝叶斯介绍

垃圾邮件分类

金融 成人 欺诈 产品 互联网 休闲 7% 16%

20% 8%

11%

38%

文章4 文章3 文章2 文章1

0%

文章类别概率

20%

40% 科技 金融

60% 娱乐

80%

100%

概率基础

• 概率定义为一件事情发生的可能性 • 扔出一个硬币,结果头像朝上 • 某天是晴天

• 为什么需要这些指标?

精确率(Precision)与召回率(Recall)

• 精确率:预测结果为正例样本中真实为正例的比例(查得准)

• 召回率:真实为正例的样本中预测结果为正例的比例(查的全,对 正样本的区分能力)

• 其他分类标准,F1-score,反映了模型的稳健型

分类模型评估API

• sklearn.metrics.classification_report

• sklearn.model_selection.GridSearchCV

GridSearchCV

• sklearn.model_selection.GridSearchCV(estimator, param_grid =None,cv=None) • 对估计器的指定参数值进行详尽搜索

• estimator:估计器对象 • param_grid:估计器参数(dict){“n_neighbors”:[1,3,5]} • cv:指定几折交叉验证 • fit:输入训练数据 • score:准确率 • 结果分析: • best_score_:在交叉验证中测试的最好结果 • best_estimator_:最好的参数模型 • cv_results_:每次交叉验证后的测试集准确率结果和训练集准确

sklearn分类数据集

sklearn.datasets.load_iris() 加载并返回鸢尾花数据集

sklearn.datasets.load_digits() 加载并返回数字数据集

数据集进行分割

• sklearn.model_selection.train_test_split(*arrays, **options)

sklearn回归数据集

sklearn.datasets.load_boston() 加载并返回波士顿房价数据集

sklearn.datasets.load_diabetes() 加载和返回糖尿病数据集

想一下之前做的特征工程的步骤?

1、实例化 (实例化的是一个转换器类(Transformer))

2、调用fit_transform(对于文档建立分类词频矩阵, 不能同时调用)

判定手机的好用与否

分类模型的评估

• estimator.score() • 一般最常见使用的是准确率,即预测结果正确的百分比

混淆矩阵

• 在分类任务下,预测结果(Predicted Condition)与正确标记 (True Condition)之间存在四种不同的组合,构成混淆矩阵 (适用于多分类)

• 对缺失数据不太敏感,算法也比较简单,常用于文本分类。

• 分类准确度高,速度快 • 缺点:

• 需要知道先验概率P(F1,F2,…|C),因此在某些时候会由于假设的先验 模型的原因导致预测效果不佳。

模型的选择与调优

1、交叉验证 2、网格搜索

交叉验证:为了让被评估的模型更加准确可信

交叉验证过程

交叉验证:将拿到的数据,分为训练和验证集。以下图为例:将数据分 成5份,其中一份作为验证集。然后经过5次(组)的测试,每次都更换不同 的验证集。即得到5组模型的结果,取平均值作为最终结果。又称5折交叉 验证。

• sklearn20类新闻分类 • 20个新闻组数据集包含20个主题的18000个新闻组帖子

朴素贝叶斯案例流程

1、加载20类新闻数据,并进行分割 2、生成文章特征词 3、朴素贝叶斯estimator流程进行预估

朴素贝叶斯分类优缺点

• 优点: • 朴素贝叶斯模型发源于古典数学理论,有稳定的分类效率。

• sklearn.neighbors.KNeighborsClassifier(n_neighbors=5,algorithm='auto

• n_neighbors:int,可选(默认= 5),k_neighbors查询默认 使用的邻居数

• algorithm:{‘auto’,‘ball_tree’,‘kd_tree’, ‘brute’},可选用于计算最近邻居的算法:‘ball_tree’将 会使用 BallTree,‘kd_tree’将使用 KDTree。‘auto’将尝 试根据传递给fit方法的值来决定最合适的算法。 (不同实现方 式影响效率)

超参数搜索-网格搜索

通常情况下,有很多参数是需要手动指定的(如k-近邻算法中的K值), 这种叫超参数。但是手动过程繁杂,所以需要对模型预设几种超参数组 合。每组超参数都采用交叉验证来进行评估。最后选出最优参数组合建 立模型。

K值 模型

K=3 模型1

K=5 模型2

K=7 模型3

超参数搜索-网格搜索API

问题: 自己准备数据集,耗时耗力,不一定真实

scikit-learn数据集API介绍

• sklearn.datasets

• 加载获取流行数据集 • datasets.load_*()

• 获取小规模数据集,数据包含在datasets里

• datasets.fetch_*(data_home=None) • 获取大规模数据集,需要从网络上下载,函 数的第一个参数是data_home,表示数据集 下载的目录,默认是 ~/scikit_learn_data/