openmp与openmpi区别

openmpi跨节点执行命令参数

openmpi跨节点执行命令参数【原创版】目录1.openmpi 概述2.openmpi 跨节点执行的命令参数3.实例说明正文1.openmpi 概述OpenMPI(Open-source MPI)是一个开源的并行计算框架,可以用于构建高性能计算(HPC)系统。

MPI(Message Passing Interface)是一种并行计算的通信协议,OpenMPI 是 MPI 的一种实现。

OpenMPI 提供了一种在分布式系统上实现并行计算的方法,它的设计目标是为了提供高性能、可移植性和易用性。

在 OpenMPI 中,可以通过 mpirun 命令来执行并行任务,这个命令可以跨节点分配任务和资源。

2.openmpi 跨节点执行的命令参数openmpi 跨节点执行的命令参数主要包括以下几个:- "-n":指定并行度,即并行处理的节点数目。

- "-l":指定每个节点上的进程数。

- "-o":指定输出文件。

- "-f":指定输入文件。

- "- Host":指定主机名,用于与主机进行通信。

- "- Port":指定端口号,用于与主机进行通信。

3.实例说明假设我们有一个名为“example.mpi”的并行计算程序,我们希望在两台节点(node1 和 node2)上执行它。

那么,我们可以使用以下命令:```mpirun -n 2 -l 2 -o output -f input example.mpi```这条命令的含义如下:- "-n 2":指定并行度为 2,即在两台节点上执行任务。

- "-l 2":指定每台节点上运行 2 个进程。

- "-o output":指定输出文件名为“output”。

- "-f input":指定输入文件名为“input”。

openmpi跨节点执行命令参数

openmpi跨节点执行命令参数摘要:1.OpenMPi 简介2.OpenMPi 跨节点执行的命令参数3.实例说明4.总结正文:1.OpenMPi 简介OpenMPi 是一种用于并行计算的开源库,尤其适用于高性能计算和超级计算。

它可以在多个处理器核心和多个节点上实现并行处理,从而加速计算任务的执行。

OpenMPi 提供了一套完善的API 和命令行工具,方便用户在不同的计算平台上进行并行应用的开发和部署。

2.OpenMPi 跨节点执行的命令参数OpenMPi 提供了一系列的命令参数,用于控制并行应用的执行。

其中,跨节点执行的命令参数主要包括以下几个:- "-np":指定并行处理的节点数目。

例如,如果一个计算节点有4 个处理器核心,需要使用4 个节点进行并行计算,那么命令参数应为"-np 4"。

- "-mca":指定OpenMPi 使用的内存分配策略。

例如,如果希望在多个节点上分配内存,可以使用"-mca orphan"参数。

- "-map-by":指定并行任务的映射方式。

例如,如果需要在多个节点上并行执行一个任务,可以使用"-map-by slot"参数。

- "-bind-to":指定并行任务绑定的计算节点。

例如,如果希望将一个并行任务绑定到指定的计算节点上,可以使用"-bind-to node"参数。

3.实例说明假设有一个计算密集型任务,需要在4 个处理器核心上并行执行。

那么,可以使用以下OpenMPi 命令参数:```mpirun -np 4 -mca orphan -map-by slot -bind-to none<executable>```这条命令指定了并行处理的节点数目为4,使用OpenMPi 的内存分配策略为orphan,并指定并行任务的映射方式为slot。

高性能计算介绍

常见编译器

Intel Compiler 由Intel公司针对Intel处理器开发(Xeon、Pentium) 支持Linux、Windows 支持C/C++(icc:Intel C/C++ Compiler)、Fortran77/90/95 (ifc: Intel Fortran Compiler) 支持多线程和OpenMP

•ScaLAPACK:可扩展线性代数库(Scalable LAPACK),是LAPACK的增强版本 是美国能源部ODE2000支持开发的20多个ACTS工具箱之一,由Oak Ridge国家 实验室、加州大学Berkeley分校和Illinois大学等联合开发 分布式存储环境运行的线性代数库,主要为可扩放的、分布存储的并行计算机而 设计的 支持稠密和带状矩阵的各类操作,如:乘法、转置、分解等等 开发源码,/scalapack

消息传递编程

常见并行环境——并行编程标准归 类

• 所有并行编程标准可分为以下三类:

– 数据并行

• HPF, Fortran90 • 用于SMP, DSM

– 共享编程

• OpenMP • 用于SMP, DSM

– 消息传递

• MPI, PVM • 用于所有并行计算机

• 三者可混合使用:

– 如对以SMP为节点的Cluster来说, 可以在节点间进行 消息传递,在节点内进行共享变量编程.

IBM Compiler for AIX VisualAge C/C++ for AIX XL Fortran for AIX

在IBM AIX Developer Kit中,包含了Java(TM) 2 Technology Edition支持。 Practical Extraction and Report Language (perl) GNU C/C++ Python

关于OpenMP_一个并行编程接口

THREADPRIVATE ,并且在进入并行区之前给 BL K1 赋初始值为 ZFIELD. 21112 工作共享 (work - sharing) 结构

这一类结构给线程划分工作 ,包括 DO 指导 、 SECTIONS 指 导 、SINGLE 指 导 和 WORKSHARE 指 导. 这些结构可以在并行区内单独使用 ,或者与 PARALLEL 连在一起使用 ,如 PARALLEL DO.

王玉红1 ,刘振中2 ,任 健3

(11 哈尔滨市投资专科学校 , 黑龙江 哈尔滨 150001 ; 21 哈尔滨市环境检测中心站 , 黑龙江 哈尔滨 150076 ; 31 黑龙江大学 计算机学院 , 黑龙江 哈尔滨 150086)

摘 要 :OpenMP 是一个公认的共享存储系统的并行编程接口. 它由一些语言指导 (directives) 及库函数 组成 ,并建立在 Fortran 或者 C、C + + 语言的基础上. 优点是简单 、通用 ,有利于快速开发并行程序. 介 绍了它的发展历史 、执行模型以及它的三个组成部份 , 即语言指导 (一些在 Fortran、C 或 C + + 基础上 增加的注释语句) 、运行库函数 (共有 10 个与执行环境有关的运行库函数) 和 环 境 变 量 ( 设 置 该 OpenMP 执行时所需的线程总数) . 文中还提供了已公开发布的 OpenMP 应用程序的情况 , 并讨论了它 将来的发展趋势. OpenMP 的推广 ,还需要解决它的可扩展性问题. 关键词 :OpenMP ; 共享存储系统 ;指导 ;同步 中图分类号 :TP311 文献标识码 :A 文章编号 :1672 - 0946 (2003) 04 - 0439 - 06

openmp并行运算注意事项

openmp并行运算注意事项随着计算机硬件的不断发展,多核处理器已经成为了计算机的主流配置。

并行计算作为一种利用多个处理器核心来加速计算的技术,得到了越来越多的关注和应用。

OpenMP作为一种简单易用的并行编程模型,为程序员提供了一种方便快捷的并行编程方法。

在使用OpenMP 进行并行编程时,需要注意一些事项,以确保并行程序的正确性和性能。

本文将从几个方面介绍OpenMP并行运算的注意事项。

一、并行区域的选择和设置在OpenMP中,使用#pragma omp parallel指令来创建并行区域。

在选择并行区域时,需要考虑并行区域的大小和并行任务的分配。

过大的并行区域可能会导致线程间的竞争和通信开销增加,过小的并行区域则会导致线程创建和销毁的开销增加。

在选择并行区域时,需要综合考虑计算量和通信开销,选择合适的并行粒度和并行方式。

二、数据共享和数据私有在并行计算中,不可避免地会涉及到数据的共享和数据的私有。

在OpenMP中,可以使用shared和private子句来显式地声明共享变量和私有变量。

需要注意的是,共享变量的并行访问可能会产生数据竞争和不确定的结果,因此需要合理地进行共享变量的访问控制和同步。

而私有变量则可以避免这些问题,但需要注意私有变量的创建和销毁开销,以及私有变量的正确初始化和赋值。

三、线程同步和竞争条件在并行计算中,线程同步和竞争条件是需要特别注意的问题。

在OpenMP中,可以使用critical、atomic和barrier等机制来实现线程同步和避免竞争条件。

需要注意的是,过多的线程同步会影响并行程序的性能,而竞争条件则可能导致程序的错误结果。

在编写并行程序时,需要谨慎地考虑线程同步和竞争条件的设置,以保证程序的正确性和性能。

四、循环并行化和数据依赖在很多科学计算和工程计算中,循环并行化是一种常见的并行优化方法。

在OpenMP中,可以使用#pragma omp for指令来对循环进行并行化。

openmp

openmp private之类的区分10.1.1 private⼦句private⼦句⽤于将⼀个或多个变量声明成线程私有的变量,变量声明成私有变量后,指定每个线程都有它⾃⼰的变量私有副本,其他线程⽆法访问私有副本。

即使在并⾏区域外有同名的共享变量,共享变量在并⾏区域内不起任何作⽤,并且并⾏区域内不会操作到外⾯的共享变量。

private⼦句的⽤法格式如下:private(list)下⾯便是⼀个使⽤private⼦句的代码例⼦:int k = 100;#pragma omp parallel for private(k)for ( k=0; k < 10; k++){printf("k=%d/n", k);}printf("last k=%d/n", k);上⾯程序执⾏后打印的结果如下:k=6k=7k=8k=9k=0k=1k=2k=3k=4k=5last k=100从打印结果可以看出,for循环前的变量k和循环区域内的变量k其实是两个不同的变量。

⽤private⼦句声明的私有变量的初始值在并⾏区域的⼊⼝处是未定义的,它并不会继承同名共享变量的值。

出现在reduction⼦句中的参数不能出现在private⼦句中。

10.1.2 firstprivate⼦句private声明的私有变量不能继承同名变量的值,但实际情况中有时需要继承原有共享变量的值,OpenMP提供了firstprivate⼦句来实现这个功能。

先看⼀下以下的代码例⼦int k = 100;#pragma omp parallel for firstprivate(k)for ( i=0; i < 4; i++){k+=i;printf("k=%d/n",k);}printf("last k=%d/n", k);上⾯代码执⾏后打印结果如下:k=100k=101k=103k=102last k=100从打印结果可以看出,并⾏区域内的私有变量k继承了外⾯共享变量k的值100作为初始值,并且在退出并⾏区域后,共享变量k的值保持为100未变。

openmp并行编程

12

OpenMP编译制导

10:49

13

OpenMP的并行化是通过使用嵌入到C/C++或 Fortran源代码中的编译制导语句来实现。 编译制导是对程序设计语言的扩展。 支持并行区域、工作共享、同步等。 支持数据的共享和私有化。 通过对串行程序添加制导语句实现并行化

10:49

14

制导语句格式

编译制导语句由下列几部分组成: 制导标识符 ( !$OMP 、 #pragma omp ) 制导名称(parallel,DO/for,section等) 制导名称 子句( 子句 privated ,shared,reduction,copyin等) 格式:制导标识符 制导名称 [Cluase,]

schedulescheduledynamicscheduleguided类似于dynamic调度但区间开始大然后迭代区间越来越少循环区间的划分是基于类似下列公式完成的不同的编译系统可能不同

OpenMP并行编程

主讲人: 赵永华 中科院计算机网络信息中心 超级计算中心 yhzhao@

OpenMP编程简介 OPenMP编程制导 OpenMP库函数 OpenMP OpenMP环境变量 OpenMP计算实例

10:49

10

OpenMP程序结构

基于Fortran语言的OpenMP程序结构 PROGRAM PROG_NAME INTEGER VAR1, VAR2 ,VAR3 ………. !$OMP PARALLEL PRIVATE(VAR1, VAR2) SHARED(VAR3) ………. !$OMP END PARALLEL …… END

9

编译执行: 编译执行: efc -openmp –o HelloWorld HelloWorld.c ./HelloWorld 运行结果: 运行结果: Hello World from OpenMP thread 2 Hello World from OpenMP thread 0 Number of threads 4 Hello World from OpenMP thread 3 Hello World from OpenMP thread 1

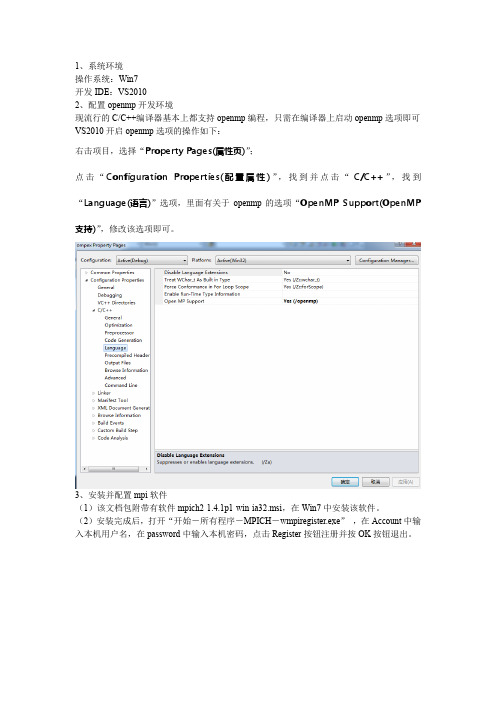

openmp和mpi环境配置

1、系统环境操作系统:Win7开发IDE:VS20102、配置openmp开发环境现流行的C/C++编译器基本上都支持openmp编程,只需在编译器上启动openmp选项即可VS2010开启openmp选项的操作如下:右击项目,选择“Property Pages(属性页)”;点击“Configuration Properties(配置属性)”,找到并点击“C/C++”,找到“Language(语言)”选项,里面有关于openmp的选项“OpenMP Support(OpenMP 支持)”,修改该选项即可。

3、安装并配置mpi软件(1)该文档包附带有软件mpich2-1.4.1p1-win-ia32.msi,在Win7中安装该软件。

(2)安装完成后,打开“开始-所有程序-MPICH-wmpiregister.exe”,在Account中输入本机用户名,在password中输入本机密码,点击Register按钮注册并按OK按钮退出。

(3)在VS2010中,配置VC++ Directories选项。

在VS2010中,VC++ Directories在Solution Explorer中,在项目名称上右键选择Properties,即进入Property Pages窗口。

(4)展开左边Configuration Properties,选中其中的VC++ Directories,在右边Include Directories加入“C:\Program Files\MPICH2\include;”(mpi安装目录里)(5)展开左边Configuration Properties,选中其中的VC++ Directories,在右边Library Directories加入“C:\Program Files\MPICH2\lib;”(6)展开左边Configuration Properties中的C/C++,选中其中的Preprocessor,在右边的Preprocessor Definitions中加入“MPICH_SKIP_MPICXX;”(7)同样展开C/C++,选中Code Generation,把右边的Runtime Library更改为“Multi-threaded Debug (/MTd)”(此外有下拉菜单可选到它)(8)展开左边的Linker,选中Input,在右边Additional Dependencies中加入“mpi.lib;”(9)运行MPI程序打开“开始-所有程序-MPICH-wmpiexec.exe”,在Applicationd右边浏览找到你在VS2010中生成的exe文件,设置Number of processes(即进程数目,用来模拟并行计算的CPU数目)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Lammps Mac 的并行之路openmp与openmpi区别openmp比较简单,修改现有的大段代码也容易。

基本上openmp只要在已有程序基础上根据需要加并行语句即可。

而mpi有时甚至需要从基本设计思路上重写整个程序,调试也困难得多,涉及到局域网通信这一不确定的因素。

不过,openmp虽然简单却只能用于单机多CPU/多核并行,mpi才是用于多主机超级计算机集群的强悍工具,当然复杂。

(1)MPI=message passing interface:在分布式内存(distributed-memory)之间实现信息通讯的一种规范/标准/协议(standard)。

它是一个库,不是一门语言。

可以被fortran,c,c++等调用。

MPI允许静态任务调度,显示并行提供了良好的性能和移植性,用 MPI 编写的程序可直接在多核集群上运行。

在集群系统中,集群的各节点之间可以采用 MPI 编程模型进行程序设计,每个节点都有自己的内存,可以对本地的指令和数据直接进行访问,各节点之间通过互联网络进行消息传递,这样设计具有很好的可移植性,完备的异步通信功能,较强的可扩展性等优点。

MPI 模型存在一些不足,包括:程序的分解、开发和调试相对困难,而且通常要求对代码做大量的改动;通信会造成很大的开销,为了最小化延迟,通常需要大的代码粒度;细粒度的并行会引发大量的通信;动态负载平衡困难;并行化改进需要大量地修改原有的串行代码,调试难度比较大。

(2)MPICH和OpenMPI:它们都是采用MPI标准,在并行计算中,实现节点间通信的开源软件。

各自有各自的函数,指令和库。

Reference:They are two implementations of the MPI standard. In the late 90s and early 2000s, there were many different MPI implementations, and the implementors started to realize they were all re-inventing the wheel; there wassomething of a consolidation. The LAM/MPI team joined with the LA/MPI, FT-MPI, and eventually PACX-MPI teams to develop OpenMPI. LAM MPI stoppedbeing developed in 2007. The code base for OpenMPI was completely new, butit brought in ideas and techniques from all the different teams.Currently, the two major open-source MPI implementation code-bases are OpenMPI andMPICH2.而MPICH2是MPICH的一个版本。

有的计算机厂商,也会针对旗下机型特点,自主开发基于MPICH的MPI软件,从而使机器的并行计算效率得以提高。

(3)OpenMP:在节点内(多核 SMP)执行的基于共享内存的编程模型。

OpenMP是针对单主机上多核/多CPU并行计算而设计的工具,换句话说,OpenMP更适合单台计算机共享内存结构上的并行计算。

由于使用线程间共享内存的方式协调并行计算,它在多核/多CPU结构上的效率很高、内存开销小、编程语句简洁直观,因此编程容易、编译器实现也容易(现在最新版的C、C++、Fortran编译器基本上都内置OpenMP支持)。

不过OpenMP最大的缺点是只能在单台主机上工作,不能用于多台主机间的并行计算。

安装参考帖子1:/shixha/article/details/106481 71硬件: SMP服务器, 4个CPU(XeonE7450), 内存64G,ATI显卡软件:Red Hat Enterprise 4, gcc3.4.6前言: 由于服务器比较老,而且我没有root权限,安装起来很不方便,各种软件和库都没有,都是下载后手工编译安装的,用了3天时间,除了GPU和CUDA因为是ATI显卡的原因无法安装外,成功安装了各个包参考网上教程和manul安装还比较顺利,但是有几个包特别麻烦...写出来分享下,希望能帮到需要的人USER-ATC: 先将MPI的头文件,用-I包含,但由于gcc版本太低,所以总是报错,手动安装gcc4.8.1后libatc.a顺利编译, 但lammps编译时报错dsygvd,dgesvd两个函数找不到,google下发现是BLAS和LAPACK里的函数,由此怀疑是lammps自带的linalg 库有问题,自己下载GotoBLAS或者LAPACk都可以,解决USER-AWPMD: 这个也比较坑爹,主要是makefile只有Makefile.openmpi,但是我编译lammps用的mpich,文档又说库和lammps编译时用的mpi要一致,解决办法是手动修改Makefile.openmpi中CC编译器为mpich的mpicxx,这样有一些警告,但是能顺利编译库,和lammpsUSER-REAXC: 要将连接库的名字与ifort库中的完全一致,-lifcore -lsvml -liompstubs5 -limf, 特别是-liompstubs5跟以前的版本不一样了KIM: 这个很好解决,下载openkim-ati库,google下即可,下载编译后将头文件的目录-I 连接上VORONOI: 也需要自己下载voro++源码,手动编译出来即可libjpeg: 下载libjpeg源码,手工编译即可附上我lammps的makefile,仅供参考[cpp]view plain copy1.# my = RedHat Linux box, g++ (v3), MPICH, FFTW32.3.SHELL = /bin/sh4.5.# ---------------------------------------------------------------------6.# compiler/linker settings7.# specify flags and libraries needed for your compiler8. = g++481 //自己link的gcc4.8.1FLAGS = -g -O11.SHFLAGS = -fPIC12.DEPFLAGS = -M13.14.LINK = g++481 //同上15.LINKFLAGS = -g -O16.LIB =17.SIZE = size18.19.ARCHIVE = ar20.ARFLAGS = -rc21.SHLIBFLAGS = -shared[html]view plain copy1.# ---------------------------------------------------------------------2.# LAMMPS-specific settings3.# specify settings for LAMMPS features you will use4.# if you change any -D setting, do full re-compile after "make clean"5.6.# LAMMPS ifdef settings, OPTIONAL7.# see possible settings in doc/Section_start.html#2_2 (step 4)8.9.LMP_INC = -DLAMMPS_GZIP -DLAMMPS_JPEG //jpeg包10.11.# MPI library, REQUIRED12.# see discussion in doc/Section_start.html#2_2 (step 5)13.# can point to dummy MPI library in src/STUBS as in Makefile.serial14.# INC = path for mpi.h, MPI compiler settings15.# PATH = path for MPI library16.# LIB = name of MPI library17.18.MPI_INC = -I/home/xhshi/mpich/include/ -DMPICH_SKIP_MPICXX //mpich头文件19.MPI_PATH =-L/home/xhshi/mpich/lib //mpich库20.MPI_LIB = -lmpich -lpthread -lmpl //库名称,要一致21.22.# FFT library, OPTIONAL23.# see discussion in doc/Section_start.html#2_2 (step 6)24.# can be left blank to use provided KISS FFT library25.# INC = -DFFT setting, e.g. -DFFT_FFTW, FFT compiler settings26.# PATH = path for FFT library27.# LIB = name of FFT library28.29.FFT_INC = -I/home/xhshi/fftw3/include -DFFT_FFTW3 //fftw3.3.2版本30.FFT_PATH = -L/home/xhshi/fftw3/lib31.FFT_LIB = -lfftw332.33.# JPEG library, OPTIONAL34.# see discussion in doc/Section_start.html#2_2 (step 7)35.# only needed if -DLAMMPS_JPEG listed with LMP_INC36.# INC = path for jpeglib.h37.# PATH = path for JPEG library38.# LIB = name of JPEG library[html]view plain copy1.JPG_INC = -I/home/xhshi/jpeg6b/include2.JPG_PATH = -L/home/xhshi/jpeg6b/lib3.JPG_LIB = -ljpeg参考文献2:(非常有用的帖子)/ooshanshui/article/details/8150233 Lammps是做分子模拟的开源软件,其模拟过程和简介可参考这里。