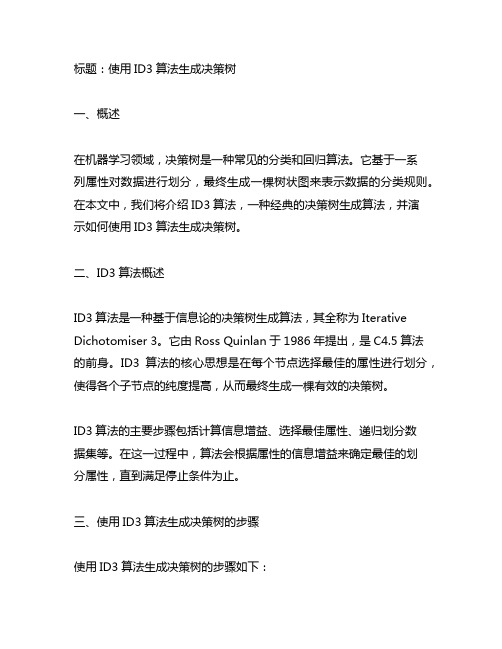

Figure 3.1 Augmented Decision Tree

第3章_决策树学习

表3-2 目标概念PlayTennis的训练样例

Day Outlook Temperature Humidity

D1

Sunny

Hot

High

D2

Sunny

Hot

High

D3 Overcast

Hot

High

D4

Rainy

Mild

High

D5

Rainy

Cool

Normal

D6

Rainy

Cool

Normal

• S的正反样例数量不等, 熵介于0,1之间

• 抛一枚均匀硬币的信息熵是多少? 解:出现正面与反面的概率均为0. 5,信息熵 是

q

E x p xi log p xi i1

(0.5log 0.5 0.5log 0.5)

1

• 用信息增益度量期望的熵降低

– 属性的信息增益,由于使用这个属性分割样例 而导致的期望熵降低

• 返回root

最佳分类属性

• 信息增益(Information Gain)

– 用来衡量给定的属性区分训练样例的能力 – ID3算法在增长树的每一步使用信息增益从候选属性中

选择属性

• 用熵度量样例的均一性

– 给定包含关于某个目标概念的正反样例的样例集S,那 么S相对这个布尔型分类的熵为

E n tr o p y (S ) p lo g 2 p plo g 2 p

ID3算法的核心问题是选取在树的每个节点要测试的属性。

表3-1 用于学习布尔函数的ID3算法

• ID3(Examples, Target_attribute, Attributes)

• 创建树的root节点

• 如果Examples都为正,返回label=+的单节点树root

仿照例题,使用id3算法生成决策树

标题:使用ID3算法生成决策树一、概述在机器学习领域,决策树是一种常见的分类和回归算法。

它基于一系列属性对数据进行划分,最终生成一棵树状图来表示数据的分类规则。

在本文中,我们将介绍ID3算法,一种经典的决策树生成算法,并演示如何使用ID3算法生成决策树。

二、ID3算法概述ID3算法是一种基于信息论的决策树生成算法,其全称为Iterative Dichotomiser 3。

它由Ross Quinlan于1986年提出,是C4.5算法的前身。

ID3算法的核心思想是在每个节点选择最佳的属性进行划分,使得各个子节点的纯度提高,从而最终生成一棵有效的决策树。

ID3算法的主要步骤包括计算信息增益、选择最佳属性、递归划分数据集等。

在这一过程中,算法会根据属性的信息增益来确定最佳的划分属性,直到满足停止条件为止。

三、使用ID3算法生成决策树的步骤使用ID3算法生成决策树的步骤如下:1. 收集数据集:需要收集一个包含多个样本的数据集,每个样本包含多个属性和一个类别标签。

2. 计算信息增益:对每个属性计算信息增益,信息增益越大表示该属性对分类的贡献越大。

3. 选择最佳属性:选择信息增益最大的属性作为当前节点的划分属性。

4. 划分数据集:根据选择的属性值将数据集划分成若干子集,每个子集对应属性的一个取值。

5. 递归生成子节点:对每个子集递归调用ID3算法,生成子节点,直到满足停止条件。

6. 生成决策树:将所有节点连接起来,生成一棵完整的决策树。

四、使用ID3算法生成决策树的示例为了更好地理解ID3算法的生成过程,我们以一个简单的示例来说明。

假设有一个包含天气、温度和湿度三个属性的数据集,我们希望使用ID3算法生成一个决策树来预测是否适合外出活动。

我们需要计算每个属性的信息增益。

然后选择信息增益最大的属性进行划分,将数据集划分成若干子集。

接着递归调用ID3算法,直到满足停止条件为止。

经过计算和递归划分,最终我们得到一棵决策树,可以根据天气、温度和湿度来预测是否适合外出活动。

梯度提升决策树(GradientBoostingDecisionTree),用于分类或回归。

梯度提升决策树(GradientBoostingDecisionTree ),⽤于分类或回归。

今天学习了梯度提升决策树(Gradient Boosting Decision Tree, GBDT ),准备写点东西作为记录。

后续,我会⽤python 实现GBDT , 发布到上,敬请Star 。

梯度提升算法是⼀种通⽤的学习算法,除了决策树,还可以使⽤其它模型作为基学习器。

梯度提升算法的思想是通过调整模型,让损失函数的值不断减⼩, 然后将各个模型加起来作为最终的预测模型。

⽽梯度提升决策树则是以决策树为基学习器。

通常,我们认为决策树是没有参数的模型,可以⽤if-else 规则来表达。

因此,在理解梯度提升决策树的⼀个关键点和难点便是梯度!梯度提升体现在哪?决策树不是没有参数吗,如何求梯度?这是我在学习过程中遇到的两个问题。

下⾯会⼀⼀解答。

⾸先,我们来回顾⼀下机器学习的基础知识。

机器学习算法⼀个基础知识是损失函数(loss function),损失函数⽤于指导模型的训练。

其中的f 就是我们的模型,梯度提升算法就是根据损失函数对模型的⼀阶导数(梯度)来对模型进⾏更新。

什么,可以对模型求导数???,等等,别急,没有想像的那么难。

对于回归问题,通常采⽤least square error (最⼩⼆乘误差)作为损失函数。

L (f )=∑12y i −f x i2对函数f 求导数为:−δL (f )δf =∑y i −f x i 于是,当函数f 的值往梯度⽅向改变⼀定的值时,损失函数就会减⼩的最快,是不是很酷?在 ⼀书中,在361页的Algorithm 10.3中,步长可以算出来。

不过,在实际的代码中,我们通常会设置⼀个学习率,这个学习率就是步长。

假设我们设置的学习率为lr ,那么:f x i +1=f x i +lr ∗y i −f x i ⼀个⽐较骚的操作时,不⽤上⾯的⽅式来更新函数值。

⽽是先⽤⼀颗决策树来拟合上⾯的梯度,然后⽤决策树的预测值来替代上⾯的梯度,进⾏函数值的更新。

决策树,生成剪枝,CART算法

决策树1. 原理1.1 模型简介决策树是一种基本的回归和分类算法。

在分类问题中,可以认为是一系列if-then 规则的几何。

决策树学通常包括三个步骤:特征选择,决策树的生成,决策树的修剪。

定义:决策树由结点和有向边组成,内部节点表示一个特征和属性,叶子结点表示一个类。

性质:决策树路径(或者对应的if-then 规则)具有互斥且完备性:每一个实例都被一条路径或规则所覆盖,而且只被这条路径或规则所覆盖。

决策树学习:能够正确对数据集进行分类的决策树可能有多个,也可能一个也没有,我们的目的是找到一个与训练数据集矛盾较小的,同时具有很好泛化能力的决策树。

特征选择:一种是在决策树学习开始的时候,对特征进行选择,只留下对训练数据有足够分类能力的特征,一种是在学习过程中对训练数据分割成自己的时候,选择最优的特征进行分割。

决策树生成:一般这是一个递归的规程。

决策树的剪枝:提高决策树的泛化能力。

1.2 特征选择特征选择的准则一般是:信息增益和信息增益比1.2.1 信息增益a.信息增益:信息增益大的特征具有更强的分类能力,即选择信息增益值大的特征作为最优特征。

b.信息熵:表示变量的不确定性(在得知特征X 的信息时,使得Y 的信息不确定性减少的程度),熵越大,变量的不确定性越大。

设X 是一个取有限值的离散型随机变量,其概率分布为:()i i p X x p ==则随机变量X 的熵定义为:1()log ni i i H X p p ==-∑注:若p i =0,定义0log 00=。

其中若对数以2为底,熵的单位称为比特,若以e 为底,单位称为纳特。

c.条件熵:随机变量X 在给定条件下随机变量Y 的条件熵H (Y|X )表示:X 给定条件下Y 的条件概率分布的熵 关于X 的数学期望:1(|)(|)ni i i H Y X p H Y X x ===∑其中,()i i p X x p ==。

当熵和条件熵有数据估计(特别是极大似然估计)得到时,被分别称为经验熵和经验条件熵。

医用数据挖掘案例与实践 第9章 决策树模型分析

分类(Classification)是一种数据分析过程,即根据 记录各种属性的值确定该记录属于预定类别中的哪一 类。分类是数据挖掘中的常用方法,在医学应用中, 疾病的诊断和鉴别诊断就是典型的分类过程。

3

分类器的产生主要通过学习和测试两部分完成。学习过程是依据训练样 本(Training Sample)进行有监督的学习,通过学习得到特定的分类器 (Classifier)。测试过程是以学习得到的分类器对测试样本(Testing Sample) 进行分类,并将分类结果与该样本的类别归属进行对照,以此判断分类器的 性能。当分类器的分类性能达到预定目标后,即可用该分类器对未知数据的 类别进行判定。用于评估分类器性能的测试样本必须独立于训练样本。常用 的测试样本主要有以下几种方法:

(1)随机分组法:将已知数据集合随机的分为互不重叠的学习样本和测 试样本,训练样本量越大,对于分类器的学习就会越准确。因此,当已知数 据集较大的时候,常采用原始数据的三分之二作为训练样本,但缺点是可能 会导致不同类别的样本在两个样本中分布不均衡。

4

(2)N倍交叉验证法:将原有数据集随机的分为N组,分 别以其中的一组数据作为测试样本,其他组数据作为训练样 本进行训练和测试。这样一共训练了N次,得到N个分类准确 率。最后取N次测试的分类准确率的均值来反应分类器的性能。 特别的,当N为总样本数时,此方法则成为留一法(leaveone-out)。

log2

3 9

6 9

log2

6 9

0.918

E(age)

I

(1,

2)

6 9

(

2 6

log2

2 6

4 6

log2

4 6

)

3 9

Learning decision trees using the area under the roc curve

Abstract

ROC analysis is increasingly being recognised as an important tool for evaluation and comparison of classifiers when the operating characteristics (i.e. class distribution and cost parameters) are not known at training time. Usually, each classifier is characterised by its estimated true and false positive rates and is represented by a single point in the ROC diagram. In this paper, we show how a single decision tree can represent a set of classifiers by choosing different labellings of its leaves, or equivalently, an ordering on the leaves. In this setting, rather than estimating the accuracy of a single tree, it makes more sense to use the area under the ROC curve (AUC) as a quality metric. We also propose a novel splitting criterion which chooses the split with the highest local AUC. To the best of our knowledge, this is the first probabilistic splitting criterion that is not based on weighted average impurity. We present experiments suggesting that the AUC splitting criterion leads to trees with equal or better AUC value, without sacrificing accuracy if a single labelling is chosen.

机器学习--决策树(ID3)算法及案例

机器学习--决策树(ID3)算法及案例1基本原理决策树是一个预测模型。

它代表的是对象属性与对象值之间的一种映射关系。

树中每个节点表示某个对象,每个分支路径代表某个可能的属性值,每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。

一般情况下,决策树由决策结点、分支路径和叶结点组成。

在选择哪个属性作为结点的时候,采用信息论原理,计算信息增益,获得最大信息增益的属性就是最好的选择。

信息增益是指原有数据集的熵减去按某个属性分类后数据集的熵所得的差值。

然后采用递归的原则处理数据集,并得到了我们需要的决策树。

2算法流程检测数据集中的每个子项是否属于同一分类:If 是,则返回类别标签;Else计算信息增益,寻找划分数据集的最好特征划分数据数据集创建分支节点(叶结点或决策结点)for 每个划分的子集递归调用,并增加返回结果到分支节点中return 分支结点算法的基本思想可以概括为:1)树以代表训练样本的根结点开始。

2)如果样本都在同一个类.则该结点成为树叶,并记录该类。

3)否则,算法选择最有分类能力的属性作为决策树的当前结点.4 )根据当前决策结点属性取值的不同,将训练样本根据该属性的值分为若干子集,每个取值形成一个分枝,有几个取值形成几个分枝。

匀针对上一步得到的一个子集,重复进行先前步骤,递归形成每个划分样本上的决策树。

一旦一个属性只出现在一个结点上,就不必在该结点的任何后代考虑它,直接标记类别。

5)递归划分步骤仅当下列条件之一成立时停止:①给定结点的所有样本属于同一类。

②没有剩余属性可以用来进一步划分样本.在这种情况下.使用多数表决,将给定的结点转换成树叶,并以样本中元组个数最多的类别作为类别标记,同时也可以存放该结点样本的类别分布[这个主要可以用来剪枝]。

③如果某一分枝tc,没有满足该分支中已有分类的样本,则以样本的多数类生成叶子节点。

算法中2)步所指的最优分类能力的属性。

这个属性的选择是本算法种的关键点,分裂属性的选择直接关系到此算法的优劣。

用于分类的决策树(DecisionTree)-ID3C4.5

⽤于分类的决策树(DecisionTree)-ID3C4.5决策树(Decision Tree)是⼀种基本的分类与回归⽅法(ID3、C4.5和基于 Gini 的 CART 可⽤于分类,CART还可⽤于回归)。

决策树在分类过程中,表⽰的是基于特征对实例进⾏划分,将其归到不同的类别。

决策树的主要优点是模型可读、易于理解、分类速度快、建模与预测速度快。

本⽂主要介绍 Quinlan 在 1986 年提出的 ID3 算法与 1993 年提出的 C4.5 算法。

下⾯⾸先对决策树模型进⾏简单介绍。

决策树模型决策树是由树节点与边组成的,其节点有两种类型,内部节点和叶节点,内部节点表⽰⼀个特征或者属性,叶节点代表类别,如下如所⽰:图中可见根节点开始到叶节点的每条路径构建⼀条规则,内部节点的特征对应着规则的条件。

整棵树满⾜⼀个重要性质:每⼀个训练数据实例都被⼀条唯⼀的路径覆盖。

决策树的学习算法是做⼀个递归选择最优特征的过程,⽤最优特征对训练数据集进⾏分割,对分割后的两个⼦数据集,选择各⾃⼦数据集的最优特征继续进⾏分割,如果某个⼦数据集已经能够正确分类,则将该节点改为叶节点。

否则⼀直递归寻找最优特征知道没有合适特征为⽌。

决策树可能对训练数据有很好的分类能⼒,对测试数据却未必,这时可能是由于过度拟合训练数据,⽽降低了其泛化性,可以通过剪枝操作合并过分细分的叶⼦节点,将数据归并到⽗节点来增加其泛化性。

所以可以看到决策树⽣成过程对应着局部最优的特征选择,⽽剪枝对应着对模型进⾏全局调优。

对决策树模型有了初步认识之后,接下来将介绍决策树的建模与剪枝过程,这⾥重点介绍 ID3 与 C4.5 ,这两种形式的决策树学习均包括三个步骤:1)特征选择;2)决策树的⽣成;3)减枝。

接下来的段落围绕这三部分展开。

特征选择特征选择在于选取具有分类能⼒的特征,来提⾼决策树的学习效率,通常选择特征的标准为信息增益(ID3)与信息增益⽐(C4.5)。

id3算法建树基本步骤

id3算法建树基本步骤1.引言i d3算法是一种用于分类问题的决策树学习算法,它通过对特征进行选择来构建决策树。

本文将介绍i d3算法的基本步骤,包括特征选择、决策树构建以及预测等关键过程。

2.特征选择特征选择是i d3算法的核心部分,它通过计算每个特征的信息增益来选择最佳特征,用于构建决策树的节点。

信息增益是指在给定某个特征的条件下,对目标变量进行分类的不确定性减少的程度。

通常使用信息熵来度量不确定性,信息熵越小表示分类越纯净。

2.1计算信息熵信息熵的计算公式为:$$E n tr op y(D)=-\s um_{i=1}^{n}p_i\log_2p_i$$其中,$D$代表数据集,$p_i$表示目标变量的某个类别在数据集中的比例。

2.2计算信息增益信息增益的计算公式为:$$G a in(A)=En tr op y(D)-\s um_{v=1}^{V}\fr a c{|D_v|}{|D|}En t ro py(D_v)$$其中,$A$代表某个特征,$V$为该特征的取值集合,$D_v$表示特征$A$取值为$v$的样本子集,$|D_v|$为子集的大小,$|D|$为整个数据集的大小。

2.3选择最佳特征根据信息增益选择最佳特征的步骤如下:1.对每个特征计算信息增益;2.选择信息增益最大的特征作为当前节点的划分特征;3.根据划分特征的不同取值,将数据集分割为多个子集。

3.决策树构建决策树构建是通过递归地选择最佳特征来构建决策树的过程。

具体步骤如下:3.1停止条件决策树构建的停止条件可以是以下几种情况中的任意一种:-所有样本属于同一类别;-所有样本在所有特征上取值相同;-特征集为空。

3.2递归划分根据选择的最佳特征将数据集分割为多个子集,对每个子集递归地构建子树。

子树的构建方法与主树相同,直到达到停止条件为止。

3.3决策树表示决策树可使用树状结构进行表示,每个节点代表一个特征,边代表特征取值,叶节点代表类别标签。

基于寿险的数据仓库技术研究及其应用

II

目 录

摘 要 ............................................................................................................................................... I Abstract ........................................................................................................................................... II 目 录 ............................................................................................................................................. III 第一章 绪论 ................................................................................................................................... 1 1.1 引言 .................................................................................................................................... 1 1.2 国内外研究现状 ............................................................................................................... 1 1.3 研究内容及意义 ............................................................................................................... 2 1.4 本文的组织结构安排 ....................................................................................................... 3 第二章 数据仓库及数据挖掘技术 ............................................................................................... 5 2.1 数据仓库技术 ................................................................................................................... 5 2.1.1 数据仓库体系结构 ................................................................................................. 5 2.1.2 数据仓库建模技术 ................................................................................................. 6 2.1.3 ETL 技术 .................................................................................................................. 8 2.1.4 数据集市 ................................................................................................................. 9 2.1.5 数据仓库实施策略 ............................................................................................... 10 2.2 数据挖掘技术 ................................................................................................................. 12 2.2.1 数据挖掘常用算法分析 ....................................................................................... 12 2.2.2 数据挖掘实施策略 ............................................................................................... 13 第三章 寿险数据仓库设计及实施 ............................................................................................. 15 3.1 寿险业务分析 ................................................................................................................. 15 3.2 寿险数据仓库模型设计 ................................................................................................. 16 3.2.1 主题分析 ............................................................................................................... 16 3.2.2 数据模型分析 ....................................................................................................... 17 3.2.3 寿险数据仓库建模 ............................................................................................... 17 3.3 寿险数据仓库总体架构 ................................................................................................. 23 3.4 寿险数据仓库实施规划 ................................................................................................. 24 3.4.1 原子层实施阶段 ................................................................................................... 24 3.4.2 分析层实施阶段 ................................................................................................... 25 3.5 实施技术路线 .................................................................................................................. 25 3.5.1 数据仓库平台选择 ............................................................................................... 25 3.5.2 ETL 工具选择 ........................................................................................................ 26 3.5.3 整体技术架构 ....................................................................................................... 26 3.6 寿险数据仓库的实施 ...................................................................................................... 27

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CS395TComputationalLearningTheoryLecture3:September13,2006Lecturer:AdamKlivansScribe:MarcAlban

3.1LearingDNFFormualsRecallfromthelastlecturetheintroductionofpolynomialsizedDNF(DisjunctiveNormalForm)formulasandaugmenteddecisiontrees.

WewouldliketodescribeanalgorithmforlearningDNFformulaswitharunningtimeofn˜O(√n)

andamistakeboundofn˜O(√n)[2].LaterwewouldliketofindanalgorithmforlearningDNFformulaswithanimprovedrunningtimeandmistakeboundofn˜O(n1/3)[5].

OurapproachtolearningDNFformulaswillbetoconstructadecisionlistthatcomputestheformulaandshowthatthemistakeboundandrunningtimeoflearningthedecisionlistarebothn˜O(√n)

3.1.1DNFFormulatoAugmentedDecisionTreeDefinition1Anaugmentedt-decisiontreeisadecisiontreethathasDNFformulaswithtermlength≤tattheleaves.

X2

X1X5

DNF1DNF2DNF3DNF4

Figure3.1:AugmentedDecisionTree

Theorem1AnypolynomialsizeDNFformulafofstermsovernbooleanvariableshasanaug-menteddecisiontreeofrankatmost2ntlns+1inwhichalltheleavesareDNFswithtermlengthatmostt.

Proof:LetT1,T2,...,Tpbethetermsoffthathavelength>t.Choosevariablex∗thatoccuresmostoftenintheseterms.Wecanconstructanaugumenteddecisiontreebyputtingx∗attheroot.Theleftandrightsubtreescorrespondtotheconditionsx∗=0andx∗=1,respectivly.Thisprocess

3-1Lecture3:September13,20063-2iscarriedoutrecursivlytoexpandthesubtrees.AnexressionisstoppedwhenaDNFformulawithtermlengthatmosttisobtained.Sinceavariablex∗istakenoutfromtheDNFformulasateachsubtree,aDNFformulawithtermlengthatmosttwilleventuallybeobtained.TheresultisanaugmenteddecisiontreewithDNFformulaleavesoftermlength≤t.

Definition2LetR(n,p)bethemaximumrankoveralltheaugmenteddecisiontreescontructedbytheabovealgorithmfromanyDNFformulaonnvariableswithatleastptermsoflengthatleastt.

Thereareatleastp×tliteralsinthetermsoftheDNF,thereforex∗mustappearinatleastp×t2nofthemduetothepigeonholeprincipal.Accordingtothealgorithm,termswithx∗areputintoonesubtreeandtermswithx∗areputintotheother.Onesubtreewillthereforehave≤p−p×t2n=p×1−t2ntermsoflength≥t.BythedefinitionofR(n,p),therankofthissubtree,S0,is≤Rn−1,p1−t2n.Theothersubtree,S1,hasarank≤R(n−1,p).LettheparentofS0andS1beS.TherankofSis≤R(n,p).Considerthefollowingcases:

•RANK(S0)>RANK(S1)→R(n,p)≤Rn−1,p1−t2n

•RANK(S0)•RANK(S0)=RANK(S1)→R(n,p)≤1+Rn−1,p1−t2n

WecancomputeR(n,p)fromtheaboverecurrentrelationgiventheinitialconditionR(m,1)where1≤m≤n.Anaugmenteddecisiontreewith1termoflengthatleasttwouldlooklikeFigure3.2.

X2

DNF2

X1

DNF1

Xk

DNFk1Figure3.2:DecisiontreeofDNFwith1termoflengthtormore.

Itiseasytoseethatthistreehasarankof1andthereforeR(m,1)=1.Solvingtherecurrencerelationwehave

R(n,p)≤R(m,1)+−lnpln1−t2nLecture3:September13,20063-3Sinceln1−x=−x+x22+x33+...

R(n,p)≤1+lnpt2n+“(t2n)2”2+“(t2n)3”3+...

R(n,p)≤1+lnpt2n

R(n,p)≤1+2ntlnp

Sincep≤s,R(n,p)le1+2ntlns

3.1.2AugmentedDecisionTreetoDecisionListWecanextendournotionofak-decisionlistsothateachoutputisaDNFinsteadof0or1.Ak-decisionlistcanthereforebedenotedas(T1,f1),(T2,f2),...,(Tm,fm),whereeachTiisatermoflength≤kandeachfiisaDNFformula.

ForanaugmenteddecisiontreeTofrankRwithDNFformulaswithtermlengthatmosttforleaves,thereisanR-decisionlistthatisitsequivalent.TheR-decisionlistofTcanbeconvertedintoan(R+t)-decisionlistthathasoutputs0or1byreplacingeach(Ti,fi)with(Ti∧Di1,1),(Ti∧Di2,1),...whereDijisthejthtermoffi.

3.2HalfSpacesHalfspaceswillbeusedinourtasktocreateaDNFlearningalgorithmwithtimeandmistakeboundn˜O(n1/3).Theyareusefulsincealmostalllearningalgorithmscanbereducedtolearninghalfspaces,includingthoseforlearningdecisiontrees,DNFs,anddecisionlists.Halfspacesareefficientlylearnableinthemistakeboundmodel[3].

++

+

+

++

+

++

----

-

-

----

-

--

-

--

-

Figure3.3:AHalfSpaceLecture3:September13,20063-4Definition3Ahalfspaceisthefunctionf(x)=SIGN(ni=1aixi−Θ)forai∈Z,Θ∈Z,andx∈{0,1}n

Definition4Alinearthreshholdfunction,orLTF,isahalfspacef.Inalearningscenerio,examplessuchas(101101,+)),(101100,−))and(100010,+))aregivenandwewishspecifyahalfspacewhichsatisfiesthem.Theexamplescanbewrittenasthefollowinginqualities:

a1+a3+a4+a6≥Θa1+a3+a4≤Θa1+a5≥Θ

andsolvedusingalinearprogramsolver[4]tofindtheai’sandΘ’s.3.2.1DecisionListtoHalfSpaceConsideradecisionlistwithnvariablesthatoutputseither-1or+1.Alinearthreshholdfunctioncanbespecifiedthatisequivalenttothedecisionlistasfollows.

1.Constructatermfortheheadofthelistbymultiplyingtogethertheoutputvaluebythevariableattheheadby2n+1.

2.Constructasimilartermforthechildoftheheadofthelist,exceptthatfinalfactoris2n.3.Constructasimilartermforthechildofthechildoftheheadofthelist,exceptthatfinalfactoris2n−1.Continueinthisfashionuntilatermiscreatedforallnodesinthedecisionlist.