第六章双目立体视觉x

双目立体视觉系统

全局算法 (Global algorithms):

能量方程: E(d ) Edata (d ) Esmooth (d ) 模拟退火(Simulated annealing), 动态规划 (Dynamic

动机:在哪寻找匹配点

P

?

Pl

Pr

极平面

极平面

极线

极点

极线约束

极线

pl

pr

匹配点必须在极线上

Ol

el

er

Or

极点

34

极线方程

左右两幅图像相对应的点之间的关系可以通过 Essential 矩阵来表明。

Essential 矩阵是摄像机标定情况下用的。

公式: ( pr )T Epl 0

Programming), 图像分割(graph-cut), etc.

42

图像匹配方法

图像匹配方法

图像匹配方法

图像匹配方法

图像匹配方法

特征匹配 VS 区域匹配

特征匹配 (Feature match):

速度快,匹配效率高; 特征的提取可以到亚像素级别,精度较高; 匹配元素为物体的几何特征,对照明变化不敏感; 重建需要拟合。

双目立体视觉系统

2

背景

立体视觉通过设计和模仿人类视觉来获得物体 深度信息。

它在逆向工程、测试测量、文化产业、公共安 全、视觉导航、地图生成、航空勘测等领域都有很 好的应用价值。

二维信息与三维信息的结合,也为一些具体的 工程问题提供了方法,如目标识别的图像分割。

双目立体视觉系统

3

主要内容

1:双目视觉系统模型

《双目立体视觉》课件

05

双目立体视觉的应用案例

机器人视觉导航

机器人视觉导航是双目立体视觉的重要应用之一。通过双目立体视觉技术,机器 人可以获取周围环境的深度信息,实现自主导航、避障和路径规划等功能。

双目立体视觉技术可以帮助机器人识别障碍物、行人和车辆等,提高机器人的安 全性和可靠性。

医学影像分析

在医学领域,双目立体视觉技术被广泛应用于医学影像分析 。通过双目立体视觉技术,医生可以获取患者的三维立体图 像,提高诊断的准确性和可靠性。

深度学习技术Байду номын сангаас

随着深度学习算法的不断发展, 双目立体视觉技术将更加智能化 ,能够自动识别和提取更多的三

维信息。

实时处理能力

随着计算能力的提升,双目立体 视觉技术将实现更快速、实时的 三维重建,满足实时应用的需求

。

多传感器融合

未来双目立体视觉技术将与其他 传感器技术(如激光雷达、毫米 波雷达等)融合,实现更全面的

运动模糊问题

总结词

运动模糊是由于摄像机或物体快速移动导致图像模糊的现象,对双目立体视觉的深度感知造成干扰。

详细描述

在动态环境中,摄像机或物体的快速移动可能导致图像模糊,从而影响双目立体视觉系统的深度感知 能力。为了解决这一问题,研究者们提出了基于运动补偿的算法,通过分析图像中的运动轨迹,对模 糊图像进行还原和补偿,以提高深度感知的准确性。

详细描述

在复杂的光照条件下,如明暗交替、阴影或高光,双目视觉 系统可能难以准确判断物体的深度和距离。这主要是因为阴 影或高光区域中的物体可能会与背景融为一体,导致立体匹 配算法失效。

遮挡和透明物体问题

总结词

遮挡和透明物体是双目立体视觉中的常见挑战,需要特殊算法来处理。

双目视觉基本原理

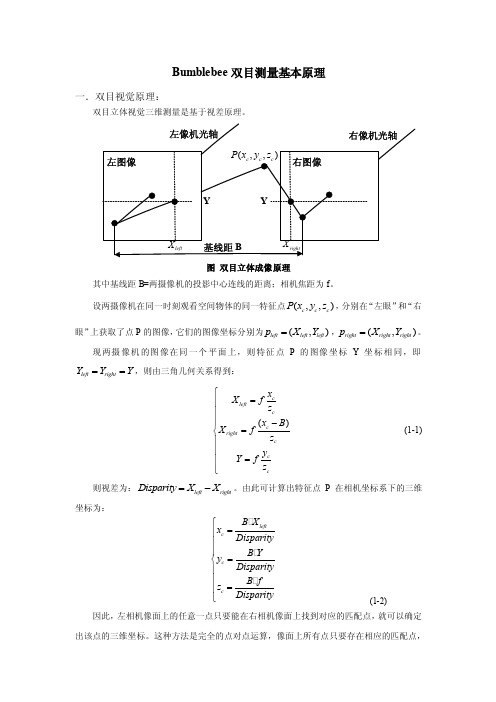

Bumblebee 双目测量基本原理一.双目视觉原理:双目立体视觉三维测量是基于视差原理。

图 双目立体成像原理其中基线距B=两摄像机的投影中心连线的距离;相机焦距为f 。

设两摄像机在同一时刻观看空间物体的同一特征点(,,)c c c P x y z ,分别在“左眼”和“右眼”上获取了点P 的图像,它们的图像坐标分别为(,)left left left p X Y =,(,)right right right p X Y =。

现两摄像机的图像在同一个平面上,则特征点P 的图像坐标Y 坐标相同,即left right Y Y Y ==,则由三角几何关系得到:()c left c c right c c c x X f z x B X f z y Y f z ⎧=⎪⎪⎪-=⎨⎪⎪=⎪⎩ (1-1)则视差为:left right Disparity X X =-。

由此可计算出特征点P 在相机坐标系下的三维坐标为:left c c c B X x Disparity B Y y Disparity B f z Disparity ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩ (1-2)因此,左相机像面上的任意一点只要能在右相机像面上找到对应的匹配点,就可以确定出该点的三维坐标。

这种方法是完全的点对点运算,像面上所有点只要存在相应的匹配点,就可以参与上述运算,从而获取其对应的三维坐标。

二.立体视觉测量过程1.图像获取(1) 单台相机移动获取(2) 双台相机获取:可有不同位置关系(一直线上、一平面上、立体分布)2.相机标定:确定空间坐标系中物体点同它在图像平面上像点之间的对应关系。

(1)内部参数:相机内部几何、光学参数(2)外部参数:相机坐标系与世界坐标系的转换3.图像预处理和特征提取预处理:主要包括图像对比度的增强、随机噪声的去除、滤波和图像的增强、伪彩色处理等;特征提取:常用的匹配特征主要有点状特征、线状特征和区域特征等4.立体匹配:根据对所选特征的计算,建立特征之间的对应关系,将同一个空间物理点在不同图像中的映像点对应起来。

双目立体视觉系统分类

双目立体视觉系统分类一、引言双目立体视觉系统是一种通过模拟人类双眼来感知物体深度的计算机视觉技术。

它模仿了人类的双眼视觉系统,并利用两个相机采集不同视角的图像,通过计算两个图像之间的视差(视点之间的差异),从而获取物体的三维信息。

本文将对双目立体视觉系统的分类进行全面、详细、完整且深入地探讨。

二、传统方法传统的双目立体视觉系统主要包括以下几种分类:1. 匹配算法匹配算法是双目立体视觉系统的核心算法之一。

它通过比较两个图像中对应的像素点(称为对极约束),找到它们之间的匹配关系,在此基础上计算视差。

常见的匹配算法包括:•基于灰度的匹配算法:使用像素灰度值进行匹配,如SAD(Sum of Absolute Differences)和SSD(Sum of Squared Differences)等。

•基于特征点的匹配算法:使用特征点提取算法,如SIFT(Scale-Invariant Feature Transform)和SURF(Speeded Up Robust Features)等,进行匹配。

2. 深度计算深度计算是双目立体视觉系统的另一个重要任务。

它通过视差计算得到每个像素点的深度信息。

常见的深度计算方法包括:•三角测量法:利用成像几何关系,利用相机的内外参,计算出像素点的三维坐标,从而得到深度信息。

•基于视差图的深度计算:根据视差图,通过一定的数学模型和滤波方法,计算出每个像素点的深度。

3. 重建方法重建方法是将双目立体视觉系统获取的二维图像信息转换为三维点云或三维模型的过程。

常见的重建方法包括:•点云重建:利用深度信息,将每个像素点转化为三维空间中的点,并通过点云生成算法,生成完整的点云模型。

•三维模型重建:利用深度信息,将每个像素点转换为三维空间中的点,并通过三维模型重建算法(如表面重建算法),生成连续的三维模型。

三、深度学习方法随着深度学习的发展,越来越多的研究者开始探索使用深度学习方法解决双目立体视觉任务。

双目立体视觉原理

双目立体视觉原理双目立体视觉原理是指人类通过双眼观察同一物体或场景时,由于双眼之间的视差,产生了立体效果,使人能够感知到物体的深度和距离。

这一原理在人类视觉系统中起着至关重要的作用,对于我们理解和感知世界具有重要意义。

首先,我们来了解一下双目立体视觉的基本原理。

人类的双眼分别位于头部的两侧,它们之间的距离大约为6.5厘米。

当我们观察一个物体时,由于双眼的位置差异,两只眼睛所看到的物体会有一定的视差。

这种视差信息会被传输到大脑皮层的视觉中枢,经过大脑的处理和分析,最终形成了我们对物体深度和距离的感知。

另外,双目立体视觉原理还与视网膜上的视觉感受器有关。

人眼的视网膜上布满了感光细胞,其中包括视锥细胞和视杆细胞。

视锥细胞主要负责颜色的感知,而视杆细胞则对光线强弱和运动有较强的感知能力。

在双目观察中,视锥细胞和视杆细胞的协同作用,使我们能够更加准确地感知物体的深度和距离。

除此之外,双目立体视觉还受到了许多外界因素的影响。

比如说光线的照射角度、物体的表面纹理、周围环境的亮度和色彩对我们的立体感知都会产生一定的影响。

因此,双目立体视觉并不是简单地由双眼的位置差异所决定,而是受到了多种因素的综合影响。

在现实生活中,双目立体视觉原理被广泛应用于各个领域。

比如在医学影像学中,医生通过观察患者的双目立体影像,可以更加准确地判断病变的位置和范围。

在航天航空领域,飞行员通过立体视觉可以更加准确地判断飞行器与其他物体的距离和位置,确保飞行安全。

在虚拟现实技术中,利用双目立体视觉原理可以为用户呈现更加逼真的虚拟场景,提升沉浸感和体验效果。

总的来说,双目立体视觉原理是人类视觉系统中的重要组成部分,它使我们能够感知到世界的立体深度和距离,对我们的日常生活和各个领域都具有重要意义。

通过对双目立体视觉原理的深入了解和研究,我们可以更好地应用它,拓展它的应用领域,为人类社会的发展和进步做出更大的贡献。

双目视觉原理

双目视觉原理

双目视觉(Stereovision)是一种立体的视觉技术,可以让用户在多视角和多空间维度上获得空间位置和大小的信息。

它通过使用两台摄像头拍摄两个不同视角的影像信息,通过算法比较和比对这两个不同视角的信息,减去干扰并进行深度重构,最终能够得到一个立体的深度图。

双目视觉由两个在同一垂直平面上,位置稍有偏移的摄像头或传感器构成,这两台摄像头会从不同角度观察同一个场景,而这两个不同的视角的影像(也称为“Shot本”)会随着安装位置的偏移形成一定的立体视觉差异。

当这两台摄像头所拍摄的影像对比时,我们就可以计算出物体在实际空间中的三维位置。

因此,双目视觉可以被用于机器视觉和深度估计,可以实现物体的检测,跟踪和定位等功能。

双目视觉成像原理

双目视觉成像原理1、引言双目立体视觉(Binocular Stereo Vision)就是机器视觉得一种重要形式,它就是基于视差原理并利用成像设备从不同得位置获取被测物体得两幅图像,通过计算图像对应点间得位置偏差,来获取物体三维几何信息得方法。

融合两只眼睛获得得图像并观察它们之间得差别,使我们可以获得明显得深度感,建立特征间得对应关系,将同一空间物理点在不同图像中得映像点对应起来,这个差别,我们称作视差(Disparity)图。

双目立体视觉测量方法具有效率高、精度合适、系统结构简单、成本低等优点,非常适合于制造现场得在线、非接触产品检测与质量控制。

对运动物体(包括动物与人体形体)测量中,由于图像获取就是在瞬间完成得,因此立体视觉方法就是一种更有效得测量方法。

双目立体视觉系统就是计算机视觉得关键技术之一,获取空间三维场景得距离信息也就是计算机视觉研究中最基础得内容。

2、双目立体视觉系统立体视觉系统由左右两部摄像机组成。

如图一所示,图中分别以下标L与r标注左、右摄像机得相应参数。

世界空间中一点A(X,Y,Z)在左右摄像机得成像面C L与C R上得像点分别为al(ul,vl)与ar(ur,vr)。

这两个像点就是世界空间中同一个对象点A得像,称为“共轭点”。

知道了这两个共轭像点,分别作它们与各自相机得光心Ol与Or得连线,即投影线alOl与arOr,它们得交点即为世界空间中得对象点A(X,Y,Z)。

这就就是立体视觉得基本原理。

图1:立体视觉系统3、双目立体视觉相关基本理论说明3.1 双目立体视觉原理双目立体视觉三维测量就是基于视差原理,图2所示为简单得平视双目立体成像原理图,两摄像机得投影中心得连线得距离,即基线距为b。

摄像机坐标系得原点在摄像机镜头得光心处,坐标系如图2所示。

事实上摄像机得成像平面在镜头得光心后,图2中将左右成像平面绘制在镜头得光心前f处,这个虚拟得图像平面坐标系O1uv得u轴与v轴与与摄像机坐标系得x轴与y轴方向一致,这样可以简化计算过程。

双目立体视觉

低于1.0cm。

立体视觉的发展方向

就双目立体视觉技术的发展现状而言,要构造出类似于人眼的通用双目立体视觉系统, 还有很长的路要走,进一步的研究方向可归纳如下:

(1)如何建立更有效的双目立体视觉模型,为匹配提供更多的约束信息,降低立体匹

配的难度。 (2)探索新的适用于全面立体视觉的计算理论和匹配更有效的匹配准则和算法结构, 以解决存在灰度失真,几何畸变(透视,旋转,缩放等),噪声干扰,特殊结构(平坦 区域,重复相似结构等),及遮掩景物的匹配问题; (3)算法向并行化发展,提高速度,减少运算量,增强系统的实用性;

4.立体匹配:根据对所选特征的计算,建立特征之间的对应关系, 将同一个空间物理点在不同图像中的映像点对应起来。

立体匹配有三个基本的步骤组成:1)从立体图像对中的一幅图像

如左图上选择与实际物理结构相应的图像特征;2)在另一幅图像如右 图中确定出同一物理结构的对应图像特征;3)确定这两个特征之间的 相对位置,得到视差。其中的步骤2是实现匹配的关键。 5.深度确定 通过立体匹配得到视差图像之后,便可以确定深度图像,并恢复 场景3-D信息。

视觉技术的发展产生了极大的推动作用,在这一领域已形成了从图像的获取到最终的三

维场景可视表面重构的完整体系,使得立体视觉已成为计算机视觉中一个非常重要的分 支。 经过几十年来的发展,立体视觉在机器人视觉、航空测绘、反求工程、军事运用、 医学成像和工业检测等领域中的运用越来越广

国外研究动态:

双目体视目前主要应用于四个领域:机器人导航、微操作系统的参数检测、三维测量和 虚拟现实。

体视觉技术的诞生。

随着研究的深入,研究的范围从边缘、角点等特征的提取,线条、平面、曲面等几 何要素的分析,直到对图像明暗、纹理、运动和成像几何等进行分析,并建立起各种数

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

32

2 Harris角点检测算法的步骤: 角点检测算法的步骤: 角点检测算法的步骤

• 4.)这个corness就代表了角点值,其中 )这个 就代表了角点值, 就代表了角点值 其中k 是你自己取的一个固定的变量, 是你自己取的一个固定的变量,典型的为 [0.04,0.06]之间。当然在求取了每个点的 之间。 之间 corness以后,最好再做一个极大值抑制, 以后, 以后 最好再做一个极大值抑制, 这样的效果比直接设置一个阀值要好。 这样的效果比直接设置一个阀值要好。

23

•

2 ) SUSAN边缘检测

SUSAN:最小(Smallest) 核同值区

检测模板:37个象素, 半径为3.4象素

1 如果 C( x0 , y0 ; x, y) = 0 如果

c

f ( x0 , y0 ) − f ( x, y) ≤ T f ( x0 , y0 ) − f ( x, y) > T

29

2 Harris角点检测算法的步骤: 角点检测算法的步骤: 角点检测算法的步骤

• 1.)计算图像的方向导数,分别保存为两个 )计算图像的方向导数, 数组Ix以及 以及Iy,这里可以使用任何方法, 数组 以及 ,这里可以使用任何方法,比 较正统的是使用Gaussian函数,因为在 函数, 较正统的是使用 函数 Harris角点检测的推导过程中默认是采用了 角点检测的推导过程中默认是采用了 Gaussian函数作为其计算图像偏导数的方 函数作为其计算图像偏导数的方 当然使用简单的Prewitt或者 或者Sobel算 法。当然使用简单的 或者 算 子也没有关系。 子也没有关系。

20

6.4.1 基本方法

• 特征点提取:平移、旋转、缩放、仿射不变性 平移、旋转、缩放、 1.SUSAN角点提取; 2.harris角点提取; 3.SIFT尺度不变特征提取

21

1

SUSAN边缘检测 边缘检测

原理

USAN: Univalue Segment Assimilating Nucleus

[

]

12

14

6.3.2 双目立体匹配

1. 极线约束

C‘和C“之间的连线 称光心线,光心线 与左右象平面的交 点E’和E”分别称为 左右象平面的极点 光心线与物点W在同一个平面中,这个平面称为极 平面,极平面与左右象平面的交线L'和L"分别称为 物点W在左右象平面上投影点的极线

15

6.3.2 双目立体匹配

• • • 不需要计算微分 对面积计算中的各个值求和(积分) 非线性响应特点 控制参数的选择简单 参数的任意性较小

28

•

易自动化实现

• •

2

Harris角点检测 角点检测

• Harris角点检测算子是 角点检测算子是Moravec角点检测 角点检测算子是 角点检测 算子的改进. 算子的改进 • Harris算子用高斯函数代替二值窗口函数 算子用高斯函数代替二值窗口函数, 算子用高斯函数代替二值窗口函数 对离中心点越近的像素赋于越大的权重, 对离中心点越近的像素赋于越大的权重, 以减少噪声影响。 以减少噪声影响。 • Moravec算子只考虑了每隔 度方向, 算子只考虑了每隔45度方向, 算子只考虑了每隔 度方向 Harris算子用 算子用Taylor展开去近似任意方向。 展开去近似任意方向。 算子用 展开去近似任意方向

六个模块 ⇔ 六项工作

1. 摄象机标定 2. 图象获取 3. 特征提取 立体视觉借助不同观察点对同一景物间的视 差来帮助求取3-D信息(特别是深度信息)。所以 需要判定同一景物在不同图象中的对应关系 选择合适的图象特征以进行多图象间的匹配

3

6.1

双目立体视觉原理

六个模块 ⇔ 六项工作

4. 立体匹配 根据对所选特征的计算来建立特征间的对应关 系,从而建立同一个空间点在不同图象中的象点 之间的关系,并由此得到相应的视差图象 5. 3-D信息恢复 信息恢复 根据得到的视差图象,可以进一步计算深度图 象,并恢复场景中的3-D信息

B Z = λ 1 − D

8

6.2.1 双目横向模式

1. 视差和深度

• 3-D空间点在两个摄象机的公共视场 (视角不同,被摄物的形状,摄影环境)

• 测距精度

x1e = x1 + e,d1e = x1 + e + x2 + B = d + e

B ∆Z = Z1e − Z = λ 1 − d 1e B λB e − λ 1 − = d d ( d + e)

6.3.2 双目立体匹配

3. 光学特性计算

利用灰度信息进一步计算物体表面的光学特性 N为表面面元法线方向的单位向量 S为点光源方向的单位向量 V为观察者视线方向的单位向量 反射亮度I(x, y)为合成反射率ρ (x, y)和合成反射量 R[N(x, y)]的乘积

I ( x, y ) = ρ ( x, y ) R [ N ( x, y )]

向量H反映出视线向量V的变化

18

6.4

基于特征的双目立体匹配

基于区域方法的缺点是依赖于图象灰 度的统计特性,所以对景物表面结构以及光 照反射等较为敏感

6.4.1 基本方法 6.4.2 动态规划匹配

19

6.4.1 基本方法

典型方法的主要步骤 (1) 用边缘检测寻找物体的轮廓线,并在轮 廓线上确定特征点 (2) 利用立体匹配方法匹配各特征点 (3) 对匹配点求视差,获取匹配点的深度 (4) 利用获得的匹配点进行深度插值,以进 一步得到其它各点的深度

30

2 Harris角点检测算法的步骤: 角点检测算法的步骤: 角点检测算法的步骤

• 2.)为每一个点计算局部自相关矩阵 ) • u(x,y) = [Ix(x,y)^2*W Iy(x,y)Ix(x,y)*W;Ix(x,y)Iy(x,y)*W Iy(x,y)^2*W]; • 这里 代表以 为中心与高斯模板 做卷 这里*W代表以 为中心与高斯模板W做卷 代表以x,y为中心与高斯模板 积,而这个模板的大小则需要你自己指定。 而这个模板的大小则需要你自己指定。

31

2 Harris角点检测算法的步骤: 角点检测算法的步骤: 角点检测算法的步骤

• 3.)如果这个u的两个特征值都很小,则说 )如果这个 的两个特征值都很小 的两个特征值都很小, 明这个区域是个平坦区域。如果u的某个特 明这个区域是个平坦区域。如果 的某个特 征值一个大一个小,则是线, 征值一个大一个小,则是线,如果两个都 很大,那么就说明这是个角点。 很大,那么就说明这是个角点。Harris提供 提供 了另一个公式来获取这个点是否是角点的 一个评价: 一个评价: corness = det(u) - k*trace(u)^2;

第6 章

双目立体视觉

Hale Waihona Puke 6.1 双目立体视觉原理 6.2 双目成象和视差 6.3 基于区域的双目立体匹配 6.4 基于特征的双目立体匹配 6.5 视差图误差检测与校正

1

6.1

双目立体视觉原理

立体视觉主要研究如何借助(多图象) 成象技术从(多幅)图象里获取场景中物体 的距离(深度)信息

2

6.1 双目立体视觉原理

t

-27 0 27

24

2 ) SUSAN边缘检测

检测对模板中的每个象素进行 得到输出的游程和(running total)

S ( x0 , y 0 ) =

( x , y )∈N ( x , y )

∑ C ( x 0 , y 0 ; x, y )

S ( x0 , y 0 ) < G

边缘响应

G − S ( x0 , y0 ) R( x 0 , y 0 ) = 0 如果 否则

核同值区:相对于模板的核,模板中有一定 的区域与它有相同的灰度

22

1) USAN原理

• • USAN的面积携带了关于图象中核象素处结 构的主要信息 当核象素处在图象中的灰度一致区域, USAN的面积会达到最大。该面积当 核处在直边缘处约为最大值的一半, 而当核处在角点处则为最大值的1/4 使用USAN面积作为特征起到了增强边缘和 角点的效果

相关系数

γ ( s, t ) =

∑ ∑ [ f ( x, y ) − f ( x, y )][w( x − s, y − t ) − w ]

x y

f ( x, y ) − f ( x, y ) ∑ ∑ [w( x − s, y − t ) − w ] ∑ ∑ x y x y

2 2

17

6.3.2 双目立体匹配

3. 光学特性计算

I ( x, y ) = ρ ( x, y ) R [ N ( x, y )]

R [ N ( x , y )] = (1 − α ) N • S + α ( N • H ) k

第一项散射效应,第二项镜面反射效应 H为镜面反射角方向的单位向量

H = (S + V ) 2[1 + ( S • V )]

12

6.3

基于区域的双目立体匹配

直接用单点灰度搜索会受到图象中许多点会 有相同灰度、图象噪声等因素影响而不实用

6.3.1 模板匹配 6.3.2 双目立体匹配

13

6.3.1 模板匹配

相关函数

c ( s , t ) = ∑∑ f ( x, y ) w( x − s , y − t )

x y

对f (x, y)和w(x, y) 幅度值的变化比较敏感

6.2.3 双目纵向模式

两个摄象机是沿光轴线依次排列

X Z −λ = − x1 λ X Z − λ − ∆Z = − x2 λ ∆Z x1 x2 X= λ x1 − x2 Z =λ+ ∆Zx2 x2 − x1

• •

基本排除由于遮挡造成的3-D空间点仅被一个 摄象机看到的问题 公共视场的边界很容易确定