Distributional word clusters vs. words for text categorization

英文分词模型

英文分词模型

英文分词模型是指用于将英文文本按照单词进行切分的算法或模型。

分词是自然语言处理中的一个重要任务,它将连续的文本切分成有意义的词汇单位,方便后续的文本处理和分析。

在英语中,单词之间通常以空格或标点符号作为分隔符,但有些情况下单词之间并没有明显的分隔符,比如复合词、缩写词和合成词等。

因此,英文分词需要利用语言规则、统计方法或机器学习技术来确定单词的边界。

常见的英文分词模型包括以下几种:

1. 基于规则的分词模型:基于一定的语言规则和词典,通过匹配规则和查找词典中的单词来切分文本。

这种方法需要人工编写规则和维护词典,适用于特定领域或语言规则较为规范的情况。

2. 统计分词模型:基于统计方法,通过分析大量的文本数据,计算词频、词组频率等统计信息,来确定单词的边界。

常见的统计分词算法有最大匹配法、最大概率法和隐马尔可夫模型等。

3. 基于机器学习的分词模型:利用机器学习算法,通过训练样本来学习英文分词的模式和规律。

常见的机器学习算法包括条件随机场(Conditional Random Field, CRF)和递归神经网络(Recurrent Neural Network, RNN)等。

这些英文分词模型各有优劣,选择合适的模型需要根据具体的应用场景和需求进行评估和比较。

同时,还可以通过模型融合和组合等方法来提高分词的准确性和鲁棒性。

泰迪智能科技文本挖掘题库

第 1 页 共 6 页 泰迪智能科技文本挖掘题库 一、选择题(每题3分,共30分) 1. 文本挖掘中,对文本进行预处理不包括以下哪个操作? A. 分词 B. 词性标注 C. 情感分析 D. 去除停用词 答案:C。解析:文本预处理主要包括分词、词性标注、去除停用词等,情感分析是后续对文本情感倾向进行分析的操作,不属于预处理。

2. 以下哪种算法常用于文本分类? A. K-Means聚类算法 B. 决策树算法 C. 关联规则挖掘算法 D. 层次聚类算法

答案:B。解析:决策树算法常用于文本分类,通过构建决策树对文本进行分类;K-Means聚类算法和层次聚类算法主要用于聚类分析;关联规则挖掘算法用于发现数据中的关联关系。

3. 在文本挖掘中,词向量的作用是什么? A. 表示文本的语义信息 B. 计算文本的相似度 C. 对文本进行分类 D. 以上都是

答案:D。解析:词向量可以表示文本的语义信息,通过词向量可以计算文本的相似度,也有助于对文本进行分类。

4. 以下哪个工具常用于文本挖掘? A. Excel B. Photoshop C. NLTK D. Premiere 第 2 页 共 6 页

答案:C。解析:NLTK是自然语言处理工具包,常用于文本挖掘;Excel主要用于数据处理和分析;Photoshop是图像处理软件;Premiere是视频编辑软件。

5. 文本挖掘中,特征选择的目的是什么? A. 减少数据维度 B. 提高模型准确性 C. 降低计算复杂度 D. 以上都是

答案:D。解析:特征选择可以减少数据维度,降低计算复杂度,同时选择合适的特征也有助于提高模型的准确性。

6. 以下哪种方法可以用于文本情感分析? A. 基于词典的方法 B. 基于机器学习的方法 C. 基于深度学习的方法 D. 以上都是

答案:D。解析:基于词典的方法通过情感词典来判断文本的情感倾向;基于机器学习的方法可以训练分类模型进行情感分析;基于深度学习的方法如神经网络等也可用于情感分析。

融合知识图谱与注意力机制的短文本分类模型

第47卷第1期Vol.47No.1计算机工程Computer Engineering2021年1月January2021融合知识图谱与注意力机制的短文本分类模型丁辰晖1,夏鸿斌1,2,刘渊1,2(1.江南大学数字媒体学院,江苏无锡214122;2.江苏省媒体设计与软件技术重点实验室,江苏无锡214122)摘要:针对短文本缺乏上下文信息导致的语义模糊问题,构建一种融合知识图谱和注意力机制的神经网络模型。

借助现有知识库获取短文本相关的概念集,以获得短文本相关先验知识,弥补短文本缺乏上下文信息的不足。

将字符向量、词向量以及短文本的概念集作为模型的输入,运用编码器-解码器模型对短文本与概念集进行编码,利用注意力机制计算每个概念权重值,减小无关噪声概念对短文本分类的影响,在此基础上通过双向门控循环单元编码短文本输入序列,获取短文本分类特征,从而更准确地进行短文本分类。

实验结果表明,该模型在AGNews、Ohsumed 和TagMyNews短文本数据集上的准确率分别达到73.95%、40.69%和63.10%,具有较好的分类能力。

关键词:短文本分类;知识图谱;自然语言处理;注意力机制;双向门控循环单元开放科学(资源服务)标志码(OSID):中文引用格式:丁辰晖,夏鸿斌,刘渊.融合知识图谱与注意力机制的短文本分类模型[J].计算机工程,2021,47(1):94-100.英文引用格式:DING Chenhui,XIA Hongbin,LIU Yuan.Short text classification model combining knowledge graph and attention mechanism[J].Computer Engineering,2021,47(1):94-100.Short Text Classification Model Combining Knowledge Graph and Attention MechanismDING Chenhui1,XIA Hongbin1,2,LIU Yuan1,2(1.School of Digital Media,Jiangnan University,Wuxi,Jiangsu214122,China;2.Jiangsu Key Laboratory of Media Design andSoftware Technology,Wuxi,Jiangsu214122,China)【Abstract】Concerning the semantic ambiguity caused by the lack of context information,this paper proposes a neural network model,which combines knowledge graph and attention mechanism.By using the existing knowledge base to obtain the concept set related to the short text,the prior knowledge related to the short text is obtained to address the lack of context information in the short text.The character vector,word vector,and concept set of the short text are taken as the input of the model.Then the encoder-decoder model is used to encode the short text and concept set,and the attention mechanism is used to calculate the weight value of each concept to reduce the influence of unrelated noise concepts on short text classification.On this basis,a Bi-directional-Gated Recurrent Unit(Bi-GRU)is used to encode the input sequences of the short text to obtain short text classification features,so as to perform short text classification more effectively.Experimental results show that the accuracy of the model on AGNews,Ohsumed and TagMyNews short text data sets is73.95%,40.69%and63.10%,respectively,showing a good classification ability.【Key words】short text classification;knowledge graph;Natural Language Processing(NLP);attention mechanism;Bi-directional-Gated Recurrent Unit(Bi-GRU)DOI:10.19678/j.issn.1000-3428.00567340概述近年来,随着Twitter、微博等社交网络的出现,人们可以轻松便捷地在社交平台上发布文本、图片、视频等多样化的信息,社交网络已超越传统媒体成为新的信息聚集地,并以极快的速度影响着社会的信息传播格局[1]。

文本分类聚类算法

文本分类聚类算法

文本分类聚类算法是一种将文本数据根据其内容或特征进行分类和聚类的方法。

常见的文本分类聚类算法有以下几种:

1. K-means聚类算法:K-means是一种基于距离的聚类算法,

可以用于将文本数据划分为k个不同的类别。

该算法通过迭代地更新类别的均值来找到最佳的聚类结果。

2. 层次聚类算法:层次聚类算法通过计算文本数据之间的相似度或距离来将其分层次地组织成一个层次结构。

这样可以通过设置层次结构中的切割点来得到不同的聚类结果。

3. 朴素贝叶斯分类算法:朴素贝叶斯分类算法是一种基于统计学原理的文本分类算法,它通过计算文本数据在不同类别下的条件概率来进行分类。

4. 支持向量机分类算法:支持向量机分类算法是一种基于机器学习的文本分类算法,它通过在特征空间中构建一个最优的超平面来实现分类。

5. 基于深度学习的分类算法:近年来,随着深度学习的发展,深度学习在文本分类聚类领域也得到了广泛应用。

常见的深度学习模型包括卷积神经网络(CNN)和循环神经网络(RNN)等。

这些算法在不同场景下有不同的适用性和性能表现,具体选择哪种算法需要根据具体问题和数据特点来决定。

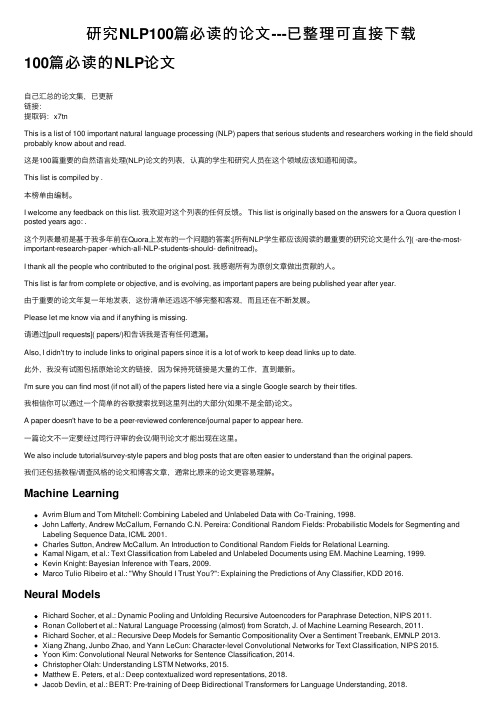

研究NLP100篇必读的论文---已整理可直接下载

研究NLP100篇必读的论⽂---已整理可直接下载100篇必读的NLP论⽂⾃⼰汇总的论⽂集,已更新链接:提取码:x7tnThis is a list of 100 important natural language processing (NLP) papers that serious students and researchers working in the field should probably know about and read.这是100篇重要的⾃然语⾔处理(NLP)论⽂的列表,认真的学⽣和研究⼈员在这个领域应该知道和阅读。

This list is compiled by .本榜单由编制。

I welcome any feedback on this list. 我欢迎对这个列表的任何反馈。

This list is originally based on the answers for a Quora question I posted years ago: .这个列表最初是基于我多年前在Quora上发布的⼀个问题的答案:[所有NLP学⽣都应该阅读的最重要的研究论⽂是什么?]( -are-the-most-important-research-paper -which-all-NLP-students-should- definitread)。

I thank all the people who contributed to the original post. 我感谢所有为原创⽂章做出贡献的⼈。

This list is far from complete or objective, and is evolving, as important papers are being published year after year.由于重要的论⽂年复⼀年地发表,这份清单还远远不够完整和客观,⽽且还在不断发展。

经典的自然语言处理模型

经典的自然语言处理模型

自然语言处理模型是针对自然语言的计算机算法模型,其目的是将文本处理成计算机可以理解和处理的形式。

以下是一些经典的自然语言处理模型:

1. 词袋模型:词袋模型是自然语言处理中最基本的模型之一。

它将一个文本看做一个词集合,忽略了语法和词序等方面的信息,只关注每个词出现的次数。

该模型广泛应用于文本分类、信息检索等任务。

2. 递归神经网络:递归神经网络是深度学习中的一种神经网络结构,用于处理序列数据。

在自然语言处理中,递归神经网络广泛应用于语言模型、机器翻译、情感分析等方面。

3. 卷积神经网络:卷积神经网络是一种基于卷积运算的神经网络结构,用于处理图像、语音和文本等数据。

在自然语言处理中,卷积神经网络常用于文本分类、情感分析等任务。

4. 隐马尔可夫模型:隐马尔可夫模型是用于建模时间序列的概率图模型,广泛应用于语音识别、自然语言生成、分词等任务。

该模型基于一个表示系统状态的马尔可夫链,但是系统状态对于观测者是不可见的,只能通过观测序列间接推断出来。

5. 条件随机场:条件随机场是一种概率无向图模型,用于建模序列标注、分词、命名实体识别等任务。

该模型假设输出序列的标签概率只和它的输入序列有关,但是标签之间是相互依赖的。

以上是一些经典的自然语言处理模型,它们的应用广泛,为自然语言处理研究提供了多种技术手段。

文本分类的关键技术

文本分类的关键技术文本分类是一种将文本划分为不同类别的自然语言处理任务,它在信息检索、情感分析、垃圾邮件过滤等领域具有重要应用。

实现文本分类的关键技术包括:特征提取、分类模型选择和模型训练等。

1. 特征提取:特征提取是文本分类的关键技术之一,它通过将文本转化为计算机可处理的向量表示,为后续的分类模型提供输入。

常用的特征提取方法包括词袋模型、TF-IDF模型和Word2Vec 模型等。

- 词袋模型:将文本表示为一个固定大小的向量,其中包含文档中出现的词或短语的频率或存在性。

这种模型忽略了单词的顺序和上下文信息,但在处理大规模文本数据时具有较快的计算速度和较低的内存占用。

- TF-IDF模型:通过计算词的词频(TF)和逆文档频率(IDF)来衡量词的重要性。

TF 表示词在文档中出现的频率,IDF表示词在整个语料库中的重要程度。

TF-IDF模型能够在保留一定上下文信息的降低常见词的权重。

- Word2Vec模型:通过将词映射到一个高维空间中的向量来表示词的语义信息。

该模型通过训练神经网络来学习词之间的关系,使得类似的词在向量空间中距离较近。

Word2Vec模型能够较好地处理语义相似的词,且保留了一定的上下文信息。

2. 分类模型选择:选择合适的分类模型对文本分类的准确性和效果有重要影响。

常用的分类模型包括朴素贝叶斯、支持向量机(SVM)、逻辑回归和深度学习模型等。

- 朴素贝叶斯:基于贝叶斯定理和特征条件独立性的假设,通过计算给定输入的条件下各个类别的概率来进行分类。

朴素贝叶斯模型具有较快的训练速度和较低的内存占用,适用于大规模数据集和高维特征。

- 支持向量机(SVM):通过寻找一个最优的超平面将不同类别的样本分开。

SVM模型具有较高的分类准确性和较好的泛化能力,特别适用于处理高维特征的文本分类任务。

- 逻辑回归:通过建立一个线性的回归模型来进行分类。

逻辑回归模型具有较快的训练速度和较好的模型解释性,适用于二分类和多分类问题。

分布式词向量表示

分布式词向量表示近年来,随着机器学习和自然语言处理的快速发展,分布式词向量表示成为了文本处理的重要技术之一。

它通过将词语表示为高维向量,实现了对文本语义的捕捉和表达。

本文将深入介绍分布式词向量表示的原理、应用以及相关技术。

一、分布式词向量表示的原理分布式词向量表示是通过将词语映射到一个高维向量空间,使得词语的语义信息能够通过向量的相似度来表示。

这种表示方式能够将语义上相似的词语聚集在向量空间中的相近位置,从而实现对词语语义的准确表达。

分布式词向量表示的核心思想是基于分布假设。

分布假设认为,上下文相似的词语往往具有相似的语义。

因此,我们可以利用词语在上下文中出现的情况来推断词语的语义信息。

通过统计大规模语料库中词语的共现关系,我们可以得到一个词语共现矩阵。

然后,通过矩阵分解等方法,我们可以得到每个词语在向量空间中的表示。

二、分布式词向量表示的应用分布式词向量表示在自然语言处理的各个任务中都有广泛的应用。

其中最为典型的应用之一是词义消歧。

词义消歧是指在文本中确定一个多义词的具体含义。

通过将词语表示为向量,我们可以计算不同义项之间的相似度,从而确定最可能的含义。

此外,分布式词向量表示还能够应用于文本分类、机器翻译、信息检索等任务。

在文本分类中,我们可以将文本表示为词向量的加和或平均值,然后通过分类器对文本进行分类。

在机器翻译中,我们可以通过将源语言和目标语言的词语表示为向量,进而实现语言之间的转换。

三、分布式词向量表示的相关技术分布式词向量表示的研究中涌现了许多优秀的算法和模型。

其中最早的算法之一是基于矩阵分解的方法,如潜在语义分析(LSA)。

LSA 通过奇异值分解(SVD)对词语共现矩阵进行分解,得到词语的向量表示。

随着神经网络的发展,出现了一系列基于神经网络的分布式词向量表示方法。

其中最为著名的是word2vec模型。

word2vec通过训练神经网络,实现了对词语向量的学习。

另外,还有一些基于深度学习的模型,如GloVe和FastText等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

JournalofMachineLearningResearch1(2002)1-48Submitted5/02;Published10/02DistributionalWordClustersvs.WordsforTextCategorization

RonBekkermanronb@cs.technion.ac.il

DepartmentofComputerScience,Technion,Haifa32000Israel

RanEl-Yanivrani@cs.technion.ac.il

DepartmentofComputerScience,Technion,Haifa32000Israel

NaftaliTishbytishby@cs.huji.ac.il

SchoolofCSandEngineeringandCenterforNeuralComputation,TheHebrewUniversity,Jerusalem91904Israel

YoadWinterwinter@cs.technion.ac.il

DepartmentofComputerScience,Technion,Haifa32000Israel

Editor:IsabelleGuyonAbstractWestudyanapproachtotextcategorizationthatcombinesdistributionalclusteringofwordsandaSupportVectorMachine(SVM)classifier.Theword-clusterrepresentationiscomputedusingtherecentlyintroducedInformationBottleneckmethod,whichgeneratesacompactandefficientrepresentationofdocuments.WhencombinedwiththeclassificationpoweroftheSVM,thismethodyieldshighperformanceintextcategorization.Wecom-parethistechniquewithSVM-basedcategorizationusingthesimplemindedbag-of-words(BOW)representation.Thecomparisonisperformedoverthreeknowndatasets.Ononeofthesedatasets(the20Newsgroups)themethodthatisbasedonwordclusterssignif-icantlyoutperformstheword-basedrepresentationintermsofcategorizationaccuracyorrepresentationefficiency.Onthetwoothersets(Reuters-21578andWebKB)theword-basedrepresentationslightlyoutperformstheword-clusterrepresentation.Weinvestigatethepotentialreasonsforthisbehavior.

1.IntroductionTextcategorizationisafundamentaltaskinInformationRetrieval,andmuchknowledgeinthisdomainhasbeenaccumulatedinthepast25years.The“standard”approachtotextcategorizationhassofarbeenusingadocumentrepresentationinaword-based‘inputspace’,i.e.asavectorinsomehigh(ortrimmed)dimensionalEuclideanspacewhereeachdimensioncorrespondstoaword.Thismethodreliesonclassificationalgorithmsthataretrainedinasupervisedlearningmanner.Sincetheearlydaysoftextcategorization(see,e.g.,SaltonandMcGill,1983),thetheoryandpracticeofclassifierdesignhassignificantlyadvanced,andseveralstronglearningalgorithmshaveemerged(see,e.g.,Dudaetal.,

c2002Bekkerman,El-Yaniv,Tishby,andWinter.Bekkerman,El-Yaniv,Tishby,andWinter2000;Vapnik,1998;SchapireandSinger,2000).Incontrast,despitenumerousattemptstointroducemoresophisticatedtechniquesfordocumentrepresentation,likeonesthatarebasedonhigherorderwordstatistics(Caropresoetal.,2001)orNLP(Jacobs,1992;Basilietal.,2000),thesimplemindedindependentword-basedrepresentation,knownasbag-of-words(BOW),remainedverypopular.Indeed,to-datethebestmulti-class,multi-labeledcategorizationresultsforthewell-knownReuters-21578datasetarebasedontheBOWrepresentation(Dumaisetal.,1998;Joachims,1998b;Weissetal.,1999).Nevertheless,attemptsatdevisingmoresophisticatedtextrepresentationmethodsarenotceasing.InthispaperwegivefurtherevidencetotheusefulnessofastatisticalfeaturegenerationtechniquethatisbasedonapplyingtherecentlyintroducedInformationBot-tleneck(IB)clusteringframework(Tishbyetal.,1999;BakerandMcCallum,1998;SlonimandTishby,2000,2001).Inthisapproach,IBclusteringisusedforgeneratingdocumentrepresentationinawordclusterspace(insteadofwordspace),whereeachclusterisadistributionoverclassesofdocuments.Weshowthatthecombinationofdistributionalrep-resentationwithaSupportVectorMachine(SVM)classifier(Vapnik,1998;CristianiniandShawe-Taylor,2000)allowstoachievehighperformanceincategorizationofthewellknown20Newsgroups(20NG)dataset.Thiscategorizationof20NGoutperformsthestrongalgo-rithmicword-basedsetupofDumaisetal.(1998),whichachievedoneofthebestreportedcategorizationresultsforthe10largestcategoriesoftheReutersdataset.Thesefindingsareperhapsnottoosurprising,sincetheuseofdistributionalwordclus-ters(insteadofwords)forrepresentingdocumentshasseveraladvantages.First,wordclusteringimplicitlyreducesdimensionalitybecauseitgroupsvariousfeatures(termsorwords).Incontrast,popularfilter-basedgreedyapproachesforfeatureselectionsuchasMutualInformation,InformationGainandTFIDF(see,e.g.,YangandPedersen,1997)onlyconsidereachfeatureindividually.Second,theclusteringthatisachievedbytheIBmethodprovidesagoodsolutiontothestatisticalsparsenessproblemthatisprominentinthestraightforwardword-based(andevenmoresoinn-gram-based)documentrepre-sentations.Thus,theclusteringofwordsallowsforextremelycompactrepresentationswithminorinformationcompromisesthatallowfortheuseofstrongbutcomputationallyintensiveclassifiers.Despiteadvantageswefoundfordistributionalclusteringincategorizingthe20NGdataset,itdoesnotshowimprovementofaccuracyoverBOW-basedcategorizationwhenusedovertheReutersdataset(ModAptesplit)andoverasubsetoftheWebKBdataset.WeanalyzethisphenomenonandarguethatthecategoriesofdocumentsinReutersandWebKBareless“complex”thanthecategoriesof20NGinthesensethattheycanalmostbe“optimally”categorizedusingasmallnumberofkeywords.Thisisnotthecasefor20NG.Therestofthispaperisorganizedasfollows.Section2describestheproblemoftextcategorization,someapproachestoitssolution,includingfeatureselectionandgeneration.Section3discussesrelatedresults.Section4brieflypresentsthealgorithmiccomponentsweuse,whichinvolveanovelcombinationofexistingtechniquesforfeatureselection,clus-teringandcategorization.Section5brieflydescribesthedatasetsweuseandtheirtextualpreprocessinginourexperiments.Section6presentsourexperimentalsetupandSection7givesadetaileddescriptionoftheresults.Section8discussestheseresults.Section9detailsthecomputationaleffortsthatwererequiredfortheseexperiments.Finally,inSection10weconcludeandoutlinesomeopenquestions.