最优化方法第三章(1)

最优化方法第三章非线性优化

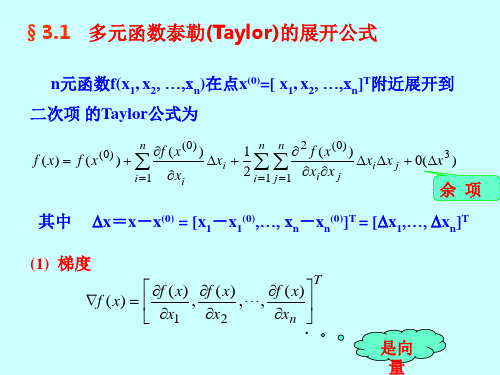

在点X

f (X )

可微,

f (X ) C1

则称向量f ( X ) ( f ( X ) ,..., f ( X ) )T

x1

xn

C1 C2

f (X) C2

为函数 f ( X ) 在点 X 处的梯度.

图3-6指出了梯度的几何意义:如果函数 f (X ) 在点 X 的梯度f (X ) 是非零向量,那么 f (X ) 就是 f (X ) 的等值面在 X 处的法向量,

Company Logo

定义3.1

设D是问题(3-1) ~ (3-3)的可行区域,

X * ∈D,若存在 X * 的一个邻域N(X *,δ),

当X∈ D∩N( X,* δ)时,就有

f (X *) f (X )

(3-4)

则称 X * 是非线性规划(3-1)~(3-3)的

一个局部最优(极小)解.

特X *别,若在(3-4)中严格不等号“<”成立,则称

x2

凸函数的判定及与Hesse矩阵的联系

定理3.7 (严格凸函数的一阶充要条件)

设D为开凸集,f X 在D上有一阶连续偏导。那么 f X 是D上

的严格凸函数的充要条件是:对D上任意两个相异X点1

有 f X 2 f X1 f X1 T X 2 X1

X,2

,都

建立数学模型:设售出两种设备分别为 x1 , x2 件。

max f 30x1 450x2

s.t.

0.5x1 (2 0.25x2 )x2 800 x1, x2 0

Company Logo

一般而言,线性规划问题总可以表示为如下

形式:

Min

f( X )

S . t . gi (X ) 0, j 1, 2,..., m

最优化方法 第三章(罚函数法)

这种惩罚策略,对于在无约束的求解过程中企图违反约

束的迭代点给予很大的目标函数值,迫使无约束问题的 极小点或者无限地向可行域D靠近,或者一直保持在可 行域D内移动,直到收敛到原来约束最优化问题的极小 点。

不改变可行域局部极小值,可以将 约束域之外的局部极小值变大。

p ( x) 0, x D p ( x) 0, x D

k k

k 1

k 1

xk 1是F x, M k 1 的最优解.

k 1 k k 1 k 0 M k 1 M k p ( x ) p ( x ) p ( x ) p ( x )

M k 1 M k

(3) f ( x k 1 ) M k p( x k 1 ) F ( x k 1 , M k ) F ( x k , M k ) f ( x k ) M k p( x k )

gi ( x) gi ( x) max gi ( x), 0 = 罚函数p(x)的构造 2 m l p( x) (max gi ( x), 0) 2 h 2 j ( x)

i 1 j 1

(1) p(x)连续 (2) p( x) 0, x D (3) p( x) 0, x D

二、外点法 外点罚函数法算法步骤 1:给定初始点 x 0 ,初始罚因子M1 0 (可取M1 1 ), 精度 0, k : 1. 2:以 x k 1初始点,求解无约束优化问题

min F ( x, M k ) f ( x) M k p( x)

得到极小点 x* ( M k ),记为 x k , 其中

p( x) (max gi ( x), 0) h 2 j ( x)

2 i 1 j 1 m l

最优化设计 课后习题答案

最优化方法-习题解答张彦斌计算机学院2014年10月20日Contents1第一章最优化理论基础-P13习题1(1)、2(3)(4)、3、412第二章线搜索算法-P27习题2、4、643第三章最速下降法和牛顿法P41习题1,2,374第四章共轭梯度法P51习题1,3,6(1)105第五章拟牛顿法P73-2126第六章信赖域方法P86-8147第七章非线性最小二乘问题P98-1,2,6188第八章最优性条件P112-1,2,5,6239第九章罚函数法P132,1-(1)、2-(1)、3-(3),62610第十一章二次规划习题11P178-1(1),5291第一章最优化理论基础-P13习题1(1)、2(3)(4)、3、4 1.验证下列各集合是凸集:(1)S={(x1,x2)|2x1+x2≥1,x1−2x2≥1};需要验证:根据凸集的定义,对任意的x(x1,x2),y(y1,y2)∈S及任意的实数λ∈[0,1],都有λx+(1−λ)y∈S.即,(λx1+(1−λ)y1,λx2+(1−λ)y2)∈S证:由x(x1,x2),y(y1,y2)∈S得到,{2x1+x2≥1,x1−2x2≥12y1+y2≥1,y1−2y2≥1(1)1把(1)中的两个式子对应的左右两部分分别乘以λ和1−λ,然后再相加,即得λ(2x1+x2)+(1−λ)(2y1+y2)≥1,λ(x1−2x2)+(1−λ)(y1−2y2)≥1(2)合并同类项,2(λx1+(1−λ)y1)+(λx2+(1−λ)y2)≥1,(λx1+(1−λ)y1)−2(λx2+(1−λ)y2)≥1(3)证毕.2.判断下列函数为凸(凹)函数或严格凸(凹)函数:(3)f(x)=x21−2x1x2+x22+2x1+3x2首先二阶导数连续可微,根据定理1.5,f在凸集上是(I)凸函数的充分必要条件是∇2f(x)对一切x为半正定;(II)严格凸函数的充分条件是∇2f(x)对一切x为正定。

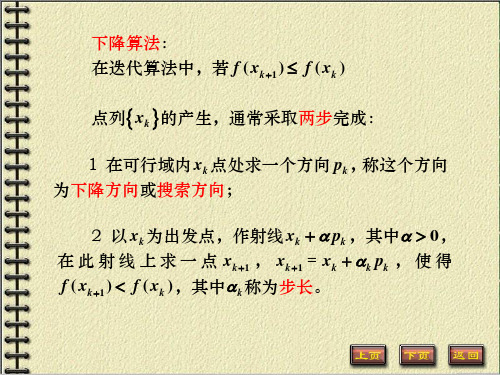

最优化方法第三章第一讲下降迭代算法基本概念

(i )

xk1 xk

或 xk1 xk

xk

;

(ii )

f ( xk1 ) f

(xk

) 或 f ( xk1 ) f ( xk ) ;

f ( xk )

(iii) f ( xk ) gk ;

(i ) 上述三种终止准则的组合,

其中 0是给定的适当小的实数。

2. 一维搜索

最优化问题的算法一般迭代格式:

给定初始点 x0,令k 0。 (i)确定 xk 处的可行下降方向 pk ;

(ii)确定步长k 0,使得 f ( xk k pk ) f ( xk ); (iii)令 xk1 xk k pk ; (i )若 xk1满足某种终止准则,则停止迭代,以 xk1为近似最优解。否则令k k 1,转(i)。

定义 1.2.1:在 xk 点处,对于 pk 0,若存在 0, 使 (0, )有

f ( xk pk ) f ( xk ) 成立,则称 pk 为 f ( x)在点 xk 处的一个下降方向。

当 f ( x)具有连续的一阶偏导数时,记f ( xk ) gk 。由

Taylor 公式 f ( xk pk ) f ( xk ) gkT pk o( )

由 xk 出发沿 pk 方向求步长k 的过程叫一维搜索

或线性搜索。

如果算法构造出的点列xk 在有限步之内得到 问题的最优解 x*,或者点列xk 有极限点,并且其

极限点是最优解 x*,则称这种算法是收敛的。

如果只有当 x0充分接近最优解 x*时,由算法产 生的点列才收敛于 x*,则该算法称为局部收敛。

定义 1.2.4:设序列xk 收敛于 x*,若对于实数 p 1,

有

lim

k

xk1 x* xk x* p

工程最优化第三章

最优点同时与目标函数及约束函数的性质有关。存在两种情况:

x2

x2

x(0) =x*

x(0)

x*

S x1

(a) 无约束极值点x(0)S

S x1

(b) 无约束极值点x(0)S

! 目标函数的梯度等于零并不是约束问题的最优性必要条件!

带有不等式约束的优化问题的最优性条件通常是一组不等式与 方程,比较复杂的,很难求解,所以在一般情况下,不是直接 求解这些条件来获得极值点,而是使用各种迭代法求出近似的 极值点。但它在理论上很重要,是各种迭代方法的基础和依据。

(一)可行方向与起作用约束

定义:设点xS,p是一个方向,如果存在实数a1>0, 使对所有

a[0, a1],有x+apS,则称p为点x 的一个可行方向,或容许

方向、允许方向。

p

几何上,若从x处沿方 向p引一射线,若该射 线起始端有一段在可 行域内,则这个方向p

就叫可行方向。

x S

! 是否为可行方向与起始点的位置有关!

例3.5.1 验证下面的非线性规划在最优点x*处不满足约束规范,

最优点不是K-T点:

min

f

(x) (x1 3)2

x

2 2

s.t g1 (x) x 2 (1 x1 )3 0

g 2 (x) x1 0

g3 (x) x2 0

解:显然最优点 min

fx*(=x[)x1*,(xx21*]T=3[)12,

0]T,

x

2 2

f

=

f

(x*)

=

4.

x2

下面验证在 s.t

因为 g1(x*)

gx*1 (=x[)1,0x]T2处不(1满足x1约)3束 规0 范。 =g02 ,(xg2)(x*) <x10,g03(x*)=0,

最优化方法-最速下降法

计算步骤

设f (X )是可微函数,精度要求为

X f ( ) K 1

,

X 0 为初始点。

(1)计算梯度

f

(

X

)

k

,初始k=0;

(2)

Pk

f

(

X

)

k

(3)求解 k

min f ( X k Pk)

s.t. 0

设 k 是一维搜索的最优解;

(4)求下一个点

评价

由例题中可以发现两次迭代的搜索方向满足:

P P P P T 0, T 0,...,

01

12

即相邻两个搜索方向 PK 与 PK1 正交,这是最速下降

法的搜索方向的基本形质。因此,最速下降法的迭代

路线呈锯齿形,尤其是在极小点附近,锯齿现象尤为

严重,从而影响了迭代速度。

评价

锯齿现象

最优化技术

第三章 7节 最速下降法

主要内容

1原 理

2 计算步骤

3 例题分析 4评 价

原理

定义:用来求解无约束多元函数 min f(x)

极小化问题的一种迭代算法。

拓展:

最速下降法又称梯度法,是 1847 年由著名数学家

Cauchy 给出的,它是解析法中最古老的一种,其他解析 方法或是它的变形,或是受它的启发而得到的,因此它是 最优化方法的基础。

X

)

0

(1,1)T

3-最优步长

2

X P ( ) f 5

0

0 2

1

0

应用一维搜索技术,解得函数最小值点 0 =0.2

举例分析

4-下一搜索点

X1

最优化理论与算法(第三章)

第三章 牛顿法§3.1 最速下降法一、最速下降法在极小化算法中,若每次都以迭代点处的负梯度方向为搜索方向,产生的算法称为最速下降法,它是无约束最优化算法中最简单、最基本的算法。

算法描述:1) 给出初始点0n x R ∈,允许误差0ε>,0k =; 2) 计算k k d g =-,若k g ε≤,Stop 令 *k x x ≈; 3) 由一维搜索确定步长因子k α,使得()min ()k k k k k f x d f x d ααα≥+=+4) 令1k k k k x x d α+=+,1k k =+,go to 2).二、最速下降算法的收敛性定理3.1 设1f C ∈,则最速下降算法产生的点列{}k x 的每个聚点均为驻点。

证明:设x 是{}k x 的一个聚点,则存在子序列{}1k K x ,使得1lim k k K x x ∈=令()k k d f x =-∇,由1f C ∈,知{}1()k K f x ∇是收敛序列,故{}1k K d 有界,且1lim ()k k K d f x ∈=-∇由定理2.6有2()(())()0Tf x f x f x ∇-∇=-∇=故有 ()0f x ∇=。

定理 3.2 设()f x 二次连续可微,且2()f x M ∇≤,则对任何给定的初始点0n x R ∈,最速下降算法或有限终止,或lim ()k k f x →∞=-∞,或lim ()0k k f x →∞∇=。

证明:不妨设k ∀,()0k f x ∇≠。

由定理2.5有211()()()2k k k f x f x f x M+-≥∇ 于是 []120101()()()()()2kk k i i i i i f x f x f x f x f x M -+==-=-≥∇∑∑令k →∞,由{()}k f x 为单调下降序列,则要么lim ()k k f x →∞=-∞,要么 lim ()0k k f x →∞∇=。

最优化方法第三章-孙文瑜

Fnk k ak (1 )(bk a k ) Fnk 1

Fn k 1 k a k (bk a k ), k 1,2,, n 1 Fn k 1 Fn k k ak (bk a k ), k 1,2,, n 1 Fn k 1

25

2018/12/11

3.2.2 Fibonacci法

另一种与0 .618 法相类似的分割方法叫Fibonacci 法. 它与0 .618 法的主要区别之一在于: 搜索区间长度的 缩短率不是采用0 .618 而是采用Fibonacci 数. Fibonacci 数列满足 F0 F1 1

Fk 1 Fk Fk 1 , k 1,2 Fibonacci 法中的计算公式为

N

1

2

1 2

Y

* (t * )

a t1 , t1 t 2 ,

1

第三章无约束问题的最优化方法

赋以0.618。

2 ,

;并计算其对应

的函数值。 3)根据区间消去法原理缩短搜索区间。为了能用原来的 坐标点计算公式,需进行区间名称的代换,并在保留区间 中计算一个新的试验点及其函数值。

如果

令 b , , f f 记N0=0; 2 2 1 2 1 如果 ,则新区间= ,

2

2

图2-5 黄金分割法

• 黄金分割法要求插入两点: a1 a (1 )(b a), f1 f (a1 )

a2 a (b a), f 2 f (a2 )

黄金分割法的搜索过程:

1)给出初始搜索区间及收敛精度 2)按坐标点计算公式计算 1

,将

在搜索区间内[a,b] 任取两点a1、b1,令f1=f(a1), f2=f(b1) • (1)如f1<f2, 则缩小的新区间为[a,b1]; • (2)如f1>f2, 则缩小的新区间为[a1,b]; • (3)如f1=f2, 则缩小的新区间为[a1,b1]

f(b1) f(a1) f(a1) f(b1) f(a1) f(b1)

a

a1

b

a

a1

b1 b

a

a1

b1

b

§3.2 一维搜索方法

黄金分割法: • 黄金分割法适用于[a,b]区间上的任何单谷函数求极小值问题。对 函数除要求“单谷”外不作其他要求,甚至可以不连续。因此,这种 方法的适应面相当广。 • 黄金分割法也是建立在区间消去法原理基础上的试探方法。 • 在搜索区间内[a,b]适当插入两点,将区间分成三段;利用区间消 去法,使搜索区间缩小,通过迭代计算,使搜索区间无限缩小,从而 得到极小点的数值近似解。 •

最优化:最速下降法和Newton法

定理 3.1.1 设假设 2.4.1的条件成立 , 那么采用精确搜索 , 或 Armijo搜索或 Wolfe- P owell搜索的最速下降法产生 的迭 代序列{xk }满足 lim || f ( xk ) || 0

k

由前面的例子看到, 最速下降法的收敛速度至多是线性的, 具体 见下面的两个定理.

第一节

最速下降法

最古老的优化方法,十九世纪中叶由Cauchy提出

1、 思想 :每次沿负梯度方向进行搜索

●

x*

xk 1

等值线(面)

●

xk

●

f ( xk )

负梯度方向也称为最速下降方向:

事实上,对任意p R n 且 || p || , 由Cauchy - Schwarz 不等式得 f ( xk ) T P - || f ( xk ) || || P || - || f ( xk ) || - f ( xk ) - f ( xk ) 当取p 时等号成立,即 p 是下列问题 || f ( xk ) || || f ( xk ) || 的解 min f ( xk ) T P

从上面的例子看到, 对于简单的二元二次函数极小化问题, 最速下降法在有限次迭代并没有求出其精确最优解, 但能 以较慢的速度无限接近最优解.

事实上,上面的例子刻画了最速下降法的所有收 敛特征

3、 最速下降法的收敛性 全局收敛性

由于最速下降法的搜索方向与负梯度方向一致, 即 k 0, 且 || f ( xk ) || || d k || 所以, 由定理2.4.1 - 2.4.3, 我们很容易得到最速下降算法的全 局收敛性.

2

max 其中 , 且max 和min分别是 f ( x * )的最大和最小特征值 . min

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(初始)搜索区间。根据定理3.1,可以给出确定搜索区 间的如下算法。

算法3.1(确定搜索区间) 已知:目标函数 (t)。

①选定初始点 t0和步长 h 。

②计算 0 (t0 ) ,t 2 t0 h ,2 (t2 ) 。

③若 2 0 ,则置 t1 t0 ,1 0 ,h h,

从本章起,以后两章将讨论非线性规划问题。本章首 先讨论无约束最优化问题,其一般形式为

min f (x) (3.1) 其中 f : R n R1

求解无约束问题的最优化方法可以分为两大类:一类

是根据目标函数的梯度(即一阶导数),有时还要根据 Hesse矩阵(即二阶导数)提供的信息构造出来的方法— —导数方法。本章介绍其中的最速下降法、Newton法、 共轭梯度法和拟Newton法。另一类是不使用导数,仅仅 利用目标函数值的信息构造出来的方法——直接方法。本 章将介绍其中的步长加速法、方法加速法和单纯形替换法。 两类方法各有利弊。前者收敛速度快,但需要计算梯度, 甚至需要计算Hesse矩阵;后者不涉及导数,适应性强, 但收敛速度慢。一般的经验是,在可以求得目标函数导数 的情况下,尽可能使用导数方法。

1. 搜索区间的确定

在以下讨论中,总假定一元函数 (t) 是单谷函数。

定义3.1 设 : L R1 R1 ,t* 是 (t) 在L上的全局

极小点。如果对于L上任意的两点 t1,t2 t1 t2 ,当 t2 t *

时,(t1 ) (t2 ) ;当 t1 t * 时,(t1 ) (t2 ) ,那么称(t)

是区间L上的单谷函数。

下图给出了单谷函数的基本图形。

定义3.2 设 : L R1 R1 , t * 是 (t) 在L上的

全局极小点。如果能够找到 t1 , t2 L ,使得 t* [t1,t2 ], 那么闭区间 [t1 , t2 ] 就称为 (t) 极小点的一个搜索区间, 记为{t1, t2}。搜索区间有时也记作{t1, t3, t2},其中 t1 t3 t2

转⑤;否则转④。

④置 t1 t0 ,1 0 ,t0 t2 ,0 2 ,h 2h 。

⑤计算 t2 t0 h ,2 (t2 ) 。若 2 0 ,则转⑥;

否则转④。ຫໍສະໝຸດ ⑥置 a min{t1, t2} , b max{ t1 , t2 } ([a, b] 即为 搜索区间),计算结束。

加负担。下面是确定 h 的一种比较合理而有效的方法。

第一次迭代( k 0 ,即从 xv0 到 xv1 的迭代)时,(t)

的初始步长可取为1,或根据问题中出现的数据的数量级

估计选定。而以后各次迭代的初始步长可按公式(3.5)

计算,

其中 0

般比从

xk

1 到

1hx。k的这距x是k离因pkx为xkk1从(xxkk3到.15小)xvk 或1 的接距近离,所xk以1 把xk按一

黄金分割法的思想是:在每次迭代中,合理地设置两

个插入点的位置,以使得在计算函数值次数同样多的条件 下,将区间缩小得最快。

设区间 [a,b] 的长为1。在距点 a 分

别为 和

为了确定

的地方插入 t1和 t2。

和 ,提出以下条

件:

第一,希望 t1 和 t2在 [a,b]中的位置是对称的。按这

一条件,有

解方法一般也会简单些。

直线搜索,理论上,分为精确的和不精确的。

精确的直线搜索方法主要分为两类:一类为区间收缩

法,另一类为函数逼近法。本节将相应地介绍两种常用的

精确的直线搜索方法:适用于一般函数的黄金分割法和适

用于一般连续函数的抛物线插值法。最后还将介绍实用的

不精确一维搜索技术。

精确的直线搜索算法的实现通常是在所谓的搜索区间 上进行的

3.1 直线搜索

直线搜索(一维搜索)是指求解如下一元函数极小化

问题

min (t )

(3.3)

的迭代方法,其中 : R1 R1 。

在微积分中,解决问题(3.3)的范围一般限于方程

(t) 0 (3.4)

可以直接解出的情况。而这里介绍的直线搜索对 不作

严格的要求。当然,对于可以求出导数的情况,相应的求

at1 t2b

即

1 .

(3.6)

这样无论删去哪一段,总保留长为 的区间。

第二,删掉一段,例如删掉[t2 , b] ,在保留下来的区间

在里[再a,插b]入中一的个位点置具t3有,相使同得的t比3 , t例1 ,在从[a而, t2保] 中证的每位次置迭与代都t1,能t2

以同一比率 缩小区间。按这一条件,有

显然,单谷函数的定义域区间是搜索区间。 单谷函数的性质。

定理3.1 设 {a, b}是单谷函数(t)极小点的一个搜索区

间。在 (a, b) 内任取两点 t1,t2 t1 t2 ,若 (t1 ) (t2 ) ,则

{a, t2 } 是(t) 极小点的一个搜索区间;若 (t1 ) (t2 ) ,则 {t1, b} 是 (t) 极小点的一个搜索区间。

(3.5)算出的作为下一次迭代的初始步长是合适的。在

实际计算中,当 k 较小时,相应的 可取得小些,而随

着的 k 增大,相应的 可取得接近1。

a

2. 直线搜索的方法

(1)黄金分割法 黄金分割法属于区间收缩法。它适用于任何单谷函

数求极小值问题。对函数除“单谷”外,不作其它要求, 甚至可以不连续。因此这种方法的适用面相当广。

上述过程开始时,必须选定初试点 t0 和步长 h。对于

任意给定的 (t),一般来说,无固定选取模式。

但对于在下降算法模式中所引入的 (t) f (xk tpk )

而言,可选取 t0 等于0(理论上)或接近0(实际计算中)。

而对于 h ,如果选得过小,那么需要迭代许多次才能找到

一个搜索区间;如果选得太大,虽然很少几步就可能把极 小点包括进来,但是这又会给下一步搜索极小点的过程增

at1 at2

at2 ab

即

1

或

2 .

(3.7)

把(3.7)代入(3.6)中,得到关于 的一元二次方程

其合理的根是 5 1 0.618 (3.8)

2

代回(3.6),得

3 5 0.382

2

在古代,人们认为按比率0.618分割线段是最协调的, 胜似黄金,故称黄金分割。因此,上述按比率0.618缩小 搜索区间的迭代方法称为黄金分割法或0.618法。