最小二乘估计量的性质

超定方程组的最小二乘解原理

超定方程组,又称为过定方程组,是线性代数中的一个概念。

当方程组的未知数数量少于方程数量时,该方程组就被称为超定方程组。

由于超定方程组通常没有精确解,我们常常会寻求一个近似解,使得所有方程的残差平方和最小。

这就是最小二乘解的原理。

一、最小二乘解的基本概念最小二乘法是一种数学优化技术,它通过最小化误差的平方和来寻找数据的最佳函数匹配。

利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和最小。

最小二乘法还可用于曲线拟合,其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。

二、超定方程组的性质对于超定方程组,由于方程数量多于未知数数量,因此通常不存在一个解能够使得所有方程同时成立。

这种情况下,我们需要寻找一个近似解,即一个解,使得所有方程的残差(即方程的实际值与解代入方程后得到的计算值之间的差)的平方和最小。

三、最小二乘解的原理最小二乘解的原理就是基于上述思想,通过最小化残差平方和来寻找超定方程组的近似解。

具体步骤如下:构建残差平方和函数:首先,我们需要构建一个表示残差平方和的函数。

假设超定方程组有(m) 个方程,(n) 个未知数((m > n)),未知数的向量记作(\mathbf{x} = (x_1, x_2, \ldots, x_n)^T),方程组的系数矩阵记作(\mathbf{A} = (a_{ij})_{m \times n}),常数项向量记作(\mathbf{b} = (b_1, b_2, \ldots, b_m)^T)。

那么,残差向量可以表示为(\mathbf{r} = \mathbf{A}\mathbf{x} - \mathbf{b}),残差平方和函数可以写为(S(\mathbf{x}) = \mathbf{r}^T\mathbf{r} = (\mathbf{A}\mathbf{x} - \mathbf{b})^T(\mathbf{A}\mathbf{x} - \mathbf{b}))。

计量经济学名词解释和简答题

计量经济学 第一部分:名词解释第一章1、模型:对现实的描述和模拟。

2、广义计量经济学:利用经济理论、统计学和数学定量研究经济现象的经济计量方法的统称,包括回归分析方法、投入产出分析方法、时间序列分析方法等。

3、狭义计量经济学:以揭示经济现象中的因果关系为目的,在数学上主要应用回归分析方法。

第二章1、总体回归函数:指在给定Xi 下Y 分布的总体均值与Xi 所形成的函数关系(或者说总体被解释变量的条件期望表示为解释变量的某种函数)。

2、样本回归函数:指从总体中抽出的关于Y ,X 的若干组值形成的样本所建立的回归函数。

3、随机的总体回归函数:含有随机干扰项的总体回归函数(是相对于条件期望形式而言的)。

4、线性回归模型:既指对变量是线性的,也指对参数β为线性的,即解释变量与参数β只以他们的1次方出现。

5、随机干扰项:即随机误差项,是一个随机变量,是针对总体回归函数而言的。

6、残差项:是一随机变量,是针对样本回归函数而言的。

7、条件期望:即条件均值,指X 取特定值Xi 时Y 的期望值。

8、回归系数:回归模型中βo ,β1等未知但却是固定的参数。

9、回归系数的估计量:指用01,ββ等表示的用已知样本提供的信息所估计出来总体未知参数的结果。

10、最小二乘法:又称最小平方法,指根据使估计的剩余平方和最小的原则确定样本回归函数的方法。

11、最大似然法:又称最大或然法,指用生产该样本概率最大的原则去确定样本回归函数的方法。

12、估计量的标准差:度量一个变量变化大小的测量值。

13、总离差平方和:用TSS 表示,用以度量被解释变量的总变动。

14、回归平方和:用ESS 表示:度量由解释变量变化引起的被解释变量的变化部分。

15、残差平方和:用RSS 表示:度量实际值与拟合值之间的差异,是由除解释变量以外的其他因素引起的被解释变量变化的部分。

16、协方差:用Cov (X ,Y )表示,度量X,Y 两个变量关联程度的统计量。

17、拟合优度检验:检验模型对样本观测值的拟合程度,用2R 表示,该值越接近1,模型对样本观测值拟合得越好。

最小二乘法估计量的性质(高斯—马尔可夫定理的初步证明)

高斯—马尔可夫定理:若一元线性模型满足计量经济基本假设,则参数的最小二乘估计(OLS)是最小方差的线性无偏估计。

(BLUE )最小二乘法估计量OLS 的性质(高斯—马尔可夫定理的初步证明)1.线性性:0ˆβ和1ˆβ都是i y 的线性函数证明:ini nj j i n j jni iiy x x x x x x y x x∑∑∑∑====--=--=1121211)()()()(ˆβΘ ;令∑=--=nj ji i x xx x k 12)()(则有i ni i y k ∑==11ˆβ ,且有=∑ik,1=∑ii xk ,∑∑=-=ni ii x xk 122)(1从而1ˆβ是i y 的线性函数;同理,0ˆβ==-x y 1ˆβi i i i n i i y k x n y k x y n ∑∑∑⎪⎭⎫⎝⎛-=-=111令i i k x nw ⋅-=1,则有:i i y w ∑=0ˆβ,即0ˆβ也是iy 的线性函数。

另有:1=∑iw ,0=∑ii xw2. 无偏性:0ˆβ和1ˆβ都是0β、1β的无偏估计量; 即有:(),ˆ0ββ=E ()11ˆββ=E证明:先证()11ˆββ=EΘ ()i i i i n i i u x k y k ++==∑∑=1011ˆβββ, 又Θ0=∑ik,1=∑i i x k()∑∑∑=++===i i i i i ni i k u x k y k 01011ˆββββ+∑∑+i i i i u k x k 1β =∑+i i u k 1β()()1101ˆββββ=++⋅=∑∑∑i i i i i u E k x k k E(因为:0=∑ik,1=∑i i x k )同理,利用1=∑i w 和0=∑i i x w 可证得(),ˆ00ββ=E3. 最优性或最小方差性:在所有的线性无偏估计中,0ˆβ和1ˆβ分别是0β、1β的方差最小的有效估计量 证明:若1~β是原值1β的一个线性无偏估计(方差条件不限),且记∑=i i y c 1~β(∵线性估计),再根据无偏估计的特性,有:∑∑==1,0i i ix c c。

第一章最小二乘估计及其性质

以 x1 代表相对水位, x2 代表温度, y 代表径向形变量。利用 SAS 软件(见文献[3]),

计算得回归方程为

yˆ = 20.778-1.148x1 -0.0182x2 .

(1.18)

通过检验,发现回归方程是显著的, x1 对 y 有显著性影响,但 x2 的回归系数不显著,故该

模型不能合理拟合变形量数据。另外,我们对残差(见图 1)进行分析,发现模型中有非线性 关系,故模型(1.18)中应增加二次项。

切向与径向定义为切向 (t ) 、径向 ( r ) 坐标系,其监测日期和监测数据见表 2。

序号

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20

表 2. 原始监测数据

日期

相对水位/mm

温度/℃

2001/12/31

9.750

14.5

2001/01/01

称为中心化.若记 则(1.11)式可改写为

æ x11 - x1 x12 - x2 L x1, p-1 - x p-1 ö

Xc

=

ç ç ç

x21 M

x1

x22 - x2 M

L

x2,

p

-1

-

x p -1

÷ ÷

M÷

ççè xn1 - x1 xn2 - x2 L xn, p-1 - xp-1 ÷÷ø

(1.12)

-0.5

9.450

11.6

2001/01/02

9.270

9.2

2001/01/03

9.020

12.8

2001/01/05

8.360

13.6

2001/01/06

8.010

3、计量经济学【一元线性回归模型——参数估计】

ˆ Y i

(8) 651.8181 753.6363 855.4545 957.2727 1059.091 1160.909 1262.727 1364.546 1466.364 1568.182 11100

ˆ ei Yi Y i

(9)=(2)-(8) 48.18190 -103.6363 44.54550 -7.272700 40.90910 -10.90910 -62.72730 35.45450 83.63630 -68.18190

假设 5:随机误差项服从 0 均值,同方差的正态 分布,即

2 i ~ N (0, ), ,,,,,,,,, ,, i 1,2, n

以上这些假设称为线性回归模型的经典假

设,满足这些假设的线性回归模型,也称为 经典线性回归模型(classical linear regression model)。在回归分析的参数估计和统计检验 理论中,许多结论都是以这些假定作为基础 的。如果违背其中的某一项假定,模型的参 数估计就会存在问题,也就是说最小二乘法 (OLS)就不再适用,需对模型进行修正或 采用其他的方法来估计模型了。

二、参数的普通最小二乘估计(OLS) 三、最小二乘估计量的性质 四、参数估计量的概率分布及随机误差项

方差的估计

给出一元线性回归模型的一般形式:

Yi 0 1 X i i ,,,, , i 1, 2, ,n

其中 Yi :被解释变量,X i :解释变量,0 和 1 :待估参 数; i :随机误差项;

ei2

(10) 2321.495 10740.48 1984.302 52.89217 1673.554 119.0085 3934.714 1257.022 6995.031 4648.771 33727.27

2.2 最小二乘的估计性质

ˆ ) E ( k ) k E ( ) E( i i 1 i i 1 1 1

同样地,容易得出

ˆ ) E ( w ) E( ) w E ( ) E( i i i i 0 0 0 0

3、有效性(最小方差性) , 即在所有线性无偏估计量

2

x nX n x

2 i 2 i

2

2

X n x

2 i i

2 2

(2)证明最小方差性

ˆ * 是其他估计方法得到的关于 的线性无偏估计量: 假设 1 1

ˆ* c Y ii 1

其中,ci=ki+di,di为不全为零的常数

则容易证明

ˆ * ) var( ˆ) var( 1 1

ˆ + ˆ Xi + ei • (2) 估计的统计模型 : Yi= 0 1

• (3) 真实的回归直线:E(Yi) = 0 + 1 Xi

ˆ = ˆ + ˆ Xi • (4) 估计的回归直线: Y i 0 1

二、参数估计量的概率分布及随机误差 项方差的估计

ˆ 的概率分布 ˆ 和 1、参数估计量 0 1

2 1 x 1 1 2 2 2 Xk i X 2 k i2 2 X k i X 2 i 2 x n n n n i 2

2

2 1 X n x2 i

高斯—马尔可夫定理(Gauss-Markov theorem)

在给定经典线性回归的假定下,最小二乘估计 量是具有最小方差的线性无偏估计量。

ˆ 证: 1

x y x

i 2 i

一元线性回归的最小二乘估计

3. 高斯--马尔柯夫定理(Gauss--Markov Theorem)

对于满足统计假设条件(1)--(4)的线性回归模型 Yt = + Xt + ut , ,普通最小二乘估计量 ( OLS估 计量) 是最佳线性无偏估计量(BLUE)。 或 对于古典线性回归模型(CLR模型)Yt=α+β+Xt , 普通最小二乘估计量(OLS估计量)是最佳线性无 偏估计量(BLUE)。

最小二乘法就是选择一条直线,使其残差平方和 ,使得 ˆ和 达到最小值的方法。即选择 α

ˆ )2 S et (Yt Y t

2

ˆX ) 2 ˆ (Yt t

达到最小值。

运用微积分知识,使上式达到最小值的必要条件为:

S S 0 ˆ ˆ

两边取期望值,得:

ˆ )2 E (

1 2 2 [ x E ( i ) xi x j E ( i j )] 2 2 i ( xt ) i j

由于 E( t )=

2

2

, t=1,2,…,n

——根据假设(3) ——根据假设(2)

E( i j )=0, i≠j

ˆ

xy 390 0.39,ˆ Y ˆ * X 22 0.39 * 30 10.3 x 1000

Eviews 创建工作文件,输入数据并进行回归:

Create u 1 5

data x y ls y c x

三、 最小二乘法估计量的性质 ˆ 和 ˆ 的均值 1.

2 1 2 2 2 ˆ E ( ) ( x 0) ∴ 2 2 i 2 ( xt ) x t 2 ˆ) 即 Var ( 2 x t

最小二乘估计量的性质

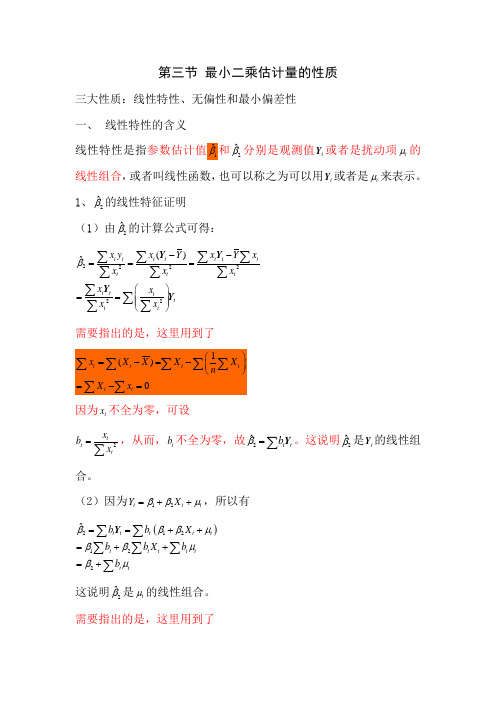

第三节 最小二乘估计量的性质三大性质:线性特性、无偏性和最小偏差性 一、 线性特性的含义线性特性是指参数估计值1ˆβ和2ˆβ分别是观测值t Y 或者是扰动项t μ的线性组合,或者叫线性函数,也可以称之为可以用t Y 或者是t μ来表示。

1、2ˆβ的线性特征证明 (1)由2ˆβ的计算公式可得: 222222()ˆt tttt ttttttt tt tt x y x Y x Y xxx xx x x x β--===⎛⎫== ⎪ ⎪⎝⎭∑∑∑∑∑∑∑∑∑∑∑Y Y Y Y需要指出的是,这里用到了因为t x 不全为零,可设2tt tx b x =∑,从而,t b 不全为零,故2ˆt t b β=∑Y 。

这说明2ˆβ是t Y 的线性组合。

(2)因为12t t t Y X ββμ=++,所以有()212122ˆt t t t t t t t t t t tb b X b b X b b βββμββμβμ==++=++=+∑∑∑∑∑∑Y这说明2ˆβ是t μ的线性组合。

需要指出的是,这里用到了220t t t t t x x b x x ===∑∑∑∑∑以及 ()2222222201t t tt t t tt ttttttttx x X x b X X x x x x X x X x x x x x⎛⎫+⎪== ⎪⎝⎭++==+=∑∑∑∑∑∑∑∑∑∑∑∑∑2、1ˆβ的线性特征证明 (1)因为12ˆˆY X ββ=-,所以有 ()121ˆˆ1t t t t tY X Y X b nXb n ββ=-=-⎛⎫=- ⎪⎝⎭∑∑∑Y Y这里,令1a Xb n=-,则有1ˆt a β=∑Y 这说明1ˆβ是t Y 的线性组合。

(2)因为回归模型为12t t t Y X ββμ=++,所以()11212ˆt t t t t t t t t ta a X a a X a βββμββμ==++=++∑∑∑∑∑Y因为111t t t a Xb X b nn⎛⎫=-=-=⎪⎝⎭∑∑∑∑。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第三节 最小二乘估计量的性质三大性质:线性特性、无偏性和最小偏差性 一、 线性特性的含义线性特性是指参数估计值1ˆβ和2ˆβ分别是观测值t Y 或者是扰动项t μ的线性组合,或者叫线性函数,也可以称之为可以用t Y 或者是t μ来表示。

1、2ˆβ的线性特征证明 (1)由2ˆβ的计算公式可得: 222222()ˆt tttt ttttttt tt tt x y x Y x Y xxx xx x x x β--===⎛⎫== ⎪ ⎪⎝⎭∑∑∑∑∑∑∑∑∑∑∑Y Y Y Y需要指出的是,这里用到了因为t x 不全为零,可设2tt tx b x =∑,从而,t b 不全为零,故2ˆt t b β=∑Y 。

这说明2ˆβ是t Y 的线性组合。

(2)因为12t t t Y X ββμ=++,所以有()212122ˆt t t t t t t t t t t tb b X b b X b b βββμββμβμ==++=++=+∑∑∑∑∑∑Y这说明2ˆβ是t μ的线性组合。

需要指出的是,这里用到了220t t t t t x x b x x ===∑∑∑∑∑以及 ()2222222201t t tt t t tt ttttttttx x X x b X X x x x x X x X x x x x x⎛⎫+⎪== ⎪⎝⎭++==+=∑∑∑∑∑∑∑∑∑∑∑∑∑2、1ˆβ的线性特征证明 (1)因为12ˆˆY X ββ=-,所以有 ()121ˆˆ1t t t t tY X Y X b nXb n ββ=-=-⎛⎫=- ⎪⎝⎭∑∑∑Y Y这里,令1a Xb n=-,则有1ˆt a β=∑Y 这说明1ˆβ是t Y 的线性组合。

(2)因为回归模型为12t t t Y X ββμ=++,所以()11212ˆt t t t t t t t t ta a X a a X a βββμββμ==++=++∑∑∑∑∑Y因为111t t t a Xb X b nn⎛⎫=-=-=⎪⎝⎭∑∑∑∑。

而 110t t t tt t t a X Xb X X X b X n n X X ⎛⎫=-=- ⎪⎝⎭-=∑∑∑∑ 所以,11ˆt t a ββμ=+∑ 这说明1ˆβ是t μ的线性组合。

至此,参数的线性特性证明完毕。

问题参数估计值线性特性的深层次含义是什么?要根据被解释变量、随机扰动项和的随机性来理解。

二、 无偏性的含义所谓无偏性是指估计值的均值等于真实值。

在这里,无偏性是指参数估计值1ˆβ和2ˆβ的期望值分别等于总体参数1β和2β。

其数学上要求是 ()11ˆE ββ=和()22ˆE ββ=。

证明:根据参数估计值的线性特征,我们推导出:11ˆt t a ββμ=+∑,所以有: ()()()()()()()()()()()111111ˆt t t t t t t t E E a E E a E E a E E a E E ββμβμβμβμβ=+=+=+=+•=∑∑∑∑ 相似地,22ˆt t b ββμ=+∑,所以有 ()()()()()()()()()()()222222ˆt t t t t t t t E E b E E b E E b E E b E E ββμβμβμβμβ=+=+=+=+•=∑∑∑∑ 三、 最优性(有的书本上直接称之为最小方差性)的含义最优性是指用最小二乘法得到的参数估计值1ˆβ和2ˆβ在各种线性无偏估计中得到的方差最小。

根据上述的定义,我们可以任意假设2ˆβ*是用其他方法得到的总体参数2ˆβ的一个线性无偏估计。

因为2ˆβ*具有线性特性,我们可以得到: ()212ˆt t t t t c c X βββμ*==++∑∑Y ,()()()()()()()()21212121212ˆ0t t t t t t t t t t t t t t t t t t tE E c E c X c E X c c E X c E c c E X c c X βββμββμββμββββ*==++=++=++=++=+∑∑∑∑∑∑∑∑∑∑Y又因为2ˆβ*是用其他方法得到的总体参数2ˆβ的一个无偏估计,所以有 ()22ˆE ββ*= 所以由上述两个结果,可以得到:122t t t c c X βββ+=∑∑上述式子要成立,必须同时满足两个条件,即0tc=∑和1t t c X =∑现在求2ˆβ*的方差: ()()()()()()()()()()()()()222222221122222112211221133223322ˆvar var ˆˆt t t t t t t t t t t t t t t t t t t t t t t t t t t c E c E c E c E c E c c E E c c E c E c E c c c E c c c c c c c c c c βμμμμμμμμμμμμμμ*⎡⎤==-⎣⎦⎡⎤⎡⎤=-=-⎣⎦⎣⎦⎡⎤⎡⎤=-=-⎣⎦⎣⎦⎡⎤==++⋅⋅⋅+⎣⎦=++⋅⋅⋅++++⋅⋅⋅++∑∑∑∑∑∑∑∑∑∑∑Y Y Y Y Y Y Y Y Y Y Y ()()()()4422t t t s t s c c E c E μμμμμ⎡⎤+⋅⋅⋅+⋅⋅⋅⎣⎦=+∑∑∑因为根据假设条件(常数方差和非自相关,即()222var()(())t t t t uE E E μμμμσ=-==和 [][]cov(,)(())(())(0)(0)()0t s t t s s t s t s E E E E E μμμμμμμμμμ=--=--==所以,有()()()()2222222222ˆvar 2u t u t t t uttututttc c b b c b bb c b βσσσσσ*==-+⎡⎤⎣⎦=-++-⎡⎤⎣⎦∑∑∑∑∑2ˆβ*方差的最后一项为 ()()()()2222222111(1)11tttt ttt t t t t t tt tt tttt t b c b b c bx x c x x c x x c X X x c XX c x -=-⎡⎤⎣⎦⎛⎫⎛⎫=- ⎪ ⎪⎪ ⎪⎝⎭⎝⎭=-=--=--=∑∑∑∑∑∑∑∑∑∑∑∑∑∑这是因为0t c =∑和1t t c X =∑因此,有()()22222ˆvar u t t u tc b b βσσ*=-+∑∑ 很明显,当t t c b =时,2ˆβ*方差最小,此时,最小值为()222ˆvar u t b βσ*=∑。

而在此时,有22ˆˆt t t t c b ββ*===∑∑Y Y 即两个估计值相等。

因为2ˆβ*的最小方差等于2ˆβ的方差,即()()22ˆˆvar var ββ*≥,因此,我们说,2ˆβ在所有线性无偏估计中的方差最小,且最小方差为: ()22222ˆvar u uttbx σβσ==∑∑同理,我们可以证明,1ˆβ在所有线性无偏估计中的方差最小,且参数估计值的方差为:()()2212ˆvar u t t X n x σβ=∑∑。

由此,说明,最小二乘估计具有BLUE(best linear unbiased estimation)性质。

从而在统计学和计量经济学中得到广泛应用。

第四节 系数的显著性检验一、 系数估计值的特性:1、根据系数估计值的线性特性,我们知道系数估计值是t Y 和t μ的线性组合。

又因为t Y 和t μ都服从正态分布,所以,我们可以自然得到两点:一是系数估计值是随机变量(这里是在数学上再次予以证明);二是系数估计值服从正态分布。

从而,可以用随机变量的一些数字特征来表示。

通常,我们采用的是均值与方差。

系数估计值的均值是多少呢?根据系数估计值的无偏性,我们知道,()11ˆE ββ=,()22ˆE ββ=。

这说明系数估计值1ˆβ和2ˆβ这两个随机变量的数学期望(均值)分别等于总体参数(实际值)。

系数估计值的方差又是多少呢?根据系数估计值的最小方差性的证明,我们得到了其方差,即有()()2212ˆvar u t tX n xσβ=∑∑ ,()22222ˆvar u uttbxσβσ==∑∑。

至此,我们可以用随机变量的数学期望和方差来刻画1ˆβ和2ˆβ这两个随机变量的分布,即有:1ˆβ服从均值为1β、方差为()222u t tX n xσ∑∑的正态分布;而2ˆβ服从均值为2β、方差为22u txσ∑的分布。

用数学的语言可以描述为:()2211,2ˆu t t X N n x σββ⎛⎫ ⎪ ⎪⎝⎭∑∑:和222,2ˆu t N x σββ⎛⎫ ⎪ ⎪⎝⎭∑:。

可以明显看出的是,在系数的描述中,方差中含有随机扰动项的方差,其他我们可以得到。

随机扰动项是总体回归模型中的误差项,无法得到,只能对其估计。

二、 随机误差项方差的估计因为总体回归模型为:12t t t Y X ββμ=++而样本回归模型为:12ˆˆt t tY X e ββ=++ 从形式上看,样本回归模型中的残差t e 可以看作随机扰动项t μ的估计值。

进一步,残差t e 的方差可以作为随机扰动项t μ的方差2u σ的估计值。

样本回归模型为:12ˆˆt t t Y X e ββ=++ 样本回归直线为:12ˆˆˆt tX ββ=+Y 样本回归模型的左右两边减去样本回归直线的左右两边,可得:ˆt t tY e -=Y ,把这个式子重新安排一下,可以得到: ()()ˆˆt t t t te Y Y Y Y =-=---Y Y现在,重点要求的是t e 的两个部分,即()ˆt Y -Y 和()tY Y -。

这两部分知道之后,才能求t e 的方差。

对样本回归模型12ˆˆt t tY X e ββ=++两边分别对t 求和,再除以n,有:1212121212ˆˆˆˆ1111ˆˆ1111ˆˆ1ˆˆt t ttttt t tt t t t Y X e Y X eY X e n n n n Y X e n n nn Y X e n ββββββββββ=++⇒=++⇒=++⇒=+⨯+⇒=++∑∑∑∑∑∑∑∑∑∑∑∑∑由前边的正规方程组,我们曾经知道,点(),X Y 在样本回归直线上,用数学的语言来讲,就有:12ˆˆY X ββ=+,因此,有 1212ˆˆˆˆˆt tX Y X ββββ=+=+Y ,进而,有 ()22ˆˆˆt t tY X X x ββ-=-=Y 对总体回归模型12t t t Y X ββμ=++两边分别对t 求和,再除以n,有:1212121211212111111111t t t tt t tt t tt t tnt Y X Y X Y X n n n n Y X n n n nY X Y X n μμββμββμββμββμββμββμ==++⇒=++⇒=++⇒=+⨯+∑⇒=++−−−−→=++∑∑∑∑∑∑∑∑∑∑∑∑∑ 所以,由1212t t t Y X Y X ββμββμ=++=++,可得,()()()22t t t t t Y Y X X x βμμβμμ-=-+-=+-将两部分结合起来,现在,我们可以得到:()()()22ˆˆˆˆt t t t t t tt t t e Y Y Y Y Y x Y Y x ββμμ=-=----=-=+-Y Y Y可以得到:()()22ˆt t te x ββμμ=-+-,(从这个式子我们可以看出什么呢?)至此,已经将残差与扰动项联系起来了。