模拟退火算法解决路径优化 的源代码

使用matlab实现模拟退火算法

使用matlab实现模拟退火算法标题:使用MATLAB实现模拟退火算法:优化问题的全局搜索方法引言:模拟退火算法(Simulated Annealing)是一种经典的全局优化算法,常用于解决各种实际问题,如组合优化、参数优化、图形分割等。

本文将详细介绍如何使用MATLAB实现模拟退火算法,并介绍其原理、步骤以及代码实现。

1. 模拟退火算法简介模拟退火算法借鉴了金属退火的物理过程,在解空间中进行随机搜索,用于找到全局最优解。

其核心思想是通过接受一定概率的劣解,避免陷入局部极小值,从而实现全局优化。

2. 模拟退火算法步骤2.1 初始参数设置在使用MATLAB实现模拟退火算法之前,我们需要配置一些初始参数,包括起始温度、终止温度、温度衰减系数等。

这些参数的合理设定对算法的效果至关重要。

2.2 初始解的生成在模拟退火算法中,我们需要随机生成一个初始解,作为搜索的起点。

这个初始解可以是随机生成的,也可以是根据问题本身的特性生成的。

2.3 判定条件模拟退火算法需要一个判定条件来决定是否接受新解。

通常我们使用目标函数值的差异来评估新解的优劣。

如果新解更优,则接受;否则,按照一定概率接受。

2.4 温度更新模拟退火算法中最重要的一步是对温度的更新。

温度越高,接受劣解的概率就越大,随着迭代的进行,温度逐渐降低,最终达到终止温度。

2.5 迭代过程在每次迭代中,我们通过随机生成邻近解,计算其目标函数值,并根据判定条件决定是否接受。

同时,根据温度更新的规则调整温度。

迭代过程中,不断更新当前的最优解。

3. MATLAB实现模拟退火算法在MATLAB中,我们可以通过编写函数或使用内置函数来实现模拟退火算法。

具体的实现方法取决于问题的复杂度和求解的要求。

我们需要确保代码的可读性和可复用性。

4. 示例案例:TSP问题求解为了演示模拟退火算法的实际应用,我们将以旅行商问题(Traveling Salesman Problem,TSP)为例进行求解。

matlab模拟退火法

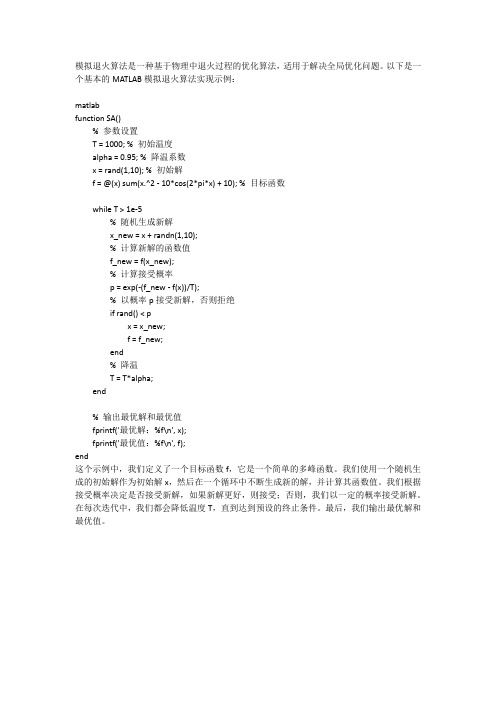

模拟退火算法是一种基于物理中退火过程的优化算法,适用于解决全局优化问题。

以下是一个基本的MATLAB模拟退火算法实现示例:

matlab

function SA()

% 参数设置

T = 1000; % 初始温度

alpha = 0.95; % 降温系数

x = rand(1,10); % 初始解

f = @(x) sum(x.^2 - 10*cos(2*pi*x) + 10); % 目标函数

while T > 1e-5

% 随机生成新解

x_new = x + randn(1,10);

% 计算新解的函数值

f_new = f(x_new);

% 计算接受概率

p = exp(-(f_new - f(x))/T);

% 以概率p接受新解,否则拒绝

if rand() < p

x = x_new;

f = f_new;

end

% 降温

T = T*alpha;

end

% 输出最优解和最优值

fprintf('最优解:%f\n', x);

fprintf('最优值:%f\n', f);

end

这个示例中,我们定义了一个目标函数f,它是一个简单的多峰函数。

我们使用一个随机生成的初始解作为初始解x,然后在一个循环中不断生成新的解,并计算其函数值。

我们根据接受概率决定是否接受新解,如果新解更好,则接受;否则,我们以一定的概率接受新解。

在每次迭代中,我们都会降低温度T,直到达到预设的终止条件。

最后,我们输出最优解和最优值。

一些解决TSP问题的算法及源代码

模拟退火算法新解的产生和接受可分为如下四个步骤:

第一步是由一个产生函数从当前解产生一个位于解空间的新解;为便于后续的计算和接受,减少算法耗时,通常选择由当

前新解经过简单地变换即可产生新解的方法,如对构成新解的全部或部分元素进行置换、互换等,注意到产生新解的变换方法

决定了当前新解的邻域结构,因而对冷却进度表的选取有一定的影响。

(3)产生新解S′

(4)计算增量Δt′=C(S′)-C(S),其中C(S)为评价函数

(5)若Δt′<0则接受S′作为新的当前解,否则以概率exp(-Δt′/T)接受S′作为新的当前解.

(6)如果满足终止条件则输出当前解作为最优解,结束程序。

终止条件通常取为连续若干个新解都没有被接受时终止算法。

(7) T逐渐减少,且T->0,然后转第2步。

(wm, wm-1 ,…,w1 , wm+1 ,…,wk-1 ,wn , wn-1 ,…,wk).

上述变换方法可简单说成是“逆转中间或者逆转两端”。

也可以采用其他的变换方法,有些变换有独特的优越性,有时也将它们交替使用,得到一种更好方法。

代价函数差设将(w1, w2 ,……,wn)变换为(u1, u2 ,……,un),则代价函数差为:

第二步是计算与新解所对应的目标函数差。因为目标函数差仅由变换部分产生,所以目标函数差的计算最好按增量计算。

事实表明,对大多数应用而言,这是计算目标函数差的最快方法。

第三步是判断新解是否被接受,判断的依据是一个接受准则,最常用的接受准则是Metropo1is准则:若Δt′<0则接受S′作

为新的当前解S,否则以概率exp(-Δt′/T)接受S′作为新的当前解S。

% coordinates given by LOC, which is an M by 2 matrix and M is

模拟退火算法(SA)求解TSP问题(C语言实现)

模拟退⽕算法(SA)求解TSP问题(C语⾔实现) 这篇⽂章是之前写的智能算法(遗传算法(GA)、粒⼦群算法(PSO))的补充。

其实代码我⽼早之前就写完了,今天恰好重新翻到了,就拿出来给⼤家分享⼀下,也当是回顾与总结了。

⾸先介绍⼀下模拟退⽕算法(SA)。

模拟退⽕算法(simulated annealing,SA)算法最早是由Metropolis等⼈提出的。

其出发点是基于物理中固体物质的退⽕过程与⼀般组合优化问题之间的相似性。

模拟退⽕算法是⼀种通⽤的优化算法,其物理退⽕过程由以下三部分组成: (1)加温过程 (2)等温过程 (3)冷却过程 其中加温过程对应算法设定的初始温度,等温过程对应算法的Metropolis抽样过程,冷却过程对应控制参数的下降。

这⾥能量的变化就是⽬标函数,要得到的最优解就是能量最低状态。

Metropolis准则是SA算法收敛于全局最优解的关键所在,Metropolis准则以⼀定的概率接受恶化解,这样就使得算法可以跳离局部最优解的陷阱。

模拟退⽕算法为求解传统⽅法难以处理的TSP问题提供了⼀个有效的途径和通⽤的处理框架,并逐渐发展成为⼀种迭代⾃适应启发式概率搜索算法。

模拟退⽕算法可以⽤于求解不同的⾮线性问题,对于不可微甚⾄不连续函数的优化,能以较⼤概率求得全局最优解,该算法还具有较强的鲁棒性、全局收敛性、隐含并⾏性以及⼴泛的适应性,对⽬标函数以及约束函数没有任何要求。

SA 算法实现的步骤如下:(下⾯以最⼩化问题为例) (1)初始化:取温度T0⾜够⼤,令T = T0,取任意解S1,确定每个T时的迭代次数,即 Metropolis链长L。

(2)对当前温度T和k=1,2,3,...,L,重复步骤(3)~(6) (3)对当前解S1随机产⽣⼀个扰动得到⼀个新解 S2. (4)计算S2的增量df = f(S2) - f(S1),其中f(S1)为S1的代价函数。

(5)若df < 0,接受S2作为新的当前解,即S1 = S2;否则S2的接受概率为 exp(-df/T),即随机产⽣(0,1)上的均匀分布的随机数rand,若 exp(-df/T)>rand,则接受S2作为新的当前解,S1 = S2;否则保留当前解。

c语言编写的模拟退火算法的代码

c语言编写的模拟退火算法的代码以下是一个简单的C语言编写的模拟退火算法的代码示例: c.#include <stdio.h>。

#include <math.h>。

#include <stdlib.h>。

#include <time.h>。

#define N 100 // 待优化参数的个数。

#define T_INITIAL 100.0 // 初始温度。

#define T_FINAL 0.1 // 最终温度。

#define ALPHA 0.9 // 降温速率。

// 计算当前解的能量。

double calculateEnergy(double solution[]) {。

// 这里可以根据具体问题来定义能量的计算方式。

// 以下是一个简单的示例,假设能量为各参数的平方和。

double energy = 0.0;for (int i = 0; i < N; i++) {。

energy += solution[i] solution[i];}。

return energy;}。

// 生成新的解。

void generateNewSolution(double currentSolution[], double newSolution[], double T) {。

// 这里可以根据具体问题来定义如何生成新解。

// 以下是一个简单的示例,假设每个参数在当前解的基础上增加一个随机值。

for (int i = 0; i < N; i++) {。

newSolution[i] = currentSolution[i] + (double)rand() / RAND_MAX T;}。

}。

// 模拟退火算法。

void simulatedAnnealing() {。

double currentSolution[N]; // 当前解。

double newSolution[N]; // 新的解。

模拟退火算法原理及matlab源代码

模拟退火算法模拟退火算法是一种通用的随机搜索算法,是局部搜索算法的扩展。

它的思想是再1953年由metropolis提出来的,到1983年由kirkpatrick等人成功地应用在组合优化问题中。

模拟退火算法来源于固体退火原理,将固体加温至充分高,再让其徐徐冷却,加温时,固体内部粒子随温升变为无序状,内能增大,而徐徐冷却时粒子渐趋有序,在每个温度都达到平衡态,最后在常温时达到基态,内能减为最小。

根据Metropolis准则,粒子在温度T时趋于平衡的概率为e-ΔE/(kT),其中E为温度T时的内能,ΔE为其改变量,k为Boltzmann常数。

用固体退火模拟组合优化问题,将内能E模拟为目标函数值f,温度T演化成控制参数t,即得到解组合优化问题的模拟退火算法:由初始解i和控制参数初值t开始,对当前解重复“产生新解→计算目标函数差→接受或舍弃”的迭代,并逐步衰减t值,算法终止时的当前解即为所得近似最优解,这是基于蒙特卡罗迭代求解法的一种启发式随机搜索过程。

退火过程由冷却进度表(Cooling Schedule)控制,包括控制参数的初值t及其衰减因子Δt、每个t值时的迭代次数L和停止条件S。

模拟退火算法新解的产生和接受可分为如下四个步骤:第一步是由一个产生函数从当前解产生一个位于解空间的新解;为便于后续的计算和接受,减少算法耗时,通常选择由当前新解经过简单地变换即可产生新解的方法,如对构成新解的全部或部分元素进行置换、互换等,注意到产生新解的变换方法决定了当前新解的邻域结构,因而对冷却进度表的选取有一定的影响。

第二步是计算与新解所对应的目标函数差。

因为目标函数差仅由变换部分产生,所以目标函数差的计算最好按增量计算。

事实表明,对大多数应用而言,这是计算目标函数差的最快方法。

第三步是判断新解是否被接受,判断的依据是一个接受准则,最常用的接受准则是Metropo1is准则: 若Δt′<0则接受S′作为新的当前解S,否则以概率exp(-Δt′/T)接受S′作为新的当前解S。

pyomo 模拟退火解方程

pyomo 模拟退火解方程

Pyomo是一个用于建模和求解数学优化问题的Python库,而模

拟退火是一种全局优化算法,通常用于求解复杂的非线性、非凸优

化问题。

要使用Pyomo进行模拟退火来解方程,你可以按照以下步

骤进行:

1. 定义优化模型,首先,你需要使用Pyomo来定义你的优化模型。

这包括定义决策变量、约束条件和优化目标函数。

在这个步骤中,你需要考虑如何将你的方程转化为数学模型的形式。

2. 配置模拟退火算法,Pyomo提供了一些优化算法的接口,包

括模拟退火算法。

你需要配置模拟退火算法的参数,比如初始温度、降温速度等。

这些参数的选择对算法的收敛性和效率有很大影响。

3. 求解优化问题,一旦你的模型和算法都配置好了,你可以使

用Pyomo来求解优化问题。

Pyomo会调用模拟退火算法来尝试找到

方程的最优解。

需要注意的是,将方程转化为优化模型的过程可能会比较复杂,特别是对于非线性方程。

你需要仔细考虑如何将方程的约束条件和

目标函数转化为优化模型的约束条件和目标函数。

此外,模拟退火算法通常用于全局优化,对于特定的方程可能存在更适合的优化算法,你需要权衡选择合适的算法。

总之,使用Pyomo的模拟退火算法来解方程是可行的,但需要仔细思考如何建立数学模型,并对算法的参数进行合适的调整。

希望这些信息能够帮助你开始使用Pyomo进行模拟退火来解方程。

如何在Matlab中进行模拟退火算法的优化

如何在Matlab中进行模拟退火算法的优化模拟退火算法是一种用于求解复杂问题的全局优化算法。

在Matlab中,我们可以利用其强大的数值计算和优化工具箱来实现模拟退火算法的优化。

本文将介绍如何在Matlab中进行模拟退火算法的优化,并通过一个实际的案例来演示其应用。

一、模拟退火算法简介模拟退火算法是一种启发式的全局优化算法,模拟了固体物体在退火过程中的特性。

其基本原理是通过模拟固体退火过程,逐渐降低系统能量,从而找到全局最优解。

在模拟退火算法中,由于退火过程中存在较高的温度,使算法有机会跳出局部极小值点,因此能够在搜索空间中全面地寻找最优解。

二、Matlab中的模拟退火算法优化函数Matlab提供了优化工具箱,在其中包含了一系列优化函数,其中包括模拟退火算法。

我们可以使用"simulannealbnd"函数来在Matlab中实现模拟退火算法的优化。

三、案例演示:函数最优化假设我们要求解以下函数的最小值:f(x) = x^2 + sin(5x)我们可以使用Matlab中的模拟退火算法优化函数来找到该函数的全局最小值。

1. 定义目标函数首先,我们需要在Matlab中定义目标函数:function y = myfunc(x)y = x.^2 + sin(5*x);2. 编写优化代码接下来,我们可以编写优化代码,利用"simulannealbnd"函数进行模拟退火算法的优化:options = saoptimset('Display','iter','TolFun',1e-6);[x,fval] = simulannealbnd(@myfunc, [-10,10],[],[],options);在上述代码中,"options"用于设置优化选项,"@myfunc"是要优化的目标函数,[-10,10]为变量的取值范围,[]表示无约束条件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

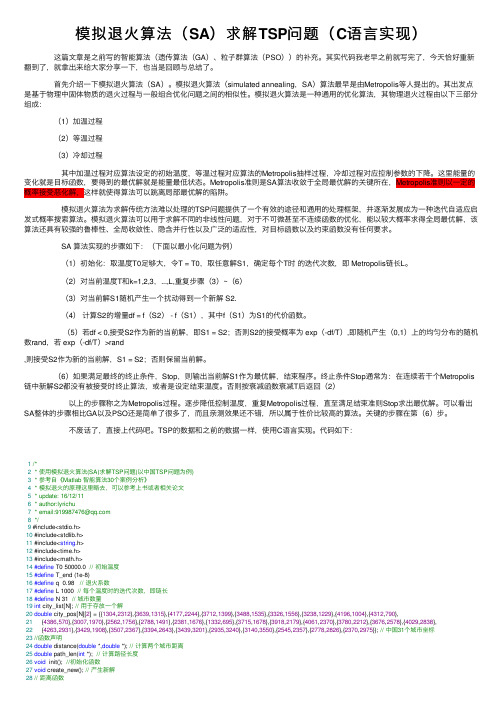

ÎÒÓÐ simulated annealing with metropolies(Monte Carlo)×öµÄÒ»¸öÏîÄ¿µÄ´úÂ룬ÄãÒª¿´¿´Ã´£¿void anneal(int nparam, int nstep, int nstep_per_block, double t0,const double * param_in,double cost_in, double * params_out, double * cost_out) {int nblock;int step;int block;int nactive;int rank;int n_accepted = 0;int i, j, n;double cost_current, cost_trial;int * param_index;double * param_current;double * param_trial;double * Q;double * S;double * u;double * dp;double * A;FILE * fp_log_file;char fname[FILENAME_MAX];double temp = t0;double tempmax = temp;double ebar, evar, emin, eta, specific_heat;double delta;double chi = 0.8; // Annealing scheduledouble chi_s = 3.0; // Vanderbilt/Louie 'growth factor' double rm;double root3 = sqrt(3.0);double p = 0.02/sqrt(3.0); //max size of annealing stepparam_current = new double[nparam];param_trial = new double[nparam];cost_current = cost_in;MPI_Comm_rank(MPI_COMM_WORLD, &rank);sprintf(fname, "a_%4.4d.log", rank);fp_log_file = fopen(fname, "a");if (fp_log_file == (FILE *) NULL) errorMessage("fopen(log) failed\n");// Work out the number of active parameters, and set up the// index table of the active parameters.// Note that the complete array of parameters (param_trial) must // be used to evaluate the cost function.nactive = 0;for (n = 0; n < nparam; n++) {param_current[n] = param_in[n];param_trial[n] = param_in[n];if (P.is_active[n]) nactive++;}param_index = new int[nactive];i = 0;for (n = 0; n < nparam; n++) {if (P.is_active[n]) param_index[i++] = n;}// Initialise the step distribution matrix Q_ijQ = new double[nactive*nactive];S = new double[nactive*nactive];u = new double[nactive];dp = new double[nactive];A = new double[nactive];double * Qtmp;Qtmp = new double[nactive*nactive];for (i = 0; i < nactive; i++) {for (j = 0; j < nactive; j++) {delta = (i == j);Q[i*nactive + j] = p*delta*param_current[param_index[j]]; }}// carry out annealing pointsnblock = nstep/nstep_per_block;rm = 1.0/(double) nstep_per_block;for (block = 0; block < nblock; block++) {// Set the schedule for this block, and initialise blockwise quantities. // We also ensure the step distribution matrix is diagonal.temp = chi*temp;for (i = 0; i < nactive; i++) {A[i] = 0.0;for (j = 0; j < nactive; j++) {S[i*nactive + j] = 0.0;delta = (i == j);Q[i*nactive + j] *= delta;}}ebar = 0.0;evar = 0.0;emin = cost_current;for (i = 0; i < nactive; i++) {printf("Step: %d %g\n", i, Q[i*nactive + i]);}for (step = 0; step < nstep_per_block; step++) {// Set the random vector u, and compute the step size dpfor (i = 0; i < nactive; i++) {u[i] = root3*(r_uniform()*2.0 - 1.0);}for (i = 0; i < nactive; i++) {dp[i] = 0.0;for (j = 0; j < nactive; j++) {dp[i] += Q[i*nactive + j]*u[j];}}for (i = 0; i < nactive; i++) {n = param_index[i];param_trial[n] = param_current[n] + dp[i];if (param_trial[n] < P.min[n]) param_trial[n] = P.min[n];if (param_trial[n] > P.max[n]) param_trial[n] = P.max[n];}// calculate new cost function scorep_model->setParameters(param_trial);cost_trial = p_costWild->getCost();cost_trial += p_costLHY->getCost();cost_trial += p_costTOC1->getCost();cost_trial += p_costAPRR->getCost();// Metropolisdelta = cost_trial - cost_current;if (delta < 0.0 || r_uniform() < exp(-delta/temp)) {for (n = 0; n < nparam; n++) {param_current[n] = param_trial[n];}cost_current = cost_trial;++n_accepted;}// 'Energy' statisticsebar += cost_current;evar += cost_current*cost_current;if (cost_current < emin) emin = cost_current;// Per time step logfprintf(fp_log_file, "%6d %6d %10.4f %10.4f %10.4f %10.4f\n", block, step, temp,cost_current, cost_trial,(float) n_accepted / (float) (block*nstep_per_block + step)); // Accumulate average, measured covariancefor (i = 0; i < nactive; i++) {A[i] += param_current[param_index[i]];for (j = 0; j < nactive; j++) {S[i*nactive + j]+= param_current[param_index[i]]*param_current[param_index[j]]; }}/* Next step*/}// Set the previous block average and measured covariancefor (i = 0; i < nactive; i++) {A[i] = rm*A[i];}for (i = 0; i < nactive; i++) {for (j = 0; j < nactive; j++) {S[i*nactive + j] = rm*S[i*nactive + j] - A[i]*A[j];if (i == j) printf("Average: %d %g %g\n", i, A[i], S[i*nactive+j]); // Set the convarience for the next iteration s = 6 chi_s S / MS[i*nactive + j] = 6.0*chi_s*rm*S[i*nactive + j];}}// Reset the step distribution matrix for the next blocki = do_cholesky(nactive, S, Q);j = test_cholesky(nactive, S, Q);printf("Cholesky %d %d\n", i, j);// Block statisticsebar = rm*ebar;evar = rm*evar;specific_heat = (evar - ebar*ebar) / temp*temp;eta = (ebar - emin)/ebar;fprintf(fp_log_file, "%d %d %f %f %f %f %f %f\n", block, nstep_per_block, temp, ebar, evar, emin, specific_heat, eta);/* Next block */}*cost_out = cost_current;for (n = 0; n < nparam; n++) {params_out[n] = param_current[n];}fclose(fp_log_file);delete param_index;delete param_current; delete param_trial;delete Q;delete u;delete dp;delete S;delete A;return;}。