信息论基础信息论PPT课件

合集下载

数字通信原理4信息论基础1103页PPT文档

xMy1,pxMy1 xMy2,pxMy2 ...xMyN,pxMyN

满足条件:

M i1

N j1pxiyj 1

2020/4/5

11

离散信源的联合熵与条件熵(续)

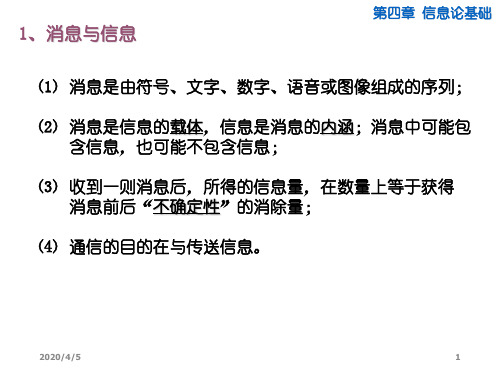

第四章 信息论基础

两随机变量的联合熵

定义4.2.3 两随机变量 X :x iy Y j,i 1 , 2 ,. M ; .j .1 , 2 ,,. N ..,

I[P(xM)]

H(X)

图4-2-1 符号的平均信息量与各个符号信息量间关系 的形象表示

2020/4/5

7

离散信源的熵(续) 示例:求离散信源

X: 0 1 2 3

pX: 38 14 14 18

的熵。

第四章 信息论基础

按照定义:

H X i4 1pxilopg xi 8 3lo8 3g 1 4lo1 4g 1 4lo1 4g 8 1lo8 1g

2020/4/5

6

4、离散信源的平均信息量:信源的熵

第四章 信息论基础

离散信源的熵

定义4.2.2 离散信源 X:xi,i 1 ,2 ,.N ..的,熵

H X iN 1p xilop x g i

熵是信源在统计意义上每个符号的平均信息量。

I[P(x1)]

I[P(x2)]

I[P(x3)]

I[P(x4)]

同时满足概率函数和可加性两个要求。

2020/4/5

4

离散信源信的息量(续)

第四章 信息论基础

定义 离散消息xi的信息量:

IPxi loP g1xiloP gxi

信息量的单位与对数的底有关:

log以2为底时,单位为比特:bit

log以e为底时,单位为奈特:nit

《信息论基础》课件

2

信息论与数学中的概率论、统计学、组合数学等 学科密切相关,这些学科为信息论提供了重要的 数学工具和理论基础。

3

信息论与物理学中的量子力学、热力学等学科也 有密切的联系,这些学科为信息论提供了更深层 次的理论基础。

信息论未来发展趋势

信息论将继续深入研究量子信 息论和网络信息论等领域,探 索更高效、更安全的信息传输

和处理技术。

随着人工智能和大数据等技 术的快速发展,信息论将在 数据挖掘、机器学习等领域

发挥更大的作用。

信息论还将继续关注网络安全 、隐私保护等问题,为构建安 全可靠的信息社会提供重要的

理论支持。

2023

REPORTING

THANKS

感谢观看

海明码(Hamming Code): 一种能够纠正一位错误的线性 纠错码。

里德-所罗门码(ReedSolomon Code):一种广泛 应用于数据存储和通信领域的 强纠错码。

差错控制机制

前向纠错(FEC)

01

在发送端采用纠错编码,使得接收端能够自动纠正传输过程中

的错误。

自动重传请求(ARQ)

02

接收端检测到错误后请求发送端重传数据,直到接收正确为止

常见信道编码技术

线性分组码

将信息序列划分为若干组,对每组进行线性 编码,常见的有汉明码、格雷码等。

循环码

将信息序列进行循环移位后进行编码,常见的有 BCH码、RS码等。

卷积码

将信息序列进行卷积处理后进行编码,常见 的有Convolutional Code等。

2023

PART 04

信息传输与错误控制

。

混合纠错(HEC)

03

结合前向纠错和自动重传请求,以提高数据传输的可靠性和效

信息论基础 ppt课件

他认为“信息是事物运动状态或存在 方式的不确定性的描述”。

ppt课件

(2)信息与消息和信号的区别

在通信中对信息的表达分为三个层次:信号、消息、信 息。

信号:是信息的物理表达层,是三个层次中最具体的层 次。它是一个物理量,是一个载荷信息的实体,可测量、

可描述、可显示。如电信号、光信号等。

消息:(或称为符号)是信息的数学表达层,它虽不是一 个物理量,但是可以定量地加以描述,它是具体物理信 号的进一步数学抽象,可将具体物理信号抽象为两大类 型: 1) 离散(数字)消息,是一组未知量,可用随机序列来 描述:U=(U1…Ui…UL) 2) 连续(模拟)消息,也是未知量,它可用随机过程来 描述:U(t,ω)

ppt课件

学习方法

本课程以概率论为基础,数学推导较多,学 习时主要把注意力集中到概念的理解上,不要 过分追求数学细节的推导。学习时一定要从始 至终注意基本概念的理解,不断加深概念的把 握。学习时注意理解各个概念的“用处”,结 合其他课程理解它的意义,而不要把它当作数 学课来学习,提倡独立思考,注重思考在学习 中的重要性。

信息论--基础理论与应用

北京理工大学 信息与电子学院 2014年3月

ppt课件

课程类型:专业选修课 学 时:32学时 授课时间:第一周----第八周 考试时间:第九周 教 材:《信息论—基础理论与应用》,傅祖芸,电子工业出版社 参考教材:

①《信息论与编码》,陈运,电子工业出版社 ②《应用信息论基础》,朱雪龙,清华大学出版社 ③《信息论与编码学习辅导及习题详解》傅祖芸,电子工业出版社

ppt课件

信息论

信息论已经成为现代信息科学的一个重要组成部分,它 是现代通信和信息技术的理论基础。现代信息论又是数 学概率论下的一个分支,与遍历性理论、大偏差理论以 及统计力学等都有密切关系,因此信息论已成为大学诸 多专业的必修课和选修课,并不再局限于已有的通信工 程、电子工程、信息工程等专业。

ppt课件

(2)信息与消息和信号的区别

在通信中对信息的表达分为三个层次:信号、消息、信 息。

信号:是信息的物理表达层,是三个层次中最具体的层 次。它是一个物理量,是一个载荷信息的实体,可测量、

可描述、可显示。如电信号、光信号等。

消息:(或称为符号)是信息的数学表达层,它虽不是一 个物理量,但是可以定量地加以描述,它是具体物理信 号的进一步数学抽象,可将具体物理信号抽象为两大类 型: 1) 离散(数字)消息,是一组未知量,可用随机序列来 描述:U=(U1…Ui…UL) 2) 连续(模拟)消息,也是未知量,它可用随机过程来 描述:U(t,ω)

ppt课件

学习方法

本课程以概率论为基础,数学推导较多,学 习时主要把注意力集中到概念的理解上,不要 过分追求数学细节的推导。学习时一定要从始 至终注意基本概念的理解,不断加深概念的把 握。学习时注意理解各个概念的“用处”,结 合其他课程理解它的意义,而不要把它当作数 学课来学习,提倡独立思考,注重思考在学习 中的重要性。

信息论--基础理论与应用

北京理工大学 信息与电子学院 2014年3月

ppt课件

课程类型:专业选修课 学 时:32学时 授课时间:第一周----第八周 考试时间:第九周 教 材:《信息论—基础理论与应用》,傅祖芸,电子工业出版社 参考教材:

①《信息论与编码》,陈运,电子工业出版社 ②《应用信息论基础》,朱雪龙,清华大学出版社 ③《信息论与编码学习辅导及习题详解》傅祖芸,电子工业出版社

ppt课件

信息论

信息论已经成为现代信息科学的一个重要组成部分,它 是现代通信和信息技术的理论基础。现代信息论又是数 学概率论下的一个分支,与遍历性理论、大偏差理论以 及统计力学等都有密切关系,因此信息论已成为大学诸 多专业的必修课和选修课,并不再局限于已有的通信工 程、电子工程、信息工程等专业。

信息论基础课件2[1][1].1.1- 2

![信息论基础课件2[1][1].1.1- 2](https://img.taocdn.com/s3/m/5d523fd3360cba1aa811da2f.png)

r i 1

a2

…

ar p(ar)

p(a2) …

0 p(a i ) 1i 1,2, r

p(a i ) 1

信息论与编码-信源熵

需要注意的是,大写字母X,Y,Z代表随机变量,指 的是信源整体,带下标的小写字母代表随机事件的 某一结果或信源的某个元素。两者不可混淆。

信息论与编码-信源熵

(4) 如p(xi)=1,则I(xi) =0 ;(必然事件不含有任何不确定 性,所以不含有任何信息量)

(5) 自信息量也是一个随机变量,它没有确定的值。

信息论与编码-信源熵

例2、 设有12枚同值硬币,其中有一枚为假币,且只知道假币

的重量与真币的重量不同,但不知究竟是轻是重。现采 用天平比较两边轻重的方法来测量(因无法码)。问至 少需要称多少次才能称出假币? 解:用天平每称一次能获得一定的信息量,能消除部分的不 确定性。测量若干次后,能消除全部不确定性,获得全部信 息,也就能确定出假币。 设“在12枚同值硬币中,某一枚为假币”该事件为a, p(a ) 1 / 12 则 p 又设“假币是重、或是轻”该事件为b,则(b) 1 / 2

(5)当X与Y相互独立时,

p( y j / xi ) p( y j ), p( xi / y j ) p( xi ), p( xi y j ) p( xi ) p( y j )

( 6) p( x i / y j ) p( x i y j )

p( x i y j )

i 1

n

p( y j / xi )

i 1 n j 1 i 1 j 1 i 1

n

m

n

m

n

p( xi y j ) p( y j ), p( xi y j ) p( xi )

a2

…

ar p(ar)

p(a2) …

0 p(a i ) 1i 1,2, r

p(a i ) 1

信息论与编码-信源熵

需要注意的是,大写字母X,Y,Z代表随机变量,指 的是信源整体,带下标的小写字母代表随机事件的 某一结果或信源的某个元素。两者不可混淆。

信息论与编码-信源熵

(4) 如p(xi)=1,则I(xi) =0 ;(必然事件不含有任何不确定 性,所以不含有任何信息量)

(5) 自信息量也是一个随机变量,它没有确定的值。

信息论与编码-信源熵

例2、 设有12枚同值硬币,其中有一枚为假币,且只知道假币

的重量与真币的重量不同,但不知究竟是轻是重。现采 用天平比较两边轻重的方法来测量(因无法码)。问至 少需要称多少次才能称出假币? 解:用天平每称一次能获得一定的信息量,能消除部分的不 确定性。测量若干次后,能消除全部不确定性,获得全部信 息,也就能确定出假币。 设“在12枚同值硬币中,某一枚为假币”该事件为a, p(a ) 1 / 12 则 p 又设“假币是重、或是轻”该事件为b,则(b) 1 / 2

(5)当X与Y相互独立时,

p( y j / xi ) p( y j ), p( xi / y j ) p( xi ), p( xi y j ) p( xi ) p( y j )

( 6) p( x i / y j ) p( x i y j )

p( x i y j )

i 1

n

p( y j / xi )

i 1 n j 1 i 1 j 1 i 1

n

m

n

m

n

p( xi y j ) p( y j ), p( xi y j ) p( xi )

信息论基础教学课件ppt信息论基础概述信息论基础概论

33

§1.2.1 通信系统模型

例如,奇偶纠错 将信源编码输出的每个码组的尾补一个1或0 当传输发生奇数差错,打乱了“1”数目的奇偶性,就 可以检测出错误。

34

§1.2.1 通信系统模型

(a) 无检错

(b) 可检错 (奇校验) (c) 可纠错(纠一个错)

图1.4 增加冗余符号增加可靠性示意图

35

§1.2.1 通信系统模型

信源的消息中所包含的信息量 以及信息如何量度

核心 问题

29

§1.2.1 通信系统模型

编码器(Encoder)

编码器的功能是将消息变成适合于信道传输的信号 编码器包括:

信源编码器(source encoder) 信道编码器(channel encoder) 调制器(modulator)

信源编码器

信道编码器

调制器

功能:将编码器的输出符号变成适合信道传输的信号 目的:提高传输效率 信道编码符号不能直接通过信道输出,要将编码器的输 出符号变成适合信道传输的信号,例如,0、1符号变成 两个电平,为远距离传输,还需载波调制,例如,ASK, FSK,PSK等。

36

§1.2.1 通信系统模型

信道(channel)

13

§1.1.2 信息的基本概念

1949年,Weaver在《通信的数学》中解释香农的工 作时,把通信问题分成三个层次: 第一层:通信符号如何精确传输?(技术问题) 第二层:传输的符号如何精确携带所需要的含义?(语义问题) 第三层:所接收的含义如何以所需要的方式有效地影响行为? (效用问题)

14

§1.1.2 信息的基本概念

§1.1.2 信息的基本概念

信息的三个基本层次:

语法(Syntactic)信息 语义(Semantic) 信息 语用(Pragmatic)信息

§1.2.1 通信系统模型

例如,奇偶纠错 将信源编码输出的每个码组的尾补一个1或0 当传输发生奇数差错,打乱了“1”数目的奇偶性,就 可以检测出错误。

34

§1.2.1 通信系统模型

(a) 无检错

(b) 可检错 (奇校验) (c) 可纠错(纠一个错)

图1.4 增加冗余符号增加可靠性示意图

35

§1.2.1 通信系统模型

信源的消息中所包含的信息量 以及信息如何量度

核心 问题

29

§1.2.1 通信系统模型

编码器(Encoder)

编码器的功能是将消息变成适合于信道传输的信号 编码器包括:

信源编码器(source encoder) 信道编码器(channel encoder) 调制器(modulator)

信源编码器

信道编码器

调制器

功能:将编码器的输出符号变成适合信道传输的信号 目的:提高传输效率 信道编码符号不能直接通过信道输出,要将编码器的输 出符号变成适合信道传输的信号,例如,0、1符号变成 两个电平,为远距离传输,还需载波调制,例如,ASK, FSK,PSK等。

36

§1.2.1 通信系统模型

信道(channel)

13

§1.1.2 信息的基本概念

1949年,Weaver在《通信的数学》中解释香农的工 作时,把通信问题分成三个层次: 第一层:通信符号如何精确传输?(技术问题) 第二层:传输的符号如何精确携带所需要的含义?(语义问题) 第三层:所接收的含义如何以所需要的方式有效地影响行为? (效用问题)

14

§1.1.2 信息的基本概念

§1.1.2 信息的基本概念

信息的三个基本层次:

语法(Syntactic)信息 语义(Semantic) 信息 语用(Pragmatic)信息

信息论基础 绪论PPT

P.5

三 信息论的研究范畴

基础 信息论

工程 信息论

广义 信息论

(一)基础信息论

主要研究通信系统的数学描述与定量分析,研究系统的最优状态

与优化理论, 即研究通信系统理论上的潜在能力与数学上的极限情 况。它是以存在性研究为主体,又称它为数学信息论。

2018/11/10 P.6

三 信息论的研究范畴

(二) 工程信息论

5) “现代情报理论”,(有本卓),中译本:近代信息论 6) “应用信息论基础”,清华大学出版社,2001年,

2018/11/10

P.10

1) 信源的描述,信息的定量度量、分析与计算。 2) 信道的描述,信道传输的定量度量、分析与计算。

3) 信源、信道与通信系统之间的统计匹配,以及通信系统的

优化。 ——Shannon的三个编码定理。 信息论诞生五十年来至今,仍然是指导通信技术发展的理 论基础,是创新新通信体制的源泉。

2018/11/10

如离散或连续)来定量描述。同样,同一信号形式,比如“0”与“1”

可以表达不同形式的信息,比如无与有、断与通、低与高(电平)等等。

2018/11/10

P.4

二 什么是信息论?

它是C.E.Shannon四十年代末期,以客观概率信息为研究对象,

从通信的信息传输问题中总结和开拓出来的理论。主要研究的问题:

2018/11/10 P.2

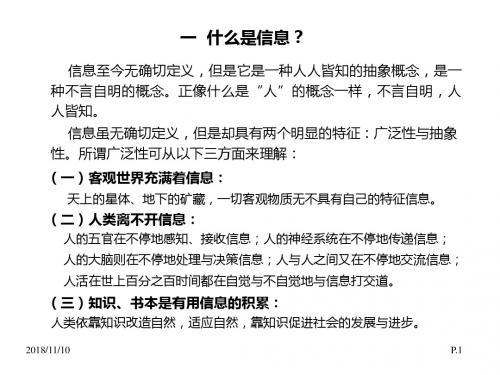

一 什么是信息?

信号:是信息的物理表达层,是三个层次中最具体的层次。它是 一个物理量,是一个载荷信息的实体,可测量、可描述、可显示。 消息:(或称为符号)是信息的数学表达层,它虽不是一个物理量 ,但是可以定量地加以描述,它是具体物理信号的进一步数学抽象, 可将具体物理信号抽象为两大类型: 1) 离散(数字)消息,是一组未知量,可用随机序列来描述: U=(U1…Ul…UL) 2)连续(模拟)消息,也是未知量,它可用随机过程来描述: U(t,ω)

信息论基础课件2.1.3

1

(3)最大离散熵定理

定理:信源X中包含n个不同的离散消息时,信源熵 H(X)有 H ( X ) log2 n 当且仅当X中各个消息出现的概率全相等时,上式 取等号。

1 p( xi ) log2 n 证明: H ( X ) log2 n p( x i ) log2 p( x i ) i 1 i 1

r

pi log pi pi log[ pi (1 )qi ]

i 1

r

r

r

i 1

r 1 pi l og (1 ) qi l ogqi pi i 1 i 1

1 (1 ) qi l og[ pi (1 )qi ] (1 ) qi l og qi i 1 i 1

p( x i y j ) log 2 [ p( x i ) p( y j / x i )]

i j

p( x i y j ) log2 p( x i ) p( x i y j ) log 2 p( y j / x i )

i j

i

j

p( x i ) log2 p( x i ) H (Y / X )

i

i

j

H ( X ) H (Y / X )

得证。

8

7、极值性(香农辅助定理)

,q 对于任意n及概率矢量 P ( p1 , p2 ,, pn ) 和 Q (q1 , q2 ,,n ) n n 有如下不等式成立 H ( p1 , p2 ,, pn ) pi log pi pi log qi

l 1

k l 1

k

H ( X ) [ p j log p j ] ( pi ) log(pi ) [ l log l ]

(3)最大离散熵定理

定理:信源X中包含n个不同的离散消息时,信源熵 H(X)有 H ( X ) log2 n 当且仅当X中各个消息出现的概率全相等时,上式 取等号。

1 p( xi ) log2 n 证明: H ( X ) log2 n p( x i ) log2 p( x i ) i 1 i 1

r

pi log pi pi log[ pi (1 )qi ]

i 1

r

r

r

i 1

r 1 pi l og (1 ) qi l ogqi pi i 1 i 1

1 (1 ) qi l og[ pi (1 )qi ] (1 ) qi l og qi i 1 i 1

p( x i y j ) log 2 [ p( x i ) p( y j / x i )]

i j

p( x i y j ) log2 p( x i ) p( x i y j ) log 2 p( y j / x i )

i j

i

j

p( x i ) log2 p( x i ) H (Y / X )

i

i

j

H ( X ) H (Y / X )

得证。

8

7、极值性(香农辅助定理)

,q 对于任意n及概率矢量 P ( p1 , p2 ,, pn ) 和 Q (q1 , q2 ,,n ) n n 有如下不等式成立 H ( p1 , p2 ,, pn ) pi log pi pi log qi

l 1

k l 1

k

H ( X ) [ p j log p j ] ( pi ) log(pi ) [ l log l ]

《信息论基础》PPT课件

精选ppt

9

信息论的研究内容

狭义信息论(经典信息论)

研究信息测度,信道容量以及信源和信道编码理论

一般信息论

研究信息传输和处理问题,除经典信息论外还包括噪 声理论,信号滤波和预测,统计检测和估值理论,调 制理论,信息处理理论和保密理论

广义信息论

除上述内容外,还包括自然和社会领域有关信息的内 容,如模式识别,计算机翻译,心理学,遗传学,神 经生理学

精选ppt

10

Shannon理论

Shannon定理的证明是非构造性的,而且也不够严格,但 他的“数学直观出奇地正确”(A. N. Kolmogrov,1963)。 已在数学上严格地证明了Shannon编码定理,而且发现了 各种具体可构造的有效编码理论和方法,可以实现 Shannon指出的极限。

几乎无错地经由Gaussian信道传信 对于非白Gassian信道,Shannon的注水定理和多载波调制(MCM) CDMA、MCM(COFDM)、TCM、BCM、各种均衡、对消技术、

精选ppt

12

I信源编码与数据压缩-关键理论进展 的十个里程碑[Kieffer 1993]

1. 无扰信源编码的诞生(1948, C. E. Shannon)。 2. Huffman算法的发现(1952, D. A. Huffman)。 3. 建立Shannon-McMillan定理(1953, B. McMillan)。 4. 发现Lloyd算法(1957, S. P. Lloyd ,1982年发表,)。 5. 率失真理论系统化(1959, C. E. Shannon,)。 6. Kolmogorov Complexity概念诞生(1964, A. N. Kolmogorov,)。 7. 通用信源编码理论系统化(1973, L. D. Davission)。 8. 多端信源编码理论诞生(1973, D. Slepian和J. K. Wolf)。 9. 第一个实际的算术编码方案(1976, J. Rissannen和R. Pasco

信息论基础详细ppt课件

1928年,哈特莱(Hartley)首先提出了用对数度量信

息的概念。一个消息所含有的信息量用它的可能值

香农

的个数的对数来表示。

(香农)信息: 信息是事物运动状态或存在方式的不确定性的描述。 可运用研究随机事件的数学工具——概率来测度不确定性大小。 在信息论中,我们把消息用随机事件表示,而发出这些消息的信 源则用随机变量来表示。

2.1 自信息和互信息

2.1.1 自信息

随机事件的自信息量 I (xi ) 是该事件发生概率 p(xi ) 的函数,并且应该满 足以下公理化条件:

1. I (xi )是 p(xi )的严格递减函数。当 p(x1)p(x2) 时,I(x1)I(x2),概率 越小,事件发生的不确定性越大,事件发生后所包含的自信息量越大

事件 x i 的概率为p(xi ) ,则它的自信息定义为:

I(xi)d eflogp(xi)logp(1xi)

从图2.1种可以看到上述信息量的定义正 是满足上述公理性条件的函数形式。I (xi ) 代表两种含义:当事件发生以前,等于 事件发生的不确定性的大小;当事件发 生以后,表示事件所含有或所能提供的 信息量。

2.极限情况下当 p(xi )=0时,I(xi);当 p(xi ) =1时,I (xi ) =0。

3.另外,从直观概念上讲,由两个相对独立的不同的消息所提供的 信息量应等于它们分别提供的信息量之和。 可以证明,满足以上公理化条件的函数形式是对数形式。

定义2.1 随机事件的自信息量定义为该事件发生概率的对数的负值。

我们把某个消息 x i 出现的不确定性的大小,定义为自信息,用这

个消息出现的概率的对数的负值来表示:I(xi)lop(g xi)

自信息同时表示这个消息所包含的信息量,也就是最大能够给予 收信者的信息量。如果消息能够正确传送,收信者就能够获得这 么大小的信息量。

信息论课件.ppt教学文案

– 先验概率:选择符号 ai 作为消息的概率----P(ai)

– 自信息:ai 本身携带的信息量

I(ai

)

log 1 P(ai

)

– 后验概率:接收端收到消息(符号) bj 后而发送端

发的是 ai 的概率 P(ai/bj)

– 互信息:收信者获得的信息量-----先验的不确定 性减去尚存在的不确定性

I(ai;bj)loP g(1 ai)loP g(ai1/bj)

第一章 绪论

信息论

通信技术 概率论 随机过程 数理统计

相结合逐步发展而形 成的一门新兴科学

奠基人:美国数学家香农(C.E.Shannon) 1948年“通信的数学理论”

本章内容:

信息的概念 数字通信系统模型 信息论与编码理论研究的主要内容及意义

1.1 信息的概念

信息是信息论中最基本、最重要的概念,既抽象又复杂

– 信息具有以下特征: (1)信息是可以识别的 (2)信息的载体是可以转换的 (3)信息是可以存贮的 (4)信息是可以传递的 (5)信息是可以加工的 (6)信息是可以共享的

1.2 信息论研究的对象,目的,内容

一、 研究对象 – 前面介绍的统一的通信系统模型。人们通过系统 中消息的传输和处理来研究信息传输和处理的共 同规律。

消息:用文字等能够被人们感觉器官所感知的形式, 把客观物质运动和主观思维活动的状态表达出来。 知识:一种具有普遍和概括性质的高层次的信息 , 以实践为基础,通过抽象思维,对客观事物规律性的 概括。 情报:是人们对于某个特定对象所见、所闻、所理解 而产生的知识 。

它们之间有着密切联系但不等同 ,信息的含义更深刻、广泛

– 它的主要目的是提高信息系统的可靠性、有效性、 保密性和认证性,以便达到系统最优化;

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

信息论研究的是关于这个通信系统的最根本、最本质的问题。例如: ①. 什么是信息?如何度量信息? ②. 怎样确定信源中含有多少信息量? ③. 对于一个信道,它传输信息量的最高极限(信道容量)是多少? ④. 为了能够无失真的传输信源信息,对信源编码时所需的最少的码

符号数是多少?(无失真信源编码即香农第一定理) ⑤. 在有噪信道中有没有可能以接近信道容量的信息传输率传输信息

第二章 信息的度量

2.1 自信息和互信息 2.2 平均自信息 2.3 平均互信息

关于信息的度量有几个重要的概念: (1)自信息:一个事件(消息)本身所包含的信息量,它是由事件的不确 定性决定的。比如抛掷一枚硬币的结果是正面这个消息所包含的信息量 (2)互信息:一个事件所给出关于另一个事件的信息量,比如今天下 雨所给出关于明天下雨的信息量。 (3)平均自信息(信息熵):事件集(用随机变量表示)所包含的平 均信息量,它表示信源的平均不确定性。比如抛掷一枚硬币的试验所包 含的信息量。 (4)平均互信息:一个事件集所给出关于另一个事件集的平均信息量 比如今天的天气所给出关于明天的天气的信息量。

我们把某个消息 x i 出现的不确定性的大小,定义为自信息,用这 个消息出现的概率的对数的负值来表示:I(xi)lopg (xi) 自信息同时表示这个消息所包含的信息量,也就是最大能够给予 收信者的信息量。如果消息能够正确传送,收信者就能够获得这 么大小的信息量。

信源所含有的信息量定义为信源发出的所有可能消息的平均不确定 性,香农把信源所含有的信息量称为信息熵。自信息的统计平均定 义为信源熵,即:

信息论是通信的数学基础,它是随着通信技术的发 展而形成和发展起来的一门新兴横断学科。信息论 创立标志是1948年Claude Shannon(香农)发表论文 “A Mathematical Theory of Communication”。在这 篇文章中香农创造性的采用概率论的方法来研究通 信中的问题,并且对信息给予了科学的定量描述, 第一次提出了信息熵的概念。

事件 x i 的概率为p( xi ) ,则它的自信息定义为:

I(xi)deflogp(xi)logp(1xi)

1.2 信息论研究对象、目的和内容

信息论研究对象 广义的通信系统,它把所有的信息流通系统都抽象成如下模型:

图1.1 通信源 顾名思义,信源是产生消息和消息序列的源。 (2). 编码器 编码就是把消息变成适合在信道传输的物理量——信号。

编码器可分为信源编码器和信道编码器。信源编码目的是提高通信系统有效性 和提高信息传输的可靠性。实际通信系统中,可靠性和有效性常常相互矛盾 。 (3). 信道 信道是指通信系统把载荷消息的信号从发送端送到接收端的媒介或通道, 是包括收发设备在内的物理设施。 (4). 译码器 译码就是把信道输出的已迭加了干扰的编码信号进行反变换,变成信宿 能够接受的消息。译码器也可分成信源译码器和信道译码器。 (5). 信宿 信宿是消息传送的对象,即接受消息的人或机器。

2.极限情况下当 p(xi ) =0时,I(xi) ;当 p(xi ) =1时,I ( xi ) =0。

3.另外,从直观概念上讲,由两个相对独立的不同的消息所提供的 信息量应等于它们分别提供的信息量之和。 可以证明,满足以上公理化条件的函数形式是对数形式。

定义2.1 随机事件的自信息量定义为该事件发生概率的对数的负值。

而错误概率几乎为零?(有噪信道编码即香农第二定理) ⑥. 如果对信源编码时允许一定量的失真,所需的最少的码符号数又

是多少?(限失真信源编码即香农第三定理)

目前,对信息论的研究内容一般有三种理解: (1)狭义信息论: 又称香农信息论。主要通过数学描述与定量分析,研究通信系统从信源到信宿 的全过程,包括信息的测度、信道容量以及信源和信道编码理论等问题,强调 通过编码和译码使收、发两端联合最优化,并且以定理的形式证明极限的存在 这部分内容是信息论的基础理论。 (2)一般信息论:也称工程信息论。 主要也是研究信息传输和处理问题,除香农信息论的内容外,还包括噪声理论 信号滤波和预测、统计检测和估计、调制理论、信息处理理论以及保密理论等 (3)广义信息论: 不仅包括上述两方面内容,而且包括所有与信息有关的自然和社会领域,如模 式识别、计算机翻译、心理学、遗传学、神经生理学、语言学、语义学甚至包 括社会学中有关信息的问题。

q

H(X) p(xi)lopg(xi) i1

这里的q表示信源消息的个数。信息熵表示信源的平均不确定性 的大小,同时表示信源输出的消息所含的平均信息量。因此,虽然 信源产生的消息可能会含有不同的信息量。

在收信端,信源的不确定性得到部分或全部消除,收信者就得 到信息。信息在数量上等于通信前后“不确定性”的消除量(减少量)

信息论基础

信息论基础教程

李亦农 李梅 编著 北京邮电大学出版社

目录

第一章 绪论 第二章 信息的度量 第三章 信源及信息熵 第四章 信道及信道容量 第五章 无失真信源编码 第六章 有噪信道编码 第七章 限失真信源编码

第一章 绪论

1.1 信息的概念 1.2 信息论研究对象、目的和内容

1.1 信息的概念

2.1 自信息和互信息

2.1.1 自信息

随机事件的自信息量 I (xi ) 是该事件发生概率 p(xi ) 的函数,并且应该满 足以下公理化条件:

1. I ( xi )是 p( xi )的严格递减函数。当 p(x1)p(x2) 时,I(x1)I(x2),概率 越小,事件发生的不确定性越大,事件发生后所包含的自信息量越大

1928年,哈特莱(Hartley)首先提出了用对数度量信

息的概念。一个消息所含有的信息量用它的可能值

香农

的个数的对数来表示。

(香农)信息: 信息是事物运动状态或存在方式的不确定性的描述。 可运用研究随机事件的数学工具——概率来测度不确定性大小。 在信息论中,我们把消息用随机事件表示,而发出这些消息的信 源则用随机变量来表示。