前馈神经网络

前馈神经网络在图像识别中的应用

前馈神经网络在图像识别中的应用前馈神经网络(Feedforward Neural Network)是一种常用的人工神经网络模型,它在图像识别领域中有着广泛的应用。

本文将探讨前馈神经网络在图像识别中的应用,并介绍其原理和优势。

首先,让我们了解一下前馈神经网络的基本原理。

前馈神经网络由多个神经元组成,每个神经元与下一层的神经元相连。

信息在网络中从输入层传递到输出层,每个神经元接收到上一层神经元传递过来的信息,并通过激活函数进行处理后传递给下一层神经元。

这种单向传递的特性使得前馈神经网络能够对输入数据进行非线性映射,从而实现复杂的图像识别任务。

前馈神经网络在图像识别中的应用非常广泛。

首先,它可以用于图像分类任务。

通过将图像输入到网络中,网络可以学习到不同类别的特征,并根据这些特征将图像分类到相应的类别中。

例如,在猫狗分类任务中,网络可以学习到猫和狗的特征,并根据这些特征将输入的图像分类为猫或狗。

其次,前馈神经网络还可以用于目标检测任务。

目标检测是指在图像中找到并标记出感兴趣的目标。

通过在网络中引入额外的输出层,可以实现对目标位置的定位和标记。

例如,在人脸检测任务中,网络可以学习到人脸的特征,并通过标记出人脸的位置来实现人脸检测。

此外,前馈神经网络还可以用于图像分割任务。

图像分割是指将图像中的像素分割成不同的区域,每个区域代表图像中的一个对象或物体。

通过在网络中引入更多的输出层,可以实现对每个像素的分类。

例如,在语义分割任务中,网络可以学习到不同类别的像素特征,并将每个像素分类到相应的类别中,从而实现对图像的分割。

前馈神经网络在图像识别中有着诸多优势。

首先,它能够处理大规模的图像数据。

由于前馈神经网络的结构简单且参数较少,它可以有效地处理大量的图像数据,从而提高图像识别的准确性和效率。

其次,前馈神经网络具有较好的泛化能力。

通过训练大量的图像数据,网络可以学习到不同类别的特征,并将这些特征应用于未见过的图像中。

前馈神经网络的基本结构与工作原理

前馈神经网络的基本结构与工作原理前馈神经网络是一种常用的人工神经网络模型,广泛应用于机器学习和模式识别等领域。

在本文中,我们将介绍前馈神经网络的基本结构和工作原理。

一、基本结构前馈神经网络由多个神经元按层次连接而成,分为输入层、隐藏层和输出层。

每个神经元都与下一层的神经元连接,前向传播信息,不同层之间没有反馈连接,因此称为“前馈”。

1. 输入层输入层是前馈神经网络的第一层,接收外部输入的数据。

每个输入神经元对应输入数据的一个特征。

输入层通常不进行计算,只将输入数据传递给下一层的神经元。

2. 隐藏层隐藏层是位于输入层和输出层之间的一层或多层神经元。

隐藏层对输入数据进行加权和偏移运算,并通过激活函数进行非线性变换。

隐藏层的神经元数量和层数可以根据问题的复杂性和数据的特征进行设置。

3. 输出层输出层是前馈神经网络的最后一层,输出网络对问题进行预测或分类。

输出层的神经元数量取决于问题的种类,例如二分类问题需要一个神经元,多分类问题需要多个神经元。

二、工作原理前馈神经网络的工作原理可以分为两个阶段:前向传播和反向传播。

1. 前向传播前馈神经网络通过前向传播将输入数据从输入层传递到输出层,实现对输入数据的处理和预测。

首先,输入层接收外部输入的数据,并将其传递给隐藏层。

隐藏层对输入数据进行加权和偏移运算,计算得到隐藏层的输出值,并通过激活函数进行非线性变换。

隐藏层的输出值被传递到下一层,依次经过每一层的计算,最后传递到输出层。

输出层接收隐藏层传递过来的数据,并进行加权和偏移运算,计算得到输出层的输出值。

输出层的输出值可以表示分类结果、预测值等问题的输出。

2. 反向传播前馈神经网络通过反向传播来更新神经网络的参数,以调整网络的权重和偏置,使网络的输出尽可能地接近真实值,从而提高预测的准确性。

反向传播的过程可以分为以下几个步骤:(1)计算输出误差:将网络的输出值与真实值进行比较,计算输出误差。

(2)传播误差:根据输出误差,沿着网络的反向传播路径,依次更新隐藏层和输入层的误差。

如何使用前馈神经网络进行时间序列预测(六)

前馈神经网络(Feedforward Neural Network,FNN)是一种常用的人工神经网络模型,它可以用来进行时间序列预测。

时间序列预测是指根据已知的一系列时间点上的数据,来预测未来某个时间点上的数值。

在金融领域、气象预测、销售预测等方面,时间序列预测都有着广泛的应用。

而前馈神经网络作为一种强大的模型,可以帮助我们更准确地进行时间序列预测。

一、前馈神经网络的基本结构前馈神经网络由输入层、隐藏层和输出层组成。

输入层接收外部数据输入,隐藏层进行信息处理,输出层输出最终的预测结果。

隐藏层可以有多层,每一层都可以包含多个神经元。

在前馈神经网络中,信息是单向传播的,即从输入层到输出层,没有反馈。

二、数据预处理在使用前馈神经网络进行时间序列预测之前,首先需要对数据进行预处理。

通常包括数据清洗、归一化处理等步骤。

数据清洗是指去除异常值或缺失值,以保证数据的完整性和准确性。

而归一化处理则是将数据缩放到一个较小的范围内,以便神经网络更好地学习和收敛。

三、选择合适的神经网络结构选择合适的神经网络结构是进行时间序列预测的关键。

通常可以根据实际问题的复杂程度来确定网络的层数和每一层神经元的个数。

过于简单的网络结构可能无法捕捉时间序列数据的复杂关系,而过于复杂的网络结构又容易造成过拟合。

因此,需要根据实际情况进行合理的选择。

四、选择合适的激活函数激活函数在神经网络中起着至关重要的作用,它决定了神经元的输出。

常用的激活函数包括Sigmoid函数、Tanh函数和ReLU函数等。

在选择激活函数时,需要考虑到函数的性质以及数据的特点,以确保神经网络能够更好地拟合时间序列数据。

五、训练神经网络在选择好神经网络结构和激活函数之后,就可以开始训练神经网络了。

通常采用梯度下降算法来更新神经网络的参数,以使网络的预测结果与实际值之间的误差最小化。

在训练过程中,需要根据损失函数的值来调整网络的参数,直到网络收敛。

六、验证和评估在训练好神经网络之后,需要对模型进行验证和评估。

bp网络原理

bp网络原理BP网络,即反向传播神经网络(Backpropagation Neural Network),是一种基于梯度下降算法的前馈神经网络。

它是一种常用的人工神经网络模型,被广泛应用于模式识别、预测和分类等任务中。

BP网络的基本原理是建立一个多层的神经网络结构,包括输入层、隐藏层和输出层。

每个神经元都与下一层的所有神经元连接,并通过权重连接进行信息传递。

输入信号从输入层经过权重连接传递到隐藏层,再经过隐藏层的激活函数作用后传递到输出层。

BP网络的训练过程主要分为前向传播和反向传播两个阶段。

在前向传播阶段,输入样本经过网络的各层神经元,得到输出结果。

每个神经元将输入信号与权重相乘并累加,然后经过激活函数进行非线性转换,得到该神经元的输出。

在反向传播阶段,通过计算输出层和期望输出之间的误差,按照梯度下降的方法不断调整每个神经元的权重,以最小化误差。

误差通过链式法则从输出层回传到隐藏层和输入层,根据权重的梯度进行更新。

反复迭代上述的前向传播和反向传播过程,直到网络的输出误差满足要求或训练次数达到指定值为止。

BP网络具有较好的非线性拟合能力和学习能力。

它的优点在于能够通过训练样本自动调整权重,从而对输入样本进行分类和预测。

然而,BP网络也存在一些问题,如容易陷入局部最小值、训练速度慢等。

为了克服BP网络的局限性,研究者们提出了一些改进方法,如改进的激活函数、正则化技术、自适应学习率等。

这些方法在提高网络性能和加速训练过程方面起到了积极的作用。

总结起来,BP网络是一种基于梯度下降算法的前馈神经网络,通过前向传播和反向传播的方式不断调整神经元的权重,以实现输入样本的分类和预测。

虽然存在一些问题,但通过改进方法可以提高其性能和训练速度。

3前馈神经网络

1 yj 1

w1 j x1 w2 j x 2 j 0 w1 j x1 w2 j x 2 j 0

则方程 w1 j x1 w2 j x2 j 0 成为二维输入样本空间上的一条分界线。

*

*

x1

*

w1 j x1 w2 j x2 j 0

节点j的输出为:

1 yj 1

w1 j x1 w2 j x 2 w3 j x3 j 0 w1 j x1 w2 j x 2 w3 j x3 j 0

方程 w1 j x1 w2 j x2 w3 j x3 j 0 确定的平面成为三维输入样本空间的 一个分界面。把输入样本*和△正确分两类(对应yj=1和-1)

X3=[-1 -1 1 0.5]T d3=1. 设初始权向量 W(0)=[0.5 1 -1 0]T η=0.1 注意:输入向量中第一个分量x0恒等于-1,权向量中第一个分量为阈值,试训 练该感知器网络. 解:第一步,输入X1 WT(0)X1= [0.5 1 -1 0][-1 1 -2 0]T=2.5 Y1(0)=sgn(2.5)=1 W(1)=W(0)+ η[d1-y1]X1= [0.5 1 -1 0]T +0.1(-1-1) [-1 1 -2 0]T

0.5x1+0.5x2-0.75=0 x 1 将输出为1的样本点作*、

输出为0的样本点作△表示。 按真值表作图,得: (0,1) △ (1,1) *

(0

该分类线不唯一,取决于具体的权值训练 逻辑”或”功能: X1 0 真值表: 0 1 1 x2 0 1 0 1 y 0 1 1 1 4个样本,两种输出 1

3.1.4感知器的学习算法

感知器采用感知器学习规则进行训练,用t表示学习步的序号,权值看作t的函

神经网络的学习名词解释

神经网络的学习名词解释神经网络是一种模拟人脑神经系统功能的计算模型,通过大量的节点(或称为神经元)之间的连接,实现信息的传递和处理。

随着机器学习和人工智能的发展,神经网络逐渐成为重要的工具,被广泛应用于图像识别、自然语言处理等领域。

本文将介绍神经网络中常见的学习名词,并对其进行解释。

1. 感知器(Perceptron):感知器是神经网络中最基本的模型,模拟了人脑中的神经元。

它接收多个输入,并通过一个激活函数产生输出。

感知器的学习过程是通过调整连接权重来使感知器输出逼近期望输出。

2. 前馈神经网络(Feedforward Neural Network):前馈神经网络是一种直接将数据从输入层传输到输出层的网络结构。

每个神经元只与下一层的神经元连接,信息只能向前传递,不能产生回路。

前馈神经网络的训练过程主要通过反向传播算法来调整网络的权重,以达到期望的输出。

3. 反向传播算法(Backpropagation):反向传播算法是神经网络中最常用的训练算法。

它通过计算权重的梯度,不断调整网络的连接权重,使网络的输出逼近期望的输出。

反向传播算法主要分为前向传播和误差反向传播两个过程,前向传播计算各层的输出,而误差反向传播则从输出层开始,逐层计算误差并反向传播到输入层。

4. 激活函数(Activation Function):激活函数决定了神经元输出的形式,常见的激活函数有Sigmoid、ReLU、Tanh 等。

激活函数引入非线性因素,使神经网络具有非线性表示能力。

它们的选择在神经网络的性能和收敛速度中起着重要的作用。

5. 损失函数(Loss Function):损失函数是用来衡量网络输出与期望输出之间的差异。

在训练过程中,通过最小化损失函数来调整网络的参数,以达到更准确的预测结果。

常见的损失函数有均方误差(MSE)、交叉熵等。

6. 优化算法(Optimization Algorithm):优化算法用来求解损失函数最小化的问题。

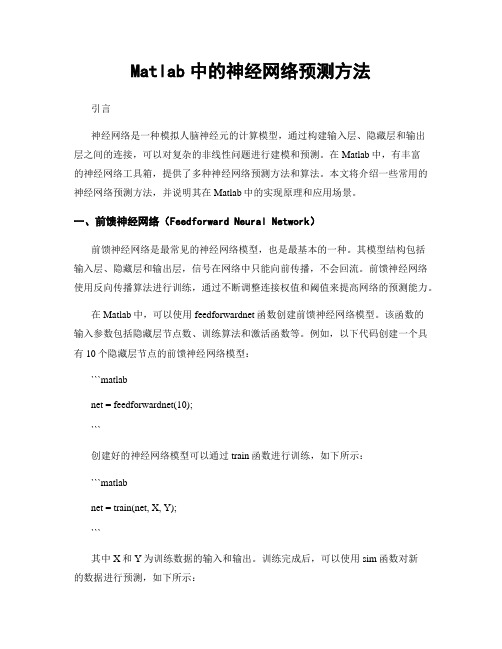

Matlab中的神经网络预测方法

Matlab中的神经网络预测方法引言神经网络是一种模拟人脑神经元的计算模型,通过构建输入层、隐藏层和输出层之间的连接,可以对复杂的非线性问题进行建模和预测。

在Matlab中,有丰富的神经网络工具箱,提供了多种神经网络预测方法和算法。

本文将介绍一些常用的神经网络预测方法,并说明其在Matlab中的实现原理和应用场景。

一、前馈神经网络(Feedforward Neural Network)前馈神经网络是最常见的神经网络模型,也是最基本的一种。

其模型结构包括输入层、隐藏层和输出层,信号在网络中只能向前传播,不会回流。

前馈神经网络使用反向传播算法进行训练,通过不断调整连接权值和阈值来提高网络的预测能力。

在Matlab中,可以使用feedforwardnet函数创建前馈神经网络模型。

该函数的输入参数包括隐藏层节点数、训练算法和激活函数等。

例如,以下代码创建一个具有10个隐藏层节点的前馈神经网络模型:```matlabnet = feedforwardnet(10);```创建好的神经网络模型可以通过train函数进行训练,如下所示:```matlabnet = train(net, X, Y);```其中X和Y为训练数据的输入和输出。

训练完成后,可以使用sim函数对新的数据进行预测,如下所示:```matlabY_pred = sim(net, X_pred);```Y_pred为预测结果,X_pred为待预测的输入数据。

二、递归神经网络(Recurrent Neural Network)递归神经网络是另一种常见的神经网络模型,不同于前馈神经网络,递归神经网络允许信号在网络中进行循环传播,使得模型可以处理序列数据和时间序列数据。

递归神经网络拥有记忆功能,可以通过上一时刻的输出来影响当前时刻的输出。

在Matlab中,可以使用narnet函数创建递归神经网络模型。

该函数的输入参数包括隐藏层节点数、训练算法和激活函数等。

五大神经网络模型解析

五大神经网络模型解析近年来,人工智能的快速发展使得深度学习成为了热门话题。

而深度学习的核心就在于神经网络,它是一种能够模拟人脑神经系统的计算模型。

今天,我们就来一起解析五大神经网络模型。

1.前馈神经网络(Feedforward Neural Network)前馈神经网络是最基本的神经网络模型之一。

在前馈神经网络中,信息是单向传输的,即神经元的输出只会被后续神经元接收,不会造成回流。

前馈神经网络能够拟合线性和非线性函数,因此在分类、预测等问题的解决中被广泛应用。

前馈神经网络的一大优势在于简单易用,但同时也存在一些缺点。

例如,神经网络的训练难度大、泛化能力差等问题,需要不断探索解决之道。

2.循环神经网络(Recurrent Neural Network)与前馈神经网络不同,循环神经网络的信息是可以进行回流的。

这意味着神经元的输出不仅会传向后续神经元,还会传回到之前的神经元中。

循环神经网络在时间序列数据的处理中更为常见,如自然语言处理、语音识别等。

循环神经网络的优点在于增强了神经网络处理序列数据的能力,但是它也存在着梯度消失、梯度爆炸等问题。

为了解决这些问题,一些变种的循环神经网络模型应运而生,如长短期记忆网络(LSTM)、门控循环单元(GRU)等。

3.卷积神经网络(Convolutional Neural Network)卷积神经网络是一种类似于图像处理中的卷积操作的神经网络模型。

卷积神经网络通过卷积神经层和池化层的堆叠来对输入数据进行分层提取特征,从而进一步提高分类性能。

卷积神经网络在图像、视频、语音等领域的应用非常广泛。

卷积神经网络的优点在于对于图像等数据具有先天的特征提取能力,可以自动识别边缘、角点等特征。

但是,卷积神经网络也存在着过拟合、泛化能力欠佳等问题。

4.生成对抗网络(Generative Adversarial Network)生成对抗网络可以说是最近几年最热门的神经网络模型之一。

它基于博弈论中的对抗训练模型,由两个神经网络构成:生成器和判别器。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

前饋式類神經網路1前言前饋式類神經網路是第一個也是最簡單的類神經網路,它是由多層的神經元所組成,其訊息傳遞的方式是從輸入層經由隱藏層往輸出層的方向傳送,每一層神經元只會接受上層神經元所傳送過來的輸出值,不同於循環式網路(Recurrent network)。

2神經元類神經網路最基本單位的是神經元(如圖1),神經元主要負責對資料的處理行為。

在類神經網路中的某個神經元,可能接收一個到數個不等的輸入變數,變數的多寡取決於傳送到該神經元的輸入值個數。

神經元接收輸入變數(I)後,視輸入變數的重要性,給予一個改變比重的參數,這些參數稱為配重值(Weight, ω),神經元會將所有輸入變數經由配重值的加權後累加,然後再與神經元中的偏移量(Bias, B)相加,會產生一個淨值(n),這個淨值將經由轉換函數的轉換,轉換出來的數值當成該神經元的輸出值。

神經元的輸出值可以傳送到一個以上的神經元當作該神經元的輸入變數,或是當成網路的輸出值,一切依網路結構的情況而定。

雖然,每個神經元可以同時接收一至多個不等的輸入變數,卻只有一個輸出值。

神經元的計算公式如式(1)、(2)所示,∑=+⋅=RjjjB In1ω(1))(nfY=(2)式中R為神經元輸入變數的個數,I1,I2,⋯,I R為神經元的輸入變數,ω1,ω2,⋯,ωR為神經元各個輸入變數的配重值,B為該神經元的偏移量,)(∙f為神經元的轉換函數。

1Y輸入值單位神經元Y=f(Wp+b)圖.1神經元神經元的轉換函數可能是線性函數或是非線性函數,依問題的需求不同所選擇的轉換函數也會不同,選擇一個適合特定問題的轉換函數,對描述輸入變數與輸出值之關係,是非常重要的。

可是,轉換函數的種類有很多,要選擇一個最適合特定問題的轉換函數,需要藉由不斷的嘗試才能獲得。

以下列出本研究所使用的十種轉換函數:1. 硬限制函數(Hard Limit transfer function)⎩⎨⎧≥<=1)(nifnifnf2. 對稱硬限制函數(Symmetrical Hard Limit transfer function)⎩⎨⎧≥<-=11)(nifnifnf3. 飽和線性函數(Saturating Linear transfer function)⎪⎩⎪⎨⎧>≤≤<=111)(nifnifnnifnf4. 對稱飽和線性函數(Symmetrical Saturating Linear transfer function)⎪⎩⎪⎨⎧>≤≤--<-=111111)(nifnifnnifnf5. 正線性函數(Positive Linear transfer function)⎩⎨⎧≥<=)(nifnnifnf6. 線性函數(Linear transfer function)nnf=)(7. S形函數(Sigmoid transfer function)ne nf -+=11)( 8. 雙曲正切函數(Hyperbolic Tangent transfer function)nn nn e e e e n f --+-=)(9. 三角基函數(Triangular basis transfer function)⎪⎪⎪⎩⎪⎪⎪⎨⎧>≤<-=<≤-+-<=101010101110)(n if n if n n if n if n n if n f 10. 高斯函數(Gaussian transfer function)22)(n e n f -=3 網路組織架構前饋式類神經網路結構如圖12所示,數個接收相同輸入變數的神經元並聯組成網路的基礎結構 − 層,再由數個層串聯組成一個前饋式類神經網路。

同一層的神經元接收前一層所有神經元的輸出,並將輸出送至下一層做為下一層每個神經元的輸入變數。

依各層的特質又可以區分為輸入層、輸出層和隱藏層三種。

1. 輸入層:輸入層每個神經元只接受一個輸入變數作為其輸入值,並將輸出送至下一層的每個神經元,所以輸入層神經元的個數等於輸入變數的個數。

輸入層有兩種類型,第一種輸入層中的神經元具有配重值與偏移量,且具有轉換函數;第二種輸入層中的神經元只有接收輸入變數的功能,輸出值便是輸入變數,不具有運算的功能,本研究採用第二種類型的輸入層。

一般若採用第二種類型的輸入層,不將此層當成一層。

2. 輸出層:輸出層每個神經元的輸出值便是網路的輸出值,所以輸出層神經元的個數等於網路的輸出值個數。

3. 隱藏層:介於輸入層與輸出層之間的層便是隱藏層,隱藏層的層數可以是零,也可以很多層,不過最常見的為一層,隱藏層神經元的個數也沒有一定,使用者視資料的複雜度調整隱藏層的層數與該隱藏層神經元的個數。

輸入層 隱藏層1 隱藏層k 輸出層圖12 前饋式類神經網路結構前饋式類神經網路是類神經網路最常見到的網路結構(如圖12),這種網路結構神經元間的資料傳遞方向與整個網路資料傳遞的方向相同,每一層的神經元只會接受前一層所有的神經元傳送過來的輸入變數,並經過處理後得到一個新輸出值,也就是說,第一層隱藏層只會接收來自輸入層的輸入變數,而第二層隱藏層只會接收來自第一層隱藏層的輸入變數,依此類推。

使用前饋式類神經網路,一定會有輸入層與輸出層。

一個非常簡單的問題可以沒有隱藏層,但是,類神經網路要具備處理複雜數據的能力,必須藉助隱藏層的使用,甚至於使用多層隱藏層。

通常不同層有不同的神經元個數和轉換函數。

同一層各神經元的轉換函數通常是相同的,也就是說,同一層的神經元有相同的輸入變數與轉換函數,但因為每個神經元內有不同的配重值和偏移量,導致同一層的神經元雖然接收相同的輸入變數,但輸出值卻大不相同。

也有可能同一層各神經元有不同的轉換函數,但本研究所開發的程式只提供同一層各個神經元使用相同的轉換函數之功能。

4 資料處理類神經網路可能具有很多層的網路結構,每一層中又有數個神經元,每一個神經元又有數個網路參數值與輸入變數與輸出值,所以必須對每個參數值、輸入變數與輸出值做一個區別,使每個符號更容易被辨別其所代表的意義。

在此用上標來表示其所在的層數,用下標來表示其所在的神經元,輸入變數m j I 代表第m層的神經元接收來自第m-1層第j 個神經元所傳送過來的輸入變數,1-m j O 代表第m-1層第j 個神經元之輸出值,也就是說1-=m j m j O I 。

m j I 所相對應的配重值為m j i ,ω,其代表意義為第m 層第i 個神經元接收上一層第j 個神經元的輸出值,該神經元的偏移量為m i B 。

舉一個例子(如圖3)來介紹前饋式類神經網路的輸出值與輸入變數之間的關係式,來說明整個類神經網路的計算過程。

從圖中的輸入層與輸出層神經元個數可知,此網路結構會從外界接收一個輸入變數,經過類神經網路的處理後,而得到一個輸出值,而其輸出值與輸入變數間的關係可表示成式(3)的通式。

)(X f Y overall =(3)Y輸入層隱藏層輸出層圖13 一層隱藏層的前饋式網路首先,本研究認為輸入層中的神經元只有接收輸入變數的功能,而其輸出值就是輸入變數,不具有運算的功能,所以輸入層的輸出值為X 。

將輸出值X 傳送到隱藏層各神經元內,當作隱藏層神經元的輸入變數,接著,經由隱藏層神經元的處理後,隱藏層各神經元的輸出值分別為)(1111,11B X f +⋅ω、)(1211,21B X f +⋅ω與)(1311,31B X f +⋅ω,其中)(1∙f 代表隱藏層的轉換函數。

再將隱藏層各神經元的輸出值傳送到輸出層,當成輸出層神經元的輸入變數,在經由輸出層神經元的處理後,便可得到一個網路輸出值,其值為])()()([211311,3123,11211,2122,11111,1121,12B B X f B X f B X f f Y ++⋅⋅++⋅⋅++⋅⋅=ωωωωωω(4)在式(2-4)中,[]∙2f 代表輸出層神經元的轉換函數。

上述的運算過程中,假如網路輸出值與目標值的誤差過大,可依據學習法則來調整各配重值與偏移量,使得網路輸出值與目標值的誤差可以達到要求。

f (n )-1.0-0.50.00.51.0-0.20.00.20.40.60.81.01.2n 圖2.2 硬限制函數f (n )-1.0-0.50.00.51.0-1.2-0.8-0.40.00.40.81.2n 圖2.3 對稱硬限制函數f (n )-0.20.00.20.40.60.81.01.2-0.20.00.20.40.60.81.01.2N圖2.4 飽和線性函數f (n )-1.2-0.60.00.61.2-1.2-0.8-0.40.00.40.81.2n圖2.5 對稱飽和線性函數f (n )-0.40.00.40.81.2-0.20.00.20.40.60.81.01.2n 圖2.6 正線性函數f (n )-1.0-0.50.00.51.0-1.0-0.50.00.51.0n 圖2.7 線性函數f (n )-6.0-3.00.03.06.0-0.20.00.20.40.60.81.01.2n 圖2.8 S 形函數f (n )-4.0-2.00.02.04.0-1.2-0.8-0.40.00.40.81.2n圖2.9 雙曲正切函數f (n )-1.6-0.80.00.81.6-0.20.00.20.40.60.81.01.2n圖2.10 三角基函數f (n )-4.0-2.00.02.04.0-0.20.00.20.40.60.81.01.2n 圖2.11 高斯函數。