最优化理论与算法(第三章)

最优化理论与算法完整版课件 PPT

Bazaraa, J. J. Jarvis, John Wiley & Sons, Inc.,

1977.

组合最优化算法和复杂性

Combinatorial

Optimization 蔡茂诚、刘振宏

Algorithms and Complexity

清华大学出版社,1988 I运nc筹.,学19基82础/1手99册8

最优化首先是一种理念, 运筹学的“三个代表”

其次才是一种方法.

• 模型

• 理论

2021/4/9

• 算法

5

绪论---运筹学(Operations Research -

运筹学O方R)法

最优化/数学规划方法

连续优化:线性规划、 非线性规划、非光滑优 化、全局优化、变分法、 二次规划、分式规划等

离散优化:组合优化、 网络优化、整数规划等

2021/4/9

11

1. 食谱问题

我每天要求一定量的两种维生素,Vc和Vb。 假设这些维生素可以分别从牛奶和鸡蛋中得到。

维生素

Vc(mg) Vb(mg) 单价(US$)

奶中含量

2 3 3

蛋中含量

4 2 2.5

每日需求 40 50

需要确定每天喝奶和吃蛋的量, 目标以便以最低可能的花费购买这些食物, 而满足最低限度的维生素需求量。

最优化理论与算法

2021/4/9

1

提纲

使用教材:

最优化理论与算法 陈宝林

参考书 :

数学规划 黄红选, 韩继业 清华大学出版社

1. 线性规划 对偶定理

2. 非线性规划 K-K-T 定理

3. 组合最优化 算法设计技巧

2021/4/9

2

其他参考书目

最优化理论-教学大纲

《最优化理论》教学大纲课程编号:112302A课程类型:专业选修课总学时:32 讲课学时:26 实验学时:6学分:2适用对象:金融工程专业先修课程:数学分析、线性代数、经济学、金融学一、教学目标最优化问题即在有限种或无限种可行方案(决策)中选择最优的方案(决策),与之相对应的最优化理论是数学领域的一个重要分支,也是金融工程专业学生需要掌握的必备工具之一。

现代金融学研究的技术化程度日益增加,金融工程的许多问题都与最优化理论与方法密切相关,例如:投资组合选择与资产配置、期权的定价与对冲、金融风险的度量与管理、资产和负债的现金流管理等等。

本课程拟对最优化的基础理论和求解方法进行一个比较全面和系统的介绍,其中涉及到的方法包括:线性规划、非线性规划、二次规划、锥优化、整数规划、动态规划、随机规划等等。

通过本课程的学习,实现以下几个教学目标:目标1:帮助学生了解各类最优化模型的数学理论与求解方法;目标2:使学生理解如何应用这些优化模型分析经济学和金融学相关问题。

二、教学内容及其与毕业要求的对应关系本课程主要介绍几种主要的最优化模型的理论与方法,根据最优化模型的类别进行划分,分为无约束最优化和有约束最优化两大类别。

其中,无约束最优化问题的子类别较少、难度相对较低,主要从理论方法和数值方法两方面进行讲解;有约束最优化重点讲解线性规划的单纯形法和非线性规划的库恩塔克条件,在时间允许的情况适当介绍其他类别的高级规划课题。

基本教学内容的框架图如下:本课以课堂讲授为主,间之以案例教学、随堂练习和课后作业,针对适当的问题讲解其计算机程序实现,使学生既能掌握理论,也能动手操作,切实做到理论与实践相结合。

该课程旨在进一步完善金融工程专业学生的数理知识,一方面有利于强化与完善了金融专业学生的数理知识体系,同时结合经济学和金融学实际问题进行讲解学习,锻炼了学生们思考学习的能力,更训练了学生应用数理思维分析经济金融问题的能力,与金融工程专业学生的毕业要求相呼应。

最优化理论与算法(第三章)

第三章 牛顿法§3.1 最速下降法一、最速下降法在极小化算法中,若每次都以迭代点处的负梯度方向为搜索方向,产生的算法称为最速下降法,它是无约束最优化算法中最简单、最基本的算法。

算法描述:1) 给出初始点0n x R ∈,允许误差0ε>,0k =; 2) 计算k k d g =-,若k g ε≤,Stop 令 *k x x ≈; 3) 由一维搜索确定步长因子k α,使得()min ()k k k k k f x d f x d ααα≥+=+4) 令1k k k k x x d α+=+,1k k =+,go to 2).二、最速下降算法的收敛性定理3.1 设1f C ∈,则最速下降算法产生的点列{}k x 的每个聚点均为驻点。

证明:设x 是{}k x 的一个聚点,则存在子序列{}1k K x ,使得1lim k k K x x ∈=令()k k d f x =-∇,由1f C ∈,知{}1()k K f x ∇是收敛序列,故{}1k K d 有界,且1lim ()k k K d f x ∈=-∇由定理2.6有2()(())()0Tf x f x f x ∇-∇=-∇=故有 ()0f x ∇=。

定理 3.2 设()f x 二次连续可微,且2()f x M ∇≤,则对任何给定的初始点0n x R ∈,最速下降算法或有限终止,或lim ()k k f x →∞=-∞,或lim ()0k k f x →∞∇=。

证明:不妨设k ∀,()0k f x ∇≠。

由定理2.5有211()()()2k k k f x f x f x M+-≥∇ 于是 []120101()()()()()2kk k i i i i i f x f x f x f x f x M -+==-=-≥∇∑∑令k →∞,由{()}k f x 为单调下降序列,则要么lim ()k k f x →∞=-∞,要么 lim ()0k k f x →∞∇=。

数值最优化算法与理论理论-第三章算法

1、最速下降法function f=fun_obj(x)f=100*(x(2)-x(1)^2)^2+(1-x(1))^2;function g=fun_grad(x)g=[2*x(1)-400*x(1)*(-x(1)^2+x(2))-2,-200*x(1)^2+200*x(2)];% 用armijo搜索确定步长,其中xk是当前迭代点,rho,sigma为armijo参数,gk为当前下降方向function mk=armijo(xk,rho,sigma,gk )%assert(rho>0&&rho<1); % 限制Armijo参数rho在(0,1)之间%assert(sigma>0&&sigma<0.5); % 限制Armijo参数sigma在(0,0.5)之间mk=0;max_mk=100; % 最大迭代次数while mk<=max_mkx=xk+rho^mk*gk; % 求解x(k+1)iffeval('fun_obj',x)<=feval('fun_obj',xk)-sigma*rho^mk*(fun_grad(xk))*g k' %终止条件break;endmk=mk+1; % 更新迭代endfunction [xk,fk,k]=steepestmain(x0)max_iter=5000; % max number of iterationsEPS=1e-6; % threshold of gradient normrho=0.8;sigma=0.59; % Armijo parametersk=0;xk=x0; % initializationwhile k<max_iterdk=fun_grad(xk);d=-dk; % search directionif norm(dk)<EPS %precisionbreak;endmk=armijo(xk,rho,sigma,d); %armijo line searchxk=xk+rho^mk*d; %updatefk=fun_obj(xk);k=k+1;endx0=[-1,2];[xk,fk,k]=steepestmain(x0);2、Newton法function f=fun_obj(x)f=100*(x(2)-x(1)^2)^2+(1-x(1))^2;function g=fun_grad(x)g=[2*x(1)-400*x(1)*(-x(1)^2+x(2))-2,-200*x(1)^2+200*x(2)];function He=Hess(x)He=[1200*x(1)^2-400*x(2)+2,-400*x(1);-400*x(1),200];% 用armijo搜索确定步长,其中xk是当前迭代点,rho,sigma为armijo参数,gk为当前下降方向function mk=armijo(xk,rho,sigma,gk )%assert(rho>0&&rho<1); % 限制Armijo参数rho在(0,1)之间%assert(sigma>0&&sigma<0.5); % 限制Armijo参数sigma在(0,0.5)之间mk=0;max_mk=100; % 最大迭代次数while mk<=max_mkx=xk+rho^mk*gk; % 求解x(k+1)iffeval('fun_obj',x)<=feval('fun_obj',xk)-sigma*rho^mk*(fun_grad(xk))*g k' %终止条件break;endmk=mk+1; % 更新迭代endfunction [xk,fk,k]=Newtonmain(x0)max_iter=5000; % 最大迭代次数EPS=1e-6; % 精度rho=1;sigma=1e-4; % Armijo 参数k=0;xk=x0; % 初值while k<max_iter % 迭代次数超过最大迭代次数时跳出循环k=k+1;dk=fun_grad(xk); % x(k)处的梯度H=Hess(xk); % x(k)处的Hessian矩阵d=-H\dk'; % x(k)处的搜索方向if norm(dk)<EPS % 终止条件break;endmk=armijo(xk,rho,sigma,d'); % 利用armijo搜索确定步长xk=xk+rho^mk*d'; % 计算x(k+1)的值fk=fun_obj(xk); % 计算x(k+1)处函数的值endx0=[1.2,1.2];[xk,fk,k]=Newtonmain(x0);3、Newton-最速下降法function f=fun_obj(x)f=100*(x(2)-x(1)^2)^2+(1-x(1))^2;function g=fun_grad(x)g=[2*x(1)-400*x(1)*(-x(1)^2+x(2))-2,-200*x(1)^2+200*x(2)];function He=Hess(x)He=[1200*x(1)^2-400*x(2)+2,-400*x(1);-400*x(1),200];% 用armijo搜索确定步长,其中xk是当前迭代点,rho,sigma为armijo参数,gk为当前下降方向function mk=armijo(xk,rho,sigma,gk )%assert(rho>0&&rho<1); % 限制Armijo参数rho在(0,1)之间%assert(sigma>0&&sigma<0.5); % 限制Armijo参数sigma在(0,0.5)之间mk=0;max_mk=100; % 最大迭代次数while mk<=max_mkx=xk+rho^mk*gk; % 求解x(k+1)iffeval('fun_obj',x)<=feval('fun_obj',xk)-sigma*rho^mk*(fun_grad(xk))*g k' %终止条件break;endmk=mk+1; % 更新迭代endfunction [xk,fk,k]=newton_steepest(x0)max_iter=5000; % 最大迭代次数EPS=1e-6; % 精度rho=1;sigma=1e-4; % Armijo 参数 rho=0.8;sigma=0.59;k=0;xk=x0; % 初值while(k<max_iter)k=k+1;dk=fun_grad(xk); % x(k)处的梯度,注意dk为行向量G=Hess(xk); % x(k)处的Hessian矩阵d=-G\dk'; % x(k)处的搜索方向,注意此时d为列向量if norm(dk)<EPS % x(k)处的搜索方向break;end%% 判断d是否为下降方向if d'*dk'<0 % 若d'*dk<0,则d为下降方向d=d;else% 若d'*dk>=0,则d不为下降方向,令下降方向为负梯度方向 d=-dk';endmk=armijo(xk,rho,sigma,d'); % 利用armijo搜索确定步长 xk=xk+rho^mk*d'; % 计算x(k+1)的值fk=fun_obj(xk); % 计算x(k+1)处函数的值endx0=rand(1,2000);[xk,fk,k]=newton_steepest(x0);。

最优化理论与算法完整版课件陈宝林

TP SHUAI

1

提纲

使用教材:

最优化理论与算法 陈宝林

参考书 :

数学规划 黄红选, 韩继业 清华大学出版社

1. 线性规划 对偶定理

2. 非线性规划 K-K-T 定理

3. 组合最优化 算法设计技巧

TP SHUAI

2

其他参考书目

Nonlinear Programming - Theory and Algorithms

j1

m

s.t xij bj

i1

xij 0

i 1, 2, , m

j 1, 2, n i 1, 2, , m j 1, 2, n

TP SHUAI

15

3 税下投资问题

• 以价格qi 购买了si份股票i,i=1,2,…,n

• 股票i的现价是pi

• 你预期一年后股票的价格为ri • 在出售股票时需要支付的税金=资本收益×30% • 扣除税金后,你的现金仍然比购买股票前增多 • 支付1%的交易费用 • 例如:将原先以每股30元的价格买入1000股股票,以

最优化首先是一种理念, 运筹学的“三个代表”

其次才是一种方法.

• 模型

• 理论

• 算法 TP SHUAI

5

绪论---运筹学(Operations Research - OR)

运筹学方法

最优化/数学规划方法

连续优化:线性规划、 非线性规划、非光滑优 化、全局优化、变分法、 二次规划、分式规划等

离散优化:组合优化、 网络优化、整数规划等

TP SHUAI

23

6.结构设计问题

p1

p2

h

2p

2L

B

d

受力分析图

非线性规划理论和算法

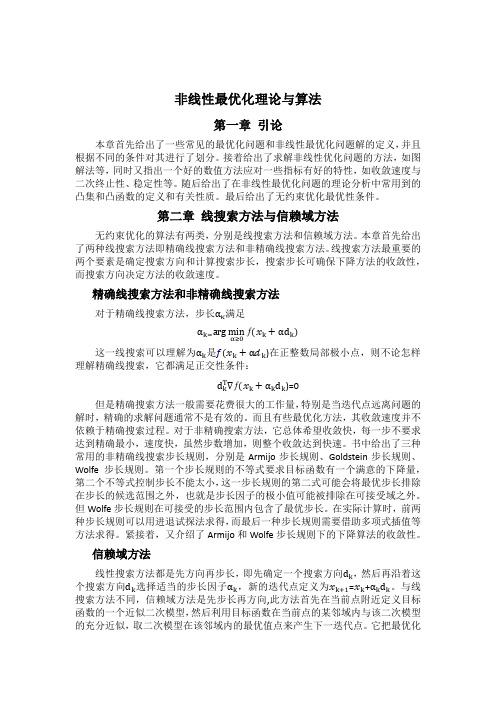

非线性最优化理论与算法第一章引论本章首先给出了一些常见的最优化问题和非线性最优化问题解的定义,并且根据不同的条件对其进行了划分。

接着给出了求解非线性优化问题的方法,如图解法等,同时又指出一个好的数值方法应对一些指标有好的特性,如收敛速度与二次终止性、稳定性等。

随后给出了在非线性最优化问题的理论分析中常用到的凸集和凸函数的定义和有关性质。

最后给出了无约束优化最优性条件。

第二章线搜索方法与信赖域方法无约束优化的算法有两类,分别是线搜索方法和信赖域方法。

本章首先给出了两种线搜索方法即精确线搜索方法和非精确线搜索方法。

线搜索方法最重要的两个要素是确定搜索方向和计算搜索步长,搜索步长可确保下降方法的收敛性,而搜索方向决定方法的收敛速度。

精确线搜索方法和非精确线搜索方法对于精确线搜索方法,步长ακ满足αk=arg minƒx k+αd kα≥0这一线搜索可以理解为αk是f(x k+αd k)在正整数局部极小点,则不论怎样理解精确线搜索,它都满足正交性条件:d k T∇ƒ(x k+αk d k)=0但是精确搜索方法一般需要花费很大的工作量,特别是当迭代点远离问题的解时,精确的求解问题通常不是有效的。

而且有些最优化方法,其收敛速度并不依赖于精确搜索过程。

对于非精确搜索方法,它总体希望收敛快,每一步不要求达到精确最小,速度快,虽然步数增加,则整个收敛达到快速。

书中给出了三种常用的非精确线搜索步长规则,分别是Armijo步长规则、Goldstein步长规则、Wolfe步长规则。

第一个步长规则的不等式要求目标函数有一个满意的下降量,第二个不等式控制步长不能太小,这一步长规则的第二式可能会将最优步长排除在步长的候选范围之外,也就是步长因子的极小值可能被排除在可接受域之外。

但Wolfe步长规则在可接受的步长范围内包含了最优步长。

在实际计算时,前两种步长规则可以用进退试探法求得,而最后一种步长规则需要借助多项式插值等方法求得。

最优化设计 课后习题答案

最优化方法-习题解答张彦斌计算机学院2014年10月20日Contents1第一章最优化理论基础-P13习题1(1)、2(3)(4)、3、412第二章线搜索算法-P27习题2、4、643第三章最速下降法和牛顿法P41习题1,2,374第四章共轭梯度法P51习题1,3,6(1)105第五章拟牛顿法P73-2126第六章信赖域方法P86-8147第七章非线性最小二乘问题P98-1,2,6188第八章最优性条件P112-1,2,5,6239第九章罚函数法P132,1-(1)、2-(1)、3-(3),62610第十一章二次规划习题11P178-1(1),5291第一章最优化理论基础-P13习题1(1)、2(3)(4)、3、4 1.验证下列各集合是凸集:(1)S={(x1,x2)|2x1+x2≥1,x1−2x2≥1};需要验证:根据凸集的定义,对任意的x(x1,x2),y(y1,y2)∈S及任意的实数λ∈[0,1],都有λx+(1−λ)y∈S.即,(λx1+(1−λ)y1,λx2+(1−λ)y2)∈S证:由x(x1,x2),y(y1,y2)∈S得到,{2x1+x2≥1,x1−2x2≥12y1+y2≥1,y1−2y2≥1(1)1把(1)中的两个式子对应的左右两部分分别乘以λ和1−λ,然后再相加,即得λ(2x1+x2)+(1−λ)(2y1+y2)≥1,λ(x1−2x2)+(1−λ)(y1−2y2)≥1(2)合并同类项,2(λx1+(1−λ)y1)+(λx2+(1−λ)y2)≥1,(λx1+(1−λ)y1)−2(λx2+(1−λ)y2)≥1(3)证毕.2.判断下列函数为凸(凹)函数或严格凸(凹)函数:(3)f(x)=x21−2x1x2+x22+2x1+3x2首先二阶导数连续可微,根据定理1.5,f在凸集上是(I)凸函数的充分必要条件是∇2f(x)对一切x为半正定;(II)严格凸函数的充分条件是∇2f(x)对一切x为正定。

最优化理论与算法

最优化理论与算法(数学专业研究生)第一章 引论§ 引言一、历史与现状最优化理论最早可追溯到古老的极值问题,但成为一门独立的学科则是在20世纪四十年代末至五十年代初。

其奠基性工作包括Fritz John 最优性条件(1948),Kuhn-Tucker 最优性条件(1951),和Karush 最优性条件(1939)。

近几十年来最优化理论与算法发展十分迅速,应用也越来越广泛。

现在已形成一个相当庞大的研究领域。

关于最优化理论与方法,狭义的主要指非线性规划的相关内容,而广义的则涵盖:线性规划、非线性规划、动态规划、整数规划、几何规划、多目标规划、随机规划甚至还包括变分、最优控制等动态优化内容。

本课程所涉及的内容属于前者。

二、最优化问题的一般形式 1、无约束最优化问题min ()nx Rf x ∈ () 2、约束最优化问题min ()()0, ..()0, i i f x c x i E s t c x i I=∈⎧⎨≥∈⎩ ()这里E 和I 均为指标集。

§数学基础一、 范数 1. 向量范数max i x x ∞= (l ∞范数) ()11ni i x x ==∑ (1l 范数) ()12221()ni i x x ==∑ (2l 范数) ()11()np pi pi xx ==∑ (p l 范数) ()12()TAxx Ax = (A 正定) (椭球范数) ()事实上1-范数、2-范数与∞-范数分别是 p -范数当 p =1、2和p →∞时情形。

2.矩阵范数定义 方阵A 的范数是指与A 相关联并记做A 的一个非负数,它具有下列性质: ① 对于0A ≠都有0A >,而0A =时0A =; ② 对于任意k R ∈,都有kA k A =; ③ A B A B +≤+; ④ AB A B ≤; 若还进一步满足: ⑤ pp AxA x ≤则称之为与向量范数p g 相协调(相容)的方阵范数。

第三章无约束问题的最优化方法

赋以0.618。

2 ,

;并计算其对应

的函数值。 3)根据区间消去法原理缩短搜索区间。为了能用原来的 坐标点计算公式,需进行区间名称的代换,并在保留区间 中计算一个新的试验点及其函数值。

如果

令 b , , f f 记N0=0; 2 2 1 2 1 如果 ,则新区间= ,

2

2

图2-5 黄金分割法

• 黄金分割法要求插入两点: a1 a (1 )(b a), f1 f (a1 )

a2 a (b a), f 2 f (a2 )

黄金分割法的搜索过程:

1)给出初始搜索区间及收敛精度 2)按坐标点计算公式计算 1

,将

在搜索区间内[a,b] 任取两点a1、b1,令f1=f(a1), f2=f(b1) • (1)如f1<f2, 则缩小的新区间为[a,b1]; • (2)如f1>f2, 则缩小的新区间为[a1,b]; • (3)如f1=f2, 则缩小的新区间为[a1,b1]

f(b1) f(a1) f(a1) f(b1) f(a1) f(b1)

a

a1

b

a

a1

b1 b

a

a1

b1

b

§3.2 一维搜索方法

黄金分割法: • 黄金分割法适用于[a,b]区间上的任何单谷函数求极小值问题。对 函数除要求“单谷”外不作其他要求,甚至可以不连续。因此,这种 方法的适应面相当广。 • 黄金分割法也是建立在区间消去法原理基础上的试探方法。 • 在搜索区间内[a,b]适当插入两点,将区间分成三段;利用区间消 去法,使搜索区间缩小,通过迭代计算,使搜索区间无限缩小,从而 得到极小点的数值近似解。 •

最优化:最速下降法和Newton法

定理 3.1.1 设假设 2.4.1的条件成立 , 那么采用精确搜索 , 或 Armijo搜索或 Wolfe- P owell搜索的最速下降法产生 的迭 代序列{xk }满足 lim || f ( xk ) || 0

k

由前面的例子看到, 最速下降法的收敛速度至多是线性的, 具体 见下面的两个定理.

第一节

最速下降法

最古老的优化方法,十九世纪中叶由Cauchy提出

1、 思想 :每次沿负梯度方向进行搜索

●

x*

xk 1

等值线(面)

●

xk

●

f ( xk )

负梯度方向也称为最速下降方向:

事实上,对任意p R n 且 || p || , 由Cauchy - Schwarz 不等式得 f ( xk ) T P - || f ( xk ) || || P || - || f ( xk ) || - f ( xk ) - f ( xk ) 当取p 时等号成立,即 p 是下列问题 || f ( xk ) || || f ( xk ) || 的解 min f ( xk ) T P

从上面的例子看到, 对于简单的二元二次函数极小化问题, 最速下降法在有限次迭代并没有求出其精确最优解, 但能 以较慢的速度无限接近最优解.

事实上,上面的例子刻画了最速下降法的所有收 敛特征

3、 最速下降法的收敛性 全局收敛性

由于最速下降法的搜索方向与负梯度方向一致, 即 k 0, 且 || f ( xk ) || || d k || 所以, 由定理2.4.1 - 2.4.3, 我们很容易得到最速下降算法的全 局收敛性.

2

max 其中 , 且max 和min分别是 f ( x * )的最大和最小特征值 . min

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第三章 牛顿法§3.1 最速下降法一、最速下降法在极小化算法中,若每次都以迭代点处的负梯度方向为搜索方向,产生的算法称为最速下降法,它是无约束最优化算法中最简单、最基本的算法。

算法描述:1) 给出初始点0nx R ∈,允许误差0ε>,0k =;2) 计算k k d g =-,若k g ε≤,Stop 令 *k x x ≈;3) 由一维搜索确定步长因子k α,使得()min ()k k k k k f x d f x d ααα≥+=+4) 令1k k k k x x d α+=+,1k k =+,go to 2).的每个聚点均为驻点。

令{}1k K d 有界,且2()(())()0Tf x f x f x ∇-∇=-∇=故有 ()0f x ∇=。

定理 3.2 设()f x 二次连续可微,且2()f x M ∇≤,则对任何给定的初始点0nx R ∈,最速下降算法或有限终止,或lim ()k k f x →∞=-∞,或lim ()0k k f x →∞∇=。

证明:不妨设k ∀,()0k f x ∇≠。

由定理2.5有211()()()2k k k f x f x f x M+-≥∇ 于是 []120101()()()()()2kk k i i i i i f x f x f x f x f x M -+==-=-≥∇∑∑令k →∞,由{()}k f x 为单调下降序列,则要么lim ()k k f x →∞=-∞,要么 lim k →∞∇定理3.3 设1f C ∈证明:直接由定理2.14可得。

注:1) 21λ,n λ分别为G 的≤ ()k k I G x α-其中k α使 (())(())k k k f I G x f I G x αα-≤-, 0α∀≥ 若设 ()1k P t t α=-,()Q t ut λ=- 其中,u R λ∈。

则有()Q G I uG λ=-,而(0)Q λ=,利用这些,可知1()()(())()(0)k k k k Q G f x f I G x f x Q α+=-≤, (要求0uλ>) 21()()1()()(())(())2(0)(0)2(0)T T k k k k Q G Q G x G x Q G x G Q G x Q Q Q == 设12,,n λλλ≥≥L 是G 的特征值,而(1,,)i u i n =L 是对应得标准特征向量(两两正交的单位向量)。

令()1nk k i ii x au ==∑,则上式可进一步表示为:()()2111(())(())2(0)n nk T k i i j j i j a Q G u G a Q G u Q ==∑∑ ()()2111(())(())2(0)n nk Tk i i i j j j i j a Q u G a Q u Q λλ===∑∑ (将G 作用到∑内每一项) ()()2111(())(())2(0)n nk T k i i i j j j j i j a Q u a Q u Q λλλ===∑∑(由i u 是标准正交向量组) 对1=-。

1n显然()Q t 单调上升。

由1()1,()1n Q Q λλ==-,及12,,n λλλ≥≥L ,即得()1(1,,)i Q i n λ≤=L 。

由 ()()22()2()1221111()()2(0)2(0)n nk k k i i i i i i i f x a Q a Q Q λλλ+==≤≤∑∑ 及 ()2()()()()()11111111()()()()()222n nn n n k T k k T k k k i i j j i i j j j i i i j i j i f x a u G a u a u a u a λλ========∑∑∑∑∑即得 12()()(0)k k f x f x Q +≤. 再由 2211(0)n n Q λλλλ⎛⎫+= ⎪-⎝⎭最后得 2111()()n k k n f x f x λλλλ+⎛⎫-≤ ⎪+⎝⎭0k ∀≥.由1101nnλλλλ-<<+,并注意到()f x 是正定二次函数(()0f x ≥), 则有()0 ()k f x k →→∞。

再由()f x 为严格凸二次函数(正定二次型),故当且仅当0x =时,()0f x =,由此可推得必有*0k x x →=.再注意到*()0f x =,则有2*111*1()()()()()()k k n k k n f x f x f x f x f x f x λλλλ++⎛⎫--=≤ ⎪-+⎝⎭是对称正定的,故有由211*11()n k kn n k k x x f x λλλλλλλ⎛⎫-≤ ⎪+-⎝⎭最后得*1*k k x x x x +-≤-(其中1nλτλ=)。

这表明:最速下降算法至少具有线性收敛速度。

定理3.5(Kantorovich 不等式)设G 是n 阶对称正定矩阵,1λ和n λ分别为其最大和最小特征值,则nx R ∀∈,有211214()()()()T n T T n x x x Gx x G x λλλλ-≥+。

证明:参见袁亚湘等《最优化理论与方法》第三章附录,略。

以上对特殊形式的二次函数1()2Tf x x Gx =的收敛速度进行讨论,对一般的二次函数 1()2TT f x x Gx b x =+ 利用Kantorovich*0Gx b +=且()f x 可表示为 **1()()()2T f x x x G x x =--记 **1()()()2T E x x x G x x =--则()E x 与()f x(由Kantorovich 不等式) (1) *x x =时,**()()()02T E x x x G x x =--=利用()E x 一致凸性,可证必有:*k x x →。

这表明:算法产生的点列{}k x 是整体收敛到*x 的。

由(1)有: 2*111*1()()()()()()k k n k k n f x f x E x f x f x E x λλλλ++⎛⎫--=≤ ⎪-+⎝⎭(2)注意到: ***1()02T f x x Gx ≤-≤,由(2)有 22*11111()()1()n nk k n n f x f x f x λλλλλλλλ+⎡⎤⎛⎫⎛⎫--⎢⎥≤+- ⎪ ⎪++⎢⎥⎝⎭⎝⎭⎣⎦211()n k n f x λλλλ⎛⎫-≤ ⎪+⎝⎭(3)再令*k k e x x =-(k ∀),则的近2()()()()()()()2T T k k k k k k f x f x f x x x x x f x x x ≈+∇-+-∇-记 ()21()()()()2k TT k k k q s f x f x s s f x s =+∇+∇,其中k s x x =-,极小化()()k qs 得211(())()k k k k k s f x f x G g --=-∇∇=-进而得牛顿算法的迭代公式: 11k k k k x x G g -+=-.关于牛顿算法的若干评注① 牛顿算法可视为椭球范数kG g 下的最速下降算法。

事实上,欧氏空间n R 中一般范数g 下的方向导数定义为:a) 即②由于min ()nx Rf x ∈等价于求解非线性方程组 ()0f x ∇=设k x 是当前迭代点,若()0k f x ∇=,则k x 是方程组的解,否则将()f x ∇在k x 处线性化,得2()()()()0k k k f x f x f x x x ∇≈∇+∇-=将上述线性方程组的解作为()0f x ∇=的近似解,得 21()()k k k x x f x f x --=-∇∇ 故有 211()()k k k k x x f x f x -+=-∇∇,这恰好就是牛顿迭代公式。

二、牛顿法的收敛性 定理3.7 设(2)f C∈,k x 充分靠近极小点*x ,而*()0f x ∇=,2*()f x ∇正定,若进一步假设Hessian矩阵()G x 满足Lipschitz 条件。

则由牛顿法产生的序列{}k x 收敛于*x ,且具有二阶的收敛速度。

证明:由 *11***00(())()()(())()k k k k k k dg x x x g x g x d G x x x x x d d ααααα+--==+--⎰⎰ 及()G x 满足Lipschitz 条件,可得**2())()]())k k k x x G x x x d αα---(*)*时,k G 正定,且1k G -有上界。

)k 最大,()k n λ最小,则1k G -的特征值为。

又特征值是特征多项式系*x x ε-≤时,存在m, M 使得 1(())(())n m G x G x M λλ≤≤≤, (相当于特征值一致有界) 因而当*k x x ε-≤时1()()n k k m G G M λλ≤≤≤(这里()n k G λ1()k G λ分别表示k G 的最小、最大特征值)。

由以上分析及(*)式,则有21**0()()k k k k G g x x o x x -=--+-2**1()0k k x x o x x +⇒-++-=2**1k k x x c x x+⇒-≤- (**)只要*1k c x x r -<<,则有*10k x x +-→,即*k x x →,迭代点列收敛,且由(**)式知,算法具有二阶收敛的速度。

关于算法的评价1)优点:当初始点0x 离最优解*x 很近时,收敛速度快;算法简单;不需要用一维搜索。

2) 缺点:局部收敛,k G 不正定时,不能保证牛顿方向是下降方向。

事实上,当k G 为正定时,牛顿方向1k k k s G g -=-满足:10T T k k k k g s g G g -=-<(下降方向),但若k G 非正定,则不能保证k s 是下降方向。

由以上分析可知,固定的步长因子不能保证目标函数有合理的改善,甚至不能保证算法下降,因此有必要对牛顿算法作一些改进,一个最直接的改进是:在牛顿算法中加入一维搜索。

112;40()min k k f x d αα≥+;52.总体收敛性定理3.8 设:nf R R →二阶连续可微,且对任意的0nx R ∈,存在常数0m >,使得()f x 在水平集00(){()()}L x x f x f x =≤上满足,22()Tu f x u m u ∇≥,nu R ∀∈,0()x L x ∈则在精确一维搜索条件下,带步长因子的牛顿法产生的迭代点列{}k x 满足: 1) 当{}k x 为有穷点列时,对某个k ,有0k g =;2) 当{}k x 为无穷点列时,{}k x 收敛到f 的唯一极小点*x 。