第三章:信源、熵率及冗余度

信源及信源熵介绍

2.2.1 自信息量

2. 不确定度 定义:随机事件的不确定度在数量上等于它的 自信息量.

说明:

a. 两者的单位相同,但含义却不相同。 b. 具有某种概率分布的随机事件不管发生与否,都存在

不确定度,不确定度表征了该事件的特性,而自信息 量是在该事件发生后给予观察者的信息量。

15

2.2.1 自信息量

22

2) 因为X中各符号xi的不确定度I(xi)为非负值,p(xi)也 是非负值,且0 p(xi)1,故信源的平均不确定度H(X) 也是非负量。

3) 平均不确定度H(X)的定义公式与热力学中熵的表示形 式相同,所以又把H(X)称为信源X的熵。熵是在平均意 义上来表征信源的总体特性的,可以表征信源的平均不确 定度。

2

p(xi ) log 2 p(xi ) i 1

= 0.72比特/次 说明:

1) 自信息量I(x1)和I(x2)只是表征信源中各个 符号的不确定度,一个信源总是包含着多个符 号消息,各个符号消息又按概率空间的先验概 率分布,因而各个符号的自信息量就不同。所 以自信息量不能作为信源总体的信息量。

=3 × 105 × 3.32 比特/画面

25

有一篇千字文章,假定每字可从万字表中任选, 则共有不同的千字文 N=100001000=104000 篇 仍按等概率1/100001000计算,平均每篇千字文 可提供的信息量为 H(X)=log2N =4 × 103 × 3.32

1.3 × 104 比特/千字文

离散消息的信源,如文字、数字、数据等符号都是

离散消息。

{ 离散信源

离散无记忆信源 离散有记忆信源

{ {

5

发出单个符号的无记忆信源 发出符号序列的无记忆信源 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源

信息论基础-第三章

信息论基础-第三章

3.3.2 离散平稳有记忆信源的熵(3)

定理 3.3.1:任意离散平稳信源,若 H1(X)

1) H(XN/X1 XN1)不随N而增加 2) H N (X ) H (X N /X 1 X N 1 ) 3) HN (X)不随N而增加 4) H(X) 存在,且 H (X ) N l i H m (X N /X 1 X N 1 )

信息论基础-第三章

3.3.1 离散平稳信源(3)

例 3.3.1 一平稳信源X的符号集A={0,1},产生随机序列, 其中P(x1=0)=p, 求P(xn=1)(n >1)的概率。

解:

平稳性 P(xn0)p

P(xn1)1p

信息论基础-第三章

3.3.1 离散平稳信源(4)

例 3.3.1续 对同一信源,若P(x1=0,x2=1)=b 求P(x4=1/x3=0)。

信息论基础-第三章

3.3.2 离散平稳有记忆信源的熵(5)

2) 只要证明N个 HN (X)的和不小于 NH (XN/X 1 XN 1)

NN H (X )H (X 1 X N) H (X 1)H (X 2/X 1) H (X N/X 1 X N 1) NH (X N/X 1 X N 1)

H N ( X ) H ( X N /X 1 X N 1 )

平均符号熵不小于条件熵

信息论基础-第三章

3.3.2 离散平稳有记忆信源的熵(6)

3) 由于 NHN(X) H ( X 1 X N 1 ) H ( X N /X 1 X N 1 ) 根据平均符号熵的定义和2)的结果,有 N H N (X ) (N 1 )H N 1 (X ) H (X N /X 1 X N 1 ) (N 1 )H N 1 (X ) H N (X )

二次扩展信源的熵

二次扩展信源的熵:

H ( X ) H ( X ) p(i )log 2 p(i ) 3

2 i 1

9

2、离散平稳有记忆信源的概念及其信源熵

离散平稳有记忆信源:输出的符号序列是平稳随机序 列,并且符号之间是相关的,即不是统计独立的信源。 数学模型为:

X X1 X 2 X 3

例3.2

设有一离散无记忆信源X,其概率空间为 x1 x2 x3 X 1 1 1 P X 2 4 4 求该信源的熵率及二次扩展信源的熵。

注意:题目中的概率空间不是离散多符号无记忆信源 的概率空间,而是其对应的离散单符号信源的概率空 间。 该例题是对离散平稳无记忆信源求熵率的一个练习,

二次扩展信源的概率空间:

X 2 1 ( x1 x1 ) 2 ( x1 x2 ) 3 ( x1 x3 ) 4 ( x2 x1 ) 5 ( x2 x2 ) 2 1/ 8 1/ 8 1/ 8 1/16 P( X ) 1/ 4 6 ( x2 x3 ) 7 ( x3 x1 ) 8 ( x3 x2 ) 9 ( x3 x3 ) 1/16 1/ 8 1/16 1/16

X X1 X 2 X 3

离散单符号信源的 N 次平稳无记忆扩展信源( N 次无记忆扩展信源)

它是一种N 次扩展信源,其每次输出的是 N 长符号序 列,数学模型为 N 维离散随机变量序列(随机矢量)

X X1 X 2 X N

其中每个随机变量之间统计独立。由平稳性知,每个 随机变量统计特性相同,故该信源又可表示为:

比特/号

2) 如果不考虑符号间的相关性,则信源熵为

1 4 11 H ( X ) H ( , , ) 1.542 比特/符号 4 9 36

信息论第3章信源及信息熵

举例

数学描述

离散信源 (数字信源)

连续信号

文字、数据、 离散化图象

离散随机变量 序列

跳远比赛的结果、语音 连续随机变量

信号抽样以后

序列

波形信源 (模拟信源)

语音、音乐、热噪声、 图形、图象

不常见

随机过程

表3.1 信源的分类

3.1 信源的分类及其数学模型

我们还可以根据各维随机变量的概率分布是否随时间的推移 而变化将信源分为平稳信源和非平稳信源,根据随机变量间 是否统计独立将信源分为有记忆信源和无记忆信源。

定义3.2 随机变量序列中,对前N个随机变量的联合熵求平

均:

HN

(X)

1 N

H ( X1X 2

XN)

称为平均符号熵。如果当N

时上式极限存在,则

lim

N

H

N

(X)

称为熵率,或称为极限熵,记为

def

H

lim

N

H

N

(

X

)

3.3.1 离散平稳无记忆信源

离散平稳无记忆信源输出的符号序列是平稳随机序列,并且

H(X ) H(X1X2 XN ) H ( X1) H ( X2 | X1) H ( X3 | X1X 2 ) H ( X N | X1X 2 X N1)

定理3.1 对于离散平稳信源,有以下几个结论:

(1)条件熵 H (X N | X1X 2 X N1) 随N的增加是递减的;

(2)N给定时平均符号熵大于等于条件熵,即

s1

si p(s j

| si )

s q

m

状态空间由所有状态及状态间的状态转移概率组成。通过引

入状态转移概率,可以将对马尔可夫信源的研究转化为对马 尔可夫链的研究。

信息论典型试题及答案

第五章

5.1将下表所列的信源进行六种不同的二进制编码。

(1)求这些码中哪些是惟一可译码。

(2)哪些码是非延长码

(3)对所有惟一可译码求出其平均码长 。

消息

C1

C2

C3

C4

C5

C6

1/2

000

0

0

0

0

0

1/4

001

01

10

10

10

100

1/16

010

011

110

110

1100

101

27.能够描述无失真信源编码定理

例1:.黑白气象传真图的消息只有黑色和白色两种,求:

1)黑色出现的概率为0.3,白色出现的概率为0.7。给出这个只有两个符号的信源X的数学模型。假设图上黑白消息出现前后没有关联,求熵H(X);

2)假设黑白消息出现前后有关联,其依赖关系为:P(白/白)=0.9,P(黑/白)=0.1,P(白/黑)=0.2,P(黑/黑)=0.8,求其熵H2(X);

10.互信息的性质是什么?

11.熵的表达式、单位、含义是什么?

12.单符号离散信源最大熵是多少?信源概率如何分布时能达到?

13.熵的性质是什么?

14.联合熵、条件熵和熵的关系。

15.平均互信息的定义是什么?平均互信息的表达式怎么推导?

16.平均互信息的含义?

17.信道疑义度、损失熵和噪声熵的含义?

18.平均互信息的性质?(能够证明,并说明每个性质的含义)

解:

由题意可知该二元信道的转移概率矩阵为:

为一个BSC信道

所以由BSC信道的信道容量计算公式得到:

3.14电视图像编码中,若每帧为500行,每行划分为600个像素,每个像素采用8电平量化,且每秒传送30帧图像。试求所需的信息速率(bit/s)。

信息论与编码试题集与答案(新)

信息论与编码试题集与答案(新)1. 在无失真的信源中,信源输出由 H (X ) 来度量;在有失真的信源中,信源输出由 R (D ) 来度量。

2. 要使通信系统做到传输信息有效、可靠和保密,必须首先信源编码,然后_____加密____编码,再______信道_____编码,最后送入信道。

3. 带限AWGN 波形信道在平均功率受限条件下信道容量的基本公式,也就是有名的香农公式是log(1)C W SNR =+;当归一化信道容量C/W 趋近于零时,也即信道完全丧失了通信能力,此时E b /N 0为-1.6 dB ,我们将它称作香农限,是一切编码方式所能达到的理论极限。

4. 保密系统的密钥量越小,密钥熵H (K )就越小,其密文中含有的关于明文的信息量I (M ;C )就越大。

5. 已知n =7的循环码42()1g x x x x =+++,则信息位长度k 为 3 ,校验多项式 h(x)= 3 1x x ++ 。

6. 设输入符号表为X ={0,1},输出符号表为Y ={0,1}。

输入信号的概率分布为p =(1/2,1/2),失真函数为d (0,0) = d (1,1) = 0,d (0,1) =2,d (1,0) = 1,则D min = 0 ,R (D min )=1bit/symbol ,相应的编码器转移概率矩阵[p(y/x )]=1001??;D max = 0.5 ,R (D max )= 0 ,相应的编码器转移概率矩阵[p(y/x )]=1010??。

7. 已知用户A 的RSA 公开密钥(e,n )=(3,55),5,11p q ==,则()φn = 40 ,他的秘密密钥(d,n )=(27,55) 。

若用户B 向用户A 发送m =2的加密消息,则该加密后的消息为 8 。

二、判断题1. 可以用克劳夫特不等式作为唯一可译码存在的判据。

(√ )2. 线性码一定包含全零码。

(√ )3. 算术编码是一种无失真的分组信源编码,其基本思想是将一定精度数值作为序列的编码,是以另外一种形式实现的最佳统计匹配编码。

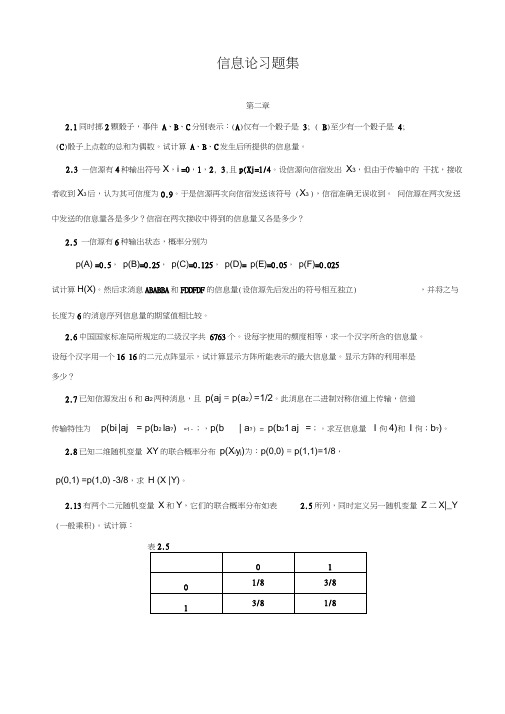

信息论习题集

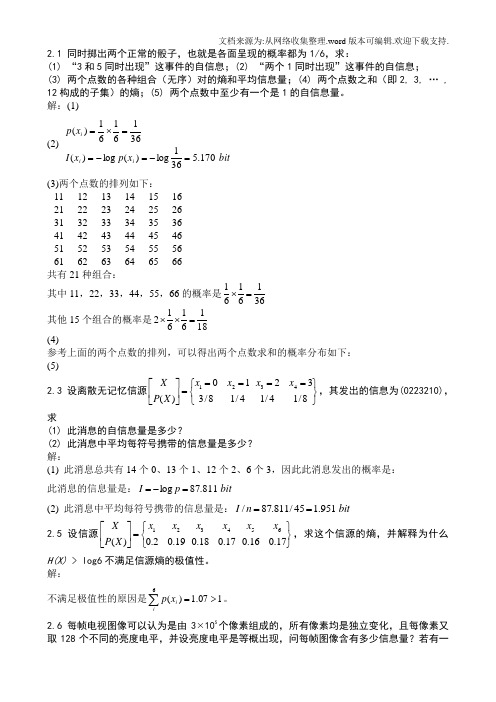

信息论习题集第二章2.1同时掷2颗骰子,事件A、B、C分别表示:(A)仅有一个骰子是3; ( B)至少有一个骰子是4;(C)骰子上点数的总和为偶数。

试计算A、B、C发生后所提供的信息量。

2.3 —信源有4种输出符号X,i =0,1,2, 3,且p(Xj=1/4。

设信源向信宿发出X3,但由于传输中的干扰,接收者收到X3后,认为其可信度为0.9。

于是信源再次向信宿发送该符号 (X3 ),信宿准确无误收到。

问信源在两次发送中发送的信息量各是多少?信宿在两次接收中得到的信息量又各是多少?2.5 一信源有6种输出状态,概率分别为p(A) =0.5,p(B)=0.25,p(C)=0.125,p(D)= p(E)=0.05,p(F)=0.025试计算H(X)。

然后求消息ABABBA和FDDFDF的信息量(设信源先后发出的符号相互独立) ,并将之与长度为6的消息序列信息量的期望值相比较。

2.6中国国家标准局所规定的二级汉字共6763个。

设每字使用的频度相等,求一个汉字所含的信息量。

设每个汉字用一个16 16的二元点阵显示,试计算显示方阵所能表示的最大信息量。

显示方阵的利用率是多少?2.7已知信源发出6和a2两种消息,且p(aj = p(a2)=1/2。

此消息在二进制对称信道上传输,信道传输特性为p(bi |aj = p(b2 la?) =1 - ;,p(b | a?) = p(b21 aj =;。

求互信息量I 佝4)和I 佝;b?)。

2.8已知二维随机变量XY的联合概率分布p(X i y j)为:p(0,0) = p(1,1)=1/8,p(0,1) =p(1,0) -3/8,求H (X |Y)。

2.13有两个二元随机变量X和Y,它们的联合概率分布如表 2.5所列,同时定义另一随机变量Z二X|_Y (一般乘积)。

试计算:(1)熵H(X),H(Y),H(Z), H(XZ),H(YZ), H(XYZ);(2)条件熵H(X |Y),H(Y|X),H(X |Z),H(Z|X),H(Y|Z), H(Z|Y), H(X|YZ), H (Y | XZ)和H(Z | XY);(3)互信息I (X;Y), I (X;Z), I (Y; Z), I(X;Y| Z),I(Y;Z| X)和I (X ;Z |Y)。

第三章 信源及信源熵

3.3.1 离散平稳信源

P(Xi) P(Xj )

推论1

P(Xi Xi1) P(Xj Xj1)

PXi1Xi PXj1Xj P(Xi Xi1

XiN) P(Xj Xj1

XjN )

PX XX X iN i i1

iN1

PXjNXjXj1 XjN1

离散平稳信源的条件概率分布与时间起点无关,只与关联长度N有关。

第19页,共60页。

3.3.2 离散平稳无记忆信源

熵率

H lN iH m NX lN iN 1 m NX H H X

离散平稳无记忆信源的熵率等于单符号离散信源熵。

例1

离散无记忆信源为:X:{a1,a2,a3};P(X):{1/4, 1/2, 1/4},试求:

12))该写信出源该的信熵源;的二次H 扩(展X 信)源 ,1并.5 求b其it概率分布;

均为离散平稳 信源

中文自然语言文字

离散平稳信源又分为无记忆信源和有记忆信源。

第11页,共60页。

3.3 离散多符号信源

离散平稳无记忆信源 信源发出的各个符号彼此是统计独立的。 对于多符号信源X=(X1 X2 …XN),各随机变量Xi(i=1,2, …,N)之

间是统计独立的,即: 称该多符号信源为离散无记忆信源的N次扩展信源。

3)根据2)中结果求该信源二次扩展信源的信源熵及熵率。

第20页,共60页。

3.3.2 离散平稳无记忆信源

2)写出该信源的二次扩展信源,并求其概率分布;

解:

二次扩展信源为: 信源符号为:

X 2 :{A1…A9}

A1=a1a1 A4=a2a1 其概率分A布7=为a3:a1

A2=a1a2 A5=a2a2 A8=a3a2

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

离散信源-单符号离散信源的数学描述

• 新信源输出的符号是N长的消息序列,用N维离散随机矢量来 描述。ai=(xi1xi2…xiN) i=1,2, …,n 每个分量xik (k=1,2,…,N)都是随机变量,都取值于同一信源X, 并且分量之间统计独立。

• 由随机矢量X组成的新信源称为离散无记忆信源X的N次扩展信

源。

• 离散无记忆信源的N次扩展信源的数学模型是X信源空间的N重

• 例3-2: THEY ARE MY FRIENDS.

离散信源-多符号离散信源的数学描述

• 多符号离散信源可用随机矢量/随机变量序列描述, 即

X=X1X2X3…

• 信源在不同时刻的随机变量Xi和Xi+r的概率分布 P(Xi)和P(Xi+r)一般来说是不相同的,即随机变量的 统计特性随着时间的推移而有所变化。

• 一般来说,信源输出的随机序列的统计特性比较复杂,分 析起来也比较困难。为了便于分析,我们假设信源输出的 是平稳的随机序列,也就是序列的统计性质与时间的推移 无关。很多实际信源也满足这个假设。

离散信源-平稳信源的数学模型(二维)

➢ 最简单的离散平稳信源:二维平稳信源 X=X1X2 ➢ 每两个符号看做一组,每组代表信源X=X1X2的一个消息;

离散信源-离பைடு நூலகம்平稳信源

• 若每变而个信量且随源,随机输即机变出每矢量的个量随随XX的机机i (各i序变=1维列量,2概,XX…=i率的,分可N(X)布能都1都取是,与值取X时是值2间有,离起限…散点,的的无X或离关N可散,数型)的也中随,。就机 是在任意两个不同时刻随机矢量X的各维概率分布都相同。 这样的信源称为离散平稳信源。如中文自然语言文字,离 散化平面灰度图像都是这种离散型平稳信源。

– 信源的统计特性如何? – 如何对信源分类? – 各类信源如何建模?

信源特性

• 信源的统计特性

– 1)什么是信源?

• 信源是信息的来源,实际通信中常见的信源有:语音、 文字、图像、数据…。在信息论中,信源是产生消息 (符号)、消息(符号)序列以及连续消息的来源,数

学上,信源是产生随机变量X,随机序列 X 和随机过程

X(t,ω)的源。

– 2)信源的主要特性

• 信源的最基本的特性是具有统计不确定性,它可用概率 统计特性来描述。

信源的分类

• 离散信源与连续信源 • 离散信源

– 单符号信源 – 序列信源

• 平稳&非平稳 • 有记忆&无记忆

• 连续信源

– 连续信源 – 波形信源

离散信源-单符号离散信源(1)

– 它是最简单也是最基本的信源,是组成实际信源 的基本单元。

• 对单符号离散信源U

有:

UP

U

u1 U p1

pi

ui

U

un pn

例3-1:对于二进制数字信源:U={0,1},则有

U P

u1 p0

0

u2 p1

1

当p0

p1

1 2

0 1 2

1

1

2

离散信源-离散多符号信源

• 实际的信源输出的消息是时间或空间上离散的一系列随机 变量。这类信源每次输出的不是一个单个的符号,而是一 个符号序列。在信源输出的序列中,每一位出现哪个符号 都是随机的,而且一般前后符号的出现是有统计依赖关系 的。这种信源称为多符号离散信源。

➢ 每组中的后一个符号和前一个符号有统计关联,这种概率 性的关系与时间起点无关;

➢ 假定符号序列的组与组之间是统计独立的。

➢设X1,X2 ∈{x1,x2,…,xn},矢量 X∈{x1x1, …x1xn,x2x1, …,x2xn, …xnx1, …,xnxn} 令

i1,i2 1, 2,,n i 1, 2,, n2 p(ai ) p(xi1 xi2 ) p(xi1 ) p(xi2 / xi1 )

• 我们称由信源空间[X,P(x)]描述的信源X为离散无记 忆信源。这信源在不同时刻发出的符号之间是无依赖的, 彼此统计独立的。

离散信源-离散无记忆信源的N次扩展信源

• 离散无记忆信源X={ x1,x2,…,xn},对它的输出消息序列,可以 用一组组长度为N的序列来表示它。这时它就等效成了一个新 信源;

– 这类信源可能输出的消息数是有限的或可数的, 而且每次只输出其中一个消息。因此,可以用一 个离散型随机变量X来描述这个信源输出的消息。 这个随机变量X的样本空间就是符号集A;而X的 概率分布就是各消息出现的先验概率,信源的概 率空间必定是一个完备集。

离散信源-单符号离散信源(2)

– 当信源给定,其相应的概率空间就已给定;反之, 如果概率空间给定,这就表示相应的信源已给定。 所以,概率空间能表征离散信源的统计特性,因此 有时也把这个概率空间称为信源空间。

第三章:信源、熵率及冗余度

问题一

• 信息论对信源的研究内容包括哪几个方面?

信息论对信源研究的内容

– 信源的建模:用恰当的随机过程来描述信号

• 关心角度:信号中携带的信息

– 信源输出信号中携带信息的效率的计算

• 熵率、冗余度

– 信源输出信息的有效表示

• 信源编码

问题二

• 从信息论的角度如何为信源建模?

空间。

例3-3:

A B D A C B B AC C D

X1 0 0 0 0 0 0 0 0 0 0 0 X2 1 1 1 1 1 1 1 1 1 1 1 X3 0 0 0 0 0 0 0 0 0 0 0 X4 0 0 0 0 0 0 0 0 0 0 0 X5 0 0 0 0 0 0 0 0 0 0 0 X6 0 0 1 0 0 0 0 0 0 0 1 X7 0 1 0 0 1 1 1 0 1 1 0 X8 1 0 0 1 1 0 0 1 1 1 0

➢ X的数学模型

离散信源-离散平稳无记忆信源

• 在某些简单的离散平稳信源情况下,信源先后发出的一 个个符号彼此是统计独立的。也就是说信源输出的随机 矢量X=(X1X2…XN)中,各随机变量Xi (i=1,2,…N)之间 是无依赖的、统计独立的,则N维随机矢量的联合概率

分布满足P(X)=P(X1)P(X2)…P(XN)