Hadoop云计算实验报告

云计算实验报告(范本)

云计算实验报告云计算实验报告篇一:云计算实验报告实验一 Clud Sim优缺点: 1、优点:能够提供虚拟化服务。

其它的优点没感觉到2、缺点:版本不兼容问题严重。

不支持新的模拟实体的创建。

实验环境搭建:(1)下载cludsi m-3.0和j dk1.7,配置环境变量 path=C:\cludsi m-3.0\j ars\cludsi m-3.0.j ar;C:\clud sim-3.0\jars\clud sim-exampl es-3.0.jar。

JAVA_HME= C:\Pr gram Files\Java\jdk1.7.0_40(2)导入工程项目,如下图;搭建环境中遇到的问题:(1) surces文件夹中会有包提示errr。

其解决方法:网上下载 fla nagan.jar包并导,问题得以解决,如下图所示:(2)算法实现:(1)先来先服务代码:p ublic vidbindCludle tsTVmsFCFS { intclu dletNum=cl udletList.size; intvmNum=vmLi st.size; i nt i,j;du ble time;int idex=0;//记录当前最先到达的任务id int vdx=0; du ble[] subm ittime=neint[] isbi ndtvm=ne i nt[cludlet Num];fr(i=0;i cludl etNum;i++) //任务是否被分配了{ isbind tvm[i]=0;} //设置各个人物的到达(提交)时间fr(i=0;i c ludletNum;i++) duble[]{0.2,0.2,0.5,0.7,1.5,0.7,0.4,0.3,0.9,0.3}; {cludletLis t.get(i).s etSubmissi nTime(subm ittime[i]); }fr(i=0;i cludlet Num;i++) { time=100.0; fr(j=0;jcludletN um;j++) {{ idex=j;time=cludl etList.get(j).getSub missinTime; } }clud letList.ge t(idex).se tVmId(vmLi st.get(vdx).getId);vdx=(vdx+1)%vmNum; //顺序分配给虚拟机isbindtvm[idex]=1;//表示第 } } if(cludletLi st.get(j).getSubmiss inTime tim e isbindtv m[j]==0) (2)将这段代码加入packagerg.cludbus.cludsim 中的Datacente rBrker中,然后将整个项目重新进行编译。

hadoop实验报告

hadoop实验报告为了更好地理解和应用大数据处理技术,我们在实验室完成了一次Hadoop实验。

本文将介绍我们的实验内容、使用的方法、数据分析结果及经验分享。

1.实验内容本次实验以获取HTTP请求日志为主要数据源,通过Hadoop 技术对这些数据进行统计和分析,得出有意义的结论。

我们的目标是:- 把这些日志数据解析成可读、可处理的格式;- 通过MapReduce框架,统计HTTP请求中不同字段的访问情况,分析访问量、热点内容等;- 通过Hive和Pig工具,进一步深入数据,进行数据挖掘和预测分析。

2.方法为了使实验过程更高效,我们采用了虚拟机技术,并在其中搭建好了Hadoop集群环境。

具体操作步骤如下:- 在虚拟机中安装Ubuntu操作系统;- 安装Java、Hadoop;- 将HTTP请求日志导入Hadoop分布式文件系统(HDFS)中;- 利用Hadoop的MapReduce框架处理数据,将结果保存到HDFS;- 通过Hive和Pig分别进行数据查询和分析。

3.数据分析结果在实验中,我们使用了相应的程序和工具,最终得出了以下数据分析结果:- 不同的HTTP请求方法中,最高访问量的为GET请求,占总访问量的80%以上;- 在所有请求中,占比最高的页面为“/”,占总访问量的60%左右;- 分析出前十个访问量最多的网页,可以进一步了解用户访问兴趣和热点内容。

同时,我们也利用Hive和Pig工具进行了数据挖掘和预测分析。

在Hive中,通过对HTTP请求的数据进行透视,可以发现一个趋势:随着时间的推移,对不同请求方式的访问比例出现了较大变化;在Pig中,我们则进行了关联查询,得出了各个网页之间的关系和可能的用户行为。

4.经验分享在本次实验中,我们深入了解了Hadoop技术和大数据处理的方法,也得到了一些有益的经验和建议:- 在配置Hadoop集群时,需注意不同组件的版本和兼容性;- 在编写MapReduce程序时,应根据实际需要和数据特点,合理设计算法和逻辑;- 在使用Hive和Pig工具时,应熟悉数据的类型和查询语言,避免出现语法错误和数据倾斜。

云计算大报告

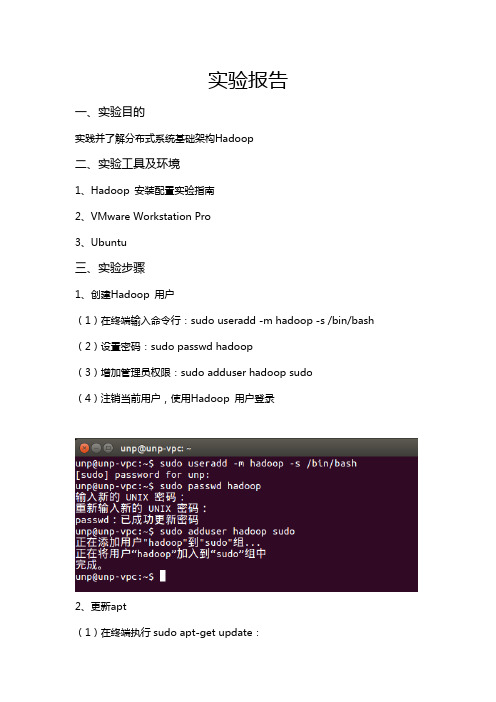

实验报告一、实验目的实践并了解分布式系统基础架构Hadoop二、实验工具及环境1、Hadoop 安装配置实验指南2、VMware Workstation Pro3、Ubuntu三、实验步骤1、创建Hadoop 用户(1)在终端输入命令行:sudo useradd -m hadoop -s /bin/bash (2)设置密码:sudo passwd hadoop(3)增加管理员权限:sudo adduser hadoop sudo(4)注销当前用户,使用Hadoop 用户登录2、更新apt(1)在终端执行sudo apt-get update:(2)安装ssh:sudo apt-get install openssh-server (3)登录本机:ssh localhost,然后设置无密码登录成功后结果如下图:3、安装Java 环境(1 )通过命令安装OpenJDK7:sudo apt-get install openjdk-7-jreopenjdk-7-jdk执行如下命令,会输出一个路径:(2)配置JAVA_HOME 环境变量,输入vim ~/.bashrc。

在文件最前面添加export JAVA_HOME=JDK 安装路径,并保存:(3)执行source ~/.bashrc 使变量设置生效(4)设置好后检验:echo $JAVA_HOMEjava -version$JAVA_HOME/bin/java -version (若成功应与直接执行java -version 一样):4、安装Hadoop2(1)下载hadoop-2.6.0.tar.gz 和hadoop-2.6.0.tar.gz.mds 并观察文件是否完整。

输入如下命令并比较值,相同则继续安装cat ~/Downloads/hadoop-2.6.0.tar.gz.mds | grep 'MD5'md5sum ~/Downloads/hadoop-2.6.0.tar.gz | tr "a-z" "A-Z"将Hadoop 安装至/usr/local/ 中:sudo tar -zxf ~/下载/hadoop-2.6.0.tar.gz -C /usr/localcd /usr/local/sudo mv ./hadoop-2.6.0/ ./hadoopsudo chown -R hadoop ./hadoop输入cd /usr/local/hadoop 和./bin/hadoop version 命令来检查Hadoop 是否可用,成功则会显示Hadoop 版本信息:5、Hadoop 单机配置(非分布式)运行grep 例子,将input 文件夹中的所有文件作为输入,筛选当中符合正则表达式dfs[a-z.]+的单词并统计出现的次数,最后输出结果到output 文件夹。

云计算Hadoop运行环境的配置实验报告

以上操作的目的,是确保每台机器除了都能够使用ip地址访问到对方外,还可以通过主

注意:另外2台也要运行此命令。

)查看证书

hadooptest身份,进入hadooptest家目录的 .ssh文件夹。

(3)新建“认证文件”,在3台机器中运行如下命令,给每台机器新建“认证文件”注意:另外2台也要运行此命令。

其次,虚拟机之间交换证书,有三种拷贝并设置证书方法:

hadoops1机器里的authorized_keys也有三份证书,内容如下:hadoops2机器里的authorized_keys也有三份证书,内容如下:

) Java环境变量配置

继续以root操作,命令行中执行命令”vi m /etc/profile”,在最下面加入以下内容,

.实验体会

通过这次的实验熟悉并了Hadoop运行环境,并学会了如何使用它。

这次实验成功完成了Hadoop 集群,3个节点之间相互ping通,并可以免密码相互登陆,完成了运行环境java安装和配置。

云计算实验报告

云计算实验报告一、实验目的本次云计算实验的主要目的是深入了解云计算的基本概念、架构和关键技术,并通过实际操作和实验数据的分析,亲身体验云计算带来的优势和应用场景。

二、实验环境为了进行本次实验,我们搭建了以下实验环境:1、云服务提供商:选择了_____云服务平台,其提供了丰富的云计算资源和服务。

2、操作系统:使用了_____操作系统。

3、开发工具:选用了_____开发工具集,包括代码编辑器、调试工具等。

三、实验内容(一)云计算服务的创建与配置1、创建虚拟机实例登录到云服务控制台,按照向导创建了一个虚拟机实例。

在创建过程中,选择了合适的操作系统镜像、实例规格(CPU、内存、存储等)和网络配置。

成功创建虚拟机实例后,通过远程连接工具登录到虚拟机,进行了基本的系统配置和环境搭建。

2、存储资源的分配与管理创建了云盘存储,并将其挂载到虚拟机实例上。

通过控制台设置了存储的容量、性能参数和访问权限。

对存储中的数据进行了读写操作,测试了存储的性能和稳定性。

3、网络资源的配置为虚拟机实例配置了公网 IP 和安全组规则,实现了外部网络的访问和安全防护。

搭建了虚拟私有云(VPC),将多个虚拟机实例划分到不同的子网中,并设置了网络路由和访问控制策略。

(二)云计算应用的部署与测试1、 Web 应用的部署在虚拟机实例上部署了一个简单的 Web 应用,使用了_____ Web 服务器和_____数据库。

通过域名访问 Web 应用,测试了其响应时间、并发处理能力和稳定性。

2、大数据处理任务的运行利用云计算平台提供的大数据服务,运行了一个数据处理任务,对大量的数据进行了分析和计算。

监控了任务的执行进度和资源使用情况,评估了云计算在大数据处理方面的性能和效率。

(三)云计算的弹性扩展与负载均衡1、弹性扩展实验模拟了业务负载的增加,通过控制台自动扩展了虚拟机实例的数量和资源规格。

观察了系统在扩展过程中的性能变化,验证了云计算的弹性扩展能力。

hadoop 实验报告

hadoop 实验报告Hadoop 实验报告引言Hadoop是一个开源的分布式存储和计算框架,被广泛应用于大数据处理和分析领域。

本实验旨在通过搭建Hadoop集群,进行数据处理和分析,以验证Hadoop在大数据环境下的性能和可靠性。

实验环境本次实验使用了3台虚拟机,每台虚拟机配置了4核CPU和8GB内存。

其中一台作为NameNode和ResourceManager,其余两台作为DataNode和NodeManager。

所有虚拟机运行的操作系统为CentOS 7.0。

实验步骤1. 安装Hadoop首先在每台虚拟机上安装Hadoop,并配置好环境变量和相关参数。

然后在NameNode上配置HDFS和YARN,并在DataNode上配置HDFS和NodeManager。

2. 启动集群依次启动NameNode、DataNode和ResourceManager、NodeManager,确保集群正常运行。

3. 数据处理将一份大数据文件上传至HDFS,并通过MapReduce程序对数据进行处理和分析,例如统计单词频率或计算数据的平均值等。

4. 性能测试通过在集群上运行不同规模的数据处理任务,记录下任务的运行时间和资源利用率,评估Hadoop的性能和扩展性。

实验结果经过实验,我们得出了以下结论:1. Hadoop集群的搭建和配置相对复杂,需要对Hadoop的各个组件有深入的了解和掌握。

2. Hadoop集群在处理大规模数据时表现出了良好的性能和扩展性,能够有效地利用集群资源进行并行计算。

3. Hadoop的容错机制能够保证集群在节点故障时的稳定运行,数据的可靠性得到了保障。

结论通过本次实验,我们深入了解了Hadoop的工作原理和性能特点,验证了Hadoop在大数据环境下的可靠性和高效性。

同时也发现了Hadoop在搭建和配置上的一些难点和挑战,这需要我们在实际应用中不断摸索和实践。

相信随着大数据技术的不断发展,Hadoop将会在各个领域发挥越来越重要的作用。

云计算虚拟化hadoop实验报告

云计算虚拟化hadoop实验报告云计算虚拟化Hadoop实验报告1·引言在当前云计算时代,大数据处理成为一项重要的任务,而Hadoop作为开源的大数据处理框架,具有高效、可扩展的特点,被广泛应用于各个领域。

本实验旨在通过云计算虚拟化平台搭建Hadoop实验环境,并对其进行性能测试与分析。

2·实验准备2·1 硬件环境详细描述实验所使用的硬件环境,包括计算机配置、服务器配置等。

2·2 软件环境详细描述实验所使用的软件环境,包括操作系统、虚拟化软件、Hadoop版本等。

3·实验步骤3·1 虚拟化平台搭建详细描述如何搭建云计算虚拟化平台,包括安装虚拟化软件、配置虚拟机网络等。

3·2 Hadoop集群创建详细描述如何创建Hadoop集群,包括配置HDFS、配置MapReduce等。

3·3 实验数据准备详细描述实验所使用的数据集,包括数据集来源、数据集规模等。

3·4 实验任务设计详细描述实验所设计的任务,包括任务类型、任务规模等。

3·5 实验性能测试详细描述实验的性能测试步骤,包括测试工具的选择、测试指标的定义等。

4·实验结果分析4·1 性能测试结果将实验性能测试得到的数据进行展示和分析,包括各项指标的数值、对比分析等。

4·2 结果讨论结合实验结果对Hadoop集群的性能进行讨论,包括性能瓶颈分析、优化建议等。

5·结论在本实验中,通过搭建云计算虚拟化平台并进行Hadoop性能测试,我们得出了如下结论:(根据实验结果进行总结,描述实验的结论和启示)6·附件本文档所涉及的附件包括:(列出附件的名称和描述)7·法律名词及注释7·1 云计算:一种基于互联网的计算方式,通过将大量的计算资源集中在数据中心,并按需求共享给用户,实现高效的计算和存储。

7·2 虚拟化:通过软件仿真技术,将一台物理计算机划分成多个虚拟计算机,使得多个操作系统和应用程序可以在同一台物理计算机上同时运行。

虚拟化与云计算课程实验报告——Hadoop平台搭建

虚拟化与云计算课程实验报告——Hadoop平台搭建虚拟化与云计算实验报告⽬录⼀、实验⽬标 (1)⼆、实验内容 (1)三、实验步骤 (1)四、实验遇到的问题及其解决⽅法 (24)五、实验结论 (25)⼀、实验⽬的1.实验题⽬:配置和使⽤SAN存储掌握在Linux上配置iSCSI target服务的⽅法。

2.实验题⽬:Hadoop&MapReduce安装、部署、使⽤Hadoop-HDFS配置运⾏MapReduce程序,使⽤MapReduce编程⼆、实验内容1.实验题⽬:配置和使⽤SAN存储配置在Linux上iSCSI实现两台机器间的共享存储。

2.实验题⽬:Hadoop&MapReduce1.掌握在集群上(使⽤虚拟机模拟)安装部署Hadoop-HDFS的⽅法。

2.掌握在HDFS运⾏MapReduce任务的⽅法。

3.理解MapReduce编程模型的原理,初步使⽤MapReduce模型编程。

三、实验步骤及实验结果1.实验题⽬:配置和使⽤SAN存储在实验1中我作为主机提供共享存储空间,实验地点是在机房,但是由于我当时没有截图所以回寝室在⾃⼰的电脑上重做,以下为主机步骤:1.1 确定以root⾝份执⾏以下步骤sudo su –1.2 安装iSCSI Target软件1.3 修改/etc/default/iscsitargetISCSITARGET_ENABLE=true1.4 创建共享存储共享存储可以是logical volumes, image files, hard drives , hard drive partitions or RAID devices 例如使⽤image file的⽅法,创建⼀个10G⼤⼩的LUN:dd if=/dev/zero of=/storage/lun1.img bs=1024k count=102401.5修改/etc/iet/ietd.conf添加:Target /doc/034859ed551810a6f5248648.html .example:storage.lun1 IncomingUser [username] [password]OutgoingUserLun 0 Path=/storage/lun1.img,Type=fileioAlias LUN1#MaxConnections 61.6 修改/etc/iet/initiators.allow如果只允许特定IP的initiator访问LUN,则如下设置/doc/034859ed551810a6f5248648.html .example:storage.lun1 192.168.0.100如果任意initiator均可以访问,则:ALL ALL1.6 启动/重启动iSCSI target/etc/init.d/iscsitarget start/etc/init.d/iscsitarget restart2.实验题⽬:Hadoop&MapReduce1.安装JDK——在实验中安装为OpenJDK 6 Runtime2.安装openssh-server,命令为:sudo apt-get install openssh-server,并检查ssh server是否已经启动:ps -e | grep ssh,如果只有ssh-agent 那ssh-server还没有启动,需要/etc/init.d/ssh start,如果看到sshd 那说明ssh-server已经启动了。

云计算 实验报告

云计算实验报告《云计算实验报告》云计算是近年来备受关注的一项技术,它的出现改变了传统的计算模式,为用户提供了更加灵活、便捷的计算服务。

为了更好地了解云计算的应用和性能,我们进行了一系列的实验,并撰写了以下实验报告。

实验一:云计算基础概念在这个实验中,我们首先对云计算的基本概念进行了学习和讨论。

我们了解了云计算的定义、特点和优势,以及云计算与传统计算模式的区别。

通过这个实验,我们对云计算有了更深入的理解,为后续实验的进行奠定了基础。

实验二:云计算平台的搭建在这个实验中,我们使用了一些主流的云计算平台,如Amazon Web Services (AWS)、Microsoft Azure和Google Cloud Platform等,搭建了一个简单的云计算环境。

我们学习了如何创建虚拟机、存储数据、部署应用程序等基本操作,并对不同平台的性能和易用性进行了比较。

实验三:云计算性能测试为了评估云计算平台的性能,我们进行了一系列的性能测试。

我们测试了虚拟机的启动时间、数据传输速度、并发处理能力等指标,以及不同配置下的性能差异。

通过这些测试,我们得出了一些关于云计算性能的结论,为用户选择合适的云计算平台提供了参考。

实验四:云计算在实际应用中的表现最后,我们选择了一些实际的应用场景,如大数据分析、人工智能模型训练等,对云计算平台进行了应用测试。

我们评估了不同平台在处理大规模数据和复杂计算任务时的表现,以及其对应用性能的影响。

通过这些测试,我们得出了一些关于云计算在实际应用中的优劣势,并为用户提供了选择合适云计算平台的建议。

通过以上一系列的实验,我们对云计算有了更加深入的了解,并为用户提供了一些关于云计算平台选择和性能评估的参考。

我们相信,随着云计算技术的不断发展,它将会在各个领域发挥越来越重要的作用。

Hadoop云计算综合实训报告

Hadoop安装部署实训报告项目:《hadoop安装部署实训》班级: XXXX 姓名:XXX指导教师: XXX 时间: XXXX年 X 月 X日一. 实训目的实现Hadoop的安装和配置二. 实训中所用设备及材料PC机Vmware15虚拟机Centos6.8镜像jdk-8u111-linux-x64.tarhadoop-2.6.5.targlibc-2.17.tar三. 实训内容(操作方案、实施方法)1、修改主机名Vi /etc/sysconfig/network2、修改ip地址Vi /etc/sysconfig/network-scripts/ifcfg-eth0Service network restart3、关闭防火墙service iptables stop chkconfig iptables off4、添加主机记录Vi /etc/hosts172.16.101.85 Lhw5、关闭selinuxVi /etc/selinux/config 6、上传jdk文件7、解压jdk文件8、查看9、修改环境变量Vi /etc/profile10、重新加载验证jdk11、上传hadoop安装包新建文件夹Mkdir /bigdata解压Hadoop安装包Tar -zxvf hadoop-2.6.5.tar.gz -C/bigdata/配置Hadoop,修改其中5的配置文件进入到/bigdata/hadoop-2.6.5/etc/hadoop1、Vi hadoop-env.sh更改后配置Java环境变量,环境变量路径为jdk安装路径2、在这当中插入文档Vi core-site.xml中间插入:<configuration><property><name>fs.defaultFS</name><value>hdfs://lihongwei:9000</value></property><property><name>hadoop.tmp.dir</name><value>/bigdata/tmp</value></property></configuration>3、修改第三个配置文件Vi hdfs-site.xml中间插入:<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>:4、修改第四个配置文件复制一份模板mapred-site.xml.template(模板文件)Cp -a mapred-site.xml.template ./mapred-site.xmlVi mapred-site.xml<configuration><property><name></name><value>yarn</value></property></configuration>5、修改第五个配置文件Vi yarn-site.xml<configuration><property><name>yarn.resourcemanager.hostname</name><value>lihongwei</value></property><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property></configuration>对HDFS进行初始化(格式化HDFS)Cd /bigdata/hadoop-2.6.5/bin//hdfs namenode -format安装出现下面提示则安装成功20/02/03 01:30:34 INFO common.Storage: Storage directory /bigdata/tmp/dfs/name has been successfully formatted.使用命令验证是否安装成功运行jps命令,显示进程号安装GCCYum install gcc* -yyum install openssh-clients上传安装包解压到当前root目录tar -zxvf glibc-2.17.tar.gzcd glibc-2.17新建文件夹并进入文件夹mkdir build; cd build进行编译../configure --prefix=/usr --disable-profile --enable-add-ons --with-headers=/usr/include --with-binutils=/usr/binmake install验证:strings /lib64/libc.so.6 | grep GLIBC出现下图表示成功启动hadoop相关服务cd /bigdata/hadoop-2.6.5/sbin./start-all.sh./start-dfs.sh通过管理网面确认服务hdfs服务启动是否成功:http://172.16.101.94:50070/注:IP地址为虚拟机地址,服务端口号为:50070启动yarn服务:./start-yarn.sh通过管理网面确认服务yarn服务启动是否成功:http://172.16.101.94:8088/注:IP地址为虚拟机地址,服务端口号为:8088四.实训中的现象及结果分析(理论的应用、方法的选择及发生的问题)使用jps命令但有些进程不存在解决方案引用https:///nszkadrgg/article/details/79809669中安装ssh客户端yum install openssh-clients。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

云计算实验报告Hadoop云计算实验报告Hadoop实验目的1在虚拟机上安装单机模式和集群;Ubuntu Hadoop编写一个用处理数据的程序,在单机和集群上运行程序。

Hadoop实验环境2虚拟机:9VMware(桌面(服务器版),操作系统:-desktop--server-x64amd64ubuntu-14.10ubuntu-12.04 版)版本: 1.2.1hadoop Hadoop版本:x647u80-linuxJdk -jdk-版本:x86_64-gtk-jee-luna-SR2-linuxEclipse eclipse-,主机集群:一台主机,一台mastersalve datanodeHadoop namenode。

,主机为主机为master IP IP 10.5.110.22310.5.110.207slave实验设计说明3主要设计思路 3.1 eclipse编写程序代码。

实现在ubuntu操作系统下,安装必要软件和环境搭建,使用大数据的统计。

本次实验是统计软件代理系统操作人员处理的信息量,即每个操作人员出现的次数。

程序设计完成后,在集成环境下运行该程序并查看结果。

算法设计 3.2程序将输入读入后该算法首先将输入文件都包含进来,然后交由map程序处理,map处理,切出其中的用户名,并标记它的数目为1,形成<word,1>的形式,然后交由reduce值收集起来,形成<word,list of1>的形式,(reduce将相同key值也就是word)的value1值加起来,即为用户名出现的个数,最后将这个<key,value>对以之后再将这些中。

的形式输出到HDFSTextOutputFormat程序说明 3.34个泛型类类继承了1)UserNameCountMap org.apache.hadoop.mapreduce.Mapper,的类型,输出的类型,输入value的类型,输出key函数输入型分别是map key value的类型。

个泛,4org.apache.hadoop.mapreduce.ReducerUserNameCountReduce2)类继承了类相同。

map型类型含义与将生setOutputPath将数据文件引入该类,在通过addInputPath函数通过main3)成结果转为一个文件,实现生成结果,即统计结果的查看。

newFileInputFormat.addInputPath(job, Path(args[0]));Path(args[1]));new FileOutputFormat.setOutputPath(job,.程序具体代码如附件中源程序。

实验过程4安装实验环境 4.1操作系统安装4.1.1 ubuntu打开在中单击“”,MachineVirtual a VMware, New Home tab Create1)选择,选择虚拟硬件版本,选择文件,,Workstation9.0next2) customios录入目标操作系统信息包括、和,,Password name Uer name3) next, Full选择默认的选项,一般不做更改,最后确认信息,,Finish4)安装成功后,会看到如下画面,5)安装配置Samba 4.1.2安装主要为了实现与操作系统的通讯,由于版本的没ubuntuserver samba windows有自带图形操作界面,所以下载资料等操作不太方便,这也是安装的目的之一。

samba)安装,输入如下命令:1samba)安装2 vim)创建共享目录,并修改权限3)配置。

修改的配置文件,将,4 security=share samba samba/etc/samba/smb.conf并在文件的末尾追加如下内容,)测试。

在实机中,通过访问虚拟机,可以见到文件夹5 shareubuntu windows ip安装配置JDK 4.1.3首先,下载开发工具包。

在本次试验中,我们下载的版本是jdk-7u80-java JDK linux- 。

解压安装到目录下,更名为。

sun7-/usr/lib/jvm/java x64.gz-配置环境变量,/etc/environment使配置生效测试安装配置结果在单节点(伪分布式)环境下运行HADOOP 4.1.4添加用户并赋予权限1) Hadoopsudo安装配置SSH 2)切换至用户,hadoop配置密钥,使得用户能够无须输入密码,通过访问,localhostSSHhadoop测试结果:安装配置Hadoop 3)首先下载解压缩到目录下本次试验中我们下载的版本是, Hadoop,/opt/hadoop。

,更改目录名称为hadoop-1.2.1-bin.tar.gzhadoop,分别是相关的配置文件(在目录下)修改与-site.xml, hadoop core/opt/hadoop/conf。

在此不一一列举。

mapred-site.xmlenv.sh,hadoop- hdsf-site.xml,运行Hadoop 4),首先格式化HDFS启动单节点集群,查看,通过jpsmasterslave停止单节点集群,在多节点(分布式)环境下运行HADOOP 4.1.5设置文件/etc/hosts1)实验中两台机器处于同一局域网中,其中一台作为,地址为,10.5.110.223master ip 一台作为,地址为,修改两台机器的文件,/etc/hosts 10.5.110.207 slave ip设置节点之间无密码登陆SSH2)验证配置是否正确SSH修改集群配置文件3)修改的、,修改所有节点的core-site.xml,hdsf-site.xml,master mastersmapredslaves-,在此不一一列出。

site.xml在上格式化HDFS master4)启动和停止集群5)启动集群,在上启动后,结果如下:jps master HDFSmasterslave在上启动后,结果如下:jps mapreduce master masterslave停止集群运行程序 4.2在单机上运行程序 4.2.1()在下,新建工程map/reduce 1 Eclipse新建一个类,编写代码()UserNameCountjava 2运行程序,结果如下:)(3.()在中编译好源代码后,导出程序的包,供在集群上使用。

jar 4 eclipse在集群上运行程序 4.2.2上启动的服务列表,结果如)(命令查看启动集群,通过,jps 1slavemaster下:()在集群环境下运行该程序包(),结果如下:2UserNameCount.jar jar查看集群环境下启动程序生成的结果,即)(文件,结果如下:output 3()数据统计结果在中,具体内容如下,00000 part -r4-附件5源代码如下:package hadoop;import java.io.IOException;import java.util.StringTokenizer;import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.LongWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.Mapper;import org.apache.hadoop.mapreduce.Reducer;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import org.apache.hadoop.mapreduce.lib.input.TextInputFormat; import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import org.apache.hadoop.mapreduce.lib.output.TextOutputFormat;public class UserNameCount{public static class UserNameCountMap extendsMapper<LongWritable,Text,Text,IntWritable>{private final IntWritable one=new IntWritable(1);Text();new=word Text privatepublic void map(LongWritable key,Text value,Context context) throws IOException,InterruptedException{String line=value.toString();StringTokenizer token=new StringTokenizer(line);while(token.hasMoreTokens()){word.set(token.nextToken());context.write(word,one);}}}public static class UserNameCountReduce extends Reducer<Text,IntWritable,Text,IntWritable>{public void reduce(Text key,Iterable<IntWritable>values, Context context)throws IOException,InterruptedException{ int sum=0;for(IntWritable val:values){sum+=val.get();}context.write(key,new IntWritable(sum));}}public static void main(String[]args)throws Exception{ Configuration conf=new Configuration();Job job=new Job(conf);job.setJarByClass(UserNameCount.class);job.setJobName(%usernamecount);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);job.setMapperClass(UserNameCountMap.class);job.setReducerClass(UserNameCountReduce.class);job.setInputFormatClass(TextInputFormat.class);job.setOutputFormatClass(TextOutputFormat.class);FileInputFormat.addInputPath(job,new Path(args[0])); FileOutputFormat.setOutputPath(job,new Path(args[1]));job.waitForCompletion(true);}}。