表碎片起因及解决办法

如何处理MySQL数据库的表碎片问题

如何处理MySQL数据库的表碎片问题为了保持MySQL数据库的高性能和稳定运行,处理表碎片问题是至关重要的。

表碎片是指表中数据不连续存储的现象,导致数据库的性能下降、查询效率下降、磁盘空间浪费等问题。

本文将介绍如何处理MySQL数据库的表碎片问题,并提供一些有效的解决方案。

一、理解表碎片问题的原因在了解如何处理表碎片问题之前,我们先来了解一下表碎片问题的原因。

MySQL数据库中的表是由若干个数据页组成的,当表中的数据发生频繁的更新、插入、删除操作时,可能会导致数据页的碎片化。

这是因为MySQL会为新数据分配新的数据页,而删除和更新操作会留下空白的数据页。

随着操作的不断进行,这些碎片化的数据页会逐渐积累,导致表的碎片化问题。

二、常见的表碎片处理方法1. 重新组织表重新组织表是指对表进行优化,并重新整理表的数据页,以减少碎片的数量。

通过执行"optimize table"命令或使用MySQL提供的工具如phpMyAdmin来实现。

2. 分区表分区表是指将表分成若干个较小的子表,每个子表存储一定范围的数据。

通过将数据分散到不同的子表中,可以减少每个表的数据量,降低碎片化的可能性。

分区表需要根据具体的需求和数据特点进行设计和实现,可以提高数据库的性能和管理效率。

3. 定期重建表定期重建表是指定期将表中的数据导出为备份文件,然后删除原表,重新创建新表,并将备份文件导入新表中。

这样可以消除表中的碎片,同时还可以对表的结构进行优化。

4. 使用碎片整理工具MySQL提供了一些碎片整理工具,如mysqldump和mysqlcheck等,可以通过这些工具来检查和优化数据库表。

它们可以对表进行检查,发现碎片化的问题,并自动优化表。

三、使用策略处理表碎片问题除了上述常见的处理方法,还可以根据具体的情况制定一些有效的策略来处理表碎片问题。

以下是一些常用的策略:1. 定期进行维护定期进行维护是保持数据库性能稳定的重要手段。

oracle表碎片详解

oracle表碎片详解Oracle表碎片是指表中的数据在物理存储上出现不连续的情况,这可能会影响数据库性能和管理。

表碎片化可能发生在多种情况下,比如频繁的数据插入、更新和删除操作,或者由于表的存储空间不足而发生的数据移动等。

下面我将从多个角度对Oracle表碎片进行详细解释。

1. 形成原因,表碎片化可能由于多种原因导致。

比如,当表中的数据频繁插入、更新和删除时,会导致数据在磁盘上不连续存储,从而产生碎片。

此外,如果表的存储空间不足,Oracle数据库可能会将表的数据分散存储在不同的区域,也会导致表碎片化。

2. 影响,表碎片化可能会对数据库性能和管理造成影响。

首先,碎片化的表可能导致查询性能下降,因为数据库需要在不连续的存储空间中查找数据。

其次,碎片化还可能增加数据库的存储空间占用,因为碎片化的表需要更多的存储空间来存储数据。

3. 解决方法,针对Oracle表碎片化问题,可以采取一些解决方法来优化表的存储结构。

比如,可以使用Oracle提供的表重组(Table Reorganization)功能来重新组织表的存储结构,从而减少碎片化。

此外,还可以定期进行表空间的整理和重建,以优化表的存储结构,减少碎片化的发生。

4. 管理工具,Oracle数据库提供了一些管理工具来帮助识别和解决表碎片化问题。

比如,可以使用Oracle Enterprise Manager来监控表的碎片化情况,并采取相应的措施来优化表的存储结构。

此外,还可以使用Oracle提供的存储管理工具来管理表空间,以减少表碎片化的发生。

总的来说,Oracle表碎片化是指表中的数据在物理存储上出现不连续的情况,可能由于多种原因导致,并可能对数据库性能和管理造成影响。

针对表碎片化问题,可以采取一些解决方法来优化表的存储结构,并可以使用Oracle提供的管理工具来帮助识别和解决表碎片化问题。

希望以上回答能够全面解释Oracle表碎片化问题。

oracle需要碎片整理的表

一、背景介绍Oracle数据库作为业界著名的关系型数据库管理系统,在处理大型数据和复杂查询时表现出色。

然而,随着数据库使用时间的增长,数据库内产生的碎片也越来越多,这些碎片将严重影响数据库的性能和查询速度。

对于存在碎片的数据库表,需要进行碎片整理以提高数据库的性能和效率。

二、碎片整理的定义数据库中的碎片是指由于删除、更新等操作而导致数据在磁盘上不连续存储的现象。

碎片整理即是对数据库中的碎片进行清理和重组,使数据在磁盘上存储更加连续,以提高数据库的性能和效率。

三、为何需要碎片整理1. 提高查询速度:碎片整理可以减少数据在磁盘上的碎片化,使得数据库的数据存储更加紧凑,从而提高查询的速度。

2. 节省存储空间:碎片整理可以释放由于碎片化造成的存储空间,减少对磁盘空间的占用。

3. 降低数据库的维护成本:经常进行碎片整理可以减少数据库的维护成本,提高数据库的稳定性和可靠性。

四、如何进行碎片整理1. 使用Oracle自带工具:Oracle提供了一些自带的工具来进行碎片整理,例如DBMS_REDEFINITION包、GATHER_DICTIONARY_STATS过程等。

2. 使用第三方工具:市面上也有一些第三方的数据库碎片整理工具,可以根据具体需求选择适合的工具进行碎片整理操作。

3. 手动整理:在一些特殊情况下,可以选择手动进行碎片整理。

需要建立临时表将数据重新整理后再将数据导入新表来进行碎片整理。

五、碎片整理的注意事项1. 在进行碎片整理前,建议先备份数据库,以防操作出现问题造成数据丢失。

2. 碎片整理操作可能会对数据库的性能产生影响,建议在业务低峰期进行操作,以减少对业务的影响。

3. 在进行碎片整理之前,需要进行全面的评估和规划,确保整理操作的顺利进行。

六、碎片整理的效果评估1. 碎片整理后,需要对数据库进行性能的评估,包括查询速度、存储空间占用等方面进行评估。

2. 如果整理效果不理想,需要及时调整整理策略,并重新进行评估,直到达到预期的整理效果。

MySQL表空间碎片的概念及相关问题解决

MySQL表空间碎⽚的概念及相关问题解决⽬录背景什么是表空间碎⽚?怎么查看表空间碎⽚怎么解决表空间碎⽚问题对于回收空间的问题背景经常使⽤ MySQL 的话,会发现 MySQL 数据⽂件的磁盘空间⼀般会不停的增长,⽽且有时候删了数据或者插⼊⼀批数据的时候,磁盘空间有时候还会毫⽆变化。

引发这个其妙现象的就是 MySQL 的表空间碎⽚。

什么是表空间碎⽚?表空间碎⽚指的是表空间中存在碎⽚,形象⼀点来⽐喻的话,就像是⼀张 A4 纸,“表空间碎⽚”就像是把这张 A4 纸撕碎,再重新拼起来,各个碎⽚之间都会有⼀些缝隙存在,这些缝隙就是“表空间碎⽚”。

重新拼起来的碎⽚实际上会⽐完整的 A4 纸⼤上⼀圈,这也代表着表空间容易引发的问题:空间浪费。

对于背景中描述的现象,可以⽤⼀张图来进⾏解释:图中的数字代表真实的数据⾏,圆⾓矩形代表⼀个表的表空间。

从左往右,第⼀次操作是删除数据,由于 MySQL 在设计上是不会主动释放空间的,因此当表中的数据⾏被删除时,虽然数据被“删除”了,但是实际上这部分空间是没有释放的,依旧会被Table A 占⽤,因此也就出现了这样⼦的情景:删除了⽇志表的很多数据,但是 MySQL 的磁盘空间并没有降低。

PS:这种不释放空间的设计多半和惰性删除有关,早期设计数据库时,使⽤的 IO 设备⼀般是机械盘,读写性能⽐ SSD 差很多,所以删除操作⼀般不会直接触发磁盘上的数据删除。

可以看到数据删除之后,原本连续的空间中出现了两个空⽩的区域,这种⼀般就叫做表空间空洞,空洞太多了就叫做表空间碎⽚化(对应的是表空间连续)。

这部分的空间虽然不会释放,但是会被标记为可重复利⽤,参考最右边的表空间⽰意图(第三个圆⾓矩形),当新插⼊数据的时候新数据会重新写⼊到表空间空洞中,这也代表着:在⼤规模删除过数据的表上,写⼊数据时,表空间可能不会明显增长或者不会增长。

实际上产⽣表空间空洞的操作并不只有 delete,update 也会引起这个问题,⽐如在 varchar 这种变长的字符型列中修改数据,改短⼀些的时候就会出现⾮常⼩的空洞,改长的话就有可能会因为空间不⾜导致把数据⾏的⼀些数据迁移到其他地⽅去。

SQL Server2005索引碎片分析和解决方法

SQL Server2005索引碎片分析和解决方法毫无疑问,给表添加索引是有好处的,你要做的大部分工作就是维护索引,在数据更改期间索引可能产生碎片,所以一些维护是必要的。

碎片可能是你查询产生性能问题的来源。

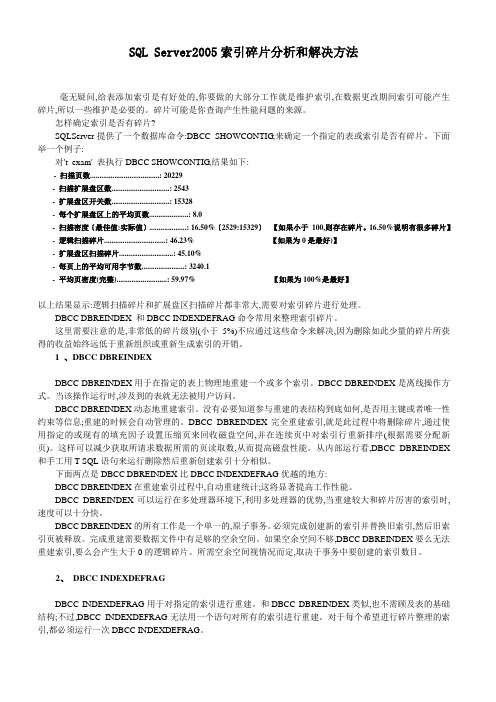

怎样确定索引是否有碎片?SQLServer提供了一个数据库命令:DBCC SHOWCONTIG,来确定一个指定的表或索引是否有碎片。

下面举一个例子:对't_exam' 表执行DBCC SHOWCONTIG,结果如下:- 扫描页数.....................................: 20229- 扫描扩展盘区数...............................: 2543- 扩展盘区开关数...............................: 15328- 每个扩展盘区上的平均页数.....................: 8.0- 扫描密度〔最佳值:实际值〕....................: 16.50%〔2529:15329〕【如果小于100,则存在碎片。

16.50%说明有很多碎片】- 逻辑扫描碎片.................................: 46.23% 【如果为0是最好)】- 扩展盘区扫描碎片.............................: 45.10%- 每页上的平均可用字节数.......................: 3240.1- 平均页密度(完整)...........................: 59.97% 【如果为100%是最好】以上结果显示:逻辑扫描碎片和扩展盘区扫描碎片都非常大,需要对索引碎片进行处理。

DBCC DBREINDEX 和DBCC INDEXDEFRAG命令常用来整理索引碎片。

这里需要注意的是,非常低的碎片级别(小于5%)不应通过这些命令来解决,因为删除如此少量的碎片所获得的收益始终远低于重新组织或重新生成索引的开销。

truncate table 索引碎片 -回复

truncate table 索引碎片-回复索引碎片整理是数据库管理中的一项关键任务。

在数据库中,索引是用于加快数据检索速度的一种数据结构。

当数据在表中进行插入、更新和删除操作时,索引可能会产生碎片。

所谓索引碎片是指索引存储的位置不连续,导致查询效率下降。

为了维持索引的高效性,我们需要定期对索引进行碎片整理。

本文将一步一步回答“truncate table 索引碎片”这个问题。

首先,我们需要了解truncate table语句的含义。

这是一种用于快速删除表中所有数据的命令。

与普通的DELETE语句不同,truncate table会直接删除整个表,而不是一行一行地删除。

接下来,我们需要明确索引的作用和原理。

在数据库中,索引是一种特殊的数据结构,用于加速数据的查找和访问。

索引是根据数据表中的某一列或多列来创建的,它通过构建一个有序列表,将数据存储在特定的数据页或磁盘块上,从而快速定位需要查询的数据。

然而,随着数据在表中的插入、更新和删除操作,索引可能会产生碎片。

这种碎片化会导致索引存储的位置不连续,进而降低查询效率。

具体来说,当数据被删除时,索引会留下空洞;而当数据被插入时,索引会产生分散的片段。

这些碎片化的索引需要进行整理,以维持数据库的高效运行。

索引碎片整理的目的是通过重新组织索引来消除碎片,以提高查询性能。

下面是一些常见的索引碎片整理方法:1. Rebuild:这是一种完全重建索引的方法。

它会删除原始索引,然后根据表中的数据重新创建索引。

这个过程可能需要较长的时间,尤其是对于大型表来说。

但是,通过重新组织数据,重建索引可以有效地消除碎片,提高查询性能。

2. Reorganize:与重建索引相比,重新组织索引是一种更轻量级的方法。

它会重新组织索引的物理结构,但不会删除和重新创建索引。

通过重新组织数据页和磁盘块,重新组织索引可以消除碎片,提升查询性能。

相对于重建索引,重新组织索引的时间更短,适用于频繁更新的表。

解决Excel中数据丢失和损坏的问题

解决Excel中数据丢失和损坏的问题在当今数字化时代,Excel已成为企业和个人管理数据的重要工具。

然而,很多人在使用Excel时常常遇到数据丢失或损坏的问题,这不仅浪费时间和精力,还可能导致信息的不准确性和重要数据的丢失。

本文将为您介绍几种解决Excel中数据丢失和损坏问题的方法。

一、定期备份数据数据备份是防范数据丢失和损坏的必要手段。

请注意,在进行任何Excel操作之前,都应该及时备份数据,并将备份文件存储在安全可靠的地方。

这样,即使出现数据丢失或损坏问题,您也可以随时恢复以前的数据,避免遭受不必要的损失。

二、避免频繁存储和关闭文件频繁的存储和关闭Excel文件可能会导致数据在保存和关闭过程中丢失。

为避免这种情况发生,建议您在对Excel进行编辑和操作时,尽可能减少文件的存储和关闭操作。

只有在确保数据完整无误后再进行存储和关闭,可以大大降低数据丢失和损坏的概率。

三、修复损坏的Excel文件如果您的Excel文件已损坏,可以尝试使用Excel自带的修复功能进行修复。

具体操作如下:1. 打开Excel软件,并点击“文件”选项卡;2. 在下拉菜单中选择“打开”;3. 在打开文件对话框中,找到需要修复的Excel文件并选中;4. 同时按下“Ctrl”和“Shift”键,然后点击“打开”按钮;5. 在弹出的修复对话框中,选择适当的修复方式进行修复。

四、使用第三方的修复工具除了Excel自带的修复功能外,市面上也有许多第三方的Excel修复工具可供选择。

这些工具往往能够更全面地检测和修复Excel文件中的问题。

您可以通过搜索引擎查找并选择适合您需求的工具进行修复。

请注意,在使用第三方修复工具之前,应谨慎选择和确认工具的安全性和可靠性。

最好选择一些知名度高、用户口碑好的工具,以确保数据的安全和有效修复。

五、寻求专业的技术支持如果您在解决数据丢失和损坏问题时遇到了困难,或者无法通过以上方法解决问题,建议您寻求专业的技术支持。

Oracle表碎片整理操作步骤详解

Oracle表碎⽚整理操作步骤详解⾼⽔位线(HWL)下的许多数据块都是⽆数据的,但全表扫描的时候要扫描到⾼⽔位线的数据块,也就是说oracle要做许多的⽆⽤功!因此oracle提供了shrink space碎⽚整理功能。

对于索引,可以采取rebuild online的⽅式进⾏碎⽚整理,⼀般来说,经常进⾏DML操作的对象DBA要定期进⾏维护,同时注意要及时更新统计信息!,使⽤HR⽤户,创建T1表,插⼊约30W的数据,并根据object_id创建普通索引,表占存储空间34M复制代码代码如下:SQL> conn /as sysdba已连接。

SQL> select default_tablespace from dba_users where username='HR';DEFAULT_TABLESPACE------------------------------------------------------------USERSSQL> conn hr/hr已连接。

SQL> insert into t1 select * from t1;已创建 74812 ⾏。

SQL> insert into t1 select * from t1;已创建 149624 ⾏。

SQL> commit;提交完成。

SQL> create index idx_t1_id on t1(object_id);索引已创建。

SQL> exec dbms_stats.gather_table_stats('HR','T1',CASCADE=>TRUE);PL/SQL 过程已成功完成。

SQL> select count(1) from t1;COUNT(1)----------299248SQL> select sum(bytes)/1024/1024 from dba_segments where segment_name='T1';SUM(BYTES)/1024/1024--------------------34.0625SQL> select sum(bytes)/1024/1024 from dba_segments where segment_name='IDX_T1_ID';SUM(BYTES)/1024/1024--------------------6,这个值应当越低越好,表使⽤率越接近⾼⽔位线,全表扫描所做的⽆⽤功也就越少!DBMS_STATS包⽆法获取EMPTY_BLOCKS统计信息,所以需要⽤analyze命令再收集⼀次统计信息复制代码代码如下:SQL> SELECT blocks, empty_blocks, num_rows FROM user_tables WHERE table_name ='T1';BLOCKS EMPTY_BLOCKS NUM_ROWS---------- ------------ ----------4302 0 299248SQL> analyze table t1 compute statistics;表已分析。

SQLServer索引碎片和解决方法

SQLServer索引碎片和解决方法毫无疑问,给表添加索引是有好处的,你要做的大部分工作就是维护索引,在数据更改期间索引可能产生碎片,所以一些维护是必要的。

碎片可能是你查询产生性能问题的来源。

那么到底什么是索引碎片呢?索引碎片实际上有2种形式:外部碎片和内部碎片。

不管哪种碎片基本上都会影响索引内页的使用。

这也许是因为页的逻辑顺序错误(即外部碎片)或每页存储的数据量少于数据页的容量(内部错误)。

无论索引产生了哪种类型的碎片,你都会因为它而面临查询的性能问题。

外部碎片当索引页不在逻辑顺序上时就会产生外部碎片。

索引创建时,索引键按照逻辑顺序放在一组索引页上。

当新数据插入索引时,新的键可能放在存在的键之间。

为了让新的键按照正确的顺序插入,可能会创建新的索引页来存储需要移动的那些存在的键。

这些新的索引页通常物理上不会和那些被移动的键原来所在的页相邻。

创建新页的过程会引起索引页偏离逻辑顺序。

下面的例子将比实际的言论更加清晰的解释这个概念。

假定在任何另外的数据插入你的表之前存在索引上的结构如下(注:下面图片里应该是7和8,原文里是6和8):INSERT语句往索引里添加新的数据,假定添加的是5。

INSERT将引起新页创建,为了给5在原来的页上留出空间,7和8被移到了新页上。

这个创建将引起索引页偏离逻辑顺序。

在有特定搜索或者返回无序结果集的查询的情况下,偏离顺序的索引页不会引起问题。

对于返回有序结果集的查询,搜索那些无序的索引页需要进行额外的处理。

有序结果集的例子如查询返回4到10之间的记录。

为了返回7和8,查询不得不进行额外的页切换。

虽然一个额外的页切换在一个长时间运行里是无关紧要的,然而想象一下一个有好几百页偏离顺序的非常大的表的情形。

内部碎片当索引页没有用到最大量时就产生了内部碎片。

虽然在一个有频繁数据插入的应用程序里这也许有帮助,然而设置一个fill factor(填充因子)会在索引页上留下空间,服务器内部碎片会导致索引尺寸增加,从而在返回需要的数据时要执行额外的读操作。

oracle表碎片详解

oracle表碎片详解Oracle数据库是一种关系型数据库管理系统,用于存储和管理大量数据。

在Oracle中,表碎片是指表的数据和索引在物理存储上被分散到不同的数据块或数据文件中。

本文将详细介绍Oracle表碎片的概念、原因、影响以及解决方法。

一、概念表碎片是指表的数据和索引在物理存储上被分散到不同的数据块或数据文件中。

这种分散导致了数据的存储不连续,影响了查询和维护的性能。

二、原因1. 数据插入、更新和删除操作导致表的数据和索引发生变化,使得数据不连续。

2. 数据迁移或表空间重组操作可能导致表碎片。

3. 数据库备份和恢复操作也可能导致表碎片的产生。

三、影响表碎片会影响数据库的性能和存储空间利用率,具体表现为:1. 查询性能下降:由于数据分散在不同的数据块或数据文件中,查询时需要跨越多个数据块或数据文件,增加了IO操作的次数,导致查询性能下降。

2. 空间浪费:表碎片导致数据存储不连续,使得表的存储空间利用率降低,造成空间浪费。

3. 维护困难:表碎片会增加数据库的维护工作量,包括碎片整理、空间释放等操作。

四、解决方法为了解决表碎片问题,可以采取以下方法:1. 碎片整理:通过执行碎片整理操作,将表的数据和索引重新组织,使其连续存储,提高查询性能。

2. 表空间重组:对于存在大量碎片的表空间,可以进行表空间重组操作,重新分配数据块,减少碎片。

3. 定期维护:定期进行数据库维护工作,包括碎片整理、空间释放等操作,保持数据库的良好状态。

4. 合理设计:在数据库设计阶段,可以考虑合理的数据分区策略,减少表碎片的产生。

总结:表碎片是Oracle数据库中常见的问题,会对数据库的性能和存储空间利用率产生影响。

通过合理的数据库维护和设计,可以有效地解决表碎片问题,提高数据库的性能和可用性。

为了保持数据库的健康状态,管理员应该定期进行碎片整理和维护工作,以提高数据库的性能和可靠性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

表碎片起因及解决办法跟表碎片有关的基础知识:什么是水线(High Water Mark)?----------------------------所有的oracle段(segments,在此,为了理解方便,建议把segment作为表的一个同义词) 都有一个在段内容纳数据的上限,我们把这个上限称为"high water mark"或HWM。

这个HWM是一个标记,用来说明已经有多少没有使用的数据块分配给这个segment。

HWM通常增长的幅度为一次5个数据块,原则上HWM只会增大,不会缩小,即使将表中的数据全部删除,HWM还是为原值,由于这个特点,使HWM很象一个水库的历史最高水位,这也就是HWM的原始含义,当然不能说一个水库没水了,就说该水库的历史最高水位为0。

但是如果我们在表上使用了truncate命令,则该表的HWM会被重新置为0。

HWM数据库的操作有如下影响:a) 全表扫描通常要读出直到HWM标记的所有的属于该表数据库块,即使该表中没有任何数据。

b) 即使HWM以下有空闲的数据库块,键入在插入数据时使用了append关键字,则在插入时使用HWM以上的数据块,此时HWM会自动增大。

如何知道一个表的HWM?a) 首先对表进行分析:ANALYZE TABLE <tablename> ESTIMATE/COMPUTE STATISTICS;b) SELECT blocks, empty_blocks, num_rowsFROM user_tablesWHERE table_name = <tablename>;BLOCKS 列代表该表中曾经使用过得数据库块的数目,即水线。

EMPTY_BLOCKS 代表分配给该表,但是在水线以上的数据库块,即从来没有使用的数据块。

让我们以一个有28672行的BIG_EMP1表为例进行说明:1) SQL> SELECT segment_name,segment_type,blocksFROM dba_segmentsWHERE segment_name='BIG_EMP1';SEGMENT_NAME SEGMENT_TYPE BLOCKS EXTENTS----------------------------- ----------------- ---------- ------- BIG_EMP1 TABLE 1024 21 row selected.2) SQL> ANALYZE TABLE big_emp1 ESTIMATE STATISTICS;Statement processed.3) SQL> SELECT table_name,num_rows,blocks,empty_blocksFROM user_tablesWHERE table_name='BIG_EMP1';TABLE_NAME NUM_ROWS BLOCKS EMPTY_BLOCKS------------------------------ ---------- ---------- ------------ BIG_EMP1 28672 700 3231 row selected.注意:BLOCKS + EMPTY_BLOCKS (700+323=1023)比DBA_SEGMENTS.BLOCKS少个数据库块,这是因为有一个数据库块被保留用作segment header。

DBA_SEGMENTS.BLOCKS 表示分配给这个表的所有的数据库块的数目。

USER_TABLES.BLOCKS表示已经使用过的数据库块的数目。

4) SQL> SELECT COUNT (DISTINCTDBMS_ROWID.ROWID_BLOCK_NUMBER(rowid)||DBMS_ROWID.ROWID_RELATIVE_FNO(rowid)) "Used"FROM big_emp1;Used----------7001 row selected.5) SQL> DELETE from big_emp1;28672 rows processed.6) SQL> commit;Statement processed.7) SQL> ANALYZE TABLE big_emp1 ESTIMATE STATISTICS;Statement processed.8) SQL> SELECT table_name,num_rows,blocks,empty_blocksFROM user_tablesWHERE table_name='BIG_EMP1';TABLE_NAME NUM_ROWS BLOCKS EMPTY_BLOCKS------------------------------ ---------- ---------- ------------ BIG_EMP1 0 700 3231 row selected.9) SQL> SELECT COUNT (DISTINCTDBMS_ROWID.ROWID_BLOCK_NUMBER(rowid)||DBMS_ROWID.ROWID_RELATIVE_FNO(rowid)) "Used"FROM big_emp1;Used----------0 -- 这表名没有任何数据库块容纳数据,即表中无数据1 row selected.10) SQL> TRUNCATE TABLE big_emp1;Statement processed.11) SQL> ANALYZE TABLE big_emp1 ESTIMATE STATISTICS;Statement processed.12) SQL> SELECT table_name,num_rows,blocks,empty_blocks2> FROM user_tables3> WHERE table_name='BIG_EMP1';TABLE_NAME NUM_ROWS BLOCKS EMPTY_BLOCKS------------------------------ ---------- ---------- ------------ BIG_EMP1 0 0 5111 row selected.13) SQL> SELECT segment_name,segment_type,blocksFROM dba_segmentsWHERE segment_name='BIG_EMP1';SEGMENT_NAME SEGMENT_TYPE BLOCKS EXTENTS----------------------------- ----------------- ---------- ------- BIG_EMP1 TABLE 512 11 row selected.注意:TRUNCATE命令回收了由delete命令产生的空闲空间,注意该表分配的空间由原先的1024块降为512块。

为了保留由delete命令产生的空闲空间,可以使用TRUNCATE TABLE big_emp1 REUSE STORAGE用此命令后,该表还会是原先的1024块。

行链接(Row chaining) 与行迁移(Row Migration)当一行的数据过长而不能插入一个单个数据块中时,可能发生两种事情:行链接(row chaining)或行迁移(row migration)。

行链接当第一次插入行时,由于行太长而不能容纳在一个数据块中时,就会发生行链接。

在这种情况下,oracle会使用与该块链接的一块或多块数据块来容纳该行的数据。

行连接经常在插入比较大的行时才会发生,如包含long, long row, lob等类型的数据。

在这些情况下行链接是不可避免的。

行迁移当修改不是行链接的行时,当修改后的行长度大于修改前的行长度,并且该数据块中的空闲空间已经比较小而不能完全容纳该行的数据时,就会发生行迁移。

在这种情况下,Oracle会将整行的数据迁移到一个新的数据块上,而将该行原先的空间只放一个指针,指向该行的新的位置,并且该行原先空间的剩余空间不再被数据库使用,这些剩余的空间我们将其称之为空洞,这就是产生表碎片的主要原因,表碎片基本上也是不可避免的,但是我们可以将其降到一个我们可以接受的程度。

注意,即使发生了行迁移,发生了行迁移的行的rowid 还是不会变化,这也是行迁移会引起数据库I/O性能降低的原因。

其实行迁移是行链接的一种特殊形式,但是它的起因与行为跟行链接有很大不同,所以一般把它从行链接中独立出来,单独进行处理。

行链接和行迁移引起数据库性能下降的原因:引起性能下降的原因主要是由于引起多余的I/O造成的。

当通过索引访问已有行迁移现象的行时,数据库必须扫描一个以上的数据块才能检索到改行的数据。

这主要有一下两种表现形式:1) 导致row migration 或row chaining INSERT 或 UPDATE语句的性能比较差,因为它们需要执行额外的处理2) 利用索引查询已经链接或迁移的行的select语句性能比较差,因为它们要执行额外的I/O如何才能检测到行迁移与行链接:在表中被迁移或被链接的行可以通过带list chained rows选项的analyze语句识别出来。

这个命令收集每个被迁移或链接的行的信息,并将这些信息放到指定的输出表中。

为了创建这个输出表,运行脚本UTLCHAIN.SQL。

SQL> ANALYZE TABLE scott.emp LIST CHAINED ROWS;SQL> SELECT * FROM chained_rows;当然你也可以通过检查v$sysstat视图中的'table fetch continued row'来检查被迁移或被链接的行。

SQL> SELECT name, value FROM v$sysstat WHERE name = 'table fetch continued row';NAME VALUE-------------------------------------------------------------------------table fetch continued row 308尽管行迁移与行链接是两个不同的事情,但是在oracle内部,它们被当作一回事。