存储分盘,SAN交换机划zone,AIX创建文件系统V2

AIX系统磁盘详解

AIX系统磁盘详解此文档对磁盘分区、分区逻辑的理解,及监控结果分析有帮助。

1、日常查看AIX操作系统各目录下磁盘大小,用df –g命令,如下。

2、也可以使用lsvg –l rootvg查看,如下:LV name,使用命令lslv –l +lv name查看hd1是属于哪些磁盘。

如下:可以看到/home的磁盘读写用到的磁盘是hdisk0,即PV。

有的目录可能占用两块磁盘的分区。

4、下面这些值的含义会帮助大家理解上面这些内容Pv:一个物理盘就是一个PV。

Vg:pv的集合(一个或者多个磁盘组成一个vg,如rootvg、datavg)。

Pp:将pv划分成连续的大小相同的单元。

Lp:由1~3个pp组成的集合Lv:由一个或者多个lp组成的集合,同时lv中的lp是连续的,但对应的pp可能不连续,可能分布在不同的pv上。

在vg上划分lv,lv挂载在目录后,操作目录就是操作lv。

如下图展示:比如1)有三块磁盘pv1(hdisk0)、pv2(hdisk1)、pv3(hdisk2);2)比如vg包含了(pv1、pv2、pv3),也可以是单个磁盘,也可以其中两个;3)比如pv1(hdisk0)分成(pp1、pp2、pp3、pp4四个单元);比如pv2(hdisk1)分成(ppa、ppb、ppc、ppd四个单元);比如pv3(hdisk2)分成(pp01、pp02、pp03、pp04四个单元);4)现在我们组合几个lp:pp1、pp2为lp1;ppc、ppd为lp2;选取lp1和lp2为一个lv并且命名为hd1(即我们上面看到的目录挂载文件名,这时候就可以和hdisk1两块磁盘的分区。

DS4000磁盘阵列管理

DS4000存储安装手册安装前根据需要准备以下内容:1、Controller firmware2、ESM & HDD firmware3、Storage Manager4、FAStT HBA BIOS5、FAStT HBA Drivers6、FC 8 - Brocade BootCode/BIOS7、FC 8 - Brocade Drivers8、FC 8/4/2 - Emulex BIOS9、FC 8/4/2 - Emulex Drivers10、FC 8/4/2 - QLogic BIOS11、FC 8/4/2 - QLogic Drivers12、Tools下载链接:/systems/support/>选择“System Storage”>选择“Disk System”>选择相应的存储设备型号>在选项右侧“Support & Downloads”栏中选择“Download”>新的页面中包含以上列出的项目下载列表Notes:DS4000可以被AIX V5.1 ML09版本支持;DS4000可以被HACMP V4.4.1版本支持。

DS4000的管理方式1、Host agent (in-band) management method这种管理方式需要在服务器端安装Storage Manager agent (SMagent) package,即存储管理软件,通过Fibre Channel I/O path连接。

2、Direct (out-of-band) management method这种管理方式需要在Mangement Workstation端安装存储管理软件,并通过IP网络与存储控制器连接。

NOTES:本文档主要在Direct (out-of-band)方式和AIX & Windows环境下做描述,其他OS下的配置请参考IBM相关REDBOOKS。

linux配置SAN存储-IPSAN

linux配置SAN存储-IPSAN简单的介绍⼀下SAN (存储区域⽹络 storage area network and SAN protocols ,简称SAN),它是⼀种⾼速⽹络实现计算机与存储系统之间的数据传输。

常见的分类是FC-SAN和IP-SAN两种。

FC-SAN通过光纤通道协议转发scsi协议;IP-SAN通过TCP协议转发scsi协议,也就是IP 地址。

存储设备是指⼀台或多台⽤以存储计算机数据的磁盘设备,通常指磁盘阵列,主要⼚商EMC、⽇⽴等。

下⾯配置IP-SAN存储实战服务名称服务器地址服务端:node01192.168.137.101客户端:node02192.168.137.102客户端:node03192.168.137.103⼀、服务端安装1.1 IPSAN 是C/S模式服务端⼝3260点击(此处)折叠或打开1. [root@node01 ~]# yum -y install scsi-target-utils #yum 安装[root@node01 ~]# ll /etc/tgt/targets.conf #主要配置⽂件-rw------- 1 root root 6945 Sep 4 2013 /etc/tgt/targets.conf[root@node01 ~]# service tgtd restart #启动服务Stopping SCSI target daemon: not running [FAILED]Starting SCSI target daemon: [ OK ][root@node01 ~]# chkconfig tgtd on[root@node01 ~]# netstat -antup |grep 3260 #检查服务端⼝tcp 0 0 0.0.0.0:3260 0.0.0.0:* LISTEN 1125/tgtdtcp 0 0 :::3260 :::* LISTEN 1125/tgtd[root@node01 ~]#1.2 新建存储分区,在这⾥我们通过在vmvare新增加⼀个块10G⼤⼩的磁盘 /dev/sdb,重启服务器点击(此处)折叠或打开[root@node01 ~]# fdisk -l |grep "Disk"Disk /dev/sda: 21.5 GB, 21474836480 bytesDisk identifier: 0x0004a1ecDisk /dev/sdb: 10.7 GB, 10737418240 bytesDisk identifier: 0x00000000[root@node01 ~]#[root@node01 ~]# fdisk /dev/sdb #分区,⼤⼩5G1.3 共享存储分区,修改/etc/tgt/targets.conf ⽂件点击(此处)折叠或打开1. [root@node01 ~]# vim /etc/tgt/targets.conf # 增加以下内容,以下是iscsi的格式2.3. <target .node01.www:target4_scan> #命名4. backing-store /dev/sdb1 #共享的分区5. initiator-address 192.168.137.102 #允许访问的地址6. initiator-address 192.168.137.1037. vendor_id node #标⽰8. product_id target4 #产品编号9. </target>10. [root@node01 ~]# tgt-admin -show #查看状态Target 1: .node01.www:target4_scanSystem information:Driver: iscsiState: readyI_T nexus information:LUN information:LUN: 0Type: controllerSCSI ID: IET 00010000SCSI SN: beaf10Size: 0 MB, Block size: 1Online: YesRemovable media: NoPrevent removal: NoReadonly: NoBacking store type: nullBacking store path: NoneBacking store flags:LUN: 1Type: diskSCSI ID: IET 00010001SCSI SN: beaf11Size: 5379 MB, Block size: 512Online: YesRemovable media: NoPrevent removal: NoReadonly: NoBacking store type: rdwrBacking store path: /dev/sdb1Backing store flags:Account information:ACL information:192.168.137.102192.168.137.103[root@node01 ~]#⼆、客户端配置2.1 安装iscsi-initiator-utils,并配置服务信息点击(此处)折叠或打开1. [root@node02 ~]# yum -y install iscsi-initiator-utils2. [root@node02 ~]# iscsiadm -m discovery -t sendtargets -p 192.168.137.101 #发现target存储3. Starting iscsid: [ OK ]4. 192.168.137.101:3260,1 .node01.www:target4_scan5. [root@node02 ~]#6. [root@node02 ~]# /etc/init.d/iscsid status #查看客户端服务7. iscsid (pid 1153) is running...8. [root@node02 ~]#9. [root@node02 ~]# tree /var/lib/iscsi/ #发现target服务,信息会写⼊/var/lib/iscsi ⽬录下10. /var/lib/iscsi/11. ├── ifaces12. ├── isns13. ├── nodes14. │└── .node01.www:target4_scan15. │└── 192.168.137.101,3260,116. │└── default17. ├── send_targets18. │└── 192.168.137.101,326019. │├── .node01.www:target4_scan,192.168.137.101,3260,1,default -> /var/lib/iscsi/nodes/iqn.2016-.node01.www:target4_scan/192.168.137.101,3260,120. │└── st_config21. ├── slp22. └── static23.24. 10 directories, 2 files25. [root@node02 ~]#26. [root@node02 ~]# /etc/init.d/iscsid start #先启动iscsid 服务[root@node02 ~]# /etc/init.d/iscsi start #在启动iscsi服务该服务是根据iscsid服务信息/var/lib/iscsi/ 来识别设备的Starting iscsi: [ OK ][root@node02 ~]#2.2 检查是否发现磁盘,以及卸载和登录scsi设备点击(此处)折叠或打开1. [root@node02 ~]# ll /dev/sdb2. brw-rw---- 1 root disk 8, 16 Aug 12 00:48 /dev/sdb3. [root@node02 ~]# lsblk #lsblk查看块信息的命令4. NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTsda 8:0 0 20G 0 disk├─sda1 8:1 0 200M 0 part /boot├─sda2 8:2 0 10G 0 part /└─sda3 8:3 0 1G 0 part [SWAP]sr0 11:0 1 3.6G 0 rom /mediasdb 8:16 0 5G 0 disk5.6. [root@node02 ~]#7. [root@node02 ~]# tree /var/lib/iscsi/8. /var/lib/iscsi/├── ifaces├── isns├── nodes│└── .node01.www:target4_scan│└── 192.168.137.101,3260,1│└── default├── send_targets│└── 192.168.137.101,3260│├── .node01.www:target4_scan,192.168.137.101,3260,1,default -> /var/lib/iscsi/nodes/iqn.2016-.node01.www:target4_scan/192.168.137.101,3260,1│└── st_config├── slp└── static10 directories, 2 files9. [root@node02 ~]# iscsiadm -m node -T .node01.www:target4_scan -u #卸载scsi设备10. Logging out of session [sid: 1, target: .node01.www:target4_scan, portal: 192.168.137.101,3260]11. Logout of [sid: 1, target: .node01.www:target4_scan, portal: 192.168.137.101,3260] successful.12. [root@node02 ~]# lsblk13. NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTsda 8:0 0 20G 0 disk├─sda1 8:1 0 200M 0 part /boot├─sda2 8:2 0 10G 0 part /└─sda3 8:3 0 1G 0 part [SWAP]sr0 11:0 1 3.6G 0 rom /media14. [root@node02 ~]# iscsiadm -m node -T .node01.www:target4_scan -l #登录scsi设备15. Logging in to [iface: default, target: .node01.www:target4_scan, portal: 192.168.137.101,3260] (multiple)16. Login to [iface: default, target: .node01.www:target4_scan, portal: 192.168.137.101,3260] successful.17. [root@node02 ~]# lsblk18. NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTsda 8:0 0 20G 0 disk├─sda1 8:1 0 200M 0 part /boot├─sda2 8:2 0 10G 0 part /└─sda3 8:3 0 1G 0 part [SWAP]sr0 11:0 1 3.6G 0 rom /mediasdb 8:16 0 5G 0 disk19. [root@node02 ~]#2.3 使⽤scsi设备,并做写⼊操作点击(此处)折叠或打开1. [root@node02 ~]# df -h2. Filesystem Size Used Avail Use% Mounted on3. /dev/sda2 9.9G 869M 8.5G 10% /4. tmpfs 238M 0 238M 0% /dev/shm5. /dev/sda1 194M 27M 158M 15% /boot6. /dev/sr0 3.6G 3.6G 0 100% /media7.8. [root@node02 ~]#9. [root@node02 ~]# fdisk /dev/sdb #分区10.11. [root@node02 ~]# lsblk #查看分区块12. NNAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTsda 8:0 0 20G 0 disk├─sda1 8:1 0 200M 0 part /boot├─sda2 8:2 0 10G 0 part /└─sda3 8:3 0 1G 0 part [SWAP]sr0 11:0 1 3.6G 0 rom /mediasdb 8:16 0 5G 0 disk└─sdb1 8:17 0 5G 0 part13.14. [root@node02 ~]# mkfs.ext4 /dev/sdb1 #格式化分区15. mke2fs 1.41.12 (17-May-2010)16. Filesystem label=17. OS type: Linux18. Block size=4096 (log=2)19. Fragment size=4096 (log=2)20. Stride=0 blocks, Stripe width=0 blocks21. 328656 inodes, 1312222 blocks22. 65611 blocks (5.00%) reserved for the super user23. First data block=024. Maximum filesystem blocks=134637158425. 41 block groups26. 32768 blocks per group, 32768 fragments per group27. 8016 inodes per group28. Superblock backups stored on blocks:29. 32768, 98304, 163840, 229376, 294912, 819200, 88473630.31. Writing inode tables: done32. Creating journal (32768 blocks): done33. Writing superblocks and filesystem accounting information: done34.35. This filesystem will be automatically checked every 21 mounts or36. 180 days, whichever comes first. Use tune2fs -c or -i to override.37. [root@node02 ~]# mkdir /scsi #挂载分区到新建⽬录/scsi38. [root@node02 ~]# mount /dev/sdb1 /scsi/39. [root@node02 ~]# df -h40. Filesystem Size Used Avail Use% Mounted on41. /dev/sda2 9.9G 869M 8.5G 10% /42. tmpfs 238M 0 238M 0% /dev/shm43. /dev/sda1 194M 27M 158M 15% /boot44. /dev/sr0 3.6G 3.6G 0 100% /media45. /dev/sdb1 5.0G 139M 4.6G 3% /scsi46. [root@node02 ~]# cp -r /root/* /scsi/ #写⼊验证47. [root@node02 ~]# ll /scsi/48. total 3649. -rw------- 1 root root 980 Aug 12 00:59 anaconda-ks.cfg50. -rw-r--r-- 1 root root 10197 Aug 12 00:59 install.log51. -rw-r--r-- 1 root root 3161 Aug 12 00:59 install.log.syslog52. drwx------ 2 root root 16384 Aug 12 00:58 lost+found53. [root@node02 ~]# df -h /scsi/54. Filesystem Size Used Avail Use% Mounted on55. /dev/sdb1 5.0G 139M 4.6G 3% /scsi56. [root@node02 ~]#三、添加另外客户端192.168.137.103。

AIX 存储、HMC、光纤交换机登入方法及IP地址

AIX 存储、HMC、光纤交换机登入方法及IP地址1.1 如何登入IBM光纤交换机1、拿网线连接光纤交换机IBM B16的网口。

2、将本地电脑地址配置成10.77.77.77同一网段。

3、在IE浏览器输入:http://10.77.77.774、输入用户名/密码:admin/passw0rd 其中0为数字5、登入后即可对光纤交换机进行维护。

1.2 如何登入IBM存储设备(DS4300、DS4700)1、使用XP系统安装 IBM DS4300磁盘阵列管理软件 storage manerger版本SMFWUpgInstaller-WS32-10.10.35.092、DS4300和DS4700两个控制卡:DS4300两个控制器IP为:192.168.128.101 192.168.128.102DS4700每个控制器有两个网口:上角的IP为 192.168.129.101 192.168.128.101右下角的控制卡IP: 192.168.128.102(第一网口)192.168.129.102 (第二网口)3、本地电脑配置成同一网段就可以。

Ping 你连接口的地址,注意:一般需要5分钟以上才能ping通。

4、使用软件管理,第一次使用管理软件需要手工添加控制口的IP地址,如果不是使用交换机连接两个管理口,将出现报错信息,但不影响使用。

可以收集阵列的配置信息,使用了多少物理硬盘、划分的raid技术如何。

当前磁盘阵列的设备状态是否正常。

1.3 如何登入IBM服务器进行管理串口方式登入1、串口方式登入,使用IBM定制的串口线。

2、配置本地电脑的超级终端,还原默认值即可。

波特率可以通过HMC的web方式页面查询得知,一般为192003、登入服务器进行相应操作。

HMC口方式登入IBM服务器有两个管理口:HMC1 HMC21、管理口1地址为:192.168.2.147 管理口2地址为:192.168.3.147一、P550 面板操作查看HMC 网口IP地址:进入控制面板上的功能30, 就能读出HMC端口的IP地址。

AIX添加和删除硬盘分区

在本例中使用了extendvg -f rootvg [pv name] (pv是从hdisk1到hdisk4和hdisk6、hdisk7;pv,即Physical Volumes)来增加rootvg的大小。

也可以增加新的vg 之后将pv加到新vg中,再执行如下操作。

在填参数时,点F4可以显示候选项,F3是取消或者后退,回车是执行。

本例中系统上只有rootvg,新增加的分区为data7,挂载点是/dev/data7。

一、创建LV终端中运行smit,依次执行下列操:在上图的操作中点F4会有候选项,而且只能这样输入在AIX中创建文件系统,建议使用JFS2,以免有创建文件大小的限制上图中Numbers of LOGICAL PARTITIONS的数值单位时“块”,每块的大小就是相应vg 中的PP SIZE大小,可以在终端中运行lsvg rootvg 查看(在此以rootvg为例)创建完成二、创建文件系统终端中运行smit之后依次执行以下操作:建议使用Enhanced Journaled File System (增强型JFS)上图的操作意思就是:在已存在的LV上建立EJFS新建立的JFS2分区,一定要填好日志文件的地址,即上图中选中的选项。

要将Mount AUTOMATICALL Y at system restart 选为yes,这样在重启后会自动挂载分区创建完成创建完成后,在终端中运行mount /dev/data7 /data7 ,用df –g查看,挂载成功。

显示结果如下:删除分区首先在终端中运行umount /data7 卸载data7之后运行smit ,执行如下操作:上图中,选择Remove Mount point ,执行后会将相应的LV一并删除。

运行成功。

浪潮InPath for AIX 存储系统用户手册说明书

浪潮存储系统InPath for AIX用户手册文档版本 2.0发布日期2020-09-28 适用版本InPath_for_AIX_V2.2.1及以上尊敬的用户:衷心感谢您选用浪潮存储系统!浪潮存储秉承“云存智用运筹新数据”的新存储之道,致力于为您提供符合新数据时代需求的存储产品和解决方案。

本手册用于帮助您更详细地了解和便捷地使用存储系统,涉及的截图仅为示例,最终界面请以实际设备显示的界面为准。

由于产品版本升级或其他原因,本手册内容会不定期进行更新,如有变动恕不另行通知。

除非另有约定,本手册仅作为使用指导,本手册中的所有陈述、信息和建议不构成任何明示或暗示的担保。

浪潮拥有本手册的版权,保留随时修改本手册的权利。

未经浪潮许可,任何单位和个人不得以任何形式复制本手册的内容。

如果您对本手册有任何疑问或建议,请向浪潮电子信息产业股份有限公司垂询。

技术服务电话:4008600011地址:中国济南市浪潮路1036号浪潮电子信息产业股份有限公司邮编:250101在您正式使用本存储系统之前,请先阅读以下声明。

只有您阅读并且同意以下声明后,方可正式开始使用本存储系统。

如果您对以下声明有任何疑问,请和您的供货商联系或直接与我们联系。

如您在开始使用本系统前未就以下声明向我们提出疑问,则默认您已经同意了以下声明。

1.请不要自行拆卸本存储系统机箱及机箱内任何硬件设备。

在本存储系统出现任何硬件故障或您希望对硬件进行任何升级时,请您将机器的详细硬件配置反映给我们的客户服务中心。

2.请不要将本存储系统的设备与任何其他型号的相应设备混用。

本存储系统的内存、CPU、CPU散热片、风扇、硬盘托架、硬盘等都是特殊规格的。

3.在使用本存储系统时遇到任何软件问题,请您首先和相应软件的提供商联系。

由提供商和我们联系,以方便我们共同沟通和解决您遇到的问题。

对于数据库、网络管理软件或其他网络产品的安装、运行问题,我们尤其希望您能够这样处理。

4.上架安装本存储系统前,请先仔细阅读相关产品手册中的快速安装指南。

海康威视IP SANNAS监控存储解决方案_模版

海康威视IP SAN/NAS存储解决方案杭州海康威视数字技术有限公司杭分公司二〇〇九年六月目录1.基本需求 (4)1.1DVR/DVS需求 (4)1.2容量计算公式 (4)1.3容量计算 (4)1.4集中式共享存储 (5)1.5数据可靠性 (5)1.6可扩展性 (5)1.7高性能 (5)1.8网络需求 (5)2.解决方案 (6)2.1.方案选择 (6)2.1.1.DVR直接存储 (6)2.1.2.NAS附网存储 (6)2.1.3.IP存储网络 (6)2.2.方案描述 (7)2.2.1.系统原理图 (8)2.3.存储技术参数 (9)2.3.1.存储配置 (9)2.4.方案分析 (12)2.4.1.监控专用存储系统,充分满足性能要求 (12)2.4.2.同时提供IP SAN和NAS (12)2.4.3.极易管理(全中文) (13)2.4.4.独有安全技术 (13)2.4.5.高可扩充性 (13)2.4.6.高性价比 (13)2.4.7.数据存储的高可靠性和可用性 (14)3.DS-A20系列IP SAN/NAS存储产品 (15)4.DS-6X00HC/HF视频服务器 (18)4.1.产品概述 (18)4.2.订货型号 (18)4.3.硬件接口 (18)4.4.技术参数 (19)5.DS-6X00HC/HF-ATA视频服务器 (20)5.1.产品概述 (20)5.2.订货型号 (20)5.3.物理接口 (20)5.4.技术参数 (21)5.5.DS-2DF1-6XY系列网络球机 (22)1. 基本需求某银行需要64路视频监控系统,7*24小时监控,数据保存3个月便可以覆盖。

存储方案采用IP SAN/NAS 集中存储。

采用4CIF 格式,1Mbps 码流。

1.1 DVR/DVS 需求➢ 64路➢ 图象分辨率: 1Mpbs➢ 7*24小时➢ 保存时间:90天1.2 容量计算公式第一步:根据式(1)计算单个通道每小时所需要的存储容量i q , 单位MByte 。

IPSAN操作手册

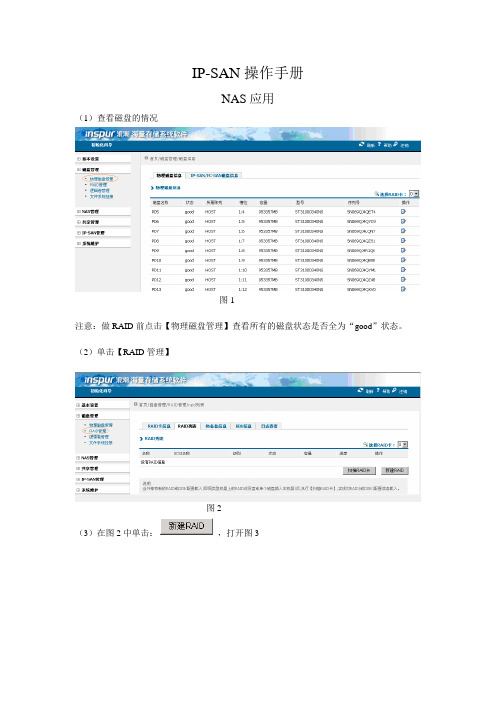

IP-SAN操作手册NAS应用(1)查看磁盘的情况图1---------------------------------------------------------------------------------------------------------------------- 注意:做RAID前点击【物理磁盘管理】查看所有的磁盘状态是否全为“good”状态。

---------------------------------------------------------------------------------------------------------------------- (2)单击【RAID管理】图2(3)在图2中单击:,打开图3图3---------------------------------------------------------------------------------------------------------------------- 注意:点击新建RAID这个按钮后就会出现所有状态为“good”的盘,在这里我们选择四块盘作为演示。

---------------------------------------------------------------------------------------------------------------------(4)选择后四块盘后单击图3下边的创建按钮,成功后出现图4图4-----------------------------------------------------------------------------------------------------------------注意:在做RAID的过程中I/O策略:选择Cached 块大小根据需求选择,一般默认就行写策略选择Bad BBU;读策略,选择Readhead,就行。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

存储划盘、SAN交换机划Zone、AIX

创建文件系统

1、存储划盘

确认事项:

1:确认规划的RAID组中知否还有可用资源

2:确认需要资源的主机是否已经与高端存储的前端口建立组关系

操作流程:

1:从高端存储的RAID组中划出Ldev。

2:将高端存储的前端口与主机的HBA卡的WWN号划进同一个组(主机之前没有用过该存储的资源)。

3:将LUN划进对应的组

1.1新建ldev

具体操作步骤:

远程桌面连接入高端存储

选择Modify Mode模式

选择Install,进入管理界面,并点击Logical Device Fomat Modify模式:可以修改配置

View模式:不能更改,只能查询配置信息

进入逻辑设备格式界面

选择CVS Configuration,进入LDEV管理界面选择LDEV(CVS)…,进入创建LDEV界面CVS Configuration :ldev管理

LUN Configuration: 逻辑单元管理

Volume to Space:用于收回ldev

LDEV(CVS)Installaton:用于创建新的ldev

选择Raid组,用于创

建新的ldev

选择需要创建LDEV的RAID组,点击Detail

选择拆分的组,每个

ldev组最大为3T,

也就是包含ldev总

和为3T

选择LDEV分组,并点击Detail

创建几个ldev,

和每个ldev包

含的Block数量

Ldev的单

位

选择需要创建的LDEV的数量,和Blocks的数量,1M=1*2*1024个Blocks

点击ADD添加,并点击OK

点击OK,并NEXT

为新创建的ldev

增加唯一编号选择创建LDEV的RAID组并点击Detail,编辑LDEV 的ID号

Ldev号包括

LDKC+CU+ID

CU号根据规划选择

ID号从左边图形界

面选择,选择未亮

蓝灯的格子

选择CU号和ID号,点击OK

点击NEXT

是否保存配置信息,可以选择Cancel

正在快速格式化跳出逻辑卷初始化界面,显示为快速初始化,等待结束

初始化完成,此时如图LDEV 00:F4:10已经初始化完成1.2新建主机与存储组

格式化完成,状态为Normal

选择Modify Mode模式

选择Change

Configuration

选择Install,并点击Change Configuration

选择LUN

Configuration

选择LUN Configuration,点击OK

下拉菜单中选择

Group

点击NEW

Display中选择Group,并点击NEW

输入主机HBA卡的

WWN号:可以从List

中选择,也可以Add

输入组名,如图所示:yztest,并点击WWN List选择主机的HBA卡WWN

号,点击NEST

选择高端存储的前

端口,根据规划

选择高端存储的前端口号

选择主机的操

作系统

选择主机的系统

建组完成

1.3将LDEV

Display 中选择LUN,选择要划LDEV 的组,点击ADD

选择ldev,并确认LUN 号,点击SET ,并OK

选择LUN 模式, 用于划LDEV 点击Add

确定CU 号

并选择要划的LDEV 并选择LUN 号,一般按顺序选择

最后点击SET 、OK

LUN划盘完成

2、San交换机创建Zone

确认事项:

1:确认SAN交换机中是否有主机的HBA卡WWN号与将要划出资源的存储前端口绑定的zone

操作流程:

1:在SAN交换机中添加zone

2:在SAN交换机的cfg配置中添加zone信息

3:保存SAN交换机的cfg配置

4:激活SAN交换机的cfg配置

具体操作步骤:

2.1 创建Zone

1.switchshow#列出所有的端口和WWN

2.aliCreate"<alias1>;""WWN1";#把WWN1设-别名alias1,依此设立别名alias2,等等.

3.zoneCreate"<zone1>","alias1;alias2"#把alias1和alias2加入zone1中

4.cfgAdd"<cfg1>","zone1 ";#把zone1和zone2加入配置cfg1中

5.cfgSave#把配置存盘

6.cfgEnable"cfg1";#激活配置

2.2 删除Zone

1.从cfg配置中删除Zone,命令如下

Admin>cfgremove “SR_CFG_A”,”yztest”

2.从Zone组中删除Zone,命令如下

Admin>zonedelete”yztest”

3.保存配置,命令如下

Admin>cfgsave

4.激活配置,命令如下

Admin>cfgenable SR_CFG_A

3、AIX创建文件系统

确认事项:

1:规划VG、LV、文件系统目录信息

2:该版本为指令创建文件系统

操作流程:

1:扫出新增加的hdisk

2:创建PV

3:创建VG

4:创建LV

5:创建文件系统

6:mount 挂载点

具体操作步骤:

1:输入lspv检查现有磁盘

2:新添加的LUN到主机,实际是一个hdisk

可以通过指令cfgmgr 刷新新硬件(图略)

3:若hdisk 后面显示为none,则需要分配PVID

指令为:chdev –l hdisk* -a pv=yes

4:创建VG,指令如下:

mkvg –y datavg –s 512 hdisk0

-y :VG名字;-s :PP大小

5:创建LV,指令如下

mklv –y testly –t jfs2 testvg 10 hdisk0

-y: lv名字;-t :文件系统格式;10在这里代表10个PP

6:创建文件系统

crfs –v jfs2 –g testvg –m /test –a size=16m –d testlv

-v :文件系统格式;-g :lv所在VG名;-m :创建的文件系统目录;-a :文件系统的大小;-d :创建文件系统所在的lv名

7:挂载

mount testlv /test。