第四章 信源编码 习题解答

信息论、编码与密码学课后习题答案

第1章 信源编码

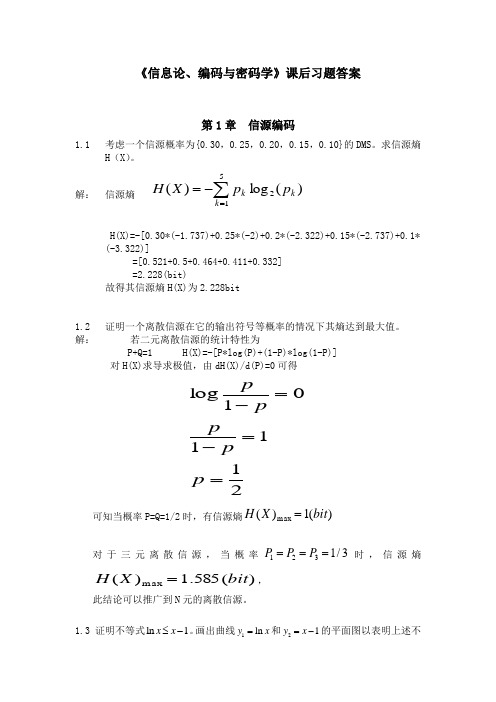

1.1考虑一个信源概率为{0.30,0.25,0.20,0.15,0.10}的DMS。求信源熵H(X)。

解: 信源熵

H(X)=-[0.30*(-1.737)+0.25*(-2)+0.2*(-2.322)+0.15*(-2.737)+0.1*(-3.322)]

10100+11110=01010 10100+00111=10011

10100+01101=11001

11110+00111=11001 11110+01101=10011

00111+01101=01010

满足第一条性质

2、全零码字总是一个码字

{00000,01010,10011,11001,10100,11110,00111,01101}

(1)给出此信源的霍夫曼码并确定编码效率。

(2)每次考虑两个符号时,给出此信源的霍夫曼码并确定编码效率。

(3)每次考虑三个符号时,给出此信பைடு நூலகம்的霍夫曼码并确定编码效率。

解:

(1)本题的霍夫曼编码如下图所示:

图1.11 霍夫曼编码

则霍夫曼码如下表:

符号

概率

码字

x1

0.5

1

x2

0.4

00

x3

0.1

01

该信源的熵为:

(2)全零字总是一个码字,

(3)两个码字之间的最小距离等于任何非零码字的最小重量,即

设 ,即 , , , ,

首先证明条件(1):

, , , , , ,

很明显,条件(1)是满足的。条件(2)也是显然成立的。

信息编码习题答案或提示

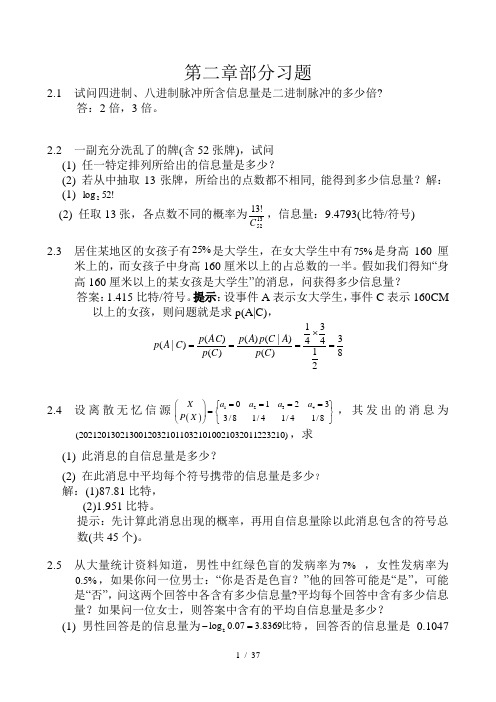

第二章部分习题2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?答:2倍,3倍。

2.2 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少?(2) 若从中抽取13张牌,所给出的点数都不相同, 能得到多少信息量?解:(1) !52log 2 (2) 任取13张,各点数不同的概率为1352!13C ,信息量:9.4793(比特/符号)2.3 居住某地区的女孩子有%25是大学生,在女大学生中有75%是身高160厘米上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 答案:1.415比特/符号。

提示:设事件A 表示女大学生,事件C 表示160CM 以上的女孩,则问题就是求p(A|C),83214341)()|()()()()|(=⨯===C p A C p A p C p AC p C A p2.4 设离散无忆信源()123401233/81/41/41/8X a a a a P X ====⎛⎫⎧⎫=⎨⎬ ⎪⎩⎭⎝⎭,其发出的消息为(2021201302130012032101103210100223210),求(1) 此消息的自信息量是多少?(2) 在此消息中平均每个符号携带的信息量是多少?解:(1)87.81比特,(2)1.951比特。

提示:先计算此消息出现的概率,再用自信息量除以此消息包含的符号总数(共45个)。

2.5 从大量统计资料知道,男性中红绿色盲的发病率为7% ,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含有多少信息量?平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?(1) 男性回答是的信息量为2log 0.07 3.8369-=比特,回答否的信息量是0.1047比特,平均每个回答含的信息量(即熵)是0.36596比特。

清华《信源编码》第四章

b 1 4e b e 2b

要使D最小, 令 e-b=0.293, D=0.657,则 =R(D)=60.6%, 比分别量化有所提高. 三维四维联合量化尚可进一步提高.

30

进一步提高压缩比的探讨(7)

K维情况,Zador得下列结果:

Lim n 2 / k G ห้องสมุดไป่ตู้ [ p( x ) k ,

21

语声的脉码调制(6)

A=87.65, y’(0)=16, =20log1016=24 db, 可压缩4比特,仍能满足小信号信扰比。 y’(1)=0.183, =-15db, 大信号时量化 噪声仍可满足。 实际用13线段来近似,均匀量化后用数 字逻辑电路实现

22

语声的脉码调制(7)

1

y

信号功率 W=2/2, 量化噪声 L 2 n L2 L Wq pi L p( x)dx 3n 2 (1 e ) 12 i 1 12

18

语声的脉码调制(3)

过载噪声

2 Wo 2 ( x L ) p( x )dx 2 L

2 L L 2 2 ( } n n

26

进一步提高压缩比的探讨(3)

要后处理,也可不用先达到最小平均失真, p(y)=p(-y)=z/2, H(Y)=z+H(z) =-log(1-2z+2z)/[z+H(z)] 取导置零,可得z=0.41, =69%. 对于独立序列,后处理虽能提高编码效率, 但效果不明显,如何能快速逼近R(D)也不 知. 对于相关信源,后处理以消除相关性, 可取得很大压缩比,以后讨论.

13

2

最佳标量量化(7)

绝对失真

( 2i 1) L dx L D |x | n L 4n 4 i 1 ( i 1) L

信息论与编码技术第四章课后习题答案

解:(1) D =

∑ P(u,υ )d (u,υ ) = (1 − p)q

UV

(2)根据题4.5,可知R(D)的最大值为H(p),此时q=0,平均失真D=0; (3)R(D)的最大值为0,此时q=1,平均失真D=(1-p); 4.7 设连续信源 X ,其概率密度分布为

p ( x) =

a − a | x| e 2

达到

D

min

的信道为

⎡1 ⎡1 0 ⎤ ⎡1 0 ⎤ ⎢ ⎥ ⎢ ⎥ ⎢1 [ P (υ j | u i )] = ⎢ ⎢ 0 1 ⎥ , ⎢1 0 ⎥ 或 ⎢ 2 ⎢ ⎣0 1 ⎥ ⎦ ⎢ ⎣0 1⎥ ⎦ ⎢0 ⎣

4.2 已知二元信源 ⎢

0⎤ 1⎥ ⎥ 2⎥ 1⎥ ⎦

1 ⎤ ⎡ X ⎤ ⎡ 0, ⎡0 1⎤ =⎢ =⎢ 以及失真矩阵 ⎡ dij ⎤ ⎥ ⎥ ⎥ ,试求: ⎣ ⎦ ⎣ p ( x ) ⎦ ⎣ p, 1 − p ⎦ ⎣1 0 ⎦

g (θ ) 的傅立叶变换

G s(w) = ∫

+∞ −∞

g

s

(θ )e

− jwθ

dθ =

s

2

s

2 2

+w

, (3)

得: Q( w) = P ( w) + w2 P( w), (4)

2

s

求式(4)的傅立叶反变换,又根据式(2)得

p( y ) = p( x = y) − D 所以 p( y ) =

2

p ( x = y), (5)

⎡0 ⎢1 定义为 D = ⎢ ⎢1 ⎢ ⎣1

解:

1 0 1 1

1 1 0 1

1⎤ 1⎥ ⎥ ,求 Dmax , Dmin 及信源的 R ( D ) 函数,并作出率失真函数曲线(取4到5个点)。 1⎥ ⎥ 0⎦

第四章习题答案

第4章习题4-1 对信源⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡01.010.015.017.018.019.02.0s s s s s s s P S 7654321进行二元编码,编码方案为(1)计算平均码长L ; (2)编码后信息传输率R ;(3)编码信息率R '; (4)编码效率η。

解:(1)()14.3Ls p L iq1i i=⋅=∑=(码元/信源符号)(2)()61.2S H =(比特/信源符号)()831.014.361.2L S ===H R (bit/码元) (3)logr L R ='=3.14( bit/信源符号) (4)831.0R Rmax==η 或者()831.0R S H ='=η 4-2 设离散无记忆信源的概率空间为⎥⎥⎦⎤⎢⎢⎣⎡=⎥⎦⎤⎢⎣⎡4143s s S 21P ,若对信源采取等长二元编码,要求编码效率96.0=η,允许译码错误概率510-≤δ,试计算需要的信源序列长度N 为多少?解:信源熵为()811034log 434log 41S .Η=+=(bit/符号)自信息量的方差()()()[]22i q1i i 2S H logp p S -=∑=σ4715.0811.041log 4143log 43222=-⎪⎭⎫⎝⎛+⎪⎭⎫ ⎝⎛= 因为编码效率96.0=η,由()()ε+=S S H H η可得()3379.0811.096.004.0S H 1=⨯=-=ηηε 可得()752221013.4103379.04715.0S N ⨯=⨯=≥-δεσ 所以,信源序列长度达到71013.4⨯以上,才能实现给定的要求,因此等长编码没有实际的意义,一般统计编码都是采用不等长编码。

4-6设离散无记忆信源的概率空间为⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡1.09.0s s S 21P ,对信源进行N 次扩展,采用霍夫曼编码。

当N=1,2,∞时的平均码长和编码效率为多少?解:(1)N=1时,将1s 编成0,2s 编成1,则1L 1=又因为信源熵()469.0))logp(s p(s S H q1i i i =-=∑=bit/符号所以()469.0L S H 11==η (2)N=2时,编码过程如下2S概率 霍夫曼编码11s s 0.81121s s 0.09 01 12s s 0.09 000 22s s 0.01001所以()=+⨯+⨯+⨯=0.090.0130.0920.811L 2则645.02L 2= 所以()==0.645X H 2η (3)N=∞时,由香农第一定理可知,必然存在唯一可译码,使()S H N L limr NN =∞→而霍夫曼编码为最佳码,即平均码长最短的码,故()()469.0S H S H N L limr NN ===∞→即1lim N N =∞→η4-7已知信源共7个符号消息,其概率空间为()⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡01.010.015.017.018.019.02.0s s s s s s s x P S 7654321试进行香农编码。

《信息论与编码》第四章习题解答

习题 4.4(3)图

(3)N 个相同 BSC 的积信道,求这时积信道容量 C N ,且证明 lim C N = ∞

N →∞

[证明] (1)见例 4.3.2 (2)首先因为

I ( X ; Y1 , Y2 ,L , YN ) = H ( X ) − H ( X | Y1 , Y2 LYN )

≤ H(X )

利用切比雪夫不等式

1 P[ Z N = 1| X = 0] = P Z ' N > | X = 0 2 1 = P Z ' N − p > − p | X = 0 2 1 ' ≤ P| Z N − p |> − p p 2 p(1 − p ) = 1 N ( − p )2 2

2

2

二元对称信道C2

4

退化信道容量为 C1 = 0 ,二元对称信道容量为 C2 = 1 − H (ε ) , 所以和信道的容量为

C = log 1 + 21− H ( ε )

达到信道容量的输入分布为

[

]

p ( X = 0) = 2 C1 − C 1 = 1 + 21− H (ε ) p ( X = 1) = p( X = 2)

所以满足定理 4.2.2 所规定的达到信道容量的充要条件,信道容量为

C=

(e)

3 bit/次 4

1 3 P = 0 1 3

1 3 1 3 0

0 1 3 1 3

1 3 1 3 1 3

信道是准对称信道,当输入分布为均匀分布时达到信道容量,即

p ( X = 0) = p( X = 1) = p ( X = 2) =

0 1

0 1

信息论与编码习题与答案第四章

4-1 设有一个二元等该率信源{}1,0∈X ,2/110==p p ,通过一个二进制对称信道(BSC )。

其失真函数ij d 与信道转移概率ij p 分别定义为 j i j i d ij =≠⎩⎨⎧=,0,1 ,j i ji p ij =≠⎩⎨⎧-=,1,εε试求失真矩阵d 和平均失真D 。

解:由题意得,失真矩阵为d ⎥⎦⎤⎢⎣⎡=0110d ,信道转移概率矩阵为P ⎥⎦⎤⎢⎣⎡--=εεεε11)(i j 平均失真为εεεεε=⨯-+⨯+⨯+⨯-==∑0)1(211211210)1(21),()()(,j i d i j p i p D ji 4-3 设输入符号与输出符号X 和Y 均取值于{0,1,2,3},且输入符号的概率分布为P(X=i)=1/4,i=0,1,2,3,设失真矩阵为⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=0111101111011110d 求)(),(,,max min max min D R D R D D 以及相应的编码器转移概率矩阵。

解:由题意,得 0min =D则symbol bit X H R D R /24log )()0()(2min ====这时信源无失真,0→0,1→1,2→2,3→3,相应的编码器转移概率矩阵为⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=1000010000100001)j (i P ∑===33,2,1,0max ),()(min i j j i d i p D,,141141041141141141141041min{⨯+⨯+⨯+⨯⨯+⨯+⨯+⨯=}041141141141141041141141⨯+⨯+⨯+⨯⨯+⨯+⨯+⨯, 43}43,43,43,43min{==则0)(max =D R此时输出概率分布可有多种,其中一种为:p(0)=1,p(1)=p(2)=p(3)=0则相应的编码器转移概率矩阵为⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=0001000100010001)(i j P4-5 具有符号集{}10,u u U =的二元信源,信源发生概率为:2/10,1)(,)(10≤<-==p p u p p u p 。

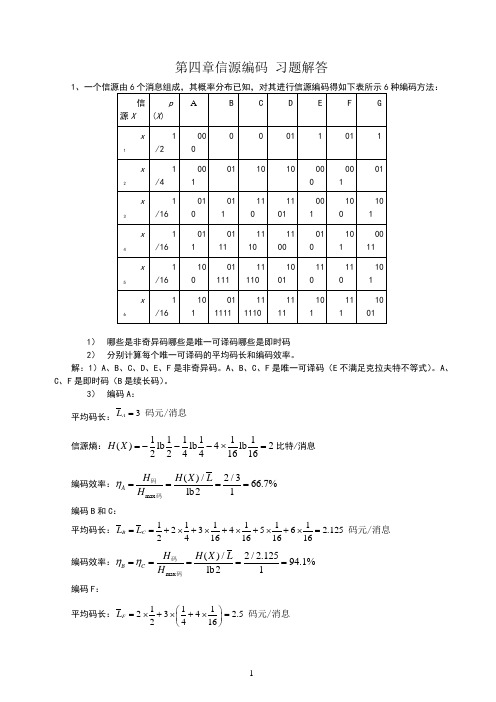

第四章信源编码习题解答

第四章信源编码习题解答1种编码方法:1)哪些是非奇异码哪些是唯一可译码哪些是即时码2)分别计算每个唯一可译码的平均码长和编码效率。

解:1)A、B、C、D、E、F是非奇异码。

A、B、C、F是唯一可译码(E不满足克拉夫特不等式)。

A、C、F是即时码(B是续长码)。

3)编码A:平均码长:3AL=码元/消息信源熵:111111()lb lb4lb222441616H X=---⨯=比特/消息编码效率:max ()/2/366.7% lb21AH H X L Hη====码码编码B和C:平均码长:11111123456 2.1252416161616B CL L==+⨯+⨯+⨯+⨯+⨯=码元/消息编码效率:max ()/2/2.12594.1% lb21B CH H X L Hηη=====码码编码F:平均码长:111234 2.52416FL⎛⎫=⨯+⨯+⨯=⎪⎝⎭码元/消息编码效率:max ()/2/2.580%lb21F H H X L H η====码码2、离散无记忆信源X 的概率空间为:1234567()0.200.190.180.170.150.100.01X x x x x x x x p X ⎧⎫⎡⎤=⎨⎬⎢⎥⎩⎭⎣⎦ 1)对其进行费诺编码,并计算其编码效率;2)对其进行哈夫曼编码,并将其编码效率与费诺编码相比较。

解:1平均码长:()()()0.20.1720.190.180.1530.10.014 2.74L =+⨯+++⨯++⨯=码元/符号 信源熵:()0.20lb0.200.19lb0.190.18lb0.180.17lb0.170.15lb0.150.1lb0.10.01lb0.01 2.60/874H X =-------= 比特符号编码后平均码元熵:() 2.608740.95212.74H X H L===码比特/码元编码效率:max 0.952195.21%lb2H H η===码码2)哈夫曼编码: 码长码字 信源X (X )2 10 x 1 2 11 x 2 3000 x 33 001 x 43 010 x 54 0110 x 64 0111x 7平均码长:()()()0.20.1920.180.170.1530.10.014 2.72L =+⨯+++⨯++⨯=码元/符号 编码后平均码元熵:() 2.608740.95912.72H X H L===码比特/码元编码效率:max 0.959195.91%lb2H H η===码码与费诺编码相比,哈夫曼编码的编码效率要高于费诺编码。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

冗余度:

2)费诺编码:

信源S

p(S)

编码过程

码字

码长

s1

0、37

0

0

00

2

s2

0、25

1

01

2

s4

0、18

1

0

10

2

s3

0、1

1

0

110

3

s6

0、07

1

0

1110

4

s5

0、03

1

1111

4

3)哈夫曼编码:

4)香农-费诺-埃利阿斯编码:

信源S

p(S)

F(s)

得二进制数

码长

码字

s1

0、37

4、离散无记忆信源S描述为:

1)计算信源熵及其冗余度;

2)对其进行费诺编码;

3)对其进行哈夫曼编码;

4*)对其进行香农-费诺-埃利阿斯编码;

5*)对其进行香农编码;

6)计算哈夫曼码得平均码长、编码效率与码冗余度;

7)把哈夫曼编码器得输出瞧成一个新信源X,计算其概率分布p(x1)与p(x2);

8)H[p(x1),p(x2)]就是否等于H码(即平均码元熵)?为什么?

x3

0、18

3

001

x4

0、17

3

010

x5

0、15

4

0110

x6

0、10

4

0111

x7

0、01

平均码长: 码元/符号

编码后平均码元熵:比特/码元

编码效率:

与费诺编码相比,哈夫曼编码得编码效率要高于费诺编码。

一般情况下哈夫曼编码效率较高,但费诺编码如果每次划分概率很接近,则效率也很高。

3、离散无记忆信源X得概率空间为:

1100

010

101

0011

x5

1/16

100

01111

11110

1001

110

110

101

x6

1/16

101

011111

111110

1111

101

111

1001

1)哪些就是非奇异码?哪些就是唯一可译码?哪些就是即时码?

2)分别计算每个唯一可译码得平均码长与编码效率。

解:1)A、B、C、D、E、F就是非奇异码。A、B、C、F就是唯一可译码(E不满足克拉夫特不等式)。A、C、F就是即时码(B就是续长码)。

3)编码A:

平均码长:

信源熵:比特/消息

编码效率:

编码B与C:

平均码长:

编码效率:

编码F:

平均码长:

编码效率:

2、离散无记忆信源X得概率空间为:

1)对其进行费诺编码,并计算其编码效率;

2)对其进行哈夫曼编码,并将其编码效率与费诺编码相比较。

解:1)费诺编码:

信源X

p(X)

编码过程

码字

码长

x1

0、20

0

0

00

2

x2

0、19

1

0

010

3

x3

0、18

1

011

3

x4

0、17

1

0

10

2

x5

0、15

1

0

110

3

x6

0、10

1

0

1110

4

x7

0、01

1

1111

4

平均码长: 码元/符号

信源熵:

编码后平均码元熵:比特/码元

编码效率:

2)哈夫曼编码:

码长

码字

信源X

p(X)

2

10

x1

0、20

2

11

x2

0、19

3

000

0、37

0、185

0、00101、、

3

001

s2

0、25

0、62

0、495

0、01111、、

3

011

s4

0、18

0、80

0、71

0、101101、、

4

1011

s3

0、1

0、90

0、85

0、1101100、、

5

11011

s6

0、07

0、97

0、935

0、1110111、、

5

11101

s5

0、03

1、00

4

1110

s5

0、03

0、97

0、1111100、、、

6

111110

6)分析哈夫曼码,

其平均码长:

平均码元熵:

编码效率:

码冗余度:

7)把哈夫曼编码器得输出瞧成一个新信源X,计算其概率分布p(x1)与p(x2):

8)计算

相比平均码元熵:

可见,两者很相近,但理论上不相同。因为平均码元熵计算得就是算术平均值,而作得就是统计平均。

第四章信源编码习题解答

1、一个信源由6个消息组成,其概率分布已知,对其进行信源编码得如下表所示6种编码方法:

信源X

p(X)

A

B

C

D

E

F

G

x1

1/2

000

0

0

01

1

01

1

x2

1/4

001

01

10

10

000

001

01

x3

1/16

010

011

110

1101

001

100

101

x4

1/16

011

0111

1110

2

D

3/16

1

0

10

2

C

2/16

1

0

110

3

B

1/16

1

0

1110

4

A

1/16

1

1111

4

平均码长:码元/符号

信源熵: 比特/符号

编码后平均码元熵:比特/码元

二元信源最大码元熵为1比特/码元,故编码效率:

哈夫曼编码:

由于平均码长与费诺编码一样,故编码效率也为99%。一般情况下哈夫曼编码效率较高,但费诺编码如果每次划分概率很接近,则效率也很高。

5、设有6个消息,其出现概率分别为

A B C D E F

1/16 1/16 2/16 3/16 4/16 5/16

将它们分别进行费诺编码与霍夫曼编码,并比较编码效率。就是否在任何情况下费诺编码比霍夫曼编码效率都低?

解:信源:

费诺编码:

信源X

p(X)

编码过程

码字

码长

F

5/16

0

0

00

2

E

4/16

1

01

6、有一冗余位序列,=15,码字为0000,试将其编成L-D码,并将L-D码译回原序列。

解:0000 N=15

编码:

,于就是得L-D码:0010 0101111

译码:

修正:

故译码恢复出原序列:0000

作业:1、2、4

1)对其进行费诺编码;

2)对其进行哈夫曼编码。

解:1)费诺编码:

信源X

p(X)

编码过程

码字

码长

x1

0、22

0

0

00

2

x2

0、20

1

01

2

x3

0、18

1

0

0

100

3

x5

0、15

1

101

3

x4

0、1

1

0

110

3

x8

0、08

1

0

1110

4

x7

0、05

1

0

11110

5

x6

0、02

1

11111

5

2)哈夫曼编码:

0、985

0、111111000、、

7

5)香农编码:

信源S

p(S)

F(s)

F(s)得二进制数

码长

码字

s1

0、37

0

0、000、、、

2

00

s2

0、25

0、37

0、010、、、

2

01

s4

0、18

0、62

0、1001、、、

3

1Hale Waihona Puke 0s30、10、8

0、11001、、、

4

1100

s6

0、07

0、9

0、11100、、、