“维特比”(Viterbi)算法

维特比算法中文分词的原理

维特比算法中文分词的原理

维特比算法是一种基于动态规划的算法,用于中文分词。

它的原理如下:

1. 首先,将待分词的句子进行切割成一个个的字或词。

2. 对于每个字或词,计算概率最大的分词节点,并记录下来。

这个节点的概率可以通过统计语料库中的词频信息来计算。

3. 从句子的第一个字或词开始,每次选择当前位置概率最大的节点,并将其加入分词结果中。

然后,从当前位置的下一个字或词开始继续选择概率最大的节点,直到句子末尾。

4. 最后,得到的分词结果就是概率最大的路径。

维特比算法的关键是使用动态规划来计算概率最大的节点。

具体来说,可以使用一个二维数组来存储每个字或词位置的概率最大节点和对应的概率值。

通过不断更新这个数组,可以得到最终的分词结果。

维特比算法在中文分词中有广泛应用,它能够通过考虑字或词之间的概率关系来提高分词准确性。

同时,维特比算法的动态规划思想也使得它能够高效地处理长句子。

viterbi算法公式

viterbi算法公式

维特比算法是一种动态规划算法,用于求解隐马尔可夫模型中的最优路径。

它基于马尔可夫假设,其中状态具有马尔可夫性质,且每个状态转移的概率已知。

算法中使用的公式包括:

1. 初始化:

- 初始状态概率:$V_1(i) = \pi_i \cdot B_{i}(O_1)$,表示在时刻1处于状态i的所有路径的概率。

- 初始路径:$Path_1(i) = i$,表示在时刻1处于状态i的最优路径。

2. 递推:

- 对于时刻t>1,计算每个状态i的最优路径概率和路径:

$$

V_t(i) = \max_{j} \left( V_{t-1}(j) \cdot A_{ji} \right) \cdot B_{i}(O_t) $$

$$

Path_t(i) = \arg\max_{j} \left( V_{t-1}(j) \cdot A_{ji} \right)

$$

这里,$A_{ji}$是从状态j到状态i的转移概率,$B_{i}(O_t)$是在时刻t观测到符号$O_t$的概率。

3. 终止:

- 在最后一时刻T,找到最大路径概率的状态:

$$

\max_{i} V_T(i)

$$

- 最优路径就是沿着每个时刻的最大路径$I_{T} \rightarrow I_{T-1} \rightarrow ... \rightarrow I_1$。

维特比算法通过递归地计算每个时刻的最优路径概率和路径来找到隐马尔可夫模型中的最优路径。

这种算法有效地解决了最优路径问题,并在语音识别、自然语言处理等领域中得到广泛应用。

维特比算法参数估计

维特比算法参数估计

维特比算法是一种基于动态规划的算法,用于求解隐马尔可夫模型中的最优路径问题。

在应用中,我们通常需要对隐马尔可夫模型中的参数进行估计。

本文将介绍维特比算法在参数估计中的应用。

在隐马尔可夫模型中,参数估计主要包括两个方面:转移概率矩阵的估计和发射概率矩阵的估计。

一般情况下,我们可以使用最大似然估计法来估计这些参数。

在使用最大似然估计法时,我们需要求解模型的似然函数,并找到使似然函数最大化的参数值。

在隐马尔可夫模型中,似然函数可以通过前向算法或后向算法计算得到。

由于维特比算法可以求解最优路径,因此在参数估计中也可以使用维特比算法来计算似然函数。

具体来说,我们可以通过维特比算法求解出最优路径,然后根据该路径计算出似然函数的值。

在转移概率矩阵的估计中,我们可以通过计算每个状态对应的转移次数来估计转移概率矩阵。

对于发射概率矩阵的估计,我们可以通过计算每个状态下每个观测值出现的次数来估计发射概率矩阵。

需要注意的是,在进行参数估计时,我们通常会遇到参数为0的情况,这会导致似然函数无法计算。

为了避免这种情况,我们可以使用平滑技术,如加1平滑或加λ平滑等。

维特比算法在隐马尔可夫模型中应用广泛,尤其在语音识别、自然语言处理等领域中具有重要的应用价值。

通过了解维特比算法在参数估计中的应用,我们可以更好地理解隐马尔可夫模型的原理和应用,

为实现更好的相关应用提供支持。

维特标准协议计算

维特标准协议计算

维特标准协议(Viterbi Algorithm)是一种用于求解最短路径问题的算法,其计算过程如下:

1. 初始化一个长度为2^n的存储空间,其中n为网络中节点数。

2. 将所有节点的状态设置为“未访问”。

3. 将起始节点的状态设置为“已访问”,并将起始节点的输出路径设为0。

4. 对每个未访问节点进行处理,将当前节点的输出路径与其相邻节点的输出路径进行比较,选择路径长度最短的一个进行更新。

5. 将当前节点标记为“已访问”。

6. 重复步骤3和4,直到所有节点的状态都设置为“已访问”。

7. 最后,将最终节点的输出路径设为该节点的最优路径。

需要注意的是,维特标准协议的计算过程比较复杂,需要一定的数学基础和计算机编程能力。

此外,在实际应用中,可能需要对算法进行优化和调整,以提高计算效率和准确性。

离散时间白噪声信道中的维特比算法在VC中的实现

离散时间白噪声信道中的维特比算法在VC中的实现邓国辉;李金武【摘要】本文讨论维特比(Viterbi)算法在离散时间白噪声信道中的实现.先给出带宽受限,存在失真且先验未知以及具有AWGN条件下信道的一种数学模型.由此得到维特比(Viterbi)算法在离散时间白噪声信道中的表示形式,且根据其在此信道模型下的算法描述,具体分析了离散时间白噪声信道中的维特比(Viterbi)算法设计问题,并利用VC6.0得出仿真结果和性能分析,得出维特比(Viterbi)译码算法对于信道特性无论好坏是普遍适用的,大大补偿了存在码间串扰(ISI)的信道的接收性能,降低了误码率.提高了信道的传输性能.【期刊名称】《贵州大学学报(自然科学版)》【年(卷),期】2015(032)002【总页数】4页(P50-53)【关键词】维特比(Viterbi)算法;高斯白噪声(AWGN);码间串扰(ISI);误码率【作者】邓国辉;李金武【作者单位】郑州科技学院信息工程系,河南郑州450064;郑州科技学院信息工程系,河南郑州450064【正文语种】中文【中图分类】TN913在实际的通信过程中,传输信息的信道的失真会引起信息比特间的干扰,如果不采取相应的措施,会产生较高的误码率,严重影响通信质量,这在实际的通信过程是不能允许的。

然而,在正常的通信过程中确实存在信息的传输信道失真问题,本文以减少由于信道失真引起的接收信号中的码间串扰(ISI)为目的,具体分析了带宽受到限制,存在失真且先验未知以及具有AWGN条件下信道中的离散时间白噪声信道中的设计问题。

首先给出数学模型—等效离散时间信道模型,在将传统的维特比(Viterbi)算法加载到信道上,得到上述条件下的维特比(Viterbi)算法具体表现形式。

大大补偿了存在码间串扰(ISI)的信道的接收性能,降低了误码率。

本篇采用离散时间白噪声信道,即采用双二进制信号脉冲传输四电平(M=4)PAM的等效离散时间信道模型,使用VC6.0对数学模型进行编程,并根据程序运行结果分析其性能。

隐马尔可夫链解码问题使用的经典算法

隐马尔可夫链解码问题使用的经典算法1. 引言隐马尔可夫模型(Hidden Markov Model, HMM)是一种用于描述时序数据的统计模型,广泛应用于语音识别、自然语言处理、生物信息学等领域。

在HMM中,我们经常面临的一个重要问题是解码问题,即根据观测序列推断隐藏状态序列的问题。

为了解决这一问题,经典算法中有几种常用的方法,本文将对其中的经典算法进行深入探讨。

2. 维特比算法(Viterbi Algorithm)维特比算法是解决HMM解码问题的经典算法之一。

它基于动态规划的思想,通过递归地计算最优路径来推断隐藏状态序列。

在该算法中,我们需要利用马尔可夫假设和观测状态的概率分布,使用动态规划的方法找到最有可能的隐藏状态序列。

维特比算法的时间复杂度为O(N^2T),其中N为隐藏状态的个数,T为观测序列的长度。

3. 前向后向算法(Forward-Backward Algorithm)前向后向算法是另一种常用的HMM解码算法。

该算法利用前向概率和后向概率来计算在每个时刻t处于状态i的概率,从而得到最优的隐藏状态序列。

与维特比算法相比,前向后向算法更侧重于计算整条观测序列的似然度,而不是单个最优路径。

该算法的时间复杂度为O(NT^2),其中N为隐藏状态的个数,T为观测序列的长度。

4. Baum-Welch算法除了维特比算法和前向后向算法,Baum-Welch算法也是解决HMM解码问题的一种重要算法。

该算法是一种无监督学习算法,用于估计HMM的参数,包括隐藏状态转移概率和观测状态概率。

通过不断迭代E步和M步,Baum-Welch算法可以得到最优的HMM参数估计。

这些参数可以用于后续的解码问题,从而得到最优的隐藏状态序列。

5. 总结与展望在本文中,我们对解决HMM解码问题的经典算法进行了深入探讨。

维特比算法、前向后向算法和Baum-Welch算法都是解决HMM解码问题的重要工具,它们在不同应用领域都有着广泛的应用。

维特比算法例题

维特比算法例题维特比(Viterbi)算法是一种动态规划算法,常用于隐马尔可夫模型(HMM)中的路径搜索问题。

以下是一个简单的维特比算法的例子:假设有一个简单的HMM,包含两个状态(状态1和状态2),以及两个观测序列(观测1和观测2)。

状态转移概率如下:P(状态1→状态1) = 0.7P(状态1→状态2) = 0.3P(状态2→状态1) = 0.4P(状态2→状态2) = 0.6观测概率如下:P(观测1|状态1) = 0.5P(观测1|状态2) = 0.5P(观测2|状态1) = 0.4P(观测2|状态2) = 0.6现在我们要找出最有可能的状态序列,使得观测序列的概率最大。

首先,我们需要计算每个状态在每个时刻的概率。

这可以通过以下公式计算:P(状态i, t) = P(观测t|状态i) * P(状态i, t-1)其中,P(观测t|状态i)是观测概率,P(状态i, t-1)是上一个时刻的状态概率。

然后,我们需要找出最有可能的状态序列。

这可以通过以下公式计算:P(最优, t) = max P(状态i, t) * P(状态i→状态j)其中,P(最优, t)是在时刻t的最有可能的状态概率,P(状态i, t)是在时刻t的状态i的概率,P(状态i→状态j)是从状态i转移到状态j的概率。

最后,我们可以通过回溯算法找出最有可能的状态序列。

回溯算法是一种通过逐步回溯搜索树来找出最有可能的解的算法。

具体来说,我们从最后一个时刻开始向前回溯,找出最有可能的状态,然后继续向前回溯,直到找到最有可能的初始状态。

以上是一个简单的维特比算法的例子,希望能帮助您理解该算法的基本原理和应用。

维特比算法(Viterbi)及python实现样例

维特⽐算法(Viterbi)及python实现样例维特⽐算法(Viterbi)维特⽐算法维特⽐算法shiyizhong 动态规划算法⽤于最可能产⽣观测时间序列的-维特⽐路径-隐含状态序列,特别是在马尔可夫信息源上下⽂和隐马尔科夫模型中。

术语“维特⽐路径”和“维特⽐算法”也被⽤于寻找观察结果最有可能解释的相关dongtai 规划算法。

例如在统计句法分析中动态规划可以被⽤于发现最有可能的上下⽂⽆关的派⽣的字符串,有时被称为“维特⽐分析”。

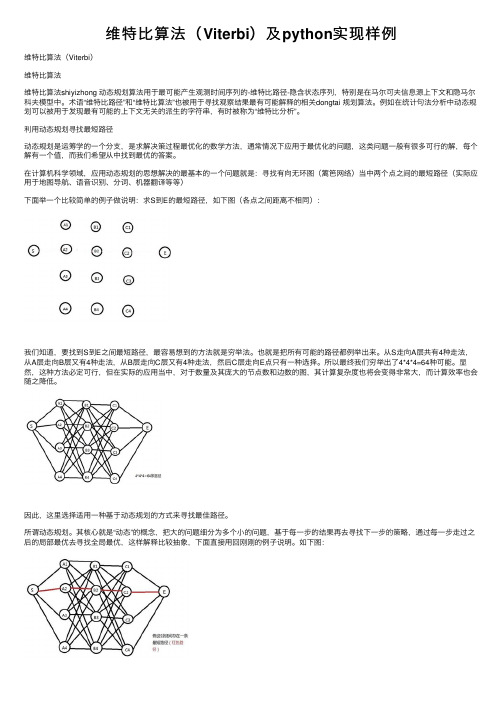

利⽤动态规划寻找最短路径动态规划是运筹学的⼀个分⽀,是求解决策过程最优化的数学⽅法,通常情况下应⽤于最优化的问题,这类问题⼀般有很多可⾏的解,每个解有⼀个值,⽽我们希望从中找到最优的答案。

在计算机科学领域,应⽤动态规划的思想解决的最基本的⼀个问题就是:寻找有向⽆环图(篱笆⽹络)当中两个点之间的最短路径(实际应⽤于地图导航、语⾳识别、分词、机器翻译等等)下⾯举⼀个⽐较简单的例⼦做说明:求S到E的最短路径,如下图(各点之间距离不相同):我们知道,要找到S到E之间最短路径,最容易想到的⽅法就是穷举法。

也就是把所有可能的路径都例举出来。

从S⾛向A层共有4种⾛法,从A层⾛向B层⼜有4种⾛法,从B层⾛向C层⼜有4种⾛法,然后C层⾛向E点只有⼀种选择。

所以最终我们穷举出了4*4*4=64种可能。

显然,这种⽅法必定可⾏,但在实际的应⽤当中,对于数量及其庞⼤的节点数和边数的图,其计算复杂度也将会变得⾮常⼤,⽽计算效率也会随之降低。

因此,这⾥选择适⽤⼀种基于动态规划的⽅式来寻找最佳路径。

所谓动态规划。

其核⼼就是“动态”的概念,把⼤的问题细分为多个⼩的问题,基于每⼀步的结果再去寻找下⼀步的策略,通过每⼀步⾛过之后的局部最优去寻找全局最优,这样解释⽐较抽象,下⾯直接⽤回刚刚的例⼦说明。

如下图:⾸先,我们假设S到E之间存在⼀条最短路径(红⾊),且这条路径经过C2点,那么我们便⼀定能够确定从S到C2的64条(4*4*4=64)⼦路经当中,该⼦路经⼀定最短。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

隐马尔可夫模型中的Viterbi算法2008年1月24日这篇文章简单描述一下Viterbi算法——一年之前我听过它的名字,直到两周之前才花了一点时间研究了个皮毛,在这里做个简单检讨。

先用一句话来简单描述一下:给出一个观测序列o1,o2,o3 …,我们希望找到观测序列背后的隐藏状态序列s1, s2, s3, …;Viterbi以它的发明者名字命名,正是这样一种由动态规划的方法来寻找出现概率最大的隐藏状态序列(被称为Viterbi路径)的算法。

这里需要抄一点有关隐马可夫序列(HMM,Hidden Markov Model)的书页来解释一下观测序列和隐藏状态序列。

首先从最简单的离散Markov过程入手,我们知道,Markov随机过程具有如下的性质:在任意时刻,从当前状态转移到下一个状态的概率与当前状态之前的那些状态没有关系。

所以,我们可以用一个状态转移概率矩阵来描述它。

假设我们有n个离散状态S1, S2,…Sn,我们可以构造一个矩阵A,矩阵中的元素aij表示从当前状态Si下一时刻迁移到Sj状态的概率。

但是在很多情况下,Markov模型中的状态是我们观察不到的。

例如,容器与彩球的模型:有若干个容器,每个容器中按已知比例放入各色的彩球(这样,选择了容器后,我们可以用概率来预测取出各种彩球的可能性);我们做这样的实验,实验者从容器中取彩球——先选择一个容器,再从中抓出某一个球,只给观察者看球的颜色;这样,每次取取出的球的颜色是可以观测到的,即o1, o2,…,但是每次选择哪个容器是不暴露给观察者的,容器的序列就组成了隐藏状态序列S1, S2,…Sn。

这是一个典型的可以用HMM描述的实验。

HMM有几个重要的任务,其中之一就是期望通过观察序列来猜测背后最有可能的隐藏序列。

在上面的例子中,就是找到我们在实验中最有可能选择到的容器序列。

Viterbi正是用来解决这个问题的算法。

HMM另外两个任务是:a) 给定一个HMM,计算一个观测序列出现的可能性;b)已知一个观测序列,HMM参数不定,如何优化这些参数使得观测序列的出现概率最大。

解决前一个问题可以用与Viberbi结构非常类似的Forward算法来解决(实际上在下面合二为一),而后者可以用Baum-Welch/EM算法来迭代逼近。

从Wiki上抄一个例子来说明Viterbi算法。

假设你有一个朋友在外地,每天你可以通过电话来了解他每天的活动。

他每天只会做三种活动之一——Walk, Shop, Clean。

你的朋友从事哪一种活动的概率与当地的气候有关,这里,我们只考虑两种天气——Rainy, Sunny。

我们知道,天气与运动的关系如下:Rainy SunnyWalk 0.1 0.6Shop 0.4 0.3Clean 0.5 0.1例如,在下雨天出去散步的可能性是0.1。

而天气之前互相转换的关系如下,(从行到列)Rainy SunnyRainy 0.7 0.3Sunny 0.4 0.6例如,从今天是晴天而明天就开始下雨的可能性是0.4 。

同时为了求解问题我们假设初始情况:通话开始的第一天的天气有0.6的概率是Rainy,有0.4概率是Sunny。

OK,现在的问题是,如果连续三天,你发现你的朋友的活动是:Walk->Shop->Clean;那么,如何判断你朋友那里这几天的天气是怎样的?解决这个问题的python伪代码如下:def forward_viterbi(obs, states, start_p, trans_p, emit_p):T = {}for state in states:## prob. V. path V. prob.T[state] = (start_p[state], [state], start_p[state])for output in obs:U = {}for next_state in states:total = 0argmax = Nonevalmax = 0for source_state in states:(prob, v_path, v_prob) = T[source_state]p = emit_p[source_state][output] *trans_p[source_state][next_state]prob *= pv_prob *= ptotal += probif v_prob > valmax:argmax = v_path + [next_state]valmax = v_probU[next_state] = (total, argmax, valmax)T = U## apply sum/max to the final states:total = 0argmax = Nonevalmax = 0for state in states:(prob, v_path, v_prob) = T[state]total += probif v_prob > valmax:argmax = v_pathvalmax = v_probreturn (total, argmax, valmax)几点说明:1. 算法对于每一个状态要记录一个三元组:(prob, v_path, v_prob),其中,prob是从开始状态到当前状态所有路径(不仅仅是最有可能的viterbi路径)的概率加在一起的结果(作为算法附产品,它可以输出一个观察序列在给定HMM下总的出现概率,即forward算法的输出),v_path是从开始状态一直到当前状态的viterbi路径,v_prob则是该路径的概率。

2. 算法开始,初始化T (T是一个Map,将每一种可能状态映射到上面所说的三元组上)3. 三重循环,对每个一活动y,考虑下一步每一个可能的状态next_state,并重新计算若从T中的当前状态state跃迁到next_state概率会有怎样的变化。

跃迁主要考虑天气转移(tp[source_state][next_state])与该天气下从事某种活动(ep[source_state][output])的联合概率。

所有下一步状态考虑完后,要从T中找出最优的选择viterbi路径——即概率最大的viterbi路径,即上面更新Map U的代码U[next_state] = (total, argmax, valmax)。

4. 算法最后还要对T中的各种情况总结,对total求和,选择其中一条作为最优的viterbi路径。

5. 算法输出四个天气状态,这是因为,计算第三天的概率时,要考虑天气转变到下一天的情况。

6. 通过程序的输出可以帮助理解这一过程:observation=Walknext_state=Sunnystate=Sunnyp=0.36triple=(0.144,Sunny->,0.144)state=Rainyp=0.03triple=(0.018,Rainy->,0.018)Update U[Sunny]=(0.162,Sunny->Sunny->,0.144)next_state=Rainystate=Sunnyp=0.24triple=(0.096,Sunny->,0.096)state=Rainyp=0.07triple=(0.042,Rainy->,0.042)Update U[Rainy]=(0.138,Sunny->Rainy->,0.096)observation=Shopnext_state=Sunnystate=Sunnyp=0.18triple=(0.02916,Sunny->Sunny->,0.02592)state=Rainyp=0.12triple=(0.01656,Sunny->Rainy->,0.01152)Update U[Sunny]=(0.04572,Sunny->Sunny->Sunny->,0.02592)next_state=Rainystate=Sunnyp=0.12triple=(0.01944,Sunny->Sunny->,0.01728)state=Rainyp=0.28triple=(0.03864,Sunny->Rainy->,0.02688)Update U[Rainy]=(0.05808,Sunny->Rainy->Rainy->,0.02688)observation=Cleannext_state=Sunnystate=Sunnyp=0.06triple=(0.0027432,Sunny->Sunny->Sunny->,0.0015552)state=Rainyp=0.15triple=(0.008712,Sunny->Rainy->Rainy->,0.004032)Update U[Sunny]=(0.0114552,Sunny->Rainy->Rainy->Sunny->,0.004032) next_state=Rainystate=Sunnyp=0.04triple=(0.0018288,Sunny->Sunny->Sunny->,0.0010368)state=Rainyp=0.35triple=(0.020328,Sunny->Rainy->Rainy->,0.009408)Update U[Rainy]=(0.0221568,Sunny->Rainy->Rainy->Rainy->,0.009408) final triple=(0.033612,Sunny->Rainy->Rainy->Rainy->,0.009408)所以,最终的结果是,朋友那边这几天最可能的天气情况是Sunny->Rainy->Rainy->Rainy,它有0.009408的概率出现。

而我们算法的另一个附带的结论是,我们所观察到的朋友这几天的活动序列:Walk->Shop->Clean在我们的隐马可夫模型之下出现的总概率是0.033612。

参考文献1. /Faculty/Rabiner/ece259/Reprints/tutorial%20on%20hmm%20and%20applications.pdf2. /wiki/Viterbi_algorithm3. /2006/04/blog-post_17.html附:c++主要代码片断void forward_viterbi(const vector<string> & ob, viterbi_triple_t & vtriple){//aliasmap<string, double>& sp = start_prob;map<string, map<string, double> > & tp = transition_prob;map<string, map<string, double> > & ep = emission_prob;// initializationInitParameters();map<string, viterbi_triple_t> T;for (vector<string>::iterator it = states.begin();it != states.end();++it){viterbi_triple_t foo;foo.prob = sp[*it];foo.vpath.push_back(*it);foo.vprob = sp[*it];T[*it] = foo;}map<string, viterbi_triple_t> U;double total = 0;vector<string> argmax;double valmax = 0;double p = 0;for (vector<string>::const_iterator itob = ob.begin(); itob != ob.end(); ++itob){cout << “observation=” << *itob << endl;U.clear();for (vector<string>::iterator itNextState = states.begin();itNextState != states.end();++itNextState){cout << “\tnext_state=” << *itNextState << endl;total = 0;argmax.clear();valmax = 0;for (vector<string>::iterator itSrcState = states.begin();itSrcState != states.end();++itSrcState){cout << “\t\tstate=” << *itSrcState << endl;viterbi_triple_t foo = T[*itSrcState];p = ep[*itSrcState][*itob] * tp[*itSrcState][*itNextState];cout << “\t\t\tp=” << p << endl;foo.prob *= p;foo.vprob *= p;cout << “\t\t\ttriple=” << foo << endl;total += foo.prob;if (foo.vprob > valmax){foo.vpath.push_back(*itNextState);argmax = foo.vpath;valmax = foo.vprob;}}U[*itNextState] = viterbi_triple_t(total, argmax, valmax);cout << “\tUpdate U[" << *itNextState << "]=” << U[*itNextState] <<“” << endl;}T.swap(U);}total = 0;argmax.clear();valmax = 0;for (vector<string>::iterator itState = states.begin();itState != states.end();++itState){viterbi_triple_t foo = T[*itState];total += foo.prob;if (foo.vprob > valmax){argmax.swap(foo.vpath);valmax = foo.vprob;}}vtriple.prob = total;vtriple.vpath = argmax;vtriple.vprob = valmax;cout << “final triple=” << vtriple << endl;}。