牛顿法与高斯牛顿法

高斯牛顿法手算例题

高斯牛顿法手算例题高斯-牛顿法是一种用于求解非线性方程组的迭代数值方法。

它通过不断迭代来逼近方程组的解。

我将通过一个手算例题来演示高斯-牛顿法的应用。

假设我们要解决以下非线性方程组:f1(x, y) = x^2 + y^2 25 = 0。

f2(x, y) = x y 9 = 0。

我们首先需要计算方程组的雅可比矩阵,即关于变量x和y的偏导数矩阵:J = |2x 2y|。

|y x |。

接下来,我们选择一个初始解向量,例如(x0, y0) = (1, 1)。

然后,我们可以使用以下公式进行迭代:(xn+1, yn+1) = (xn, yn) (J^T J)^(-1) J^T f(xn, yn)。

其中,^T表示矩阵的转置,^(-1)表示矩阵的逆,f(xn, yn)是方程组的函数向量。

现在,让我们开始手算迭代过程:首先,计算f(x0, y0)和J在(x0, y0)处的值:f(x0, y0) = (1^2 + 1^2 25, 11 9) = (-22, -8)。

J = |21 21|。

|1 1 |。

接下来,我们需要计算(J^T J)^(-1) J^T的值。

首先计算J^T J:J^T J = |2 1| |2 2| = |8 4|。

|1 1| |2 2| |4 4|。

然后计算其逆矩阵:(J^T J)^(-1) = (1/(84-44)) |2 -1| = (1/8) |1 -1|。

|-1 2 | |-12 |。

最后,计算(J^T J)^(-1) J^T:(J^T J)^(-1) J^T = (1/8) |1 -1| |2 1| = (1/8) |21|。

|-1 2 | |1 1| |-1 2|。

现在,我们可以将这些值代入迭代公式中:(x1, y1) = (1, 1) (1/8) |2 1| |-22|。

|-1 2 | |-8 |。

(x1, y1) = (1, 1) (1/8) |2 1| |-22| = (1, 1) (1/8)|18|。

高斯牛顿迭代法

高斯牛顿迭代法

高斯-牛顿迭代法,基本思想是使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多次迭代,多次修正回归系数,使回归系数不断逼近非线性回归模型的最佳回归系数,最后使原模型的残差平方和达到最小。

高斯-牛顿法的一般步骤为:

(1)初始值的选择。

其方法有三种,一是根据以往的经验选定初始值;二是用分段法求出初始值;三是对于可线性化的非线性回归模型,通过线性变换,然后施行最小平方法求出初始值。

(2)泰勒级数展开式。

设非线性回归模型为:

i=1,2,…,n(3-68)其中r为待估回归系数,误差项~N(0,)。

python高斯-牛顿迭代法

python高斯-牛顿迭代法高斯-牛顿迭代法(Gauss-Newton method)是一种用于非线性优化问题的迭代算法。

它基于线性最小二乘法,用于求解非线性函数的最优解。

在本文中,我们将详细介绍高斯-牛顿迭代法的原理和实现,以及一些常见的应用。

1.高斯-牛顿迭代法原理高斯-牛顿迭代法的目标是找到一个最优的参数向量x,使得一个非线性函数集合F(x)的残差平方和最小化。

其中,残差r(x)定义为测量值与模型值之间的差异,即r(x) = y - f(x),其中y是测量值,f(x)是模型值函数。

残差平方和定义为S(x) = sum(r(x)^2),即所有残差的平方和。

为了找到最优的参数向量x,高斯-牛顿迭代法采用以下步骤进行迭代:1.初始化参数向量x的值。

2.计算残差r(x)和残差雅可比矩阵J(x)。

3.求解线性最小二乘问题J(x)^T J(x) dx = -J(x)^T r(x),其中dx是参数的增量。

4.更新参数向量x = x + dx。

5.重复步骤2-4,直到满足停止条件(如参数更新小于某个阈值)。

2.高斯-牛顿迭代法的实现高斯-牛顿迭代法的实现需要计算残差和雅可比矩阵,通过求解线性最小二乘问题来更新参数向量。

以下是一个简单的实现示例:```pythonimport numpy as npdef gauss_newton(x0, y, f, f_prime, max_iterations=100,tol=1e-6):x = x0for i in range(max_iterations):r = y - f(x)J = f_prime(x)dx = np.linalg.lstsq(J, -r, rcond=None)[0]x = x + dxif np.linalg.norm(dx) < tol:breakreturn x```在上述代码中,x0是参数向量的初始值,y是测量值,f是模型值函数,f_prime是模型值函数的导数。

高斯-牛顿法

c=Fk-1/Fk+1 d=Fk/Fk+1

Fibonacci(1170-1250)

达.芬奇与黄金分割

黄金分割法:

给出[0, 1]: X=0.382 Y=0.618

新区间: [0, 0.618] or [0.382, 1]

一个 n 维问题 转化为 n 个 一维问题

共轭梯度法的实现

著名的β选取:

Hestenes (1906-1991)

Stiefel (1909-1978)

新的共轭梯度法

Dai-Yuan(1999) More methods by Hager-Zhang, etc..

牛顿法巧 -- 复杂问题简单化

黄金分割法

黄金分割法

华罗庚(1910-1985)

华罗庚在农村推广优选法

华罗庚在大庆油田讲优选法

华罗庚在矿山推广优选法

华罗庚在工厂、车间

Max f(x)

[a, b] 上的连续函数 f(x) 是单峰的(只有 一个最大值点), 求解 max f(x)

任取 a<c<d<b, 如果 f( c ) < f(d) , 则 我们只需在 [c, b] 上求 max f(x)

瞎子爬山 vs 优化方法

瞎子和计算机谁快? 瞎子和计算机谁聪明? 瞎子会如何“看” “瞎子爬山法”呢?

优化方法的特征

基于极小 ( min f(x) )

基于KKT 条件 (

)

迭代

迭代 - 计算的基本

千里之行始于足下 ---老子

几个经典优化方法

黄金分割法 最速下降法 共轭梯度法 牛顿法与拟牛顿法 高斯牛顿法与信赖域方法 单纯形法与内点法 交替方向法

光学牛顿公式和高斯公式

光学牛顿公式和高斯公式

光学公式(公式一):

在光学中,有一条被称为光学公式的基本关系式,其形式类似于牛顿公式。

这个公式

描述了光线经过光学元件(如透镜)时产生的折射现象。

设光线从一个介质(如空气)射入另一个介质(如玻璃),其入射角为θ_1,折射角为θ_2。

则根据光学公式可以得到如下关系:

n_1 × sin(θ_1) = n_2 × sin(θ_2)

n_1和n_2分别是两个介质的折射率,sin(θ_1)和sin(θ_2)分别是入射角和折射角

的正弦值。

高斯公式(公式二):

高斯公式是光学中用于计算薄透镜成像的一种公式,由哥特弗里德·威廉·莱布尼茨

与约翰内斯·凯普勒设计。

设一个物体与薄透镜之间的距离为u,物体到透镜的焦距为f,则像到透镜的距离为v。

根据高斯公式,我们可以得到如下关系:

1/v - 1/u = 1/f

v为像的位置,u为物体的位置。

此公式的表达方式是光学中常用的一种方法,用于定性描述薄透镜成像的情况。

这两个公式在光学研究中具有重要的作用,能够描述光线在传播和成像过程中的行为,为我们解释和预测光学现象提供了基础。

matlab高斯牛顿算法求参数

matlab高斯牛顿算法求参数

一、背景

1、matlab高斯牛顿算法是一种解决非线性回归问题的算法,它是一类最优化算法的一种,主要用于迭代求解多个参数之间的关系。

2、matlab高斯牛顿算法的核心思想就是以“最小二乘法”为基础,基于牛顿迭代法,对模型参数不断迭代,最终获取最优参数,从而达到最小化平方误差。

二、实现原理

1、matlab高斯牛顿算法是利用牛顿迭代法求解参数。

牛顿法的迭代过程中,采用“梯度下降法”的概念,逐步减少误差,最终趋近最优解。

2、在迭代过程中,需要求解参数的梯度,此时使用偏导数表来求解。

对于非线性模型,误差即为拟合曲线到样本点距离的平方和,即所谓的二次损失函数,求解参数的梯度,即求此损失函数的偏导数。

3、求解参数的梯度以后,就可以进行参数的迭代更新,根据迭代的结果,可以求出该参数的最优解,即最小二乘法所说的唯一最优参数,此时迭代求解就可以结束。

三、使用步骤

1、首先,使用matlab实现梯度下降法,求出参数的梯度和初值。

2、根据参数的梯度和初值,构建误差函数,求偏导数,以计算梯度方向,然后运用牛顿迭代法,对参数进行更新。

3、使用给定的步长和迭代次数,开始做参数迭代更新,不断的

改变参数的值,寻求最优参数。

4、迭代停止后,获取参数最优值,结束matlab高斯牛顿算法迭代过程。

四、结论

matlab高斯牛顿算法是一种求解非线性回归问题的最优化算法。

其核心思想是根据损失函数的梯度,通过牛顿迭代法,不断更新参数,最终求解出最优参数,从而最小化平方误差。

高斯牛顿迭代法解方程组

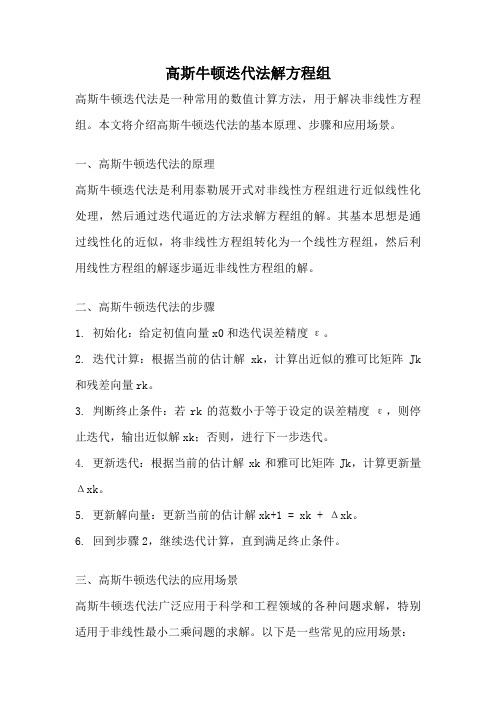

高斯牛顿迭代法解方程组高斯牛顿迭代法是一种常用的数值计算方法,用于解决非线性方程组。

本文将介绍高斯牛顿迭代法的基本原理、步骤和应用场景。

一、高斯牛顿迭代法的原理高斯牛顿迭代法是利用泰勒展开式对非线性方程组进行近似线性化处理,然后通过迭代逼近的方法求解方程组的解。

其基本思想是通过线性化的近似,将非线性方程组转化为一个线性方程组,然后利用线性方程组的解逐步逼近非线性方程组的解。

二、高斯牛顿迭代法的步骤1. 初始化:给定初值向量x0和迭代误差精度ε。

2. 迭代计算:根据当前的估计解xk,计算出近似的雅可比矩阵Jk 和残差向量rk。

3. 判断终止条件:若rk的范数小于等于设定的误差精度ε,则停止迭代,输出近似解xk;否则,进行下一步迭代。

4. 更新迭代:根据当前的估计解xk和雅可比矩阵Jk,计算更新量Δxk。

5. 更新解向量:更新当前的估计解xk+1 = xk + Δxk。

6. 回到步骤2,继续迭代计算,直到满足终止条件。

三、高斯牛顿迭代法的应用场景高斯牛顿迭代法广泛应用于科学和工程领域的各种问题求解,特别适用于非线性最小二乘问题的求解。

以下是一些常见的应用场景:1. 数据拟合:在实际问题中,常常需要根据一组观测数据拟合出一个数学模型。

高斯牛顿迭代法可以通过最小化观测数据与模型之间的误差,来确定最优的模型参数。

2. 图像处理:高斯牛顿迭代法可以用于图像处理中的图像恢复、图像去噪、图像分割等问题的求解。

例如,在图像恢复中,可以利用高斯牛顿迭代法求解出最佳的恢复图像。

3. 机器学习:高斯牛顿迭代法可以用于机器学习中的参数估计和模型训练。

例如,在逻辑回归中,可以使用高斯牛顿迭代法来求解最优的模型参数。

4. 无线通信:高斯牛顿迭代法在无线通信系统中的信道估计、自适应调制等问题的求解中得到广泛应用。

通过迭代计算信道的状态信息,可以提高通信系统的性能。

高斯牛顿迭代法是一种强大的数值计算方法,可以有效地求解非线性方程组。

牛顿壳层定理高斯定理证明

一、引言牛顿壳层定理(Newton's Shell Theorem)和高斯定理(Gauss's Theorem)是电磁学中的两个重要定理。

牛顿壳层定理指出,在静电场中,一个带电体的外部电场与该带电体的形状和大小无关,只与带电体的总电荷有关。

高斯定理则表明,闭合曲面的电通量等于闭合曲面所包围的电荷总量除以真空介电常数。

本文将对这两个定理进行证明。

二、牛顿壳层定理的证明假设有一个带电体,其电荷为Q,形状为任意形状。

为了证明牛顿壳层定理,我们将考虑一个半径为r的球壳,其厚度为dr,且与带电体相切。

根据库仑定律,球壳内外的电场强度分别为:E1 = kQ/(4πε0r^2) (球壳内部)E2 = kQ/(4πε0(r+dr)^2) (球壳外部)其中,k为库仑常数,ε0为真空介电常数。

现在,我们计算球壳内外电场的差异:ΔE = E2 - E1 = kQ[1/(4πε0(r+dr)^2) - 1/(4πε0r^2)]将上式化简得:ΔE = kQdr/(4πε0r^2(r+dr)^2)为了证明牛顿壳层定理,我们需要证明球壳内外电场差异ΔE与r无关。

为此,我们考虑以下极限:lim (ΔE/dr) = lim [kQ/(4πε0r^2(r+dr)^2) dr/dr]由于dr是无穷小量,我们可以将其与dr相消,得到:lim (ΔE/dr) = lim [kQ/(4πε0r^2(r+dr)^2)] = kQ/(4πε0r^4)由此可见,ΔE与r无关,因此牛顿壳层定理得证。

三、高斯定理的证明高斯定理的数学表达式为:∮E·dS = Q_enclosed/ε0其中,E为电场强度,dS为闭合曲面上的面积元素,Q_enclosed为闭合曲面所包围的电荷总量。

为了证明高斯定理,我们考虑一个带电体,其电荷为Q,形状为任意形状。

现在,我们构造一个以带电体为中心,半径为r的闭合曲面S。

根据库仑定律,闭合曲面S上的电场强度E可以表示为:E = kQ/(4πε0r^2) r^2/|r|^3 n其中,r为带电体到闭合曲面S上某点的位置矢量,n为闭合曲面S上该点的单位法向量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

where

1 2

i zj i=1

− h j ( x j , yi ) ,

2

i = zj

1 if yi is of category j , 0 otherwise.

|| x k +1 - x*|| o(|| x k - x*||) || x k - x*|| = lim k→∞ || xk - x*|| = 0

superlinear convergence! (see p. 64)

CONVERGENCE BEHAVIOR OF PURE FORM

g(x) = e x - 1

p(j |y ) = P (object w/ feature vector y is of category j ) Assign object with feature vector y to category j ∗ (y ) = arg max p(j |y ). • If p(j |y ) are unknown, we can estimate them using functions hj (xj , y ) parameterized by vectors xj . Obtain xj by minimizing

m

1 2

zi − h(x, yi )

i=1

2

• Example of a linear model: Fit the data pairs by a cubic polynomial approximation. Take h(x, y ) = x3 y 3 + x2 y 2 + x1 y + x0 , where x = (x0 , x1 , x2 , x3 ) is the vector of unknown coefficients of the cubic polynomial.

r

min

i =1

|| zi − h ( xi , yi ) ||2

THE GAUSS-NEWTON METHOD • Idea: Linearize around the current point xk g ˜(x, xk ) = g (xk ) + ∇g (xk ) (x − xk ) and minimize the norm of the linearized function g ˜: xk+1 = arg min n

−1 2 k ∇ f (x ) ∇f ( x k )

− Very fast when it converges (how fast?) − May not converge (or worse, it may not be defined) when started far from a nonsingular local min − Issue: How to modify the method so that it converges globally, while maintaining the fast convergence rate

dk

=−

∇2 f ( x k )

+

−1 k ∆ ∇f ( x k ) ,

whenever the Newton direction does not exist or is not a descent direction. Here ∆k is a diagonal matrix such that ∇ 2 f ( x k ) + ∆k ≥ 0 − Modified Cholesky factorization − Trust region methods

Model Construction – Curve Fitting:

x∈ y∈ z∈

n p r

unknown parameters model's input model's output

assume z = h ( x, y ), h a known function Problem: find x that matches best the data, i.e., that minimizes the sum of squared errors:

k 0 1 2 3 4000 - 0.63212 0.71828 1.05091 0.20587 0.22859 0.01981 0.02000 0.00019 0.00019 0.00000 0.00000

x0 = -1

0

x2

x1

x

g(x)

x3

x1

0

x0

x2

x

MODIFICATIONS FOR GLOBAL CONVERGENCE • Use a stepsize • Modify the Newton direction when: − Hessian is not positive definite − When Hessian is nearly singular (needed to improve performance) • Use

NEURAL NETS • Nonlinear model construction with multilayer perceptrons • x of the vector of weights • Universal approximation property

PATTERN CLASSIFICATION • Objects are presented to us, and we wish to classify them in one of s categories 1, . . . , s, based on a vector y of their features. • Classical maximum posterior probability approach: Assume we know

• Global Convergence

NEWTON’S METHOD

xk+1

=

xk

−

αk

−1 2 k ∇ f (x ) ∇f ( x k )

assuming that the Newton direction is defined and is a direction of descent • Pure form of Newton’s method (stepsize = 1) xk+1 = xk −

i

ψi = arg min n

x∈ j =1

g ˜j (x, ψj −1 ) 2 , i = 1, . . . , m,

where g ˜j are the linearized functions g ˜j (x, ψj −1 ) = gj (ψj −1 )+∇gj (ψj −1 ) (x−ψj −1 )

2

xk+1 = Arg Min

x∈ n

1/2|| g (x, xk)||2

|| g (x, xk)||2 = ||g(xk)||2 + 2 g(xk)’ ∇g(xk)’ (x-xk) +(x-xk)’ ∇g(xk) ∇g(xk)’ (x-xk) is min at xk+1 when its gradient is 0: 2 ∇g(xk) g(xk) + 2 ∇g(xk) ∇g(xk)’ (xk+1 -xk) = 0 or, if ∇g(xk) ∇g(xk)’ is invertible: (xk+1-xk) = - [∇g(xk) ∇g(xk)’]-1 ∇g(xk) g(xk) , i.e., xk+1= xk - [∇g(xk) ∇g(xk)’]-1 ∇g(xk) g(xk) .

x∈

1 2

g ˜(x, xk )

2 −1

=

xk −

∇g ( x k ) ∇g ( x k )

∇g ( xk ) g ( x k )

• The direction − ∇g ( x k ) ∇g ( x k )

−1

∇g ( xk ) g ( x k )

is a descent direction since ∇g (xk )g (xk ) = ∇ (1/2) g (x) ∇g ( x k ) ∇ g ( x k ) > 0

LEAST-SQUARES PROBLEMS

m

minimize subject to

f ( x) = x∈

1 2

g ( x)

2

=

1 2

g i ( x)

i=1

2

n, n

where g = (g1 , . . . , gm ), gi :

→

ri .

• Many applications: − Model Construction – Curve Fitting − Neural Networks − Pattern Classification

MODEL CONSTRUCTION • Given set of m input-output data pairs (yi , zi ), i = 1, . . . , m, from the physical system

• Hypothesize an input/output relation z = h(x, y ), where x is a vector of unknown parameters, and h is known • Find x that matches best the data in the sense that it minimizes the sum of squared errors

−1

− If g (x) = ∇f (x), we get pure form of Newton