随机森林原理解释及其中各个参数的含义中文解释

随机森林的原理及分析结果

随机森林的原理及分析结果

随机森林是一种集成学习方法,它结合了多个决策树模型来进行预测和分类。

随机森林的原理如下:

1. 随机选择样本:从训练数据集中随机选择一个子集作为训练样本。

这意味着每个决策树模型都是使用一个不同的训练样本。

2. 随机选择特征:对于每个决策树模型,从所有特征中随机选择一部分特征进行特征选择,这有助于减少过拟合。

3. 构建多个决策树:基于随机选择的样本和特征,在每个子集上构建决策树模型。

4. 组合决策树:将多个决策树模型组合起来进行预测和分类,通常采用投票机制或取平均值的方式来决定最终的预测结果。

随机森林的分析结果一般包括以下几个方面:

1. 特征的重要性:随机森林可以给出每个特征的重要性指标,用来评估特征对预测结果的影响程度。

2. 预测结果:随机森林可以给出对测试数据的预测结果,以及每个样本被分类

到每个类别的概率。

3. 过拟合检测:随机森林可以用来判断模型是否出现过拟合,例如通过观察训练数据和测试数据上的性能表现来判断模型的泛化能力。

4. 可解释性:随机森林模型通过多个决策树的组合,可以提供更好的可解释性,可以解释每个决策树是如何做出判断的。

总之,随机森林能够提供对各个特征的重要性、预测结果、过拟合检测以及模型的可解释性等方面的分析结果。

randomforest随机森林 参数

randomforest随机森林参数

Random Forest(随机森林)参数

Random Forest(随机森林)是一种基于决策树的集成学习(ensemble learning)方法,通过构建多个决策树,将它们拼接在一起,从而形成一个强有力的、具有良好泛化能力的决策树模型。

它非常适合做分类和回归任务。

Random Forest有如下重要参数:

1. n_estimators:决策树的数量,即构建森林时使用的树的数量,默认值为10 。

2. max_features:决策树每次生成时,所使用的最大特征数量,默认值为None,也可以设置一个整数或者浮点数。

3. min_samples_split:决策树中每个节点最少需要分割的样本数,默认值为2。

4. min_samples_leaf:决策树每个叶子节点所需要的最少样本数,默认值为1。

5. max_depth:决策树深度,即从根节点到叶子节点的最大分入数量,如果为None,则节点的深度将不受限,默认值为None。

6. bootstrap:是否有放回的采样,默认值为True,即有放回采样。

7. criterion:决策树所使用的评价准则,默认值为“gini”,也可以选择“entropy”。

8. oob_score:是否使用袋外数据来估计泛化精度,默认值为

False,即不使用袋外数据。

随机森林通俗理解

随机森林通俗理解

随机森林通俗理解:

随机森林(Random Forests)是一种分类和回归的机器学习方法,它是对决策树的扩展,由多个决策树组成,它们具有强大的泛化能力,可以处理非线性问题。

这种方法可以帮助我们更好地理解数据,并有效地预测未来结果。

随机森林最早由Breiman于2001年提出,其核心思想是基于多个决策树的集成方法,即将多个决策树结合起来,以期得到更准确的预测结果。

随机森林的优势在于,它不仅可以提供准确的预测,而且还可以衡量特征的相关性,从而发现数据中的模式。

随机森林的工作原理如下:

1、首先,从原始数据集中抽取N个子数据集,每个子数据集包含M个特征,每个特征都有K个不同的值;

2、然后,使用每个子数据集训练一棵决策树,每棵树都可以根据训练数据生成一组预测结果;

3、最后,将每棵树的预测结果汇总,用来预测新的数据。

因此,随机森林的工作原理就是在训练数据上训练多个决策树,然后将它们的预测结果汇总,从而提高预测精度。

随机森林的优势如下:

1、随机森林的泛化能力很强:它比单个决策树的泛化能力要强,降低了过拟合的风险;

2、随机森林能够处理非线性问题;

3、随机森林可以检测特征之间的相关性,从而发现数据中的隐藏模式;

4、随机森林运行效率较高,可以解决大数据集的问题。

总之,随机森林是一种强大的机器学习方法,它可以有效地处理大型数据集,改善模型的泛化能力,还可以检测特征之间的相关性,从而发现数据中的隐藏模式。

随机森林原理解释及其中各个参数的含义中文解释

随机森林原理解释及其中各个参数的含义中文解释随机森林(Random Forest)是一种集成学习算法,它结合了决策树和随机性的概念,能够用于分类和回归问题。

随机森林通过构建多棵决策树,并基于“投票”或“平均”策略来做出最终预测。

以下是对随机森林的原理和各个参数的中文解释。

随机森林的原理包括两个主要部分:随机性构建决策树和投票或平均策略。

1.随机性构建决策树:随机森林中的每棵决策树都是以随机取样方式构建的。

首先,从原始数据集中有放回地随机抽取一些样本(称为bootstrap样本),然后使用这些bootstrap样本构建一棵决策树。

这种随机抽样与替换的方式能够保证每个决策树都有一定的差异性。

2.投票或平均策略:对于分类问题,随机森林中的每棵决策树都会根据样本特征做出预测。

最后,根据“投票”策略,所有决策树的预测结果中得票最多的类别被认定为最终的预测结果。

对于回归问题,随机森林中的每棵决策树都会输出一个数值结果,最后取所有决策树输出结果的平均值作为最终预测结果。

随机森林参数解释:随机森林有许多参数可以调节,以下是其中一些重要参数的中文解释:1. n_estimators(决策树数量):决策树的数量,也就是随机森林中包含的决策树的个数。

n_estimators参数越大,随机森林的性能可能会更好,但是计算开销也会增加。

2. max_depth(最大深度):决策树的最大深度限制,用于控制决策树的复杂度。

较小的最大深度可以减少过拟合的风险,但可能导致欠拟合。

3. min_samples_split(内部节点最少样本数):决定是否需要进一步拆分内部节点的最小样本数。

当样本数量小于min_samples_split时,节点将不再拆分,成为叶节点。

4. min_samples_leaf(叶节点最小样本数):叶节点中需要含有的最少样本数。

当样本数量小于min_samples_leaf时,样本将和同类别的样本一起作为一个叶节点。

随机森林的原理分析

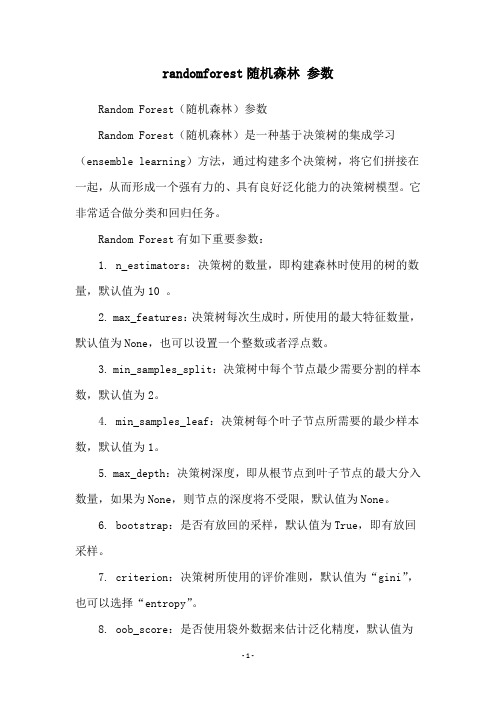

随机森林的原理分析集成~依赖~单元~投票~拟合~抗噪~⽣长~袋外⾼⼤并重~噪多基~串~投~敏~同~⽅⼀、优势互补: RF属于集成学习,集成学习通过构建并结合多个分类器来完成学习任务,常可获得⽐单⼀学习器更好的泛化性能 ⼀个简单例⼦:在⼆分类任务中,假定三个分类器在三个测试样本上的表现如下图,其中√表⽰分类正确,×表⽰分类错误,集成学习的结果通过投票法产⽣,即“少数服从多数”。

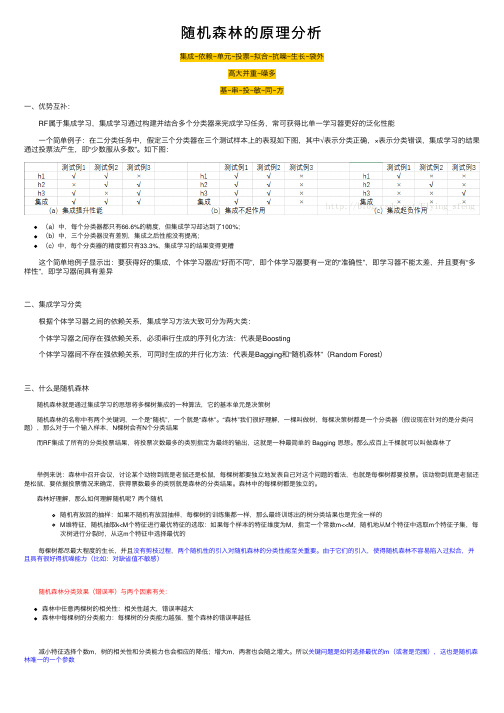

如下图:(a)中,每个分类器都只有66.6%的精度,但集成学习却达到了100%;(b)中,三个分类器没有差别,集成之后性能没有提⾼;(c)中,每个分类器的精度都只有33.3%,集成学习的结果变得更糟 这个简单地例⼦显⽰出:要获得好的集成,个体学习器应“好⽽不同”,即个体学习器要有⼀定的“准确性”,即学习器不能太差,并且要有“多样性”,即学习器间具有差异⼆、集成学习分类 根据个体学习器之间的依赖关系,集成学习⽅法⼤致可分为两⼤类: 个体学习器之间存在强依赖关系,必须串⾏⽣成的序列化⽅法:代表是Boosting 个体学习器间不存在强依赖关系,可同时⽣成的并⾏化⽅法:代表是Bagging和“随机森林”(Random Forest)三、什么是随机森林 随机森林就是通过集成学习的思想将多棵树集成的⼀种算法,它的基本单元是决策树 随机森林的名称中有两个关键词,⼀个是“随机”,⼀个就是“森林”。

“森林”我们很好理解,⼀棵叫做树,每棵决策树都是⼀个分类器(假设现在针对的是分类问题),那么对于⼀个输⼊样本,N棵树会有N个分类结果 ⽽RF集成了所有的分类投票结果,将投票次数最多的类别指定为最终的输出,这就是⼀种最简单的 Bagging 思想。

那么成百上千棵就可以叫做森林了 举例来说:森林中召开会议,讨论某个动物到底是⽼⿏还是松⿏,每棵树都要独⽴地发表⾃⼰对这个问题的看法,也就是每棵树都要投票。

该动物到底是⽼⿏还是松⿏,要依据投票情况来确定,获得票数最多的类别就是森林的分类结果。

随机森林原理解释及其中各个参数的含义中文解释

一、RF原理解释:首先,从给定的训练集通过多次随机的可重复的采样得到多个 bootstrap 数据集。

接着,对每个 bootstrap 数据集构造一棵决策树,构造是通过迭代的将数据点分到左右两个子集中实现的,这个分割过程是一个搜索分割函数的参数空间以寻求最大信息增量意义下最佳参数的过程。

然后,在每个叶节点处通过统计训练集中达到此叶节点的分类标签的直方图经验的估计此叶节点上的类分布。

这样的迭代训练过程一直执行到用户设定的最大树深度(随机森林提出者Breiman采用的是ntree=500)或者直到不能通过继续分割获取更大的信息增益为止,网上的代码中作者都是对树的最大深度设置了最大值。

二、函数,参数的中文解释function model = classRF_train(X,Y,ntree,mtry, extra_options)随机森林中模型的训练X,表示输入的数据矩阵Y输出Ntree 设置的树的数目Mtry的默认值为floor(sqrt(size(X,2)),表示不超过矩阵X列数的二次开根值的整数。

extra_options 包含很多控制RF的项extra_options.replace 取值为1或0,默认值为1,表示是否做变量替换extra_options.classwt 表示预先知道的类,函数首先得到一个升序排列的标签然后给先前的类同样的排序。

extra_options.cutoff 只在分类器中使用的一个向量,长度等于类的数目。

对类的观察值是取对cutoff投票占的的最大比例的一个。

extra_options.strata 用于分层抽样extra_options.sampsize 样本的长度extra_options.nodesize 表示终端节点的最小值,这个参数设置得越大会使更小的树生长,耗时更少。

extra_options.importance 判断是否需要对预测器的importance进行评估extra_options.localImp 决定是否对casewise的重要性度量进行计算extra_options.proximity 判别是否计算行之间的距离extra_options.oob_prox 判断是否计算out-of-bagextra_options.do_trace 如果设定为TRUE,当随机森林运行的时候输出更多冗长的数据。

randomforestclassifier参数量统计-概述说明以及解释

randomforestclassifier参数量统计-概述说明以及解释1.引言1.1 概述随着机器学习领域的不断发展,Random Forest Classifier(随机森林分类器)作为一种强大的分类算法,在解决各种复杂的分类问题中受到广泛关注。

随机森林算法的优势在于它能够处理高维数据和大规模数据集,同时具有良好的鲁棒性和准确性。

在本文中,我们将重点关注Random Forest Classifier算法中的参数量统计部分。

通过对算法中各种参数的详细介绍和统计分析,我们将深入探讨这些参数对算法性能的影响,并为算法的优化提供参考依据。

通过本文的研究,我们希望能够更加全面地了解Random Forest Classifier算法的参数特性,从而提高对算法的理解和应用能力。

同时,我们也将为相关领域的研究和实践工作提供一定的参考和借鉴价值。

1.2 文章结构:本文主要分为三个部分,包括引言、正文和结论。

在引言部分,将会对Random Forest Classifier进行简要介绍,并对文章的结构和目的进行说明。

在正文部分,将首先介绍Random Forest Classifier的基本概念和原理,然后详细介绍各个参数的作用和意义,并对参数量进行统计和分析。

在结论部分,将对文章进行总结归纳,展望未来对Random Forest Classifier参数优化的研究方向,以及对研究意义进行探讨。

1.3 目的本文旨在对Random Forest Classifier模型中的参数进行统计分析,了解各个参数在模型中的作用和影响。

通过对参数量的统计,可以帮助读者更好地理解Random Forest Classifier模型的构建过程和调参方法,进一步提升模型的性能和准确度。

同时,通过对参数量的研究,也可以为后续深入探讨Random Forest Classifier模型的优化和改进提供有益的参考。

通过本文的研究,希望能够为读者提供一定的参考价值,促进Random Forest Classifier模型在实际应用中的更广泛和深入的应用。

机器学习——随机森林,RandomForestClassifier参数含义详解

机器学习——随机森林,RandomForestClassifier参数含义详解1.随机森林模型

1 clf = RandomForestClassifier(n_estimators=200, criterion='entropy', max_depth=4)

2 rf_clf = clf.fit(x, y.ravel())

RandomForestClassifier函数的参数含义详解:

max_features:随机森林允许单个决策树使⽤特征的最⼤数量。

Python为最⼤特征数提供了多个可选项。

下⾯是其中的⼏个:

Auto/None :简单地选取所有特征,每颗树都可以利⽤他们。

这种情况下,每颗树都没有任何的限制。

sqrt :此选项是每颗⼦树可以利⽤总特征数的平⽅根个。

例如,如果变量(特征)的总数是100,所以每颗⼦树只能取其中的10个。

“log2”是另⼀种相似类型的选项。

0.2:此选项允许每个随机森林的⼦树可以利⽤变量(特征)数的20%。

如果想考察的特征x%的作⽤,我们可以使⽤“0.X”的格式。

n_estimators:在利⽤最⼤投票数或平均值来预测之前,你想要建⽴⼦树的数量。

较多的⼦树可以让模型有更好的性能,但同时让你的代码变慢。

你应该选择尽可能⾼的值,只要你的处理器能够承受的住,因为这使你的预测更好更稳定。

其他参数还包括决策树模型的系列参数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一、RF原理解释:

首先,从给定的训练集通过多次随机的可重复的采样得到多个 bootstrap 数据集。

接着,对每个 bootstrap 数据集构造一棵决策树,构造是通过迭代的将数据点分到左右两个子集中实现的,这个分割过程是一个搜索分割函数的参数空间以寻求最大信息增量意义下最佳参数的过程。

然后,在每个叶节点处通过统计训练集中达到此叶节点的分类标签的直方图经验的估计此叶节点上的类分布。

这样的迭代训练过程一直执行到用户设定的最大树深度(随机森林提出者Breiman采用的是ntree=500)或者直到不能通过继续分割获取更大的信息增益为止,网上的代码中作者都是对树的最大深度设置了最大值。

二、函数,参数的中文解释

function model = classRF_train(X,Y,ntree,mtry, extra_options)

随机森林中模型的训练

X,表示输入的数据矩阵

Y输出

Ntree 设置的树的数目

Mtry的默认值为

floor(sqrt(size(X,2)),表示不超过矩阵X列数的二次开根值的整数。

extra_options 包含很多控制RF的项

取值为1或0,默认值为1,表示是否做变量替换

表示预先知道的类,函数首先得到一个升序排列的标签然后给先前的类同样的排序。

只在分类器中使用的一个向量,长度等于类的数目。

对类的观察值是取对cutoff投票占的的最大比例的一个。

用于分层抽样

样本的长度

表示终端节点的最小值,这个参数设置得越大会使更小的树生长,耗时更少。

判断是否需要对预测器的importance进行评估

决定是否对casewise的重要性度量进行计算

判别是否计算行之间的距离

判断是否计算out-of-bag

如果设定为TRUE,当随机森林运行的时候输出更多冗长的数据。

如果设置为一些整数,输出每个追踪树。

通过树的数目矩阵跟踪每个样本在树上的in-bag。

norm_votes 统计每一类的投票数

importance 对于分类器来说是一个列数等于类别数加二,第一列计算精度下降值。

在ncalss+1列表示所有类平均精度减少值。

最后一列表示Gini指数平均减小值。

在随机森林用于回归的应用中importance表示的含义又不一样,我们只用到分类的作用,所以对回归的含义不做介绍。

importanceSD 标准差

localImp 包含importance标准化残差测量值的矩阵

ntree 生长的树的数目

mtry 在每一个分裂节点处样本预测器的个数。

Votes 一个矩阵,行表示每一个输入数据点,列表示每一类,记录投票数。

Proximity 如果proximity=TRUE表示随机森林被调用。

Combine 把树结合起来

getTree(rfobj, k=1, labelVar=FALSE),这个函数的作用是从随机森林中提取树的结构,rfob 表示对应的随机森林,k 表示要提取的那棵树,, labelVar 表示是否是最好的标签用于变量分离和类的预测。

在分类器预测中分裂点用整数表示,比如预测器如果有四个参数,分裂点是十三,就表示成()因为3

2102*12*12*02*113+++=

if labelVar=TRUE) 一个列数为六,行数等于树中节点总数的矩阵。

六列分别为:left daughter ,如果是末端左子女节点取值为0。

right daughter ,如果这个右子节点是末端节点则取值为零。

split var 表示哪个变量用来分裂节点,如果是末端节点则取零。

split point 表示最佳分裂的位置。

Status 是否是终端节点-1/1. Prediction 对节点的预测 用0表示还没有到达终端节点。

grow(x, , ...) 给现有的树的群体增加新的额外的树。

X 表示随机森林的类,表示增加到随机森林x 中的树的个数。

importance(x, type=NULL, class=NULL, scale=TRUE, ...) x 表示随机森林中的类,type 表示测量的类型,取值为1的时候表示不准确度,取值为2的时候表示节点不纯度测量。

Class 返回值表示哪一个具体的类被测量了。

Scale 对测量值进行变换,求他们的标准差。

对于分类器来说,节点不纯度是通过Gini 系数求解的。

返回值为一个矩阵,行表示每个预测变量,列表示不同的importance 测量值。

margin(x, ...) 从随机森林分类器中计算或绘制预测器的边缘。

MDSplot(rf, fac, k=2, palette=NULL, pch=20, ...) 随机森林中相似矩阵的多维测量。

rf 表示包含近邻成分的随机森林的类。

Fac 训练rf 的一个响应值。

k 表示伸缩坐标的维数。

Palette 用颜色要区分不同的类。

outlier(x, cls=NULL, ...) 基于相似矩阵计算无关测量值。

x 指的是相似矩阵。

Cls 表示相似矩阵所在的行属于的类。

如果没有给出,则默认为所有数据来自同一个类。

partialPlot(x, , , , w, plot = TRUE, add = FALSE, = min(length(unique[, xname])), 51), rug = TRUE, xlab=deparse(substitute), ylab="", main=paste("Partial Dependence on", deparse(substitute)), ...) 用图表描述局部的一个变量对类的概率的边缘效应。

plot(x, type="l", main=deparse(substitute(x)), ...)计算错误率

predict(object, newdata, type="response",=TRUE, =FALSE, proximity=FALSE,

nodes=FALSE,cutoff, ...) 用随机森林预测测试数据。

Object 表示随机森林类的对象,由随机森林函数创建。

Newdata 表示包含新数据的数据帧或者矩阵。

可表示响应,概率,票数,指输出的类型。

Nodes 判断是否是终点。

Proximity 判断是否需要进行近邻测量。

判断是否保留所有的预测器。

randomForest(x, y=NULL, xtest=NULL, ytest=NULL, ntree=500, mtry=if (!(y) && !(y))

max(floor(ncol(x)/3), 1) else floor(sqrt(ncol(x))), replace=TRUE, classwt=NULL, cutoff, strata, sampsize = if (replace) nrow(x) else ceiling(.632*nrow(x)), nodesize = if (!(y) && !(y)) 5 else 1,

maxnodes = NULL, importance=FALSE, localImp=FALSE, nPerm=1, proximity, =proximity, =TRUE, =FALSE, =!(y) && (xtest), =FALSE, =FALSE, ...)

data是一个可选的数据帧,包含模型中的变量。

Subset是一个指示量表示哪一行应该被使用。

Xtest测试集,

ytest表示对测试集的输出,

Cutoff 是一个长度等于类的数目的向量。

被预测的类是投票给cutoff投票率最高的一个类。

treesize(x, terminal=TRUE)表示数的宽度。