BP神经网络实验详解(MATLAB实现)

基于遗传算法的BP神经网络MATLAB代码

基于遗传算法的BP神经网络MATLAB代码以下是基于遗传算法的BP神经网络的MATLAB代码,包括网络初始化、适应度计算、交叉运算、突变操作和迭代训练等。

1.网络初始化:```matlabfunction net = initialize_network(input_size, hidden_size, output_size)net.input_size = input_size;net.hidden_size = hidden_size;net.output_size = output_size;net.hidden_weights = rand(hidden_size, input_size);net.output_weights = rand(output_size, hidden_size);net.hidden_biases = rand(hidden_size, 1);net.output_biases = rand(output_size, 1);end```2.适应度计算:```matlabfunction fitness = calculate_fitness(net, data, labels)output = forward_propagation(net, data);fitness = sum(sum(abs(output - labels)));end```3.前向传播:```matlabfunction output = forward_propagation(net, data)hidden_input = net.hidden_weights * data + net.hidden_biases;hidden_output = sigmoid(hidden_input);output_input = net.output_weights * hidden_output +net.output_biases;output = sigmoid(output_input);endfunction result = sigmoid(x)result = 1 ./ (1 + exp(-x));end```4.交叉运算:```matlabfunction offspring = crossover(parent1, parent2)point = randi([1 numel(parent1)]);offspring = [parent1(1:point) parent2((point + 1):end)]; end```5.突变操作:```matlabfunction mutated = mutation(individual, mutation_rate) for i = 1:numel(individual)if rand < mutation_ratemutated(i) = rand;elsemutated(i) = individual(i);endendend```6.迭代训练:```matlabfunction [best_individual, best_fitness] =train_network(data, labels, population_size, generations, mutation_rate)input_size = size(data, 1);hidden_size = round((input_size + size(labels, 1)) / 2);output_size = size(labels, 1);population = cell(population_size, 1);for i = 1:population_sizepopulation{i} = initialize_network(input_size, hidden_size, output_size);endbest_individual = population{1};best_fitness = calculate_fitness(best_individual, data, labels);for i = 1:generationsfor j = 1:population_sizefitness = calculate_fitness(population{j}, data, labels);if fitness < best_fitnessbest_individual = population{j};best_fitness = fitness;endendselected = selection(population, data, labels);for j = 1:population_sizeparent1 = selected{randi([1 numel(selected)])};parent2 = selected{randi([1 numel(selected)])};offspring = crossover(parent1, parent2);mutated_offspring = mutation(offspring, mutation_rate);population{j} = mutated_offspring;endendendfunction selected = selection(population, data, labels) fitnesses = zeros(length(population), 1);for i = 1:length(population)fitnesses(i) = calculate_fitness(population{i}, data, labels);end[~, indices] = sort(fitnesses);selected = population(indices(1:floor(length(population) / 2)));end```这是一个基于遗传算法的简化版BP神经网络的MATLAB代码,使用该代码可以初始化神经网络并进行迭代训练,以获得最佳适应度的网络参数。

BP神经网络原理及其MATLAB应用

BP神经网络原理及其MATLAB应用BP神经网络(Back Propagation Neural Network)是一种基于梯度下降算法的人工神经网络模型,具有较广泛的应用。

它具有模拟人类神经系统的记忆能力和学习能力,可以用来解决函数逼近、分类和模式识别等问题。

本文将介绍BP神经网络的原理及其在MATLAB中的应用。

BP神经网络的原理基于神经元间的权值和偏置进行计算。

一个标准的BP神经网络通常包含三层:输入层、隐藏层和输出层。

输入层负责接收输入信息,其节点数与输入维度相同;隐藏层用于提取输入信息的特征,其节点数可以根据具体问题进行设定;输出层负责输出最终的结果,其节点数根据问题的要求决定。

BP神经网络的训练过程可以分为前向传播和反向传播两个阶段。

前向传播过程中,输入信息逐层传递至输出层,通过对神经元的激活函数进行计算,得到神经网络的输出值。

反向传播过程中,通过最小化损失函数的梯度下降算法,不断调整神经元间的权值和偏置,以减小网络输出与实际输出之间的误差,达到训练网络的目的。

在MATLAB中,可以使用Neural Network Toolbox工具箱来实现BP神经网络。

以下是BP神经网络在MATLAB中的应用示例:首先,需导入BP神经网络所需的样本数据。

可以使用MATLAB中的load函数读取数据文件,并将其分为训练集和测试集:```data = load('dataset.mat');inputs = data(:, 1:end-1);targets = data(:, end);[trainInd, valInd, testInd] = dividerand(size(inputs, 1), 0.6, 0.2, 0.2);trainInputs = inputs(trainInd, :);trainTargets = targets(trainInd, :);valInputs = inputs(valInd, :);valTargets = targets(valInd, :);testInputs = inputs(testInd, :);testTargets = targets(testInd, :);```接下来,可以使用MATLAB的feedforwardnet函数构建BP神经网络模型,并进行网络训练和测试:```hiddenLayerSize = 10;net = feedforwardnet(hiddenLayerSize);net = train(net, trainInputs', trainTargets');outputs = net(testInputs');```最后,可以使用MATLAB提供的performance函数计算网络的性能指标,如均方误差、相关系数等:```performance = perform(net, testTargets', outputs);```通过逐步调整网络模型的参数和拓扑结构,如隐藏层节点数、学习率等,可以进一步优化BP神经网络的性能。

BP神经网络matlab教程

w

N 1 ho

w o (k )hoh (k )

N ho

2.4.2 BP网络的标准学习算法

第七步,利用隐含层各神经元的 h (k )和 输入层各神经元的输入修正连接权。

e e hih (k ) wih (k ) h (k ) xi (k ) wih hih (k ) wih w

p

i 1

h 1,2,

o 1,2,

,p

q

yio (k ) whohoh (k ) bo

o 1,2,

yoo (k ) f( yio (k ))

h 1

q

2.4.2 BP网络的标准学习算法

第四步,利用网络期望输出和实际输出, 计算误差函数对输出层的各神经元的偏导 o (k ) 数 。 ( w ho (k ) b ) e e yio yi (k )

输入样本---输入层---各隐层---输出层

判断是否转入反向传播阶段:

若输出层的实际输出与期望的输出(教师信号)不 符

误差反传

误差以某种形式在各层表示----修正各层单元 的权值

网络输出的误差减少到可接受的程度 进行到预先设定的学习次数为止

2.4.2 BP网络的标准学习算法

网络结构 输入层有n个神经元,隐含层有p个神经元, 输出层有q个神经元 变量定义 x x1, x2 , , xn 输入向量; 隐含层输入向量; hi hi1 , hi2 , , hi p 隐含层输出向量; ho ho1 , ho2 , , ho p 输出层输入向量; yi yi1 , yi2 , , yiq 输出层输出向量; yo yo1 , yo2 , , yoq 期望输出向量; d o d1 , d 2 , , d q

BP神经网络matlab实现的基本步骤

1、数据归一化2、数据分类,主要包括打乱数据顺序,抽取正常训练用数据、变量数据、测试数据3、建立神经网络,包括设置多少层网络(一般3层以内既可以,每层的节点数(具体节点数,尚无科学的模型和公式方法确定,可采用试凑法,但输出层的节点数应和需要输出的量个数相等),设置隐含层的传输函数等。

关于网络具体建立使用方法,在后几节的例子中将会说到。

4、指定训练参数进行训练,这步非常重要,在例子中,将详细进行说明5、完成训练后,就可以调用训练结果,输入测试数据,进行测试6、数据进行反归一化7、误差分析、结果预测或分类,作图等数据归一化问题归一化的意义:首先说一下,在工程应用领域中,应用BP网络的好坏最关键的仍然是输入特征选择和训练样本集的准备,若样本集代表性差、矛盾样本多、数据归一化存在问题,那么,使用多复杂的综合算法、多精致的网络结构,建立起来的模型预测效果不会多好。

若想取得实际有价值的应用效果,从最基础的数据整理工作做起吧,会少走弯路的。

归一化是为了加快训练网络的收敛性,具体做法是:1 把数变为(0,1)之间的小数主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

2 把有量纲表达式变为无量纲表达式归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量比如,复数阻抗可以归一化书写:Z = R + jωL = R(1 + jωL/R) ,复数部分变成了纯数量了,没有量纲。

另外,微波之中也就是电路分析、信号系统、电磁波传输等,有很多运算都可以如此处理,既保证了运算的便捷,又能凸现出物理量的本质含义。

神经网络归一化方法:由于采集的各数据单位不一致,因而须对数据进行[-1,1]归一化处理,归一化方法主要有如下几种,供大家参考:1、线性函数转换,表达式如下:复制内容到剪贴板代码:y=(x-MinValue)/(MaxValue-MinValue)说明:x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最大值和最小值。

实验一、BP及RBP神经网络逼近

实验一、BP及RBF神经网络逼近一、实验目的1、了解MATLAB集成开发环境2、了解MATLAB编程基本方法3、熟练掌握BP算法的原理和步骤4、掌握工具包入口初始化及调用5、加深BP、RBF神经网络对任意函数逼近的理解二、实验内容1、MATLAB基本指令和语法。

2、BP算法的MATLAB实现三、实验步骤1、熟悉MATLAB开发环境2、输入参考程序3、设置断点,运行程序,观察运行结果四、参考程序1. BP算法的matlab实现程序%lr为学习步长,err_goal期望误差最小值,max_epoch训练的最大次数,隐层和输出层初值为零lr=0.05;err_goal=0.0001;max_epoch=10000;a=0.9;Oi=0;Ok=0;%两组训练集和目标值X=[1 1;-1 -1;1 1];T=[1 1;1 1];%初始化wki,wij(M为输入节点j的数量;q为隐层节点i的数量;L为输出节点k的数量)[M,N]=size(X);q=8;[L,N]=size(T);wij=rand(q,M);wki=rand(L,q);wij0=zeros(size(wij));wki0=zeros(size(wki));for epoch=1:max_epoch%计算隐层各神经元输出NETi=wij*X;for j=1:Nfor i=1:qOi(i,j)=2/(1+exp(-NETi(i,j)))-1;endend%计算输出层各神经元输出NETk=wki*Oi;for i=1:Nfor k=1:LOk(k,i)=2/(1+exp(-NETk(k,i)))-1;endend%计算误差函数E=((T-Ok)'*(T-Ok))/2;if (E<err_goal)break;end%调整输出层加权系数deltak=Ok.*(1-Ok).*(T-Ok);w=wki;wki=wki+lr*deltak*Oi';wki0=w;%调整隐层加权系数deltai=Oi.*(1-Oi).*(deltak'*wki)';w=wij;wij=wij+lr*deltai*X';wij0=w;endepoch %显示计算次数%根据训练好的wki,wij和给定的输入计算输出X1=X;%计算隐层各神经元的输出NETi=wij*X1;for j=1:Nfor i=1:qOi(i,j)=2/(1+exp(-NETi(i,j)))-1;endend%计算输出层各神经元的输出NETk=wki*Oi;for i=1:Nfor k=1:LOk(k,i)=2/(1+exp(-NETk(k,i)))-1;endendOk %显示网络输出层的输出2、BP逼近任意函数算法的matlab实现程序⏹X=-4:0.08:4;⏹T=1.1*(1-X+2*X.^2).*exp(-X.^2./2);⏹net=newff(minmax(X),[20,1],{'tansig','purelin'});⏹net.trainParam.epochs=15000;⏹net.trainParam.goal=0.001;⏹net=train(net,X,T);⏹X1=-1:0.01:1;⏹y=sim(net,X1);⏹figure;⏹plot(X1,y,'-r',X,T,':b','LineWidth',2);3.RBF能够逼近任意的非线性函数⏹X=-4:0.08:4;⏹T=1.1*(1-X+2*X.^2).*exp(-X.^2./2);⏹net=newrb(X,T,0.002,1);⏹X1=-1:0.01:1;⏹y=sim(net,X1);⏹figure;⏹plot(X1,y,'-r',X,T,':b','LineWidth',3);五、思考题1. 将结果用图画出。

PSO优化的BP神经网络(Matlab版)

PSO优化的BP神经⽹络(Matlab版)前⾔:最近接触到⼀些神经⽹络的东西,看到很多⼈使⽤PSO(粒⼦群优化算法)优化BP神经⽹络中的权值和偏置,经过⼀段时间的研究,写了⼀些代码,能够跑通,嫌弃速度慢的可以改⼀下训练次数或者适应度函数。

在我的理解⾥,PSO优化BP的初始权值w和偏置b,有点像数据迁徙,等于⽤粒⼦去尝试作为⽹络的参数,然后训练⽹络的阈值,所以总是会看到PSO优化了权值和阈值的说法,(⼀开始我是没有想通为什么能够优化阈值的),下⾯是我的代码实现过程,关于BP和PSO的原理就不⼀⼀赘述了,⽹上有很多⼤佬解释的很详细了……⾸先是利⽤BP作为适应度函数function [error] = BP_fit(gbest,input_num,hidden_num,output_num,net,inputn,outputn)%BP_fit 此函数为PSO的适应度函数% gbest:最优粒⼦% input_num:输⼊节点数⽬;% output_num:输出层节点数⽬;% hidden_num:隐含层节点数⽬;% net:⽹络;% inputn:⽹络训练输⼊数据;% outputn:⽹络训练输出数据;% error : ⽹络输出误差,即PSO适应度函数值w1 = gbest(1:input_num * hidden_num);B1 = gbest(input_num * hidden_num + 1:input_num * hidden_num + hidden_num);w2 = gbest(input_num * hidden_num + hidden_num + 1:input_num * hidden_num...+ hidden_num + hidden_num * output_num);B2 = gbest(input_num * hidden_num+ hidden_num + hidden_num * output_num + 1:...input_num * hidden_num + hidden_num + hidden_num * output_num + output_num);net.iw{1,1} = reshape(w1,hidden_num,input_num);net.lw{2,1} = reshape(w2,output_num,hidden_num);net.b{1} = reshape(B1,hidden_num,1);net.b{2} = B2';%建⽴BP⽹络net.trainParam.epochs = 200;net.trainParam.lr = 0.05;net.trainParam.goal = 0.000001;net.trainParam.show = 100;net.trainParam.showWindow = 0;net = train(net,inputn,outputn);ty = sim(net,inputn);error = sum(sum(abs((ty - outputn))));end 然后是PSO部分:%%基于多域PSO_RBF的6R机械臂逆运动学求解的研究clear;close;clc;%定义BP参数:% input_num:输⼊层节点数;% output_num:输出层节点数;% hidden_num:隐含层节点数;% inputn:⽹络输⼊;% outputn:⽹络输出;%定义PSO参数:% max_iters:算法最⼤迭代次数% w:粒⼦更新权值% c1,c2:为粒⼦群更新学习率% m:粒⼦长度,为BP中初始W、b的长度总和% n:粒⼦群规模% gbest:到达最优位置的粒⼦format longinput_num = 3;output_num = 3;hidden_num = 25;max_iters =10;m = 500; %种群规模n = input_num * hidden_num + hidden_num + hidden_num * output_num + output_num; %个体长度w = 0.1;c1 = 2;c2 = 2;%加载⽹络输⼊(空间任意点)和输出(对应关节⾓的值)load('pfile_i2.mat')load('pfile_o2.mat')% inputs_1 = angle_2';inputs_1 = inputs_2';outputs_1 = outputs_2';train_x = inputs_1(:,1:490);% train_y = outputs_1(4:5,1:490);train_y = outputs_1(1:3,1:490);test_x = inputs_1(:,491:500);test_y = outputs_1(1:3,491:500);% test_y = outputs_1(4:5,491:500);[inputn,inputps] = mapminmax(train_x);[outputn,outputps] = mapminmax(train_y);net = newff(inputn,outputn,25);%设置粒⼦的最⼩位置与最⼤位置% w1阈值设定for i = 1:input_num * hidden_numMinX(i) = -0.01*ones(1);MaxX(i) = 3.8*ones(1);end% B1阈值设定for i = input_num * hidden_num + 1:input_num * hidden_num + hidden_numMinX(i) = 1*ones(1);MaxX(i) = 8*ones(1);end% w2阈值设定for i = input_num * hidden_num + hidden_num + 1:input_num * hidden_num + hidden_num + hidden_num * output_numMinX(i) = -0.01*ones(1);MaxX(i) = 3.8*ones(1);end% B2阈值设定for i = input_num * hidden_num+ hidden_num + hidden_num * output_num + 1:input_num * hidden_num + hidden_num + hidden_num * output_num + output_num MinX(i) = 1*ones(1);MaxX(i) = 8*ones(1);end%%初始化位置参数%产⽣初始粒⼦位置pop = rands(m,n);%初始化速度和适应度函数值V = 0.15 * rands(m,n);BsJ = 0;%对初始粒⼦进⾏限制处理,将粒⼦筛选到⾃定义范围内for i = 1:mfor j = 1:input_num * hidden_numif pop(i,j) < MinX(j)pop(i,j) = MinX(j);endif pop(i,j) > MaxX(j)pop(i,j) = MaxX(j);endendfor j = input_num * hidden_num + 1:input_num * hidden_num + hidden_numif pop(i,j) < MinX(j)pop(i,j) = MinX(j);endif pop(i,j) > MaxX(j)pop(i,j) = MaxX(j);endendfor j = input_num * hidden_num + hidden_num + 1:input_num * hidden_num + hidden_num + hidden_num * output_numif pop(i,j) < MinX(j)pop(i,j) = MinX(j);endif pop(i,j) > MaxX(j)pop(i,j) = MaxX(j);endendfor j = input_num * hidden_num+ hidden_num + hidden_num * output_num + 1:input_num * hidden_num + hidden_num + hidden_num * output_num + output_num if pop(i,j) < MinX(j)pop(i,j) = MinX(j);endif pop(i,j) > MaxX(j)pop(i,j) = MaxX(j);endendend%评估初始粒⼦for s = 1:mindivi = pop(s,:);fitness = BP_fit(indivi,input_num,hidden_num,output_num,net,inputn,outputn);BsJ = fitness; %调⽤适应度函数,更新每个粒⼦当前位置Error(s,:) = BsJ; %储存每个粒⼦的位置,即BP的最终误差end[OderEr,IndexEr] = sort(Error);%将Error数组按升序排列Errorleast = OderEr(1); %记录全局最⼩值for i = 1:m %记录到达当前全局最优位置的粒⼦if Error(i) == Errorleastgbest = pop(i,:);break;endendibest = pop; %当前粒⼦群中最优的个体,因为是初始粒⼦,所以最优个体还是个体本⾝for kg = 1:max_iters %迭代次数for s = 1:m%个体有52%的可能性变异for j = 1:n %粒⼦长度for i = 1:m %种群规模,变异是针对某个粒⼦的某⼀个值的变异if rand(1)<0.04pop(i,j) = rands(1);endendend%r1,r2为粒⼦群算法参数r1 = rand(1);r2 = rand(1);%个体位置和速度更新V(s,:) = w * V(s,:) + c1 * r1 * (ibest(s,:)-pop(s,:)) + c2 * r2 * (gbest(1,:)-pop(s,:));pop(s,:) = pop(s,:) + 0.3 * V(s,:);%对更新的位置进⾏判断,超过设定的范围就处理下。

(完整版)BP神经网络matlab实例(简单而经典)

p=p1';t=t1';[pn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始数据归一化net=newff(minmax(pn),[5,1],{'tansig','purelin'},'traingdx');%设置网络,建立相应的BP网络net.trainParam.show=2000; % 训练网络net.trainParam.lr=0.01;net.trainParam.epochs=100000;net.trainParam.goal=1e-5;[net,tr]=train(net ,pn,tn); %调用TRAINGDM算法训练BP 网络pnew=pnew1';pnewn=tramnmx(pnew,minp,maxp);anewn=sim(net,pnewn); %对BP网络进行仿真anew=postmnmx(anewn,mint,maxt); %还原数据y=anew';1、BP网络构建(1)生成BP网络=net newff PR S S SNl TF TF TFNl BTF BLF PF(,[1 2...],{ 1 2...},,,)PR:由R维的输入样本最小最大值构成的2R⨯维矩阵。

S S SNl:各层的神经元个数。

[ 1 2...]{ 1 2...}TF TF TFNl:各层的神经元传递函数。

BTF:训练用函数的名称。

(2)网络训练[,,,,,] (,,,,,,)=net tr Y E Pf Af train net P T Pi Ai VV TV(3)网络仿真=[,,,,] (,,,,)Y Pf Af E perf sim net P Pi Ai T{'tansig','purelin'},'trainrp'2、BP网络举例举例1、%traingdclear;clc;P=[-1 -1 2 2 4;0 5 0 5 7];T=[-1 -1 1 1 -1];%利用minmax函数求输入样本范围net = newff(minmax(P),T,[5,1],{'tansig','purelin'},'trainrp');net.trainParam.show=50;%net.trainParam.lr=0.05;net.trainParam.epochs=300;net.trainParam.goal=1e-5;[net,tr]=train(net,P,T);net.iw{1,1}%隐层权值net.b{1}%隐层阈值net.lw{2,1}%输出层权值net.b{2}%输出层阈值sim(net,P)举例2、利用三层BP神经网络来完成非线性函数的逼近任务,其中隐层神经元个数为五个。

MATLAB实例:BP神经网络用于回归任务

MATLAB 实例:BP 神经⽹络⽤于回归任务MATLAB 实例:BP 神经⽹络⽤于回归(⾮线性拟合)任务作者:凯鲁嘎吉 - 博客园问题描述给定多元(多维)数据X ,有真实结果Y ,对这些数据进⾏拟合(回归),得到拟合函数的参数,进⽽得到拟合函数,现在进来⼀些新样本,对这些新样本进⾏预测出相应地Y 值。

通常的最⼩⼆乘法进⾏线性拟合并不适⽤于所有数据,对于⼤多数数据⽽⾔,他们的拟合函数是⾮线性的,⼈为构造拟合函数相当困难,没有⼀定的经验积累很难完美的构造出符合条件的拟合函数。

因此神经⽹络在这⾥被应⽤来做回归(拟合)任务,进⼀步⽤来预测。

神经⽹络是很强⼤的拟合⼯具,虽然数学可解释性差,但拟合效果好,因⽽得到⼴泛应⽤。

BP 神经⽹络是最基础的⽹络结构,输⼊层,隐层,输出层,三层结构。

如下图所⽰。

整体的⽬标函数就是均⽅误差L =||f (X )−Y ||22其中(激活函数可以⾃⾏设定)f (X )=purelin W 2⋅tan sig (W 1⋅X +b 1)+b 2N : 输⼊数据的个数D : 输⼊数据的维度D 1: 隐层节点的个数X : 输⼊数据(D *N )Y : 真实输出(1*N )W 1: 输⼊层到隐层的权值(D 1*D )b 1: 隐层的偏置(D 1*1)W 2: 输⼊层到隐层的权值(1*D 1)b 2: 隐层的偏置(1*1)通过给定训练数据与训练标签来训练⽹络的权值与偏置,进⼀步得到拟合函数f (X )。

这样,来了新数据后,直接将新数据X 代⼊函数f (X ),即可得到预测的结果。

y = tansig(x) = 2/(1+exp(-2*x))-1;y = purelin(x) = x ;()MATLAB程序⽤到的数据为UCI数据库的housing数据:输⼊数据,最后⼀列是真实的输出结果,将数据打乱顺序,95%的作为训练集,剩下的作为测试集。

这⾥隐层节点数为20。

BP_kailugaji.mfunction errorsum=BP_kailugaji(data_load, NodeNum, ratio)% Author:凯鲁嘎吉 https:///kailugaji/% Input:% data_load: 最后⼀列真实输出结果% NodeNum: 隐层节点个数% ratio: 训练集占总体样本的⽐率[Num, ~]=size(data_load);data=data_load(:, 1:end-1);real_label=data_load(:, end);k=rand(1,Num);[~,n]=sort(k);kk=floor(Num*ratio);%找出训练数据和预测数据input_train=data(n(1:kk),:)';output_train=real_label(n(1:kk))';input_test=data(n(kk+1:Num),:)';output_test=real_label(n(kk+1:Num))';%选连样本输⼊输出数据归⼀化[inputn,inputps]=mapminmax(input_train);[outputn,outputps]=mapminmax(output_train);%% BP⽹络训练% %初始化⽹络结构net=newff(inputn, outputn, NodeNum);net.trainParam.epochs=100; % 最⼤迭代次数net.trainParam.lr=0.01; % 步长net.trainParam.goal=1e-5; % 迭代终⽌条件% net.divideFcn = '';%⽹络训练net=train(net,inputn,outputn);W1=net.iw{1, 1};b1=net.b{1};W2=net.lw{2, 1};b2=net.b{2};fun1=yers{1}.transferFcn;fun2=yers{2}.transferFcn;%% BP⽹络预测%预测数据归⼀化inputn_test=mapminmax('apply',input_test,inputps);%⽹络预测输出an=sim(net,inputn_test);%⽹络输出反归⼀化BPoutput=mapminmax('reverse',an,outputps);%% 结果分析figure(1)plot(BPoutput,'-.or')hold onplot(output_test,'-*b');legend('预测输出','期望输出')xlim([1 (Num-kk)]);title('BP⽹络预测输出','fontsize',12)ylabel('函数输出','fontsize',12)xlabel('样本','fontsize',12)saveas(gcf,sprintf('BP⽹络预测输出.jpg'),'bmp');%预测误差error=BPoutput-output_test;errorsum=sum(mse(error));% 保留参数save BP_parameter W1 b1 W2 b2 fun1 fun2 net inputps outputpsdemo.mclear;clc;close alldata_load=dlmread('housing.data');NodeNum=20;ratio=0.95;errorsum=BP_kailugaji(data_load, NodeNum, ratio);fprintf('测试集总体均⽅误差为:%f\n', errorsum);%%% 验证原来的或者预测新的数据num=1; % 验证第num⾏数据load('BP_parameter.mat');data=data_load(:, 1:end-1);real_label=data_load(:, end);X=data(num, :);X=X';Y=real_label(num, :);%% BP⽹络预测%预测数据归⼀化X=mapminmax('apply',X,inputps);%⽹络预测输出Y_pre=sim(net,X);%⽹络输出反归⼀化Y_pre=mapminmax('reverse',Y_pre,outputps);error=Y_pre-Y';errorsum=sum(mse(error));fprintf('第%d⾏数据的均⽅误差为:%f\n', num, errorsum);结果测试集总体均⽅误差为:5.184424第1⾏数据的均⽅误差为:3.258243注意:隐层节点个数,激活函数,迭代终⽌条件等等参数需要根据具体数据进⾏调整。

BP神经网络实验报告

BP神经网络实验报告BP神经网络实验报告一、实验目的本实验的目的是熟悉MATLAB中神经网络工具箱的使用方法,同时通过编程实现BP网络逼近标准正弦函数,来加深对BP网络的了解和认识,理解信号的正向传播和误差的反向传递过程。

二、实验原理传统的感知器和线性神经网络无法解决线性不可分问题,因此在实际应用过程中受到了限制。

而BP网络却拥有良好的繁泛化能力、容错能力以及非线性映射能力,因此成为应用最为广泛的一种神经网络。

BP算法将研究过程分为两个阶段:第一阶段是信号的正向传播过程,输入信息通过输入层、隐层逐层处理并计算每个单元的实际输出值;第二阶段是误差的反向传递过程,若在输入层未能得到期望的输出值,则逐层递归的计算实际输出和期望输出的差值(即误差),以便根据此差值调节权值。

这种过程不断迭代,最后使得信号误差达到允许或规定的范围之内。

基于BP算法的多层前馈型网络模型的拓扑结构如下图所示:BP算法的数学描述:三层BP前馈网络的数学模型如下图所示。

三层前馈网中,输入向量为X=(x1,x2.xi。

xn)T;隐层输入向量为Y=(y1,y2.___。

y_m)T;输出层输出向量为O=(o1,o2.ok。

ol)T;期望输出向量为d=(d1,d2.dk。

dl)T。

输入层到隐层之间的权值矩阵用V表示,V=(v1,v2.其中列向量vj 为隐层第j个神经元对应的权向量;v_j。

v_m)Y,隐层到输出层之间的权值矩阵用W表示,W=(w1,w2.wk。

wl),其中列向量wk为输出层第k个神经元对应的权向量。

下面分析各层信号之间的数学关系。

对于输出层,有:yj=f(netj)。

j=1,2.mnetj=∑vijxi。

j=1,2.m对于隐层,有:Ok=f(netk)。

k=1,2.l___∑wjk*yi。

k=1,2.lj=1其中转移函数f(x)均为单极性Sigmoid函数:f(x)=1/(1+e^-x),具有连续、可导的特点,且f'(x)=f(x)[1-f(x)]。

BP人工神经网络试验报告一

BP⼈⼯神经⽹络试验报告⼀学号:北京⼯商⼤学⼈⼯神经⽹络实验报告实验⼀基于BP算法的XX及Matlab实现院(系)专业学⽣姓名成绩指导教师2011年10⽉⼀、实验⽬的:1、熟悉MATLAB 中神经⽹络⼯具箱的使⽤⽅法;2、了解BP 神经⽹络各种优化算法的原理;3、掌握BP 神经⽹络各种优化算法的特点;4、掌握使⽤BP 神经⽹络各种优化算法解决实际问题的⽅法。

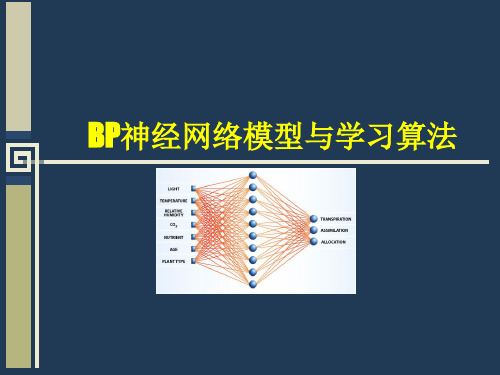

⼆、实验内容:1 案例背景1.1 BP 神经⽹络概述BP 神经⽹络是⼀种多层前馈神经⽹络,该⽹络的主要特点是信号前向传递,误差反向传播。

在前向传递中,输⼊信号从输⼊层经隐含层逐层处理,直⾄输出层。

每⼀层的神经元状态只影响下⼀层神经元状态。

如果输出层得不到期望输出,则转⼊反向传播,根据预测误差调整⽹络权值和阈值,从⽽使BP 神经⽹络预测输出不断逼近期望输出。

BP 神经⽹络的拓扑结构如图1.1所⽰。

图1.1 BP 神经⽹络拓扑结构图图1.1中1x ,2x , ……n x 是BP 神经⽹络的输⼊值1y ,2y , ……n y 是BP 神经的预测值,ij ω和jk ω为BP 神经⽹络权值。

从图1.1可以看出,BP 神经⽹络可以看成⼀个⾮线性函数,⽹络输⼊值和预测值分别为该函数的⾃变量和因变量。

当输⼊节点数为n ,输出节点数为m 时,BP 神经⽹络就表达了从n 个⾃变量到m 个因变量的函数映射关系。

BP 神经⽹络预测前⾸先要训练⽹络,通过训练使⽹络具有联想记忆和预测能⼒。

BP 神经⽹络的训练过程包括以下⼏个步骤。

步骤1:⽹络初始化。

根据系统输⼊输出序列()y x ,确定⽹络输⼊层节点数n 、隐含层节点数l ,输出层节点数m ,初始化输⼊层、隐含层和输出层神经元之间的连接权值ij ω和式中, l 为隐含层节点数; f 为隐含层激励函数,该函数有多种表达形式,本章所选函数为:步骤3:输出层输出计算。

根据隐含层输出H ,连接权值jk ω和阈值b ,计算BP 神经⽹络预测输出O 。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

BP神经网络实验详解(MATLAB实现)

BP(Back Propagation)神经网络是一种常用的人工神经网络结构,

用于解决分类和回归问题。

在本文中,将详细介绍如何使用MATLAB实现

BP神经网络的实验。

首先,需要准备一个数据集来训练和测试BP神经网络。

数据集可以

是一个CSV文件,每一行代表一个样本,每一列代表一个特征。

一般来说,数据集应该被分成训练集和测试集,用于训练和测试模型的性能。

在MATLAB中,可以使用`csvread`函数来读取CSV文件,并将数据集

划分为输入和输出。

假设数据集的前几列是输入特征,最后一列是输出。

可以使用以下代码来实现:

```matlab

data = csvread('dataset.csv');

input = data(:, 1:end-1);

output = data(:, end);

```

然后,需要创建一个BP神经网络模型。

可以使用MATLAB的

`patternnet`函数来创建一个全连接的神经网络模型。

该函数的输入参数

为每个隐藏层的神经元数量。

下面的代码创建了一个具有10个隐藏神经

元的单隐藏层BP神经网络:

```matlab

hidden_neurons = 10;

net = patternnet(hidden_neurons);

```

接下来,需要对BP神经网络进行训练。

可以使用`train`函数来训练模型。

该函数的输入参数包括训练集的输入和输出,以及其他可选参数,如最大训练次数和停止条件。

下面的代码展示了如何使用`train`函数来训练模型:

```matlab

net = train(net, input_train, output_train);

```

训练完成后,可以使用训练好的BP神经网络进行预测。

可以使用

`net`模型的`sim`函数来进行预测。

下面的代码展示了如何使用`sim`函数预测测试集的输出:

```matlab

output_pred = sim(net, input_test);

```

最后,可以使用各种性能指标来评估预测的准确性。

例如,可以使用MATLAB的`confusionmat`函数来计算混淆矩阵,并使用`classperf`函数来计算分类性能指标,如准确率、召回率和F1分数。

下面的代码展示了如何计算这些指标:

```matlab

confusion = confusionmat(output_test, output_pred);

cp = classperf(output_test, output_pred);

accuracy = cp.CorrectRate;

recall = cp.Sensitivity;

f1 = 2*(precision*recall)/(precision+recall);

```

以上是使用MATLAB实现BP神经网络的基本步骤。

然而,为了提高模型的性能和泛化能力,还可以采取一些优化措施,如交叉验证、正则化、参数调整等等。

总结起来,这篇文章详细介绍了如何使用MATLAB实现BP神经网络的实验。

从数据准备、模型创建、训练和预测、性能评估等方面进行了详细的说明。

希望读者可以通过这篇文章对BP神经网络有一个全面的了解,并能够在实际项目中灵活应用。