模式识别(第十章)

模式识别课后习题答案

• 2.16 证明M ahalanobis距离r符合距离定义三定理,即 – (1) r(a, b) = r(b, a) – (2) 当且仅当a = b时,r(a, b) = 0 – (3) r(a, c) ≤ r(a, b) + r(b, c) 证明: (1) r(a, b) = (a − b)T Σ−1 (a − b) = (b − a)T Σ−1 (b − a) = r(b, a) (2) Σ为半正定矩阵所以r(a, b) = (a − b)T Σ−1 (a − b) ≥ 0,只有当a = b时,才有r(a, b) = 0。 (3) Σ−1 可对角化,Σ−1 = P ΛP T • 2.17 若将Σ−1 矩阵写为:Σ−1 h1d h2d ,证明M ahalanobis距离平方为 . . . hdd

• 2.13 把连续情况的最小错误率贝叶斯决策推广到离散情况,并写出其判别函数。 • 2.14 写出离散情况条件风险R(ai |x)的定义,并指出其决策规则。 解: R(ai |x) = = R(ak |x) = min

c ∑ j =1 c ∑ j =1

λij P (wj |x) λij pቤተ መጻሕፍቲ ባይዱx|wj )P (wj )////omit the same part p(x)

j =1,...,c j =1,...,c

考虑两类问题的分类决策面为:P (w1 |x) = P (w2 |x),与p(x|w1 )P (w1 ) = p(x|w2 )P (w2 ) 是相同的。 • 2.9 写出两类和多类情况下最小风险贝叶斯决策判别函数和决策面方程。 • 2.10 随机变量l(x)定义为l(x) = p(x|w1 ) ,l(x)又称为似然比,试证明 p(x|w2 )

1

模式识别 张学工

Xuegong Zhang, Tsinghua University

2

张学工《模式识别》教学课件

10.1.2

测试错误率

独立的测试集

ˆ

k N

N:测试集样本数;k:测试集错分样本数 最大似然估计

Xuegong Zhang, Tsinghua University

3

张学工《模式识别》教学课件

10.1.3 交叉验证

张学工《模式识别》教学课件

第十章 模式识别系统的评价

Xuegong Zhang, Tsinghua University

1

张学工《模式识别》教学课件

10.1 监督模式识别方法的错误率估计

10.1.1 训练错误率

几个同义词: 训练错误率(Training Error Rate 或简称作 Training Error) 视在错误率(Apparent Error) 重代入错误率(re-substitution error) 经验风险 偏乐观 经验风险与期望风险的关系: 《统计学习理论》

紧致性(compactness)或一致性(homogeneity)

连接性(separation)

Xuegong Zhang, Tsinghua University

12

张学工《模式识别》教学课件

Silhouette 值:同时反映类内距离和类间距离的指标

Dunn 指数(Dunn Index)

Xuegong Zhang, Tsinghua University

7

张学工《模式识别》教学课件

10.2.2 用扰动重采样估计 SVM 错误率的置信区间

Bo Jiang, Xuegong Zhang and Tianxi Cai, Estimating the confidence interval for prediction errors of support vector machine classifiers. Journal of Machine Learning Research, 9:521-540, 2008

模式识别 模式识别概述

三.关于模式识别的国内、国际学术组织

• 1973年 IEEE发起了第一次关于模式识别 的国际会议“ICPR”,成立了国际模式识 别协会---“IAPR”,每2年召开一次国际学 术会议。 • 1977年 IEEE的计算机学会成立了模式分 析与机器智能(PAMI)委员会,每2年 召开一次模式识别与图象处理学术会议。 • 国内的组织有电子学会,通信学会,自 动化协会,中文信息学会….。

变量 样本 X1 X2 … XN

2018/10/14

x1 X11 X21 … XN1

x2 X12 X22 … XN2

… … … … …

xn X1n X2n … XNn

9

3. 几何表示 一维表示

X1=1.5 X2=3

二维表示

X1=(x1,x2)T=(1,2)T X2=(x1,x2)T=(2,1)T

三维表示

因为x1 , x2 的夹角小,所以x1 , x2 最相似。

2018/10/14 17

⑦ 相关系数

rij

n

ห้องสมุดไป่ตู้

X

n

ki

Xi Xkj Xj

X

k 1

k 1

ki

Xi

X

2 n k 1

kj

Xj

2

Xi, Xj 为xi xj的均值

注意:在求相关系数之前,要将数据标准化

2018/10/14 4

§1-2 模式识别系统

• 信息的获取:是通过传感器,将光或声音等信 息转化为电信息。信息可以是二维的图象如文 字,图象等;可以是一维的波形如声波,心电 图,脑电图;也可以是物理量与逻辑值。 • 预处理:包括A\D,二值化,图象的平滑,变换, 增强,恢复,滤波等, 主要指图象处理。

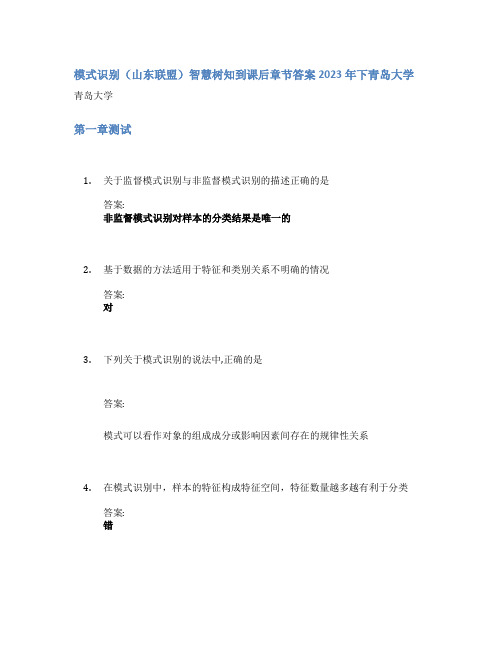

模式识别(山东联盟)智慧树知到课后章节答案2023年下青岛大学

模式识别(山东联盟)智慧树知到课后章节答案2023年下青岛大学青岛大学第一章测试1.关于监督模式识别与非监督模式识别的描述正确的是答案:非监督模式识别对样本的分类结果是唯一的2.基于数据的方法适用于特征和类别关系不明确的情况答案:对3.下列关于模式识别的说法中,正确的是答案:模式可以看作对象的组成成分或影响因素间存在的规律性关系4.在模式识别中,样本的特征构成特征空间,特征数量越多越有利于分类答案:错5.在监督模式识别中,分类器的形式越复杂,对未知样本的分类精度就越高答案:错第二章测试1.下列关于最小风险的贝叶斯决策的说法中正确的有答案:条件风险反映了对于一个样本x采用某种决策时所带来的损失;最小风险的贝叶斯决策考虑到了不同的错误率所造成的不同损失;最小错误率的贝叶斯决策是最小风险的贝叶斯决策的特例2.我们在对某一模式x进行分类判别决策时,只需要算出它属于各类的条件风险就可以进行决策了。

答案:对3.下面关于贝叶斯分类器的说法中错误的是答案:贝叶斯分类器中的判别函数的形式是唯一的4.当各类的协方差矩阵相等时,分类面为超平面,并且与两类的中心连线垂直。

答案:错5.当各类的协方差矩阵不等时,决策面是超二次曲面。

答案:对第三章测试1.概率密度函数的估计的本质是根据训练数据来估计概率密度函数的形式和参数。

答案:对2.参数估计是已知概率密度的形式,而参数未知。

答案:对3.概率密度函数的参数估计需要一定数量的训练样本,样本越多,参数估计的结果越准确。

答案:对4.下面关于最大似然估计的说法中正确的是答案:在最大似然函数估计中,要估计的参数是一个确定的量。

;在最大似然估计中要求各个样本必须是独立抽取的。

;最大似然估计是在已知概率密度函数的形式,但是参数未知的情况下,利用训练样本来估计未知参数。

5.贝叶斯估计中是将未知的参数本身也看作一个随机变量,要做的是根据观测数据对参数的分布进行估计。

答案:对第四章测试1.多类问题的贝叶斯分类器中判别函数的数量与类别数量是有直接关系的。

模式识别讲义

模式识别讲义《模式识别与图像处理》教学讲义上篇模式识别§1. 模式识别序论近年来,科技发展的重要方向之一就是:人类智能的机器化和人造机器的智能化。

前者以计算机、专家系统、神经网络算法等为代表;后者以智能机器人(具有视觉、听觉、触觉、嗅觉等)为典型。

两个方向的努力都归结为一个目标——研究人工智能。

当然,目前科技水平还远没有达到设定目标。

使机器具有人类的智能水平,使机器像人那样进行目标识别尚需艰苦努力。

模式识别是智能的核心功能之一。

换句话说就是模式识别属于人工智能的范畴。

这里所说的智能或人工智能是指用机器完成以往只能由人类方能胜任的智能活动。

包括:①通过视、听、触、嗅觉接受各种自然信息、感知环境;②经推理、分析、判断、综合将感性认识加工成理论知识,进而形成概念、建立方法以及做出决策;③对外界环境的变化和干扰做出适应性反应等等。

模式识别就是要用机器实现上述第一项人类智能活动。

而第二项则已有神经网络、专家系统等仿照人类思维的智能方法。

第三项则是人类早已开始研究的各种自动化技术、自适应控制、自学习控制等。

那么,什么叫做模式识别呢?§1-1 模式识别的基本概念1、模式与模式识别定义一:模式是一些供模仿用的完美无缺的标本;模式识别就是辨别出特定客体所模仿的标本。

定义二:模式是对特定客体的定量的或结构的描述;模式识别是把待识别模式划分到各自的模式类中去。

这里所说的模式类是具有某些共同特性的模式的集合。

两个定义中,模式一词的含义是不同的。

前者指标本,后者指对客体的描述。

本课程中使用定义二,并且作如下狭义约定:模式识别是指利用计算机自动地或有少量人为干预的方法把待识别模式加以分类,即划分到模式类中去。

一般认为,模式是通过对具体的事物进行观测所得到的具有时间与空间分布的信息,模式所属的类别或同一类中的模式的总体称为模式类,其中个别具体的模式往往称为样本。

模式识别就是研究通过计算机自动的(或人为少量干预)将待识别的模式分配到各个模式类中的技术。

模式识别课件

模式识别课件预览说明:预览图片所展示的格式为文档的源格式展示,下载源文件没有水印,内容可编辑和复制模式识别参考材料:[1]边肇祺,张学工等编,模式识别(第二版)清华大学出版社 2000[2]R.O.Duda, P.E.Hart. Pattern Classification and Scene Analysis.NewYork: John wiley & sons. 1973[3]Nello Cristianini & Jogn Shawe –Jaylor. An Introduction to Support Vector Machines and other Kernel –based learning method. Cambridge University Press 2000学习目标:模式识别这个词是Pattern Recognition翻译来的,通俗一点讲究就是机器识别,计算机识别,或机器自动识别。

Pattern这个词翻译成模式,模式是要让机器自动识别的事物(辨别是否相同或是否相似)。

如一个具体数字,是印刷体还是手写体。

本课程学习目标为,使学生能应用模式识别方法处理计算机自动识别事物、机器学习、数据分析中有关的技术问题。

能掌握模式识别技术中最基本的概念,以及基本的处理问题方法。

课程要求:本课程主要是学习让计算机自动识别的基本概念,方法的课程,但它与相关学科的术语都有密切联系,如人工智能也是让计算机具有智能,因此这两门课程有许多相通、互助的方面。

模式识别技术中十分重要的概念是让机器通过学习确定参数改进性能,因此是机器学习这个学术名词中的重要与基础内容。

模式识别主要是对视频、图像、声音等多媒体信息进行分类识别,因此具有这方面的背景也是比较有利的。

第一章绪论§课前索引重点:1、模式识别的含义,模式的概念2、模式的描述方法3、模式识别系统的组成4、模式识别利用训练样本设计分类器的原理,两种最基本的分类方法的原理课前思考1、什么是模式识别,是不是就是机器自动识别、或机器自动分类?常说的语音识别、汉字识别、手写体识别是不是属于这门学科的内容2、模式识别这门课有用吗?哪里可以应用?3、机器自动识别的最基本原理是什么?知识点模式识别的含义——机器自动识别与分类§1.1 模式识别和模式的概念学科作用模式识别是六十年代初迅速发展的一门学科。

模式识别课后习题答案

– (1) E{ln(x)|w1} = E{ln+1(x)|w2} – (2) E{l(x)|w2} = 1 – (3) E{l(x)|w1} − E2{l(x)|w2} = var{l(x)|w2}(教材中题目有问题) 证∫ 明ln+:1p对(x于|w(12)),dxE={ln∫(x()∫p(|wp(x(1x|}w|w=1)2))∫n)+nl1nd(xx)所p(x以|w∫,1)Ed{xln=(x∫)|w(1p(}p(x(=x|w|Ew1)2{))ln)n+n+11d(xx)又|wE2}{ln+1(x)|w2} = 对于(2),E{l(x)|w2} = l(x)p(x|w2)dx = p(x|w1)dx = 1

对于(3),E{l(x)|w1} − E2{l(x)|w2} = E{l2(x)|w2} − E2{l(x)|w2} = var{l(x)|w2}

• 2.11 xj(j = 1, 2, ..., n)为n个独立随机变量,有E[xj|wi] = ijη,var[xj|wi] = i2j2σ2,计 算在λ11 = λ22 = 0 及λ12 = λ21 = 1的情况下,由贝叶斯决策引起的错误率。(中心极限 定理)

R2

R1

容易得到

∫

∫

p(x|w2)dx = p(x|w1)dx

R1

R2

所以此时最小最大决策面使得P1(e) = P2(e)

• 2.8 对于同一个决策规则判别函数可定义成不同形式,从而有不同的决策面方程,指出 决策区域是不变的。

3

模式识别(第二版)习题解答

2016年福建自考《认知心理学》考试大纲

2016年福建自考《认知心理学》考试大纲。

(二)模式识别识记:模板说、原型说、特征说应用:(1)模板说的核心思想认为在人的长时记忆中,贮存着许多各式各样的过去在生活中形成的外部模式的袖珍样本。

基本思想是刺激与模板匹配,而且这两种匹配要求两者有限度的重叠。

模板说的基本观点得到一些实验结果的支持。

(2)原型说认为在记忆贮存的不是与外部模式有一对一关系的模板,而是原型(Prototype)。

对于原型说来讲,关键点在于是否存在这种原型,目前已有一些实验结果提示原型确实存在。

(3)特征说认为,模式可以分解为诸特征。

照特征说来看,特征和特征分析在模式识别中起着关键的作用。

(三)结构优势效应识记:结构优势效应包括字词优势效应、客体优势效应、构型优势效应、字母优势效应。

这些效应都表明上下文,或者严格地说,整体的结构在模式识别中所起的有利的作用,可统称为结构优势效应。

第三章注意一、学习目的与要求通过本章的学习理解过滤器模型和衰减模型、反应选择模型与知觉选择模型。

明确中枢能量理论,认识控制性加工与自动加工。

二、考核知识点与考核目标(一)过滤器模型和衰减模型识记:过滤器模型是英国心理学家Broadbent于1958年提出的一个较早的注意模型。

Cherry应用追随程序所做的双听实验也支持过滤器模型。

识记:Treisman提出了衰减模型,并将阙限概念引入高级分析水平。

理解:(1)衰减模型(2)过滤器模型和衰减模型的共同点和不同点(二)反应选择模型与知觉选择模型识记:(1)反应选择模型以Deutsh为代表(2)反应选择模型与知觉选择模型主要差别在于对注意机制在信息加工系统中所处的位置有不同的看法。

理解:(1)反应选择模型(2)两类注意模型的比较(三)中枢能量理论理解:双作业操作识记:(1)一些心理学家并不设想一个瓶颈结构,即存在于某个位置的过滤器,而是将注意看做人能用于执行任务的数量有限的能量和资源,用这种能量或资源的分配来解释注意。

模式识别培训课程课件

04

语音模式识别

语音信号的预处理

噪声抑制

去除语音信号中的环境噪声,如 风、电气噪声等,提高语音信号

的清晰度和可懂度。

标准化

将语音信号的幅度和时间尺度进行 归一化处理,以消除不同说话人之 间的差异,提高识别系统的鲁棒性 。

分帧

将语音信号分割成短小的片段,通 常为20-30毫秒,以便于特征提取 和模式分类。

04 空间特征

提取图像中的空间特征,

反映图像中目标之间的空

间关系。

分类器的选择与优化

分类器选择

根据不同的应用场景 选择合适的分类器, 如支持向量机、神经

网络等。

参数优化

通过调整分类器的参 数,提高分类器的准 确率和泛化能力。

模型训练

使用训练数据集训练 分类器,并评估其性

能。

模型验证

使用验证数据集验证 分类器的性能,并调

模式识别培训课程课 件

目录

• 模式识别概述 • 模式识别的基本理论 • 图像模式识别 • 语音模式识别 • 文字识别 • 模式识别技术的发展趋势与挑战

01

模式识别概述

什么是模式识别

模式识别是指通过计算机或人工手段对自然界或人造的 复杂对象进行自动识别、分类、解释、理解或预测。它 涉及对输入数据的研究和分析,以识别出有用的信息, 并对其做出决策或判断。

基于光学原理的文字识别

01

02

03

光学原理

通过光学原理,将文本图 像转化为可识别的数字化 信息。

扫描仪

利用扫描仪对文档进行扫 描,将纸质文档转化为电 子文档。

OCR技术

光学字符识别(OCR)技 术可以将文本图像转化为 可编辑和搜索的文本。

模式识别第7,8,9,10章

第七章特征选择1.基于类内类间距离的可分性判据Fisher线性判别采用了使样本投影到一维后类内离散度尽可能小,类间离散度尽可能大的准则来确定最佳的投影方向,这就是一个直观的类别可分性判别。

这一思想可以可用来定义一系列基于类内类间距离的判别。

2.基于熵的可分性判据,熵J E越小,可分性越好3.特征选择的最优算法一种不需要进行穷举法但仍能取得最优解的方法是分支定界法,基本思想是:设法将所有可能特征选择组合构建成一个树状的结构,按照特定的规律对树进行搜索,使得搜索过程尽可能早地可以达到最优解而不必遍历整个树。

4.特征选择的次优算法单独最优特征的组合;顺序前进法;顺序后退法;增l减r法。

5.把分类器与特征选择集成来一起、利用分类器进行特征选择的方法通常被称作包裹法;于此对应,利用单独的可分性准则来选择特征在进行分类的方法为过滤法。

第八章特征提取1.主成分分析方法主成分分析其出发点是从一组特征中计算出一组按重要性从大到小的排列的新特征,它们是原有特征的线性组合,并且相互之间是不相关的。

在模式识别中应用主成分分析的方法,通常的做法是首先用样本估算协方差矩阵或自相关矩阵,求解其特征方程,得到各个主成分方向,选择适当数目的主成分作为样本的新特征,将样本投影到这些主成分方向上进行分类或聚类。

2.K-L变换a.定义:K-L变换是模式识别中常用的一种特征提取方法,其最基本的形式原理上与主成分分析是相同的,但K-L变换能够考虑到不同的分类信息,实现监督的特征提取。

b. K-L变换的重要性质:K-L变换是信号的最佳压缩表示;K-L变换的新特征是互不相关的;用K-L坐标系表示原数据,表示熵最小。

3.特征提取与特征选择特征选择的含义是从D个特征选出d(<D)个特征,另一种把特征空间降维的方法是特征提取,即通过适当的变换把D个特征转换成d(<D)个新特征第九章非监督模式识别1.非监督模式识别非监督模式识别分为两大类,一是基于样本的概率分布模型进行聚类划分,另一类是直接根据样本间的距离或相似性度量进行聚类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2

p ( y )dy

它反映了 f ( y | Γ i ) 和 f ( y | Γ j ) 之间的“距离”。

目标:求使 J 最大的子集划分

p( y | Γ i ) =

1 Ni

∑

j =1

Ni

k ( y, y i ) ,y j ∈ Γ i

(Parzen 窗法)

考查某个样本 y k ,若它原属于 Γ j ,从 Γ j 移入 Γ i ,得新的 Γ j 和 Γ i , 则显然

算法研究: 设已有一个划分方案,考查 Γ k 中的样本 y ,若把 y 移入 Γ j ,此时 Γ k 变成 Γ k , Γ j 变成 Γ j ,有

~

~

~ =m + m k k

~ =m + m j j

1 [mk − y ] Nk −1

1 y − mj N j +1

[

]

N ~ J k = J k − k y − mk N k −1

3.4

非监督参数估计

非监督参数估计指样本类别未知,但各类条件概率密度函数的形式已 知,根据所有样本估计各类密度函数中的参数。 ---- 混合概率模型

3.4.1 非监督参数估计的最大似然法 3.4.2 非监督参数估计示例:正态分布情况 -----局限:需要较强的先验假设,需要较多的样本

10.3

回顾:

投影方向:使方差最大的方向,即协方差阵本征值最大的本征向量方向。

算法步骤: (1)计算样本协方差矩阵的最大本征值对应的 本征向量 u j ,把样本投影到 u j 上。 (--- KL 变换)

(2)估计投影后样本 v j = u j x 的概率密度函数 p (v j ) 。

T

(用直方图方法或其它方法) , (3)求 p (v j ) 中的极小点(波谷) 在这些极小点上作垂直于 u j 的超平面作为分类超平面, 得到子集划分。 (4)如果 p (v j ) 上没有这种极小点, 则用下一个本征值对应的本征向量作为投影方向,重复(2)~(3) 。 (5)对划分出的第一个子集重复上述过程, 直到不能再分(所有方向上都是单峰) 。

2

Nj ~ y − mj Jj = Jj + N j +1

若

2

Nj N j +1

y − mj

2

<

Nk y − mk Nk −1

2

则把 y 从 Γ k 移入 Γ j 会使 J e 减小。

C 均值算法: (1)初始划分 c 个聚类, Γ i , i = 1, L , c 计算 mi , i = 1, L , c 和 J e (2)选样本 y ,设 y ∈ Γ i (3)若 N i = 1 ,则转(2) ;否则继续。 (4)计算 ρ j :

直方图法求概率密度函数:

N 个样本 v ij , i = 1, L, N ,按小到大排队,组成 {v j (l )}N ,其中

v j (l ) ≤ v j (l + i ) , ∀l , i > 0 , l + i ≤ N

将 v j 划分为若干间隔,统计每个间隔内样本的数目,用它(占样本总 数的比例)作为对概率密度函数值的估计 间隔长度 ρ 的确定:对某个 k ,求

~

~

~ f ( y | Γi ) ≥ f ( y | Γi )

~ f (y | Γ j ) i ) = f ( y | Γ i ) + ∆f i ,

∆f i = −∆f i =

1 k ( y, y k ) N

把 y k 从 Γ j 移入 Γ i 引起的指标变化量:

相似性度量:以某种距离定义

直观理解:同一类的样本的特征向量应是相互靠近的。 ——前提:特征选取合理,能反映所求的聚类关系。

与基于密度函数的方法的关系: 概念上相互关联,因密度估计也是在样本间距离的基础上的。 具体关系取决于具体数据情况。

10.3.1

动态聚类方法

多次迭代,逐步调整类别划分,最终使某准则达到最优。

ρ = min{v j (l + k ) − v j (l )}. 1 ≤ l ≤ N − k

l

其中 k 应满足:

N →∞

lim k = ∞

lim

k =0 N →∞ N

N →∞

lim

k =∞ log N

通常可选 k = & a N , a 为一定的常数 问题: 如何选择投影方向? ----- 方差最大的准则有时并不一定最有利于聚类。

ρj =

ρi =

Nj N j +1

y − mj , j ≠ i

2

2

Ni y − mi Ni + 1

(5)选 ρ j 中的最小者,即若 ρ k <

ρ j , ∀j ,则把 y 从 Γ i 移到 Γ k 中。

(6)重新计算 mi , i = 1, L , c 和 J e

(7)若连续 N 次迭代 J e 不改变,则停止;否则转(2) 。

(2) 对 S 中的第 r + 1 个样本 y r +1 ,考查它与已有各子集的关系, 即考查它是否是剩余候选样本中离该子集距离最近的样本。 可能有三种情况: (a) 若对所有已有子集 Γ j , j = 1, L , i , y r +1 都不是下一个离它最

近的样本,则用 y r +1 开始一个子集 Γ i +1 ,置 i = i + 1 ; (b) 若对某个 Γ j , y r +1 是候选点中离它最近的样本,而对其它子集 都不是候选最近样本,则令 y r +1 ∈ Γ j ; (c) 若对一个以上的子集, y r +1 都是候选点中离它们最近的样本,则 选择其中与 y r +1 距离最近的子集 Γ j ,使 y r +1 ∈ Γ j 。 (3) 从候选样本中去掉 y r +1 ,更新候选样本距离排序,置 r = r + 1 , 重复(2) ,直到 r == N 。 (4) 这样找出的子集数可能多于单峰子集数,因此:根据 p ( y ) 的极大点 是哪些子集 Γ j 的内点确定出单峰子集的核 y j 。 (5) 对于其余(非核)子集,根据其峰值点距各核中最近样本(或中心) 的距离合并到最近的单峰子集(核)中。

i j i

目标:

通过把 y k 从 Γ j 移入 Γ i ,使 J 增大,故应选择使 ∆J 尽可能大的 Γ i 移入, 即选择

f ( y k | Γ i ) = max f ( y k | Γ l )

l

以使 f ( y | Γ i ) − f ( y | Γ j ) 最大,从而使 ∆J 最大。 ,则可移入其中任一 若存在两个(或以上)子集的 f ( y k | Γ i ) 最大(相等) 类。

10.2.3

单峰子集分离的迭代算法

设数据集 Y 划分为 c 个子集 Γ i , i = 1,2, L , c 每个子集中样本数为 N i ,总样本数为 N 。 考查类条件概率密度的加权估计值:

f ( y | Γi ) =

Ni p( y | Γ i ) N

定义指标

J=

1 2∫

∑ ∑ [ f ( y | Γ ) − f ( y | Γ )]

三个要点: ① 选某种距离作为样本相似性度量 ② 定义某个准则函数,用于评价聚类质量。 ③ 初始分类方法及迭代算法

(一) C 均值算法( k 均值,C-means or k-means)

误差平方和聚类准则

Je = ∑

i =1

c

y∈Γi

∑

y − mi

2

= ∑ Ji

i =1

c

其中, Γ i 是第 i 个聚类, i = 1, L , c ,其中样本数为 N i ,

∆J = ∫ f ( y | Γ i ) − f ( y | Γ j ) − [ f ( y | Γ i ) − f ( y | Γ j )]

~ ~

2

{[

]

2

+

k =1 k ≠i , j

∑ [( f ( y | Γ

c

k

~ ) − f ( y | Γ j )) 2 − ( f ( y | Γ k ) − f ( y | Γ j )) 2

~ + ( f ( y | Γ k ) − f ( y | Γ i )) 2 − ( f ( y | Γ k ) − f ( y | Γ i )) 2 p ( y )dy

]}

= ∫ [2c∆f i ] p( y )dy + 2c ∫

2

[ f ( y | Γ ) − f ( y | Γ )]∆f p( y)dy

两大类方法

直接方法 : 基于概率密度函数估计 间接聚类方法

: 基于样本间相似性度量

10.2

单峰子集(类)的分离方法

基本假定: 各类样本的分布是单峰的,根据总体分布中的单峰来划分子集

10.2.1

基本思路:

投影方法

把样本投影到某一一维坐标轴(按某种准则) ,在这一维上求样本的概 率密度(边缘概率密度) ,根据这一概率密度函数的单峰划分子集。 (如果这一维上只有一个峰,则寻找下一个投影方向。 )

[

]

算法步骤: (1) 初始划分 Y (2) 对每个样本 y k , k = 1, L , N ,逐一计算 f ( y k | Γ i ) ,并归入使

f ( y k | Γ i ) 最大的子集中。

(3) 重复(2) ,直到不再有样本发生转移。

10.2.4

参数化方法

以上介绍方法均属非参数方法,在对数据分布没有先验知识的情况下采用。 如果已知(或可假设)数据分布的概率密度函数的形式,则可采用参数化方 法。 回顾:

z z

对称集一定是单峰的 划分单峰子集→划分对称集