kmeans聚类公式

Kmeans聚类算法实现(输出聚类计算过程,分布图展示)

Kmeans聚类算法实现(输出聚类过程,分布

图展示)

Kmeans聚类算法是聚类算法中最基础最常用的聚类算法,算法很简单,主要是将距离最近的点聚到一起,不断遍历点与簇中心的距离,并不断修正簇中心的位置与簇中的点集合,通过最近距离和遍历次数来控制输出最终的结果。

初始的簇中心、遍历次数、最小距离会影响最终的结果。

具体的聚类算法过程不详细讲解,网上资料很多,本文主要是java语言实现,1000个点(本文是二维向量,也可以是多维,实现原理和程序一样),程序运行过程中会输出每一次遍历点的簇中心,和簇中包含的点,并将最终结果通过插件在html中显示。

一、Kmeans聚类算法实现步骤

1、将本地文件读取到点集合中:

2、从点集合中随机选取K个簇中心(也可以采取其他方法获取,后续讲解,初始簇中心的选择会影响最终聚类结果):

3、Kmeans聚类。

Kmeans聚类的实现主要是通过遍历所有点与簇中心的距离,不断更换簇中心并将点存入距离最近的簇中,距离的计算公式有多种,常用的是欧几里得距离算法。

二、Kmeans聚类算法实现结果

1、运算过程:

2、分布图:

需要源代码的朋友可联系我们。

matlab的kmeans函数

matlab的kmeans函数一、kmeans函数简介kmeans函数是Matlab中用于聚类分析的重要函数之一。

它将数据集分成k个簇,每个簇包含与其它成员相似的数据点。

该函数是基于距离度量的,并且使用了迭代算法来最小化簇内平方和误差。

二、kmeans函数基本语法[k, c] = kmeans(X, k)其中,X是一个m×n的矩阵,表示有m个样本,每个样本有n个特征;k表示要划分的簇数;kmeans函数返回两个参数:k表示每个样本所属的簇号,c表示每个簇的中心点。

三、kmeans函数参数详解1. X:待聚类数据集X是一个m×n的矩阵,其中m表示样本数量,n表示特征数量。

在使用kmeans函数时必须指定X。

2. k:聚类数目k指定了要将数据集分成多少个簇。

在使用kmeans函数时必须指定k。

3. distance:距离度量方法distance指定了距离度量方法,默认为欧氏距离。

其他可选项包括“cityblock”(曼哈顿距离)、“cosine”(余弦相似度)等。

4. start:初始点选择方法start指定了初始点选择方法,默认为“sample”,即从样本中随机选择k个点作为初始点。

其他可选项包括“uniform”(在数据集范围内均匀分布选择)等。

5. emptyaction:空簇处理方法emptyaction指定了空簇处理方法,默认为“error”,即如果有空簇则停止运行并报错。

其他可选项包括“drop”(删除空簇)等。

6. display:显示信息display指定了显示信息的详细程度,默认为“off”,即不显示任何信息。

其他可选项包括“iter”(每次迭代时显示信息)等。

四、kmeans函数使用示例1. 导入数据集load fisheririsX = meas;2. 聚类分析[k, c] = kmeans(X, 3);其中,将iris数据集聚成3个簇。

3. 可视化结果gscatter(X(:,1), X(:,2), k);hold onplot(c(:,1), c(:,2), 'kx', 'MarkerSize', 15, 'LineWidth', 3);legend('Cluster 1','Cluster 2','Cluster 3','Centroids','Location','NW')xlabel('Sepal length');ylabel('Sepal width');title('Iris Clustering Results');其中,使用gscatter函数将聚类结果可视化,并在图中标出各个簇的中心点。

聚类算法介绍(K-means+DBSCAN+典型案例)

排序,速度相对于K-Means较慢,一般只适合小数据量。

二,DBSCAN

在DBSCAN算法中将数据点分为一下三类:

01

核心点:在半径r内含有超过minPoints数目的点

边界点:在半径r内点的数量小于minPoints,但是落在核心点的邻域内

噪音点:既不是核心点也不是边界点的点

算密度单元的计算复杂度大,

每一簇内较大的点代表核心对象,较

小的点代表边界点(与簇内其他点密

度相连,但是自身不是核心对象)。

黑色的点代表离群点或者叫噪声点。

三,凝聚层级聚类(HAC)

HAC是自下而上的一种聚类算法。

1

HAC首先将每个数据点视为一个单一的簇,然后计算所有簇之间的距离来合并

簇,直到所有的簇聚合成为一个簇为止。

之间具有更多的相似性。

是一种探索性的分析。聚类分析所

使用方法的不同,常常会得到不同

的结论。不同研究者对于同一组数

据进行聚类分析,所得到的聚类数

未必一致。

从机器学习的角度讲,簇相当

于隐藏模式。聚类是搜索簇的

无监督学习过程。

01

02

04

03

05

06

从统计学的观点看,聚类分析

是通过数据建模简化数据的一

种方法。

典型的应用案例

例3:基于DBSCAN算法的交通事故读法点段排查方法

核心思想:对于构成交通事故多发点段的每个交通事敌,其发生的地点半径e(邻域)公里范围以内的其它交通

事故的个数,必须不小于一个给定的阈值(MinPts),也就是说其邻域的密度必须不小于某个阈值。

下面是DBSCAN算法的交通事故多发点段排查方法在交通事故黑点排查中的一些定义:

kmeans的聚类算法

kmeans的聚类算法K-means是一种常见的聚类算法,它可以将数据集划分为K个簇,每个簇包含相似的数据点。

在本文中,我们将详细介绍K-means算法的原理、步骤和应用。

一、K-means算法原理K-means算法基于以下两个假设:1. 每个簇的中心是该簇内所有点的平均值。

2. 每个点都属于距离其最近的中心所在的簇。

基于这两个假设,K-means算法通过迭代寻找最佳中心来实现聚类。

具体来说,该算法包括以下步骤:二、K-means算法步骤1. 随机选择k个数据点作为初始质心。

2. 将每个数据点分配到距离其最近的质心所在的簇。

3. 计算每个簇内所有数据点的平均值,并将其作为新质心。

4. 重复步骤2和3直到质心不再变化或达到预定迭代次数。

三、K-means算法应用1. 数据挖掘:将大量数据分成几组可以帮助我们发现其中隐含的规律2. 图像分割:将图像分成几个部分,每个部分可以看做是一个簇,从而实现图像的分割。

3. 生物学:通过对生物数据进行聚类可以帮助我们理解生物之间的相似性和差异性。

四、K-means算法优缺点1. 优点:(1)简单易懂,易于实现。

(2)计算效率高,适用于大规模数据集。

(3)结果可解释性强。

2. 缺点:(1)需要预先设定簇数K。

(2)对初始质心的选择敏感,可能会陷入局部最优解。

(3)无法处理非球形簇和噪声数据。

五、K-means算法改进1. K-means++:改进了初始质心的选择方法,能够更好地避免陷入局部最优解。

2. Mini-batch K-means:通过随机抽样来加快计算速度,在保证精度的同时降低了计算复杂度。

K-means算法是一种常见的聚类算法,它通过迭代寻找最佳中心来实现聚类。

该算法应用广泛,但也存在一些缺点。

针对这些缺点,我们可以采用改进方法来提高其效果。

kmeans与kmeans++的python实现

kmeans与kmeans++的python实现⼀.kmeans聚类:基本⽅法流程1.⾸先随机初始化k个中⼼点2.将每个实例分配到与其最近的中⼼点,开成k个类3.更新中⼼点,计算每个类的平均中⼼点4.直到中⼼点不再变化或变化不⼤或达到迭代次数优缺点:该⽅法简单,执⾏速度较快。

但其对于离群点处理不是很好,这是可以去除离群点。

kmeans聚类的主要缺点是随机的k个初始中⼼点的选择不够严谨,因为是随机,所以会导致聚类结果准确度不稳定。

⼆.kmeans++聚类:kmeans++⽅法是针对kmeans的主要缺点进⾏改进,通过在初始中⼼点的选择上改进不⾜。

中⼼点的选择:1.⾸先随机选择⼀个中⼼点2.计算每个点到与其最近的中⼼点的距离为dist,以正⽐于dist的概率,随机选择⼀个点作为中⼼点加⼊中⼼点集中,重复直到选定k个中⼼点对于正⽐于dist的概率随机选择⼀个数据点作为新的中⼼点的理解有⼀个英⽂资料解释如下:3.计算同kmeans⽅法三.评估⽅法误差平⽅和可以评估每次初始中⼼点选择聚类的优劣,公式如下:计算每个点到它⾃⼰的类的中⼼点的距离的平⽅和,外层是不同类间的和。

根据每次初始点的选择聚类结果计算SSE,SSE值越⼩结果越好。

四.代码1#!/usr/bin/python2# -*- coding: utf-8 -*-3import math4import codecs5import random67#k-means和k-means++聚类,第⼀列是label标签,其它列是数值型数据8class KMeans:910#⼀列的中位数11def getColMedian(self,colList):12 tmp = list(colList)13 tmp.sort()14 alen = len(tmp)15if alen % 2 == 1:16return tmp[alen // 2]17else:18return (tmp[alen // 2] + tmp[(alen // 2) - 1]) / 21920#对数值型数据进⾏归⼀化,使⽤绝对标准分[绝对标准差->asd=sum(x-u)/len(x),x的标准分->(x-u)/绝对标准差,u是中位数]21def colNormalize(self,colList):22 median = self.getColMedian(colList)23 asd = sum([abs(x - median) for x in colList]) / len(colList)24 result = [(x - median) / asd for x in colList]25return result2627'''28 1.读数据29 2.按列读取30 3.归⼀化数值型数据31 4.随机选择k个初始化中⼼点32 5.对数据离中⼼点距离进⾏分配33'''34def__init__(self,filePath,k):35 self.data={}#原始数据36 self.k=k#聚类个数37 self.iterationNumber=0#迭代次数38#⽤于跟踪在⼀次迭代改变的点39 self.pointsChanged=040#误差平⽅和41 self.SSE=042 line_1=True43 with codecs.open(filePath,'r','utf-8') as f:44for line in f:45# 第⼀⾏为描述信息46if line_1:47 line_1=False48 header=line.split(',')49 self.cols=len(header)50 self.data=[[] for i in range(self.cols)]51else:52 instances=line.split(',')53 column_0=True54for ins in range(self.cols):55if column_0:56 self.data[ins].append(instances[ins])# 0列数据57 column_0=False58else:59 self.data[ins].append(float(instances[ins]))# 数值列60 self.dataSize=len(self.data[1])#多少实例61 self.memberOf=[-1 for x in range(self.dataSize)]6263#归⼀化数值列64for i in range(1,self.cols):65 self.data[i]=self.colNormalize(self.data[i])6667#随机从数据中选择k个初始化中⼼点68 random.seed()69#1.下⾯是kmeans随机选择k个中⼼点70#self.centroids=[[self.data[i][r] for i in range(1,self.cols)]71# for r in random.sample(range(self.dataSize),self.k)]72#2.下⾯是kmeans++选择K个中⼼点73 self.selectInitialCenter()7475 self.assignPointsToCluster()7677#离中⼼点距离分配点,返回这个点属于某个类别的类型78def assignPointToCluster(self,i):79 min=1000080 clusterNum=-181for centroid in range(self.k):82 dist=self.distance(i,centroid)83if dist<min:84 min=dist85 clusterNum=centroid86#跟踪改变的点87if clusterNum!=self.memberOf[i]:88 self.pointsChanged+=189#误差平⽅和90 self.SSE+=min**291return clusterNum929394#将每个点分配到⼀个中⼼点,memberOf=[0,1,0,0,...],0和1是两个类别,每个实例属于的类别 95def assignPointsToCluster(self):96 self.pointsChanged=097 self.SSE=098 self.memberOf=[self.assignPointToCluster(i) for i in range(self.dataSize)]99100# 欧⽒距离,d(x,y)=math.sqrt(sum((x-y)*(x-y)))101def distance(self,i,j):102 sumSquares=0103for k in range(1,self.cols):104 sumSquares+=(self.data[k][i]-self.centroids[j][k-1])**2105return math.sqrt(sumSquares)106107#利⽤类中的数据点更新中⼼点,利⽤每个类中的所有点的均值108def updateCenter(self):109 members=[self.memberOf.count(i) for i in range(len(self.centroids))]#得到每个类别中的实例个数110 self.centroids=[111 [sum([self.data[k][i] for i in range(self.dataSize)112if self.memberOf[i]==centroid])/members[centroid]113for k in range(1,self.cols)]114for centroid in range(len(self.centroids))]115116'''迭代更新中⼼点(使⽤每个类中的点的平均坐标),117然后重新分配所有点到新的中⼼点,直到类中成员改变的点⼩于1%(只有不到1%的点从⼀个类移到另⼀类中) 118'''119def cluster(self):120 done=False121while not done:122 self.iterationNumber+=1#迭代次数123 self.updateCenter()124 self.assignPointsToCluster()125#少于1%的改变点,结束126if float(self.pointsChanged)/len(self.memberOf)<0.01:127 done=True128print("误差平⽅和(SSE): %f" % self.SSE)129130#打印结果131def printResults(self):132for centroid in range(len(self.centroids)):133print('\n\nCategory %i\n=========' % centroid)134for name in [self.data[0][i] for i in range(self.dataSize)135if self.memberOf[i]==centroid]:136print(name)137138#kmeans++⽅法与kmeans⽅法的区别就是初始化中⼼点的不同139def selectInitialCenter(self):140 centroids=[]141 total=0142#⾸先随机选⼀个中⼼点143 firstCenter=random.choice(range(self.dataSize))144 centroids.append(firstCenter)145#选择其它中⼼点,对于每个点找出离它最近的那个中⼼点的距离146for i in range(0,self.k-1):147 weights=[self.distancePointToClosestCenter(x,centroids)148for x in range(self.dataSize)]149 total=sum(weights)150#归⼀化0到1之间151 weights=[x/total for x in weights]152153 num=random.random()154 total=0155 x=-1156while total<num:157 x+=1158 total+=weights[x]159 centroids.append(x)160 self.centroids=[[self.data[i][r] for i in range(1,self.cols)] for r in centroids]161162def distancePointToClosestCenter(self,x,center):163 result=self.eDistance(x,center[0])164for centroid in center[1:]:165 distance=self.eDistance(x,centroid)166if distance<result:167 result=distance168return result169170#计算点i到中⼼点j的距离171def eDistance(self,i,j):172 sumSquares=0173for k in range(1,self.cols):174 sumSquares+=(self.data[k][i]-self.data[k][j])**2175return math.sqrt(sumSquares)176177if__name__=='__main__':178 kmeans=KMeans('filePath',3)179 kmeans.cluster()180 kmeans.printResults()参考:1.machine.learning.an.algorithmic.perspective.2nd.edition. 2.a programmer's guide to data mining。

K-均值聚类算法

4.重复分组和确定中心的步骤,直至算法收敛;

2.算法实现

输入:簇的数目k和包含n个对象的数据库。 输出:k个簇,使平方误差准则最小。

算法步骤:

1.为每个聚类确定一个初始聚类中心,这样就有K 个初始 聚类中心。

2.将样本集中的样本按照最小距离原则分配到最邻近聚类

给定数据集X,其中只包含描述属性,不包含 类别属性。假设X包含k个聚类子集X1,X2,„XK;各 个聚类子集中的样本数量分别为n1,n2,„,nk;各个 聚类子集的均值代表点(也称聚类中心)分别为m1, m2,„,mk。

3.算法实例

则误差平方和准则函数公式为:

k

2

E p mi

i 1 pX i

单个方差分别为

E1 0 2.52 2 22 2.5 52 2 22 12.5 E2 13.15

总体平均误差是: E E1 E2 12.5 13.15 25.65 由上可以看出,第一次迭代后,总体平均误差值52.25~25.65, 显著减小。由于在两次迭代中,簇中心不变,所以停止迭代过程, 算法停止。

示为三维向量(分别对应JPEG图像中的红色、绿色 和蓝色通道) ; 3. 将图片分割为合适的背景区域(三个)和前景区域 (小狗); 4. 使用K-means算法对图像进行分割。

2 015/8/8

Hale Waihona Puke 分割后的效果注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。

2 015/8/8

例2:

2 015/8/8

Ox y 102 200 3 1.5 0 450 552

数据对象集合S见表1,作为一个 聚类分析的二维样本,要求的簇的数 量k=2。

k均值算法

k均值算法

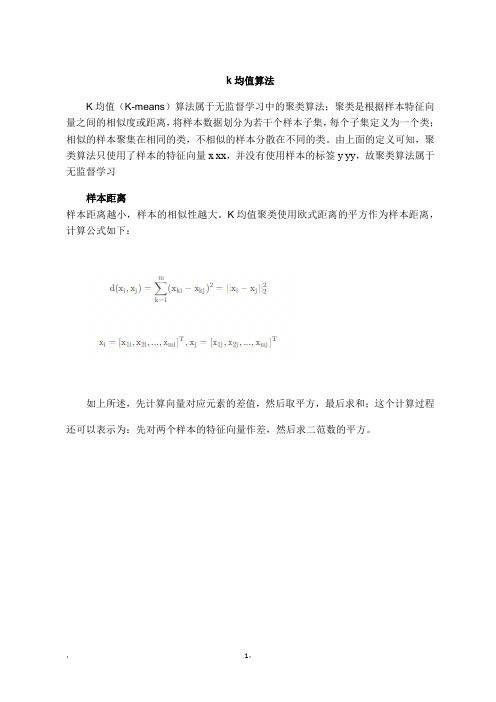

K均值(K-means)算法属于无监督学习中的聚类算法;聚类是根据样本特征向

量之间的相似度或距离,

将样本数据划分为若干个样本子集,每个子集定义为一个类;相似的样本聚集在相同的类,不相似的样本分散在不同的类。

由上面的定义可知,聚类算法只使用了样本的特征向量x xx,并没有使用样本的标签y yy,故聚类算法属于无监督学习

样本距离

样本距离越小,样本的相似性越大。

K均值聚类使用欧式距离的平方作为样本距离,计算公式如下:

如上所述,先计算向量对应元素的差值,然后取平方,最后求和;这个计算过程还可以表示为:先对两个样本的特征向量作差,然后求二范数的平方。

,1,。

kmeans聚类算法评价指标

kmeans聚类算法评价指标Kmeans聚类算法是一种经典的聚类算法,它将数据点分成K个簇,使得每个簇内的数据点相似度较高,不同簇之间的数据点相似度较低。

在Kmeans聚类算法中,评价聚类质量的指标是非常重要的,下面介绍几种常用的Kmeans聚类算法评价指标。

1. SSE(Sum of Squared Errors):SSE是Kmeans聚类算法中最常用的评价指标,它计算的是所有数据点到其所属簇中心的距离的平方和。

SSE值越小,表示簇内数据点的相似度越高,聚类效果越好。

2. 轮廓系数(Silhouette Coefficient):轮廓系数是一个综合评价指标,它考虑了簇内数据点之间的相似度和簇间数据点的相似度。

对于一个数据点i,它的轮廓系数为s(i)=(b(i)-a(i))/max(a(i),b(i)),其中a(i)表示数据点i与同簇其他数据点的平均距离,b(i)表示数据点i到其他簇中所有数据点的平均距离,s(i)的取值范围为[-1,1],值越接近1,表示数据点i的聚类效果越好。

3. CH指标(Calinski-Harabasz Index):CH指标是一个聚类质量的综合评价指标,它基于簇内的离散度和簇间的相似度,计算公式为CH=(B/(k-1))/(W/(n-k)),其中B表示簇间的离散度,W表示簇内的离散度,k表示簇的个数,n表示数据点的个数,CH指标的值越大,表示聚类效果越好。

4. DB指数(Davies-Bouldin Index):DB指数是一种基于簇内的离散度和簇间的相似度的聚类质量评价指标,它计算的是簇间距离与簇内距离之比的平均值,公式为DB= (1/k) *sum(max(R(i,j)+R(j,i))/D(i,j)),其中R(i,j)表示簇i和簇j之间的距离,D(i,j)表示簇i和簇j内所有数据点之间的平均距离,DB 指数的值越小,表示聚类效果越好。

以上是Kmeans聚类算法常用的一些评价指标,根据不同的应用场景,选择合适的评价指标来评估Kmeans聚类算法的聚类效果,可以更加准确地评估聚类算法的性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

kmeans聚类公式

Kmeans聚类方法是一种常用的无监督学习算法,它将数据集分

成K个不同的类别。

其核心思想是将数据点分配到最近的聚类中心,并不断更新聚类中心的位置,直到达到最优解。

下面是Kmeans聚类

的公式:

1. 初始化聚类中心

在开始Kmeans算法之前,需要先选择初始的聚类中心。

可以随

机从数据集中选择K个点作为初始聚类中心,也可以利用其他聚类初始化方法。

2. 计算数据点到聚类中心的距离

对于每个数据点,需要计算它们到每个聚类中心的距离。

这里使用欧几里得距离公式来计算数据点i到聚类中心j的距离:

distance(i, j) = sqrt( (x(i)-c(j))^2 + (y(i)-c(j))^2 + ... + (z(i)-c(j))^2 )

其中,x(i), y(i), z(i)代表数据点i的坐标值,c(j)代表聚类中心j的坐标值。

3. 将数据点分配到最近的聚类中心

对于每个数据点,将其分配到距离最近的聚类中心所在的类别中。

4. 更新聚类中心的位置

对于每个类别,计算该类别中所有数据点的坐标平均值,作为新的聚类中心坐标。

如下所示:

c(j) = (1/n) * SUM(x(i))

其中,n代表该类别中数据点的个数,SUM(x(i))代表该类别中所有数据点的坐标值之和。

5. 重复以上步骤

重复以上步骤2-4,直到聚类中心的位置不再改变为止,或者达到最大迭代次数。

最终的聚类结果即为数据集被分成的K个不同的类别。