RedHat GFS基于ISCSI的部署

iscsi总结

1iscsi工作原理与服务器搭建1.1概念iSCSI是因特网小型计算机系统接口(internet Small Computer System Interface)的简称,其是IETF制订的一项标准,用于将SCSI数据块映射为以太网数据包。

从根本上来说,它是一种基于IP Storage 理论的新型存储技术。

简单的说,iSCSI就是在IP网络上运行SCSI 协议的一种网络存储技术。

一个可以用于存储数据的iSCSI磁盘阵列或者具有iSCSI功能的设备都可以称为“iSCSI Target”。

目前大部分iSCSI Target 都是收费的,例如DataCoreSoftware,FalconStor Software的iSCSI Server for Windows等,这些都是支持Windows平台的。

不过在linux平台下也存在iSCSI Target软件,例如iSCSI Enterprise Target,而这也是我们KMJ 所使用的,后面则会重点介绍该软件。

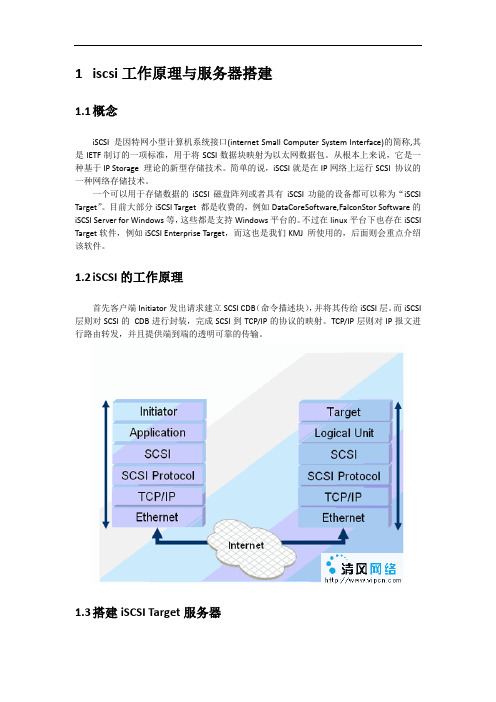

1.2iSCSI的工作原理首先客户端Initiator发出请求建立SCSI CDB(命令描述块),并将其传给iSCSI层。

而iSCSI 层则对SCSI的CDB进行封装,完成SCSI到TCP/IP的协议的映射。

TCP/IP层则对IP报文进行路由转发,并且提供端到端的透明可靠的传输。

1.3搭建iSCSI Target服务器1寻找一台linux服务器,搭建好yum源,我们一般使用kylin 3.1.8或kylin3.2.2操作系统。

2安装iSCSI Target 包yum–y install scsi-target-utils3在该服务器上添加一块空闲分区或者硬盘作为存储盘,比如将/dev/sdb作为映射存储。

4修改配置文件vi /etc/tgt/targets.conf<target zkt> //target名称可自定义backing-store /dev/sdb</target>5启动iSCSI Target服务6service tgtd start7关闭selinux 和防火墙关闭selinux,setenforcesoftmode关闭防火墙,service iptables stop 或者/etc/init.d/iptables start1.4搭建iSCSI Initiator 服务器注:以下操作不需要手动去做,KMJ 已经默认安装或通过web进行配置,只需对其有一定了解即可。

简单描述iscsi工作流程

简单描述iscsi工作流程iSCSI是一种用于在IP网络上传输SCSI命令的协议,它使得远程主机可以通过网络访问存储设备。

iSCSI工作流程包括初始化、发现、登录、传输和终止五个主要阶段。

首先是初始化阶段。

在此阶段,iSCSI初始化器(即发起端)通过初始化器驱动程序发送一个iSCSI请求到目标端的iSCSI引导服务器,请求建立一个iSCSI会话。

初始化器驱动程序负责将本地主机上的SCSI命令转换为iSCSI请求,并将其发送到网络上。

接下来是发现阶段。

在此阶段,目标端的iSCSI引导服务器会回复一个iSCSI响应,其中包含目标端上可用的iSCSI目标设备的信息。

初始化器根据这些信息选择要连接的目标设备。

然后是登录阶段。

在此阶段,初始化器发送一个iSCSI登录请求到目标设备,请求建立一个iSCSI会话。

目标设备通过验证初始化器的身份并分配一个唯一的ISID(iSCSI会话标识符)和TSIH(iSCSI 传输会话标识符)给该会话。

初始化器接受这些标识符,并与目标设备建立起一条逻辑连接。

接着是传输阶段。

在此阶段,初始化器通过iSCSI会话向目标设备发送SCSI命令,目标设备接收并处理这些命令,并将响应发送回初始化器。

传输阶段使用TCP/IP协议,以确保数据的可靠传输。

最后是终止阶段。

在此阶段,初始化器发送一个iSCSI注销请求到目标设备,请求终止当前的iSCSI会话。

目标设备收到注销请求后,终止与初始化器的逻辑连接,并释放该会话使用的资源。

总的来说,iSCSI工作流程包括初始化、发现、登录、传输和终止五个主要阶段。

通过这些阶段,远程主机可以使用iSCSI协议在IP网络上访问存储设备。

iSCSI的优势在于通过使用现有的IP网络基础设施,提供了一种廉价、灵活且易于管理的存储解决方案。

同时,iSCSI也具备与SCSI相似的性能和功能,能够满足大多数存储需求。

RedHat GFS 集群文件系统入门和进阶 资源帖

/viewthread.php?tid=777867&extra=page %3D1%26filter%3DdigestGFS = RedHat Global File SystemGFS 的入门必读以下为入门必看- GFS 的介绍 /solutions/gfs/- RedHat杂志关于GFS的最佳实践/magazine/009jul05/features/gfs_practices/- RedHat杂志关于GFS和以太网和SAN光纤存储网的介绍/magazine/008jun05/features/gfs/- RedHat杂志关于企业如何用GFS来存储数据的介绍/magazine/009jul05/features/gfs_overview/- RedHat杂志关于用GFS来做数据共享的介绍/magazine/006apr05/features/gfs/- RedHat杂志关于RHCS集群的介绍/magazine/009jul05/features/cluster/- RedHat 官方的GFS 概述文档/whitepapers/rha/gfs/GFS_INS0032US.pdf- RedHat 关于GFS扩展性的介绍 /solutions/scaleout/- RedHat和HP提供的HP MC/SG + GFS的方案介绍/promo/hp_serviceguard/ (注意右侧的多个连接所指向的文档)- GFS 6.1U3版本的Release notes /docs/manua ... HEL4U3-relnotes.txt- GFS 6.1U2版本的Release notes /docs/manua ... HEL4U2-relnotes.txt- GFS 6.1的Release notes /docs/manua ... FS_6_1-relnotes.txt - GFS 6.1的Admin Guide /docs/manuals/csgfs/browse/rh-gfs-en/- 本版suran007 同学提供的"GFS6.1 ON RHAS4 U2安装文档" /viewthr ... &extra=page%3D1- 本版发起的"关于多台web服务器挂载GFS系统" 的讨论/viewthr ... 4&highlight=GFS- LinuxVirtualServer 站点上网友hosyp 2006-02-15 发表的"集群LVS+GFS+ISCSI+TOMCAT" /node/100- RedHat杂志关于企业如何用GFS来存储数据的介绍06年8月更新版/magazine/021jul06/features/gfs_update/- gb8007同学发起的关于安装GFS过程中kernel版本和GFS版本的冲突问题/viewthr ... &extra=page%3D1- jeepmac同学发起的关于"自己规划了一个GFS+iSCSI集群方案" /viewthr ... &extra=page%3D1- 重点推荐, RedHat GFS 综合介绍Web 录像 /f/swf/gfs/- zhangning_1999同学贡献的"用VMWARE安装配置GFS(使用DLM方法)" 原创/viewthr ... &extra=page%3D1GFS 软件介绍- RedHat GFS 的版权许可介绍A.RedHat GFS 是一个遵守GPL 开放源代码的集群文件系统B.RedHat出售GFS软件及收费的技术服务C.用户可以选择购从RedHat购买包含技术支持服务的GFS软件D.也可以直接从RedHat官方的服务器上下载rpm格式的源代码包,修改并自由使用(见下面连接)E.可以直接从RedHat CVS服务器 checkout GFS源代码(普通source file+directory).F.用户也可以通过centOS组织提供的服务器,下载已经编译成二进制可运行的GFS或源代码(见下面连接)- RedHat 官方提供的GFS软件的下载 ftp:///pub/redhat/linux/enterprise/4/en/RHGFS- CentOS 组织提供的GFS软件的下载v4 6.1 /centos/4/csgfs/- CentOS 组织提供的GFS软件的下载v3 6.0 /centos/3/csgfs/GFS 进阶应用- RedHat杂志关于GFS和NFS性能和扩展性比较的介绍/magazine/008jun05/features/gfs_nfs/- RedHat杂志关于GFS支持Oracle RAC集群的介绍/magazine/009jul05/features/gfs_oracle/- Google 可以使用的搜索关键字举例 "RedHat GFS Global file system filetype:pdf" - RedHat官方GFS 知识库 /faq/topten_78_0.shtm- RedHat 2006年峰会的GFS和集群相关的演讲稿/promo/summit/presentations/cns.htm。

集群文件系统之GFS2

集群⽂件系统之GFS2⼀、⽂件系统分类 1.集群⽂件系统 GFS2 OCFS2 2.分布式⽂件系统(有分布式⽂件锁。

) GFS(Goole) :适⽤海量⼤⽂件 HDFS(Hadoop) :适⽤海量⼤⽂件 MogileFS :适⽤海量⼩⽂件⼆、RHCS(Redhat Hat Cluster Suite)红帽集群套件 注:需要适⽤GFS2则需要先安装RHCS 1.RHCS概念: RHCS是⼀个功能完备的集群应⽤解决⽅案,它从应⽤的前端访问到数据后端的数据数据存储都提供了⼀个⾏之有效的集群架构实现,通过RHCS提供的这种解决⽅案,不但能保证前端应⽤持久,稳定的提供服务,同时也保证了后端数据存储的安全。

RHCS提供了集群系统中三种集群架构,分别是⾼可⽤性集群,负载均衡集群,存储集群 2.RHCS核⼼功能特点: ⾼可⽤集群 LVS GFS⽂件系统三、部署RHCS的⽅法 1.conga部署(luci+ricci) 控制节点:luci 集群节点:ricci 注意:在安装RHCS的时候要禁⽤epel源 2.⼿动部署四、conga部署RHCS 1.需要四台linux机器。

⼀台控制节点。

三台集群节点。

控制节点安装ansible、并且主机名、双机互信配置完毕。

2.集群节点通过ansible安装ricci (注意这⾥要⽤本机镜像内的源安装,不⽤epel源安装,因为epel版本可能更旧) #ansible webserver -m yum -a "name=ricci state=present disablerepo=epel" 3.主节点安装luci #yum -y install luci --disablerepo=epel 4.验证集群节点ricci服务 netstat -tulp (ricci⽤tcp:1111与upd:111端⼝) 5.启动控制节点服务 service luci start 6.使⽤浏览器登录RHCS管理界⾯(地址在启动服务的时候会显⽰) 7.配置集群节点及资源五、配置GFS2(集群⽂件系统)六、配置CLVM(集群逻辑卷)。

iscsi共享存储(scsi-target-utils包)

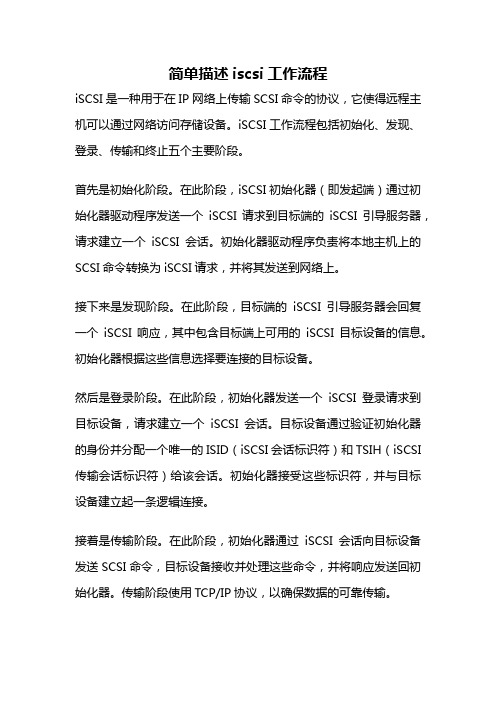

一.概述本实验要搭建一个linux 系统下的iscsi 共享磁盘存储系统,实验一共用到三台机器,其中一个作为target端的存储服务器,另外两个作为client端,用来验证共享存储服务设置是否正确。

本实验用的操作系统是Red Hat Enterprise Linux 5.7 (64位),三台机器用虚拟机创建,虚拟机用的软件是VMware workstation 7.1.0 build-261024。

存储服务器target 端用的软件是redhat自带scsi-target-utils-1.0.14-1.el5.x86_64,client端用到软件也是系统自带的iscsi-initiator-utils-6.2.0.872-10.el5.x86_64。

二.搭建实验环境在虚拟机里创建包含三台机器的虚拟组,组成员在同一网段。

机器名分别为:target ip:192.168.71.133clienta ip: 192.168.71.134clinetb ip: 192.168.71.135target端另外多挂载了两个硬盘,分别为sdb和sdc。

sdb大小20G,sdc大小10G,计划sdb 共享给clienta使用,sdc共享给chientb使用。

在target机器安装scsi-target-utils-1.0.14-1.el5.x86_64# yum -y install scsi-target-utils# service tgtd start# chconfig tgtd on# netstat –anltp|grep 3260client端软件iscsi-initiator-utils-6.2.0.872-10.el5.x86_64默认系统已经安装好了,不用安装了。

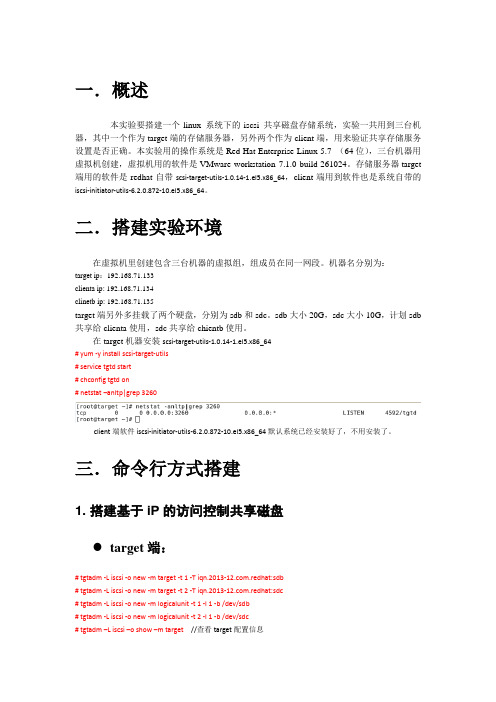

三.命令行方式搭建1. 搭建基于iP的访问控制共享磁盘target端:# tgtadm -L iscsi -o new -m target -t 1 -T .redhat:sdb# tgtadm -L iscsi -o new -m target -t 2 -T .redhat:sdc# tgtadm -L iscsi -o new -m logicalunit -t 1 -l 1 -b /dev/sdb# tgtadm -L iscsi -o new -m logicalunit -t 2 -l 1 -b /dev/sdc# tgtadm –L iscsi –o show –m target //查看target配置信息绑定ip# tgtadm -L iscsi -o bind -m target -t 1 -I 192.168.71.134# tgtadm -L iscsi -o bind -m target -t 2 -I 192.168.71.135# tgtadm –L iscsi –o show –m target //查看target ip 绑定信息。

linux中iscsi配置流程

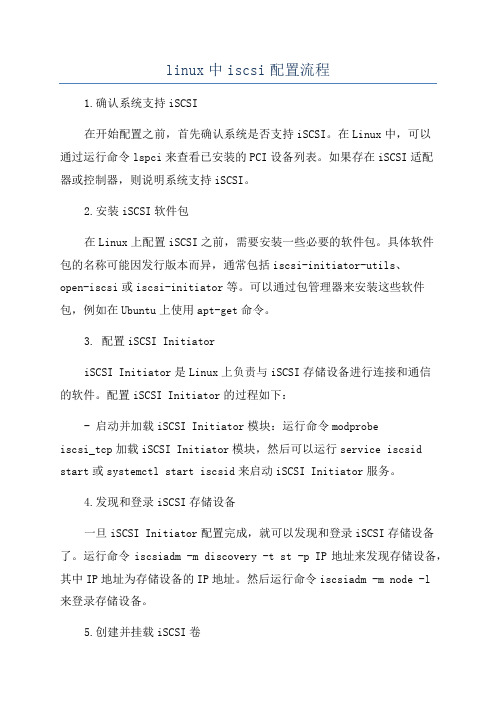

linux中iscsi配置流程1.确认系统支持iSCSI在开始配置之前,首先确认系统是否支持iSCSI。

在Linux中,可以通过运行命令lspci来查看已安装的PCI设备列表。

如果存在iSCSI适配器或控制器,则说明系统支持iSCSI。

2.安装iSCSI软件包在Linux上配置iSCSI之前,需要安装一些必要的软件包。

具体软件包的名称可能因发行版本而异,通常包括iscsi-initiator-utils、open-iscsi或iscsi-initiator等。

可以通过包管理器来安装这些软件包,例如在Ubuntu上使用apt-get命令。

3. 配置iSCSI InitiatoriSCSI Initiator是Linux上负责与iSCSI存储设备进行连接和通信的软件。

配置iSCSI Initiator的过程如下:- 启动并加载iSCSI Initiator模块:运行命令modprobeiscsi_tcp加载iSCSI Initiator模块,然后可以运行service iscsid start或systemctl start iscsid来启动iSCSI Initiator服务。

4.发现和登录iSCSI存储设备一旦iSCSI Initiator配置完成,就可以发现和登录iSCSI存储设备了。

运行命令iscsiadm -m discovery -t st -p IP地址来发现存储设备,其中IP地址为存储设备的IP地址。

然后运行命令iscsiadm -m node -l来登录存储设备。

5.创建并挂载iSCSI卷登录成功后,可以使用命令fdisk -l来查看已登录的iSCSI设备列表。

然后可以使用fdisk命令来创建一个分区,并使用mkfs命令对其进行格式化。

接下来,可以使用mount命令将iSCSI设备挂载到文件系统中。

修改/etc/fstab文件以在系统启动时自动挂载iSCSI设备。

6. 配置iSCSI Target(可选)如果要将Linux系统配置为iSCSI Target,以提供存储资源给其他主机访问,还需要进行进一步的配置。

高可用,多路冗余GFS2集群文件系统搭建详解

⾼可⽤,多路冗余GFS2集群⽂件系统搭建详解⾼可⽤,多路冗余GFS2集群⽂件系统搭建详解2014.06标签:实验拓扑图:实验原理:实验⽬的:通过RHCS集群套件搭建GFS2集群⽂件系统,保证不同节点能够同时对GFS2集群⽂件系统进⾏读取和写⼊,其次通过multipath 实现node和FC,FC和Share Storage之间的多路冗余,最后实现存储的mirror复制达到⾼可⽤。

GFS2:全局⽂件系统第⼆版,GFS2是应⽤最⼴泛的集群⽂件系统。

它是由红帽公司开发出来的,允许所有集群节点并⾏访问。

元数据通常会保存在共享存储设备或复制存储设备的⼀个分区⾥或逻辑卷中。

实验环境:1 2 3 4 5 6 7 8[root@storage1 ~]# uname -r2.6.32-279.el6.x86_64[root@storage1 ~]# cat /etc/redhat-releaseRed Hat Enterprise Linux Server release 6.3 (Santiago) [root@storage1 ~]# /etc/rc.d/init.d/iptables status iptables: Firewall is not running.[root@storage1 ~]# getenforceDisabled实验步骤:1、前期准备⼯作0)、设置⼀台管理端()配置ssh 私钥、公钥,将公钥传递到所有节点上12 3 4 5 6 7 8 9 10 11 12 13 14[root@manager ~]# ssh-keygen \\⽣成公钥和私钥Generating public/private rsa key pair.Enter file in which to save the key (/root/.ssh/id_rsa):Enter passphrase (empty for no passphrase):……[root@manager ~]# for i in {1..6}; do ssh-copy-id -i 192.168.100.17$i; done \\将公钥传输到各节点/root/.ssh/⽬录下root@192.168.100.171's password:Now try logging into the machine, with "ssh '192.168.100.171'", and check in:.ssh/authorized_keysto make sure we haven't added extra keys that you weren't expecting..……[root@manager ~]# ssh node1 \\测试登录Last login: Sat Jun 8 17:58:51 2013 from 192.168.100.31[root@node1 ~]#1)、配置双⽹卡IP,所有节点参考拓扑图配置双⽹卡,并配置相应IP即可1 2 3 4 5[root@storage1 ~]# ifconfig eth0 | grep "inet addr" | awk -F[:" "]+ '{ print $4 }' 192.168.100.171[root@storage1 ~]# ifconfig eth1 | grep "inet addr" | awk -F[:" "]+ '{ print $4 }' 192.168.200.171……2)、配置hosts⽂件并同步到所有节点去(也可以配置DNS,不过DNS解析绝对不会有hosts解析快,其次DNS服务器出问题会直接导致节点和节点以及和存储直接不能够解析⽽崩溃)12 3 4 5 6 7 8 9[root@manager ~]# cat /etc/hosts127.0.0.1 localhost 192.168.100.102 manager 192.168.100.171 storage1 192.168.200.171 storage1 192.168.100.172 storage2 192.168.200.172 storage2 192.168.100.173 node1 192.168.200.173 node1 192.168.100.174 node2 9 10 11 12 13 14 15 16 17 18 19 20 21 22192.168.100.174 node2 192.168.200.174 node2 192.168.100.175 node3 192.168.200.175 node3 192.168.100.176 node4 192.168.200.176 node4 [root@manager ~]# for i in {1..6}; do scp /etc/hosts 192.168.100.17$i:/etc/ ; done hosts 100% 591 0.6KB/s00:00 hosts 100% 591 0.6KB/s00:00 hosts 100% 591 0.6KB/s00:00 hosts 100% 591 0.6KB/s00:00 hosts 100% 591 0.6KB/s00:00 hosts 100% 591 0.6KB/s00:003)、配置yum源(将所有节点光盘挂接到/media/cdrom,如果不⽅便,也可以做NFS,将镜像挂载到NFS⾥⾯,然后节点挂载到NFS共享⽬录中即可,注意:不同版本的系统,RHCS集群套件存放位置会有所不同,所以yum源的指向位置也会有所不同)1234 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38[root@manager ~]# cat /etc/yum.repos.d/rhel-gfs2.repo[rhel-cdrom]name=RHEL6U3-cdrombaseurl=file:///media/cdromenabled=1gpgcheck=0[rhel-cdrom-HighAvailability]name=RHEL6U3-HighAvailabilitybaseurl=file:///media/cdrom/HighAvailabilityenabled=1gpgcheck=0[rhel-cdrom-ResilientStorage]name=RHEL6U3-ResilientStoragebaseurl=file:///media/cdrom/ResilientStorageenabled=1gpgcheck=0[rhel-cdrom-LoadBalancer]name=RHEL6U3-LoadBalancerbaseurl=file:///media/cdrom/LoadBalancerenabled=1gpgcheck=0[rhel-cdrom-ScalableFileSystem]name=RHEL6U3-ScalableFileSystembaseurl=file:///media/cdrom/ScalableFileSystemenabled=1gpgcheck=0[root@manager ~]# for i in {1..6}; do scp /etc/yum.repos.d/rhel-gfs2.repo 192.168.100.17$i:/etc/yum.repos.d ; done rhel-gfs2.repo 100% 588 0.6KB/s00:00rhel-gfs2.repo 100% 588 0.6KB/s00:00rhel-gfs2.repo 100% 588 0.6KB/s00:00rhel-gfs2.repo 100% 588 0.6KB/s00:00rhel-gfs2.repo 100% 588 0.6KB/s00:00rhel-gfs2.repo 100% 588 0.6KB/s00:00[root@manager ~]# for i in {1..6}; do ssh 192.168.100.17$i "yum clean all && yum makecache"; doneLoaded plugins: product-id, security, subscription-managerUpdating certificate-based repositories.Unable to read consumer identity……4)、时间要同步,可以考虑配置NTP时间服务器,如果联⽹可以考虑同步互联⽹时间,当然也可以通过date命令设置相同时间。

ISCSI服务器简介

ISCSI服务器简介3.0.0 本章简介:-描述iSCSI存储的工作原理与机制;-如何定义iSCSI的服务器端与客户端;-解释说明iSCSI的配置与有关工具;3.0.1 红帽的iSCSI驱动器:在第一章中我们就熟悉到了什么是iSCSI。

iSCSI(ip Over SCSI)业内也常叫作ipSAN,即是通过TCP/IP的网络协议来传输磁盘的SCSI数据,随着以太网技术的进展,千兆万兆都将应用在企业中,而以iSCSI存储的性价比,很多中小型企业会更加倾向于使用。

也就是说,iSCSI是基于TCP/IP下的网络存储解决方案,那么iSCSI与SCSI/FC存储机制有什么不一致呢:左边的模型是iSCSI存储的整个数据流淌模型,右边的是FC SAN 的模型,通过这个图能够清晰地看出iSCSI存储与FC光纤存储的对应关系。

从模型架构的角度来看,iSCSI驱动器结合了主机的TCP/IP协议栈、网络驱动器与网卡,提供了与SCSI/FC驱动器一样的功能。

尽量用单独的网络来使用iSCSI存储。

3.02 iSCSI数据访问:iSCSI存储分为服务器端(targets)与客户端(initiators),客户端发送SCSI命令到远程的存储设备端(服务器端),iSCSI使用的是TCP/IP 协议,默认使用TCP的3260端口。

客户端:-通过discovery程序来请求远程的块设备;-客户端务必安装了iscsi设备驱动器;-要安装iscsi-initiator-utils-*.rpm软件包;服务器端:-公布一个或者多个块设备给initiator访问;-从RHEL5.3以后开始支持iSCSI;-需要安装scsi-target-utils-*.rpm软件包;关于每个target来说,主机ID是唯一的,存储块设备的LUN ID 是由iSCSI target来分配的。

iSCSI驱动器为SCSI请求与回应提供了一个通过IP网络传输的渠道。

ISCSI系统验证与NFS性能比较

ISCSI系统验证与NFS性能比较一、Iscsi部署环境:1.一台iscsi-target(9.186.88.248:redhat 6.1):把本地硬盘上的分区通过iscsi共享给iscsi的initiator客户端。

2.一台iscsi-initiator(9.186.88.247:redhat 5.6):连接iscsi-target服务端的硬盘。

二、Target 配置:1./etc/hosts 文件配置:# Do not remove the following line, or various programs# that require network functionality will fail.127.0.0.1 localhost.localdomain localhost::1 localhost6.localdomain6 localhost69.186.88.248 target9.186.88.247 rhcs19.186.88.246 rhcs22.确保tgtd服务能够启动起来:如果service tgtd restart不成功,可能3260端口被占用,通过lsof -i:3260命令来查看占用3260端口的进程并将其杀死,这样tgtd服务便可以启动了。

三、Target创建脚本和Client连接验证脚本目前在9.186.88.247上/repository/deployshell/iscsiTargetCreate.sh/repository/deployshell/iscsiClientScan.sh四、Initiator发现和挂载:1.在9.186.88.247上执行如下命令发现iscsi设备:iscsiadm -m discovery -t sendtargets -p 9.186.88.2482.执行如下命令登陆设备,重启iscsi服务生效:iscsiadm -m node -T .ibm.disk1 -p 9.186.88.248service iscsi restart3.挂载设备,通过fdisk -l发现/dev/sdb,将/dev/sdb挂到/mnt下的iscsi目录下。

EAS系统部署方案

金蝶EAS系统部署方案金蝶软件(中国)有限公司前言概述描述EAS产品技术架构,基本部署模型以及不同并发规模下的软硬件选型参考建议等。

各个模块权重计算软、硬件配置等。

适用范围现场实施同事、总部研发。

约定符号约定在本文中可能出现下列标志,它们所代表的含义如下。

内容约定本处对文中通用信息作如下约定●$EAS_HOME表示EAS服务器安装的根目录,即安装过程中输入的本地路径。

●$BOS_HOME表示BOS工具的安装根目录,即安装过程中输入的本地路径。

目录1 前言 (5)2 金蝶BOS (6)3 系统部署方式 (8)3.1标准方案 (8)3.2双机互备方案 (9)3.3应用级集群部署方案 (10)3.3.1 集群模型特点 (10)3.3.2 集群部署建议 (11)3.4系统级集群方案 (11)3.4.1 IBM P系列服务器群集技术(HACMP) (11)3.4.2 HP MC/ServiceGuard 集群方案 (12)3.5分区技术 (13)4 网络安全 (13)4.1防火墙 (13)4.2VPN技术 (14)4.3C ITRIX解决方案 (15)4.4多种身份认证 (17)5 网络环境 (18)5.1网络指标 (18)5.2局域网 (18)5.3无线局域网(WLAN) (19)5.4广域网 (20)5.5南北电信互联互通问题 (23)6 服务器选型与配置 (24)6.1EAS运行支持环境 (24)6.2服务器硬件选型 (26)6.3磁盘存储系统 (28)6.4数据备份 (29)6.5数据库选型 (30)6.6应用服务器选型 (31)6.7客户端硬件配置 (31)7 典型配置 (31)7.220个并发用户以内 (32)7.320-50个并发用户数 (34)7.450-100个并发用户数 (37)7.5100-200个并发用户数 (38)7.6200-500个并发用户数 (41)7.7500个并发用户数以上 (43)7.8EAS群集部署案例 (46)8 附件:性能测试报告 (47)8.1EAS IBM IIC(上海)性能测试报告 (47)8.2EAS HP方案解决中心性能测试报告 (51)8.3EAS S UN F IRE服务器兼容性暨性能测试报告 (55)8.4金蝶EAS V6.0IBM POWERBLADE服务器性能测试报告 (58)1 前言金蝶EAS(Enterprise Application Suite),是金蝶国际软件集团推出的新一代企业应用套件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

RedHat GFS基于ISCSI的部署一、描述:部署基于ISCSI方案的GFS。

涉及技术:并发文件系统技术--GFS2基于IP协议的SAN技术--ISCSIRedHat 集群技术--RHCS二、环境:一台iscsi—target :采用centos 5.2 x64 的系统,采用PXE方式安装8G系统硬盘,外加24G硬盘;作为iscsi的target服务端,把本地硬盘上的分区通过iscsi共享给iscsi的initiator客户端;两台iscsi—initiator:entos 5.2 x64 的系统,采用PXE方式安装,各有一块8G系统硬盘;作为iscsi的initiator客户端,连接iscsi-target服务端的硬盘,并在集群中规划为GFS文件系统模式下的集群存储池;三、IP配置:#iscsi—target:IP:10.0.40.31DNS:#iscsi—initiator:IP:10.0.70.51DNS:#iscsi—initiator:IP:10.0.70.61DNS:/etc/hosts 文件配置# Do not remove the following line, or various programs# that require network functionality will fail.127.0.0.1 localhost.localdomain localhost::1 localhost6.localdomain6 localhost610.0.40.31 target10.0.70.51 rhcs110.0.70.61 rhcs2四、ISCSI—Target(10.0.40.31)配置步骤:4.1 安装iscsi软件#下载iSCSI Enterprise Targetwget /sourceforge/iscsitarget/iscsitarget-0.4.17.tar.gz#解压缩tar -zxvf iscsitarget-0.4.17.tar.gzcd iscsitarget-0.4.17#编译、安装makemake install#或者使用yum安装Yum install -y scsi-target-utils#安装集群软件包套件yum groupinstall "Clustering" "Cluster Storage"#配置服务chkconfig --level 2345 tgtd onservice tdtd start4.2挂载设备#配置第一个iSCSI设备#系统另外挂了一个24G的硬盘,划分出三个分区即:[root@10_0_40_31 ~]# fdisk -lDisk /dev/sda: 8589 MB, 8589934592 bytes255 heads, 63 sectors/track, 1044 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 521 4184901 83 Linux/dev/sda2 522 1043 4192965 82 Linux swap / SolarisDisk /dev/sdb: 25.7 GB, 25769803776 bytes255 heads, 63 sectors/track, 3133 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 1045 8393931 83 Linux/dev/sdb2 1046 2090 8393962+ 83 Linux/dev/sdb3 2091 3133 8377897+ 83 Linux#通过tgt服务器把这三个分区共享出来:[root@10_0_40_31 ~]# chkconfig tgtd on[root@10_0_40_31 ~]# service tgtd restartStopping SCSI target daemon: [ OK ]Starting SCSI target daemon: [ OK ]#使用tgtadm定义iscsi target的qualified的名字:[root@10_0_40_31 ~]# tgtadm --lld iscsi --op new --mode target --tid 1 -T .haoyuan-inc.disk1[root@10_0_40_31 ~]# tgtadm --lld iscsi --op new --mode target --tid 2 -T .haoyuan-inc.disk2[root@10_0_40_31 ~]# tgtadm --lld iscsi --op new --mode target --tid 3 -T .haoyuan-inc.disk3#使用tgtadm为上一步创建的目标增加分区:[root@10_0_40_31 ~]# tgtadm --lld iscsi --op new --mode logicalunit --tid 1 --lun 1 -b /dev/sdb1 [root@10_0_40_31 ~]# tgtadm --lld iscsi --op new --mode logicalunit --tid 2 --lun 1 -b /dev/sdb2 [root@10_0_40_31 ~]# tgtadm --lld iscsi --op new --mode logicalunit --tid 3 --lun 1 -b /dev/sdb3 #使用tgtadm允许客户端访问这三个目标逻辑卷:[root@10_0_40_31 ~]# tgtadm --lld iscsi --op bind --mode target --tid 1 -I ALL[root@10_0_40_31 ~]# tgtadm --lld iscsi --op bind --mode target --tid 2 -I ALL[root@10_0_40_31 ~]# tgtadm --lld iscsi --op bind --mode target --tid 3 -I ALL#使用tatadm验证所有的目标逻辑卷定义正确:[root@10_0_40_31 ~]# tgtadm --lld iscsi --op show --mode target |grep TargetTarget 1: .haoyuan-inc.disk1Target 2: .haoyuan-inc.disk2Target 3: .haoyuan-inc.disk3#为使配置生效,将上述命令添加到/etc/rc.local,添加命令:cat >> /etc/rc.local# tgtadm --lld iscsi --op new --mode target --tid 1 -T .haoyuan-inc.disk1# tgtadm --lld iscsi --op new --mode target --tid 2 -T .haoyuan-inc.disk2# tgtadm --lld iscsi --op new --mode target --tid 3 -T .haoyuan-inc.disk3# tgtadm --lld iscsi --op new --mode logicalunit --tid 1 --lun 1 -b /dev/sdb1# tgtadm --lld iscsi --op new --mode logicalunit --tid 2 --lun 1 -b /dev/sdb2# tgtadm --lld iscsi --op new --mode logicalunit --tid 3 --lun 1 -b /dev/sdb3# tgtadm --lld iscsi --op bind --mode target --tid 1 -I ALL# tgtadm --lld iscsi --op bind --mode target --tid 2 -I ALL# tgtadm --lld iscsi --op bind --mode target --tid 3 -I ALLEOF五、ISCSI—Initiator(10.0.70.51&10.0.70.61)配置步骤:5.1 rhcs1配置步骤:#安装iscsi-initiator软件包Yum install -y iscsi-initiator-utils#安装集群软件包套件yum groupinstall "Clustering" "Cluster Storage"#启动iscsifuw[root@10_0_70_51 ~]# chkconfig iscsi on[root@10_0_70_51 ~]# service iscsi startiscsid is stoppedTurning off network shutdown. Starting iSCSI daemon: [ OK ][ OK ]Setting up iSCSI targets: iscsiadm: No records found![ OK ]#运行下面命令,查看target上的逻辑卷[root@10_0_70_51 ~]# iscsiadm -m discovery -t sendtargets -p 10.0.40.3110.0.40.31:3260,1 .haoyuan-inc.disk110.0.40.31:3260,1 .haoyuan-inc.disk210.0.40.31:3260,1 .haoyuan-inc.disk3#上述表示已经挂载成功#使用iscsiadmin登陆target:[root@10_0_70_51 ~]# iscsiadm -m node -T .haoyuan-inc.disk1 -p 10.0.40.31 -l Logging in to [iface: default, target: .haoyuan-inc.disk1, portal: 10.0.40.31,3260] Login to [iface: default, target: .haoyuan-inc.disk1, portal: 10.0.40.31,3260]: successful[root@10_0_70_51 ~]# iscsiadm -m node -T .haoyuan-inc.disk2 -p 10.0.40.31 -l Logging in to [iface: default, target: .haoyuan-inc.disk2, portal: 10.0.40.31,3260]Login to [iface: default, target: .haoyuan-inc.disk2, portal: 10.0.40.31,3260]: successful[root@10_0_70_51 ~]# iscsiadm -m node -T .haoyuan-inc.disk3 -p 10.0.40.31 -l Logging in to [iface: default, target: .haoyuan-inc.disk3, portal: 10.0.40.31,3260] Login to [iface: default, target: .haoyuan-inc.disk3, portal: 10.0.40.31,3260]: successfu#使用fdisk检验被识别的设备名:[root@10_0_70_51 ~]# fdisk -lDisk /dev/sda: 8589 MB, 8589934592 bytes255 heads, 63 sectors/track, 1044 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 521 4184901 83 Linux/dev/sda2 522 1043 4192965 82 Linux swap / SolarisDisk /dev/sdb: 8595 MB, 8595385344 bytes64 heads, 32 sectors/track, 8197 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDisk /dev/sdb doesn't contain a valid partition tableDisk /dev/sdc: 8595 MB, 8595417600 bytes64 heads, 32 sectors/track, 8197 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDisk /dev/sdc doesn't contain a valid partition tableDisk /dev/sdd: 8578 MB, 8578967040 bytes64 heads, 32 sectors/track, 8181 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDisk /dev/sdd doesn't contain a valid partition table#从上面看,iscsitarget上的逻辑卷,已经被识别为/dev/sdb /dev/sdc /dev/sdc三个本地硬盘#在这三个硬盘上分别建立三个分区,下面为结果:[root@10_0_70_51 ~]# fdisk -lDisk /dev/sda: 8589 MB, 8589934592 bytes255 heads, 63 sectors/track, 1044 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 521 4184901 83 Linux/dev/sda2 522 1043 4192965 82 Linux swap / SolarisDisk /dev/sdb: 8595 MB, 8595385344 bytes64 heads, 32 sectors/track, 8197 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 8197 8393712 83 LinuxDisk /dev/sdc: 8595 MB, 8595417600 bytes64 heads, 32 sectors/track, 8197 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytes/dev/sdc1 1 8197 8393712 83 LinuxDisk /dev/sdd: 8578 MB, 8578967040 bytes64 heads, 32 sectors/track, 8181 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDevice Boot Start End Blocks Id System/dev/sdd1 1 8181 8377328 83 Linux5.2 rhcs2配置步骤:#安装iscsi-initiator软件包Yum install -y iscsi-initiator-utils#安装集群软件包套件yum groupinstall "Clustering" "Cluster Storage"#启动iscsifuw[root@10_0_70_61 ~]# chkconfig iscsi on[root@10_0_70_61 ~]# service iscsi startiscsid is stoppedTurning off network shutdown. Starting iSCSI daemon: [ OK ][ OK ]Setting up iSCSI targets: iscsiadm: No records found![ OK ]#运行下面命令,查看target上的逻辑卷[root@10_0_70_61 ~]# iscsiadm -m discovery -t sendtargets -p 10.0.40.3110.0.40.31:3260,1 .haoyuan-inc.disk110.0.40.31:3260,1 .haoyuan-inc.disk210.0.40.31:3260,1 .haoyuan-inc.disk3#上述表示已经挂载成功#使用iscsiadmin登陆target:[root@10_0_70_61 ~]# iscsiadm -m node -T .haoyuan-inc.disk1 -p 10.0.40.31 -l Logging in to [iface: default, target: .haoyuan-inc.disk1, portal: 10.0.40.31,3260] Login to [iface: default, target: .haoyuan-inc.disk1, portal: 10.0.40.31,3260]: successful[root@10_0_70_61 ~]# iscsiadm -m node -T .haoyuan-inc.disk2 -p 10.0.40.31 -l Logging in to [iface: default, target: .haoyuan-inc.disk2, portal: 10.0.40.31,3260] Login to [iface: default, target: .haoyuan-inc.disk2, portal: 10.0.40.31,3260]: successful[root@10_0_70_61 ~]# iscsiadm -m node -T .haoyuan-inc.disk3 -p 10.0.40.31 -l Logging in to [iface: default, target: .haoyuan-inc.disk3, portal: 10.0.40.31,3260] Login to [iface: default, target: .haoyuan-inc.disk3, portal: 10.0.40.31,3260]: successful#扫描本地硬盘:[root@10_0_70_61 ~]# fdisk -lDisk /dev/sda: 8589 MB, 8589934592 bytes255 heads, 63 sectors/track, 1044 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytes/dev/sda1 * 1 521 4184901 83 Linux/dev/sda2 522 1043 4192965 82 Linux swap / Solaris Disk /dev/sdb: 8595 MB, 8595385344 bytes64 heads, 32 sectors/track, 8197 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 8197 8393712 83 LinuxDisk /dev/sdc: 8595 MB, 8595417600 bytes64 heads, 32 sectors/track, 8197 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDevice Boot Start End Blocks Id System/dev/sdc1 1 8197 8393712 83 LinuxDisk /dev/sdd: 8578 MB, 8578967040 bytes64 heads, 32 sectors/track, 8181 cylindersUnits = cylinders of 2048 * 512 = 1048576 bytesDevice Boot Start End Blocks Id System/dev/sdd1 1 8181 8377328 83 Linux六、配置rhcs1和rhcs2分别enable基于集群的lvm-clvm:#开启集群Lvmconf --enable-cluster#添加开机启动Chkconfig clvmd on启动clvmd服务Server clvmd start[root@10_0_70_51 ~]# lvmconf --enable-cluster[root@10_0_70_51 ~]# chkconfig clvmd on[root@10_0_70_51 ~]# service clvmd start[root@10_0_70_61 ~]# lvmconf --enable-cluster[root@10_0_70_61 ~]# chkconfig clvmd on[root@10_0_70_61 ~]# service clvmd start七、配置GFS和CLUSTER7.1 基本设置#初始化luci:Luci_admin init#添加开机启动Chkconfig clvmd on#重启动luci服务Service luci restart[root@10_0_40_31 ~]# luci_admin initInitializing the luci serverCreating the 'admin' userEnter password:Confirm password:Please wait...The admin password has been successfully set.Generating SSL certificates...The luci server has been successfully initializedYou must restart the luci server for changes to take effect.Run "service luci restart" to do so[root@10_0_40_31 ~]# chkconfig clvmd on[root@10_0_40_31 ~]# service luci restartShutting down luci: [ OK ]Starting luci: Generating https SSL certificates... done[ OK ]Point your web browser to https://10_0_40_31:8084 to access luci#登陆luci ,如图:#如出现Site Error 这样可以解决:IE中的设置,点击IE菜单栏中的"工具"--"Internet 首选项"---"常规"点击语言按钮,添加英语,将将设为最优先.7.2 创建hy0-cluster基本框架#添加机器到集群,如图:#提交后结果,如图:#在经过install-reboot-configure-join四个过程后,hy0-cluster基本形成,如图:#查看hy0-cluster的状态:#绿色表示正常#查看运行的服务,cman&rgmanager7.3 设置共享存储#点击,如图:#点击Volume Groups 点击New Volume Group 输入名称:HyVol,选择/dev/sdb /dev/sdc /dev/sdc 点击create ,如图:#点击New Logical Volume按钮,创建逻辑卷,如图:Name:HyVolContent:gfs2GFS name:Hy-lvMountpoint:/lvNumber:3创建完毕后,结果如下:#查看[root@10_0_70_61 mapper]# df -lhFilesystem Size Used Avail Use% Mounted on/dev/sda1 3.9G 3.2G 531M 86% /tmpfs 1006M 0 1006M 0% /dev/shm/dev/shm 1006M 0 1006M 0% /tmp/dev/mapper/HyVol-hy_lv24G 67M 24G 1% /lv#/etc/fstab........../dev/mapper/HyVol-hy_lv /lv gfs2 defaults 0 0八、补充说明以上为luci方式配置的集群,这种方法最为方便,其他方式有向导和命令方式,向导方式和luci方式大致相同暂略,下面为命令行方式配置步骤:#基本环境:#iscsi—target:IP:10.0.40.31DNS:#iscsi—initiator:IP:10.0.70.51DNS:#iscsi—initiator:IP:10.0.70.61DNS:#安装软件包[rhcs1 and rhcs2] yum install -y cman gfs-utils kmod-gfs kmod-dlm modcluster ricci cluster-snmp iscsi-initiator-utils lvm2-cluster openais oddjob rgmanager#配置iscsi-initiator[rhcs1 and rhcs2] echo -e "node.startup = automatic\ername = ISCSI_USER\nnode.session.auth.password = ISCSI_PASS\ername =ISCSI_USER\ndiscovery.sendtargets.auth.password = ISCSI_PASS\nnode.session.timeo.replacement_timeout = 120\nnode.conn[0].timeo.login_timeout = 15\nnode.conn[0].timeo.logout_timeout = 15\nnode.conn[0].timeo.noop_out_interval = 10\nnode.conn[0].timeo.noop_out_timeout = 15\nnode.session.iscsi.InitialR2T = No\nnode.session.iscsi.ImmediateData = Yes\nnode.session.iscsi.FirstBurstLength = 262144\nnode.session.iscsi.MaxBurstLength = 16776192\nnode.conn[0].iscsi.MaxRecvDataSegmentLength = 65536">/etc/iscsi/iscsid.Conf #ISCSI_USER 更改为你的用户名#ISCSI_PASS 更改为你的密码#启动iscsi服务[rhcs1 and rhcs2] service iscsi start#查看iscsi-target端列表[rhcs1 and rhcs2] iscsiadm -m discovery -t sendtargets -p 10.0.40.31#重启iscsi服务[rhcs1 and rhcs2] service iscsi restart#查看结果[rhcs1 and rhcs2] disk -l/dev/sdb/dev/sdc/dev/sdd#已经成功挂载iscsi 设备#配置/etc/hosts文件[rhcs1 and rhcs2 and iscsi-server] vi /etc/hosts# Do not remove the following line, or various programs# that require network functionality will fail.127.0.0.1 localhost.localdomain localhost::1 localhost6.localdomain6 localhost610.0.40.31 target10.0.70.51 rhcs110.0.70.61 rhcs2#配置节点[rhcs1 and rhcs2]ccs_tool create MyGFSClusterccs_tool addfence -C node1_ipmi fence_ipmilan ipaddr=192.168.255.1 login=root passwd=密码ccs_tool addfence -C node2_ipmi fence_ipmilan ipaddr=192.168.255.2 login=root passwd=密码ccs_tool addnode -C rhcs1 -n 1 -v 1 -f node1_ipmiccs_tool addnode -C rhcs2 -n 2 -v 1 -f node2_ipmiservice cman startcman_tool nodesNode Sts Inc Joined Name1 M 4 rhcs12 M 16 rhcs2#启动GFS服务service gfs start ;service gfs2 start ;#启动clvmd服务service clvmd start#开启clusterlvmconf --enable-cluster#装机GFS文件系统[rhcs1]pvcreate /dev/sdavgcreate vg_test /dev/sdalvcreate -n GFStest -L 9G vg_testgfs_mkfs -j 4 -p lock_dlm -t MyGFSCluster:FirstGFSVolume /dev/vg_test/GFStest #启动相关服务[rhcs1 and rhcs2]chkconfig gfs onchkconfig gfs2 onchkconfig clvmd onchkconfig cman onchkconfig iscsi onchkconfig acpid off#挂载逻辑卷echo "/dev/vg_test/GFStest /mnt gfs defaults 0 0" >>/etc/fstabmount /mnt#验证配置结果[rhcs1]Filesystem Type Size Used Avail Use% Mounted on/dev/hda1 ext3 8.8G 695M 7.6G 9% /tmpfs tmpfs 506M 0 506M 0% /dev/shm/dev/mapper/gfstest-lvgfstestgfs 19G 11M 19G 1% /mnt[rhcs2]Filesystem Type Size Used Avail Use% Mounted on/dev/hda1 ext3 8.8G 695M 7.6G 9% /tmpfs tmpfs 506M 0 506M 0% /dev/shm/dev/mapper/gfstest-lvgfstestgfs 19G 11M 19G 1% /mnt。