第二十一讲广义特征值与极小极大原理

矩阵特征值问题

§1、特征值的估计

由于工程计算中求矩阵尤其是高阶矩阵的 精确特征值通常比较困难,而许多情况下我们 只需要知道特征值在什么范围内变化或者落在 什么区域内,例如判断方阵的幂级数是否收敛 只要看方阵的特征值的模或谱半径是否小于1, 因此特征值的估计就显得尤其必要,这方面的 理论在特征值问题中相当经典。

由于

实际上是 的

一个

维子空间,因此我们希望将

搜索极值的空间放大到任意

维子空

间 。而增大后的集合的极大值不会比原集

合的小,极小值也不会比原集合大。

58

设有 则

,并假定

,即

59

并且当

时等号成立。因此

60

一般地,我们有

定理4 (Courant-Fischer)设

是

Hermite矩阵,其特征值为

,则

存在Hermite矩阵特征值的极值原理

48

一、 Rayleigh商

二次型

,如果存在

,那么

所以如果

,我们自然也希望

49

定义1 设

是Hermite矩阵,称

为矩阵 的Rayleigh商。 注意到

因此我们可以把对 在单位球面

的极性的讨论限定 上。

50

单位球面 是闭集,又因为

是 的连续

函数,因此根据多元函数的最值定理,

在 上存在最大值和最小值。由于特征值与

对于广义特征值问题

,可以通过

适当选择位移(shift)或极点(pole) ,再通过 求逆,将之转化为SEP:

这种方法的优点是特征向量不变,矩阵 奇 异时也可以使用,并且在求解邻近 的特征 值或绝对值很小的特征值时效率较高。缺点仍 然是 一般不是特殊矩阵。

广义特征值分解

广义特征值分解广义特征值分解(Generalized Eigenvalue Decomposition, GED)是一种重要的矩阵分解方法,常常被应用在信号处理、机器学习等领域中。

它能够将两个矩阵同时对角化,得到它们的特征向量和特征值。

在本文中,我们将对广义特征值分解做一个详细的讲解。

步骤一:理解特征值与特征向量在矩阵计算中,特征向量是指在矩阵进行线性变换后仍然保留其方向的向量。

特征值是与特征向量相关的标量,描述了该特征向量在变换中的“伸缩”程度。

一般来说,我们可以通过解决以下方程式来找到一个矩阵的特征向量和特征值:(A−λI)v=0其中,A是一个方阵,λ是一个标量,I是单位矩阵,v是特征向量。

步骤二:理解广义特征值分解在广义特征值分解中,我们要找到两个矩阵A和B的特征向量和特征值。

也就是说,我们需要解决以下方程式:Av=λBv其中,v是特征向量,λ是特征值。

将其转化为标准形式:(A−λB)v=0这样,我们就可以将两个矩阵同时对角化,得到它们的特征向量和特征值。

步骤三:寻找广义特征值分解在实际应用中,我们可以使用数值计算方法来寻找广义特征值分解。

这包括基于迭代算法的方法,如幂法、反幂法和雅可比迭代法等。

其中,幂法是最常用的方法之一,可以用来寻找矩阵的最大特征值和对应的特征向量。

雅可比迭代法则是另一个最常见的方法,可以用来寻找所有特征值和对应的特征向量。

步骤四:应用广义特征值分解广义特征值分解在实际应用中有很多用途。

例如,它可以用来处理分析较大的数据集、图像、信号等。

在信号处理领域中,可以将电磁波分解为多个频率的成分,在图像处理领域中,可以寻找图像的相似性和模式。

在机器学习领域中,广义特征值分解可以被用来进行降维和特征提取。

总之,广义特征值分解是一种非常有用的矩阵分解方法,在很多领域中都被广泛应用。

理解广义特征值分解的原理和寻找方法,将有助于我们更好地应用这种方法来解决实际问题。

第五章 特征值估计及对称矩阵的极性-1

三,广义特征值分解算法

3. GEVD的总体最小二乘算法: 步一,对阵A进行SVD: A=U∑VH≈U1∑1V1H , 其中∑1是的主奇异值阵; 步 二 , 把 A-λB 左 乘 U1H 并 右 乘 V1 , 得 ∑ 1λU1HBV1 , 从 而 转 化 成 新 的 矩 阵 束 (∑1 , λU1HBV1)的GEVD问题. 该方法适合于有噪情况下的主特征对的计算. 参见张贤达的《矩阵分析与应用》的第8 参见张贤达的《矩阵分析与应用》的第8.8节.

§5.2 广义特征值问题

定义 称Ax=λBx的特征值问题为矩阵 相 定义: 矩阵A相 矩阵 对于矩阵B的广义特征值问题 的广义特征值问题,称数λ为矩 对于矩阵 的广义特征值问题 矩 相对于矩阵B的特征值 阵A相对于矩阵 的特征值 相对于矩阵 的特征值;而与λ相对应 的非零解x称之为属于λ的特征向量 属于 的特征向量. 广义特征值由det(A-λB)=0的根给出. 一,广义特征值问题的等价形式 1. 等价形式1:B可逆时B-1Ax=λx,等价地化 为非对称阵B-1A的普通特征值问题. 2. 等价形式2:B正定时B =GGT使得Sy=λy, 其中y=GTx, 对称阵S=G-1AG-T.等价地转 化为对称矩阵S的普通特征值问题

二,特征值的包含区域

1. 定义 设A=(aij)∈Cn×n,称区域Gi:|z-aii|≤Ri 为矩阵 A 的第 i 个盖尔圆 第 个盖尔圆,其中 Ri=∑j≠i|aij| 称为盖尔圆Gi的半径(i=l,…,n) . 盖尔圆 2. 定理 矩阵 A=(aij)∈Cn×n 的一切特征值都 在它的n个盖尔圆的并集之内. 3.定理 由矩阵A的所有盖尔圆组成的连通 定理 部分中任取一个,如果它是由k个盖尔圆 构成的,则在这个连通部分中有且仅有A 的k个特征值(盖尔圆相重时重复计数.特 征但相同时也重复计数)..

矩阵不等式

(5.1.3) (5.1.4)

推论: Hermite 矩阵的特征值都是实数; 反 Hermite 矩阵的特征值为零或纯虚数。 事实上,当 A 为 Hermite 矩阵时,由式(5.1.4) 知 Im( )=0,即 为实数; 当 A 为反 Hermite 矩阵时,由式(5.1.3)知 Re( )=0,即为 为零或纯虚数。 定义.5.1 设 A (ars ) C

a1

h

p O q ak

定理 5.5 (Schur’s inequality) 设 A=(ars)Cn×n 的特征值为1,…,n,则有

| r |2

r 1

n

r ,s 1

| a

n

rs

|2 || A ||2 F

(5.1.9)

证明:根据定理 1.43,存在酉矩阵 U 使得 A=UTUH 其中 T 为上三角矩阵。因此 T 的对角元素为 A 的特征值,且有

b

i 1 j i

n 1

ij

( xi y j x j yi ) |2

2

n (2M) | xi y j x j yi | i 1 j i

2

(利用(a1+a2+…+an)2 n((a1)2+(a2)2+…+(an)2)

n 2 (2M) (n(n1)/2) | xi y j x j yi | i 1 j i

xT x yT x

(求等式两边矩阵的对角元之和,可得 (xTx+yTy)=xTAx+yTAy (1) 等式两边矩阵的左上角单元减去右下角单元 可得: (xTx+yTy)=xT(AAT)y 1). 记 B=AAT,则 |xTBy|||x||2 ||B||2||y||2 从而 ||||x||2 ||B||2||y||2 /((||x||2)2 +(||y||2)2) 利用 ab/(a2+b2)1/2 可得 ||||B||2 /2. 2). 由于|xTBy|||Bx||1 ||y||||B||1||x||1 ||y|| 从而 ||||B||1 ||x||1 ||y|| /((||x||2)2 +(||y||2)2) 易证明 ||x||1 ||y|| /((||x||2)2 +(||y||2)2) n /2. (显然,不妨假设(||x||2)2 +(||y||2)2=1, 设||y||=t=cos(), 则 y 必为 t ej 的形式(为什么?) , 从而极值转化为求解如下最大值问题: max ||x||1, 满足约束(||x||2)2=1t2 这样有均值不等式||x||1 n ||x||2=

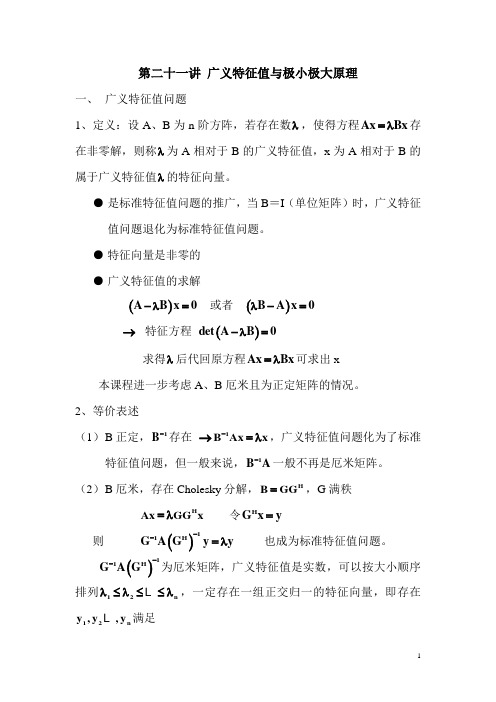

21 广义特征值与极大极小原理

第二十一讲 广义特征值与极小极大原理一、 广义特征值问题1、定义:设A 、B 为n 阶方阵,若存在数λ,使得方程Ax Bx =λ存在非零解,则称λ为A 相对于B 的广义特征值,x 为A 相对于B 的属于广义特征值λ的特征向量。

● 是标准特征值问题的推广,当B =I (单位矩阵)时,广义特征值问题退化为标准特征值问题。

● 特征向量是非零的 ● 广义特征值的求解()A B x 0-λ= 或者 ()B A x 0λ-=→ 特征方程 ()det A B 0-λ=求得λ后代回原方程Ax Bx =λ可求出x本课程进一步考虑A 、B 厄米且为正定矩阵的情况。

2、等价表述(1) B 正定,1B -存在 →1B Ax x -=λ,广义特征值问题化为了标准特征值问题,但一般来说,1B A -一般不再是厄米矩阵。

(2) B 厄米,存在Cholesky 分解,H B GG =,G 满秩 H Ax GG x =λ 令H G x y = 则 ()11H G A Gy y --=λ 也成为标准特征值问题。

()11H G A G--为厄米矩阵,广义特征值是实数,可以按大小顺序排列12n λ≤λ≤≤λ ,一定存在一组正交归一的特征向量,即存在12n y ,y ,y 满足()11H i i G A Gy y --=λH i j ij1i jy y 0i j=⎧=δ=⎨≠⎩ 还原为()1Hi i x G y -= (i=1,2, ,n),则()()H H HH ij ij ij ij 1i jy y x G G x x Bx 0i j=⎧===δ=⎨≠⎩ (带权正交)二、 瑞利商A 、B 为n 阶厄米矩阵,且B 正定,称()()H H x AxR x x 0x Bx =≠为A相对于B 的瑞利商。

12n x ,x ,x 线性无关,所以,n x C ∀∈,存在12n a ,a ,a C ∈ ,使得 ni i i 1x a x ==∑Hnn n n2HHi i i j j j i j i i 1j 1i,j 1i 1x Bx a x B a x a a x Bx a ====⎛⎫⎛⎫=== ⎪ ⎪⎝⎭⎝⎭∑∑∑∑n n n2HHH i i j ij j ii j i i i,j 1i,j 1i 1x Ax a a x Ax a a x Bx a =====λ=λ∑∑∑∴ ()n2i ii 1n2ii 1a R x a ==λ=∑∑●()1x 0minR x ≠=λ ()n x 0maxR x ≠=λ证明:()()()()()HHHH kx A kx x Ax R x x Bx kx B kx == k 为非零常数 可取1k x=, kx 1=∴ ()H Hx 1x AxR x x Bx== (闭区域)当1x x =或()i a 0i 2,3,,n == 时,()1R x =λ i 1λ≥λ ()n2i i 111n2ii 1a R x a==≥λ=λ∑∑∴()1x 0minR x ≠=λ另一方面,i n λ≤λ ()n2i i 1n n n2ii 1a R x a==≤λ=λ∑∑∴ ()n x 0maxR x ≠=λ[证毕] 当B =I 时,标准特征值问题 A x x =λ (H A A =)12nHi j ijx x λ≤λ≤≤λ⎧⎨=δ⎩ 则 ()H 1H x 0x Ax min x x ≠=λ ()H n H x 0x Axmax x x≠=λ进一步分析可得()12x 0a 0minR x ≠==λ ()n n 1x 0a 0max R x -≠==λ()12k k 1x 0a a a 0minR x +≠=====λ ()n n 1n k n k 1x 0a a a 0max R x ----≠=====λ定理1.设{}r r 1s L span x ,x ,,x += ()r r 1s +λ≤λ≤≤λ ,则 ()r x 0x LminR x ≠∈=λ ()s x 0x Lmax R x ≠∈=λ这一结果不便于应用,希望对上述结果进行改造,改造成不依赖于i x 的一种表达方式。

第十八讲 广义特征值问题及对称矩阵特征值的极性

于 是 (1) 式 可 写 为 Ax GGT x , 令

y GT x,则有 x (GT )1 y (G1 )T y ,代入 上式得

A(G1 )T y Gy ,即 G1 A(G1 )T y y 。

1 r s n ,则有

min x0

R(

x)

r

,

max x0

R(

x)

s

。

二、 对称矩阵特征值的极性

定理 3、( Couanrt hrFsei

)设实对称

矩阵 A 的特征值按 1 2 n 的次序排 列,则 A 的第 k 个特征值

k

min max{xT Ax Vk

xபைடு நூலகம்Vk ,

x

2

1},

其 中 Vk 是 Rn 的 任 意 一 个 k 维 子 空 间 ,

1 k n。

二、 对称矩阵特征值的极性

2、广义特征值的极小极大原理

定义 4、设 A 、B 为 n 阶实对称矩阵,且

B 正定, x Rn 。称

R(x)

xT xT

Ax Bx

,

x

0

为矩阵 A 相对于矩阵 B 的广义 Rayleigh 商。

二、 对称矩阵特征值的极性

定理 4、非零向量 x0 是 R( x)的驻点的充

推 论 2 、 设 Vnk 1 是 Rn 的 任 意 一 个 n k 1维子空间,则定理 5 或推论 1 的结论

可写成如下形式:

k

max[ min R(x)] , Vnk1 0 xVnk1

nk 1

min[ max

Vnk1 0 xVnk1

极大极小原理:为什么让很多人都顿悟了

极大极小原理:为什么让很多人都顿悟了作者:老喻在加来源:孤独大脑(ID:lonelybrain)1在“假设发生如下事情”之前,祝福我们此生永不发生这类事情。

假设你外出时,遭遇绑架,该怎么办?有一位(国外的)自卫专家,给出了三个应对原则:1、不要跟他去第二个地点。

如果你心怀侥幸,他可能将你带到偏僻的地方,为所欲为,甚至下毒手,然后掩藏他的罪恶痕迹。

2、记住,他在撒谎。

不管坏人说多好听,别相信。

这位专家的观点是:从一开始,每个谋杀犯,绑架犯,强奸犯,他们都会用同一句话:“照我说的做,我就不会伤害你。

”然而,一旦你照他们说的做,最后受伤最深的,还是你。

3、要在原地,用尽一切手段与之搏斗。

这一点似乎有点儿让人疑惑,万一受伤呢?被人用刀抵住,拼命挣扎要是不幸丢了命,岂非不识时务?然而,这位专家的洞见是:如果他们想在原地杀你,你早就已经死了。

所以:1.他们不想在原地杀你,他们希望带你去其他地方,或者先干点别的事。

2.通过打乱他们的计划,你会成为他们最恐怖的噩梦。

3.如果他们不想被抓,不想把事搞得太麻烦,他们可能就会直接逃跑了。

以上三点原则的所有原因,其实只有一个:如果你进了他的车,或者跟着他们去了某个地方,你死定了。

(以上经验仅供参考,不构成本文作者对遇到绑架的具体建议。

)2以上是一个生动的博弈场景。

由此引出我的一句“大脑碎片”:好的一手棋,是其令对手有不好的下一手,以及自己有好的下下一手棋。

我们姑且不讨论,在第1节里,专家应对绑架的三点原则的适用范围,以及如何根据情境调整策略。

本文的焦点是:极大极小原理。

绑架,是一场零和博弈。

就像下棋,一个人赢,一个人输,即使和棋,也只是暂时的平静。

双方没有合作的可能。

对于这类博弈,冯·诺依曼提出了“极小极大原理”。

《囚徒的困境》一书,用我们熟悉的分蛋糕来示例。

众所周知,公平的分法是:一个人切,一个人选。

假如两个孩子都不是孔融,并且都想吃更多蛋糕,这其实是一个典型的零和博弈。

姚极小极大原理

姚极小极大原理

姚极小极大原理(Minimax Principle)是决策论中的一个重要概念,也常应用于博弈论等领域。

该原理基于两个核心观点:

1. 极小:在一个给定的决策问题中,假设每个决策者都会尽力使自己所能获得的最小利益最大化。

也就是说,每个决策者都会考虑对手可能的最优策略,并选择自己能够达到的最优结果。

2. 极大:相对地,每个决策者也会试图将对手所能获得的最大利益最小化。

每个决策者都会推断对手的可能策略,并努力避免对手获得最佳结果。

通过这种极小极大思想,决策者可以在不确定情况下进行决策,尽量减少风险和损失,同时争取最有利的结果。

在博弈论中,姚极小极大原理经常被应用于两个对手之间的零和游戏,例如象棋、围棋等。

每个选手都会根据对手的最佳策略来选择自己的行动,以期望在对手的最优情况下获得最大利益。

总之,姚极小极大原理是一种基于对手最优策略的决策思想,旨在通过预测对手行为来优化自身的决策,并最大程度地减少潜在损失。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

x ≠0 x∈Vn −1

min R ( x ) ≤ λ 2

max R ( x ) ≥ λ n−1

x ≠0 x∈Vn −1

即,对于不同的 Vn−1 , R ( x ) 的最小值及最大值有可能不同,其中各个

−1

特征值问题,但一般来说, B A 一般不再是厄米矩阵。 (2) B 厄米,存在 Cholesky 分解, B = GG ,G 满秩

H

−1

Ax = λGG H x

则

令G x = y

H

G −1 A G H

( )

−1

y = λy

也成为标准特征值问题。

3

G −1 A G H

( )

−1

为厄米矩阵,广义特征值是实数,可以按大小顺序排

x H Ax = (x) = 证明: R x H BxHmax R (源自x ) = λ nx ≠0

( kx ) A ( kx ) H ( kx ) B ( kx )

k 为非零常数

可取 k =

∴

1 , kx = 1 x

x H Ax R (x) = H x Bx

(闭区域)

x =1

ai 0= ( i 2, 3, , n ) 时, R ( x ) = λ1 当 x = x1 或=

x ≠0

a1 =0

= λ2 = λ k +1

max R ( x )

x ≠0

an =0

= λ n−1 = λ n−k −1

a1 = a2 = = ak = 0

min R ( x )

x ≠0

max R ( x )

x ≠0

an = a n −1 = = an − k = 0

9

定理 1.设 L = span {x r , x r +1 , , x s }

( A − λB ) x = 0

或者

0 ( λB − A ) x =

2

→ 特征方程

det ( A − λB ) = 0

求得 λ 后代回原方程 Ax = λBx 可求出 x 本课程进一步考虑 A、B 厄米且为正定矩阵的情况。 2、等价表述

−1 (1) B 正定, B 存在 → B Ax = λx ,广义特征值问题化为了标准

λn

x1 , x 2 , x n 线性无关,所以, ∀x ∈ Cn ,存在 a1 , a 2 , an ∈ C ,

5

使得

H

x = ∑ ai x i

i =1

n

n n n n H x Bx ∑ ai x i = B ∑ a jx j ∑ ai a jx i Bx j ∑ ai = = = = i 1 i1 = j 1= i,j 1

7

λ i ≥ λ1

∴

R ( x ) ≥ λ1

∑a ∑a

i =1 i =1 n

n

2 i 2 i

= λ1

min R ( x ) = λ 1

x ≠0

另一方面, λ i ≤ λ n

R (x ) ≤ λn

∑a ∑a

i =1 i =1 n

n

2 i 2 i

= λn

∴

max R ( x ) = λ n

x ≠0

[证毕]

( λ r ≤ λ r +1 ≤ ≤ λ s )

,则

min R ( x ) = λ r

x ≠0 x∈L

max R ( x ) = λ s

x ≠0 x∈L

这一结果不便于应用,希望对上述结果进行改造,改造成不依赖 于 x i 的一种表达方式。

a1 = 0 和 an = 0 的情况均对应于 x 在(n-1)维的子空间内变动,x

8

当 B=I 时,标准特征值问题

λ1 ≤ λ 2 ≤ ≤ λ n xH i x j = δ ij

Ax = λx

(A = A)

H

则

x H Ax min H = λ 1 ( x ≠0 ) x x

x H Ax max H = λ n ( x ≠0 ) x x

进一步分析可得

min R ( x )

min max R ( x ) = λ n−1 Vn −1∈Cn x ≠0 x∈Vn−1 min max R x ( ) = λ k x ≠0 Vk ∈Cn x∈Vk

定理 2. 设 Vk 是 Cn 的一个 k 维子空间,则

10

最小值中最大者为 λ 2 ,各个最大值中的最小者为 λ n−1

max min R ( x ) = λ 2 Vn −1∈Cn x ≠0 x∈Vn−1

max min R x ( ) = λ n − k +1 Vk ∈Cn x ≠0 x∈Vk

H

2

n n H H i j i i j i j i j = i,j 1 = i,j 1 = i 1 H

x Ax = ∑ a a x Ax = ∑ a a x λ Bx = ∑ λ i ai

n

2

∴ R (x) =

∑λ

i =1 n i =1

n

i

ai

2 i

2

∑a

以下两点成立

6

R ( x ) = λ1 ● min x ≠0

列 λ 1 ≤ λ 2 ≤ ≤ λ n ,一定存在一组正交归一的特征向量,即存在

y 1 , y 2 , y n 满足

G −1 A G H

( )

−1

y i = λy i

i=j i≠j

1 yH y = δ = i j ij 0

H 还原为 x i = G

( )

−1

y i (i=1,2, ,n),则

第二十一讲 广义特征值与极小极大原理

1

一、 广义特征值问题 1、定义:设 A、B 为 n 阶方阵,若存在数 λ ,使得方程 Ax = λBx 存在 非零解,则称 λ 为 A 相对于 B 的广义特征值,x 为 A 相对于 B 的属于 广义特征值 λ 的特征向量。 ● 是标准特征值问题的推广,当 B=I(单位矩阵)时,广义特征值 问题退化为标准特征值问题。 ● 特征向量是非零的 ● 广义特征值的求解

4

1 H H H yH y x G G x x Bx = = = δ = i j i j i j ij 0

(

)(

)

i=j i≠j

(带权正交)

二、 瑞利商

x H Ax = R (x) ( x ≠ 0) 为 A A、B 为 n 阶厄米矩阵,且 B 正定,称 x H Bx

相对于 B 的瑞利商。

x i 为 A 相对于 B 的广义特征值和特征向量, 且 λ1≤λ2≤· · · ≤ 设 λi,