中文文本分类语料

用albert-tiny-chinese 做文本分类-概述说明以及解释

用albert-tiny-chinese 做文本分类-概述说明以及解释1.引言1.1 概述概述在当今信息爆炸的时代,准确、高效地对文本进行分类变得越来越重要。

文本分类可以帮助我们理解和组织海量的文本数据,为我们提供精准的信息,从而支持决策和应用开发。

而在进行文本分类任务时,合适的预训练模型的选择则变得尤为关键。

本文将介绍一种基于自然语言处理技术的预训练模型——Albert-tiny-chinese,并探讨其在文本分类中的应用。

Albert-tiny-chinese是一种中文预训练模型,它采用了ALBERT(A Lite BERT)架构,并在中文语料上进行了预训练。

相比于传统的BERT模型,Albert-tiny-chinese在参数量和模型大小方面进行了精简,具有更高的效率和灵活性。

文章将从Albert-tiny-chinese的简介开始,介绍其背后的原理和关键技术。

随后,将探讨文本分类的应用场景,包括情感分析、垃圾邮件过滤、新闻分类等。

通过具体的案例和实验结果,展示Albert-tiny-chinese在这些场景中的应用效果和优势。

然后,文章将对于Albert-tiny-chinese在文本分类中的效果进行深入分析,并与其他常见的预训练模型进行对比。

通过评估指标的统计和对比实验的结果,我们可以更好地理解Albert-tiny-chinese在文本分类任务中的性能和优势所在。

最后,文章将总结Albert-tiny-chinese的优势和不足之处,并对未来的发展方向进行展望。

通过全面的分析和探讨,我们可以更好地了解Albert-tiny-chinese在文本分类中的实际应用价值,为相关领域的研究和实践提供指导和参考。

1.2 文章结构本篇文章主要介绍如何利用Albert-tiny-chinese模型进行文本分类任务。

文章分为以下几个部分:引言:本部分将简要概述本文的主要内容和目的,以及对Albert-tiny-chinese模型在文本分类任务中的应用和效果进行介绍。

中文基准语料库-概述说明以及解释

中文基准语料库-概述说明以及解释1.引言1.1 概述中文基准语料库是指一种包含大量中文文本的语料库,它被广泛用作语言研究、自然语言处理、机器翻译等领域的标准参考。

中文基准语料库的建立旨在提供一个覆盖广泛的文本资源,使研究人员能够进行准确和全面的中文语言分析。

中文基准语料库的构建是一个复杂而耗时的过程。

通常,它涉及对大量现代和古代中文文本的收集、整理和标注。

这些文本可以包括各种文学作品、新闻报道、社交媒体内容等。

通过对这些文本进行语言学和语义分析,研究人员可以得到有关中文语言规律和特点的重要信息。

中文基准语料库具有重要的研究价值和实际意义。

首先,它为中文语言研究提供了全面的材料基础,可以帮助研究人员深入了解中文的语法、词汇和语义结构。

其次,它为自然语言处理和人工智能领域的技术开发提供了必要的训练和评估数据。

通过大规模的中文基准语料库,研究人员可以构建和改进各种中文文本处理模型和算法。

中文基准语料库在许多应用领域都发挥着重要的作用。

例如,在机器翻译领域,中文基准语料库可以用来训练和改进机器翻译系统,提高系统的翻译质量和准确性。

在文本分类和信息检索领域,中文基准语料库可以用来构建文本分类模型和搜索引擎,帮助用户更快捷地找到需要的信息。

此外,中文基准语料库还可以在教育、语言学习和文化研究等方面发挥重要的作用。

总之,中文基准语料库是中文语言研究和自然语言处理领域不可或缺的资源,它为各种语言分析和技术应用提供了基础和支持。

随着技术的不断发展和语料库的不断壮大,中文基准语料库将持续发挥重要的作用,并为未来的研究和应用提供更多可能性。

1.2 文章结构:本文主要分为引言、正文和结论三个部分。

在引言中,首先对中文基准语料库进行概述,介绍其定义、重要性以及应用领域。

然后说明文章结构,即引言、正文和结论的内容安排,并提出文章的目的。

接下来是正文部分,主要包括三个子部分。

首先介绍中文基准语料库的定义,包括其所指的内容范围和构建标准。

利用TfidfVectorizer进行中文文本分类(数据集是复旦中文语料)

利⽤TfidfVectorizer进⾏中⽂⽂本分类(数据集是复旦中⽂语料)1、对语料进⾏分析基本⽬录如下:其中train存放的是训练集,answer存放的是测试集,具体看下train中的⽂件:下⾯有20个⽂件夹,对应着20个类,我们继续看下其中的⽂件,以C3-Art为例:每⼀篇都对应着⼀个txt⽂件,编码格式是gb18030.utf8⽂件夹下的是utf-8编码格式的txt⽂件。

其中C3-Art0001.txt的部分内容如下:2、数据预处理(1)将⽂本路径存储到相应的txt⽂件中我们要使⽤数据,必须得获得⽂本以及其对应的标签,为了⽅便我们进⾏处理,⾸先将训练集中的txt的路径和测试集中的txt的路径分别存到相应的txt⽂件中,具体代码如下:def txt_path_to_txt():#将训练数据的txt和测试数据的txt保存在txt中train_path = "/content/drive/My Drive/NLP/dataset/Fudan/train/"#训练数据存放位置test_path = "/content/drive/My Drive/NLP/dataset/Fudan/answer/"#测试数据存放位置train_txt_path = "/content/drive/My Drive/NLP/dataset/Fudan/train.txt"test_txt_path = "/content/drive/My Drive/NLP/dataset/Fudan/test.txt"train_list = os.listdir(train_path)fp1 = open(train_txt_path,"a",encoding="utf-8")fp2 = open(test_txt_path,"a",encoding="utf-8")for train_dir in train_list:for txt in glob.glob(train_path+train_dir+"/*.txt"):fp1.write(txt+"\n")fp1.close()test_list = os.listdir(test_path)for test_dir in test_list:for txt in glob.glob(test_path+test_dir+"/*.txt"):fp2.write(txt+"\n")fp2.close()os.listdir():⽤于获取⽬录下的所有⽂件夹,返回⼀个列表。

国内语料库研究综述

国内语料库研究综述摘要本文旨在回顾国内语料库研究的发展历程、现状,并探讨未来研究方向。

通过分析相关文献资料,文章总结了国内语料库研究的主要成果、不足之处,并提出了针对性的建议。

本文旨在为语料库研究领域的学者提供参考,以推动国内语料库研究的发展。

关键词:语料库、国内研究、发展历程、现状、未来研究方向引言语料库是指为语言研究而收集的、有一定规模的、有代表性的语言材料集合。

自20世纪中期以来,语料库在国外得到了广泛应用,并在多个领域取得了显著的成果。

近年来,随着国内语言学、计算语言学等学科的快速发展,语料库在国内的研究和应用也逐渐受到重视。

本文将重点探讨国内语料库研究的现状、成果及未来研究方向。

研究现状1.国内语料库的发展历程和现状自20世纪80年代起,国内开始出现一些小型语料库的建设和研究,如国家语委现代汉语通用词库等。

随着计算机技术的不断发展,90年代中后期以来,国内开始大力推进语料库的建设和研究,涉及的领域也日益广泛。

目前,国内已经建立了一系列不同规模、不同类型的语料库,如中国传媒大学的中国广播电视媒体语言语料库、上海交通大学的中文文本分类语料库等。

2.基于不同领域语料库的研究成果和不足语料库在多个领域得到了广泛应用,如语言教学、词典编纂、语言政策研究等。

在语言教学领域,语料库可以提供真实的语言材料和语境,有助于提高语言学习者的兴趣和理解能力。

在词典编纂领域,语料库可以提供大量的实例和用法,有助于提高词典的准确性和实用性。

在语言政策研究领域,语料库可以提供真实的语言使用情况和发展趋势,有助于制定科学的语言政策和发展规划。

然而,国内基于不同领域语料库的研究成果尚不够丰富,且在某些领域还存在着研究空白。

例如,针对特定领域的语料库建设和研究尚不够深入,部分领域的语料库仍存在着规模较小、代表性不足等问题。

此外,针对语料库在二语习得、语言演化等领域的研究尚不够充分。

3.国内语料库在语言教学中的应用语料库在语言教学中的应用已经得到了广泛的认可。

基于Albert_与TextCNN_的中文文本分类研究

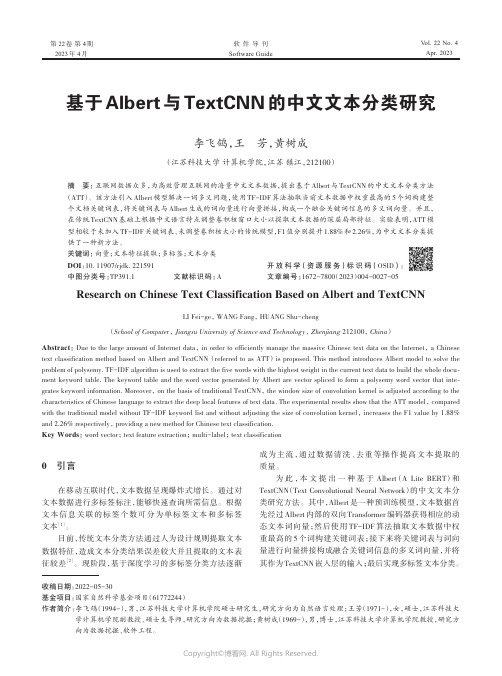

第 22卷第 4期2023年 4月Vol.22 No.4Apr.2023软件导刊Software Guide基于Albert与TextCNN的中文文本分类研究李飞鸽,王芳,黄树成(江苏科技大学计算机学院,江苏镇江,212100)摘要:互联网数据众多,为高效管理互联网的海量中文文本数据,提出基于Albert与TextCNN的中文文本分类方法(ATT)。

该方法引入Albert模型解决一词多义问题,使用TF-IDF算法抽取当前文本数据中权重最高的5个词构建整个文档关键词表,将关键词表与Albert生成的词向量进行向量拼接,构成一个融合关键词信息的多义词向量。

并且,在传统TextCNN基础上根据中文语言特点调整卷积核窗口大小以提取文本数据的深层局部特征。

实验表明,ATT模型相较于未加入TF-IDF关键词表、未调整卷积核大小的传统模型,F1值分别提升1.88%和2.26%,为中文文本分类提供了一种新方法。

关键词:向量;文本特征提取;多标签;文本分类DOI:10.11907/rjdk.221591开放科学(资源服务)标识码(OSID):中图分类号:TP391.1 文献标识码:A文章编号:1672-7800(2023)004-0027-05Research on Chinese Text Classification Based on Albert and TextCNNLI Fei-ge, WANG Fang, HUANG Shu-cheng(School of Computer, Jiangsu University of Science and Technology, Zhenjiang 212100, China)Abstract:Due to the large amount of Internet data, in order to efficiently manage the massive Chinese text data on the Internet, a Chinese text classification method based on Albert and TextCNN (referred to as ATT) is proposed. This method introduces Albert model to solve the problem of polysemy. TF-IDF algorithm is used to extract the five words with the highest weight in the current text data to build the whole docu‐ment keyword table. The keyword table and the word vector generated by Albert are vector spliced to form a polysemy word vector that inte‐grates keyword information. Moreover, on the basis of traditional TextCNN, the window size of convolution kernel is adjusted according to the characteristics of Chinese language to extract the deep local features of text data. The experimental results show that the ATT model, compared with the traditional model without TF-IDF keyword list and without adjusting the size of convolution kernel, increases the F1 value by 1.88% and 2.26% respectively, providing a new method for Chinese text classification.Key Words:word vector; text feature extraction; multi-label; text classification0 引言在移动互联时代,文本数据呈现爆炸式增长。

中文短文本分类

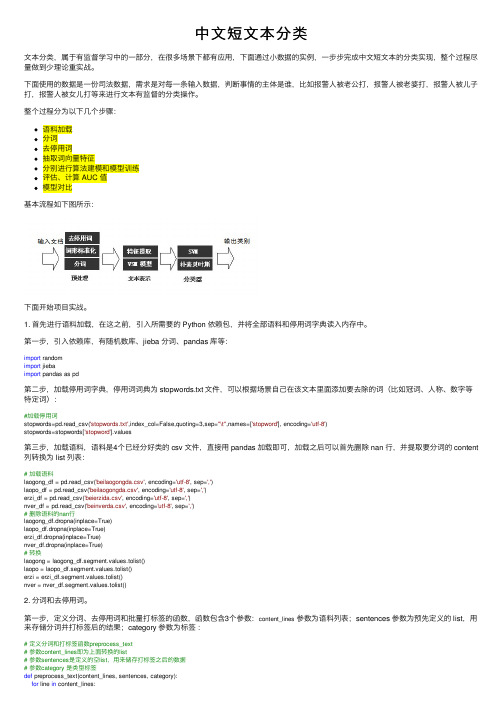

中⽂短⽂本分类⽂本分类,属于有监督学习中的⼀部分,在很多场景下都有应⽤,下⾯通过⼩数据的实例,⼀步步完成中⽂短⽂本的分类实现,整个过程尽量做到少理论重实战。

下⾯使⽤的数据是⼀份司法数据,需求是对每⼀条输⼊数据,判断事情的主体是谁,⽐如报警⼈被⽼公打,报警⼈被⽼婆打,报警⼈被⼉⼦打,报警⼈被⼥⼉打等来进⾏⽂本有监督的分类操作。

整个过程分为以下⼏个步骤:语料加载分词去停⽤词抽取词向量特征分别进⾏算法建模和模型训练评估、计算 AUC 值模型对⽐基本流程如下图所⽰:下⾯开始项⽬实战。

1. ⾸先进⾏语料加载,在这之前,引⼊所需要的 Python 依赖包,并将全部语料和停⽤词字典读⼊内存中。

第⼀步,引⼊依赖库,有随机数库、jieba 分词、pandas 库等:import randomimport jiebaimport pandas as pd第⼆步,加载停⽤词字典,停⽤词词典为 stopwords.txt ⽂件,可以根据场景⾃⼰在该⽂本⾥⾯添加要去除的词(⽐如冠词、⼈称、数字等特定词):#加载停⽤词stopwords=pd.read_csv('stopwords.txt',index_col=False,quoting=3,sep="\t",names=['stopword'], encoding='utf-8')stopwords=stopwords['stopword'].values第三步,加载语料,语料是4个已经分好类的 csv ⽂件,直接⽤ pandas 加载即可,加载之后可以⾸先删除 nan ⾏,并提取要分词的 content 列转换为 list 列表:# 加载语料laogong_df = pd.read_csv('beilaogongda.csv', encoding='utf-8', sep=',')laopo_df = pd.read_csv('beilaogongda.csv', encoding='utf-8', sep=',')erzi_df = pd.read_csv('beierzida.csv', encoding='utf-8', sep=',')nver_df = pd.read_csv('beinverda.csv', encoding='utf-8', sep=',')# 删除语料的nan⾏laogong_df.dropna(inplace=True)laopo_df.dropna(inplace=True)erzi_df.dropna(inplace=True)nver_df.dropna(inplace=True)# 转换laogong = laogong_df.segment.values.tolist()laopo = laopo_df.segment.values.tolist()erzi = erzi_df.segment.values.tolist()nver = nver_df.segment.values.tolist()2. 分词和去停⽤词。

使用glove训练中文语料

使用glove训练中文语料要使用GloVe训练中文语料,首先需要准备好中文语料库和相应的预处理工具。

以下是一般步骤:1. 数据预处理,对中文语料进行清洗和分词。

清洗,去除无效字符、标点符号、HTML标签等。

分词,使用中文分词工具(如jieba)将文本分割成词语。

2. 构建词汇表,根据预处理后的语料,构建词汇表。

统计词频,遍历语料库,统计每个词语的出现频率。

设置词频阈值,根据需求,可以设置一个词频阈值,过滤掉低频词。

建立词汇表,根据词频排序,选择出现频率最高的N个词语作为词汇表。

3. 构建共现矩阵,根据词汇表和预处理后的语料,构建共现矩阵。

定义窗口大小,选择一个合适的窗口大小,表示在该窗口内的词语被认为是共现的。

遍历语料库,遍历预处理后的语料库,统计词语在窗口内的共现次数。

构建共现矩阵,将共现次数填入共现矩阵的对应位置。

4. 训练GloVe模型,使用预处理后的共现矩阵训练GloVe模型。

设置超参数,如词向量维度、学习率、迭代次数等。

初始化词向量,为每个词语随机初始化词向量。

计算损失函数,根据共现矩阵和词向量,计算GloVe模型的损失函数。

更新词向量,使用梯度下降法更新词向量,最小化损失函数。

迭代训练,重复以上步骤,直到达到设定的迭代次数。

5. 应用训练好的词向量,使用训练好的词向量进行下游任务。

词语相似度计算,通过计算词向量之间的余弦相似度,可以衡量词语之间的语义相似度。

文本分类,将词向量作为输入,用于文本分类任务。

词语聚类,使用词向量进行聚类分析,将语义相似的词语分到同一类别。

需要注意的是,中文语料的处理相对英文语料更为复杂,需要使用中文分词工具进行分词处理。

此外,还可以考虑使用更大规模的语料库和调整超参数来提高训练效果。

自然语言处理中文语料库-概述说明以及解释

自然语言处理中文语料库-概述说明以及解释1.引言1.1 概述自然语言处理(Natural Language Processing,简称NLP)是人工智能领域一项重要的研究领域,旨在使计算机能够理解和处理人类自然语言。

而中文作为全球最流行的语言之一,对于中文语料库的建设和应用具有重要意义。

中文语料库是指收集和整理的大量中文文本数据集合,可以是书籍、报纸、电子邮件、社交媒体上的文本等。

它们以结构化或非结构化的形式存在,总结和反映了中文语言的特点和使用习惯。

概括而言,中文语料库在自然语言处理中扮演着至关重要的角色。

首先,中文语料库作为研究和开发的基础,为构建和训练中文语言模型提供了必要的数据和素材。

其次,中文语料库可以用于中文文本的词法分析、句法分析、语义分析以及情感分析等一系列任务,以获取更准确、更全面的语义信息。

在过去的几十年里,中文语料库的建设方法也得到了长足的发展。

传统的构建方法包括人工标注、网络爬虫等方式,但由于人力成本和效率问题,近年来基于自动化技术的语料库构建方法逐渐兴起。

利用自然语言处理和机器学习技术,可以通过大规模文本数据的自动抽取和标注来搭建中文语料库。

纵观全球的自然语言处理研究和应用领域,可以发现中文语料库的前景广阔而且潜力巨大。

随着人工智能技术的不断发展和深入,中文语料库可以为机器翻译、智能问答、信息检索等领域提供更加准确和高效的支持。

在大数据时代,中文语料库的规模和质量不断提升,将对中文自然语言处理的研究和应用产生积极而深远的影响。

尽管中文语料库的发展已经取得了很大的成绩,但仍面临着一些挑战。

其中之一就是语料库的规模和多样性问题。

尽管中文是世界上使用最广泛的语言之一,但由于其复杂的构造和汉字的数量庞大,建设大规模且多样化的中文语料库仍具有一定的难度。

总之,中文语料库在自然语言处理的研究和应用中起着重要的作用。

它们为中文语言模型的建立提供了基础数据,为各种文本分析任务提供了实验平台,同时也为人工智能技术的发展开辟了更加广阔的空间。

文本分类语料库

文本分类语料库

名称:文本分类语料库

关键词:文本分类、互联网语料

摘要:文本分类语料库设计为基于搜狐分类目录手工编辑的网页分类结果组织成的网页、分类结果及基准分类算法在内的综合数据集合。

为各种从事中文文本分类工作的研究者提供一个标准的较大规模的研究平台。

介绍:文本分类语料库来源于Sohu新闻网站保存的大量经过编辑手工整理与分类的新闻语料与对应的分类信息。

其分类体系包括几十个分类节点,网页规模约为十万篇文档。

语料库统计的意义:提供一个较大规模的标准中文文本分类测试平台。

应用案例:中文文本分类,主题跟踪与检测等。

说明:语料库数据包括:

[1] 用于分类的新闻语料,按照SOGOU-T网页语料库格式整理

[2] 分类体系说明

[3] 数据集合统计信息

数据下载声明见“SogouLab 数据使用许可证”

Please read the "License for Use of Sogou Lab Data" carefully before downloading.

下载:mini版(tar.gz格式)136K

mini版(zip格式)167K

精简版(tar.gz格式)24M

精简版(zip格式)30M

完整版 107M(由于文件较大,需要注册后获取ftp地址下载)分类编码对照表(txt格式)138字节

反馈:在搜狗实验室吧与搜狗核心研发团队分享您的研究成果。

在线上反馈留下您的宝贵意见和建议。

在资源下载FAQ中查找您遇到的资源下载问题的答案。

搜狗文本分类语料库精简版

搜狗文本分类语料库精简版搜狗文本分类语料库精简版是什么?搜狗文本分类语料库是一种针对文本分类任务的大型数据集合,其中包含了数百万条经过人工标注的文本数据,用于支持文本分类算法的研发。

然而,由于其数据量非常庞大,对于训练文本分类模型的任务来说过于冗余且资源浪费,因此搜狗文本分类语料库精简版应运而生。

搜狗文本分类语料库精简版的特点1. 数据量优化:与原版搜狗文本分类语料库相比,精简版删减了大量重复数据和无用信息,将数据规模缩小至数千条左右,使得数据更加精简高效。

2. 数据质量保证:所有数据都经过了严格的筛选,确保语言准确无误,数据可靠性高,从而提高了训练分类模型的效果。

3. 多领域涵盖:搜狗文本分类语料库精简版涵盖了多个领域的语言文本,如新闻、博客、论坛等,能够满足各个领域对训练数据的需求。

4. 适用算法广泛:搜狗文本分类语料库精简版可用于支持各种文本分类算法的构建和测试,如传统的朴素贝叶斯算法、支持向量机、深度学习等等。

搜狗文本分类语料库精简版的应用场景1. 自然语言处理学习:对于自然语言处理领域的研究人员和学生,搜狗文本分类语料库精简版提供了高度优化的数据,可用于构建分类模型和模型测试,帮助提高算法研究功底。

2. 信息安全应用:对于信息安全领域,搜狗文本分类语料库精简版可用于训练分类模型,支持恶意软件检测、垃圾邮件过滤等安全应用场景。

3. 商业应用:搜狗文本分类语料库精简版可用于更加精准的文本预测和语言模型构建,提高商业应用的精度和效率,例如智能客服、语音助手等。

总而言之,搜狗文本分类语料库精简版提供了高度优化的数据集合,适用于各种领域数据处理的应用。

其优化的数据质量、多领域涵盖的特点,使其成为构建支持各种文本分类算法的优秀数据集。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

中文文本分类语料

文本自动分类就是用电脑对文本按照一定的分类体系或标准进行自动分类标记。

文本分类问题与其它分类问题没有本质上的区别,其方法可以归结为根据待分类数据的某些特征来进行匹配,当然完全的匹配是不太可能的,因此必须(根据某种评价标准)选择最优的匹配结果,从而完成分类。

现如今,统计学习方法已经成为了文本分类领域绝对的主流。

统计学习方法需要一批由人工进行了准确分类的文档作为学习的材料(称为训练集,注意由人分类一批文档比从这些文档中总结出准确的规则成本要低得多),计算机从这些文档中挖掘出一些能够有效分类的规则,这个过程被形象的称为训练,而总结出的规则集合常常被称为分类器。

训练完成之后,需要对计算机从来没有见过的文档进行分类时,便使用这些分类器来进行。

下面提供一些网上能下载到的中文的好语料,供研究人员学习使用。

1.中科院自动化所的中英文新闻语料库/data/13484

中文新闻分类语料库从凤凰、新浪、网易、腾讯等版面搜集。

英语新闻分类语料库为Reuters-21578的ModApte版本。

2.搜狗的中文新闻语料库/labs/dl/c.html

包括搜狐的大量新闻语料与对应的分类信息。

有不同大小的版本可以下载。

3.李荣陆老师的中文语料库 /data/11968

压缩后有240M大小

4.谭松波老师的中文文本分类语料/data/11970

不仅包含大的分类,例如经济、运动等等,每个大类下面还包含具体的小类,例如运动包含篮球、足球等等。

能够作为层次分类的语料库,非常实用。

5.网易分类文本数据/data/11965

包含运动、汽车等六大类的4000条文本数据。

6.中文文本分类语料/data/11963

包含Arts、Literature等类别的语料文本。

7.更全的搜狗文本分类语料 /labs/dl/c.html

搜狗实验室发布的文本分类语料,有不同大小的数据版本供免费下载

8.2002年中文网页分类训练集/data/15021

2002年秋天北京大学网络与分布式实验室天网小组通过动员不同专业的几十个学生,人工选取形成了一个全新的基于层次模型的大规模中文网页样本集。

它包括11678个训练网页实例和3630个测试网页实例,分布在11个大类别中。