日志文件

电脑删除文件的日志-概述说明以及解释

电脑删除文件的日志-概述说明以及解释1.引言1.1 概述概述:电脑删除文件的日志是指在电脑系统中记录文件删除操作的相关信息。

当用户删除文件时,系统会生成相应的日志记录,包括删除时间、删除者、删除文件名等信息。

这些日志记录对于文件管理和数据安全至关重要。

通过分析日志记录,可以了解文件删除的情况,以便及时恢复误删文件或追踪恶意删除行为。

在本文中,我们将探讨电脑删除文件的日志记录方式、日志对文件恢复的影响以及日志记录的重要性。

通过深入了解这些内容,可以更好地理解电脑文件管理的重要性,从而提高文件安全性和数据管理的效率。

1.2 文章结构本文主要分为三个部分,分别是引言、正文和结论。

引言部分将首先对电脑删除文件的日志进行概述,介绍电脑删除文件的日志记录方式,并阐明文章的目的。

正文部分将深入探讨电脑删除文件的日志记录方式,分析日志对文件恢复的影响,并探讨日志记录的重要性。

结论部分将总结电脑删除文件日志的作用,提出建议提高电脑文件安全性的方法,并展望未来电脑文件管理的发展趋势。

通过这三部分的分析和讨论,读者将对电脑删除文件的日志有更深入的理解,并对提高文件安全性有更多的思考。

1.3 目的本文的主要目的是介绍电脑删除文件的日志记录方式,并探讨日志对文件恢复的影响,以及强调日志记录对文件管理的重要性。

通过深入分析和讨论,我们希望读者能够认识到电脑删除文件的日志记录对于维护文件安全、保护隐私信息的重要性,以及如何提高电脑文件管理的安全性。

同时,展望未来电脑文件管理的发展趋势,为读者提供更好更安全的文件管理方案和方法。

通过本文的阐述,读者将能够更好地了解电脑删除文件的日志记录技术,从而更好地保护自己的文件和隐私信息。

2.正文2.1 电脑删除文件的日志记录方式电脑删除文件的日志记录方式通常分为两种方法:一种是通过操作系统自带的日志功能记录文件的删除操作,另一种是通过第三方软件或工具进行日志记录。

1. 操作系统自带的日志功能:大多数操作系统都会记录文件的删除操作,这些日志会包含文件的名称、路径、删除时间、操作者等信息。

solidworks 提示:无法生成日志文件

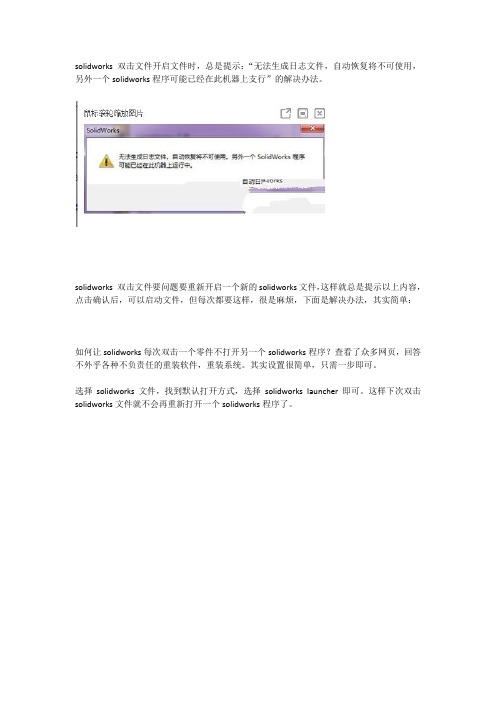

solidworks 双击文件开启文件时,总是提示:“无法生成日志文件,自动恢复将不可使用,另外一个solidworks程序可能已经在此机器上支行”的解决办法。

solidworks 双击文件要问题要重新开启一个新的solidworks文件,这样就总是提示以上内容,点击确认后,可以启动文件,但每次都要这样,很是麻烦,下面是解决办法,其实简单:

如何让solidworks每次双击一个零件不打开另一个solidworks程序?查看了众多网页,回答不外乎各种不负责任的重装软件,重装系统。

其实设置很简单,只需一步即可。

选择solidworks文件,找到默认打开方式,选择solidworks launcher即可。

这样下次双击solidworks文件就不会再重新打开一个solidworks程序了。

【vspher运维】ESXI日志文件

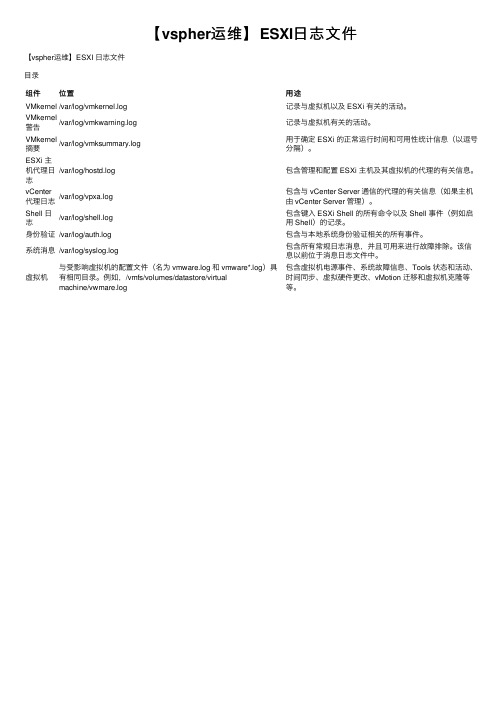

【vspher运维】ESXI⽇志⽂件【vspher运维】ESXI ⽇志⽂件⽬录组件位置⽤途VMkernel/var/log/vmkernel.log记录与虚拟机以及 ESXi 有关的活动。

VMkernel警告/var/log/vmkwarning.log记录与虚拟机有关的活动。

VMkernel 摘要/var/log/vmksummary.log⽤于确定 ESXi 的正常运⾏时间和可⽤性统计信息(以逗号分隔)。

ESXi 主机代理⽇志/var/log/hostd.log包含管理和配置 ESXi 主机及其虚拟机的代理的有关信息。

vCenter 代理⽇志/var/log/vpxa.log包含与 vCenter Server 通信的代理的有关信息(如果主机由 vCenter Server 管理)。

Shell ⽇志/var/log/shell.log包含键⼊ ESXi Shell 的所有命令以及 Shell 事件(例如启⽤ Shell)的记录。

⾝份验证/var/log/auth.log包含与本地系统⾝份验证相关的所有事件。

系统消息/var/log/syslog.log 包含所有常规⽇志消息,并且可⽤来进⾏故障排除。

该信息以前位于消息⽇志⽂件中。

虚拟机与受影响虚拟机的配置⽂件(名为 vmware.log 和 vmware*.log)具有相同⽬录。

例如,/vmfs/volumes/datastore/virtualmachine/vwmare.log包含虚拟机电源事件、系统故障信息、Tools 状态和活动、时间同步、虚拟硬件更改、vMotion 迁移和虚拟机克隆等等。

log4j输出多个日志文件

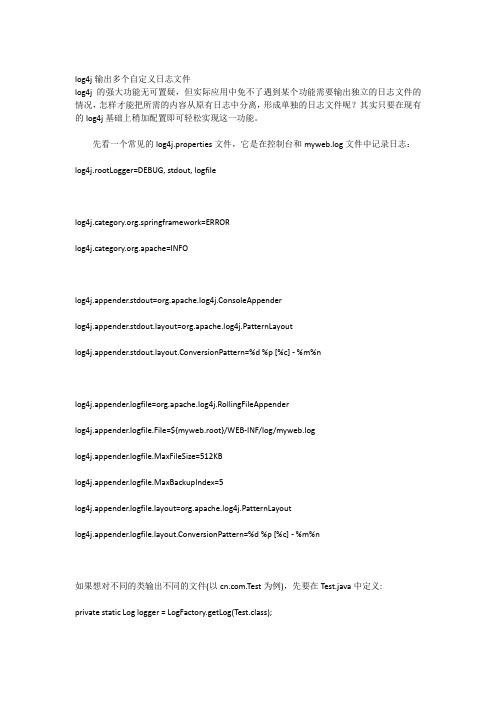

log4j输出多个自定义日志文件log4j的强大功能无可置疑,但实际应用中免不了遇到某个功能需要输出独立的日志文件的情况,怎样才能把所需的内容从原有日志中分离,形成单独的日志文件呢?其实只要在现有的log4j基础上稍加配置即可轻松实现这一功能。

先看一个常见的log4j.properties文件,它是在控制台和myweb.log文件中记录日志:log4j.rootLogger=DEBUG, stdout, logfile.springframework=ERROR.apache=INFOlog4j.appender.stdout=org.apache.log4j.ConsoleAppenderyout=org.apache.log4j.PatternLayoutyout.ConversionPattern=%d %p [%c] - %m%nlog4j.appender.logfile=org.apache.log4j.RollingFileAppenderlog4j.appender.logfile.File=${myweb.root}/WEB-INF/log/myweb.loglog4j.appender.logfile.MaxFileSize=512KBlog4j.appender.logfile.MaxBackupIndex=5yout=org.apache.log4j.PatternLayoutyout.ConversionPattern=%d %p [%c] - %m%n如果想对不同的类输出不同的文件(以.Test为例),先要在Test.java中定义:private static Log logger = LogFactory.getLog(Test.class);然后在log4j.properties中加入:.Test= DEBUG, testlog4j.appender.test=org.apache.log4j.FileAppenderlog4j.appender.test.File=${myweb.root}/WEB-INF/log/test.logyout=org.apache.log4j.PatternLayoutyout.ConversionPattern=%d %p [%c] - %m%n也就是让.Test中的logger使用log4j.appender.test所做的配置。

Kafka-Message、日志和索引文件、消费组、rebalance

Kafka-Message、⽇志和索引⽂件、消费组、rebalance记录下和kafka相关的Message、⽇志⽂件、索引⽂件、consumer记录消费的offset相关内容,⽂中很多理解参考⽂末博⽂、书籍还有前辈。

kafka中的消息kafka中的消息Message,在V1版本中是如下部分组成,主要关系key和value。

(1)key:当需要将消息写⼊到某个topic下的指定partition分区时,需要给定key的值。

(2)value:实际消息内容保存在这⾥。

(3)其他均是消息的元数据,⼀般不⽤关⼼,对⽤户来说是透明的。

为了保存这些消息数据,kafka使⽤了ByteBuffer来存储,它是紧凑型字节数组,相⽐使⽤java对象来保存消息数据到堆内存,它更加的节省空间,提⾼内存使⽤率。

log和index⽂件基本介绍查看⼀个topic分区⽬录下的内容,发现有log、index和timeindex三个⽂件,它有以下⼏个特点。

(1)log⽂件名是以⽂件中第⼀条message的offset来命名的,实际offset长度是64位,但是这⾥只使⽤了20位,应付⽣产是⾜够的。

可以看出第⼀个log⽂件名是以0开头,⽽第⼆个log⽂件是4161281,说明第⼀log⽂件保存了offset从0到4161280的消息。

(2)⼀组index+log+timeindex⽂件的名字是⼀样的,并且log⽂件默认写满1G后,会进⾏log rolling形成⼀个新的组合来记录消息,这个是通过broker端log.segment.bytes=1073741824指定的,可以修改这个值进⾏调整。

(3)index和timeindex在刚使⽤时会分配10M的⼤⼩,当进⾏log rolling后,它会修剪为实际的⼤⼩,所以看到前⼏个索引⽂件的⼤⼩,只有⼏百K。

# ⼀个分区⽬录下⽂件内容,参考⽂末书籍杜撰,主要为了说明概念[root@hadoop01 /home/software/kafka-2/kafka-logs/football-0]# ll -h-rw-r--r--. 1 root root 514K Mar 20 16:04 00000000000000000000.index-rw-r--r--. 1 root root 1.0G Mar 17 03:36 00000000000000000000.log-rw-r--r--. 1 root root 240K Mar 20 16:04 00000000000000000000.timeindex-rw-r--r--. 1 root root 512K Mar 20 16:04 00000000000004161281.index-rw-r--r--. 1 root root 1.0G Mar 17 03:36 00000000000004161281.log-rw-r--r--. 1 root root 177K Mar 20 16:04 00000000000004161281.timeindex-rw-r--r--. 1 root root 10M Mar 20 16:04 00000000000008749921.index-rw-r--r--. 1 root root 390M Mar 17 03:36 00000000000008749921.log-rw-r--r--. 1 root root 10M Mar 20 16:04 00000000000008749921.timeindex如果想查看这些⽂件,可以使⽤kafka提供的shell来完成,⼏个关键信息如下:(1)offset是逐渐增加的整数。

Linuxlog日志查看

Linux log 日志查看其实,可以说成是监控系统的记录,系统一举一动基本会记录下来。

这样由于信息非常全面很重要,通常只有 root 可以进行视察!通过登录文件(日志文件)可以根据屏幕上面的错误讯息与再配合登录文件的错误信息,几乎就可以解决大部分的 Linux 问题!所以日志文件异常重要,作为一个合格的linux 系统工程师,日志文件是必要熟练掌握的部分。

常见的几个登录文件有:/var/log/secure:记录登入系统存取数据的文件,例如 pop3, ssh, telnet, ftp 等都会被记录;/var/log/wtmp:记录登入者的讯息数据,由于本文件已经被编码过,所以必须使用last指令来取出文件的内容;/var/log/messages:尤为重要,几乎发生的错误讯息(或是重要信息)都会被记录在此;/var/log/boot.log:记录开机或者是一些服务启动的时候,所显示的启动或关闭讯息;/var/log/maillog 或 /var/log/mail/*:纪录邮件存取或往来( sendmail 与 pop3 )的使用者记录;/var/log/cron:记录 crontab 这个例行性服务的内容的。

/var/log/httpd, /var/log/news, /var/log/mysqld.log, /var/log/samba,/var/log/procmail.log:分别是几个不同的网络服务的记录文件!登录文件的纪录程序之一: syslogd通常经过 syslog 而记录下来的数据主要有:事件发生的日期与时间;发生此事件的主机名称;启动此事件的服务名称 (如 samba, xinetd 等) 或函式名称 (如 libpam ..);该讯息数据内容syslogd的daemon配置文件:/etc/syslog.conf内容语法是这样的:服务名称[.=!]讯息等级讯息记录的文件名或装置或主机# 例如底下: /var/log/maillog_info服务名称:该服务产生的讯息会被纪录的意思。

Linux查看登录日志

Linux查看登录⽇志⼀、查看⽇志⽂件Linux查看/var/log/wtmp⽂件查看可疑IP登陆last -f /var/log/wtmp该⽇志⽂件永久记录每个⽤户登录、注销及系统的启动、停机的事件。

因此随着系统正常运⾏时间的增加,该⽂件的⼤⼩也会越来越⼤,增加的速度取决于系统⽤户登录的次数。

该⽇志⽂件可以⽤来查看⽤户的登录记录,last命令就通过访问这个⽂件获得这些信息,并以反序从后向前显⽰⽤户的登录记录,last也能根据⽤户、终端tty或时间显⽰相应的记录。

查看/var/log/secure⽂件寻找可疑IP登陆次数⼆、脚本⽣成所有登录⽤户的操作历史在linux系统的环境下,不管是root⽤户还是其它的⽤户只有登陆系统后⽤进⼊操作我们都可以通过命令history来查看历史记录,可是假如⼀台服务器多⼈登陆,⼀天因为某⼈误操作了删除了重要的数据。

这时候通过查看历史记录(命令:history)是没有什么意义了(因为history 只针对登录⽤户下执⾏有效,即使root⽤户也⽆法得到其它⽤户histotry历史)。

那有没有什么办法实现通过记录登陆后的IP地址和某⽤户名所操作的历史记录呢?答案:有的。

通过在/etc/profile⾥⾯加⼊以下代码就可以实现:PS1="`whoami`@`hostname`:"'[$PWD]'USER_IP=`who -u am i 2>/dev/null| awk '{print $NF}'|sed -e 's/[()]//g'`if [ "$USER_IP" = "" ]thenUSER_IP=`hostname`fiif [ ! -d /tmp/dbasky ]thenmkdir /tmp/dbaskychmod 777 /tmp/dbaskyfiif [ ! -d /tmp/dbasky/${LOGNAME} ]thenmkdir /tmp/dbasky/${LOGNAME}chmod 300 /tmp/dbasky/${LOGNAME}fiexport HISTSIZE=4096DT=`date "+%Y-%m-%d_%H:%M:%S"`export HISTFILE="/tmp/dbasky/${LOGNAME}/${USER_IP}-dbasky.$DT"chmod 600 /tmp/dbasky/${LOGNAME}/*dbasky* 2>/dev/nullsource /etc/profile 使⽤脚本⽣效退出⽤户,重新登录⾯脚本在系统的/tmp新建个dbasky⽬录,记录所有登陆过系统的⽤户和IP地址(⽂件名),每当⽤户登录/退出会创建相应的⽂件,该⽂件保存这段⽤户登录时期内操作历史,可以⽤这个⽅法来监测系统的安全性。

Windows事件日志简要解析

Windows事件日志简要解析简介:Windows系统内置三个核心日志文件:System、Security、Application,默认大小均为20480kB也就是20MB,记录数据超过20MB时会覆盖过期的日志记录;其他的应用程序以及服务日志默认大小均为1MB,超过这个大小一样的处理方法。

日志类型:事件类型注释信息(Information)指应用程序、驱动程序、或服务的成功操作事件警告(Warning)警告事件不是直接的、主要的,但是会导致将来问题的发生错误(Error)指用户应该知晓的重要问题成功审核(Success Audit)主要指安全性日志,记录用户的登录/注销、对象访问、特权使用、账户管理、策略更改、详细跟踪、目录服务访问、账户登录事件失败审核(FailureAudit)失败的审核安全登录尝试事件日志文件类型:类别类型描述文件名Windows 日志系统包含系统进程,设备磁盘活动等。

事件记录了设备驱动无法正常启动或停止,硬件失败,重复IP地址,系统进程的启动,停止及暂停等行为。

System.evtxWindows 日志安全包含安全性相关的事件,如用户权限变更,登录及注销,文件及文件夹访问,打印等信息。

Security.evtxWindows 日志应用程序包含操作系统安装的应用程序软件相关的事件。

事件包括了错误、警告及任何应用程序需要报告的信息,应用程序开发人员可以决定记录哪些信息。

Application.evtx应用程序及服务日志Microsoft Microsoft文件夹下包含了200多个微软内置的事件日志分类,只有部分类型默认启用记录功能,如远程桌面客户端连接、无详见日志存储目录对应文件类别类型描述文件名线网络、有线网路、设备安装等相关日志。

应用程序及服务日志MicrosoftOfficeAlters微软Office应用程序(包括Word/Excel/PowerPoint等)的各种警告信息,其中包含用户对文档操作过程中出现的各种行为,记录有文件名、路径等信息。

Log4j使用笔记:每天生成一个日志文件、按日志大小生成文件

Log4j使⽤笔记:每天⽣成⼀个⽇志⽂件、按⽇志⼤⼩⽣成⽂件其中TestLog4j.java如下:package cn.zhoucy.test;import org.apache.log4j.Logger;public class TestLog4j {private static Logger logger=Logger.getLogger(TestLog4j.class); // 获取logger实例public static void main(String[] args) {logger.debug("调试debug信息");("普通Info信息");logger.warn("警告warn信息");logger.error("error信息");logger.fatal("严重错误fatal信息");}}123456789101112131415161718log4j.properties如下:log4j.rootLogger=DEBUG, Console ,File ,DailyRollingFile ,RollingFile#Consolelog4j.appender.Console=org.apache.log4j.ConsoleAppenderyout=org.apache.log4j.PatternLayoutyout.ConversionPattern=%d [%t] %-5p [%c] - %m%n#Filelog4j.appender.File = org.apache.log4j.FileAppenderlog4j.appender.File.File = E://File.logyout = org.apache.log4j.PatternLayoutyout.ConversionPattern =%d [%t] %-5p [%c] - %m%n#DailyRollingFilelog4j.appender.DailyRollingFile = org.apache.log4j.DailyRollingFileAppenderlog4j.appender.DailyRollingFile.File = E://DailyRollingFile.logyout = org.apache.log4j.PatternLayoutyout.ConversionPattern =%d [%t] %-5p [%c] - %m%n#RollingFilelog4j.appender.RollingFile = org.apache.log4j.RollingFileAppenderlog4j.appender.RollingFile.File = E://RollingFile.loglog4j.appender.RollingFile.MaxFileSize=1KBlog4j.appender.RollingFile.MaxBackupIndex=3yout = org.apache.log4j.PatternLayoutyout.ConversionPattern =%d [%t] %-5p [%c] - %m%n1234567891011121314151617181920212223242526由配置⽂件:Console 和File是常规的控制台和⽂件输出,⽽DailyRollingFile 和RollingFile分别是按天⽣成,和按⽇志⽂件指定⼤⼩⽣成⽂件。

redo 日志相关

Redo日志重做日志文件(REDO LOGFILE)又被称为事务日志文件(TRANSACTION LOGFILE)。

它对ORACLE 数据库来说是至关重要的。

ORACLE中每执行一条更新操作时,都会引起数据库的变化,因此都会生成一定数量的重做日志,他们将被记录到重做日志文件中。

以便在数据库出现例程失败或介质故障时,可以利用重做日志文件来恢复数据库。

一、重做日志文件概述重做日志文件是ORACLE三类文件中最为复杂的一类。

在ORACLE 10G安装完毕后,会自动创建3个重做日志文件。

重做日志文件主要以重做记录的形式记录、保存对数据库所作的修改(或事务)。

如果在一段时间内只对数据库进行了查询操作,则不产生重做日志记录信息。

如果对一个表的数据进行了修改,并完成了事务的提交,这时数据文件只存储修改后的数据,但重做日志文件中要记录两类数据:一类是修改前的数据;一类是修改后的数据。

所以重做日志文件的管理方式与数据文件的管理方式有所不同。

(一)重做日志文件的作用与目的重做日志文件在数据库的恢复过程中起着非常重要的作用,可以用来进行例程和介质恢复,以及事务的撤销。

1.数据库运行不正常,如由于断电而出现的例程失败,或者是由于磁盘损坏而出现的介质失败时,都能够实现例程恢复或介质恢复。

其中介质恢复需要借助于归档日志文件;2.数据库运行正常时,由于不正确的删除或修改了某条记录、某个表,甚至表空间时,能够实现事务的撤销。

在撤销时要借助于撤销表空间或撤销段。

(二)重做记录重做日志文件是由一条一条重做记录组成的,重做记录(REDO RECORD)是有一个个修改向量(CHANGE VECTOR)组成的。

每个修改向量记录了对数据库中的某个数据块所作的修改。

重做记录记录了可以用来对数据可进行恢复的所有修改的数据,包括回退段。

因此,重做日志文件同样也会保护回退数据。

当使用重做日志文件来进行数据库恢复时,ORACLE将读取其中的重做记录(包括其中的修改向量),并且将这些修改用于相关的块中。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

日志文件 什么是日志文件? Oracle 数据库中日志主要有: 1.redo log files 联机日志或重做日志 2.archive log files 归档日志

3.alert log files 告警日志 4.trace files user_dump_dest 用户信息日志如跟踪会话日志 Background_dump_dest 进程日志

重做日志

1. 用途: A:维护数据库的一致性 B :记录数据库更改的操作 至少要两个组,组内必须要有一个成员;从一个组到另一个组的过程,叫日志切换。当你进行日志切换到那个坏掉的组中,如果你写的组成员坏了, lgwr 就会出现问题,由于lgwr是后台进程中最重要的五个进程之一,只要down 掉一个数据库就会down 掉。

2.日志切换有两种方式:

手工切换:系统自动从一个组切换到另一个组 人工切换:人为的把日志从一个组切换到另一个组:alter system switch logfile;

3.规划原则

1.分散放开到不同的硬盘:解决IO冲突,解决由故障产生IO不可用的情况 2.日志所在盘的IO要足够 3.IO读写都要快。不能使用raid 5 做,因为RAID 5 读快写慢。

4.查看日志文件

Select * from v$log; Select * from v$logfile; Host ls /u01/app/oacle/oradata/ora11/redo*; 5.添加日志组或成员

1.Alter database add logfile group 4 ‘/u01/app/oracle/oradata/ora11/redo04.log’ size 50M; 添加一个组一个成员

Unused 表示刚刚添加过来的;在进行日志切换时,将会优先使用状态为unused; 2.alter database add logfile group 5 (‘/u01/app/oracle/oradata/ora11/redo05.log’,’/u01/app/oracle/oradata/ora11/redo06.log’) size 50M; 添加一个组,组中有两个成员

3.Alter database add logfile group 6 ‘/u01/app/oracle/radata/ora11/redo07.log’ size 50M,group 7‘/u01/app/oracle/oradata/ora11/redo08.log’ size 50M; 添加两个组,一组中各有一个成员

自动分配编号,会先把那些空的组填满,在依次往后加 4.Alter database add logfile member ‘/u01/app/oracle/oradata/ora11/redo09.log’ to group 4;给已经有的组4添加一个成员

5.Alter database add logfile member ‘/u01/app/oracle/oradata/ora11/redo1.log’ to group 1 ,‘/u01/app/oracle/oradata/ora11/redo2.log’ to group 2,’/u01/app/oracle/oradata/ora11/redo3.log’ to roup 3; 给多个组添加多个成员

添加一个组,并且组中成员一个都没有使用,在v$logfile 中状态中没有显示;如果在v$logfile 中,状态显示invalid 只有两种情况,一种是不存在,另一种是在这个组中有多个成员,有些成员是用过的,有些成员是没有用过的。

6.日志组的删除或成员的删除

删除日志文件也只是在数据字典和控制文件中将日志文件组的信息删除,而对应的物理文件并没有删除,若要删除,可以采用手动删除的方式;

1.Alter database drop logfile group 7; 删除一个组。 这样删可能删不掉,在v$log 中,状态中有current,active 中是不能删除的;删不掉的情况下进行日志切换,一直到你删除你能删的为止。

2.Alter database drop logfile goup 6,group 5;删除多个组.必须在一个循环之内,因为current,active 在一个循环之内

Alter system switch logfile; Select * from v$log; 3.Alter database drop logfile member ‘/u01/app/oracle/oradata/ora11/redo09.log’;删除组中的一个成员

Select * fromv$logfile; Alter database drop logfile member ‘/u01/app/oracle/oradata/ora11/redo01.log’; 这样是删除不掉的,因为正在使用。删除办法是进行日志切换,直到一个循环之外。 4. alter database drop logfile member ‘/u01/app/oracle/oradata/ora11/redo1.log’,’/u01/app/oracle/oradata/ora11/redo2.log’; 删除多个组中的成员

Select * from v$logfile;

7.日志文件重命名

在归档模式或者是非归档模式都可以进行日志文件重命名 只要在v$log下不是current 状态都可以重命名 就是你从你当前的日志文件路径改到另一个路径 Select * from v$log ; 如果你想对那个当前状态是current的文件重命名就需要进行日志切换,一直切到不是这两个状态为止。

Select * from v$logfile; Host cp /u01/app/oracle/oradata/ora11/redo04.log /u01/app/oracle/oradata/ora11/redo4.log

Host ls /u01/app/oracle/oradata/ora11/redo4.ctl Aler database rename file ‘/u01/app/oracle/oradata/ora11/redo04.log’ to ‘/u01/app/oracle/oradata/ora11/redo4.log’; 老的文件名到新的文件名

Archive log list 在mount状态下可以对日志文件中current的日志文件重命名,在open 状态下不能对currption的文件重命名

到非归档模式下的重命名:一致性关闭数据库,启动到mount 改名操作,没有状态限制,。 Shutdown immediate Startup mount Alter database noarchivelog ; Alter database open; Select * from v$log;; Select * from v$logfile; Host cp /u01/app/oracle/oradata/ora11/redo4.log /u01/app/oracle/oradata/ora11/redo04.log

Alter database rename file ‘/u01/app/oracle/oradata/ora11/redo4.log’ to ‘/u01/app/oracle/oradata/ora11/redo04.log’;

Archive log list Alter system switch logfile; 改active 状态的 Select * from v$log;; Select * from v$logfile; Host cp /u01/app/oracle/oradata/ora11/redo4.log /u01/app/oracle/oradata/ora11/redo04.log

Alter database rename file ‘/u01/app/oracle/oradata/ora11/redo4.log’ to ‘/u01/app/oracle/oradata/ora11/redo04.log’;

Archive log list 例如:磁盘坏掉了,或者是磁盘空间满掉了,

8.日志文件的重新改变大小

把原来的日志文件删除,重建就好。 Select to_char(first_time,’yyyy-mm-dd hh24:mi:ss’) ,group# from v$log;查看日志切换的时间是否满足你的需求

Alter database drop logfile group 3; Host rm –rf /u01/app/orqcle/oradata/ora11/redo03.log Alter database add logfile group 3 (‘/u01/app/oracle/oradata/ora11/redo0.log’,/u01/app/oracle/oradata/ora11/redo04.log’) size 100M;

当前用的状态为active,current,的组是不能删除的。

9.日志文件不一致的解决办法

1.alter database clear logfile group n.;只能清空你当前处于inactive状态的 2.alter database clear unarchive logfile group n; 可以清除处于active ,inactive状态的

只是当你的数据库启动时说什么东西报错时,才可以使用。清除后就直接变成了unused了

10.日志文件丢失的解决办法

首先查/u01/app/oracle/diag/ora11/ora11/trace/ ,看有什么信息 然后可以用清空的办法试下:alter database clear logfile group 3; 如果数据局一致性关闭时,可以用这种办法来解决。如果没有一致性关闭,则会解决不了这种错误。

解决办法:shutdown immediate Alter database clear logfile group 1; Alter database clear unarchived logfile group 1; Recover database using backup controlfile; Alter database open resetlogs; Recover database ; Alter system set “_allow_resetlogs_corruption”=true scope=spfile;