并行程序设计心得

MPI并行程序设计实例教程教学设计

MPI并行程序设计实例教程教学设计1. 简介MPI (Message Passing Interface) 是一种进程间通信的标准,可用于实现并行计算。

MPI 是一个库,通过对 MPI 中的函数调用,可实现在共享内存和分布式内存计算机中实现并行计算的任务分割和进程通信。

在实际应用中,MPI 会被和多线程一样用于实现算法的并行化,从而提高计算效率和运行速度。

2. 教学目标通过这个实例教程,我们会:1.了解 MPI 并行程序设计的基本概念和原理2.学会使用 MPI 的基本函数和指令3.学会通过实例演示的方式,掌握常见的 MPI 算法和技术4.实现一个简单的 MPI 并行程序,对其进行测试和优化,提高程序的执行效率3. 教学计划本教程共计 5 个部分,每个部分涵盖不同的内容。

每个部分的内容和学习目标如下:第一部分:MPI 基础概念和原理本部分的目标是让学生了解 MPI 的概念、原理和应用场景。

通过课堂讲授、案例分析和问题解答等方式,使学生领悟 MPI 的并行计算模型和通信方式。

第二部分:MPI 基本函数和指令本部分的目标是让学生掌握 MPI 中的基本函数和指令,理解其使用方法和调用方式。

通过讲解 MPI_Init、MPI_Comm_size、MPI_Comm_rank 等函数和指令,让学生能够熟练使用 MPI 构建并行程序。

第三部分:MPI 并行算法实例本部分的目标是让学生通过具体实例学习 MPI 并行算法设计的方法和技巧。

通过案例分析的方式,让学生了解 MPI 算法设计的核心思想、主要步骤和注意事项。

同时,本部分还会介绍一些常见的 MPI 库和工具,如 MPIBLAST 和 OpenMPI。

第四部分:MPI 程序设计和优化本部分的目标是让学生实践 MPI 代码的编写、调试和优化过程。

通过一个综合实例,让学生学习 MPI 并行程序的设计、实现和测试。

同时,本部分还会讲授MPI 排序算法和负载平衡算法的具体实现方法。

LabVIEW中的并行编程和多线程

LabVIEW中的并行编程和多线程LabVIEW(Laboratory Virtual Instrument Engineering Workbench)是一种用于科学与工程领域的视觉化编程语言,它提供了一种基于图形化界面和数据流的开发环境。

在LabVIEW中,可以通过并行编程和多线程技术来实现对任务的同时执行,提高程序的效率和性能。

本文将探讨LabVIEW中的并行编程和多线程的应用。

一、并行编程的概念及原理并行编程是指在程序中同时执行多个任务,它充分利用了多核处理器的优势,提高了程序的整体执行效率。

在LabVIEW中,可以通过使用并行循环(Parallel Loop)和并行操作(Parallel Operation)来实现并行编程。

并行循环是指将迭代次数多的循环体分解成若干个子循环,这些子循环可以同时执行,提高了程序的并行度。

在LabVIEW中,可以通过使用For 循环之外的Parallel Loop节点来实现并行循环,将循环体细分为多个任务,实现并行执行。

并行操作是指将一个任务分解成多个子任务,并行地执行这些子任务,最后将结果合并得到最终的结果。

在LabVIEW中,可以使用并行操作节点(Parallel Operation Node)来实现并行操作。

二、多线程的应用场景多线程是指在一个程序中同时运行多个线程,每个线程负责不同的任务,提高了程序的响应速度和并发性。

在LabVIEW中,可以通过使用多个线程来实现程序的并行执行。

1. 数据采集与处理在实验室中,经常需要进行数据采集和处理。

而数据采集和处理过程通常是一种密切相关的任务,可以通过多线程来同时进行,提高数据采集与处理的效率。

2. 控制系统在控制系统中,需要对多个传感器、执行器等进行实时控制。

通过使用多线程来实现对多个硬件设备的同时控制,可以提高系统的实时性和稳定性。

3. 图像处理图像处理是一种计算密集型的任务,通过使用多线程可以将图像分成多个区域进行处理,最后将结果进行合并,提高了图像处理的速度和效率。

并行计算的课程设计

并行计算的课程设计一、课程目标知识目标:1. 让学生理解并行计算的基本概念,掌握并行计算的核心原理。

2. 学会分析问题,识别适合并行计算的算法和场景。

3. 掌握并行编程的基本技巧,能运用所学知识对简单程序进行并行化改造。

技能目标:1. 培养学生运用并行计算技术解决问题的能力,提高计算效率。

2. 培养学生具备团队协作和沟通能力,能参与并行计算项目的开发和优化。

3. 培养学生具备自主学习能力,能够紧跟并行计算领域的发展趋势。

情感态度价值观目标:1. 激发学生对并行计算的兴趣,培养其探索精神和创新意识。

2. 培养学生具备良好的科学素养,认识到并行计算在科技发展中的重要作用。

3. 引导学生树立正确的价值观,明确并行计算为社会进步带来的积极影响。

分析课程性质、学生特点和教学要求,本课程将目标分解为以下具体学习成果:1. 学生能够解释并行计算的基本概念,阐述并行计算的核心原理。

2. 学生能够分析实际问题,提出并行计算解决方案,并评估其性能。

3. 学生能够掌握并行编程技巧,完成至少一个简单的并行程序设计。

4. 学生能够积极参与团队合作,共同完成并行计算项目。

5. 学生能够关注并行计算领域的发展动态,了解其应用前景。

本课程教学内容依据课程目标,结合教材章节,科学系统地组织如下:1. 并行计算基本概念:介绍并行计算的定义、分类及其发展历程,使学生了解并行计算的基本框架。

2. 并行计算原理:讲解并行计算的基本原理,如并发性、并行性、数据并行、任务并行等,并通过实例分析,使学生掌握并行计算的核心思想。

3. 并行计算模型:介绍 Flynn 分类法、SIMD、MIMD 等并行计算模型,让学生了解不同并行计算模型的特点及应用场景。

4. 并行编程技术:讲解并行编程的基本方法,如 OpenMP、MPI、CUDA 等,使学生掌握并行编程的技巧和注意事项。

5. 并行算法设计:分析常见并行算法设计方法,如分治法、迭代法、管道线法等,并通过实例让学生学会设计并行算法。

并行程序设计环境的研究

预 报 。 油勘 探 开 发 , 聚 变 模 拟 等 , 石 核 他们 对 计 算 机 的 性 能 提 了 T要 求 ( 秒 万 亿 次 的 负 电速 度 , 每 万亿 字 节 的存 储 容 量 及 每 秒 万 亿 比特 的 传 输 速 度 ) 些 重 大 的应 用 需 求 推 动 了 当代 计 算 技 术 的迅 这

T NG L i A Xu —egLU h-u A eP N e f .I Z iJn . n

( p  ̄ n f mp trS in eW u a o n ie r g Co e eW u a 3 4 , ia De a me t o Co ue ce c , hn Bie gn e n H g , h n4 0 Chn ) i 1 5

Ab t c: I e a e P sn t f e i as n a p c ct n frme ae p sn a e M PCH i ap r bei l n t n o sr t a MP ( s g — a ig I e a ) s a d r s ei a o o s g — a igl r s M s s n rc t d i f i s s  ̄r . I ot l mpe t o f i s a me a i

( MP 异 步 执 行 时 能 保 护用 户 的其 它 软 件 不 受 影 响 : 5 I ) f MP 是 完 全 可 移 植 标 准平 台 。 6 I )

M I H 是 MP 1 PC I. 准 的一 个 完 全 实 现 ,也 是 应 用 范 围最 广 2标

的一 种 并 行 及 分 布式 环 境 。M IH 除 包 含 M I 数库 之 外 , 包 PC P函 还

的 H C ( i e om n eC m uiga d C mm nc t n 计 划 中 P C H g P r r a c o p t n o u i i ) h f n ao 提 出 的 一批 具 有 重 大挑 战 意 义 的 科 学 与 工 程 问 题 , : 球 天 气 如 全

并行算法设计及编程基本方法

第2卷第4期零陵学院学报(教育科学) V ol. 2 No.4 2004年8月 Journal of Lingling University Aug. 2004并行算法设计及编程基本方法孙兴文(永州职业技术学院,湖南永州,425006)摘 要: 并行算法是指一次可执行多个操作的算法。

对并行算法的研究现在已发展为一个独立的研究领域。

很多用串行算法解决的问题也已经有了相应的并行算法。

在本文,我们阐述了一些简单的并行计算以说明并行算法的一些基本概念、应用和编程方法。

关键词: 并行算法; 效率 ;编程*中图分类号: TP311 文献标识码: A 文章编号:1671-9697(2004)04-0182-031. 并行算法设计1.1 并行算法的基本概念所谓并行,是只有一个以上的事件在同一时刻伙同时间段内发生,有人把并行分为几类:数据并性行,分布式并性行与人的并行性,世界上客观事物的发展过程很多是并行的,彼此相对独立,相互又有一定的联系和制约。

1.2 并行算法的目标从计算复杂性的角度来看,一个算法的复杂性表示为空间复杂性和时间复杂性两个方面。

并行算法的目标是尽可能减少时间复杂性,通常是增加空间复杂性(如增加空间的维数及增加处理器的台数)来实现。

从算法树的结构来看,通常的串行算法树“深而窄”。

递推算法是串行算法本质上是为一维问题设计的,而不少高维问题的计算本质上仍借助一维的张量积形式。

体现在矩阵计算则是70年代稀疏矩阵技术的广发应用。

并行算法树的结构则截然不同,为达到把时间复杂性转化为时间复杂性的目的,并行算法树采用“浅而宽”的结构,即每时刻可容纳的计算量相应增加,使整个算法的步数尽可能减少。

适当增加空间复杂性(如引入较复杂的基底,增加空间维数等),是不少并行算法所实际采用的有效的方法。

1.3 加速比定率与可扩展性顾名思义,并行加速比是表示采用多个矗立起计算速度所能得到的加速的倍数。

设t seq表示用串行机求解某个计算问题所需的时间,t P是用p个处理器求解该问题所需的时间。

Matlab中的多CPU并行计算:一种基于Matlab引擎的混合编程

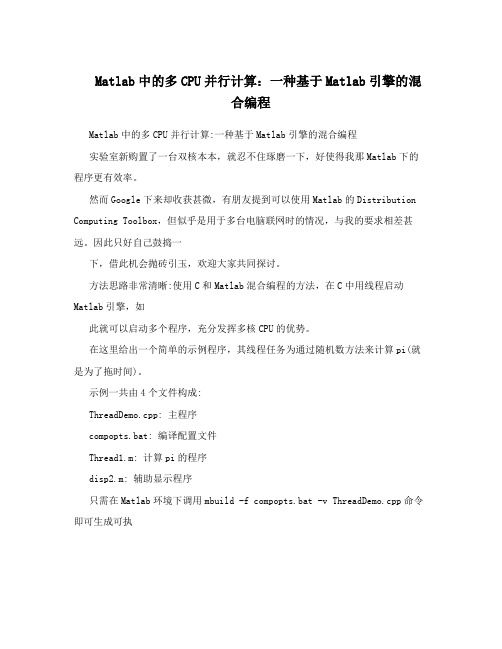

Matlab中的多CPU并行计算:一种基于Matlab引擎的混合编程Matlab中的多CPU并行计算:一种基于Matlab引擎的混合编程实验室新购置了一台双核本本,就忍不住琢磨一下,好使得我那Matlab下的程序更有效率。

然而Google下来却收获甚微,有朋友提到可以使用Matlab的Distribution Computing Toolbox,但似乎是用于多台电脑联网时的情况,与我的要求相差甚远。

因此只好自己鼓捣一下,借此机会抛砖引玉,欢迎大家共同探讨。

方法思路非常清晰:使用C和Matlab混合编程的方法,在C中用线程启动Matlab引擎,如此就可以启动多个程序,充分发挥多核CPU的优势。

在这里给出一个简单的示例程序,其线程任务为通过随机数方法来计算pi(就是为了拖时间)。

示例一共由4个文件构成:ThreadDemo.cpp: 主程序compopts.bat: 编译配置文件Thread1.m: 计算pi的程序disp2.m: 辅助显示程序只需在Matlab环境下调用mbuild -f compopts.bat -v ThreadDemo.cpp命令即可生成可执行文件ThreadDemo.exe,再输入命令!ThreadDemo即可观察结果。

实验环境为在Matlab6.5, VC6.0。

Matlab7.0由于对混合编程的方式进行了较大改动,示例可以通过编译,但不能正常运行。

以下为运行结果:>> !ThreadDemo10:41:32 --> Time used: 27", 10:41:05 -- 10:41:3210:41:32 --> Task1: IterNum = 100000000, Result = 3.14196110:41:33 --> Time used: 27", 10:41:06 -- 10:41:3310:41:33 --> Task2: IterNum = 100000000, Result = 3.141961可以看到两个任务几乎同时启动,同时结束。

双机并行通讯程序设计

双机并行通讯程序设计1 问题的描述与分析题目要求由甲乙两台微机之间并行传送1K字节数据。

先甲机发送,乙机接收,后乙机发送,甲机接收。

甲乙双方的8255A均采用方式2工作。

8255A控制口地址为303。

本题属于双机并行通讯问题,应分为发送和接收两方面分别来进行研究。

由于程序需要对地址进行直接操作,所以选择汇编语言来编写较为简单方便。

在写程序的过程中,由于要用8255A芯片作为并行传输芯片,所以要熟练掌握8255A的控制方法;此外,程序多处还要用到DOS功能调用,所以还要对DOS的各种功能进行系统的学习。

两台PC各与一个8255A芯片相连,程序分为两部分,分别运行与两台PC机上以实现并行传输。

连接图如下:图1-1双机通讯的连接图程序分为两个部分,分别在甲机和乙机上面运行。

甲机运行的程序是先发送后接收,乙机上运行的程序时先接收后发送,实现先从甲机到乙机传输1KB的数据,后从乙机到甲机传输1KB的数据的功能。

我们在两台微机的内存中各开辟一个1KB的字符区BUF1,象征性的输入少许字符,来模拟要传输的1KB的数据。

再各开辟一个1KB的字符区BUF2用来存储接收到的1KB数据。

2 8255A芯片的介绍2.1 8255A的引脚功能8255A的芯片引脚图见图2-1:图2-1 8255A的芯片引脚图RESET:复位输入线,当该输入端外于高电平时,所有内部寄存器(包括控制寄存器)均被清除,所有I/O口均被置成输入方式。

PA0~PA7:端口A输入输出线,一个8位的数据输出锁存器/缓冲器,一个8位的数据输入锁存器。

PB0~PB7:端口B输入输出线,一个8位的I/O锁存器,一个8位的输入输出缓冲器。

PC0~PC7:端口C输入输出线,一个8位的数据输出锁存器/缓冲器,一个8位的数据输入缓冲器。

端口C可以通过工作方式设定而分成2个4位的端口,每个4位的端口包含一个4位的锁存器,分别与端口A和端口B配合使用,可作为控制信号输出或状态信号输入端口。

基于块同步模型的并行遗传程序设计方法

遗传程序设计 ,并 以人工蚂蚁 问题的求解为例对该方

法进行d大学的 J K z 教授 t fr a . oa R 于上世 纪 9 O年代提出,作为进化计算 的一个新分支,

1 遗传程序 设计 的原理

遗传程序 设计的基本思想是 :随机产生一个适合 于给 定环境 的初始计算机程序种群 ,即问题 的搜索 空 间,通过反复的计算过程获得进 化。与遗传算法类 似 , 构成种群 的个 体都有 一个适应度 函数 ,依据适者生存

串行处理求解时,第 0代 的计算机程 序平均吃掉 3 . 5片食物。 进化到 2 7代时出现能够 把 8 9片食物 都搜 索到的程序个体 ,即该个体是一个 能够在尽量 短的时 间内遍历完所有食物节 点的蚂蚁程序 ,如 图 4所示 。

多个进程,其中主进程处理顺序 的 G 过程,完成程 P 序片段 的交叉 、复制 、编译操作 ,当需要 计算适 应度

收 稿 时间 : 1—1 7收 到修 改稿 时间 : 1-1 6 2 11- ; 0 0 2 1l. 0 2

《深入理解并行编程》中文版 并发编程网

《深入理解并行编程》中文版并发编程网原文的下载地址:/pub/linux/kernel/people/paulmck/perfbook /perfbook.html中文版下载地址:深入理解并行编程V1.0 (4.1M)本书是linux内核大牛paul的力作,和鲁阳同学一起,花了两个月时间进行翻译。

目前没有翻译问答部分,主要是时间不够,也担心不能将这部分翻译准确。

对内核深度发烧的同学可以看看。

本书目录1. 简介 (14)1.1. 导致并行编程困难的历史原因 (14)1.2. 并行编程的目标……………………………………………………………… (15)1.2.1. 性能 (16)1.2.2. 生产率 (17)1.2.3. 通用性 (18)1.3. 并行编程的替代方案 (20)1.3.1. 顺序应用多实例化 (20)1.3.2.使用现有的并行软件 (21)1.3.3. 性能优化 (21)1.4. 是什么使并行编程变得复杂? (22)1.4.1. 工作分 (22)1.4.2. 并行访问控制 (23)1.4.3. 资源分割和复制 (24)1.4.4. 与硬件交互 (24)1.4.5. 组合使用 (24)1.4.6. 语言和环境如何对这样的任务进行支持? (25)1.5. 本书导读 (25)1.5.1. 小问题 (25)1.5.2. 随书源 (26)2. 硬件的习性 (28)2.1. 概述 (28)2.1.1. CPU流水线 (29)2.1.2. 内存引用 (30)2.1.3. 原子操作 (31)2.1.4. 内存屏障 (32)2.1.5. CacheMiss …………………………………………………………… (33)2.1.6. I/O操作 (34)2.2. 开销 (35)2.2.1. 硬件体系结构 (36)2.2.2. 操作的开销 (37)2.3. 硬件的免费午餐? (38)2.3.1. 3D集成 (39)2.3.2. 新材料和新工艺 (39)2.3.3. 专用加速器 (39)2.3.4. 现有的并行软件 (40)2.4. 软件设计Implication (40)3. 工具 (43)3.1. 脚本语言 (43)3.2. POSIX多进程 (44)3.2.1. POSIX进程创建和撤销 (44)3.2.2. POSIX线程的创建和撤销 (46)3.2.3. POSIX 锁……………………………………………………………… (48)3.2.4. POSIX读写锁………………………………………………………………..523.3. 原子操作 (55)3.4. Linux内核中类似POSIX的操作 (56)3.5. 趁手的工具——该如何选择? (58)4. 计数 (59)4.1. 为什么并发计数不可小看? (60)4.2. 统计计数器 (62)4.2.1. 设计 (62)4.2.2. 基于数组的实现 (62)4.2.3. 结果一致的实现 (64)4.2.4. 基于每线程变量的实现 (66)4.2.5. 讨论 (69)4.3. 近似上限计数器 (69)4.3.1. 设计 (69)4.3.2. 简单的上限计数器实现 (70)4.3.3. 关于简单上限计数器的讨论 (76)4.3.4. 近似上限计数器的实现 (76)4.3.5. 关于近似上限计数器的讨论 (77)4.4. 精确上限计数器 (77)4.4.1. 原子上限计数器的实现 (77)4.4.2. 关于原子上限计数器的讨论 (86)4.4.3. Signal-Theft上限计数器的设计 (86)4.4.4. Signal-Theft上限计数器的实现 (87)4.4.5. Signal-Theft上限计数器讨论 (94)4.5. 特殊的并行计数器………………………………………………………………..954.6. 并行计数的讨论 (96)5. 分割和同步设计……………………………………………………………… (100)5.1. 分割练习 (100)5.1.1. 哲学家就餐问题 (100)5.1.2. 双端队列 (102)5.1.3. 关于分割问题示例的讨论 (111)5.2. 设计准则 (111)5.3. 同步粒度 (113)5.3.1. 串行程序 (114)5.3.2. 代码锁……………………………………………………………… (116)5.3.3. 数据锁 (117)5.3.4. 数据所有权 (120)5.3.5. 锁粒度与性能 (121)5.4. 并行快速路径 (121)5.4.1. 读写锁 (122)5.4.2. 层级锁 (123)5.4.3. 资源分配器缓存 (125)5.5. 性能总结 (131)6. 锁 (132)6.1. 生存(staying alive) (133)6.1.1. 死锁 (133)6.1.2. 活锁 (136)6.1.3. 不公平 (137)6.1.4. 低效率 (137)6.2. 锁的类型………………………………………………………………6.2.1. 互斥锁 (138)6.2.2. 读写锁 (138)6.2.3. Beyond Reader-WriterLocks (138)6.3. 基于锁的存在担保(existence guarantee) (138)7. 数据所有者 (140)8. 延迟处理 (142)8.1. 屏障 (142)8.2. 引用计数………………………………………………………………8.2.1. 引用计数类型的实现 (143)8.2.2. 支持引用计数的Linux原语 (150)8.2.3. 计数器优化 (151)8.3. Read-Copy Update (RCU) (151)8.3.1. RCU基础 (151)8.3.2. RCU用法 (163)8.3.3. Linux内核中的RCU API (176)8.3.4. “玩具式”的RCU实现 (183)8.3.5. RCU练习……………………………………………………………… (206)9. 使用RCU (207)9.1. RCU和基于每线程变量的统计计数器 (207)9.1.1. 设计 (207)9.1.2. 实现 (207)9.1.3. 讨论 (211)9.2. RCU和可移除I/O设备的计数器 (211)10. 验证:调试及分析 (214)11. 数据结构……………………………………………………………… (216)12. 高级同步 (218)12.1. 避免锁 (218)12.2. 内存屏障 (218)12.2.1. 内存序及内存屏障 (218)12.2.2. 如果B在A后面, 并且C在B后面, 为什么C不在A后面? 22012.2.3. 变量可以拥有多个值 (221)12.2.4. 能信任什么东西? (222)12.2.5. 锁实现回顾 (229)12.2.6. 一些简单的规则 (230)12.2.7. 抽象内存访问模型 (230)12.2.8. 设备操作 (233)12.2.9. 保证 (233)12.2.10. 什么是内存屏障? (234)12.2.11. 锁约束 (247)12.2.12. 内存屏障示例 (248)12.2.13.CPU (251)12.2.14. 哪里需要内存屏障? (253)12.3. 非阻塞同步 (253)12.3.1. 简单NBS (253)12.3.2. 冒险指针 (253)12.3.3. 原子数据结构 (253)12.3.4. “Macho” NBS (253)13. 易于使用 (254)13.1. Rusty Scale for APIDesign (254)13.2. Shaving the MandelbrotSet (255)14. 时间管理……………………………………………………………… (258)15. 未来的冲突 (259)15.1. 可交易内存 (259)15.1.1. I/O 操作 (260)15.1.2. RPC 操作 (260)15.1.3. 内存映射操作 (261)15.1.4. 多线程事务 (262)15.1.5. 外部的事务访问 (263)15.1.6. 延时……………………………………………………………… (264)15.1.7. 锁 (264)15.1.8. 读者-写者锁 (265)15.1.9. 持续性 (266)TM如何提供类似的持续性功能? (266)15.1.10. 动态链接装载 (266)15.1.11. 调试 (267)15.1.12. exec() 系统调用 (268)15.1.13.RCU (268)15.1.14. 讨论 (270)15.2. 共享内存并行编程 (270)15.3. 基于任务的并行编程 (270)A. 重要问题 (271)A.1 “after“的含义是什么? (271)B. 同步原语 (277)B.1 初始化 (277)B.1.1smp_init() ……………………………………………………… (277)B.2 线程创建、销毁及控制 (278)B.2.1create_thread() (278)B.2.2smp_thread_id() (278)B.2.3for_each_thread() (278)B.2.4for_each_running_thread() (279)B.2.5wait_thread() ………………………………………………………………… 279 深入理解并行编程B.2.6wait_all_threads() (279)B.2.7 用法示例 (279)B.3 锁 (280)B.3.1s pin_lock_init() (280)B.3.2spin_lock() (280)B.3.3spin_trylock() (281)B.3.4spin_unlock() (281)B.3.5 用法示例 (281)B.4 每线程变量……………………………………………………………… (281)B.4.1DEFINE_PER_THREAD() (282)B.4.2DECLARE_PER_THREAD() (282)B.4.3per_thread() (282)B.4.4__get_thread_var() (282)B.4.5init_per_thread() (282)B.4.6 用法示例 (282)B.5 性能 (283)C. 为什么使用内存屏障 (284)C.1 Cache 结构 (284)C.2 缓存一致性协议 (286)C.2.1 MESI 状态 (286)C.2.2 MESI 协议消息 (287)C.2.3 MESI状态图 (288)C.2.4 MESI 协议示例 (289)C.3 不必要的存储延迟 (291)C.3.1 StoreBuffers (291)C.3.2 StoreForwarding (292)C.3.3 存储缓冲区及内存屏障 (293)C.4 不必要的存储延迟 (296)C.4.1 无效队列 (296)C.4.2 使无效队列及使无效应答 (296)C.4.3 无效队列及内存屏障 (297)C.5 读和写内存屏障……………………………………………………………… (300)C.6 内存屏障示例 (300)C.6.1 乱序体系结构 (300)C.6.2 示例1 …………………………………………………………………… 301 深入理解并行编程C.6.3 示例2 (302)C.6.4 示例3 (303)C.7 特定CPUs的内存屏障指令 (304)C.7.1Alpha (306)C.7.2AMD64 …………………………………………………………C.7.3ARMv7-A/R (309)6ISB(); (309)C.7.4IA64 (309)C.7.5PA-RISC (310)C.7.6 POWER / PowerPC (310)C.7.7 SPARC RMO, PSO, andTSO (311)C.7.8x86 (312)C.7.9zSeries …………………………………………………………C.8 内存屏障是永恒的? (313)C.9 对硬件设计者的建议 (314)D. RCU实现 (315)D.1 可睡眠RCU 实现 (315)D.1.1 SRCU 实现原理 (316)D.1.2 SRCU API 及用法 (317)D.1.3 实现 (320)D.1.4 SRCU 概述……………………………………………………………… (326)D.2 分级RCU 概述 (326)D.2.1 RCU 基础回顾 (326)D.2.2 经典RCU 实现概要 (327)D.2.3 RCU 迫切要解决的问题 (328)D.2.4 可扩展RCU 实现 (329)D.2.5 迈向不成熟的RCU 实现 (332)D.2.6 状态机 (334)D.2.7 用例 (335)D.2.8 测试 (340)D.2.9 结论 (345)D.3 分级RCU代码走查 (346)D.3.1 数据结构及内核参数 (346)D.3.2 外部接口 (354)D.3.3 初始化…………………………………………………………………… 362 深入理解并行编程D.3.4 CPU 热插拨 (367)D.3.5 杂项函数 (372)D.3.6 Grace-Period检测函数 (373)D.3.7 Dyntick-Idle 函数 (385)D.3.8 强制静止状态 (390)D.3.9 CPU-延迟检测 (397)D.3.10 可能的缺陷及变更 (400)D.4 可抢占RCU (400)D.4.1 RCU概念 (401)D.4.2 可抢占RCU算法概述 (402)D.4.3 验证可抢占RCU (419)E. 形式验证 (422)E.1 什么是Promela 和Spin? (422)E.2 Promela 示例: 非原子性递增 (423)E.3 Promela 示例: 原子递增 (426)E.3.1 组合 (427)E.4 如何使用Promela (428)E.4.1 Promela 特性 (428)E.4.2 Promela编程技巧 (429)E.5 Promela 示例: 锁 (430)E.6 Promela 示例:QRCU (433)E.6.1 运行QRCU 示例 (438)E.6.2 到底需要多少读者和写者? (439)E.6.3 可选方法: 正确性校验 (439)E.6.4 可选方法: 更多工具 (440)E.6.5 可选方法: 分而治之 (440)E.7 Promela Parable: dynticks 和可抢占RCU (440)E.7.1 可抢占RCU 和dynticks介绍 (441)E.7.2 验证可抢占RCU和dynticks (445)E.7.3 回顾 (466)E.8 简单的避免形式校验 (467)E.8.1 简单Dynticks 接口的状态变量 (467)E.8.2 进入和退出Dynticks-Idle 模式 (468)E.8.3 从Dynticks-Idle 模式进入NMIs (469)E.8.4 Interrupts From Dynticks-IdleMode (470)E.8.5 检查Dynticks 静止状态 (471)E.8.6 讨论 (473)E.9 概要 (473)F. 问题答案 (474)G. 术语表 (475)H. 感谢 (476)(全文完)原创文章转载请注明出处:《深入理解并行编程》中文版支持本站::Pay For Your Wish4About Latest Posts谢宝友谢宝友:毕业于四川省税务学校税收专业,现供职于中兴通讯操作系统团队,对操作系统内核有较强的兴趣。

Java中的函数式编程(八)流Stream并行编程

Java中的函数式编程(⼋)流Stream并⾏编程写在前⾯在本系列⽂章的第⼀篇,我们提到了函数式编程的优点之⼀是“易于并发编程”。

Java作为⼀个多线程的语⾔,它通过 Stream 来提供了并发编程的便利性。

题外话:严格来说,并发和并⾏是两个不同的概念。

“并发(Concurrency)”强调的是在同⼀时间开始执⾏多个任务,通常会涉及多线程之间的上下⽂切换;“并⾏(Parallelism)”强调的是将⼀个⼤任务分解为多个⼩任务后,再同时执⾏这些⼩任务,得到多个中间结果后再汇总为⼀个最终结果。

但在多CPU和分布式的时代,并发和并⾏的概念联系越来越紧密。

⾄少在Java的Stream中,我们可以将并发和并⾏理解为同⼀个意思:基于多线程技术,对⼀个⼤任务分拆为多个⼩任务,分配到不同的线程中执⾏,得到多个中间结果后再汇总为⼀个最终结果。

Stream的并⾏编程并⾏编程是Stream的⼀个重要功能和特性。

它的⼀个优点是:不管数据源是否线程安全,通过并⾏流(parallel stream)都可以轻松的实现并⾏编程。

Stream的并⾏编程,底层是基于 ForkJoinPool 技术来实现的。

ForkJoinPool是Java 7引⼊的⽤于并⾏执⾏的任务框架,核⼼思想是将⼀个⼤任务拆分成多个⼩任务(即fork),然后再将多个⼩任务的处理结果汇总到⼀个结果上(即join)。

此外,它也提供基本的线程池功能,譬如设置最⼤并发线程数,关闭线程池等。

在本系列之前的⽂章中,也零零散散的提到了⼀些关于并⾏编程的知识点。

本⽂再做⼀个更系统的总结。

并⾏流(parallel stream)Stream的并⾏操作都是基于并⾏流(parallel stream)。

⽣成⼀个并⾏流也⾮常简单:1. 通过 Collection.parallelStream ⽅法可以得到⼀个并⾏流2. ⽣成⼀个串⾏的Stream后,可以通过⽅法 BaseStream.parallel() 将⼀个串⾏流(serial stream)转换成并⾏流。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1、MPI实质上是多进程,并且不支持多线程; 2、初始化时在每个处理机(结点)上创建一个进程,执行期间进程数不能动态改变; 3、MPI其实就是一种在各进程之间进行通讯的标准; 4、并行程序设计最常用的两种方法: 1、共享变量方法——利用共享存储器中共享变量来实现处理机间的通信,它主要用在共享存储结构中(OpenMP) 2、消息传递方法——主要特点是不同处理机间必须通过网络传送消息来相互通信,并达到任务间需要的同步操作,它主要应用于分布式存储结构中(MPI) 5、一个基本的MPI 程序的流程图

对于多核程序设计的一点总结 多核下的多线程程序设计与传统的单核下的多线程程序设计有着一定的差别,在单CPU下,是多个线程在同一个CPU上并发地执行,而在多核下,则是由多个线程在多个核上并行地执行。 但是,目前的程序设计中对于多核的利用并没有达到预期的效果。因此,为了能够在多核的环境下设计出更适合多核系统的程序,则是一个挑战。 要做到这一点,就必须将应用程序看做是众多相互依赖的任务的集合,将应用程序划分成多个独立的任务,并确定这些任务之间的相互依赖关系,这就称为分解(decomposition)。如下如示:

分解方式 设计 说明 任务分解 不同的程序行为采用不同的线程实现 常用于GUI应用程序 数据分解 多个线程对不同的数据块执行相同的操作 常用于音频、图像处理和科学计算应用程序 数据流分解 一个线程的输出作为另一个线程的输入 应注意尽量避免延迟

任务分解:对应用程序根据其执行的功能进行分解的过程称为任务分解(task decomposition)。根据这种方法,就能够对众多的独立任务进行分类。如果其中两个任务能够同时运行,那么开发人员就应该对其进行调度,形成二者之间的并行执行。

数据分解:数据分解也称为数据级并行(data-level parallelism)。是将应用程序根据各任务所处理的数据而非按任务来进行分解的方法,即以数据为中心。一般而言,能够按照数据分解方式进行分解的应用程序都包含多个线程,这些线程分别对不同的数据对象执行相同的操作。

数据流分解:在很多情况下,当对一个问题进行分解时,关键问题不在于采用一些什么任务来完成这个工作,而在于数据在这些任务之间是如何流动的。这个时候就要采用数据流分解方式,如典型的生产者/消费者问题。

对于任务分解,有两个需要注意的地方: 1. 划分的对象是计算,将计算划分为不同的任务 2. 划分后,研究不同任务所需的数据,如果这些数据不相交,则证明划分是成功的,如果数据有相当程序的相交,意味着要重新进行数据划分和功能划分。 如在一个气候模型中,需要考虑到地表模型、水文模型与海洋模型等多种情况,那么就应该将这几种模型划分成不同的任务,再分别进行并行地运算。

对于数据分解,划分的对象是数据,可以是算法的输入数据、中间处理数据和输出数据。在划分时应该考虑到数据上的相应操作。 最简单的情况下,比如对1000万个数进行相加,可以对其进行数据上的分解,用多个线程来分别计算不同批次的数据。然后再将计算的中间数据加到一起成为最终的结果。

1. 线程过多 线程并不是越多越好,对于某个程序,如果线程过多反而会严重地降低程序的性能。这种影响主要在于: 将给定的工作量划分给过多的线程会造成每个线程的工作量过少,因此可能导致线程启动和终止的开销比程序实际工作的时间还要多。 同时,太多并发线程的存在将导致共享有限硬件资源的开销增大。如保存和恢复寄存器状态的开销、保存和恢复线程cache状态的开销、废除虚存的开销、线程聚集在一起等待获取某个锁。 怎样解决这个问题: 限制可运行线程的个数 将计算线程与I/O线程分离开 使用已有的技术,如OpenMP,线程池等

2. 数据竞争、死锁 死锁,想必大家都很熟悉。这里谈谈一些简单的避免死锁的规则: 加锁的顺序是关键,使用嵌套的锁时必须保证以相同的顺序获取锁 防止发生饥饿:即这个代码的执行是否一定会结束。 不要重复请求同一个锁 越复杂的加锁方案越有可能造成死锁—设计应力求简单

3. 竞争激烈的锁 即使是正确使用锁来避免数据竞争,但如果各线程对锁的竞争很激烈,那么也会引发性能问题。即很多个线程来竞争同一个锁。在这个情况下,可以考虑将资源划分成若干个部分,然后用彼此独立的锁分别保护各个部分。即合理地安排加锁粒度的问题。在早期的Linux内核中就使用了大内核锁,现在已经把锁给细划到不同的子系统中去了。 如果一个数据结构被频繁读取但不被频繁写入,就可以使用读写锁来解决竞争。

4. 线程安全函数 已有的一些函数并不是线程安全的,具体的线程安全函数可以参考APUE2上面的线程一章。

5. 存储效率问题 目前,处理器的速度已经比存储器快很多,一个处理器从内存中读或写一个值的时间内可以完成上百次的操作。因此,现在的程序往往受限于存储器的瓶颈。 首先,可以通过节省带宽,可以减少与存储器的数据交换数量,要节省带宽就要将数据压缩得更加紧凑。 其次是cache的利用。可以减少数据在不同CPU的cache间的移动。CPU亲合力(CPU Affinity)就是指在Linux系统中能够将一个或多个进程绑定到一个或多个处理器上运行。一个进程的CPU亲合力掩码决定了该进程将在哪个或哪几个CPU上运行,在一个多处理器系统中,设置CPU亲合力的掩码可能会获得更好的性能。 在下面的例子中讲解了如何利用将某个进程绑定以某个CPU上运行的实例。 http://linux.chinaunix.net/bbs/viewthread.php?tid=904906&extra=page%3D1%26amp%3Bfilter%3Ddigest

目前双核心的 CPU 当道,AMD 的 Athlon64x2、Intel 的 Pentium-D、Core Duo,以及即将上市的 Core 2 Duo,俨然将成为下一代电脑的主流(尤其是超低价的 Pentium D,绝对是现阶段 C/P 值极高的双核心 CPU)。但是双核心有什麼用呢? 对於一般单一执行绪(single thread)的程式,多核心的处理器并没有办法提升它的处理效能;不过对於多执行绪(multi thread)的程式,就可以透过不同的核心同时计算,来达到加速的目的了!简单的例子,以单执行绪的程式来说,一件事做一次要十秒的话,要做十次,都丢给同一颗核心做的话,自然就是 10 秒 * 10 次,也就是 100 秒了;但是以多执行绪的程式来说,它可以把这一件事,分给两颗核心各自做,每颗核心各做 5 次,所以所需要的时间就只需要 50 秒! OpenMP 诞生于1997年 目前正在制定并即将推出OpenMP 3.0版本 www.openmp.org 标准版本2.5,2005年5月,支持Fortran/C/C++ 面向共享内存以及分布式共享内存的多处理器多线程并行编程语言 一种能够被用于显式指导多线程、共享内存并行的应用程序编程接口(API) 具有良好的可移植性,支持多种编程语言 支持多种平台 优点是简单、通用,有利于快速开发并行程序 大多数的类UNIX系统以及Windows NT系统(Windows 2000,Windows XP,Windows Vista等) 从物理划分上共享内存和分布式内存是两种基本的并行计算机存储方式除此之外分布式共享内存也是一种越来越重要的并行计算机存储方式; 共享内存多处理器 内存是共享的,某一个处理器写入内存的数据会立刻被其它处理器访问到 分布式内存 每一个处理器或者一组处理器有一个自己私有的内存单元 共享或者不共享一个公用的内存单元

目前业界流行的共享内存模型开发标准是OpenMP。OpenMP 定义了一套编译指导语句,用于指定程序的并行性、数据的共享/私有等信息。其目标是为SMP 系统提供可移植、可扩展的开发接口。Intel,DEC,Silicon Graphics,Kuch & Associates 和IBM 早在15 年前就联合定义了OpenMP 早期标准。新的OpenMP 标准由OpenMP Architecture Review Board 于1997 年推出,现在已发展到2.0 版。作为一套可移植可扩展的标准OpenMP 为程序员提供了一个简单和灵活的接口,可以方便地为共享内存的多处理器平台增加并行机制。大部分高性能计算机厂商和软件厂商,例如。OpenMP 在所有的架构上都支持使用C/C++FORTRAN 进行共享内存并行编程,包括基于Microsoft? WindowsNT? 和UNIX?操作系统的构架OpenMP 还使用编译器指令和库函数,帮助并行应用程序员使用C/C++和FORTRAN 创建多线程应用。对于包含有多个耗时的循环的应用,OpenMP 特别有用,它可以将工作划分为多个线程。任一应用中划分粗糙的循环级别的并行机制的数量往往比较有限,限制了应用程序的可扩展性。一个并行区域可能嵌入在其它并行区域之内,但是它们缺省的执行方式是必须使用一个线程组来串行执行。OpenMP 使用fork- join 并行机制,程序首先顺序执行,然后转换成为并行程 序。OpenMP 允许程序员使用划分良好的循环级并行机制来扩展应用,实现多处理。它们可以添加划分粗糙的并行机制,同时仍然能保留以前在扩展方面所做的投资。使用这种增量式的开发战略,程序员可以避免转向消息传递或其它并行编程模型时所具有的风险。要开发新的应用,程序员必须分析原始问题,将它分解为多个使用共享和本地数据的任务,确定数据之间的依赖性,然后重新组织任务进入执行单元的顺序,这可以使用并行编程环境来实现编码。 展望:OpenMP 将成为支持SMP 系统编程的主要标准,将来的工作在于研究和开发更加有效的OpenMP 编译器,以及更加强大友好的开发、调试工具。

P0 P1 P2 Pn

处理器

共享内存