ffmpeg+libsrt 编译

windows下使用MinGW msys编译ffmpeg

C++:windows下使用MinGW+msys编译ffmpegFFmpeg是在Linux平台下开发的,但它同样也可以在其它操作系统环境中编译运行,本文介绍的就是在windowsXP下编译FFmpeg。

一准备环境:1 下载mingw 和MSYS去/projects/mingw/ 下载A 点击“DownLoad mingw-get-inst-...exe”;B 切换到页面:download? Check your browser's security bar, or try a direct link, or try another mirror. ;C 点击“direct link”下载类似:mingw-get-inst-20110802.exe 的文件。

提示:msys此处就不用下载了,mingw-get-inst-20110802.exe 中已经包含了msys1.0,后面安装的时候就可以看到该选项。

2 下载yasmffmpeg编译里面的汇编代码需要yasm.exe去官网:/Download.html 下载直接下载:Win32 .exe (for general use on 32-bit Windows)文件名为:yasm-1.1.0-win32.exe3 下载ffmpegffmpeg可以到/releases/ 下载本人选择的是最新版本:ffmpeg-0.8.5.tar.gz(X) 0.10.2版本文件名为:ffmpeg-0.8.5.tar.gz4 下载SDLSDL下载可以到:/download-1.2.php选择:SDL-1.2.14.tar.gz - GPG signed此版本需要自己编译,后面会解释为什么下载该版本,而不下载编译好的SDL-devel-1.2.14-mingw32.tar.gz (Mingw32)5 下载pthreadGC2.dllpthreadgc2.dll是功能强大的处理数字化影视作品编辑软件premiere6运行所需的一个DLL文件。

linux编译ffmpeg支持x264,x265

linux编译ffmpeg支持x264,x2651. 前言本教程涉及的ffmpeg, x264, x2652. 环境依赖2.1 删除系统中安装的ffmpeg等库[plain] view plain copy1.sudo apt-get --purge remove ffmpeg mplayer x264 x2652.2 安装依赖库[plain] view plain copy1.sudo apt-get update2.sudo apt-get -y --force-yes install autoconf automake build-essential libass-dev libfreetype6-dev libgpac-dev \3.libsdl1.2-dev libtheora-dev libtool libva-dev libvdpau-dev libvorbis-dev libxcb1-dev libxcb-shm0-dev \4.libxcb-xfixes0-dev pkg-config texi2html zlib1g-dev注: 服务器版本可忽略libsdl1.2-dev libva-dev libvdpau-dev libxcb1-dev libxcb-shm0-dev libxcb-xfixes0-dev2.3 下载源代码(1) ffmpeg[plain] view plain copy1.git clone git:///ffmpeg.git ffmpeg(2) x264[plain] view plain copy1.<pre name="code" class="plain"><pre name="code" clas s="plain">git clone git:///x264.git(3) x265[plain] view plain copy1.hg clone /multicoreware/x265(4) yasmyasm 是x86平台的一个汇编优化器, 能够加快ffmpeg x264的编译[plain] view plain copy1.wget /projects/yasm/releases/yasm-1.3.0.tar.gz2.tar xzvf yasm-1.3.0.tar.gz3. 编译3.1 配置编译输出目录[plain] view plain copy1.export FFMPEG_PATH="YOUR_PATH"2.export PATH="$FFMPEG_PATH/bin:$PATH"例如我输出目录为$HOME/ffmpeg_2.6.3/build_out那么:[plain] view plain copy1.export FFMPEG_PATH="$HOME/ffmpeg_2.6.3/build_out"3.1 yasm[plain] view plain copy1.cd yasm-1.3.02../configure --prefix="$HOME/"3.make4.make install或者安装已有的库(yasm version ≥ 1.3.0)[plain] view plain copy1.sudo apt-get install yasm3.2 x264在配置ffmpeg config时需要加入--enable-gpl和--enable-libx264[plain] view plain copy1.cd x264*2../configure --prefix="$FFMPEG_PATH" --enable-shared --enable-static3.make -j44.make install5.make clean或者安装已有的库(yasm version ≥ 1.3.0)[plain] view plain copy1.sudo apt-get install libx264-dev3.3 x265[plain] view plain copy1.cd x265/build/linux2.cmake -G "Unix Makefiles" -DCMAKE_INSTALL_PREFIX="$FFMPEG_PATH" -DENABLE_SHARED:bool=off ../../source3.make -j44.make install5.make clean6.</tt></span>3.4 aac在配置ffmpeg config时需要加入--enable-libfdk_aac(如果开启--enable-gpl同时需要开启--enable-nonfree )[plain] view plain copy1.PKG_CONFIG_PATH="$FFMPEG_PATH/lib/pkgconfig" ./co nfigure \2.--prefix="$FFMPEG_PATH" \3.--pkg-config-flags="--static" \4.--extra-cflags="-I$FFMPEG_PATH/include" \5.--extra-ldflags="-L$FFMPEG_PATH/lib" \6.--enable-gpl \7.--enable-libass \8.--enable-libfaac \9.--enable-libfreetype \10.--enable-libmp3lame \11.--enable-libtheora \12.--enable-libvorbis \13.--enable-libx264 \14.--enable-libx265 \15.--enable-nonfree \16.--enable-shared \17.--enable-postproc \18.--enable-x11grab \19.--enable-bzlib \20.--enable-libxvid \21.--enable-zlib \22.--disable-debug4. 将ffmpeg添加到环境变量4.1 将ffmpeg添加到环境变量[plain] view plain copy1.vim ~/.bashrc在最后添加[plain] view plain copy1.export FFMPEG_PATH="/home/guohe/workspace/ffmpeg _2.6.3/build_out"2.export PATH="$FFMPEG_PATH/bin:$PATH"4.2 添加链接库编译完成之后调用ffmpeg 会出现error while loading shared libraries: xxx解决这种问题有2中方法:(1) 修改/etc/ld.so.conf[plain] view plain copy1.vim /etc/ld.so.conf在最后添加[plain] view plain copy1.$FFMPEG_PATH/lib然后执行[plain] view plain copy1.sudo ldconfig(2) 修改LD_LIBRARY_PATH[plain] view plain copy1.vim ~/.bashrc在最后添加[plain] view plain copy1.export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:$FFMPEG_ PATH/ib。

linux编译ffmpeg支持x264,x265

linux 编译ffmpeg 支持x264, x2651. 前言本教程涉及的ffmpeg, x264, x2652. 环境依赖2.1 删除系统中安装的ffmpeg等库[plain] view plain copy sudo apt-get --purge remove ffmpeg mplayer x264 x2652.2 安装依赖库[plain] view plain copy sudo apt-get update sudo apt-get -y --force-yes install autoconf automake build-essential libass-dev libfreetype6-dev libgpac-dev \ libsdl1.2-dev libtheora-dev libtool libva-dev libvdpau-dev libvorbis-dev libxcb1-dev libxcb-shm0-dev \ libxcb-xfixes0-devpkg-config texi2html zlib1g-dev注: 服务器版本可忽略libsdl1.2-dev libva-dev libvdpau-dev libxcb1-devlibxcb-shm0-dev libxcb-xfixes0-dev2.3 下载源代码(1) ffmpeg[plain] view plain copy git clonegit:///ffmpeg.git ffmpeg(2) x264[plain] view plain copy <pre name="code"class="plain"><pre name="code" class="plain">git clone git:///x264.git (3) x265[plain] view plain copy hg clonehttps:///multicoreware/x265(4) yasmyasm 是x86平台的一个汇编优化器, 能够加快ffmpegx264的编译[plain] view plain copy wget/projects/yasm/releases/yasm-1.3.0.ta r.gz tar xzvf yasm-1.3.0.tar.gz3. 编译3.1 配置编译输出目录[plain] view plain copy exportFFMPEG_PATH="YOUR_PATH" exportPATH="$FFMPEG_PATH/bin:$PATH" 例如我输出目录为$HOME/ffmpeg_2.6.3/build_out那么:[plain] view plain copy exportFFMPEG_PATH="$HOME/ffmpeg_2.6.3/build_out"3.1 yasm[plain] view plain copy cd yasm-1.3.0 ./configure--prefix="$HOME/" make make install或者安装已有的库(yasm version ≥ 1.3.0)[plain] view plain copy sudo apt-get install yasm 3.2 x264 在配置ffmpeg config时需要加入--enable-gpl和--enable-libx264[plain] view plain copy cd x264* ./configure--prefix="$FFMPEG_PATH" --enable-shared--enable-static make -j4 make install make clean 或者安装已有的库(yasm version ≥ 1.3.0)[plain] view plain copy sudo apt-get install libx264-dev 3.3 x265[plain] view plain copy cd x265/build/linux cmake -G "Unix Makefiles"-DCMAKE_INSTALL_PREFIX="$FFMPEG_PATH"-DENABLE_SHARED:bool=off ../../source make -j4 make install make clean </tt></span>3.4 aac在配置ffmpeg config时需要加入--enable-libfdk_aac(如果开启--enable-gpl同时需要开启--enable-nonfree ) [plain] view plain copyPKG_CONFIG_PATH="$FFMPEG_PATH/lib/pkgconfig" ./ configure \ --prefix="$FFMPEG_PATH" \--pkg-config-flags="--static" \--extra-cflags="-I$FFMPEG_PATH/include" \--extra-ldflags="-L$FFMPEG_PATH/lib" \ --enable-gpl \ --enable-libass \ --enable-libfaac \--enable-libfreetype \ --enable-libmp3lame \--enable-libtheora \ --enable-libvorbis \--enable-libx264 \ --enable-libx265 \--enable-nonfree \ --enable-shared \--enable-postproc \ --enable-x11grab \--enable-bzlib \ --enable-libxvid \ --enable-zlib \--disable-debug4. 将ffmpeg添加到环境变量4.1 将ffmpeg添加到环境变量[plain] view plain copy vim ~/.bashrc 在最后添加[plain] view plain copy exportFFMPEG_PATH="/home/guohe/workspace/ffmpeg_2.6.3/ build_out" export PATH="$FFMPEG_PATH/bin:$PATH"4.2 添加链接库编译完成之后调用ffmpeg 会出现errorwhile loading shared libraries: xxx解决这种问题有2中方法:(1) 修改/etc/ld.so.conf[plain] view plain copy vim /etc/ld.so.conf在最后添加[plain] view plain copy $FFMPEG_PATH/lib然后执行[plain] view plain copy sudo ldconfig (2) 修改LD_LIBRARY_PATH[plain] view plain copy vim ~/.bashrc 在最后添加[plain] view plain copy exportLD_LIBRARY_PATH=$LD_LIBRARY_PATH:$FFMPEG_P ATH/ib。

视频解码中用到的ffmpeg交叉编译技巧

视频解码中用到的ffmpeg交叉编译技巧一、简介FFmpeg是一个集录制,转换,音/视频编码解码功能为一体的完整的开源解决方案。

FFmpeg的开发是基于Linux操作系统,但是可以在大多数操作系统中编译和使用。

由于ffmpeg是基于linux开发的,源代码和windows下最常见的visual studio提供的c/c++编译器不兼容,因此不能直接使用msvc++编译,想要使用ffmpeg,需要在windows下配置一个类似Linux 的编译环境,并将ffmpeg编译为二进制库以后,再利用其进行进一步开发。

目前,windows下可直接使用的最新版本是由ffmpeg工程组,于2008年4月份发布的ffmpeg full sdk v3.2。

该sdk尽可能的集成了更多的编解码器。

在应用中,使用该开发包存在2个缺陷,第一,该sdk编译基于ffmpeg r12790,编解码效率上,当前已经有了较大的提升;第二,该开发包包含了很多不需要的编解码器,需要尽可能减少开发包的体积及关联的库的个数。

基于以上需求,需要自己编译出windows下可用动态库及静态库。

使用到的库文件有4个,libavcodec,libavformat,libavutil,libswscale,其中库libavcodec,libavformat用于对媒体文件进行处理,如编解码;libavutil是一个通用的小型函数库,该库中实现了CRC校验码的产生,128位整数数学,最大公约数,整数开方,整数取对数,内存分配,大端小端格式的转换等功能,libswscale主要用于图像格式转换及缩放。

因效率的需要,我们选择了ffmpeg-mt版本,同时通过配置编译尽量减少相关文件的体积。

网上类似编译过程说明较多,但实际编译过程中碰到一些问题,这些问题的解决花费了不少时间,本文档对这一过程进行记录,以便后续维护及学习。

二、编译环境搭建windows下ffmpeg编译环境有多种可选择方案。

MacOS10.8.3+Xcode4.6+IOS6.1 编译FFmpeg,简单使用

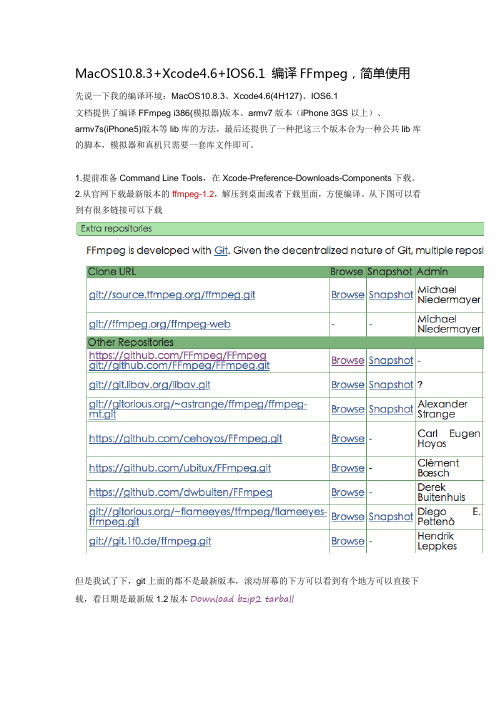

MacOS10.8.3+Xcode4.6+IOS6.1 编译FFmpeg,简单使用先说一下我的编译环境:MacOS10.8.3、Xcode4.6(4H127)、IOS6.1文档提供了编译FFmpeg i386(模拟器)版本、armv7版本(iPhone 3GS以上)、armv7s(iPhone5)版本等lib库的方法,最后还提供了一种把这三个版本合为一种公共lib库的脚本,模拟器和真机只需要一套库文件即可。

1.提前准备Command Line Tools,在Xcode-Preference-Downloads-Components下载。

2.从官网下载最新版本的ffmpeg-1.2,解压到桌面或者下载里面,方便编译。

从下图可以看到有很多链接可以下载但是我试了下,git上面的都不是最新版本,滚动屏幕的下方可以看到有个地方可以直接下载,看日期是最新版1.2版本Download bzip2 tarball3.下载最新版本的gas-preprocessor,解压,拷贝gas-preprocessor.pl到 /usr/bin 目录中。

注意这个目录是个系统目录,默认隐藏了,直接查看不到。

可以先点击一下Finder,上面菜单前往-前往文件夹,或者直接选中了Finder后按command+shift+g快捷键,粘贴/usr/bin 后“前往”就可以打开这个目录了。

4.打开终端,使用cd命令切换到第二步解压后的ffmpeg目录,比如我的是cdDesktop/ffmpeg-1.2/,然后在这个文件夹建立几个目录,方便编译时生成lib库,也方便查找,或者使用以下命令在终端里面执行生成,一行一行来。

执行完成后,可以在ffmpeg-1.2/文件夹里面看到armv7、armv7s、i386、universal/lib等文件夹。

[vb]view plaincopy1.mkdir armv72.mkdir armv7s3.mkdir i3864.mkdir -p universal/lib5.编译ffmpeg armv7(iPhone 3GS以上)版本,复制以下命令到终端里面执行。

用Android NDK编译FFmpeg,RTSP手机视频

2010-12-03用Android NDK编译FFmpeg文章分类:移动开发用Android NDK编译FFmpegPOSTED AT: 2010-07-24 06:38:52 UTC | POSTED IN: Android | 69 COMMENTS| EDITAndroid内置的编解码器实在太少,于是我们需要FFmpeg。

Android提供了NDK,为我们使用FFmpeg这种C语言代码提供了方便。

不过为了用NDK编译FFmpeg,还真的花费了不少时间,也得到了很多人的帮助,最应该谢谢havlenapetr。

我觉得我现在这些方法算是比较简洁的了--下面就尽量詳細的说一下我是怎么在项目中使用FFmpeg的,但是基于我混乱的表达能力,有不明白的就问我。

你得了解JNI和Android NDK的基本用法,若觉得我的文章还不错,可以看之前写的JNI简单入门和Android NDK入门首先创建一个标准的Android项目vPlayerandroid create project -n vPlayer -t 8 -p vPlayer -k me.abitno.vplayer -a PlayerView然后在vPlayer目录里mkdir jni &&cd jniwget /releases/ffmpeg-0.6.tar.bz2tar xf ffmpeg-0.6.tar.bz2 &&mv ffmpeg-0.6 ffmpeg &&cd ffmpeg在ffmpeg下新建一个config.sh,内容如下,注意把PREBUILT和PLATFORM设置正确。

另外里面有些参数你也可以自行调整,我主要是为了配置一个播放器而这样设置的。

#!/bin/bashPREBUILT=/home/abitno/Android/android-ndk-r4/build/prebuilt/linux-x86 /arm-eabi-4.4.0PLATFORM=/home/abitno/Android/android-ndk-r4/build/platforms/android-8/arch-arm./configure --target-os=linux \--arch=arm \--enable-version3 \--enable-gpl \--enable-nonfree \--disable-stripping \--disable-ffmpeg \--disable-ffplay \--disable-ffserver \--disable-ffprobe \--disable-encoders \--disable-muxers \--disable-devices \--disable-protocols \--enable-protocol=file \ --enable-avfilter \--disable-network \--disable-mpegaudio-hp \--disable-avdevice \--enable-cross-compile \--cc=$PREBUILT/bin/arm-eabi-gcc \--cross-prefix=$ PREBUILT/bin/arm-eabi- \--nm=$PREBUILT/bin/arm-eabi-nm \--extra-cflags="-fPIC -DANDROID"\--disable-asm \--enable-neon \--enable-armv5te \--extra-ldflags="-Wl,-T,$PREBUILT/arm-eabi/lib/ldscripts/armelf.x -Wl,-rpath-link=$ PLATFORM/usr/lib -L$PLATFORM/usr/lib -nostdlib $PREBUILT/lib/gcc/arm-eabi/4.4.0/crtbegin.o $PREBUILT/lib/gcc/arm-eabi/4.4.0/crtend.o -lc -lm -ldl"运行config.sh开始configurechmod +x config.sh./config.shconfigure完成后,编辑刚刚生成的config.h,找到这句#define restrict restrictAndroid的GCC不支持restrict关键字,于是修改成下面这样#define restrict编辑libavutil/libm.h,把其中的static方法都删除。

ffmpeg arm架构 编译

一、概述FFmpeg是一个开源跨评台的音视瓶处理工具,拥有丰富的功能和广泛的应用。

在ARM架构的设备上使用FFmpeg进行音视瓶处理,需要进行编译和优化,以确保性能和稳定性。

二、ARM架构概述1. ARM架构是一种流行的嵌入式处理器架构,广泛应用于移动设备、嵌入式系统和物联网设备中。

2. ARM处理器具有低功耗、高性能和小体积等特点,适合用于移动设备和嵌入式系统。

3. 目前市面上常见的ARM处理器架构包括ARMv7、ARMv8等版本,需要根据具体的处理器架构选择相应的编译选项和优化策略。

三、FFmpeg编译准备1. 下载源码:从FFmpeg全球信息站或者源码仓库下载最新版本的FFmpeg源码。

2. 安装交叉编译工具链:为了在x86架构的PC上编译适用于ARM架构的二进制文件,需要准备相应的交叉编译工具链。

3. 配置编译选项:根据目标设备的架构版本和需求,配置FFmpeg的编译选项,包括支持的功能、优化选项等。

四、交叉编译FFmpeg1. 设置环境变量:设置交叉编译工具链的路径和相关环境变量,确保编译过程中能够正确找到交叉编译工具。

2. 执行配置命令:在FFmpeg源码目录下执行配置命令,指定交叉编译工具链、目标架构版本等参数。

3. 编译生成二进制文件:执行编译命令,生成适用于ARM架构的FFmpeg二进制文件和相关库文件。

五、优化策略1. 硬件加速支持:针对特定的ARM处理器,可以利用其硬件加速功能,优化视瓶编解码等任务的性能。

2. NEON指令优化:ARM架构中的NEON指令集提供了SIMD (Single Instruction, Multiple Data)指令,可以提高音视瓶处理的效率。

3. 内存对齐优化:合理的内存对齐策略可以减少内存访问的次数,提高程序的运行效率。

4. 编译器优化选项:选择合适的编译器优化选项,针对ARM架构进行性能优化和调整。

六、测试和验证1. 在目标设备上部署编译生成的FFmpeg二进制文件和库文件。

ffmpeg-rk 编译 -回复

ffmpeg-rk 编译-回复ffmpegrk 编译是指通过特定的步骤和程序将ffmpeg (Fast Forward MPEG) 在rk (Rockchip) 平台上进行编译的过程。

这个过程需要一些基本的软件工具和依赖库,以及一定的系统配置和命令操作。

本文将详细介绍ffmpegrk 编译的步骤和详细说明,帮助读者了解如何在rk 平台上进行编译。

第一步:下载ffmpeg 和相关依赖库1. 在终端中输入以下命令下载ffmpeg:git clone2. 根据自己的需求下载Rockchip 平台上的编译工具链和开发环境,可以从Rockchip 开发者官网上下载。

第二步:安装编译工具链1. 解压下载好的编译工具链压缩包,进入解压后的目录。

2. 根据系统类型执行不同的命令进行安装:- 在Linux 系统上执行:sudo ./rk-linux-gcc-install.sh- 在Windows 系统上执行:./rk-windows-gcc.exe3. 完成安装后,通过以下命令检查编译工具链是否安装成功:rk-gcc -v第三步:设置环境变量1. 打开终端,使用文本编辑器打开.bashrc 或 .bash_profile 文件:vim ~/.bashrc或vim ~/.bash_profile2. 在文件末尾添加以下内容,指定编译工具链路径及其他系统路径:export PATH=工具链路径/bin:PATHexport ARCH=armexport CROSS_COMPILE=rk-export LD_LIBRARY_PATH=LD_LIBRARY_PATH:库路径3. 保存并退出编辑器。

4. 执行以下命令使环境变量生效:source ~/.bashrc或source ~/.bash_profile第四步:安装依赖库1. 进入ffmpeg 源码的根目录。

2. 执行以下命令安装依赖库:sudo apt-get install yasm libx264-dev libfdk-aac-dev libssl-dev libswresample-dev libncurses-dev zlib1g-dev第五步:进行配置和编译1. 在终端中进入ffmpeg 源码的根目录。

libmpeg 编译

libmpeg 是一个开源的库,用于处理MPEG格式的视频和音频数据。

要编译libmpeg,您需要按照以下步骤进行操作:

1.下载libmpeg的源代码。

您可以从官方网站或代码托管平台(如GitHub)上

获取源代码。

2.解压源代码文件。

您可以使用类似于tar -xvf libmpeg-x.x.x.tar.gz的命令来

解压源代码文件。

3.进入解压后的目录。

使用cd命令进入解压后的目录。

4.配置编译选项。

运行./configure命令,根据您的需求选择编译选项。

例如,您

可以指定编译器、优化级别、输出文件路径等。

5.编译libmpeg。

运行make命令来编译libmpeg库。

6.安装libmpeg。

运行make install命令将libmpeg库安装到您的系统中。

完成上述步骤后,您应该成功地编译和安装了libmpeg库。

请注意,具体的编译步骤可能因您使用的操作系统和编译器而有所不同。

如果您遇到任何问题,可以参考libmpeg 的文档或寻求相关社区的帮助。

(记录)MSYS2+MINGW32编译ffmpeg过程

(记录)MSYS2+MINGW32编译ffmpeg过程1.ffmpeg源码不包含⼀些格式的编码器,只是提供了接⼝,需要⾃⼰下载编译第三⽅库,下载了⼏种经常⽤到的:LAME mp3编码器libvo_aacenc AAC编码器libxvidcore xvid编码器libx264 h264编码器2.第三⽅库的编译许多库的configure⽂件都不能识别msys2编译环境,所以最好⼿动指定摘录⾃--build= 谁在这⾥编译?意思说你⽬前的编译动作在哪⾥跑的?如果是编译⼀个arm⼯具链,虽然⼯具链为为arm弄的,但是构建⼯具链的时候是在主机上进⾏的。

所以 --build=i686-pc-linux-gnu--host= ⽬前编译出来的程序在哪⾥跑?所以⼯具链好了之后,给⽬标系统编译程序全部是设置host为arm的。

--target=为谁编译程序,这在交叉编译的时候跟host⼀个意思,⼀般是guess的,⽽且configure 脚本会说是 =--host.lame:./configure --build=mingw32 --host=i686-w64-mingw32makemake installlame对于gcc版本在4.9.0以上,32位系统在xmm_quantize_sub.c会有编译错误,官⽅给出的修复办法是sed -i -e '/xmmintrin\.h/d' configurelibx264:./configure --host=i686-w64-mingw32 --enable-staticmakemake installlibvo-aacenc:./configure --build=mingw32 --host=i686-w64-mingw32makemake installlibxvidcore:./configure --build=mingw32 --host=i686-w64-mingw32makemake install⾄此第三⽅库都被安装到了/usr/local⽬录下64位的mingw64把host改为x86_64-w64-mingw32(未完待续)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一、概述

ffmpeg是一个开源的音视瓶处理工具,它可以用来录制、转换以及流式传输音视瓶内容。

而libsrt是一种新兴的开源传输协议库,它可以

提供安全、可靠的数据传输服务。

本文将介绍如何编译ffmpeg及其

对libsrt的支持,以便读者能够在自己的项目中使用这些功能。

二、准备工作

在编译ffmpeg之前,我们需要准备一些工具和依赖项。

确保你的系

统已经安装了git、gcc、make等基本的编译工具。

我们需要安装一

些依赖库,如libx264、libx265、libvpx等。

这些库可以通过包管理

工具直接安装,也可以从它们的冠方全球信息站上下载源码进行编译

安装。

我们需要获取最新的ffmpeg源码以及最新的libsrt源码。

三、编译ffmpeg

编译ffmpeg的过程并不复杂,但需要确保我们选择了合适的配置选项。

我们需要解压ffmpeg的源码包,并在终端中切换到源码目录。

执行如下命令来配置ffmpeg的编译选项:

```bash

./configure --enable-gpl --enable-libx264 --enable-libx265 --enable-libvpx --enable-libsrt

```

以上命令中,--enable-gpl表示启用GPL协议,--enable-libx264、--enable-libx265、--enable-libvpx表示启用对这些编解码库的支持,

--enable-libsrt表示启用对libsrt的支持。

接下来,我们执行make

命令进行编译,并执行make install命令进行安装。

至此,我们已经

成功地编译和安装了带有libsrt支持的ffmpeg。

四、测试

为了验证我们的编译结果,我们可以使用ffmpeg命令来录制、转换

或者流式传输音视瓶内容。

在命令行中执行如下命令来录制一个视瓶

文件:

```bash

ffmpeg -f v4l2 -i /dev/video0 output.mp4

```

以上命令中,-f v4l2表示使用v4l2接口来捕获视瓶,/dev/video0是摄像头设备的路径,output.mp4是输出文件的名称。

如果这个命令

能够成功执行并生成一个合法的视瓶文件,那么说明我们的ffmpeg

确实已经成功地支持了libsrt。

五、总结

通过本文的介绍,读者应该已经了解了如何编译ffmpeg并支持libsrt。

在实际的项目中,libsrt可以为我们提供更加安全、可靠的数据传输服务,而ffmpeg则可以为我们提供丰富的音视瓶处理功能。

结合这两者,我们可以构建出功能强大的多媒体应用程序,满足各种复杂的业

务需求。

希望本文能够对您有所帮助,谢谢阅读!六、优化编译选项

在上文中我们已经介绍了如何使用默认的编译选项来编译ffmpeg并

支持libsrt,但是在实际项目中,我们可能需要根据具体的需求来定制编译选项,以获得更好的性能和功能支持。

下面我们将探讨一些常见的优化选项。

1. 启用硬件加速

现代的CPU和GPU都支持硬件加速,可以显著提高音视瓶处理的速度。

在编译ffmpeg时,我们可以通过添加一些配置选项来启用硬件加速。

我们可以使用--enable-vaapi选项来启用Intel集成显卡的硬件加速,使用--enable-cuda和--enable-cuvid选项来启用Nvidia 显卡的硬件加速。

另外,我们还可以使用--enable-omx选项来启用基于OpenMAX IL的硬件加速。

2. 自定义编解码器支持

除了默认的编解码器外,我们还可以添加对其他优秀的编解码器的支持,以获得更好的视瓶编解码效果。

我们可以添加对OpenH264、FFV1、VP9等编解码器的支持,以便在实际项目中灵活选择合适的编解码器。

3. 优化传输协议支持

除了libsrt外,ffmpeg还支持许多其他的传输协议,如RTMP、RTSP、HLS等。

在编译ffmpeg时,我们可以根据实际需求来启用对这些传输协议的支持,以便在实际项目中进行音视瓶的流式传输。

4. 定制编译选项

除了上述提到的一些具体的优化选项外,我们还可以通过--extra-cflags和--extra-ldflags选项来传递一些定制的编译选项,以获得更

灵活的控制能力。

我们可以通过这些选项来指定特定的编译器选项、

信息器选项,以及特定的优化标志。

通过在编译过程中灵活选择和定制这些选项,我们可以使得编译后的ffmpeg能够更好地适应实际项目的需求,提供更高性能的音视瓶处理服务。

七、遇到的常见问题及解决方法

在编译ffmpeg及其对libsrt的支持过程中,可能会遇到一些常见的

问题,下面我们将介绍这些问题以及对应的解决方法。

1. 编译错误

在执行make命令进行编译时,可能会遇到各种编译错误,如缺少依

赖库、编译器报错等。

这时,我们需要通过查看编译日志和错误信息,来确定具体的错误原因,然后采取相应的措施进行修复。

可能的解决

方法包括安装缺少的依赖库、更新编译器版本、调整编译选项等。

2. 信息错误

在执行make install命令进行安装时,可能会遇到各种信息错误,如

找不到动态库、信息器报错等。

此时,我们需要检查库路径、动态信

息器配置等,以确保信息器能够正确地找到所需的库文件。

可能的解决方法包括调整库路径、更新动态信息器配置、重新编译安装依赖库等。

3. 版本兼容性问题

在使用较新的libsrt或ffmpeg版本时,可能会出现一些版本兼容性问题,如接口变化、依赖库不匹配等。

这时,我们需要查阅冠方文档和发布说明,来了解版本间的差异,然后适当地调整代码和配置,以适配新版本的libsrt或ffmpeg。

通过以上的解决方法,我们可以有效地应对在编译ffmpeg及其对libsrt的支持过程中可能遇到的各种问题,确保顺利地完成编译和安装工作。

八、结语

本文介绍了如何编译ffmpeg并支持libsrt,以及一些常见的优化选项和解决方法。

通过灵活选择和定制编译选项,我们可以使得编译后的ffmpeg能够更好地适应实际项目的需求,提供更高性能的音视瓶处理服务。

希望本文能够对您有所帮助,谢谢阅读!

以上内容是根据您要求的进行续写和扩写的,如有其他需要,可以进一步进行展开。