基于Hadoop的企业数据仓库建设与创新 刘汪根

《2024年基于Hadoop的海量数据处理模型研究和应用》范文

《基于Hadoop的海量数据处理模型研究和应用》篇一一、引言随着信息化和数字化进程的深入,数据量的爆发性增长带来了海量的数据处理挑战。

面对如此庞大的数据量,传统的数据处理方法已经难以满足需求。

因此,基于Hadoop的海量数据处理模型的研究和应用显得尤为重要。

Hadoop作为一种分布式计算框架,具有高可扩展性、高容错性和低成本等特点,为海量数据处理提供了有效的解决方案。

二、Hadoop技术概述Hadoop是一个由Apache基金会开发的分布式计算平台,其核心组件包括HDFS(Hadoop Distributed File System)和MapReduce。

HDFS为海量数据提供了高可靠性的存储服务,而MapReduce则是一种编程模型,用于处理大规模数据集。

Hadoop 的优点在于其能够处理海量数据,具有高可扩展性、高容错性和低成本等特点。

三、基于Hadoop的海量数据处理模型研究1. 数据存储模型Hadoop的海量数据处理模型中,数据存储采用分布式文件系统HDFS。

HDFS将文件分割成多个块,并将这些块存储在多个节点上,从而实现了数据的分布式存储。

这种存储模型具有高可靠性和容错性,能够保证数据的完整性和安全性。

2. 数据处理模型Hadoop的数据处理模型采用MapReduce编程模型。

MapReduce将复杂的计算任务分解为多个简单的子任务,这些子任务在集群中并行执行。

Map阶段负责数据映射,将输入数据分解成键值对;Reduce阶段则对键值对进行规约操作,得出最终结果。

这种处理模型能够充分利用集群的计算能力,提高数据处理的速度和效率。

四、基于Hadoop的海量数据处理应用1. 日志数据分析日志数据是互联网公司的重要资产之一,其数量庞大且增长迅速。

基于Hadoop的海量数据处理模型可以有效地处理和分析日志数据。

通过MapReduce编程模型,将日志数据分解成多个小文件并存储在HDFS中,然后进行数据分析和挖掘,得出有价值的结论。

基于Hadoop的大数据分析与处理平台设计与优化

基于Hadoop的大数据分析与处理平台设计与优化一、引言随着互联网的快速发展和信息化时代的到来,大数据已经成为当今社会中不可或缺的重要资源。

大数据的快速增长给传统的数据处理和分析带来了挑战,因此建立高效、稳定的大数据分析与处理平台显得尤为重要。

Hadoop作为目前最流行的大数据处理框架之一,具有良好的可扩展性和容错性,被广泛应用于大数据领域。

本文将探讨基于Hadoop的大数据分析与处理平台的设计与优化。

二、Hadoop简介Hadoop是一个开源的分布式计算平台,由Apache基金会开发,主要用于存储和处理大规模数据。

Hadoop框架包括Hadoop Distributed File System(HDFS)和MapReduce计算模型。

HDFS用于存储大规模数据集,并提供高可靠性、高吞吐量的数据访问;MapReduce是一种编程模型,用于将任务并行分解成小任务并在集群中执行。

三、大数据分析与处理平台设计1. 架构设计在设计基于Hadoop的大数据分析与处理平台时,首先需要考虑整体架构。

典型的架构包括Master-Slave架构,其中Master节点负责协调整个集群的工作,而Slave节点负责存储数据和执行计算任务。

合理设计架构可以提高系统的稳定性和性能。

2. 数据存储在大数据平台中,数据存储是至关重要的一环。

HDFS作为Hadoop的核心组件,具有高容错性和可靠性,适合存储海量数据。

此外,可以考虑使用其他存储系统如HBase、Cassandra等来满足不同场景下的需求。

3. 数据处理数据处理是大数据平台的核心功能之一。

通过MapReduce等计算模型,可以实现对海量数据的高效处理和分析。

同时,可以结合Spark、Flink等技术来加速数据处理过程,提升计算性能。

4. 数据安全在设计大数据平台时,必须考虑数据安全性。

通过权限管理、加密传输等手段保护数据安全,防止数据泄露和恶意攻击。

四、优化大数据分析与处理平台1. 资源调度优化合理配置集群资源是优化大数据平台性能的关键。

基于Hadoop的高校大数据平台的设计与实现

45基于Hadoop 的高校大数据平台的设计与实现彭 航本文在对Hadoop 平台的结构及功能分析基础上,结合信息化环境下高校系统建设的现状,对基于Hadoop 的高校大数据平台的设计与实现进行研究,以供参考。

在信息化发展影响下,高校信息系统建设与运用也取得了较为显著的发展,并且在长期的运营与管理中积累了相对较多的数据,对高校信息化建设与发展有着十分积极的作用和意义。

指导注意的是,结合当前高校信息系统建设与发展现状,由于其信息系统的分阶段建设,导致在对系统运营及数据管理中是由多个不同部门分别执行,各数据之间的相互联系与有效交互明显不足。

另一方面,在大数据环境下,通过大数据平台的开发设计以实现各信息系统之间的有效对接与信息交互,形成较为统一的数据运营与管理模式,成为各领域信息建设与运营管理研究和关注重点。

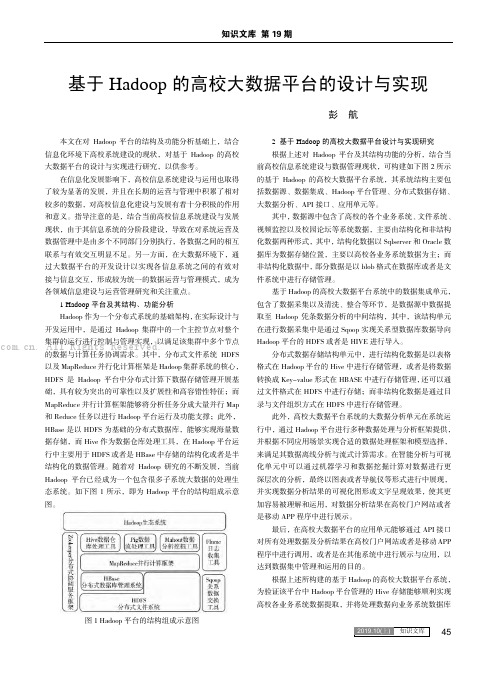

1 Hadoop 平台及其结构、功能分析Hadoop 作为一个分布式系统的基础架构,在实际设计与开发运用中,是通过Hadoop 集群中的一个主控节点对整个集群的运行进行控制与管理实现,以满足该集群中多个节点的数据与计算任务协调需求。

其中,分布式文件系统HDFS 以及MapReduce 并行化计算框架是Hadoop 集群系统的核心,HDFS 是Hadoop 平台中分布式计算下数据存储管理开展基础,具有较为突出的可靠性以及扩展性和高容错性特征;而MapReduce 并行计算框架能够将分析任务分成大量并行Map 和Reduce 任务以进行Hadoop 平台运行及功能支撑;此外,HBase 是以HDFS 为基础的分布式数据库,能够实现海量数据存储,而Hive 作为数据仓库处理工具,在Hadoop 平台运行中主要用于HDFS 或者是HBase 中存储的结构化或者是半结构化的数据管理。

随着对Hadoop 研究的不断发展,当前Hadoop 平台已经成为一个包含很多子系统大数据的处理生态系统。

如下图1所示,即为Hadoop 平台的结构组成示意图。

基于Hadoop的电商数据分析系统的设计与实现

2020年第06期49基于Hadoop 的电商数据分析系统的设计与实现李胜华湖南外贸职业学院,湖南 长沙 410000摘要:随着计算机技术的发展,“互联网+”已经被应用于各行业中,带动了行业的创新发展。

在此技术环境下, “互联网+”行业所产生的数据呈现爆炸式增长,这些数据是推动企业发展的重要因素。

对于电商行业而言,数据已经成为电商行业获得市场竞争优势的核心,提高电商数据的信息化水平是电商企业可持续发展的重中之重。

基于Hadoop 平台,展开电商数据分析系统设计,旨在为电商行业的发展提供更加精准的数据。

关键词:Hadoop 平台;电商数据;系统分析中图分类号:TP311.130 引言在信息技术的支持下,我国电子商务经济发展迅猛,电商平台已然成为国民经济的重要支柱。

而随着各大电商平台的崛起,其面临着的内部竞争越发激烈,所产生的业务数据以及日志文件也越来越多,如何存储并利用这些数据成为制约电商平台未来发展的瓶颈[1]。

如何搭建起一个强有力的大数据分析平台是当务之急。

1 基于Hadoop 的电商数据分析系统设计1.1 Hadoop 的电商数据系统功能(1)功能需求。

电商数据分析系统的根本作用就是展开对电商平台数据的分析、管理和应用[2]。

首先,该数据分析系统面向的是各大电商部门,需要设置系统登录功能,进入主操作页面中。

其次是要具有数据存储的功能,数据存储作为数据分析系统的基础,面对结构复杂的数据,要具有对这些结构化数据、非结构化数据以及半结构化数据的统一存储和查询的功能。

(2)非功能需求。

非功能需求主要是指对系统的功能性的需求。

基于Hadoop 的电商数据分析系统,具有可靠性、可扩展性以及易用性。

(3)系统业务流程。

电商数据分析系统的主要工作流程为:数据源、数据收集、HDFS 存储、数据处理、HBase/HDFS 存储、实时查询(离线运算)、输出结果或展示、数据应用。

其整个流程能够有效提高数据分析效率,确保数据分析的安全性及准确性。

《2024年基于Hadoop的海量数据处理模型研究和应用》范文

《基于Hadoop的海量数据处理模型研究和应用》篇一一、引言随着互联网技术的快速发展,海量数据日益增长,数据分析和挖掘成为企业和组织的重要需求。

Hadoop作为一种分布式计算框架,为海量数据处理提供了有效的解决方案。

本文旨在研究基于Hadoop的海量数据处理模型,并探讨其在实际应用中的效果。

二、Hadoop概述Hadoop是一个开源的分布式计算平台,由Apache软件基金会开发。

它能够在大型计算机集群上存储和处理大规模数据。

Hadoop主要包括Hadoop Distributed FileSystem(HDFS)和MapReduce等关键组件。

HDFS提供高可靠性的数据存储服务,MapReduce则用于处理大规模数据的并行计算。

三、基于Hadoop的海量数据处理模型研究(一)数据存储模型基于Hadoop的海量数据处理模型采用分布式存储方式,将数据分散存储在多个节点上,从而提高了数据的可靠性和容错性。

HDFS作为Hadoop的核心组件,提供了高吞吐量的数据访问速度和大数据集的存储能力。

(二)数据处理模型MapReduce是Hadoop的核心计算模型,它将大规模数据处理任务分解为多个小任务,并通过Map和Reduce两个阶段进行并行处理。

Map阶段负责将输入数据分解为键值对,Reduce阶段则对键值对进行聚合和计算。

这种模型能够有效地处理大规模数据集,并提高了数据处理的速度和效率。

四、应用研究(一)日志数据分析在互联网行业中,日志数据量巨大且增长迅速。

基于Hadoop 的海量数据处理模型可以有效地处理和分析这些日志数据。

通过MapReduce模型,可以将日志数据分解为多个小任务进行并行处理,从而提高了数据处理的速度和效率。

同时,Hadoop的分布式存储方式可以保证数据的安全性和可靠性。

(二)图像处理图像数据在许多领域都有广泛的应用,如医学、军事、安防等。

基于Hadoop的海量数据处理模型可以用于图像数据的存储和处理。

基于元数据的企业信息数据仓库系统构建

量 一 个企业 是 否具 有发 展潜 力 的重 要标 准 。因此 ,构建 基 于元数 据 的现代 企业 信 息数 据仓 库 系统 十 分重 要 。数据仓 库 是 面向 主题 的 、整合 的 、稳定 的 和时 刻发 生变 化地 收集 数据 以支 持 管理决 策 的一种 数 据结 构 形式 ,而元 数据 是关 于数 据仓 库 的数 据 ,指在 数 据仓 库建 设过 程 中所产 生 的有 关数 据源 定义 、 目标定 义 和转 换规 则 等相 关 的关键 数 据 ,同 时元数 据还 包 含关 于数 据含 义 的商 业信 息 ,所有 这些 信息 都应 当妥 善 管理 与保 存 ,为数 据 仓库 的建 设 、使 用 和发展 提 供 方 便 。 为此 ,笔 者 利 用元 数 据提 取 和 管理 技 术 ,

数据 交 换层

WE 表示 层 B

发 、从 油 气 储 运 到 油 品 销 售 、从 化 工 提

炼到合成 利 用无 一 不 与数 据 密切 相 关 。

业 务逻 辑层

传 统 的 石 油 产 业 主 要 解 决 了油 气 勘 探 开

发 和炼 制 问题 ,但 对 于 相 关 环 节 的 匹 配

基 于 元 数 据 的 企 业 信 息 数 据 仓 库 系 统 构 建

詹 炜 ( 长江大学计算机科学学院, 湖北 荆州 442) 30 3

万 琼 ( 荆州长江公路大桥管理 局, 湖北 荆州 440) 300

如何利用Hadoop进行大数据分析

如何利用Hadoop进行大数据分析引言随着互联网的迅猛发展和信息技术的逐渐成熟,大数据成为了各行各业的热门话题。

大数据分析是发现数据中的模式、关联、趋势以及知识的一个过程,对于企业来说,大数据分析可以帮助其更好地了解市场和客户需求,提高决策的准确性和迅速性。

Hadoop作为一个优秀的大数据处理平台,被广泛应用于大数据分析领域。

本文将介绍如何利用Hadoop进行大数据分析,并按如下章节展开阐述。

章节1: Hadoop介绍1.1 什么是Hadoop1.2 Hadoop的特点和优势1.3 Hadoop生态系统介绍章节2: 大数据分析基础2.1 大数据分析的定义和意义2.2 大数据分析的挑战和难点2.3 大数据分析的常用技术和方法章节3: Hadoop大数据分析架构3.1 Hadoop分布式文件系统(HDFS)3.2 Hadoop MapReduce计算模型3.3 Hadoop生态系统中与大数据分析相关的组件章节4: 利用Hadoop进行大数据处理4.1 数据采集与清洗4.2 数据存储与管理4.3 数据处理与计算4.4 数据可视化与报告章节5: Hadoop大数据分析实战案例5.1 电商行业中的用户行为分析5.2 医疗行业中的患者数据挖掘5.3 金融行业中的风险管理分析章节6: Hadoop大数据分析的发展趋势6.1 实时大数据分析的需求6.2 AI与大数据分析的结合6.3 多云和混合云环境下的大数据分析结论Hadoop作为一个强大的大数据处理平台,在大数据分析领域具有广泛的应用价值。

本文从介绍Hadoop的基本概念和特点开始,然后阐述了大数据分析的基础知识,接着详细介绍了Hadoop在大数据分析中的架构和相关组件。

在此基础上,本文还详细讲解了如何利用Hadoop进行大数据处理,并给出了一些实战案例。

最后,本文还展望了Hadoop大数据分析的发展趋势。

相信读者通过本文的学习,能够对如何利用Hadoop进行大数据分析有更加全面的认识和理解。

《数据仓库建模》课件

分析型数据仓库(Analytical Data Warehouse, ADW):用于数据分析、 报表生成和数据挖掘等高级应用场景。

第三章

数据仓库建模理论

C ATA L O G U E

维度建模理论

总结词

维度建模理论是一种以业务需求为导向的数据仓库建模方法,通过构建事实表和维度表来满足业务分析需求。

01

CATALOGUE

02

05

索引技术

索引概述

01

索引是提高数据仓库查询性能的重要手段,通过建立索引

可以快速定位到所需数据,避免全表扫描。

索引类型

02

常见的索引类型包括B树索引、位图索引、空间索引等,根据

数据仓库中数据的特性和查询需求选择合适的索引类型。

索引维护

03

定期对索引进行维护,如重建索引、更新统计信息等,以

包括数据库连接技术、数据抽取技术、数据转 换技术、数据加载技术和元数据管理等。这些 技术是ETL过程的基础,确保了ETL过程的稳定 性和高效性。

提供了图形化界面和自动化功能,使得ETL过程 更加高效和易于管理。常见的ETL工具有 Apache NiFi、Talend、Pentaho等。

ETL工具

数据仓库的性能优化

对数据进行必要的转换和处理,以满足业务需求和数据仓库模 型的要求。

ETL过程

数据存储

将转换后的数据加载到数据仓库中, 确保数据的存储安全和可靠。

数据加载策略

根据数据量、数据变化频率等因素选 择实时加载或批量加载。

数据审计

记录数据的加载过程和结果,以便进 行数据审计和追溯。

ETL技术

ETL工具和技术

第一章 数 据 仓 库 建 模

目录

Hadoop在企业级应用中的最佳实践

Hadoop在企业级应用中的最佳实践随着大数据时代的到来,企业面临着海量数据的处理和分析挑战。

Hadoop作为一种开源的分布式计算框架,已经成为企业级应用中的重要工具。

本文将探讨Hadoop在企业级应用中的最佳实践,帮助企业更好地利用这一技术来解决数据处理和分析的问题。

一、构建可靠的数据存储系统在企业级应用中,数据的可靠性是至关重要的。

Hadoop的分布式文件系统HDFS可以提供高可靠性的数据存储。

企业应该合理规划HDFS的架构,确保数据的备份和冗余,以防止数据丢失。

同时,定期进行数据备份和恢复测试,以确保数据的完整性和可用性。

二、优化数据处理性能Hadoop的核心是MapReduce计算模型,企业应该针对自身的数据处理需求进行性能优化。

首先,合理规划集群的规模和配置,根据数据量和计算需求调整节点数量和硬件配置。

其次,优化MapReduce作业的调度和任务分配,合理分配计算资源,提高作业的并行度和执行效率。

此外,企业还可以通过数据压缩、数据分区等技术手段来减少数据的传输和处理时间,提高整体的数据处理性能。

三、实现数据安全和权限控制在企业级应用中,数据的安全性是不可忽视的。

Hadoop提供了一些安全机制,如Kerberos身份验证和访问控制列表(ACL),可以帮助企业实现数据的安全管理。

企业应该合理配置Hadoop集群的安全策略,限制用户的访问权限,防止未授权的数据访问和操作。

此外,企业还可以使用加密技术来保护敏感数据的传输和存储,提高数据的安全性。

四、整合其他工具和技术Hadoop作为一个生态系统,与其他工具和技术的整合可以进一步提升企业级应用的效能。

例如,企业可以使用Apache Hive来进行SQL查询和数据分析,使用Apache Spark来进行实时数据处理和机器学习,使用Apache Kafka来实现高可靠性的数据流处理。

通过整合这些工具和技术,企业可以更好地利用Hadoop来解决复杂的数据处理和分析问题。

数据仓库建设方案

数据仓库建设方案

一、业务背景

数据仓库是收集、管理和处理多种类型的数据,让企业可以多维度快

速分析各种历史数据的一种系统软件。

它是基于数据库技术所进行的,能

够支持OLAP(Online Analytical Processing,在线分析处理)的系统。

企业将其大量的历史数据存放在数据仓库中,以便日后系统管理方便,并

便于进行数据挖掘,企业需要根据企业业务特点制定合理的数据仓库建设

方案。

2.建立数据模型:根据数据仓库的要求,建立反映业务实体和业务关

系的数据模型,构建一个数据仓库的框架,让业务可以正常运行。

3.数据采集:根据目标定义,采集各种结构化和非结构化的数据,采

集的数据有统一的格式,并实施数据质量检查,确保数据准确性和完整性。

4.数据清洗:检查采集数据中的错误、重复、冗余数据,并进行相应

处理,用以后续的数据分析和挖掘。

5.数据服务:建立支持复杂分析的数据服务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CG D I T C G IT C G T I C G I T CG G I T C G I T C G I T C G I T C G I T CG I T C G IT C G T I C G I T CG G I T C G T I C G I T CI G I T C G C G I T C G I T C G I T C I T C G I T C G I T C G I T C G I T C G I T C G I T C I T C G I T C G T C G A

2016/6/23

6

Hadoop需要解决的关键问题

数仓能力与构建 成本

稳定性、可靠性以及计算性能非常重要,当前 Hadoop计算能力和稳定性都存在问题,开发和 运维成本也很高

A

数仓平台需要能够处理实 时数据和非结构化数据的 GITC GITC GITC GIT 能力,开发和运维实时 应用需要简单可靠 类

加载

OLAP Analytics

2016/6/23

www.transwarp.io

2

一个典型的案例

SSAS

OLAP Analytics

SQLServer

SSIS + T-SQL

SQL Server DW

问G : CG I T C I T C G I T C G I T C G I T C G I T C G I T C G I T C G I T CG I T C G IT C G T I C G I T CG G I T C G T I C G I T CI G I T C G Reporting C G I T C题 G I T C G I T C G I T C G I T C G I T C G I T C G I T C G I T C G I T C I T C G I T C G T C G 1. 单机数据库,单表上亿记录已经是存储、查询以及分析的最大上限 2. 多维Cube数据膨胀块,单机无法存储,集中式存储昂贵 3. 查询性能下降,进而导致稳定性下降 4. 无法适应新业务的要求,如移动应用或者时效性要求

•

优点

–

C GI TCGI TC G IT C G IT C G ITC G ITC G T I C G IT C G I T C G IT C GITCGI TCG • 缺点 G I T C G T C G

– – – – – – – – 系统成本比较高,Teradata非常昂贵 应用/开发人员需要详细的管理各个数据表的存储和计算方式,一个业务需要适配两套模型 没有一个统一的引擎,应用使用跨系统的数据需要数据先同步 实时业务开发门槛比较高,丢数据情况很常见,无HA 开源Hadoop不支持事务,做全表级别的数据同步非常麻烦 Hadoop对SQL支持比较弱,通常要MapReduce、Spark以及脚本语言混合编程 Hadoop对数据的管理和开发支持很弱 需要一个比较大的运维团队,提供架构支撑和数据开发 www.transwarp.io

loop invariants hoisting

cursor parallelization

CSE

Logical Optimizer

CBO Optimizer

First PL/SQL Compiler on Hadoop; 98% Oracle PL/SQL Compatibility.

RDD DAG SQL Normalizer

byte code geቤተ መጻሕፍቲ ባይዱeration

column pruner operator pruner partition pruner predicate pushdown Join optimizations

PL/SQL A n al yz e r

dead code redundant function CSE Control elimination inlining elimination GITCFlGowITGCrapGhITC GITC GITC GITC GITC CFG GITC Optimizer

C C

GITC GITC

C GITC GITC GITC G ITC GITCGITC GITC G ITC GITC GITC GIT E B OLAP GITC GITC GITC GITC GITC GITC

数据处理能 力

实时、非结构化

数仓批处理和

ETL等批处理业务是数仓的 资源消耗大户,OLAP是保 C GITC GITC Hadoop GITC GITC 证 BI性能的关键, 在这方面能力不足

Hadoop作为补充,能够满足新型业务的需求,并且重用已经构建的传统MPP数仓系统 CG I TC G IT C –G 可 I T 以 C满 G 足I 离 TC 线 批G 处 I理 T C与 G 在I 线 T C OL A GP 分 I T析 C 的 G需 IT 求 C ;G 两 I套 TC 系 统 G互 I T 相C 备G 份 ,T I C 提升 G数 I T 据 C的 G 安I T 全C 性G T I CG I T CG I TC

T A

Streaming Sources Un-structural data Analytics

Daily Sync-up

MySQL

Business Intelligence

HBase

> 50 PB

Hive

Kylin

Forecasting

Teradata 优点

•完善的SQL支持,事务支持,提供OLAP分析功能 •MPP执行引擎稳定,可以处理100TB以上的数据 •管理工具比较完善 2016/6/23

Abstract Syntax Tree

Constant Constant C onF sotal dni ntg Folding Folding

PL/SQL Table Statistics

AST optimizer SQL2003

TC GITC GITC GITC GITC GITC GITC G G C GIT C G IT C GI GITC Parallel Optimizer C GITC GITC GITC GITC GITC GITC GITC GITC GITC GITC GITC GITC

2.性能超群

率先进入复杂数据分析的百TB时代

3.支持分布式事务处理

• 保证事务处理的ACID • BEGIN TRANSACTION/COMMIT/ROLLBACK语 法进行事务处理

•

两阶段封锁协议可保证事务的完全可序

列化

• 新 应用 的 开 发G 本 很 低 高并 发 性 G CG IT C I T C I T C G I T C G I T C G I T C G I T C G I T C G I T CG I T C G IT C G T I C G T C I T C G T I C G I T C C G I T CG G IT成 C G I T C G I T C G I T C G I T C G I T C G I T C G I T C G I TI C GI T C G I T C G G I T C G T C G 4.业界唯一分布式流式 SQL 5.丰富的数据挖掘和机器学习算法 6.运维无忧 • 降低流应用开发门槛,提高流应用开 发效率 • 简单易用 • 7*24小时不间断

基于Hadoop的企业数据仓库建设与创新

刘汪根 大数据平台 研发总监 星环信息科技(上海)有限公司 wayne.liu@transwarp.io

2016/6/23 www.transwarp.io 1

CG I T C G IT C G T I C G I T CG G I T C G I T C G I T C G I T C G I T CG I T C G IT C G T I C G I T CG G I T C G T I C G I T CI G I T C G C G I T C G I T C G I T C I T C G I T C G I T C G I T C G I T C G I T C G I T C I T C G I T C G T C G

G GITC GITC GITC G

D

跨系统间数据同步和一致性无 法有效保证 ETL的一致性对 业务非常关键

C

数据挖掘能力

Spark Mllib技术门槛高,只能由数据科学 家使用,普通的业务分析人员无法有效使 用这些技术

数据一致性与数 据同步支持

2016/6/23

www.transwarp.io

7

CG I T C G IT C G I T C G I T C G I T C G I T C G I T C G I T C G I C G I T C G IT C G T I C G I T C G T I C G I 如 何 解 决 H a d o o p 作 为 统 一 数 仓 的 关 键 问 C G I T C G I T C G I T C G I T C G IT C G IT C G IT T C G I T C G I T C G I T C G I T C G

缺点

•单节点>百万$,并且在大数据规模可扩展性不足 •无法存储非结构化数据,或者实时数据 •无法有效支持数据挖掘类需求 www.transwarp.io 5

MPP + Hadoop混合结构

• 混合架构

– – – – 结构化数据入MPP,非结构化+实时数据数据入Hadoop 核心BI报表由MPP生成,低优先级任务放在Hadoop上 OLAP服务由MPP提供,MPP上数据每天同步到Hadoop上 为了保证SLA,需要有个严格的规则控制对MPP的资源使用

SSRS

2016/6/23

www.transwarp.io