KUKA机器人定位抓取视觉设置说明

机器人视觉系统用户手册

机器人视觉系统用户手册第一章介绍1.1 欢迎使用机器人视觉系统欢迎使用我们的机器人视觉系统,本用户手册将会帮助您更好地了解和使用该系统。

机器人视觉系统是通过摄像头和相应的软件来实现对环境进行感知和理解的系统,它能够帮助机器人进行目标检测、导航、识别和交互等功能。

1.2 系统组成机器人视觉系统主要由以下几个部分组成:- 摄像头/相机:用于捕捉环境中的图像或视频数据。

- 图像处理单元:用于对捕捉到的图像数据进行处理和分析。

- 控制系统:通过控制算法和模型来使机器人根据视觉信息做出相应的动作。

1.3 适用范围机器人视觉系统适用于各类机器人应用场景,包括但不限于家庭服务机器人、工业机器人、无人驾驶车辆等。

第二章系统安装和设置2.1 系统安装在使用机器人视觉系统之前,您需要按照以下步骤进行安装:- 将摄像头/相机固定在机器人上合适的位置,并连接至图像处理单元。

- 安装相应的驱动程序和软件,确保系统硬件能够正常工作。

- 检查系统连通性,确保摄像头和处理单元能够正常通信。

2.2 参数设置在系统安装完成后,您可以根据实际需求对机器人视觉系统的参数进行设置,包括图像采集格式、分辨率、曝光时间、白平衡等。

系统的参数设置对于机器人视觉的效果以及实际应用效果具有重要影响,因此需要根据实际情况进行调整。

第三章系统使用指南3.1 图像捕捉机器人视觉系统通过摄像头捕捉环境中的图像数据,用户可以通过相应的接口或者程序来启动图像捕捉功能,并获取捕捉到的图像或视频数据。

3.2 目标检测与识别机器人视觉系统可以通过图像处理技术进行目标检测和识别。

用户可以通过系统提供的接口或者算法来实现对特定目标的检测和识别,从而为机器人的后续行为提供相应的信息。

3.3 环境感知和导航在机器人应用中,环境感知和导航是非常重要的功能。

机器人视觉系统可以通过对环境中的图像数据进行分析和处理,实现对环境的感知和理解,从而帮助机器人进行导航和路径规划。

3.4 异常识别和报警机器人视觉系统还可以通过图像识别技术来进行异常识别和报警,在发现异常情况时,系统可以通过相应的报警机制来通知相关人员或系统进行相应的处理。

机器人视觉系统用户手册

机器人视觉系统用户手册欢迎使用机器人视觉系统!机器人视觉系统是一种基于先进计算机视觉技术的智能系统,旨在实现机器人的实时感知和辨识能力。

本用户手册将为您介绍系统的关键特性和操作指南,以帮助您充分利用机器人视觉系统的潜力。

1. 系统概述机器人视觉系统基于深度学习和计算机图像处理算法,能够实现图像捕捉、图像处理和目标识别等功能。

通过结合摄像头和高性能处理器,系统能够准确地感知和理解周围环境,为机器人的导航、操作和与环境的互动提供重要支持。

2. 基本功能机器人视觉系统具备以下基本功能:- 实时图像捕捉:系统能够高效地捕捉环境中的图像信息,并进行处理和分析。

- 图像处理:系统能够对捕捉到的图像进行预处理,如去噪、增强和滤波等操作,以提高图像质量。

- 物体识别和跟踪:系统能够识别并跟踪环境中的目标物体,帮助机器人进行智能导航和操作。

- 姿态估计:系统能够实时估计目标物体的姿态,包括位置、朝向和大小等信息,为机器人的操作提供重要依据。

3. 使用指南以下是使用机器人视觉系统的操作指南:- 激活系统:确保系统已经正确连接摄像头和处理器,并按照说明书提供的方法激活系统。

- 环境调整:保持环境光线适宜,避免过于明亮或过于昏暗的情况,以确保图像质量。

- 目标识别:使用系统提供的目标识别功能,可以通过标定或训练的方式让机器人识别特定目标。

- 跟踪与导航:系统能够实时跟踪目标物体,并提供导航指引,使机器人能够精确运动和操作。

4. 系统优势机器人视觉系统的优势包括:- 高精度:系统基于先进的深度学习算法,能够实现准确的物体识别和目标跟踪。

- 实时性:通过高性能处理器和优化的图像处理算法,系统能够实时处理和分析图像信息。

- 灵活性:系统支持各种场景下的应用,可以根据具体需求进行定制和扩展。

- 易用性:系统提供简单直观的用户界面和操作指南,使用户能够轻松上手和操作。

机器人视觉系统是一项将现代计算机视觉技术应用于机器人操作的重要创新。

机器人视觉物体定位方法

机器⼈视觉物体定位⽅法机器⼈视觉物体定位⽅法本次设计的题⽬是机器⼈视觉物体定位。

伴随社会发展,机器⼈的利⽤越来越普及,出现了多种多样的智能机器⼈,由此也引发了对机器视觉的研究热潮。

⽂章⾸先介绍了机器视觉的发展历程,并详细说明了各阶段的特点。

接着概述了机器视觉技术的原理,深⼊剖析了主流视觉物体定位⽅法。

然后介绍了机器⼈视觉物体定位⽅法常⽤的⼏种应⽤。

最后介绍了⼏种新颖的视觉物体定位⽅法,并猜想机器⼈视觉物体定位技术未来发展⽅向。

关键词:机器视觉 SLAM技术单⽬视觉双⽬视觉多⽬视觉第⼀章:绪论1.1选题的背景及意义在我国持续爆发的2019新型冠状病毒(即2019-nCoV)事件中,⾃动化⾷品仓储配送系统服务包括机器⼈、⽆⼈驾驶、⽆⼈机等再次成为讨论的焦点。

配送机器⼈如何实现⾃动取货送货?⽆⼈驾驶汽车是怎么躲避⾏⼈?⽆⼈机巡航中怎么确定物体之间的距离?当我们谈到相关的话题时,机器视觉定位是⽆论如何也绕不开的问题。

⾃被誉为“机器⼈之⽗”的恩格尔伯格先⽣1959年发明第⼀台机器⼈以来,科学家⼀直把对机器⼈的研究作为研究的重点⽅向。

传统的机器⼈缺乏环境感知能⼒和⾃动应变能⼒,仅仅只能在严格的预定义的环境中完成⼀些预定义和指令下的动作,应⽤⾮常有限局限。

随着机器⼈逐渐⾛进⼈们的⽣产和⽣活中,⼈们也对机器⼈提出了更⾼的要求,希望实现在⽣产加⼯中对物体的⾃动加⼯、对⾃⾝运动轨迹实时的随动检测,节省对其运动轨迹的预先编程,提⾼⽣产效率。

要达到这些要求,必须同时满⾜图像信息的获取、采集、处理和输出,这就是本⽂的研究重点:机器⼈视觉物体定位⽅法。

机器⼈视觉物体定位系统的设计和研发是为了更好地为⼯业机器⼈服务,它的本质是发挥摄像机定位以及跟踪性功能,很多企业在⾃⾝⽣产环节依赖于机器⼈,⽣产效率明显得到改善。

然⽽很多的机器⼈是半⾃动的⼯作模式,只有在⼈⼯操控的指引下才能完成⼯作任务,这样的机器⼈实⽤性很差,⽆法彻底解放⼈⼯,实现⾃动化操作。

机器人视觉识别技术的说明书

机器人视觉识别技术的说明书一、概述机器人视觉识别技术是一种利用数字图像处理技术对图像进行分析和识别的技术。

该技术可以用于机器人机械臂的自动抓取、人脸识别、智能安防、无人驾驶等领域。

本说明书旨在介绍机器人视觉识别技术的原理、应用和使用方法。

二、原理机器人视觉识别技术的基础是数字图像处理技术。

该技术通过对数字图像进行滤波、分割、特征提取、分类等处理,将图像转换为计算机可理解的数字信号,并通过算法进行分析和识别。

具体原理如下:1. 图像采集:使用摄像头或其他图像传感设备对待处理图像进行采集和传输。

2. 图像预处理:对图像进行滤波、去噪、增强等处理,以便于后续的特征提取。

3. 特征提取:通过图像处理技术,提取出图像的特征信息,例如颜色、纹理、形状等。

4. 特征匹配:将提取出的特征信息与已知模板进行匹配,根据匹配度进行分类和识别。

5. 目标跟踪:基于目标跟踪算法,实现对目标在图像中的轨迹、位置和大小的跟踪,做出适当的响应动作。

三、应用机器人视觉识别技术在工业生产、家庭服务、智能交通、医疗辅助等领域拥有广泛的应用前景。

1. 工业生产:例如在制造业中,利用机器人视觉识别技术可以检测和识别产品的质量和形状,自动进行组装和加工操作。

2. 家庭服务:例如利用机器人视觉识别技术可以实现智能家居和智能客服,在家庭服务和娱乐中起到辅助作用。

3. 智能交通:例如基于机器人视觉识别技术,可以实现智能交通信号灯、智能停车管理系统等。

4. 医疗辅助:例如利用机器人视觉识别技术可以辅助医生进行病人的诊断和治疗。

四、使用方法机器人视觉识别技术的使用方法如下:1. 软件配置:在计算机、嵌入式系统或者机器人控制系统中配置图像处理软件。

2. 算法选择:选择适合自己应用场景的视觉识别算法,例如神经网络、SIFT、SURF、HOG等。

3. 参数设置:设置算法的相关参数,例如处理图像的分辨率、滤波器类型和特征值阈值等。

4. 图像采集:使用相机或者图像传感器采集待处理图像。

常见机器人与视觉标定的几种办法

a是旋转标准的角度

Mdx=X1-X0,即旋转后Mark坐标与训练模板 的mark坐标

1.相机非线性校正

2.相机与机器人做9点标定 3.计算机器人的旋转中心 4.相机通过公式计算得出最终的输出结果

旋转中心标定说明

红色框为CCD FOV,黄色为工件

z

五星为Mark点

训练的标准位置

工件发生平移

y 工件发生平移和旋转

x Base Frame

所有 旋转中心方法用于

机器人与视觉配合场景

方法:计算工件实际发生的偏移量和旋转量,结合机器人的旋转中心进行二次补偿后,把补偿量 发送给机器人,然后机器人把补偿量补偿后进行抓取或放置即可;

下面介绍如何求解StDx和StDy

旋转中心标定—计算补偿

• StDx,StDy计算过程,首先Robot在拍照点旋转一定角度a(一定是Robot给出)

X0,Y0

X1,Y1

CDx= cos (a) * (Cx0-X0) - sin (a) * (Cy0-Y0) + X1 – Cx0 = (cos (a) -1) * (Cx0-X0) - sin (a) * (Cy0-Y0) + MDx = (cos (a) -1) * StDx- sin (a) * StDy+ MDx

CDy= cos (a) * (Cy0-Y0) + sin (a) * (Cx0-X0) + Y1 – Cy0

X’= cos (a) * (X0-Cx0) - sin (a) * (Y0-Cy0) + Cx0

(X0, Y0)

Y’= cos (a) * (Y0-Cy0) - sin (a) * (X0-Cx0) + Cy0

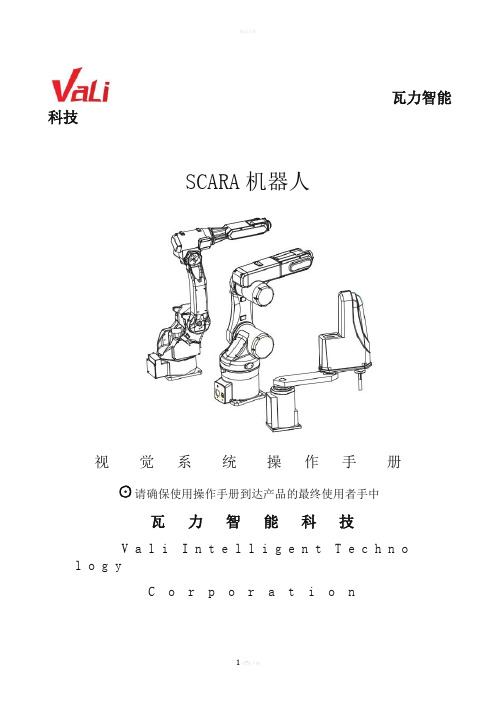

SCARA机器人视觉操作说明

瓦力智能科技SCARA机器人视觉系统操作手册☉请确保使用操作手册到达产品的最终使用者手中瓦力智能科技V a l i I n t e l l i g e n t T e c h n o l o g yC o r p o r a t i o n操作前,请注意安全。

确认人员与周边设备都在工作范围外。

内容若有错误,请以原厂操作说明书为准!步骤:1.设定视觉坐标及世界坐标的点位,要求点位十分精确,否则影响机器人运行的结果2.设定要抓取物件的模板3.视觉精度测试与校正4.编写程序5.运行程序步骤详细操作说明:1.设定视觉坐标及世界坐标的点位第一步:设定测试模板。

开启本软件,打开‘参数’->‘视觉’->‘模板设定’界面。

单击‘开始采集’,选择‘制作模板’中的‘定位模式’为圆形(以抓取目标为准)。

框选测试目标,然后单击鼠标右键。

单击‘设定模板’,稍等一段时间后,再选择‘模板形状’为矩形。

框选整个视频屏幕,单击鼠标右键。

如下图1,2所示图一:图二:第二步:获取视觉坐标的三点和世界坐标的三点然后标记保存。

测试模板设定好后,选择‘识别定位’中的‘测试’,让摄像头自动扫描目标。

扫描到目标后,单击‘停止测试’然后单击‘视觉工具’。

选取‘选取测量点’为‘测量点1’。

单击‘读入图像坐标’,选择‘视觉参数’。

用刚才的操作步骤,获取剩下的2个测量点的坐标值。

然后,将机械手移动到刚才视觉的扫描的一号点位上去,再打开‘参数’->‘视觉’->‘视觉标定’,选取‘选取测量点’为‘测量点1’。

单击‘读入世界坐标’。

在用这种方式,获取剩下的2个视觉的扫描点。

当3个视觉坐标和3个世界坐标都获取成功后,修改世界坐标的Z参数为120(以实际操作数为准,本数据只做参考)。

然后单击‘标定’,‘保存数据’。

如下图3所示图三:第三步:关闭该软件,再重新开启软件2.设定要抓取物件的模版打开‘参数’-> ‘视觉’-> ‘模板设定’界面。

机器人视觉抓取工作原理

机器人视觉抓取工作原理

机器人视觉抓取是指机器人利用视觉系统对目标进行识别和定位,然

后通过机械臂等装置进行抓取的过程。

其工作原理主要包括图像采集、图像处理、目标识别和机械臂控制等几个方面。

首先,机器人视觉抓取需要进行图像采集。

这一步骤通常使用摄像头

等设备对目标进行拍摄,获取目标的图像信息。

在采集图像时,需要

注意光照、角度、距离等因素的影响,以保证图像质量。

接下来,机器人需要对采集到的图像进行处理。

这一步骤主要包括图

像预处理、特征提取和目标分割等过程。

图像预处理可以对图像进行

去噪、增强等操作,以提高图像质量。

特征提取则是从图像中提取出

目标的特征,如颜色、形状等。

目标分割则是将目标从背景中分离出来,为后续的识别和定位做准备。

在目标识别方面,机器人需要根据特征信息对目标进行识别。

这一步

骤通常使用机器学习等技术进行,通过训练模型来实现目标的自动识别。

在识别过程中,机器人需要对目标进行分类,确定目标的种类和

属性。

最后,机器人需要通过机械臂等装置对目标进行抓取。

这一步骤需要

根据目标的位置和姿态信息来控制机械臂的运动,实现精确的抓取。

在抓取过程中,机器人需要考虑目标的重量、形状等因素,以保证抓取的成功率和安全性。

总的来说,机器人视觉抓取是一项复杂的技术,需要涉及多个方面的知识和技能。

随着人工智能和机器学习等技术的不断发展,机器人视觉抓取将会越来越普及和应用。

KUKA机器人工作空间监控配置

KUKA机器人工作空间监控配置KUKA机器人的工作空间可以直接在系统软件中进行配置。

最多可建立8个轴坐标工作空间或者8个笛卡尔工作空间。

用轴坐标工作空间可以进一步限定由软件限位开关所确定的区域,以保护机器人或工具和工件。

在笛卡尔工作空间中,仅TCP 的位置受到监控,无法监控机器人的其它部件是否超出工作空间。

一、工作空间模式①#OFF工作空间监控已关闭。

②#INSIDE笛卡尔工作空间:当TCP 或法兰位于工作空间内时,给定义的输出端赋值。

轴坐标工作空间:当轴位于工作空间内时,给定义的输出端赋值。

③#OUTSIDE笛卡尔工作空间:当TCP 或法兰位于工作空间外时,给定义的输出端赋值。

轴坐标工作空间:当轴位于工作空间外时,给定义的输出端赋值。

④#INSIDE_STOP笛卡尔工作空间:当TCP、法兰或腕点位于工作空间内时,设置定义的输出端。

(腕点= 轴A5 的中点)轴坐标工作空间:当轴位于工作空间内时,给定义的输出端赋值。

另外还停住机器人,并显示信息提示。

只有在关闭或桥接了工作空间监控之后,机器人才可重新运行。

⑤#OUTSIDE_STOP笛卡尔工作空间:当TCP 或法兰位于工作空间外时,给定义的输出端赋值。

轴坐标工作空间:当轴位于工作空间外时,给定义的输出端赋值。

另外还停住机器人,并显示信息提示。

只有在关闭或桥接了工作空间监控之后,机器人才可重新运行。

二、配置笛卡尔工作空间①在【主菜单】下选择【配置】—【其它或工具)】—【工作空间监控】—【配置】。

打开笛卡尔工作空间窗口。

②输入值后按【保存】键保存。

③按【信号】键,信号窗口打开。

④在笛卡尔组中:在工作空间编号处输入当超出工作空间时应赋值的输出端。

⑤按【保存】键保存。

⑥关闭窗口。

三、例:以P2为原点,P1相对于P2构成的空间。

X1、Y1、Z1则是到原点的距离。

机器人小知识机器人视觉零点标定操作

机器人小知识机器人视觉零点标定操作机器人的零点标定是需要将机器人的机械信息和位置信息同步,来定义机器人的物理位置,从而使机器人能够准确地按照原定位置移动。

通常在机器人出厂前已经进行了零点标定。

但是,机器人还是很有可能丢失零点数据,需要重新经行零点标定。

在如下情况,机器人必须进行零点标定:1:机器人执行一个初始化启动;2:SRAM的备份电池的电压下降导致mastering数据丢失;3:SPC(轴编码器)备份电池电压下降导致脉冲计数丢失;4:在关机的情况下卸下电池盒子;5:编码器电源线断开;6:更换编码器。

在零点丢失的情况下,如果对机器人轨迹精度要求不高的应用前提下,可以以点动的方式,示教机器人各轴到0度位置(每一个运动轴的连接处有两个标签,只要刻线重合就是此轴的0度)如下图示1。

图1 机器人机械零点刻度但是对于激光切割,弧焊等对机器人轨迹要求非常高的应用时,当机器人零点丢失后,就必须对机器人进行高精度零点标定功能。

首先点动示教机器人至各轴0度位置,然后在通过视觉的零点标定功能来进一步提供机器人零点精度。

视觉零点标定(Vision Mastering)功能,将相机安装在机器人的工具尖端(无需精度),在多个机器人姿势下,自动测量已被固定的同一测量目标,调整J2~J5轴的零点标定参数和J2~J6轴的弹性系数。

要执行视觉零点标定功能,需要有以下硬件:支持视觉用的机器人控制柜,附带镜头的相机(可参考如下图示2),连接到控制柜的相机电缆,测量目标(可参考如下图示3)(视觉用点阵板),同样需要有以下软件:iRVision 2D Pkg(R685),iRCalibration VMaster (J992)。

图2相机和镜头图3视觉用点阵板本文介绍的不考虑重力补偿有效时的视觉零点标定的步骤。

Vision Mastering的方框流程图如下:详细具体的安装要求如下:相机安装位置和点阵板之间的位置要求如图4所示,相机的光轴尽量保持与点阵板平面垂直,相机的位置和目标(点阵板)的位置要在400mm以上,相机与J6轴法兰的中心距离在100mm以上,为了确保在做Vision Mastering的过程中机器人的手腕和相机之间不产生干涉,尽量使得机器人处在如图示的参考位置,如图5所示。

基于视觉引导的工业机器人定位抓取系统设计

基于视觉引导的工业机器人定位抓取系统设计一、本文概述Overview of this article随着工业自动化技术的不断发展,工业机器人在生产线上的应用越来越广泛。

其中,定位抓取系统是工业机器人的重要组成部分,其准确性和稳定性直接影响到生产效率和产品质量。

本文旨在设计一种基于视觉引导的工业机器人定位抓取系统,以提高工业机器人的智能化水平和抓取精度。

With the continuous development of industrial automation technology, the application of industrial robots on production lines is becoming increasingly widespread. Among them, the positioning and grasping system is an important component of industrial robots, and its accuracy and stability directly affect production efficiency and product quality. This article aims to design a visual guided industrial robot positioning and grasping system to improve the intelligence level and grasping accuracy of industrial robots.本文首先介绍了工业机器人在现代工业生产中的应用及其重要性,并指出了定位抓取系统在设计中的关键性。

接着,阐述了基于视觉引导的定位抓取系统的基本原理和优势,包括通过摄像头捕捉目标物体的图像信息,利用图像处理算法提取目标物体的特征,并通过机器人控制系统实现精准定位与抓取。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

机器人定位抓取

---视觉部分设置手册

机器人定位抓取视觉部分设置步骤如下:

一、调整相机到适当的位置

1、将相机连接到PC;

2、打开In-Sight软件;

3、将相机添加到In-Sight网络;

若相机与PC机本地连接在相同的网段(IP地址的前三段

相同、最后一段不同,例如:PC机IP为192.168.3.11,

相机IP为192.168.3.9),则在In-Sight网络里可直接找到

相机,如下图所示:

若在In-Sight网络里找不到相机,则需要通过修改相机IP

地址的方式将相机添加进来,方法如下:

1)在In-Sight网络里右键单击“In-Sight传感器”,选择

“添加传感器/设备”

2)在出现的界面中左键单击左侧区域出现的相机,在右侧区域选择“使用下列网络设置”,将相机IP地

址前三段及子网掩码修改为与PC机一致(当IP地

址前三段或子网掩码与PC机不一致时,右侧会出

现红色叹号),

3)相机IP地址及子网掩码修改好之后,点击“应用”,会出现如下对话框

点击“确定”,出现

同时,In-Sight网络里会出现相机。

点击“确定”,然后关闭设置页面。

4、连接相机

双击In-Sight网络里出现的相机。

5、查看右下角相机状态

若右下角显示,则单击上面工具栏中的“联

机/脱机”图标,使相机处于脱机状态

6、点击工具栏中的“实时”图标,使相机处于实时状态

7、调整相机高度,使相机的视野范围(图像可见范围)满足

检测需求(下图中的视野范围为18.5*13.875)

8、固定相机高度

二、调整图像

1、将检测物放置在相机视野范围内;

2、调节镜头上的“光圈”,使图像亮度适中(此操作说明中

没有使用光源,所以只需要调节光圈;若使用光源,应先

将光源打开,然后同时调整光源亮度及镜头光圈,使图像

亮度适中);

3、调节镜头上的“焦距调节”,使需要检测的平面图像最清

晰,如下图

4、锁紧镜头上的螺丝,使“光圈”及“焦距调节”都不可变。

三、标定/校准

由于相机检测的结果均为像素值,而机器人需要的是实际数据(mm值),所以需要进行数据转换。

但是在转换之前需要提供转换标准,这就是需要做标定的原因。

标定步骤如下:

1、将标定板放置到与检测面相同的高度,如果有多种不同高

度的产品,需要进行多次标定。

2、将In-Sight软件切换到“电子表格”

3、在表格中添加标定工具,进行标定工作

在右侧“选择板”中选择“坐标变换”—“校准”—“ClibrateGrid(使用棋盘格校准)”

将工具拖到表格中某个空的单元格。

然后会出现以下界面

根据标定板及镜头的实际情况选择红色框内的设置。

此说明书中使用的是方格图案(带基准)、网格间距10mm的棋盘格标定板,平面检测(2D)姿势数选择1,镜头型号一般标准均为径向。

4、选择完成,点击左侧的“姿势”,

5、点击右侧的“实况视频”,根据机器人的原点及坐标轴方

向调整标定板的摆放位置及方向

6、在实时图像上单击,软件会自动查找特征点、进行标定。

如果右上角显示找到的特征点数大于30,点击下面的“校准”。

7、页面会自动切换到“结果”,

红色框内显示的是校准结果,如果结果为“优”或者“良

好”可直接点击“确定”,完成标定工作;如果结果为“合

格”,在检测精度要求不是很高的情况下,也可以点击“确

定”,完成标定工作;如果结果为“差”,则需要调整光源

镜头等,重新进行标定工作。

四、将校准结果与图像关联

在右侧“选择板”中选择“坐标变换”—“校准”—“ClibrateImage (将校准与图像关联)”

将工具拖到表格中某个空的单元格,会出现以下界面

双击“校准”,然后选择之前放置标定工具的单元格

,点击“确定”,即可将图像上所有的像素坐标转换为实际坐标(mm)。

五、模型设置

将标定板取走,相机设置为“实时”模式,将检测物放置到抓取标准位置(或将检测物放置到视野中心,机器人试教到这个位置进行抓取),在图像上单击,拍摄产品图片。

此位置作为抓取基准位置,之后相机发送给机器人的将是与此基准点的偏移量。

在“选择板”中选择“视觉工具”--“图案匹配”—“TrainPatmaxPattern(训练图案)”,将工具拖到电子表格中某个空的单元格

在出现的界面中进行图案训练

双击“图像”,选择之前转换后的图像(单元格E2),然后双击“图案区域”,根据产品形状设置图案区域,形状可调整。

形状设置完成,双击返回之前的页面;双击“图案原点”,将原

点拖动至机器人的抓取点(如果机器人有多个抓取点,则将原

点拖动至产品中心),双击返回;

点击“确定”,完成图案训练工作。

六、产品查找

七、在“选择板”中选择“视觉工具”--“图案匹配”—

“FindPatmaxPatterns(图案查找)”,将工具拖到电子表格中某个空的单元格

在弹出的页面中双击“图像”,选择之前转换后的图像(E2);

双击“查找区域”,将查找区域调整到包含产品可能出现的所有位置;双击“图案”,选择之前训练的图案(C5);根据每次可能出现的产品数量设置“查找数量”;根据不同产品的相似程度及检测要求设置“接受”阈值;将“显示”选择为“仅结果图形”。

点击“确定”,完成。

列、角度值)

然后,将检测得到的数据与手动记录的数据相减,即得到偏移

量(第一次设置时偏移量为0,0,0)。

八、将数据发送给PLC(PROFINET协议)

1、首先进行网络设置

点击工具栏中的“传感器”—“网络设置”,在“实时以

太网协议”中选择“PROFINET”,点击后面的“设置”,

修改相机的名称。

(由于此时没有连接其他外接网络设备,

所以以太网协议部分均为灰色的)

2、设置输出缓冲区

在“选择板”中选择“输入/输出”—“FormatOutputBuffer”,

将其拖至电子表格中某个空白的单元格。

在弹出的界面中点击“添加”,将3个偏移量加入输出缓冲区。

点击“确定”

3、设置输出

在“选择板”中,选择“输入/输出”—网络—

“WriteProfinetBuffer”,将其拖至电子表格中某个空白单

元格。

在弹出的页面中,双击“缓冲区”,选择设置好的输出缓冲区(D14),点击“确定”(由于没接PROFINET设备,所以在“确定”的旁边有红色叹号的报警,在电子表格中也会显示“ERR”)。

会显示输出缓冲区中的数据数量(输出缓冲区中添加了3

个数据,此处应该显示3)。

九、保存设置

将设置完成的检测程序保存到相机中。

步骤如下:

1、点击左上角工具栏中的“保存”

2、在弹出的页面中输入程序名

点击“保存”

十、相机运行

1、将相机触发模式设置为“网络”

双击A0单元格,在弹出的页面中将“触发器”选择为

点击“确定”

2、设置上电自动联机

点击工具栏中的“传感器”—“启动”,在弹出页面中勾选“联机”,将作业设置为之前保存的作业。

3、联机运行

点击工具栏中的“联机/脱机”图标,使相机处于联机状

态

此时,右下角应显示

,左边为程序运行时间

然后通过PROFINET提供触发信号,相机即可进行位置查找工作。

(由于没有连接PROFINET设备,验证时选择的是手动触发模式)

以下为几组测试结果图片及偏移量数据(X、Y、角度)。