Python机器学习

python机器学习之支持向量机非线性回归SVR模型

python机器学习之⽀持向量机⾮线性回归SVR模型本⽂介绍了python ⽀持向量机⾮线性回归SVR模型,废话不多说,具体如下:import numpy as npimport matplotlib.pyplot as pltfrom sklearn import datasets, linear_model,svmfrom sklearn.model_selection import train_test_splitdef load_data_regression():'''加载⽤于回归问题的数据集'''diabetes = datasets.load_diabetes() #使⽤ scikit-learn ⾃带的⼀个糖尿病病⼈的数据集# 拆分成训练集和测试集,测试集⼤⼩为原始数据集⼤⼩的 1/4return train_test_split(diabetes.data,diabetes.target,test_size=0.25,random_state=0)#⽀持向量机⾮线性回归SVR模型def test_SVR_linear(*data):X_train,X_test,y_train,y_test=dataregr=svm.SVR(kernel='linear')regr.fit(X_train,y_train)print('Coefficients:%s, intercept %s'%(regr.coef_,regr.intercept_))print('Score: %.2f' % regr.score(X_test, y_test))# ⽣成⽤于回归问题的数据集X_train,X_test,y_train,y_test=load_data_regression()# 调⽤ test_LinearSVRtest_SVR_linear(X_train,X_test,y_train,y_test)def test_SVR_poly(*data):'''测试多项式核的 SVR 的预测性能随 degree、gamma、coef0 的影响.'''X_train,X_test,y_train,y_test=datafig=plt.figure()### 测试 degree ####degrees=range(1,20)train_scores=[]test_scores=[]for degree in degrees:regr=svm.SVR(kernel='poly',degree=degree,coef0=1)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,3,1)ax.plot(degrees,train_scores,label="Training score ",marker='+' )ax.plot(degrees,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_poly_degree r=1")ax.set_xlabel("p")ax.set_ylabel("score")ax.set_ylim(-1,1.)ax.legend(loc="best",framealpha=0.5)### 测试 gamma,固定 degree为3, coef0 为 1 ####gammas=range(1,40)train_scores=[]test_scores=[]for gamma in gammas:regr=svm.SVR(kernel='poly',gamma=gamma,degree=3,coef0=1)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,3,2)ax.plot(gammas,train_scores,label="Training score ",marker='+' )ax.plot(gammas,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_poly_gamma r=1")ax.set_xlabel(r"$\gamma$")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)### 测试 r,固定 gamma 为 20,degree为 3 ######rs=range(0,20)train_scores=[]test_scores=[]for r in rs:regr=svm.SVR(kernel='poly',gamma=20,degree=3,coef0=r)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,3,3)ax.plot(rs,train_scores,label="Training score ",marker='+' )ax.plot(rs,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_poly_r gamma=20 degree=3")ax.set_xlabel(r"r")ax.set_ylabel("score")ax.set_ylim(-1,1.)ax.legend(loc="best",framealpha=0.5)plt.show()# 调⽤ test_SVR_polytest_SVR_poly(X_train,X_test,y_train,y_test)def test_SVR_rbf(*data):'''测试⾼斯核的 SVR 的预测性能随 gamma 参数的影响'''X_train,X_test,y_train,y_test=datagammas=range(1,20)train_scores=[]test_scores=[]for gamma in gammas:regr=svm.SVR(kernel='rbf',gamma=gamma)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))fig=plt.figure()ax=fig.add_subplot(1,1,1)ax.plot(gammas,train_scores,label="Training score ",marker='+' ) ax.plot(gammas,test_scores,label= " Testing score ",marker='o' ) ax.set_title( "SVR_rbf")ax.set_xlabel(r"$\gamma$")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)plt.show()# 调⽤ test_SVR_rbftest_SVR_rbf(X_train,X_test,y_train,y_test)def test_SVR_sigmoid(*data):'''测试 sigmoid 核的 SVR 的预测性能随 gamma、coef0 的影响.'''X_train,X_test,y_train,y_test=datafig=plt.figure()### 测试 gammam,固定 coef0 为 0.01 ####gammas=np.logspace(-1,3)train_scores=[]test_scores=[]for gamma in gammas:regr=svm.SVR(kernel='sigmoid',gamma=gamma,coef0=0.01) regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,2,1)ax.plot(gammas,train_scores,label="Training score ",marker='+' ) ax.plot(gammas,test_scores,label= " Testing score ",marker='o' ) ax.set_title( "SVR_sigmoid_gamma r=0.01")ax.set_xscale("log")ax.set_xlabel(r"$\gamma$")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)### 测试 r ,固定 gamma 为 10 ######rs=np.linspace(0,5)train_scores=[]test_scores=[]for r in rs:regr=svm.SVR(kernel='sigmoid',coef0=r,gamma=10)regr.fit(X_train,y_train)train_scores.append(regr.score(X_train,y_train))test_scores.append(regr.score(X_test, y_test))ax=fig.add_subplot(1,2,2)ax.plot(rs,train_scores,label="Training score ",marker='+' )ax.plot(rs,test_scores,label= " Testing score ",marker='o' )ax.set_title( "SVR_sigmoid_r gamma=10")ax.set_xlabel(r"r")ax.set_ylabel("score")ax.set_ylim(-1,1)ax.legend(loc="best",framealpha=0.5)plt.show()# 调⽤ test_SVR_sigmoidtest_SVR_sigmoid(X_train,X_test,y_train,y_test)以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

python解释模型库Shap实现机器学习模型输出可视化

python解释模型库Shap实现机器学习模型输出可视化⽬录安装所需的库导⼊所需库创建模型创建可视化1、Bar Plot2、队列图3、热图4、瀑布图5、⼒图6、决策图解释⼀个机器学习模型是⼀个困难的任务,因为我们不知道这个模型在那个⿊匣⼦⾥是如何⼯作的。

解释是必需的,这样我们可以选择最佳的模型,同时也使其健壮。

我们开始吧…安装所需的库使⽤pip安装Shap开始。

下⾯给出的命令可以做到这⼀点。

pip install shap导⼊所需库在这⼀步中,我们将导⼊加载数据、创建模型和创建该模型的可视化所需的库。

df = pd.read_csv('/content/Diabetes.csv')features = ['Pregnancies', 'Glucose','BloodPressure','SkinThickness','Insulin','BMI','DiabetesPedigreeFunction','Age']Y = df['Outcome']X = df[features]X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size = 0.2, random_state = 1234)xgb_model = xgb.XGBRegressor(random_state=42)xgb_model.fit(X_train, Y_train)创建模型在这⼀步中,我们将创建机器学习模型。

在本⽂中,我将创建⼀个XGBoost模型,但是你可以选择任何模型。

我们将⽤于此模型的数据集是著名的糖尿病数据集,可从Kaggle下载。

df = pd.read_csv('/content/Diabetes.csv')features = ['Pregnancies', 'Glucose','BloodPressure','SkinThickness','Insulin','BMI','DiabetesPedigreeFunction','Age']Y = df['Outcome']X = df[features]X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size = 0.2, random_state = 1234)xgb_model = xgb.XGBRegressor(random_state=42)xgb_model.fit(X_train, Y_train)创建可视化现在我们将为shap创建解释程序,找出模型的shape值,并使⽤它们创建可视化效果。

机器学习:Python实现聚类算法(二)之AP算法

机器学习:Python实现聚类算法(⼆)之AP算法1.算法简介AP(Affinity Propagation)通常被翻译为近邻传播算法或者亲和⼒传播算法,是在2007年的Science杂志上提出的⼀种新的聚类算法。

AP 算法的基本思想是将全部数据点都当作潜在的聚类中⼼(称之为exemplar),然后数据点两两之间连线构成⼀个⽹络(相似度矩阵),再通过⽹络中各条边的消息(responsibility和availability)传递计算出各样本的聚类中⼼。

2.相关概念(假如有数据点i和数据点j)(图1)(图2)(图3)1)相似度:点j作为点i的聚类中⼼的能⼒,记为S(i,j)。

⼀般使⽤负的欧式距离,所以S(i,j)越⼤,表⽰两个点距离越近,相似度也就越⾼。

使⽤负的欧式距离,相似度是对称的,如果采⽤其他算法,相似度可能就不是对称的。

2)相似度矩阵:N个点之间两两计算相似度,这些相似度就组成了相似度矩阵。

如图1所⽰的黄⾊区域,就是⼀个5*5的相似度矩阵(N=5) 3) preference:指点i作为聚类中⼼的参考度(不能为0),取值为S对⾓线的值(图1红⾊标注部分),此值越⼤,最为聚类中⼼的可能性就越⼤。

但是对⾓线的值为0,所以需要重新设置对⾓线的值,既可以根据实际情况设置不同的值,也可以设置成同⼀值。

⼀般设置为S相似度值的中值。

(有的说设置成S的最⼩值产⽣的聚类最少,但是在下⾯的算法中设置成中值产⽣的聚类是最少的)4)Responsibility(吸引度):指点k适合作为数据点i的聚类中⼼的程度,记为r(i,k)。

如图2红⾊箭头所⽰,表⽰点i给点k发送信息,是⼀个点i 选点k的过程。

5)Availability(归属度):指点i选择点k作为其聚类中⼼的适合程度,记为a(i,k)。

如图3红⾊箭头所⽰,表⽰点k给点i发送信息,是⼀个点k 选diani的过程。

6)exemplar:指的是聚类中⼼。

7)r (i, k)加a (i, k)越⼤,则k点作为聚类中⼼的可能性就越⼤,并且i点⾪属于以k点为聚类中⼼的聚类的可能性也越⼤3.数学公式1)吸引度迭代公式:(公式⼀)说明1:R t+1(i,k)表⽰新的R(i,k),R t(i,k)表⽰旧的R(i,k),也许这样说更容易理解。

深入浅出Python机器学习

15.3.1 Kaggle算法大赛平台和OpenML平台 15.3.2在工业级场景中的应用 15.3.3对算法模型进行A/B测试

作者介绍

这是《深入浅出Python机器学习》的读书笔记模板,暂无该书作者的介绍。

精彩摘录

这是《深入浅出Python机器学习》的读书笔记模板,可以替换为自己的精彩内容摘录。

感谢观看

读书笔记

看过纸质书,单从初步理解和运用机器学习的角度来说还是比较好的,适合新手入门。

目录分析

1.1什么是机 1

器学习——从 一个小故事开 始

1.2机器学习 2

的一些应用场 景——蝙蝠公 司的业务单元

3 1.3机器学习

应该如何入 门——世上无 难事

4 1.4有监督学

习与无监督学 习

5 1.5机器学习

13.2.1使用n-Gram改善词袋模型 13.2.2使用tf-idf模型对文本数据进行处理 13.2.3删除文本中的停用词

14.1简单页面的爬 取

14.2稍微复杂一点 的爬取

14.3对文本数据进 行话题提取

14.4小结

14.1.1准备Requests库和User Agent 14.1.2确定一个目标网站并分析其结构 14.1.3进行爬取并保存为本地文件

7.3.1初步了解数据集 7.3.2使用SVR进行建模

8.1神经网络的前世 今生

8.2神经网络的原理 及使用

8.3神经网络实例— —手写识别

8.4小结

8.1.1神经网络的起源 8.1.2第一个感知器学习法则 8.1.3神经网络之父——杰弗瑞·欣顿

8.2.1神经网络的原理 8.2.2神经网络中的非线性矫正 8.2.3神经网络的参数设置

11.2使用网格搜索 优化模型参数

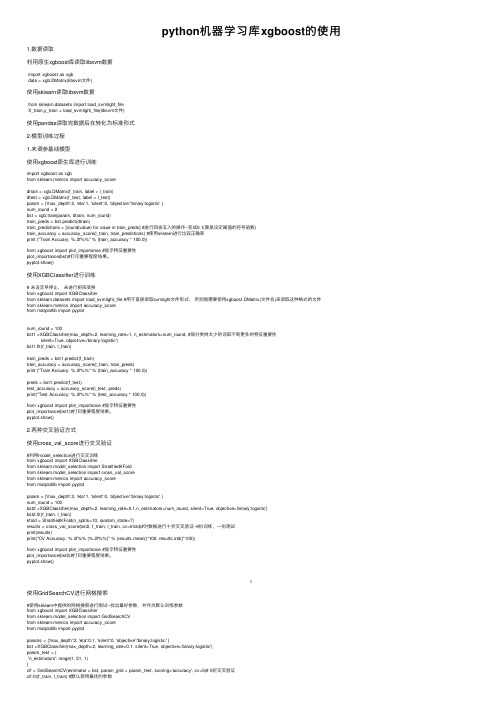

python机器学习库xgboost的使用

python机器学习库xgboost的使⽤1.数据读取利⽤原⽣xgboost库读取libsvm数据import xgboost as xgbdata = xgb.DMatrix(libsvm⽂件)使⽤sklearn读取libsvm数据from sklearn.datasets import load_svmlight_fileX_train,y_train = load_svmlight_file(libsvm⽂件)使⽤pandas读取完数据后在转化为标准形式2.模型训练过程1.未调参基线模型使⽤xgboost原⽣库进⾏训练import xgboost as xgbfrom sklearn.metrics import accuracy_scoredtrain = xgb.DMatrix(f_train, label = l_train)dtest = xgb.DMatrix(f_test, label = l_test)param = {'max_depth':2, 'eta':1, 'silent':0, 'objective':'binary:logistic' }num_round = 2bst = xgb.train(param, dtrain, num_round)train_preds = bst.predict(dtrain)train_predictions = [round(value) for value in train_preds] #进⾏四舍五⼊的操作--变成0.1(算是设定阈值的符号函数)train_accuracy = accuracy_score(l_train, train_predictions) #使⽤sklearn进⾏⽐较正确率print ("Train Accuary: %.2f%%" % (train_accuracy * 100.0))from xgboost import plot_importance #显⽰特征重要性plot_importance(bst)#打印重要程度结果。

利用Python实现深度学习网络

利用Python实现深度学习网络

深度学习是一种机器学习的技术,它结合了多层感知器,卷积神经网络和深度强化学习等技术来设计和构建复杂的机器学习系统。

使用Python进行深度学习可以利用Python的各种特性,如它的面向对象、多线程以及模块化编程,来帮助实现深度学习网络。

首先,要实现深度学习网络,必须先准备好数据集,这些数据集包括图像,视频,语音或文本文件。

之后,通过导入

Python模块,将数据集转换为上下文相关特征,以便进行机

器学习模型训练。

接着,使用Python开发框架,如Tensorflow,Keras等,来构

建深度学习网络的拓扑结构,该拓扑结构包括神经网络层、激活函数层、损失函数层和优化器层。

之后,就可以利用深度学习网络对模型进行训练,以提高模型准确性。

最后,可以使用Python中的可视化工具,如Matplotlib,来可

视化深度学习网络的训练结果,以帮助开发者更好地理解深度学习模型的内部工作原理。

此外,还可以使用相应的库,如Pillow或OpenCV,将训练结果可视化出来,从而获得最佳的

模型表达。

总的来说,Python的强大特性及丰富的库支持,使得它是实

现深度学习网络的最佳选择。

只要具备基础的Python编程知识,就可以利用它来创建出兼具准确性与可视性的深度学习网络。

机器学习之python---Python实现逻辑回归(LogisticRegression)

机器学习之python---Python实现逻辑回归(LogisticRegression)⼀. 逻辑回归在前⾯讲述的回归模型中,处理的因变量都是数值型区间变量,建⽴的模型描述是因变量的期望与⾃变量之间的线性关系。

⽐如常见的线性回归模型:⽽在采⽤回归模型分析实际问题中,所研究的变量往往不全是区间变量⽽是顺序变量或属性变量,⽐如⼆项分布问题。

通过分析年龄、性别、体质指数、平均⾎压、疾病指数等指标,判断⼀个⼈是否换糖尿病,Y=0表⽰未患病,Y=1表⽰患病,这⾥的响应变量是⼀个两点(0-1)分布变量,它就不能⽤h函数连续的值来预测因变量Y(只能取0或1)。

总之,线性回归模型通常是处理因变量是连续变量的问题,如果因变量是定性变量,线性回归模型就不再适⽤了,需采⽤逻辑回归模型解决。

逻辑回归(Logistic Regression)是⽤于处理因变量为分类变量的回归问题,常见的是⼆分类或⼆项分布问题,也可以处理多分类问题,它实际上是属于⼀种分类⽅法。

⼆分类问题的概率与⾃变量之间的关系图形往往是⼀个S型曲线,如图所⽰,采⽤的Sigmoid函数实现。

这⾥我们将该函数定义如下:函数的定义域为全体实数,值域在[0,1]之间,x轴在0点对应的结果为0.5。

当x取值⾜够⼤的时候,可以看成0或1两类问题,⼤于0.5可以认为是1类问题,反之是0类问题,⽽刚好是0.5,则可以划分⾄0类或1类。

对于0-1型变量,y=1的概率分布公式定义如下:y=0的概率分布公式定义如下:其离散型随机变量期望值公式如下:采⽤线性模型进⾏分析,其公式变换如下:⽽实际应⽤中,概率p与因变量往往是⾮线性的,为了解决该类问题,我们引⼊了logit变换,使得logit(p)与⾃变量之间存在线性相关的关系,逻辑回归模型定义如下:通过推导,概率p变换如下,这与Sigmoid函数相符,也体现了概率p与因变量之间的⾮线性关系。

以0.5为界限,预测p⼤于0.5时,我们判断此时y更可能为1,否则y为0。

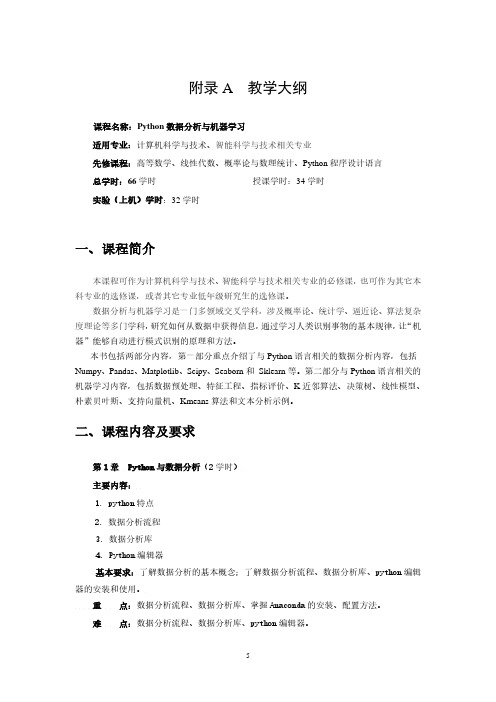

《Python数据分析与机器学习》课程教学大纲

附录A 教学大纲课程名称:Python数据分析与机器学习适用专业:计算机科学与技术、智能科学与技术相关专业先修课程:高等数学、线性代数、概率论与数理统计、Python程序设计语言总学时:66学时授课学时:34学时实验(上机)学时:32学时一、课程简介本课程可作为计算机科学与技术、智能科学与技术相关专业的必修课,也可作为其它本科专业的选修课,或者其它专业低年级研究生的选修课。

数据分析与机器学习是一门多领域交叉学科,涉及概率论、统计学、逼近论、算法复杂度理论等多门学科,研究如何从数据中获得信息,通过学习人类识别事物的基本规律,让“机器”能够自动进行模式识别的原理和方法。

本书包括两部分内容,第一部分重点介绍了与Python语言相关的数据分析内容,包括Numpy、Pandas、Matplotlib、Scipy、Seaborn和Sklearn等。

第二部分与Python语言相关的机器学习内容,包括数据预处理、特征工程、指标评价、K近邻算法、决策树、线性模型、朴素贝叶斯、支持向量机、Kmeans算法和文本分析示例。

二、课程内容及要求第1章 Python与数据分析(2学时)主要内容:1. python特点2. 数据分析流程3. 数据分析库4. Python编辑器基本要求:了解数据分析的基本概念;了解数据分析流程、数据分析库、python编辑器的安装和使用。

重点:数据分析流程、数据分析库、掌握Anaconda的安装、配置方法。

难点:数据分析流程、数据分析库、python编辑器。

第2章Numpy-数据分析基础工具(4学时)主要内容:1.ndarray对象2.创建ndarray对象3.数组变换4.索引和切片5.线性代数基本要求:掌握Numpy数值计算方法,主要包括数组和矩阵运算。

重点:掌握ndarray对象、创建数组变换、索引和切片、线性代数难点:掌握ndarray对象、创建数组变换、索引和切片、线性代数第3章Matplotlib-数据可视化工具(4学时)主要内容:1.绘图步骤2. 子图基本操作3.各类图4. 概率分布基本要求:掌握Matplotlib数据可视化绘图基础,参数设置及常用绘图。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Python机器学习

随着人工智能时代的到来,机器学习已成为业内热门话题。

Python作为一种优秀的编程语言,在机器学习领域也占有一席之地。

下面我将为大家介绍Python机器学习的一些基础知识和应用。

一、Python机器学习入门

1.1 什么是机器学习?

机器学习是一种通过数据来提高机器性能的方法。

从广义上来讲,凡是能够根据数据来提高性能的方法都可以称为机器学习。

在实际应用中,机器学习通常可以分为监督学习、无监督学习和强化学习三类。

1.2 Python机器学习的优势

Python语言在机器学习领域的优势主要体现在以下几个方面:

(1)Python语言简洁易学,入门门槛低。

(2)Python拥有众多的第三方库和工具,包括NumPy、SciPy、Pandas、Scikit-learn等。

(3)Python在数据可视化和交互式编程方面也具备优势,如Matplotlib和IPython等。

1.3 Python机器学习工具箱

Python机器学习工具箱包括NumPy、SciPy、Pandas、Scikit-learn、TensorFlow等。

(1)NumPy:用于数值计算的Python库,提供了强大的数组处理能力。

(2)SciPy:Python数学库,提供了各种数值优化、拟合和积分等算法。

(3)Pandas:基于NumPy数组的数据处理工具,提供了数据排序、分组、聚合等各种功能。

(4)Scikit-learn:Python机器学习库,提供了各种监督学习和无监督学习算法。

(5)TensorFlow:Google开发的机器学习框架,可用于各种深度学习任务。

二、Python机器学习算法介绍

2.1 监督学习

监督学习是指通过已有的标记好的样本数据来训练模型,并通过学习得到一个可以应用于未知数据的模型。

在实践中,监督学习算法主要可以分为以下三类:

(1)分类算法

分类算法是指将数据分为不同的类别。

在分类算法中,通常使用到的算法包括决策树、支持向量机、神经网络等。

(2)回归算法

回归算法是指预测一个连续变量的值。

在回归算法中,通常使用到的算法包括线性回归、多项式回归、岭回归等。

(3)时间序列算法

时间序列算法是指通过历史数据来预测未来的趋势。

在时间序列算法中,通常使用到的算法包括AR、MA、ARMA、ARIMA 等。

2.2 无监督学习

无监督学习是指通过对未标记的数据进行学习和训练,来获取数据的潜在结构、分布等信息。

在实践中,无监督学习算法主要可以分为以下三类:

(1)聚类算法

聚类算法是将数据分成不同的组。

在聚类算法中,通常使用到的算法包括K-means、层次聚类、谱聚类等。

(2)降维算法

降维算法是将高维数据降低到低维空间中。

在降维算法中,通常使用到的算法包括主成分分析(PCA)、因子分析等。

(3)关联算法

关联算法是指找出不同数据之间的相关性。

在关联算法中,通常使用到的算法包括Apriori算法、FP-growth算法等。

三、Python机器学习实战

3.1 Iris数据集分类

Iris数据集是机器学习中常用的数据集之一,包含了三类不同品种的鸢尾花,每类50个样本,共150个样本。

下面是使用Python和Scikit-learn对Iris数据集进行分类的代码:

```

#导入Iris数据集

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

#将数据集分为训练集和测试集

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3)

#使用SVM分类器

from sklearn.svm import SVC

clf = SVC(kernel='linear')

clf.fit(X_train, y_train)

#预测测试集

y_pred = clf.predict(X_test)

#计算准确率

from sklearn.metrics import accuracy_score accuracy = accuracy_score(y_test, y_pred)

print("Accuracy:", accuracy)

```

3.2 手写数字识别

手写数字识别是机器学习中常见的任务之一。

下面是使用Python和Scikit-learn对手写数字进行识别的代码:

```

#导入手写数字数据集

from sklearn.datasets import load_digits

digits = load_digits()

X = digits.data

y = digits.target

#将数据集分为训练集和测试集

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3) #使用SVM分类器

from sklearn.svm import SVC

clf = SVC(kernel='linear')

clf.fit(X_train, y_train)

#预测测试集

y_pred = clf.predict(X_test)

#计算准确率

from sklearn.metrics import accuracy_score

accuracy = accuracy_score(y_test, y_pred)

print("Accuracy:", accuracy)

```

以上就是本人对Python机器学习的一些简单介绍和应用实例。

希望对大家有所帮助。