《信息论》(电子科大)第六章 连续信源与连续信道PPT课件

合集下载

第6章 连续信源的熵、连续信道的平均互信息与信道容量

6.1 单符号连续信源的熵与微分熵

1、单符号连续信源

定义

信源发出的消息为单一符号,这些符号随机取值于 一个连续域

表示

连续型随机变量X

第6章 连续信源的熵、连续信道的平均互信息与信道容量

X x [a , b] dP(X x ) p( X x ) p( x ) dX

随机变量X的取值x为信源发出的消息

定义

对应于单符号连续信源和单符号连续信宿的信道

表示

信源——连续型随机变量X 信宿——连续型随机变量Y

第6章 连续信源的熵、连续信道的平均互信息与信道容量

X x [a , b] dP(X x ) p( X x ) p( x ) dX 随机变量X的取值x为信源发出的消息

Y y [c, d] 通常[c, d] [a , b] dP(Y y) p( Y y) p( y) dY 随机变量Y的取值y为信宿收到的消息

第6章 连续信源的熵、连续信道的平均互信息与信道容量

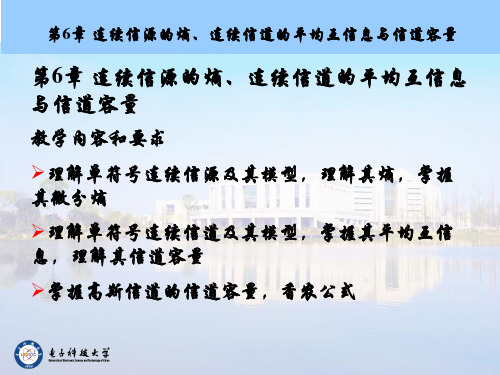

第6章 连续信源的熵、连续信道的平均互信息 与信道容量

教学内容和要求

理解单符号连续信源及其模型,理解其熵,掌握 其微分熵 理解单符号连续信道及其模型,掌握其平均互信 息,理解其信道容量 掌握高斯信道的信道容量,香农公式

第6章 连续信源的熵、连续信道的平均互信息与信道容量

微分熵不能作为信息度量,平均互信息——微分熵 差,具有信息度量的意义 信宿每收到一条消息所含信源一条消息的平均信息

第6章 连续信源的熵、连续信道的平均互信息与信道容量

I(X; Y) h(X) h(X / Y)

以信宿为参考,利用信宿的微分熵和信道的噪声 微分熵来度量信道中传输的平均信息 以信源为参考,利用信源的微分熵和信道的损失 微分熵来度量信道中传输的平均信息

信息论与编码课件910PPT

消息的形式可以是离散消息(如汉字、符号、字母) 或连续消息(如图像、语音)。

信源消息中的信息是一个时变的不可预知的函数,因 此,描述信源消息或对信源建模,随机过程是一个有效的 工具,随机过程的特性依赖于信源的特性。

离散信源和连续信源

信源的输出被抽象为一个随机变量序列(随机过程)

离散信源:如果信源输出的随机变量取值于某一离散符号集 合,消息在时间和幅值上均是离散的,就叫做离散信源。

pi

log

[

1] pi

自信息量的单位取决于对数选取的底。

单位:比特bit、奈特nat、笛特Det 。

当对数的底取2时,单位为比特bit

当以自然数e为底时,单位为奈特nat(理论推导常用)

当以10为底时,单位为笛特Det(工程计算常用)

表

对数及常用公式

y=log10x y=logbx

x=10y x=by

➢ 离散(数字)消息,一组未知量,可用随机序列来描述: X=(X1…Xi…Xn)

➢ 连续(模拟)消息,未知量,它可用随机过程来描述: X(t)

信息:它是更高层次哲学上的抽象,是信号与消 息的更高表达层次。

信息、消息和信号

❖ 信息、消息和信号是既有区别又有联系的三 个不同的概念。

消息中包含信息,是信息的载体。 信号携带着消息,它是消息的运载工具。

什么是信息?

就狭义而言,在通信中对信息的表达分为 三个层次:信号、消息、信息。 信号:是信息的物理表达层,是三个层次 中最具体的层次。它是一个物理量,是一 个载荷信息的实体,可测量、可描述、可 显示。

消息:(或称为符号)是信息的数学表达层,它虽 不是一个物理量,但是可以定量地加以描述,它 是具体物理信号的进一步数学抽象,可将具体物 理信号抽象为两大类型:

信源消息中的信息是一个时变的不可预知的函数,因 此,描述信源消息或对信源建模,随机过程是一个有效的 工具,随机过程的特性依赖于信源的特性。

离散信源和连续信源

信源的输出被抽象为一个随机变量序列(随机过程)

离散信源:如果信源输出的随机变量取值于某一离散符号集 合,消息在时间和幅值上均是离散的,就叫做离散信源。

pi

log

[

1] pi

自信息量的单位取决于对数选取的底。

单位:比特bit、奈特nat、笛特Det 。

当对数的底取2时,单位为比特bit

当以自然数e为底时,单位为奈特nat(理论推导常用)

当以10为底时,单位为笛特Det(工程计算常用)

表

对数及常用公式

y=log10x y=logbx

x=10y x=by

➢ 离散(数字)消息,一组未知量,可用随机序列来描述: X=(X1…Xi…Xn)

➢ 连续(模拟)消息,未知量,它可用随机过程来描述: X(t)

信息:它是更高层次哲学上的抽象,是信号与消 息的更高表达层次。

信息、消息和信号

❖ 信息、消息和信号是既有区别又有联系的三 个不同的概念。

消息中包含信息,是信息的载体。 信号携带着消息,它是消息的运载工具。

什么是信息?

就狭义而言,在通信中对信息的表达分为 三个层次:信号、消息、信息。 信号:是信息的物理表达层,是三个层次 中最具体的层次。它是一个物理量,是一 个载荷信息的实体,可测量、可描述、可 显示。

消息:(或称为符号)是信息的数学表达层,它虽 不是一个物理量,但是可以定量地加以描述,它 是具体物理信号的进一步数学抽象,可将具体物 理信号抽象为两大类型:

信息论基础课件35-6

7

当 输 入 随 机X变 是量 均 值 为 零 、方X2的 差高 为斯 随 机 变 量 。 噪 N是 声均 值 为 零 、方2高 差斯 为随 机 变 量

输出随机Y变也量 是一个高斯随,机其变均量值为零

方差为Y2 X2 2 PY,此时 h(Y)达到最大值。

C1 2lo2 g e(X 22)1 2lo2 g e2

log1P PN x log1(30)

14

3.20 设电话信号的信息率5.6104比特/秒,在一个噪声功率

谱为N0= 510-6 mW/Hz、限频F、限输入功率P的高斯信道中 传送,若F=4kHz,问无差错传输所需的最小功率P是多少瓦?

若F→∞,则P是多少瓦?

解:

Ct

Wlog1( PX ) PN

3.5 连续信道

连续信道:输入输出均为连续的信道。

单维连续通信系统:

X

Y

p(Y/X)

仿照离散信道,我们定义连续信道的信道容量C为 信源X等于某一概率密度函数p0(x)时,信道平均互 信息量的最大值,即

Cma{Ix(X;Y)}

p(x)

1

加性连续信道:

X

+

Y=X+N

加

性

信

道

N 所谓加性连续信 指道 噪, 声是 为连续随 N,机 且与 X相互统计独立的信道。 1. X、N统计独立

15

22

22

5

对于高斯加性信道

h (Y /X )h (N ) p (n )lo 2p g (n )dn

N

p(n)lo2g

N

1

[n2ቤተ መጻሕፍቲ ባይዱ]

e 22 dn

2 2

1l

2

《信息论方法》课件

信道容量:信道能够传输的最大信息量 编码定理:信道容量可以通过编码技术达到 信道编码:将信息转换为适合信道传输的信号 信道解码:将接收到的信号转换为原始信息

失真函数和信息率失真函数

单击此处添加标题

失真函数:描述信号失真的程度,通常用均方误差或方差表示

单击此处添加标题

信息率失真函数:描述信息传输过程中信号失真的程度,通常用信息熵或互 信息表示

解调:将接收到的射频信号还 原为信息信号

调制解调器:实现调制和解调 功能的设备

调制解调技术:如FSK、PSK、 QAM等,用于提高传输速率和 可靠性

光纤通信系统的编码与调制

光纤通信系统的基 本原理

光纤通信系统的编 码方式

光纤通信系统的调 制方式

光纤通信系统的传 输速率和距离

06

信息论在数据处理中的 应用

起源:1948年,美国数学家 克劳德·香农提出信息论

信息论:研究信息的传输、 存储、处理和利用的科学

发展:信息论在通信、计算 机科学、经济学等领域得到

广泛应用

意义:信息论为信息处理提 供了理论基础,推动了信息

时代的发展

信息论的基本概念

信息量:衡量信息不确定性 的度量

信息:指具有不确定性的事 件或消息

信号的统计特性和信息量

信号的统计特性:包括均值、 方差、自相关函数等

信息量的定义:信息量是信号 中包含的信息量的度量

信息量的计算:通过香农熵公 式计算

信息量的应用:在信号处理中, 信息量可以用来衡量信号的质 量和传输效率

信号的压缩编码和解码

编码方法:包括Huffman编 码、LZW编码、JPEG编码 等

预测编码:根据过去的数据 预测未来的数据

预测编码的应用:语音识别、 图像处理、数据压缩等

失真函数和信息率失真函数

单击此处添加标题

失真函数:描述信号失真的程度,通常用均方误差或方差表示

单击此处添加标题

信息率失真函数:描述信息传输过程中信号失真的程度,通常用信息熵或互 信息表示

解调:将接收到的射频信号还 原为信息信号

调制解调器:实现调制和解调 功能的设备

调制解调技术:如FSK、PSK、 QAM等,用于提高传输速率和 可靠性

光纤通信系统的编码与调制

光纤通信系统的基 本原理

光纤通信系统的编 码方式

光纤通信系统的调 制方式

光纤通信系统的传 输速率和距离

06

信息论在数据处理中的 应用

起源:1948年,美国数学家 克劳德·香农提出信息论

信息论:研究信息的传输、 存储、处理和利用的科学

发展:信息论在通信、计算 机科学、经济学等领域得到

广泛应用

意义:信息论为信息处理提 供了理论基础,推动了信息

时代的发展

信息论的基本概念

信息量:衡量信息不确定性 的度量

信息:指具有不确定性的事 件或消息

信号的统计特性和信息量

信号的统计特性:包括均值、 方差、自相关函数等

信息量的定义:信息量是信号 中包含的信息量的度量

信息量的计算:通过香农熵公 式计算

信息量的应用:在信号处理中, 信息量可以用来衡量信号的质 量和传输效率

信号的压缩编码和解码

编码方法:包括Huffman编 码、LZW编码、JPEG编码 等

预测编码:根据过去的数据 预测未来的数据

预测编码的应用:语音识别、 图像处理、数据压缩等

信息论课件第六章

根据这样一个信道矩阵,设计 一个译码规则A,即 F (b1 ) = a1 A : F (b2 ) = a2 F (b3 ) = a3

由于S个输出符号中的每一个都可以译成r个输入符号 r s 种译码规则可供选择。 中的任何一个,所以共有

译码规则的选择应该根据什么准则?一个很自然的 准则当然就是要使平均错误概率最小. 为了选择译码规则,首先必须计算平均错误概率. 在确定译码规则F(bj)=ai后,若信道输出端接收到的 符号为bj,则一定译成ai,如果发送端发送的就是ai,这 就为正确译码;如果发送的不是ai,就认为错误译码. 那么收到bj 条件下译码的条件正确译码概率为 P[F(bj)|bj]=P(ai|bj) 令P(e|bj)为条件错误译码概率,其中e表示除了F(bj)=ai 以外的所有输入符号的集合. 条件错误译码概率与条件正确译码概率之间有关系 (6.3) P(e|bj)=1-P(ai|bj)=1-P[F(bj)|bj]

一般P(b j ) ≠ 0, b j ∈ B, 这样,最大后验概率准则就可 表示为:选择译码函数 F (b j ) = a * a * ∈ A, b j ∈ B

使满足P(b j | a * ) P(a * ) ≥ P(b j | ai ) P(ai ) ai ∈ A, ai ≠ a * (6.7)

若输入符号的先验概率 P ( ai )均相等,则上式可以写 成 选择译码函数 F (b j ) = a * a * ∈ A, b j ∈ B ( 6 .8 a ) (6.8b) 并满足 P (b j | a * ) ≥ P (b j | ai ) ai ∈ A, ai ≠ a *

6.2 错误概率与编码方法

从(6.10)可知,消息通过有噪信道传输时会发生错 误,而错误概率与译码规则有关。 但一般当信道给定即信道矩阵给定,不论采用什 么译码规则,PE总不会等于或趋于0。 而要想进一步减少错误概率PE,必须优选信道编 码方法。

《信息论与编码》课件第6章 信道编码理论

X

信源编码

Y

差错控制 编码

Z

调制

信息错误

数据错 误一定

物理信道

条件:实

信宿

重建 符号

Xˆ

信源译码

Yˆ 差错控制 Zˆ

接收 信息

译码

接收 数据

解调

注

际信息传 输速率不 大于信道

容量,

意 1.信道一定,数据出现差错的概率一定,这是无

法改变的,与差错控制编码/译码方式无关

2.数据出现差错的概率不可改变,但是可以通过引 入差错控制编码/译码,降低信息传递中的错误

即如何选择 译码规则和 编码方法

减少信道传 输中的信息 差错

由于信道噪声或者干扰的存在, 会产生数据传输错误。

信道编码定理,也 称为香农第二定理

通信原理告诉我们,信噪声为例, 介绍虚警概率、漏报概率,以及 计算错误概率的过程和方法

原始

数

符号

信息

据

信源

(4) 纠正t个随机错误, ρ个删除,则要求码的最小距离满足 d0 ≥ ρ +2t+1

分组码的最小汉明距离满足下列关系

d0 n k 1

奇偶校验码是只有一个检验元的分组码 最小汉明距离为2,只能检测一个错误, 不能纠错。

是不等式, 不能用于计

算d0

差错 控制 译码 已知 条件

任务

6.3 译码规则

p( y)

p( y)

﹝ ❖ 考虑y的取值 两者之间比较

P(0 | y 0)

(1 pe ) p

p(1 pe ) (1 p) pe

P(1| y 0)

(1 p) pe

p(1 pe ) (1 p) pe

﹝ 两者之间比较

信源编码

Y

差错控制 编码

Z

调制

信息错误

数据错 误一定

物理信道

条件:实

信宿

重建 符号

Xˆ

信源译码

Yˆ 差错控制 Zˆ

接收 信息

译码

接收 数据

解调

注

际信息传 输速率不 大于信道

容量,

意 1.信道一定,数据出现差错的概率一定,这是无

法改变的,与差错控制编码/译码方式无关

2.数据出现差错的概率不可改变,但是可以通过引 入差错控制编码/译码,降低信息传递中的错误

即如何选择 译码规则和 编码方法

减少信道传 输中的信息 差错

由于信道噪声或者干扰的存在, 会产生数据传输错误。

信道编码定理,也 称为香农第二定理

通信原理告诉我们,信噪声为例, 介绍虚警概率、漏报概率,以及 计算错误概率的过程和方法

原始

数

符号

信息

据

信源

(4) 纠正t个随机错误, ρ个删除,则要求码的最小距离满足 d0 ≥ ρ +2t+1

分组码的最小汉明距离满足下列关系

d0 n k 1

奇偶校验码是只有一个检验元的分组码 最小汉明距离为2,只能检测一个错误, 不能纠错。

是不等式, 不能用于计

算d0

差错 控制 译码 已知 条件

任务

6.3 译码规则

p( y)

p( y)

﹝ ❖ 考虑y的取值 两者之间比较

P(0 | y 0)

(1 pe ) p

p(1 pe ) (1 p) pe

P(1| y 0)

(1 p) pe

p(1 pe ) (1 p) pe

﹝ 两者之间比较

信息论基础教学课件ppt信息论基础概述信息论基础概论

33

§1.2.1 通信系统模型

例如,奇偶纠错 将信源编码输出的每个码组的尾补一个1或0 当传输发生奇数差错,打乱了“1”数目的奇偶性,就 可以检测出错误。

34

§1.2.1 通信系统模型

(a) 无检错

(b) 可检错 (奇校验) (c) 可纠错(纠一个错)

图1.4 增加冗余符号增加可靠性示意图

35

§1.2.1 通信系统模型

信源的消息中所包含的信息量 以及信息如何量度

核心 问题

29

§1.2.1 通信系统模型

编码器(Encoder)

编码器的功能是将消息变成适合于信道传输的信号 编码器包括:

信源编码器(source encoder) 信道编码器(channel encoder) 调制器(modulator)

信源编码器

信道编码器

调制器

功能:将编码器的输出符号变成适合信道传输的信号 目的:提高传输效率 信道编码符号不能直接通过信道输出,要将编码器的输 出符号变成适合信道传输的信号,例如,0、1符号变成 两个电平,为远距离传输,还需载波调制,例如,ASK, FSK,PSK等。

36

§1.2.1 通信系统模型

信道(channel)

13

§1.1.2 信息的基本概念

1949年,Weaver在《通信的数学》中解释香农的工 作时,把通信问题分成三个层次: 第一层:通信符号如何精确传输?(技术问题) 第二层:传输的符号如何精确携带所需要的含义?(语义问题) 第三层:所接收的含义如何以所需要的方式有效地影响行为? (效用问题)

14

§1.1.2 信息的基本概念

§1.1.2 信息的基本概念

信息的三个基本层次:

语法(Syntactic)信息 语义(Semantic) 信息 语用(Pragmatic)信息

§1.2.1 通信系统模型

例如,奇偶纠错 将信源编码输出的每个码组的尾补一个1或0 当传输发生奇数差错,打乱了“1”数目的奇偶性,就 可以检测出错误。

34

§1.2.1 通信系统模型

(a) 无检错

(b) 可检错 (奇校验) (c) 可纠错(纠一个错)

图1.4 增加冗余符号增加可靠性示意图

35

§1.2.1 通信系统模型

信源的消息中所包含的信息量 以及信息如何量度

核心 问题

29

§1.2.1 通信系统模型

编码器(Encoder)

编码器的功能是将消息变成适合于信道传输的信号 编码器包括:

信源编码器(source encoder) 信道编码器(channel encoder) 调制器(modulator)

信源编码器

信道编码器

调制器

功能:将编码器的输出符号变成适合信道传输的信号 目的:提高传输效率 信道编码符号不能直接通过信道输出,要将编码器的输 出符号变成适合信道传输的信号,例如,0、1符号变成 两个电平,为远距离传输,还需载波调制,例如,ASK, FSK,PSK等。

36

§1.2.1 通信系统模型

信道(channel)

13

§1.1.2 信息的基本概念

1949年,Weaver在《通信的数学》中解释香农的工 作时,把通信问题分成三个层次: 第一层:通信符号如何精确传输?(技术问题) 第二层:传输的符号如何精确携带所需要的含义?(语义问题) 第三层:所接收的含义如何以所需要的方式有效地影响行为? (效用问题)

14

§1.1.2 信息的基本概念

§1.1.2 信息的基本概念

信息的三个基本层次:

语法(Syntactic)信息 语义(Semantic) 信息 语用(Pragmatic)信息

第6章_连续消息和连续信道

东南大学移动通信国家重点实验室

1

“信息论与编码”课件

第六章 连续消息和连续信道

东南大学移动通信国家重点实验室

2

“信息论与编码”课件

本章内容提要

连续消息的信息 连续消息在信道上的传输问题 香农信道容量公式 连续消息的识别和理想接收机 连续信源的数字处理及其编码

东南大学移动通信国家重点实验室

第二项,当x0时它趋于无限大,称为绝对熵,用 H(x0)表示: H ( x 0 ) p ( x ) lb x d x (6.7)

东南大学移动通信国家重点实验室

9

“信息论与编码”课件

6.1 连续消息的信息度量

6.1.1 基本思路

相对熵分析 由于H(x)=E[I(x)],连续消息每一样值只有对应的概率 密度,其所占概率为0,根据自信息量的定义,连续消 息每一样值的自信息量都是无限大,况且量化前样值 集合的幅度连续,有无限多幅度值。 但经量化后,样值集合的幅度值变为有限,样值与样 值之间的差异也就变为有限。 反映在信息特性上,就是相对熵,它仅与连续信源的 概率密度有关,不同概率密度的信源具有不同的相对 熵,因此它表征了信源间平均信息量的差异,故又称 之为“熵差”。

h ( x1 ) h ( x 2 ) lo g 1

2

东南大学移动通信国家重点实验室

17

“信息论与编码”课件

6.1 连续消息的信息度量

6.1.2 几种连续信源的相对熵

3. 指数分布 指数分布连续信源X的信源空间为

(0, ) X : X P : P (X ) : p(x)

当m = 0时,方差就是高斯连续信源X的p(x) p ( x ) d x 1 (6.14) 高斯分布连续信源的概率 密度函数的曲线描绘如图

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

电子科技大学

第6章 连续信源与连续信道

信源分为离散信源和连续信源,在讨论 了离散信源整体测度的基础上,本章讨 论的第一个问题是:

从连续信源的整体出发,它的信息量应 该如何度量?

信道也分为离散信道和连续信道,在讨 论了离散信道中流通信息量的整体测度 及能达到的最大值的基础上,本章讨论 的第二个问题是:

1、单变量连续信源的数学模型

P(XX)ap(xx) b

b

并满足 a p(x)dx1

式中,p(x)为随机变量的概率密度函数。

2、单变量连续信源的熵 假定概率密度函数p(x)如图所示

4

p(x)

p(xi )

b

a

n

电子科技大学

a

a+(i-1)△ x ia+i△ b x

随机变量落在第i个小区的概率为

a i

②熵差具有信息测度的意义。

7

同理,可以定义其它相对熵: 两个连续随机变量的联合熵

电子科技大学

Hc(X)Y p (x)yl b(x p)ydxdy R2

两个连续随机变量的条件熵

H c(X/Y ) p(xy)lb p (x/y)d xd y R 2

H c(Y/X )p (x)y lb(yp/x)dxdy R2 8

b

b

p(x)lb(xp )d xlim lb p(x)dx

a

n a

0

b

p(x)lb(px)dxlim lb

a

n

0

6

(2)连续信源的相对熵

电子科技大学

定义连续信源的相对熵

b

Hc(X)ap(x)lb(x p)dx

相对熵不能反映连续信源的平均不确定 度。 定义相对熵的目的:

①在形式上与离散信源熵统一;

P (a (i 1 ) X a i ) p (x )dx a (i 1 )

根据中值定理,有

ai

a(i1)p(x)dxp(xi)

5

(1)连续信源的绝对熵

电子科技大学

n

H(X)n l i 0m {i1p(xi)lb [p(xi)]}

n

n

n l i 0m i1p(xi) lb(xip )n l i 0m i1p(xi) lb

13

可直接由定义证明:

电子科技大学

Hc(X)Y p (x)ylb(xp)ydxdy

R2

p (x)lyb (x)p dxdp (y x)lyb (y/p x)dxd

R 2

R 2

p(x)lb(xp )d xp (x)lyb(yp /x)dxdy

R

R 2

H c(X )H c(Y /X )

14

③最大相对熵定理

H c (X ) 1 2 ln 2 e ( 2 ) 1 2 ln 2 e( ),P x

18

设p(x)是除高斯分布以外的任何概率密电子科技大学

度函数,且

p(x)dx1

x2p(x)dxP

H c(X )p(x)l

b(xp )dx

x2

22 e 22

p(x)lbp(x)

x2 dx

Hale Waihona Puke 22 e 2219

x2

x2 电子科技大学

e 22

p(x)lb

dx

p(x)l b

e 22

dx

2 2

2 2 p(x)

可利用不等式ln z≤z-1进行证明

设p(x)是定义域(a,b)上除均匀分布以外 的任何概率密度函数,且

b

a p(x)dx1

16

b

Hc(X)ap(x)lb(x p)dx

电子科技大学

bp(x)lb(x p)badx

a

ba

b

b

1

ap (x)lb (ba)d x ap (x)lb (ba)p (x)dx

2E [X (m )2](xm )2p (x )dx

H c(X ) p p((xx))llbb ((xp )1dx e(x2 m 2)2)dx

2 2

10

lb p e(x )(x2 m 2)2d x lb 2 2 p (x )d 电子科技大x 学

2 l b 2 e (xm )2p (x)d xlb22

1lbleb22 1lb (2 e 2)

2

2

(3)指数分布连续信源的相对熵

p(x)1em x ,0x m

11

其 中 m E , [X ]x(p x)dx 0

电子科技大学

H c(X )0p(x)lb(x p )dx

p(x)lb(1em x)dx

0

m

lb e p(x)xd xlbm p(x)dx

1

电子科技大学

第一部分

整体概述

THE FIRST PART OF THE OVERALL OVERVIEW, PLEASE SUMMARIZE THE CONTENT

2

电子科技大学

从整体的角度,如何度量在连续信道中 流通的信息量?该信息量能达到的最大 值是多少?

3

一、连续信源及其相对熵

电子科技大学

b

b

lb (b a ) p (x )d x lbp e (x )ln

1

dx

a

a (b a )p (x )

b

1

lb (ba)lbap e(x)([ba)p (x)1]dx

17

l( b ba )lb [be1d xbp (x)d]x电子科技大学

aba a lb(ba)

•平均功率受限条件下的最大熵定理 随机变量的平均功率被限定,则均值为 零、方差为该平均功率的高斯分布的连 续信源具有最大熵,即

电子科技大学

连续信源没有一般意义下的最大熵,只 有限制条件下的最大熵。

通常讨论三种限制条件下的最大熵:

•取值范围受限;

•平均功率受限;

•均值受限。

15

电子科技大学

•取值范围受限条件下的最大熵定理

随机变量取值被限定在一定范围内,则 在该有限定义域内均匀分布的连续信源 具有最大熵,即

H c (X ) l( b b a ), a x b

3、几种连续信源的相对熵

(1)均匀分布连续信源的相对熵

p(x) 1 ,axb ba

b

Hc(X)ap(x)lbp(x)dx

b1

1

a

lb dx ba ba

lb(ba)

电子科技大学 9

(2)高斯分布连续信源的相对熵

电子科技大学

p(x)

1

(xm)2

e 22 , x

2 2

其中 m E , [X ]x(p x)dx

0m

0

lbexp(x)dxlbm

m0

lbe lb m lb (em )

12

4、相对熵的性质及最大相对熵定理 电子科技大学 ①相对熵不具有非负性 例如,当b-a<1时,均匀分布连续信源的 相对熵 H c(X )lb (ba)0 ②相对熵的可加性 H c (X ) Y H c (X ) H c (Y /X ) H c (X ) Y H c (Y ) H c (X /Y )

第6章 连续信源与连续信道

信源分为离散信源和连续信源,在讨论 了离散信源整体测度的基础上,本章讨 论的第一个问题是:

从连续信源的整体出发,它的信息量应 该如何度量?

信道也分为离散信道和连续信道,在讨 论了离散信道中流通信息量的整体测度 及能达到的最大值的基础上,本章讨论 的第二个问题是:

1、单变量连续信源的数学模型

P(XX)ap(xx) b

b

并满足 a p(x)dx1

式中,p(x)为随机变量的概率密度函数。

2、单变量连续信源的熵 假定概率密度函数p(x)如图所示

4

p(x)

p(xi )

b

a

n

电子科技大学

a

a+(i-1)△ x ia+i△ b x

随机变量落在第i个小区的概率为

a i

②熵差具有信息测度的意义。

7

同理,可以定义其它相对熵: 两个连续随机变量的联合熵

电子科技大学

Hc(X)Y p (x)yl b(x p)ydxdy R2

两个连续随机变量的条件熵

H c(X/Y ) p(xy)lb p (x/y)d xd y R 2

H c(Y/X )p (x)y lb(yp/x)dxdy R2 8

b

b

p(x)lb(xp )d xlim lb p(x)dx

a

n a

0

b

p(x)lb(px)dxlim lb

a

n

0

6

(2)连续信源的相对熵

电子科技大学

定义连续信源的相对熵

b

Hc(X)ap(x)lb(x p)dx

相对熵不能反映连续信源的平均不确定 度。 定义相对熵的目的:

①在形式上与离散信源熵统一;

P (a (i 1 ) X a i ) p (x )dx a (i 1 )

根据中值定理,有

ai

a(i1)p(x)dxp(xi)

5

(1)连续信源的绝对熵

电子科技大学

n

H(X)n l i 0m {i1p(xi)lb [p(xi)]}

n

n

n l i 0m i1p(xi) lb(xip )n l i 0m i1p(xi) lb

13

可直接由定义证明:

电子科技大学

Hc(X)Y p (x)ylb(xp)ydxdy

R2

p (x)lyb (x)p dxdp (y x)lyb (y/p x)dxd

R 2

R 2

p(x)lb(xp )d xp (x)lyb(yp /x)dxdy

R

R 2

H c(X )H c(Y /X )

14

③最大相对熵定理

H c (X ) 1 2 ln 2 e ( 2 ) 1 2 ln 2 e( ),P x

18

设p(x)是除高斯分布以外的任何概率密电子科技大学

度函数,且

p(x)dx1

x2p(x)dxP

H c(X )p(x)l

b(xp )dx

x2

22 e 22

p(x)lbp(x)

x2 dx

Hale Waihona Puke 22 e 2219

x2

x2 电子科技大学

e 22

p(x)lb

dx

p(x)l b

e 22

dx

2 2

2 2 p(x)

可利用不等式ln z≤z-1进行证明

设p(x)是定义域(a,b)上除均匀分布以外 的任何概率密度函数,且

b

a p(x)dx1

16

b

Hc(X)ap(x)lb(x p)dx

电子科技大学

bp(x)lb(x p)badx

a

ba

b

b

1

ap (x)lb (ba)d x ap (x)lb (ba)p (x)dx

2E [X (m )2](xm )2p (x )dx

H c(X ) p p((xx))llbb ((xp )1dx e(x2 m 2)2)dx

2 2

10

lb p e(x )(x2 m 2)2d x lb 2 2 p (x )d 电子科技大x 学

2 l b 2 e (xm )2p (x)d xlb22

1lbleb22 1lb (2 e 2)

2

2

(3)指数分布连续信源的相对熵

p(x)1em x ,0x m

11

其 中 m E , [X ]x(p x)dx 0

电子科技大学

H c(X )0p(x)lb(x p )dx

p(x)lb(1em x)dx

0

m

lb e p(x)xd xlbm p(x)dx

1

电子科技大学

第一部分

整体概述

THE FIRST PART OF THE OVERALL OVERVIEW, PLEASE SUMMARIZE THE CONTENT

2

电子科技大学

从整体的角度,如何度量在连续信道中 流通的信息量?该信息量能达到的最大 值是多少?

3

一、连续信源及其相对熵

电子科技大学

b

b

lb (b a ) p (x )d x lbp e (x )ln

1

dx

a

a (b a )p (x )

b

1

lb (ba)lbap e(x)([ba)p (x)1]dx

17

l( b ba )lb [be1d xbp (x)d]x电子科技大学

aba a lb(ba)

•平均功率受限条件下的最大熵定理 随机变量的平均功率被限定,则均值为 零、方差为该平均功率的高斯分布的连 续信源具有最大熵,即

电子科技大学

连续信源没有一般意义下的最大熵,只 有限制条件下的最大熵。

通常讨论三种限制条件下的最大熵:

•取值范围受限;

•平均功率受限;

•均值受限。

15

电子科技大学

•取值范围受限条件下的最大熵定理

随机变量取值被限定在一定范围内,则 在该有限定义域内均匀分布的连续信源 具有最大熵,即

H c (X ) l( b b a ), a x b

3、几种连续信源的相对熵

(1)均匀分布连续信源的相对熵

p(x) 1 ,axb ba

b

Hc(X)ap(x)lbp(x)dx

b1

1

a

lb dx ba ba

lb(ba)

电子科技大学 9

(2)高斯分布连续信源的相对熵

电子科技大学

p(x)

1

(xm)2

e 22 , x

2 2

其中 m E , [X ]x(p x)dx

0m

0

lbexp(x)dxlbm

m0

lbe lb m lb (em )

12

4、相对熵的性质及最大相对熵定理 电子科技大学 ①相对熵不具有非负性 例如,当b-a<1时,均匀分布连续信源的 相对熵 H c(X )lb (ba)0 ②相对熵的可加性 H c (X ) Y H c (X ) H c (Y /X ) H c (X ) Y H c (Y ) H c (X /Y )