递推最小二乘法

递推最小二乘法原理

递推最小二乘法原理递推最小二乘法(Recursive Least Squares, 简称RLS)是一种经典的参数估计方法,广泛应用于信号处理、通信系统、自适应滤波等领域。

它通过不断迭代更新参数,逐步逼近最优解,具有快速收敛、适应性强的特点。

本文将从最小二乘法出发,介绍递推最小二乘法的原理及其应用。

最小二乘法(Least Squares)是一种常见的参数估计方法,用于寻找一组参数,使得模型预测值与观测值之间的误差平方和最小。

对于线性模型,最小二乘法可以通过求解正规方程或者利用矩阵运算的方式得到最优参数。

然而,在实际应用中,数据通常是逐步到来的,因此需要一种能够动态更新参数的方法,于是递推最小二乘法应运而生。

递推最小二乘法的基本原理是利用递推的方式不断更新参数,以逼近最优解。

在每一时刻,根据当前的观测数据和先前的参数估计,通过递推公式计算出新的参数估计值,从而实现参数的动态更新。

这样的方法不仅能够适应数据的动态变化,还能够实现快速的收敛,适用于实时系统和非平稳环境下的参数估计。

递推最小二乘法的核心思想是利用指数加权的方式对历史数据进行处理,赋予近期数据更大的权重,从而更好地适应数据的变化。

通过引入遗忘因子(Forgetting Factor),可以控制历史数据对参数估计的影响程度,使得算法更具灵活性和适应性。

同时,递推最小二乘法还可以结合正交分解等技术,进一步提高计算效率和数值稳定性。

在实际应用中,递推最小二乘法被广泛应用于自适应滤波、信道均衡、系统辨识等领域。

例如,在自适应滤波中,递推最小二乘法可以根据接收信号的实际情况,动态调整滤波器的参数,实现信号的实时去噪和增强。

在通信系统中,递推最小二乘法可以用于自适应调制解调器的设计,提高系统的抗干扰能力和适应性。

此外,递推最小二乘法还被广泛应用于雷达跟踪、无线定位等领域,发挥着重要作用。

总之,递推最小二乘法作为一种经典的参数估计方法,具有快速收敛、适应性强的特点,在信号处理、通信系统、自适应滤波等领域有着重要的应用。

递推最小二乘法_协方差矩阵_概述说明以及解释

递推最小二乘法协方差矩阵概述说明以及解释1. 引言1.1 概述在统计学和计量经济学中,递推最小二乘法(Recursive Least Squares,简称RLS)是一种常用的参数估计方法。

它通过不断更新样本数据进行参数的估计,并且可以适用于非静态数据场景。

协方差矩阵是统计分析中重要的概念,它描述了变量之间的线性关系强度和方向,并且在许多领域具有广泛应用。

1.2 文章结构本文首先介绍递推最小二乘法的定义和原理,在此基础上详细解释算法的步骤以及其应用领域。

接着,我们将引入协方差矩阵的概念并介绍其计算方法,同时探讨了它在实际问题中所起到的作用和应用场景。

最后,我们将对递推最小二乘法与协方差矩阵之间的关系进行解释,并通过实例分析来说明它们如何相互影响。

1.3 目的本文旨在全面介绍递推最小二乘法和协方差矩阵,并深入探讨它们之间的联系。

通过对这两个概念及其应用的理解,我们可以更好地理解参数估计方法和变量间关系的描述与分析。

此外,我们还将展望相关领域未来可能的研究方向,以促进学术和实践的进一步发展。

2. 递推最小二乘法2.1 定义和原理:递推最小二乘法是一种用于估计线性模型参数的方法。

它可以通过历史数据的不断更新来逐步拟合模型,以使得估计值与观测值之间的误差达到最小化。

该方法可以被形式化地描述为以下步骤:1. 初始化模型参数的初始值。

2. 从历史数据中选择一个样本,并使用当前参数估计出该样本对应的输出值。

3. 计算该样本的预测误差。

4. 根据预测误差对参数进行调整,使得预测误差尽量减小。

5. 重复步骤2至4,直到所有样本都被处理过一遍,或者满足终止条件。

递推最小二乘法是基于最小二乘原理,即将真实观测值与模型预测值之间的差异平方求和并最小化这个目标函数。

通过迭代地更新参数,递推最小二乘法可以逐渐优化模型,并获得更准确的参数估计。

2.2 算法步骤:具体而言,在每次迭代中,递推最小二乘法按照以下步骤进行操作:1. 根据历史数据选择一个样本,并根据当前的参数估计出预测值。

递推最小二乘法推导

递推最小二乘法推导递推最小二乘法是一种经典的数学方法,用于解决数据拟合问题。

它通过最小化误差平方和的方法,寻找最佳的拟合曲线或平面,从而对数据进行预测和分析。

本文将详细介绍递推最小二乘法的原理和推导过程。

一、引言在现实生活和科学研究中,我们经常需要通过已知的数据来拟合一个函数,以便对未知的数据进行预测或分析。

而最小二乘法就是一种常用的数据拟合方法,它的基本思想是通过最小化误差的平方和,找到最佳的拟合函数。

二、最小二乘法的基本原理最小二乘法的基本原理是通过最小化残差平方和来确定拟合函数的参数。

残差指的是每个数据点的观测值与拟合函数预测值之间的差异。

最小二乘法的目标是找到使得残差平方和最小的参数值,从而得到最佳的拟合曲线或平面。

三、递推最小二乘法的推导过程递推最小二乘法是最小二乘法的一种改进方法,它能够更加高效地进行参数估计。

下面将结合一个简单的一元线性回归问题,来详细介绍递推最小二乘法的推导过程。

假设我们有一组样本数据(x₁, y₁), (x₂, y₂), …, (xₙ, yₙ),需要找到一条直线y = ax + b 来拟合这些数据。

我们可以定义残差eᵢ= yᵢ- (axᵢ + b),其中 eᵢ表示第 i 个数据点的残差。

我们的目标是通过最小化残差平方和来确定直线的参数a 和b。

即最小化损失函数 S = Σ(eᵢ²)。

我们需要计算一些中间变量,包括样本数据的均值xₙ和yₙ,以及样本数据的协方差 sₓy 和方差 sₓ²。

其中,xₙ = (x₁ + x₂ + … + xₙ) / n,yₙ = (y₁ + y₂ + … + yₙ) / n,sₓy = (Σ(xᵢ - xₙ)(yᵢ - yₙ)) / (n - 1),sₓ² = (Σ(xᵢ - xₙ)²) / (n - 1)。

接下来,我们可以通过递推公式来更新参数 a 和 b 的估计值。

首先,我们初始化a₀和 b₀的估计值为0。

递推最小二乘估计

当C=I 时, [A+BD]-1 = A-1 -A-1B[I +DA-1B]-1DA-1

理论。 • 高斯仅用1小时就算出了谷神星的

轨道形状,并进行了预测

•1794年,高斯提出了最小二乘的思想。

1:引言

最小二乘法(Least Square)Gauss 1795年提出 在预测卫星和彗星运动的轨道时,需要处理由望远镜获得的观测数 据,以估计天体运动的六个参数。

Gauss在《天体运动理论》一书中写道:“未知量的最大概值是这 样的数值,它使各实测值与计算值之差的平方乘以度量其精度的数 值后,所得的和值达到最小。” ——著名的最小二乘思想 在系统辨识中,LS已成功应用于系统参数估计。 在自校正控制中,LS是应用最广泛的算法之一。

2:原理

2:原理

2:原理

2:原理

2:原理

3:特点

3:特点

(1):无需存储全部数据,取得一组观测数据便 可估计一次参数,而且都能在一个采样周期中完 成,所需计算量小,占用的存储空间小。

(2):具有一定的实时处理能力

谢谢

递推最小二乘估计(RLS)

董博南

一:最小二乘法回顾

二:递推最小二乘估计

一:最小二乘法回顾

1:引言 2:原理

3:特点

1:引言

• 1801年初,天文学家皮亚齐发现了谷神星。

•1801年末,天文爱好者奥博斯,在高斯预 言的时间里,再次发现谷神星。 •1802年又成功地预测了智神星的轨道。

递推最小二乘法原理

递推最小二乘法原理递推最小二乘法(Recursive Least Squares, 简称RLS)是一种经典的自适应滤波算法,它在信号处理、通信系统、控制系统等领域得到了广泛的应用。

本文将介绍递推最小二乘法的原理及其在实际应用中的一些特点。

首先,让我们来了解一下最小二乘法。

最小二乘法是一种数学优化方法,用于寻找一组参数,使得给定的模型与观测数据之间的误差平方和最小。

在线性回归问题中,最小二乘法可以用来拟合一个线性模型,以最小化观测数据与模型预测值之间的差异。

最小二乘法的基本思想是通过最小化误差的平方和来寻找最优的参数。

递推最小二乘法是最小二乘法的一种变种,它的特点在于可以实时地更新参数估计,适用于需要动态调整的系统。

在实际应用中,由于系统参数可能随时间变化,传统的最小二乘法在每次参数更新时都需要重新计算整个数据集,计算复杂度较高,不适合实时性要求高的场景。

而递推最小二乘法则可以通过递推的方式,实时地更新参数估计,适用于动态环境下的参数估计问题。

递推最小二乘法的原理可以用数学公式来描述。

假设我们有一个线性模型,\[y_k = \theta^T x_k + e_k\]其中\(y_k\)是观测数据,\(x_k\)是输入向量,\(\theta\)是待估计的参数,\(e_k\)是噪声。

我们的目标是通过观测数据\(y_k\)和输入向量\(x_k\)来估计参数\(\theta\)。

递推最小二乘法的核心思想是通过递推的方式,实时地更新参数\(\theta\)的估计值。

具体来说,我们可以通过以下递推公式来更新参数\(\theta\)的估计值,\[\theta_k =\theta_{k-1} + \frac{P_{k-1}x_k}{1 + x_k^T P_{k-1} x_k}(y_k x_k^T \theta_{k-1})\]其中\(\theta_k\)是第\(k\)次的参数估计值,\(\theta_{k-1}\)是第\(k-1\)次的参数估计值,\(P_{k-1}\)是第\(k-1\)次的参数估计误差的协方差矩阵。

几种最小二乘法递推算法的小结

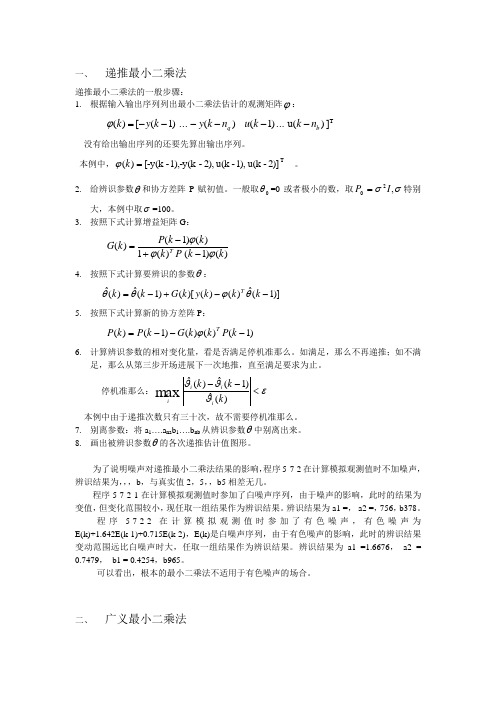

一、 递推最小二乘法递推最小二乘法的一般步骤:1. 根据输入输出序列列出最小二乘法估计的观测矩阵ϕ:] )(u ... )1( )( ... )1([)(T b q n k k u n k y k y k ------=ϕ没有给出输出序列的还要先算出输出序列。

本例中, 2)]-u(k 1),-u(k 2),-1),-y(k -[-y(k )(T =k ϕ。

2. 给辨识参数θ和协方差阵P 赋初值。

一般取0θ=0或者极小的数,取σσ,20I P =特别大,本例中取σ=100。

3. 按照下式计算增益矩阵G :)()1()(1)()1()(k k P k k k P k G T ϕϕϕ-+-= 4. 按照下式计算要辨识的参数θ:)]1(ˆ)()()[()1(ˆ)(ˆ--+-=k k k y k G k k T θϕθθ5. 按照下式计算新的协方差阵P :)1()()()1()(---=k P k k G k P k P T ϕ6. 计算辨识参数的相对变化量,看是否满足停机准那么。

如满足,那么不再递推;如不满足,那么从第三步开场进展下一次地推,直至满足要求为止。

停机准那么:εϑϑϑ<--)(ˆ)1(ˆ)(ˆmax k k k i i i i 本例中由于递推次数只有三十次,故不需要停机准那么。

7. 别离参数:将a 1….a na b 1….b nb 从辨识参数θ中别离出来。

8. 画出被辨识参数θ的各次递推估计值图形。

为了说明噪声对递推最小二乘法结果的影响,程序5-7-2在计算模拟观测值时不加噪声, 辨识结果为,,,b ,与真实值2,5,,b5相差无几。

程序5-7-2-1在计算模拟观测值时参加了白噪声序列,由于噪声的影响,此时的结果为变值,但变化范围较小,现任取一组结果作为辨识结果。

辨识结果为a1 =, a2 =,756,b378。

程序5-7-2-2在计算模拟观测值时参加了有色噪声,有色噪声为E(k)+1.642E(k-1)+0.715E(k-2),E(k)是白噪声序列,由于有色噪声的影响,此时的辨识结果变动范围远比白噪声时大,任取一组结果作为辨识结果。

递推最小二乘法

取二 E ( ) 为 的 合目 函 相 的 的 合目 函 : =, j 作 新 拟 标 数, 应 新 拟 标 数为 Dw

jO ( ) J 艺z艺:( 】 习回 ) Q 加 司一 一 e } j = 。+ G 阶川 = D叭

权最小二乘拟合。 (3 ) (3 0 把式( .和( .) 3 9 3 1 代入式(3 3 . . ( .) 3 1 则有: .

度函数。 下面仅举出第一种计算相关函数法的计算过程。 用这个方法进行相关分析辨识

系统模型的计算分为三个步骤:

1 根 输 和 出 随 数 计 相 函 R )互 关 数 = ) ) 据 入 输 的 机 据 算自 关 数 , 和 相 函 R令; , 卜 r

2 求 ,) R(的 立 变 Sj 凡行) ) *: s)傅 叶 换 x 、 (和 3 , r () 。; ) 0 和

把 宪G 做型,把一实值模值差 “ O 模值并每点测与型之 j 州 ( )

: E . = J j() =( , - + , j )P ( Q. -

( ..1 331 )

称为拟合误 差,再取全部采样频率。上的 拟合误差s 平方和厂作为 , 的 拟合目 标函数。

,rn 、。、下不二不} '-厂 J ‘ Bol }. v\ 、 G , l . W厂 _ _ : Vw } k 一YE t-L]1 G ) ' 二 ' U i - -, ' i

二 ( + ( v } jr ) u mm )

( ..0 33 1 )

现要定数, 以d2 由j(所示频特 在 参bi, i., ’ j 表的率性 确 p. 及, 使 ( . bm . 得 劣 ) . . b dn . 0 d

函 与 验 得 频 特 加 + ) 接 如 把P 和Q , 做 测 而 数 实 求 的 率 性p ) .最 近。 果 阮) () 实 值, M .叫

递推的最小二乘法

1

说明: 公式①的物理意义

( N 1) WLS ( N ) 在以前观测的基础上对本次观测值的预测

T 0 y ( N 1) ( N 1) WLS ( N ) 预测误差,说明 WLS ( N )与实际参数(N)的偏差 T

进行递推,起动问题:

. 一般选 WLS (0)=0,相应的P(0) I = = 0

递推的最小二乘法

最小二乘估计:

LS ( ) Y

T 1 T

加权的最小二乘估计:

WLS ( W ) WY

T 1 T

Y:所有观测数据的全体,所以以上都是成批处理观测数据的一次完成算法,是离 线辨识方法。优点:辨识精度高;缺点:计算量大(特别是高阶矩阵求逆),对 计算机内存要求高,不能在线辨识!

从

WLS ( N )

到

WLS ( N 1)

的递推公式过程(略P191)

递推公式:

T ★ ① WLS ( N 1) WLS ( N ) L( N 1) y ( N 1) ( N 1) WLS ( N ) ② L( N 1) P( N 1) ( N 1) ( N 1)

1、递推的最小二乘法基本思想:

• 本次(新)的估计值

(k )

=上次(老)的估计值

(k 1)

+修正项

•

可以观察随着时间的推移,新的输入、输出信息不断增加的情况下,参数估计的变化情况,特别适用于 在线实时辨识。

设原先得到的参数估计用 WLS ( N ) 表示,则

WLS ( N ) ( T ( N )W ( N ) ( N )) 1 T ( N )W ( N )Y ( N )

递推最小二乘法

递推最小二乘法递推最小二乘法是一种避免精度损失的迭代计算方法,在最小二乘法的基础上加以改进,主要用于拟合复杂的数据,解决拟合时出现精度下降问题。

一、什么是递推最小二乘法递推最小二乘法是一种迭代计算方法,利用多项式曲线拟合曲线数据,对于某个曲线,只需要实施最小二乘法的迭代计算,而不需要考虑精度的损失。

递推最小二乘法的主要工作是根据给定的拟合曲线,把它拟合到数据集中,从而使数据集距离拟合曲线最小。

二、递推最小二乘法的原理递推最小二乘法的核心原理是,利用多项式拟合曲线,按照“最小二乘法”的原理,以当前拟合曲线为参照,不断进行前进和后退,以达到拟合曲线将数据集中的数据最佳拟合的目的。

这个最佳拟合目标就是实现拟合曲线与数据集之间的最小误差,其中,最小误差就是拟合曲线与实际数据集之间的最小差值。

递推最小二乘法的实现方式主要有两种,一种是基于递推的方式,另一种是基于函数的方式。

前者大致的实现方法是:先计算出多项式拟合曲线的每一个系数,然后再利用这些系数计算出多项式拟合曲线的最终拟合曲线,最后比较拟合曲线与实际数据集之间的实际差异,根据差异再调整系数,不断循环,直到最后拟合曲线与实际数据集之间的实际差异达到预期值为止。

函数的实现方式也很类似,只是在计算过程中,会使用函数的方式,将拟合曲线的系数表示为函数的形式,然后再比较拟合曲线与实际数据集之间的实际差异,根据差异再调整函数系数,最后实现拟合曲线与实际数据集之间的最小差异。

三、应用递推最小二乘法在实际应用中可以用来拟合复杂的数据曲线,以求得更好的拟合效果,解决拟合时出现精度下降问题。

它具有计算量小、运算简单、拟合结果较好的优点,因此在实际应用中得到了广泛的使用,比如在众多植物物种的遗传分析中,用递推最小二乘法来拟合植物的遗传规律,以获得更准确的估计结果;在探测地球大气层时,也可以用最小二乘法来拟合大气层中的湿度数据,以获取更加准确的湿度数据;在搜索引擎中,对查询结果也可以用最小二乘法拟合出来,以获得更准确的查询结果等等。

递推最小二乘法原理

递推最小二乘法原理递推最小二乘法是一种用于估计参数的统计方法,它可以帮助我们通过观测数据来拟合模型,从而预测未来的结果。

在实际应用中,我们经常会遇到数据量大、模型复杂的情况,这时候传统的最小二乘法可能会面临计算量大、求解困难的问题。

而递推最小二乘法则可以通过递推的方式,逐步更新参数估计,从而减小计算量,提高效率。

递推最小二乘法的原理主要基于最小二乘法和递推算法。

最小二乘法是一种常用的参数估计方法,它通过最小化观测值与模型预测值之间的误差平方和来求解参数。

而递推算法则是一种通过递推更新参数的方法,可以在每次新的数据到来时,不必重新计算所有参数,而是通过已有的参数估计值和新的数据进行递推更新,从而减小计算量。

在实际应用中,递推最小二乘法可以应用于时间序列分析、信号处理、机器学习等领域。

它可以帮助我们更好地处理大规模数据,提高模型的拟合精度和预测能力。

同时,递推最小二乘法也具有较好的稳定性和收敛性,能够有效应对数据变化和噪声干扰。

递推最小二乘法的核心思想是通过递推更新参数,不断优化模型的拟合效果。

在实际应用中,我们可以通过以下步骤来实现递推最小二乘法:1. 初始化参数,首先,我们需要初始化模型的参数估计值,可以根据经验值或者随机值来初始化。

2. 递推更新参数,当新的数据到来时,我们可以利用已有的参数估计值和新的数据,通过递推算法来更新参数。

这样就可以不断优化模型的拟合效果。

3. 模型预测,通过不断更新参数,我们可以得到更加准确的模型,从而可以用于预测未来的结果。

递推最小二乘法的优点在于它能够有效地处理大规模数据和复杂模型,同时具有较好的稳定性和收敛性。

它在实际应用中具有广泛的应用前景,可以帮助我们更好地分析数据、预测结果。

总之,递推最小二乘法是一种重要的参数估计方法,它通过递推更新参数的方式,可以有效地处理大规模数据和复杂模型,提高模型的拟合精度和预测能力。

在实际应用中,我们可以根据具体的问题和数据特点,选择合适的递推最小二乘法模型,从而更好地分析数据、预测结果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

线性方程组的最优求解方法一.递推最小二乘法设线性方程组b Ax = (1)则有k b k =x :A ),(, (n k Λ,2,1=) (2)其中,[]kn k k a a a k ,,,:),(21Λ=A ,[]Tn x x x ,,,21Λ=x 。

设x :A ),()(k k f = (3)下面采用基于递推最小二乘法(RLS)的神经网络算法来训练权值向量x ,以获得线性方程组(1)的解x 。

由式(3)可知,若以)(k f 为神经网络输出,以k b 为神经网络训练样本,以x 为神经网络权值向量,[]kn k k a a a k ,,,:),(21Λ=A 为神经网络输入向量,则解线性方程组的神经网络模型如同1所示。

图1 神经网络模型采用RLS 算法训练神经网络权值向量x ,其算法如下: (1)神经网络输出:x :A ),()(k k f = (4)(2)误差函数:)()(k f b k e k -= (5)(3)性能指标:∑==n k k e J 12)(21 (6)(4)使min =J 的权值向量x ,即为所求的神经网络权值向量x ,这是一个多变量线性优化问题,为此,由0=∂∂xJ可得最小二乘递推法(RLS ):]),([1k k k k k k b x :A Q x x -+=+ (7)),(),(1),(:A P :A :A P Q k k k T k T k k+= (8)k k k k P :A Q I P )],([1-=+ (9)()n k ,,2,1Λ=随机产生初始权值向量)1,(0n rand =x ,设nn ⨯∈=R I P α0(α是足够大的正数(一般取10610~10=α),nn ⨯∈R I 是单位矩阵),通过对样本数据训练,即可获得神经网络权值向量x ,此即为线性方程组(1)的解。

二.具有遗忘因子的递推最小二乘估计公式为:]),([1k k k k k k b x :A Q x x -+=+ (10)),(),(),(:A P :A :A P Q k k k Tk T k k+=λ (11) k k k k P :A Q I P )],([11-=+λ(12)式中,1:)],(:),([)(-=k A k A k TW P ,W 为加权对角阵:⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡=--10021λλλOn n W(nn ⨯∈=R I P α0,10610~10=α)。

几点说明:(1) 当1=λ时,该估计公式组为基本递推最小二乘算法; (2)λ的选择范围一般在:99.095.0≤≤λ。

当参数变化快时,λ取小点;变化慢时,取大点;三.共轭梯度法及其应用设线性方程组b Ax =,则有给定初始近似0x ,取000Ax b r p -=-= 对Λ,2,1,0=k 计算:kTk kT k k Ap p p r -=α k k k k p x x α+=+1k k k k k Ap r b Ax r α+=-=++11,且b Ax r -=k kkTk kT k k Ap p Ap r 1+=β k k k k p r p β+-=++11。

几点说明:1. 应用共轭梯度法求解实对称正定线性方程组,不必事先估计方程组的系数矩阵A 的特征值的上、下界,不需要选取任何迭代参数,使用方便。

而且,它的收敛速度较快,对于非坏条件问题,一般来说,所需的迭代次数远小于矩阵A 的阶数n (如果计算过程中没有舍入误差,理论上,最多迭代n 步便可得到方程组的准确解。

如果矩阵A 只有)(n m ≤个相异的特征值,则共轭梯度法至多进行m 步迭代,便可得到方程组的准确解)。

因此,共轭梯度法目前已得到较为普遍应用。

特别对于解大型稀疏矩阵的线性方程组,它是一个有效的方法。

2. 共轭梯度法适用于A 为对称正定矩阵的情形。

对于A 为非对称矩阵的情形,可将线性方程组b AX =化为b A AX A TT=,此时,设A 为非奇异,则A A T 为对称正定矩阵。

【应用实例】用共轭梯度法对信号进行滤波处理,模型如下∑∑-=>=<⎥⎦⎤⎢⎣⎡⎪⎭⎫ ⎝⎛+⎪⎭⎫ ⎝⎛+==2/)1(102sin 2cos )(2N n n nN n nkn nk N b nk N a F eF k f Nπππ,1,,1,0-=N k K . 其中,2221nn n b a F +=。

与DTFT 的区别:∑>=<-=.2)(1N k nk n Nek f NF π。

3. 当矩阵A 的条件数较大时,各种计算方法的收敛速度都会很慢。

因为求解线性方程组b AX =的收敛速度通常与矩阵A 的条件数有关,即:br A x x x )(**cond ≤-,其中x 是近似解,*x 是精确解,b Ax r -=是剩余向量。

特别是当矩阵A 的条件数很大时(很怀条件),却会发生这样的情况:相当精确的解,其剩余向量并不小;不精确的解,反而其剩余向量却很小。

由此可见,对于很坏条件线性方程组而言,从剩余向量的大小不能说明相应的近似解精确与否。

为此,国外学者提出了改善矩阵条件数的方法。

四.改善矩阵A 条件数的方法4.1 条件预优方法设线性方程组b Ax = (13)的系数矩阵A 是对称正定的。

将线性方程组b Ax =化为等价的方程组:b y Aˆˆ= (14) 其中Cx y = (15)Aˆ和C 仍然是对称正定的,但条件数不大。

这样就很容易由共轭梯度法求解线性方程组(14)和(15),这就是条件预优处理的思想。

怎样确定对称正定矩阵Aˆ、C 和b ˆ?方法如下: 我们将矩阵A 分裂成:R Q A -=,其中,Q (条件预优矩阵)为对称正定矩阵,则存在对称正定矩阵C 使得CC Q = (16)用1-C 左乘方程组(13)的两端得b C Ax C 11--=或写成b C Cx AC C 111---=设11ˆ--=AC C A,b C b 1ˆ-= (17) 则b y Aˆˆ= (18)Cx y = (19)我们可以用共轭梯度法求解线性方程组(18),得到y ,然后解方程组(19)即可得到方程组(13)的解x 。

条件预优共轭梯度算法如下:b Ax r -=00,010r Q z -=,00z p -=kTk kT k k Ap p z r =α k k k k p x x α+=+1k k k k Ap r r α+=+1,且b Ax r -=k k 111+-+=k k r Q zkTk k T k k z r z r 11++=β k k k k p z p β+-=++11。

上述算法的关键问题是如何确定对称正定矩阵Q ?主要方法如下: (1) 方法一T )()(1L D D L D Q ωω++=- (20)其中),,,(2211nn a a a diag Λ=D (对角矩阵),10<<ω,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=-000000001,2121n n n n a a a a ΛΛΛΛΛΛΛΛL (准下三角矩阵) 设2/12/1-+=LD D E ω (21)则T E E Q = (22)因此,Q 是对称正定矩阵。

可用上述条件预优共轭梯度算法求解x 。

此外,设T --=AE E A1ˆ (23) 则Aˆ为对称正定矩阵,且方程组(13)化为 b y Aˆˆ= (24) x E y T = (25)其中,b E b1ˆ-=。

特别说明:与对称正定矩阵C 不同的是,矩阵E 不一定是对称正定矩阵。

用常规共轭梯度算法求解方程组(24)得到y ,然后用RLS 算法求解方程组(25)可得x 。

或将方程组(25)化为等价的方程组:x E E E y T = (26)设Ey y=ˆ,TE EE =ˆ,则有 x E yˆˆ= (27) 因为TEEE =ˆ是对称正定矩阵,因此可用常规共轭梯度算法求解方程组(27)得到x 。

(2) 方法二另一种条件预优处理是1977年J.A.Meijerink 和A.Van Der Vorst 提出的不完全的Cholesky 分解的方法。

将矩阵A 分解为R LL A +=T其中,L 是下三角阵,使TLL 尽可能接近A ,且L 保持跟A 一样的稀疏性或具有其它形状的稀疏性。

⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡=nn n n n l l l l l l l l l l ΛΛM M M 3213332312221110000000000L 完全分解是对矩阵A 进行三角分解:T LL A =;不完全分解是对矩阵R A -进行三角分解T LL 。

由于矩阵R 可以变化,因此,L 的稀疏结构可以预先适当控制,即L 中哪些元素为0,可以预先规定,但也不能任意规定,还要考虑到T LL 接近A 。

在实际计算中,常考虑使R 有较多零元素。

设TLL Q =,则Q 为对称正定矩阵,可用上述条件预优共轭梯度算法求解x 。

此外,设T --=AL L A1ˆ (28) 则Aˆ为对称正定矩阵,且方程组(13)化为 b y Aˆˆ= (29) x L y T = (30)其中,b L b1ˆ-=。

特别说明:与对称正定矩阵C 不同的是,矩阵L 不是对称正定矩阵。

用常规共轭梯度算法求解方程组(29)得到y ,然后用RLS 算法求解方程组(30)可得x 。

或将方程组(30)化为等价的方程组:x LL Ly T = (31)设Ly y=ˆ,TLL L =ˆ,则有 x L yˆˆ= (32) 因为TLL L=ˆ是对称正定矩阵,因此可用常规共轭梯度算法求解方程组(27)得到x 。

4.2 残差校正方法求解线性方程组b Ax =其中,矩阵A 的条件数较大但不是很大。

设精确解为*x 。

算法步骤如下: Step1. 求解b Ax =(用共轭梯度法等),得到近似解1x ; Step2. 校正1x :计算剩余向量:11Ax b r -=,解11r x A =∆(用用共轭梯度法等),得到近似解1x ∆。

校正:112x x x ∆+=;Step3. 计算剩余向量:22Ax b r -=,解22r x A =∆,得到近似解2x ∆。

校正:223x x x ∆+=; ……综上所述,给定近似解k x ,计算剩余向量:k k Ax b r -=,解k k r x A =∆,得到近似解k x ∆,校正:k k k x x x ∆+=+1,(k=1,2,……,M),其中M 是最大迭代数。