受限玻尔兹曼机详细讲解PPT

《玻耳兹曼统计》PPT课件

可分辨(定域)粒子系统统计

h

1

主要内容

7.1 热力学量的统计表达式 7.2 理想气体的物态方程

基础

7.3 麦克斯韦速度分布率 7.4 能量均分定理 7.5 理想气体的内能和热容量

对理想气 体体系的 应用

7.6 理想气体的熵 7.7 固体热容量的爱因斯坦理论

对固体的 应用

h

§7.1 热力学量的统计表达式

21m(px2py2pz2)

U 3 NkT 2

CV

3 Nk 2

Cp 5 CV 3

P202, 表 7.2

Cp

5 2

Nk

h

B. 双原子分子理想气体

z

r

5 kT 2

刚性连接:r =常量

pr

21M(px2 py2 pz2)21I (p2 si1n2 p2)

21pr2u(r)

p

Mm1m2

m1m2

二、配分函数

21m(px2py2pz2)

d 2m (px 2p2 ypz 2)

Z e 1

xd y xdd yp dzzp d h3

p

h 1 3

p x 2

p 2 y

p z 2

dxd ey 2 m d dxp z e2 m dyp e2 m dzp

Z1 V(2h2m)3/2

h

三、物态方程

p

N

ln Z1 V

N V[lV n2 3ln2h(2m)]

p NkT V

四、内能

U N lnZ1

N [lV n2 3ln2 h(2 m)]

U 3 NkT 2

h

§7.3 麦克斯韦速度分布率

目的 对气体分子

受限玻尔兹曼机matlab编程实现

受限玻尔兹曼机matlab编程实现受限玻尔兹曼机(Restricted Boltzmann Machine, RBM)是一种常用于机器学习和深度学习的无监督学习模型。

它具有强大的模式识别和特征提取能力,被广泛应用于图像识别、自然语言处理等领域。

在本文中,我们将深入探讨受限玻尔兹曼机在MATLAB中的编程实现,并分享一些对该模型的观点和理解。

第一部分:受限玻尔兹曼机简介在这一部分中,我们将简要介绍受限玻尔兹曼机的基本概念和原理。

我们将探讨其结构和工作原理,以及其与其他神经网络模型的比较。

我们还将讨论受限玻尔兹曼机在无监督学习中的应用,以及为什么它被广泛使用。

第二部分:受限玻尔兹曼机的MATLAB编程实现在这一部分中,我们将详细介绍如何使用MATLAB实现一个受限玻尔兹曼机模型。

我们将讨论如何定义网络结构、初始化参数,以及如何使用反向传播算法进行模型训练。

我们还将分享一些在MATLAB中编写受限玻尔兹曼机代码时的技巧和注意事项。

第三部分:利用受限玻尔兹曼机进行特征提取在这一部分中,我们将探讨如何利用受限玻尔兹曼机进行特征提取。

我们将介绍如何将输入数据编码为受限玻尔兹曼机的隐藏层表示,并讨论如何从隐藏层中重构输入数据。

我们还将讨论如何使用受限玻尔兹曼机进行降维和数据可视化。

第四部分:案例研究和应用实例在这一部分中,我们将分享一些受限玻尔兹曼机在实际问题中的应用实例。

我们将介绍一些经典的案例研究,包括图像识别、文本生成等领域。

我们还将讨论一些当前的研究热点和挑战,以及对受限玻尔兹曼机未来发展的展望。

总结和回顾:受限玻尔兹曼机的优势和局限性在这一部分中,我们将对前文的内容进行总结和回顾。

我们将强调受限玻尔兹曼机作为一种无监督学习模型的优势和局限性,并讨论其与其他模型的比较。

我们还将提出一些进一步研究和探索受限玻尔兹曼机的方向,以及对该模型的未来发展的看法。

我对受限玻尔兹曼机的观点和理解通过研究和编程实践,我认为受限玻尔兹曼机是一种强大而灵活的机器学习模型。

深度学习受限玻尔兹曼机

数媒学院-许鹏

Boltzmann Machine—Review—Model

Boltzmann Machine—Review—Algorithm

A more efficient way of collecting the statistics

RBM-Algorithm

现在我们的公式推导就算全部完成了,并且得到了对数似然函数对于各个参数的偏导数,那我们 再具体看一下这个偏导数到底能不能直接计算出来。

RBM-Algorithm

下面我们用图形象化的展示一下现在用于训练RBM的算法:

……

t=0 t=1 t=2 t=infinity

2002-Hinton-Training Products of Experts by Minimizing Contrastive Divergence

hidden units

visible units

RBM-Model

虽然RBM只是BM的层内连接受到了限制,但是在讨论RBM的学习算法和应用场景之前,还是先 为RBM做一个模型定义,用比较严谨的数学方式把它表达出来。

1. 仍然把RBM看成一个能量模型,则可见单元和隐藏单元的总能量为:

2. 我们要使得这个模型的能量减少到一个稳定状态,就需要更新 神经元状态,那么首先要计算某个神经元开启和关闭时的能量差:

……

t=0 t=1 t=2 t=infinity

2002-Hinton-Training Products of Experts by Minimizing Contrastive Divergence

RBM-Contrastive Divergence

受限波尔兹曼机_张春霞

-

,

西安

0 0 4 9

;

2 长 安 大 学理 学 院

,

,

西安

7

1

0 0 6 4

;

西 安 工 业 大 学 机 电 工程 学 院

t

i

西安

i

7

1

0 0 2

1

)

摘

对 要 受 限 波 尔 兹 曼 机 re s r c e d Bo z man n ma ch n es R B M 是 类 具 有 两 层 结 构 称 连 接 且 无 自 反 馈 的 随 机 神 经 网 络 模 型 层 间 全 连接 层 内 无 连接 近 年 来 随 着 RB M 的 快 速 学 习 算 法 对 比 散 度 的 出 现 机 器 学 习 界 掀 起 了 研 究 RB M 理 论 及 应

,

基 于 能 量 的模 型

未归

化 的统 计模型 的 研究

如分类

、

】

.

应用 方

、

RB M 目

前 已 被 成 功 地应 用 于 不 同 的 机 器 学 习 问 题

、

回归

、

降维

高维

时 间 序 列 建模

图 像 特 征提 取

、

协 同 过滤 等 等

.

M

(

隐层

Q

(

Q X?

隱层

AM S

(

2 0 0 0

9 2

B2

0 6 8

;

中 图 分类 号

TP

1

0

2 3 5

文献 标识 码

:

A

1

玻耳兹曼分布律PPT讲解

自由运动的路程 :自由程 其平均值 :平均自由程

二、平均碰撞频率

v

一个分子在单位时间内和其他分子碰撞的次数 Z :碰撞频率

其平均值 Z :平均碰撞频率

一个分子在单位时间内走过的平均路程:v , v / Z

4

三、Z 、 的计算

d :分子直径

v

Z d 2vn

d 2:分子碰撞截面

Z 2d 2vn

V1

V2

V

V2 V

10

功 A是过程量,不是状态量,与 P,V,T,E不同

元功 dA,dP、 dV 、dT 、 dE

9

四、平衡态、准静态过程、功的几何表示

理想气体, PV RT

P

P

P

( P,V )

V

V

点 平衡态

有向曲线 准静态过程

V1

P

面积 A V2 PdV V1

面积 准静态过程的功

只有 PV 图上的面积表示功

解: Z 2d 2vn 2d 2 8RT P kT

81.19 亿次/秒

kT

2d 2P

ห้องสมุดไป่ตู้

2.09 107 m

T t 273.15 , 1atm 1.013105Pa

6

热力学基础 第1节 几个基本概念

一、系统与外界 确定为研究对象的宏观体系:系统或体系 系统以外的物体:外界或环境

二、准静态过程 系统状态随时间的变化:热力学过程 准静态过程:如果一个过程进行的无限缓慢,体系所经历的 每一个中间态都无限接近于平衡态

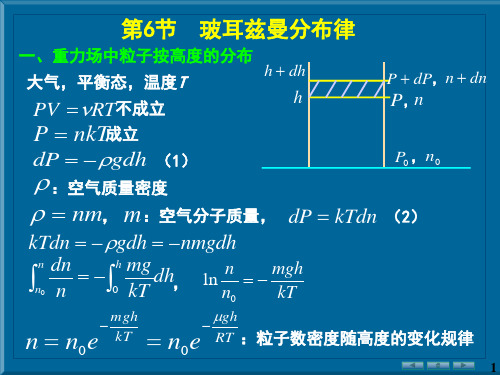

例:求大气中 n 相差一倍的两处的高度差

已知:空气摩尔质量 28.97 103 kg ,T 300K

解: h1处:n1

gh1

受限玻尔兹曼机RBM剖析

根据y的值计算概率p(hj=1|v),其中hj的取值就是yj的值。 2.然后产生一个0到1之间的随机数,如果它小于p(vi=1|h),hi的取值 就是1,否则就是0。

受限玻尔兹曼机

• RBM的基本模型 RBM也可以被视为一个无向图模型。v 为可见层,用于 表示观测数据,h 为隐层,可视为一些特征提取器,W 为 两层之间的连接权重。 对于一组给定的状态(v; h), RBM作为一个系统所具备 的能量定义为

受限玻尔兹曼机

当参数确定时,基于该能量函数,我们可以得到(v; h)的 联合概率分布:

对于一个实际问题,我们最关心的是由RBM所定义的关于 观测数据v的分布,即联合概率分布的边际分布,也称为 似然函数:

受限玻尔兹曼机

由RBM的特殊结构(即层间有连接,层内无连接)可知: 当给定可见单元的状态时,各隐单元的激活状态之间是条 件独立的。此时,第j个隐单元的激活概率为

e ss

果小磁针方向与外场方向一致,则能量也会降低。我们定义总能量:

Esi J

i , j

s s

i

j

H si

i

N

其中J为一个能量耦合常数,E{si}表示系统处于状态组合{si}下的总 能量。求和下标表示对所有相邻的两个小磁针进行求和。我们看到, 如果si=sj,则总能量就会减少J。H表示外界磁场的强度,它是一个参 数,如果外界磁场向上H为正,否则为负。如果某个小磁针的方向与 外场一致,则总能量减少一个单位。

后来,他让他的学生Ernst Ising对一维的Ising模型进行求解,但是并 没有发现相变现象,因此也没有得到更多物理学家的关注。随后,著

名的统计物理学家Lars Onsager于1944年对二维的Ising模型进行了

受限玻尔兹曼机结合聚类的特异点挖掘方法

受限玻尔兹曼机结合聚类的特异点挖掘方法【摘要】受限玻尔兹曼机(Restricted Boltzmann Machine,RBM)是一种深度学习模型,通常用于无监督学习。

本文介绍了受限玻尔兹曼机的基本原理和结构,以及其在聚类分析中的应用。

特异点挖掘方法是一种用于发现数据集中异常值或特殊模式的技术,在本文中我们探讨了如何结合受限玻尔兹曼机和聚类分析来进行特异点挖掘。

具体步骤包括数据预处理、模型训练和特异点挖掘。

通过实验验证,我们展示了受限玻尔兹曼机结合聚类的特异点挖掘方法在数据挖掘领域的有效性和实用性。

未来,这种方法有望在金融、医疗等领域得到广泛应用。

本文系统地介绍了受限玻尔兹曼机结合聚类的特异点挖掘方法,为相关研究提供了重要参考。

【关键词】受限玻尔兹曼机、聚类分析、特异点挖掘、原理、步骤、应用前景、总结、研究背景、研究意义1. 引言1.1 研究背景受限玻尔兹曼机结合聚类的特异点挖掘方法是一种新兴的数据挖掘技术,其在处理复杂数据集中的异常点和离群点方面具有独特的优势。

随着数据挖掘和机器学习领域的不断发展,传统的聚类方法在处理高维、大规模数据时面临着诸多挑战,特异点挖掘方法的需求也日益迫切。

研究受限玻尔兹曼机结合聚类的特异点挖掘方法不仅可以提升数据挖掘任务的效率和准确率,还能够为异常检测、故障诊断、风险预测等实际应用领域带来更为可靠和有效的解决方案。

本文将探讨受限玻尔兹曼机结合聚类的原理和方法,以及其在特异点挖掘中的应用前景和意义。

1.2 研究意义随着数据科学和机器学习技术的快速发展,越来越多的数据被用于各种分析和应用中。

在大数据时代,数据中存在着大量的信息和结构,然而也存在着一些异常或特征点,这些特征点可能包含有用的信息,也可能引起数据分析结果的偏差。

对于数据中的特异点的挖掘成为一项重要的研究任务。

受限玻尔兹曼机结合聚类的特异点挖掘方法的研究意义在于能够提高数据分析的准确性和可解释性。

通过将受限玻尔兹曼机和聚类方法结合起来,可以更好地挖掘数据中的特异点,识别出与其他数据点不同的样本或模式。

基于受限玻尔兹曼机的中文文档分类

本 文 采 用 了基 于 受 限 玻 尔 兹 曼 机 抽取 低 维 高 可 区 别 特 征 对 中 文 文 档 进 行 分 类 。 度 信 念 网 络 抽取 低 维高 度 可 区 分 特征 有 助 于 深 提 高 支 持 向 量机 的 回归 性 能 , 而 提 示 文档 分 类 的 准确 度 。 验 结 从 实 果 表 明 这 种 方 法获 得 令 人 满 意 的分 类 结果 。 管 如 此 , 尽 本文 原 始 特 征 的提 取 过 于 简 单 , 用 一 些 更加 成熟 的 方法 将 有 助 于 提 高 分 类 采

性能。

参考文献

[]王 自强 , 旭 . 于 KDA和s M 的 文 档分 类 算 法[】 计 算 机 应 1 钱 基 V J.

用 , 0 9 2, 1 ~ 4 20 , 46 l 8. [】王 自强 , 2 钱旭 , 孔敏 . 向文 档 分类 的 L 面 DE ̄ 简 化SVM 方法 研 究 n [. J 计算 机 工 程与 应 用 , 0 9 4 ( 2 : ~6 ] 2 0 , 52 ) l . 【】何 明 , 博琴 , 向华 . 3 冯 傅 基于 Ro gh集潜 在 语 义索 引的 We u b文 档 分 类[]计 算机 工 程 , 0 4 3 ( 3 : ~5 J. 2 0 ,0 1 )3 .

4 Co cu i n n lso

3 实 验

3 1实 验 数 据 . 国内 目前还 没 有标 准 的且 普 遍 接 受 的 中 文 文 档 分 类 测试 文 档 库, 我们 使 用 自己 建 立 的测 试 文 档 库测 试 我 们 的 文 档分 类 器 。 测试 文 档库 中的 文 档 均 来 自腾 讯 门 户网 站 , 它们 被 分 为4 个类 , 们取 0 我 其 中 的 包 含 文 档 数 最 多 的2 个 类 进 行 测 试 , 练集 总共 包 含 1 0 0 训 03 3 文档 , 试 集 包 含 8 3 篇 文 档 。 篇 测 02 3 2实验 设 置 . 实验环境 为I tl n e Co e Qu d r a 2.GHz 4 4 、GB内存 ̄ Ge re t N Fo cg 2 4 显卡 , O 显存 为 1 GB. 权重 矩 阵 的元 素 初 始为 卜1 ,.] . 1 的随 机 数 , 0 0 偏 置 b和 c初 始化 为0 高斯 可 视 节 点 的标 准 方 差 固 定 为 1 0 采 用J , .。 a

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

– Repeat for all data vectors in the training set. • Negative phase

– Do not clamp any of the units – Let the whole network reach thermal equilibrium at a

temperature of 1 (where do we start?)

– Sample si s j for all pairs of units

– Repeat many times to get good estimates • Weight updates

– Update each weight by an amount proportional to the difference in sis j in the two phases.

– This is a big advantage over directed belief nets

hidden j

i visible

Maximizing the training data log

likelihood

Standard PoE form

•

We want maximizing parameters

• Can observe some of the variables and we would like to solve two problems:

• The inference problem: Infer the states of the unobserved variables.

• The learning problem: Adjust the interactions between variables to make the network more likely to generate the observed data.

• The derivation is nasty.

Frank Wood - fwood@

Equilibrium Is Hard to Achieve

• With:

log p(D | 1, ,n ) log fm d | m

log fm c|m

m

m

P0

m

P

1 1 e j s jwij T

1 1 eEi T

temperature

Energy gap Ei E(si0) E(si1)

The Energy of a joint configuration

binary state of unit i in joint configuration v, h

– The temperature controls the amount of noise.

– Decreasing all the energy gaps between configurations is equivalent to raising the noise level.

p( si 1)

p(v, h) eE(v,h)

• The probability of a configuration over the visible units is found by summing the probabilities of all the joint configurations that contain it.

Restricted Boltzmann Machines and Deep Belief Networks

Presented by Matt Luciw

USING A VAST, VAST MAJORITY OF SLIDES ORIGINALLY FROM:

Geoffrey Hinton, Sue Becker, Yann Le Cun, Yoshua Bengio, Frank Wood

• In an RBM, the hidden units are conditionally independent given the visible states.

– So can quickly get an unbiased sample from the posterior distribution when given a data-vector.

p(si 1)

ห้องสมุดไป่ตู้

1

1 exp(bi

s jwji )

j

1

p(si 1) 0.5

0 0

bi s jwji

j

Stochastic units

• Replace the binary threshold units by binary stochastic units that make biased random decisions.

• Unsupervised learning could do “local-learning” (each module tries its best to model what it sees)

• Inference (+ learning) is intractable in directed graphical models with many hidden variables

Restricted Boltzmann Machines

• Restrict the connectivity to make learning easier.

– Only one layer of hidden units.

• Deal with more layers later

– No connections between hidden units.

Expected value of product of states at thermal equilibrium when nothing is clamped

The (theoretical) batch learning

algorithm

• Positive phase – Clamp a data vector on the visible units. – Let the hidden units reach thermal equilibrium at a temperature of 1

log p(v) wij

si s j

v

sis j

free

Derivative of log probability of one training vector

Expected value of product of states at thermal equilibrium when the training vector is clamped on the visible units

can now train our PoE model. • But… there’s a problem:

– Pis computationally infeasible to obtain (esp. in an inner gradient ascent loop).

– Sampling Markov Chain must converge to target distribution. Often this takes a very long time!

• Current unsupervised learning methods don’t easily extend to learn multiple levels of representation

Belief Nets

• A belief net is a directed acyclic graph composed of stochastic variables.

– The energy is determined by the weights and biases (as in a Hopfield net).

• The energy of a joint configuration of the visible and hidden units determines its probability:

E(v,h)

sivhbi

sivh

s

vh j

wij

iunits

i j

Energy with configuration v on the visible units and h on the hidden units

bias of unit i

weight between units i and j

Stochastic binary neurons

• These have a state of 1 or 0 which is a stochastic function of the neuron’s bias, b, and the input it receives from other neurons.

Frank Wood - fwood@

A very surprising fact

• Everything that one weight needs to know about the other weights and the data in order to do maximum likelihood learning is contained in the difference of two correlations.

Solution: Contrastive Divergence!