玻尔兹曼机网络

DBN(深度信念网络)MATLABDeepLearnToolbox源码学习

DBN(深度信念网络)MATLABDeepLearnToolbox源码学习深度信念网络(Deep Belief Networks,DBN)是一种无监督学习算法,用于将浅层的无监督学习算法(如受限玻尔兹曼机)组合成深层的结构。

DBN的核心思想是通过逐层训练,将特征从原始数据中抽取出来,并在每一层中学习到更加抽象和高级的特征表示。

为了学习DBN的实现细节,我选择了MATLAB中的DeepLearnToolbox源码进行学习。

DeepLearnToolbox是MATLAB的一个开源工具包,提供了各种深度学习模型的实现,包括DBN。

在学习DBN的MATLAB源码之前,首先了解一下DBN的结构和训练过程是非常重要的。

DBN由多层玻尔兹曼机(RBM)组成,每一层的RBM都被训练为一个无监督学习的生成模型。

在训练完成之后,DBN的每一层就是上一层的隐藏层,通过从上到下的顺序连接起来形成整个DBN。

学习源码时,首先需要熟悉DeepLearnToolbox提供的DBN类的方法和属性。

然后,可以根据具体的需求对源码进行修改和调试。

在学习源码的过程中,我发现DBN类中的一些核心方法特别值得关注,如train、propup、sampleH、reconstruct和propdown等。

这些方法分别对应DBN的训练过程中的不同步骤,如正向传播、反向传播、样本采样和重构等。

理解这些方法的实现细节,可以帮助我们更好地理解DBN的实现原理。

此外,我还注意到DeepLearnToolbox提供了一些辅助函数,如sigm、rbmup、rbmdown和sample等,用于计算激活函数的输出、计算RBM的正向传播和反向传播的输出、以及对样本进行采样等。

这些辅助函数在DBN 的实现中起到了重要的作用。

在学习DBN的源码过程中,我还可以将实现的方法与DBN的理论知识进行对比,加深对DBN算法的理解。

另外,还可以通过实验和调试源码,观察不同参数设置对DBN性能的影响,从而进一步探索DBN的特性。

【生成模型】浅析玻尔兹曼机的原理和实践

【生成模型】浅析玻尔兹曼机的原理和实践这一期将介绍另一种生成模型—玻尔兹曼机,虽然它现在已经较少被提及和使用,但其对概率密度函数的处理方式能加深我们对生成模型的理解。

作者&编辑 | 小米粥1 玻尔兹曼机玻尔兹曼机属于另一种显式概率模型,它是一种基于能量的模型。

训练玻尔兹曼机同样需要基于极大似然的思想,但在计算极大似然的梯度时,运用了一种不同于变分法的近似算法。

玻尔兹曼机已经较少引起关注,故在此我们只简述。

在能量模型中,通常将样本的概率p(x)建模成如下形式:其中,Z为配分函数。

为了增强模型的表达能力,通常会在可见变量h的基础上增加隐变量v,以最简单的受限玻尔兹曼机RBM为例,RBM中的可见变量和隐变量均为二值离散随机变量(当然也可推广至实值)。

它定义了一个无向概率图模型,并且为二分图,其中可见变量v组成一部分,隐藏变量h组成另一部分,可见变量之间不存在连接,隐藏变量之间也不存在连接(“受限”即来源于此),可见变量与隐藏变量之间实行全连接,结构如下图所示:在RBM中,可见变量和隐藏变量的联合概率分布由能量函数给出,即其中能量函数的表达式为配分函数Z可写为考虑到二分图的特殊结构,发现在隐藏变量已知时,可见变量之间彼此独立;当可见变量已知时,隐藏变量之间也彼此独立,即有以及进一步地,可得到离散概率的具体表达式:为了使得RBM与能量模型有一致的表达式,定义可见变量v的自由能f(v)为其中h i为第i个隐藏变量,此时可见变量的概率为配分函数Z。

使用极大似然法训练RBM模型时,需要计算似然函数的梯度,记模型的的参数为θ ,则可以看出,RBM明确定义了可见变量的概率密度函数,但它并不易求解,因为计算配分函数 Z 需要对所有的可见变量v和隐藏变量h 求积分,所以对数似然log p(v)也无法直接求解,故无法直接使用极大似然的思想训练模型。

但是,若跳过对数似然函数的求解而直接求解对数似然函数的梯度,也可完成模型的训练。

基于深度玻尔兹曼机的蛋白质O-糖基化位点的预测

基于深度玻尔兹曼机的蛋白质O-糖基化位点的预测杨雪梅【期刊名称】《内江科技》【年(卷),期】2018(039)012【总页数】2页(P98-99)【作者】杨雪梅【作者单位】咸阳师范学院数学与信息科学学院【正文语种】中文用深度学习(DL)的方法对蛋白质O-糖基化位点进行了预测。

首先用SMOTE方法处理非平衡数据集,对较少一类的样本用“近亲繁殖”的方法产生新的样本,弥补“欠采样”或“过采样”造成的预测误差;然后用深度学习中的深度玻尔兹曼机神经网络(DBM)进行分类(预测),并用多数投票法对结果进行集成。

实验结果表明,DBM是预测O-糖基化位点的行之有效的方法。

糖基化是指在酶的作用下将糖转移到蛋白质,是蛋白质的一种翻译后修饰,有调节改良蛋白质功能的作用。

在生物制药工程中,糖基化对治疗性蛋白质的稳定性、半衰期活性等具有重要的影响,通过对糖基化位点的预测,选择合适的载体对蛋白质进行糖基化修饰,可以提高药物的治疗效果和降低毒副作用。

另外,蛋白质的糖基化程度和糖链结构的异常变化是癌症及其他疾病发生的标志之一[1]。

糖基化有多种实现过程,本文关注O-糖基化,其发生的位点是丝氨酸(S)或苏氨酸残基(T)的羟基氧[1],我们预测一个含有S或T的氨基酸序列是否糖基化。

目前,文献中出现的预测方法有人工神经网络(ANN)[2]、支持向量机(SVM)[3],以及一些特征提取的方法包括主成分分析[4]、独立成分分析[5]、核Fisher[6]等,都获得了较好的效果。

本文将采用深度玻尔兹曼机(DBM)的方法进行预测。

DBM由Hinton等人于2006年提出,广泛应用于自然语言处理和图像等领域,取得了很好的效果[7]。

目前有人用这种方法预测过蛋白质二级结构,但尚未有人用该种方法预测过蛋白质一级结构。

由于它采用“预训练”的方法,有效解决了传统神经网络层数过多难以优化的问题[8],将使预测准确率得以提高。

本文结构如下:第一节介绍蛋白质序列数据与编码;第二节构造平衡数据集;第三节描述用来预测的DBN算法;第四节是预测与结果;最后给出结论。

深度学习技术的非监督学习方法教程

深度学习技术的非监督学习方法教程近年来,深度学习技术在计算机视觉、自然语言处理和机器学习等领域取得了显著的成就。

而监督学习方法是传统深度学习的核心,它需要大量标记好的数据进行训练,并且对于训练数据的质量和数量也有较高的要求。

然而,在许多实际场景中,获取大量标记好的数据往往是一项困难和昂贵的任务。

为了解决这个问题,非监督学习方法应运而生。

非监督学习是指对未标记数据进行分析和建模的机器学习方法。

它通过发现数据中的隐藏模式和结构来获得信息,避免了对标记数据的依赖。

在深度学习中,非监督学习方法发挥着重要的作用,能够提供更多的信息和知识,为其他任务如分类、聚类和生成模型等提供支持。

在下面的文章中,我们将介绍几种常见的非监督学习方法,以帮助读者更好地了解深度学习技术的应用。

1. 自编码器(Autoencoder)自编码器是一种无监督学习的神经网络模型。

它包括一个编码器和一个解码器,旨在将输入数据压缩到一个低维表示并重构回输入空间。

自编码器通过最小化输入和重构之间的差异来学习有用的特征表示。

它可以用于特征提取、降维和去噪等任务。

2. 稀疏编码(Sparse Coding)稀疏编码是一种将输入数据表示成稀疏线性组合的方法。

它假设数据可以由少数的基向量表示,并通过最小化表示的稀疏度来学习这些基向量。

稀疏编码可以应用于特征学习、噪声去除、图像修复等任务。

3. 受限玻尔兹曼机(Restricted Boltzmann Machine, RBM)受限玻尔兹曼机是一种生成式模型,可以用于学习数据的概率分布。

RBM通过最大化数据的似然函数来学习模型参数,从而能够生成与原始数据相似的样本。

受限玻尔兹曼机可以应用于生成模型、特征学习和协同过滤等任务。

4. 深度信念网络(Deep Belief Networks, DBN)深度信念网络是由多层受限玻尔兹曼机组成的深度神经网络。

它通过逐层无监督地预训练和有监督的微调来学习数据的表示和分类。

基于受限玻尔兹曼机的手写字符识别算法研究

基于受限玻尔兹曼机的手写字符识别算法研究目录目录 (1)摘要 (2)ABSTRACT (2)第1章绪论 (3)1.1 研究背景 (3)1.2 研究现状 (3)1.3 本文的主要工作 (3)1.4 论文的组织结构 (4)第2章神经网络基本原理与RBM模型探讨 (5)2.1 启发式思想与模拟退火算法 (5)2.1.1 贪心算法的局部最优限制与启发式思想 (5)2.1.2 模拟退火模型及其概率转移计算 (5)2.2 玻尔兹曼机与受限玻尔兹曼机 (6)2.3 受限玻尔兹曼机模型概述 (7)2.3.1 受限玻尔兹曼机网络结构 (7)2.3.2 受限玻尔兹曼机能量函数及概率分布计算 (8)第3章 受限玻尔兹曼机中的数学理论 (11)3.1 随机梯度法解对数似然函数 (11)3.2 马尔可夫链蒙特卡罗策略与Gibbs采样 (13)3.2.1 马尔科夫链与马氏定理 (13)3.2.2 三种采样算法 (15)3.2.3 用采样技术解受限玻尔兹曼机中的计算难题 (19)3.3 对比散度算法 (20)第4章 基于受限玻尔兹曼机的手写字符识别模型 (23)4.1 手写字符特征提取 (23)4.1.1 图像特征提取概念及背景 (23)4.1.2 常见的手写字符图像特征提取方法 (23)4.1.3 数据降维与受限玻尔兹曼机提取特征 (25)4.1.4 深度信念网络与贪婪学习 (26)4.2 手写字符特征分类 (27)4.3 手写字符识别算法流程 (27)第5章 基于受限玻尔兹曼机的手写字符识别模型示例 (29)5.1 手写数字数据集MNIST解析 (29)5.2 结果分析 (30)第6章 总结与展望 (33)致谢 (34)参考文献 (35)附录1 英文原文 (37)附录2 译文 (39)摘要受限玻尔兹曼机(RBM)是一种内含两层结构,对称链接,无自反馈的深度学习网络模型。

受限玻尔兹曼机的快速学习算法近年来一直是研究热点,随着对比散度算法的出现,受限玻尔兹曼机在机器学习节掀起了应用和研究的热潮。

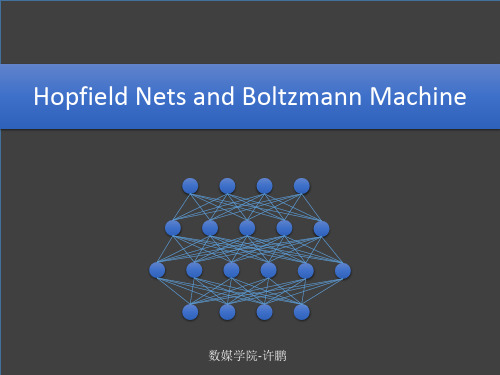

深度学习受限玻尔兹曼机

数媒学院-许鹏

Boltzmann Machine—Review—Model

Boltzmann Machine—Review—Algorithm

A more efficient way of collecting the statistics

RBM-Algorithm

现在我们的公式推导就算全部完成了,并且得到了对数似然函数对于各个参数的偏导数,那我们 再具体看一下这个偏导数到底能不能直接计算出来。

RBM-Algorithm

下面我们用图形象化的展示一下现在用于训练RBM的算法:

……

t=0 t=1 t=2 t=infinity

2002-Hinton-Training Products of Experts by Minimizing Contrastive Divergence

hidden units

visible units

RBM-Model

虽然RBM只是BM的层内连接受到了限制,但是在讨论RBM的学习算法和应用场景之前,还是先 为RBM做一个模型定义,用比较严谨的数学方式把它表达出来。

1. 仍然把RBM看成一个能量模型,则可见单元和隐藏单元的总能量为:

2. 我们要使得这个模型的能量减少到一个稳定状态,就需要更新 神经元状态,那么首先要计算某个神经元开启和关闭时的能量差:

……

t=0 t=1 t=2 t=infinity

2002-Hinton-Training Products of Experts by Minimizing Contrastive Divergence

RBM-Contrastive Divergence

基于双边滤波与受限玻尔兹曼机的冷冻电镜单颗粒图像识别

Biophysics 生物物理学, 2021, 9(1), 34-42Published Online February 2021 in Hans. /journal/biphyhttps:///10.12677/biphy.2021.91005基于双边滤波与受限玻尔兹曼机的冷冻电镜单颗粒图像识别王桉迪,姚睿捷,黄强*复旦大学生命科学学院,上海收稿日期:2021年1月5日;录用日期:2021年2月15日;发布日期:2021年2月26日摘要冷冻电镜技术(Cryo-EM)起源于20世纪70年代,是结构生物学中蛋白质与核酸分子结构研究的重要技术手段。

21世纪以来,计算机性能的提升与直接电子检测相机的极大发展,使得人们在小样本低剂量样本条件下仍可获得接近原子分辨率级的三维结构模型。

由于三维结构模型是利用多角度投影,通过大量二维冷冻电镜单颗粒图像重构所得,因此,二维单颗粒图像的识别与分类直接影响最终模型的分辨率。

目前,通过冷冻电镜获得的图像大部分噪声较多,因此对二维单颗粒图像的筛选,往往需要耗费有经验的科学工作者耗费大量时间。

针对此问题,本文运用计算机图形学与机器学习相结合的方法,在预处理阶段以双边滤波器(Bilateral Filter)对信噪比较低的图像进行边缘优化,并通过直方图均衡化实现图像信息增强,最后以少量高置信度图像为训练样本,通过受限玻尔兹曼机(Restricted Boltzmann Machine,RBM)进行监督式学习并实现图像的分类与筛选,以提高二维单颗粒图像识别的效率与准确率。

在方法检验阶段,首先,我们利用蛋白质数据库(Protein Data Bank, PDB)中已知的生物大分子结构,投影生成不同信噪比的模拟单颗粒模拟数据,验证了在低信噪比条件下应用本方法进行单颗粒图像识别分类的准确性。

随后我们以瞬态受体电位离子通道蛋白子类V成员1 (Transient Receptor Potential cation channel subfamily V member 1,TRPV1)的真实二维单颗粒图像数据集进行识别分类与三维模型重构,通过cryoSPARC平台,以约53%的原始数据量重构出了与原分辨率3.6Å相近的模型。

深度学习-BM玻尔兹曼机

按照这个规则,整个Hopfield网络的神经元从某个随机的状态开始,以序列化的方式,每次更新 一个神经元,则最后网络可以达到一个能量的最小值状态,但是这个最小值可能只是局部最小。

Hopfield Network—Energy Model

举个例子:

1 3 1 2

-4

-1

3

-1

3 1 -1

如右图state1是网络的随机开始状态,这个状态 下只有一个单元对被激活了,所有总能量为-11。 现在我们以序列化方式随机更新其他的单元, 随便挑选一个,比如右上角橘黄色的单元,这 个单元原来的状态是关闭的-1,这时候观察它 的总输入为(-4)*1+3*(-1)+3*(-1)=-4,小于0, 所以把它关闭,即还处于状态-1。 我们看state2,计算橘黄色神经元的总输入为 3*1+(-1)*(-1)=4,大于0,所以保持开状态1。

ISING Model

伊辛模型表述如下: 每个结点是一个小磁针,有向上和向下两种状态,即 Si=+1或者Si=-1,相邻的小磁针可以发生相互作用。我们 可以为整个模型定义一个总能量,总能量由两部分组成, 一部分是所以小磁针内部能量,即如果小磁针方向一致, 那么总能量减1,否则加1;另一部分是外部能力,即外 界也有磁场,如果小磁针和外界磁场方向相同则总能量 加1,否则减1.

ising模型假设磁铁物质由一堆规则排列的小磁针组成每个磁针只有上下两个方向相邻的小磁针之间通过能量约束发生相互作用同时又由于环境热噪声的干扰而发生随即转变由上变为下或者反之涨落的大小由关键的温度参数决定温度越高随机涨落干扰越强小磁针越容易发生无序而剧烈的状态转变从而可能会让上下两个方向的磁性抵消整个系统消失的磁性

Hopfield Network—Associative Memory

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Boltzmann 机网络1. 网络结构伯尔兹曼机网络(Boltzmann machines ,BM )在网络结构方面与Hopfield 神经网络类似,网络采取有教师的学习方法,每一个神经元之间对称的反馈互联,即各对神经元之间的传输权重系数是对称的:ji ij w w =,0=ii w 。

但是,两者之间在运行原理方面有根本区别。

(1)Hopfield 网络的神经元的结构功能,及其在网络中的地位是一样的。

BM 中一部分神经元与外部相连,可以起到网络的输入、输出功能,或者严格的说可以受到外部条件的约束;而另一部分神经元则不与外部相连,因而属于隐单元;BM 是具有隐单元的反馈互联网络。

(2)神经元的状态为0或1的概率取决于相应的输入。

(3)学习与工作原理有其独特之处。

BM 网络的神经元特性取概率阈值模型,如图1所示。

对于第i 号神经元,它的全部输入信号的总和为i I ,可表示如下i N i j j j ij i x w I θ-=∑-≠=1,0 (1)或者∑-≠==1,0N i j j j ij i x w I (2)神经元i 的输出为i x ,i x 只能取1或0,i x 取1的概率i p 由下式决定 ()()T I i j e x p /111-+== (3) ()()==-==110i i x p x p ()T I T I j j e e //1--+ (4) 式(3)就是我们熟悉的Sigmoid 形式,但是前面分析中常用的参数0u 改用了字母T ,并且称之为温度,这与在BM 的分析中将与热力学类比有关,在不同的温度下i p 随i I 的变化如图2所示,温度参数T 在BM 神经网络的搜索过程中起重要的作用。

图1 BM 神经元结构图2 BM 神经元的特性2.训练方法2.1 状态更新算法(1)网络初始化给初始状态赋[-1,1]之间的随机数,设定起始温度0T 和目标温度值final T 。

(2)求解内部状态从N 个神经元中随机选取一个神经元,根据下式求解出神经元的输入总和,即内部状态。

()()j j Ni j j ij i b t u w t H +=∑≠=,1 (5)()j j nj ij i b v w t u +=∑=1 (6)(3)更新神经元状态根据下面的公式更新神经元的状态:()[]()()T t H t v P i i /ex p 1111-+==+ (7) 1vv iv 1-200.90.80.750-5-100.10.20.30.40.50.6-150151020()()()T t u i i e t v P -+==+1111 (8)(4) 除i 外的神经元的输出状态保持不变,即除i 外的神经元的状态由下面公式求解得出:()()t v t v j j =+1 i j N j ≠⋅⋅⋅=;,,2,1 。

(9)(5) 令 1+=t t ,按照下式计算出新的温度参数:()()1log 10+=+t T t T (10) (6) 第(5)步计算出的温度参数是否小于目标温度,小于目标温度则算法结束,否则返回(2),进入下一轮计算。

2.2 注意事项(1)概率阀值的确定方法在网络初始化时按经验确定,或在运行过程中选取一个[0,0.5]之间均匀分布的随机数。

(2)网络权值的确定方法(3)在每一温度下达到热平衡的条件(4)降温方法通常采用指数降温,即()()1log 10+=+t T t T 为加快网络收敛速度,也可采用一个倍乘小于1的降温系数的办法。

3.相关问题算法BM 神经元网络的运行:最佳解的模拟退火法搜索模拟退火算法是最优化处理理论和方法的一个方面,并不是在BM 网络中所专有的,恰恰相反,正是由于上述的网络概率状态对参数T 的强烈依赖使我们自然地想到,在网络的运行过程中T 应先高后低以便能够在搜索速度和搜索精度两个方面得到好处,快熟而又精确地获得全局最优解。

就像在所有的自适应运算中对迭代步长α的处理那样。

而作为热处理工艺的模拟退火方法也将工件高温加热,然后慢慢冷却,所追求的物理目的就是将工件的微观物质结构在高温下进行充分的扰动、而在降温的进程中生成微观晶格有序化的低能量状态,共同的理论思想使二者走到了一起,也是热力学理论引入信息处理领域的最初尝试和成功范例。

模拟退火算法(Simulated Annealing ,SA )它由Metropolis 于1953年提出,是最优化处理算法中的一种改进的蒙特—卡罗方法、包括Metropolis 算法和退火过程(Annealing Procedure ,AP )组成。

S Kirkpatrick (1983)和V Cerny (1985)进一步发展和应用了这一方法。

方法的概要是,首先在高温下进行搜索,由于此时各状态出现概率相差不大,系统可以很快进入“热平衡状态”,是一种快速找到系统概率的低能区的“粗搜索”过程。

随着温度逐渐降低,各状态出现概率的差距逐渐被扩大,搜索精度不断提高。

最后以一较高置信度达到网络能量函数的全局最小点。

简要说明如下。

(1)Metropolis 抽样过程Metropolis 算法是模拟退火算法的基础。

它假定随机变量在某一时刻的状态为i v ,在另一时刻状态为j v 。

假设这种状态的转移满足对称条件()()i j j i v v p v v p ||=。

令i E ∆表示系统从状态i v 转移至状态j v 所引起的能量差。

如果i E ∆<0,即转移就导致了状态能量的降低,则兑现这种转移。

新状态将作为算法下一步的起点。

如果i E ∆>0,算法按概率操作结果随机决定兑现或放弃这一转移。

概率操作的方法很多,其中取随机数的方法很简单。

随机生成一个在[0,1]区间内均匀分布的随机数ξ,如果T E i e /∆-<ξ。

则兑现这种转移,否则拒绝这种转移。

反复迭代,达到系统当前温度下的热平衡(能量最小)。

这个过程称作Metropolis 抽样过程。

(2)退火过程退火过程就是降温过程。

即在Metropolis 抽样过程中将温度T 缓慢降低,通过参数T 的变化使系统状态收敛于全局最小能量处。

T 参数的选择对于算法最后的结果有很大的影响。

初始温度和终止温度设置的过低或过高都会延长搜索时间。

降温步骤太快,往往会漏掉全局最优点,使算法收敛至局部最优点。

叫我降温步骤太慢,则会大大延迟搜索全局最优点的计算时间,从而难以实际应用。

模拟退火的算法,得到许多研究者从不同角度和方面进行大量的研究,得到了广泛的应用。

在BM 网络中为了达到最优搜索结果,更是对模拟退火算法的应用与实现进行了充分的研究,而其中的一个重要问题就是温度降低策略。

Kirkpatrick 等进行了大量的研究,并给出了一些有用的原则。

①初始温度:选取足够高的0T ,保证存在所有可能的转移状态。

②温度下降策略:有不同降温策略,例如()()⋅⋅⋅==+2,1,1k k T k T λ此处λ是一小于却接近与1的常数。

例如可在0.8至0.99之间取值。

另外如()()⋅⋅⋅=+=+2,1,1lg 10k k T k T ③终止温度:如果在连续的若干个温度下没有可接受的新状态,算法结束。

BM 网络的运行采用了模拟退火算法,具体步骤如下:设BM 网络具有N 个神经元,其中P 个为显见神经元,Q 个为隐见神经元;j i ,号神经元的连接权值为()N j i w ,,2,1,ij ⋅⋅⋅=。

请特别注意,这里讨论的是网络工作阶段的运行问题。

ij w 是已训练的最优权值。

第一步:网络初始化。

设定初始温度0T 、终止温度end T 、神经元输出取1的概率阈值ρ。

第二部:逐一调整每一个神经元的状态。

首先,在温度()k T 条件下,随机选取网络中的一个神经元i ,计算神经元i 的净输入∑-≠==1,0N i j j j ij i x w I若0>i I 即能量差i E ∆>0,由前述分析知,i x 取1降低网络能量,故兑现之u ,取()11=+k x i 。

若0<i I 即能量差i E ∆<0,则()1+k x i 按概率取值。

先计算取1概率()()T I i j e x p /111-+== 若()ρ>k p i ,取()11=+k x i ,若()ρ<k p i ,取()k x k x i i =+)1(。

然后,判断网络是否是一个局部稳态,若是,则转入第三步,降低温度,实施退火;若不是一个局部稳态,则反复随机选取另一个神经元重复本步过程,直到达到一个局部稳态。

第三步:模拟退火。

重新逐一调整每一神经元的状态。

按()()1,1<=+λλk T k T 等策略降低系统温度,重复第二步工作。

第四步:终止。

条件终止:如果在连续的若干个温度下没有可接受的新状态,算法结束。

无条件终止:()end T k T >+1,算法结束。

4.BM 机的应用介绍BM 网络的应用结果的文献相对其它类型的网络少得多,其原因在前面已经提及,主要就是计算工作量太大,限制了应用者的兴趣。

但是许多研究者致力于网络模型和计算方法改进的研究,还取得了一些重要进展,在各个技术领域的最优化处理应用也相当的广泛。

目前BM 机已经广泛应用到图像、声纳、雷达等模式识别领域。

下面结合一些实际的应用来具体介绍一下。

4.1 BM 在最优化计算方面的应用目前已有许多利用BM 进行一类复杂决策问题的BM 求解实例。

本节重点介绍用遗传算法优化的BM 机。

由于人工神经网络自身具有并行性、鲁棒性等特点,附以一些其他算法,有可能解决目前优化设计领域中存在的一些问题。

国内外已有很多学者对此进行了研究,也取得了令人满意的结果。

目前BM 机已经广泛应用到图像、声纳、雷达等模式识别领域。

但是BM 机运用模拟退火算法学习理论上能跳出局部最优值而获得全局最优值或者全局最优值的近似值,是一种功能比较强大的网络。

但是其各个节点状态的变化是个异步的过程,并且在权值调整时调整量的大小不容易确定。

遗传算法是一种并行计算的智能优化算法,并且对于待寻优的函数无连续性、可微性等限制,因而应用范围较广。

将遗传算法应用于BM 机的学习中,用其并行寻优能力调整BM 机的权值变化,实现了不通过复杂的概率统计调整BM 机的权值,同样训练出来符合要求的网络。

4.1 .1 算法原理BM 机学习过程中,在正向学习阶段和反向学习阶段,网络中的自由活动的节点的输出状态按概率: T E i i eP /11∆-+= (4-1) 进行改变。

式中,T 为网络的温度,i E ∆为由节点状态的变化而引起的网络能量的变化值。

并且经过模拟退火算法不断降低网络的温度,最终使网络达到热平衡状态。

当正向学习阶段的网络和反向学习阶段的网络都达到热平衡状态时,统计网络中的任意两个节点同时为1的平均概率,根据概率统i 为由节点状态的变化而引起的网络能量的变化值。