Quality_Pyramid_08_10_05 (course number)

python过拟合程度的评价代码

python过拟合程度的评价代码Python中有很多评价过拟合程度的代码,对于机器学习和深度学习的应用非常有用。

下面是一个简单的Python代码示例,用于评价过拟合程度:```import numpy as npimport matplotlib.pyplot as plt# 生成样本数据X = np.linspace(-np.pi, np.pi, 100)y = np.sin(X)# 添加噪声y = y + np.random.normal(0, 0.1, len(X))# 将数据分为训练集和测试集train_X = X[:80]train_y = y[:80]test_X = X[80:]test_y = y[80:]# 训练模型model = LinearRegression()model.fit(train_X.reshape(-1, 1), train_y.reshape(-1, 1))# 使用模型进行预测train_pred = model.predict(train_X.reshape(-1, 1))test_pred = model.predict(test_X.reshape(-1, 1))# 计算训练误差和测试误差train_error = np.mean((train_pred - train_y.reshape(-1, 1)) ** 2)test_error = np.mean((test_pred - test_y.reshape(-1, 1)) ** 2)# 绘制图像plt.plot(X, y, label='True Function')plt.plot(train_X, train_pred, label='Training Prediction')plt.plot(test_X, test_pred, label='Testing Prediction') plt.legend()plt.title(f'Train Error: {train_error:.2f} Test Error: {test_error:.2f}')plt.show()```这个代码示例使用线性回归作为模型,并生成一个正弦函数的样本数据。

recursive feature pyramid代码

recursive feature pyramid代码Recursive Feature Pyramid代码是用于计算机视觉领域中的图像识别任务的一种算法。

该算法基于特征金字塔理论,通过递归地应用特征金字塔来提取图像中不同层次的特征,最终达到高精度的图像识别结果。

在算法实现上,Recursive Feature Pyramid代码主要由以下几部分构成:1.特征金字塔构建部分。

通过对输入图像进行一系列的卷积操作,逐渐缩小图像尺寸并提取更高层次的特征。

这一部分会生成一系列不同分辨率的特征图像。

2.特征金字塔融合部分。

通过对不同分辨率的特征图像进行卷积操作和上采样操作,将不同分辨率的特征图像进行融合,得到更加丰富的特征表示。

3.分类器部分。

根据融合后的特征图像进行分类,实现图像识别任务。

递归地应用特征金字塔构建和融合可以提取出图像中更加丰富的特征信息,从而提高图像识别的精度。

同时,该算法可以在不同尺寸的图像上进行识别,具有很好的鲁棒性。

以下是一段简单的Recursive Feature Pyramid代码实现:```pythondef recursive_feature_pyramid(image, max_levels, stride):feature_pyramid = []for i in range(max_levels):pyramid_image = imagefor j in range(i):pyramid_image = resize_image(pyramid_image, stride) feature = extract_feature(pyramid_image)feature_pyramid.append(feature)return feature_pyramiddef feature_pyramid_fusion(feature_pyramid):fused_feature = Nonefor feature in reversed(feature_pyramid):if fused_feature is None:fused_feature = featureelse:fused_feature = convolve(fused_feature, feature)fused_feature = upsample(fused_feature)return fused_featuredef image_classification(image, max_levels, stride):feature_pyramid = recursive_feature_pyramid(image,max_levels, stride)fused_feature = feature_pyramid_fusion(feature_pyramid)result = classifier(fused_feature)return result```以上代码中,recursive_feature_pyramid函数实现了特征金字塔的构建,feature_pyramid_fusion函数实现了特征金字塔的融合,image_classification函数实现了图像分类任务。

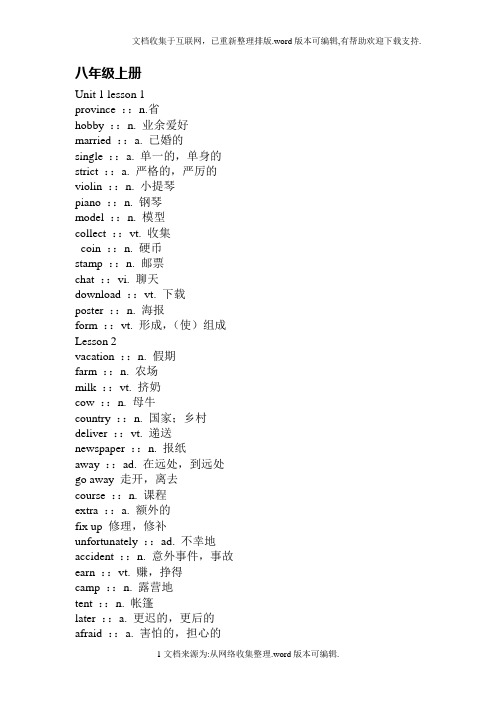

北师大八年级上学期课本教材单词汇总全

八年级上册Unit 1 lesson 1province ::n.省hobby ::n. 业余爱好married ::a. 已婚的single ::a. 单一的,单身的strict ::a. 严格的,严厉的violin ::n. 小提琴piano ::n. 钢琴model ::n. 模型collect ::vt. 收集coin ::n. 硬币stamp ::n. 邮票chat ::vi. 聊天download ::vt. 下载poster ::n. 海报form ::vt. 形成,(使)组成Lesson 2vacation ::n. 假期farm ::n. 农场milk ::vt. 挤奶cow ::n. 母牛country ::n. 国家;乡村deliver ::vt. 递送newspaper ::n. 报纸away ::ad. 在远处,到远处go away 走开,离去course ::n. 课程extra ::a. 额外的fix up 修理,修补unfortunately ::ad. 不幸地accident ::n. 意外事件,事故earn ::vt. 赚,挣得camp ::n. 露营地tent ::n. 帐篷later ::a. 更迟的,更后的afraid ::a. 害怕的,担心的Lesson 3win ::vt. (获)胜,取得胜利work out 做大运动量的锻炼invite ::vt. 邀请score ::n. 得分vt. 记分goal ::n. (球赛)得分;目标ant ::n. 蚂蚁except ::prep. 除了……之外enormous ::a.巨大的,庞大的Lesson 4nothing ::neg pron. 无get together 聚会,联欢lunchtime ::n. 午餐时间appointment ::n. 约会,约定Expansion 1horseback ::n. 马背rock ::n. 岩石rock climbing 攀岩scary ::a. 引起惊慌的;害怕的program ::n. 节日,节目till ::prep. 直到conj. 在……以前,直到……为止midnight ::n. 午夜probably ::ad. 大概,或许Unit 2 lesson5article ::n. 文章project ::n. 工程;方案totally ::ad. 完全地,整体地accept ::vt. 接受refuse ::vt. 拒绝reason ::n. 理由,原因tonight ::ad. 今晚,今夜tomorrow ::n. 明天guest ::n. 客人,来宾stay up 不睡觉;熬夜fishing ::n. 钓鱼Lesson 6future ::n. 未来,将来grow ::vi. 生长,成长grow up 长大成人,成长sports car 跑车poor ::a. 贫穷的,可怜的cure ::n. 药物,治疗方法aids ::n. 艾滋病college ::n. 学院,大学general ::adj. 普遍的,总体的in general 通常,大体上dumb ::a. 哑的,无说话能力的part-time 兼职的less ::a. 较少的though ::ad.&conj. 虽然,尽管first of all 首先find ::vt. 发现,找到find out 发现,查明why ::ad. 为什么checkup 核对,检验energy ::n. 精力,活力appetite ::n. 食欲,胃口discover ::vt. 发现Lesson 7teenage ::a. 十几岁的percent ::n. 百分比,百分数ticket ::n. 票,入场券overweight ::a. 超重mexican ::a. 墨西哥的n. 墨西哥人iced ::a. 冰冷的,冰冻的pocket ::n. 衣袋,口袋pocket money 零用钱babysitting ::n. 临时保姆,照顾婴儿boat ::n. 小船key ::n. 钥匙ring ::n. 环状物luck ::n. 运气Lesson 8term ::n. 学期progress ::n. 进步make progress 取得进步little by little 渐渐地vocabulary ::n. 词汇in front of 在……前面at least 至少confident ::a. 自信的grammar ::n. 语法rule ::n. 规则improve ::vt. 改进,提高skill ::n. 技能,技巧habit ::n. 习惯advantage ::n. 优势,有利条件take advantage of 利用offer ::n.&vt. 提议,提供worry about 担心take part in 参加mistake ::n. 错误responsible ::a. 有责任的be responsible for 对……负责Expansion 2concentrate ::vi. 全神贯注于graduate ::n. (大学)毕业生vi. 毕业language ::n. 语言keep fit 保持健康the great sphinx (古埃及)狮身人面像egypt ::n. 埃及pyramid ::n. 金字塔camel ::n. 骆驼law ::n. 法律,法规Unit 3 lesson9india ::n. 印度western ::a.西方的mountion ::n. 山,山脉ancient ::a. 远古的be famous for 因……著名Lesson 10the amazon river 亚马孙河the nile river 尼罗河the sahara desert 撒哈拉沙漠the gobi desert 戈壁滩mount qomolangma 珠穆朗玛峰lake baikal 贝加尔湖the caspian sea 里海foot ::n. 英尺(pl.feet)eastern ::a. 东方的;东部的pacific ::adj. 和平的,太平的the pacific ocean 太平洋atlantic ::adj. 大西洋的n. 大西洋the atlantic oceanthe indian ocean 印度洋in terms of 根据,按照bit ::n. 少量a bit 一点儿compare ::vt. 比较compare…with 与……相比hometown ::n. 故乡certainly ::ad. 的确,当然Lesson 11attraction ::n. 吸引,吸引力traditional ::a. 传统的historically ::ad. 历史地used ::adj. 已使用过的,已习惯的used to 过去常常clean ::a. 清洁的,干净的vt.打扫than ::conj. 比thousand ::num. 一千basic ::a. 基本的peaceful ::a. 和平的,平静的prohibit ::vt. 禁止,阻止toy ::n. 玩具Lesson 12dust ::n. 尘土,灰尘storm ::n. 风暴,暴风雨dust storm 沙尘暴danger ::n. 危险during ::prep. 在……期间reach ::vt. 到达separate ::vt. 分开;隔离government ::n. 政府become ::vi. 变成,成为salty ::a. 有盐分的,咸的plant ::n. 植物,工厂no longer 不再clear ::a. 清楚的,清晰的fisherman ::n. 渔夫sand ::n. 沙子wasteland ::n. 荒地lift up 提起来everybody ::pron. 每个人,人人complain ::vi. 抱怨condition ::n. 条件;情形soon ::ad. 立刻,不久promise ::vt.&n. 许诺,允诺,保证village ::n. 乡村affect ::vt. 影响,感动Expansion 3volcano ::n. 火山crater ::n. 火山口bring ::vt. 拿来,带来another ::a. 另一个breeze ::n. 微风vi. 吹微风itself ::pron. 它自己convenient ::a. 便利的,方便的service ::n. 服务on the other hand 另一方面conference ::n. 会议business ::n. 交易,生意;事情personally ::ad. 亲自worth ::a. 值钱的;值得的Unit 4 lesson13story ::n. 故事,小说talent ::n. 天才,才能could ::v. can的过去式already ::ad. 已经keyboard ::n.(钢琴的)键盘invent ::vt. 发明comic ::a. 喜剧的performance ::n. 表演night ::n. 夜晚count ::vt. 数copy ::vt. 模仿beat ::vt. 打;打败act ::vi. 扮演Lesson 14card ::n. 卡片suspect ::n. 嫌疑犯lord ::n. 封建领主,统治者tower ::n. 塔,城堡shine ::vi. 照耀n. 光亮servant ::n. 仆人front ::n. 前面wait ::vi. (~for)等待,steal ::vt. 偷,偷窃gold ::n. 黄金;金色evidence ::n. 证据return ::vi. 返回reply ::n.&vi. 答复,回答myself ::pron. 我自己lady ::n. 女士,夫人,小姐gardener ::n. 园丁just now 刚刚trust ::vt. 信任,信赖garden ::n. 花园Lesson 15customer ::n. 顾客suddenly ::ad. 突然地appear ::vi. 出现streetlight ::n. 街灯suitcase ::n. 手提箱wave ::vi. (挥手)示意;致意paper ::n. 纸silence ::n. 沉默stoplight ::n. 停止行进标志mirror ::n. 镜子look at 看cry ::vi. 哭,叫,喊inside ::prep. 在……之内knock ::(~on)vi. 敲,敲打waste ::vt. 浪费empty ::a. 空的die ::vi. 死亡light ::n. 光;灯Lesson 16save ::v. 解救;保存;储蓄burn ::v. 烧,烧焦flame ::n. 火焰ladder ::n. 梯子emergency ::n. 紧急事件(情况)place ::v. 放置truck ::n. 卡车ambulance ::n. 救护车firefighter ::n. 救火队员put out 扑灭,熄灭take care of 照顾bravely ::ad. 勇敢地sadly ::ad. 悲痛地,悲哀地scene ::n. 现场,场面,情景knife ::n. 刀fork ::n. 叉casually ::ad.偶然地;随便地formally ::ad.正式地Expansion 4assistant ::n.助手,助理investigate ::vt.调查,研究kill ::vt.杀死hero ::n.英雄;男主角crime ::n.犯罪officer ::n.政府官员,军官in the end 最后,终于murder ::n.谋杀death ::n.死亡sign ::n.征兆,迹象perhaps ::ad.或许birthplace ::n.诞生地well-know ::a.众所周知的Unit 5 Lesson 17fair ::a.公平的stubborn ::a.顽固的,固执的motorcycle ::n.摩托车seem ::vi.好像,似乎stupid ::a.愚笨的trusting ::a.表示信任的look after 照顾complaint ::n.诉苦,抱怨surfboard ::n.冲浪板point ::n.点;尖端have a point 有道理Lesson 18mood ::n.心情,情绪deal with 安排,处理annoyed ::a.烦恼的yourself ::pron.你自己put off 推迟,拖延until ::prep.到……为止conj.直到……才lie ::n.说谎tell lies 说谎absent-minded ::a.心不在焉的hardworking ::a.苦干的,不辞辛劳的impatient ::a.不耐烦的,急躁的moody ::a.喜怒无常的self-centered ::a.自我中心的humorous ::adj.幽默的,诙谐的helpful ::a.有帮助的,有用的lonely ::a.孤独的,寂寞的laugh ::n. &vi.笑sporty ::a.擅长运动的loud ::a. & ad.高声,大声shout ::n. &vi.呼喊,呼叫Lesson 19goldfish ::n.金鱼mouse ::n.老鼠(pl.mice)turtle ::n.海龟experiment ::n.实验take place 发生horse ::n.马a number of 许多的treatment ::n.对待,治疗calm ::a.平静的,镇静的criticize ::vt.批评,责备secret ::n.秘密keep a secret 保守秘密feed ::vt.喂养,饲养goat ::n.山羊note ::n.笔记,记录take notes 做笔记wonder ::vi.,vt.对……感到惊讶;想知道power ::n.能力,力量guard ::vt.保卫,警卫Lesson 20careless ::a.粗心的complete ::a.完全的;完成的patient ::a.有耐心的tidy ::a.整齐的,整洁的careful ::a.小心的,仔细的be careful with 小心electricity ::n.电save electricity 节电rubbish ::n.垃圾,废物metal ::n.金属plastic ::n.塑料trashcan ::n.垃圾桶right ::a.合适的,恰当的make sure 确定drip ::vi.滴下,滴水Expansion 5have problem with 在……(方面)有问题pick up 捡起shout at sb.(向某人)大声喊叫heavy metal music 重金属音乐ugly ::a.丑陋的,难看的operation ::n.手术Unit 6Lesson 21gift ::n.赠品,礼物decoration ::n.装饰,装饰品last ::vi.持续;维持celebrate ::vt.庆祝decorate ::vt.装饰silver ::n.银,银色common ::a.共同的;普通的colored ::a.有颜色的angel ::n.天使at the top of 在……顶端send ::vt.送,寄,发送message ::n.消息;讯息greeting ::n.祝贺,问候christmas eve 圣诞节前夕include ::vt.包括,包含wise ::a.英明的,明智的Lesson 22from top of bottom 从头至尾window frame 窗框suppose ::vt.推想;假设be supposed to 应该poem ::n.诗,韵文dumpling ::n.饺子meatball ::n.肉丸子spare ::a.多余的,剩下的certain ::a.某一个,某些packet ::n.小包裹Lesson 23clap ::vi.鼓掌,轻拍cheer ::vi.欢呼arrive ::vi.到达,抵达nearby ::a.附近的,邻近的countdown ::n.倒数计秒pole ::n.棒,杆look up at 向上看shoulder ::n.肩,肩部culture ::n.文化jewish ::a.犹太人somewhere ::ad.某处,在某处Lesson 24surprise ::n.惊讶,惊喜fortieth ::num.第四十notice ::n.通知,布告vt.注意到candle ::n.蜡烛breath ::n.呼吸,气息,短暂的休息out of breath 上气不接下气direction ::n.方向celebration ::n.庆祝,庆典epiphany ::n.主显节doll ::n.洋娃娃,玩偶figure ::n.(人或动物的)像Expansion 6candy ::n.糖果trick ::n.诡计,恶作剧treat ::v.对待;治疗jack-o’ lantern 杰克灯,空心南瓜灯scare ::vt.惊吓public ::a.公众的,公共的roast turkey 烤火鸡envelope ::n.信封set off 燃放(焰火,爆竹)firework ::n.焰火。

python的dinitializers.randomnormalt函数参数 -回复

python的dinitializers.randomnormalt函数参数-回复在Python 中,初始化函数isinstance.random.normal 的目的是生成高斯(正态)分布的随机数。

这个函数的参数控制生成的随机数的平均值(均值)和标准差。

本文将逐步介绍并解释random.normal 函数的各个参数。

random.normal 函数参数如下:- loc(均值):即高斯分布的均值(中心位置)。

- scale(标准差):即高斯分布的标准差(数据分散程度)。

- size(形状):用于指定生成随机数的形状。

现在,让我们一步一步地深入了解这些参数的作用和用法。

1. 均值参数(loc)均值参数(loc)用于指定生成随机数的高斯分布的均值(中心位置)。

它控制生成的随机数在均值附近的分布。

如果不指定该参数,它的默认值为0。

下面的例子演示了如何使用均值参数来生成均值为5 的高斯分布的随机数:pythonimport numpy as nprandom_numbers = np.random.normal(loc=5, size=1000)在上述示例中,我们使用`np.random.normal` 函数生成了一个含有1000 个随机数的一维数组。

这些随机数遵循了均值为5 的高斯分布。

2. 标准差参数(scale)标准差参数(scale)用于指定生成的随机数的高斯分布的标准差(数据分散程度)。

它控制生成的随机数分布的丰满程度,也称为分散程度。

如果不指定该参数,它的默认值为1。

下面的例子演示了如何使用标准差参数来生成均值为0,标准差为2 的高斯分布的随机数:pythonimport numpy as nprandom_numbers = np.random.normal(scale=2, size=1000)在上述示例中,我们使用`np.random.normal` 函数生成了一个含有1000 个随机数的一维数组。

分层采样函数 python

分层采样函数 python分层采样是一种常用的采样方法,它可以使得不同层次的数据在采样时被平等对待。

在python中,我们可以通过以下代码实现分层采样函数:```pythonimport numpy as npdef stratified_sampling(x, y, num_per_class):'''分层采样函数:param x: 特征数据:param y: 标签数据:param num_per_class: 每个类别需要采样的样本数:return: 采样后的特征和标签数据'''n_classes = np.unique(y).shape[0]sample_per_class = num_per_class // n_classessampled_x = []sampled_y = []for i in range(n_classes):idxs = np.where(y == i)[0]idxs = np.random.choice(idxs, sample_per_class, replace=False)sampled_x.append(x[idxs])sampled_y.append(y[idxs])return np.vstack(sampled_x), np.hstack(sampled_y)```其中,参数x是特征数据,y是标签数据,num_per_class是每个类别需要采样的样本数。

函数先计算出类别的个数n_classes,然后根据num_per_class和n_classes计算出每个类别需要采样的样本数sample_per_class。

接着,对于每个类别,函数通过np.where函数找到对应的索引idxs,并从中随机选择sample_per_class个样本。

最后,把采样后的特征和标签数据使用np.vstack和np.hstack函数纵向合并和横向合并即可。

Pytorch使用ReduceLROnPlateau来更新学习率

Pytorch使⽤ReduceLROnPlateau来更新学习率如需了解完整代码请跳转到:缘由⾃⼰之前写过⼀个,其中感觉依据是否loss升⾼或降低的次数来动态更新学习率,感觉是个挺好玩的东西,⾃⼰弄了好久都设置错误,今天算是搞出来了!解析说明torch.optim.lr_scheduler.ReduceLROnPlateau(optimizer, mode='min', factor=0.1, patience=10, verbose=False, threshold=0.0001, threshold_mode='rel', cooldown=0, min_lr=0, eps=1e-08)在发现loss不再降低或者acc不再提⾼之后,降低学习率。

各参数意义如下:参数含义mode'min'模式检测metric是否不再减⼩,'max'模式检测metric是否不再增⼤;factor触发条件后lr*=factor;patience不再减⼩(或增⼤)的累计次数;verbose触发条件后print;threshold只关注超过阈值的显著变化;threshold_mode有rel和abs两种阈值计算模式,rel规则:max模式下如果超过best(1+threshold)为显著,min模式下如果低于best(1-threshold)为显著;abs规则:max模式下如果超过best+threshold为显著,min模式下如果低于best-threshold为显著;cooldown触发⼀次条件后,等待⼀定epoch再进⾏检测,避免lr下降过速;min_lr最⼩的允许lr;eps如果新旧lr之间的差异⼩与1e-8,则忽略此次更新。

例⼦,如图所⽰的y轴为lr,x为调整的次序,初始的学习率为0.0009575则学习率的⽅程为:lr = 0.0009575 * (0.35)^ximport mathimport matplotlib.pyplot as plt#%matplotlib inlinex = 0o = []p = []o.append(0)p.append(0.0009575)while(x < 8):x += 1y = 0.0009575 * math.pow(0.35,x)o.append(x)p.append(y)print('%d: %.50f' %(x,y))plt.plot(o,p,c='red',label='test') #分别为x,y轴对应数据,c:color,labelplt.legend(loc='best') # 显⽰label,loc为显⽰位置(best为系统认为最好的位置)plt.show()难点我感觉这⾥⾯最难的时这⼏个参数的选择,第⼀个是初始的学习率(我⽬前接触的miniest和下⾯的图像分类貌似都是0.001,我这⾥训练调整时才发现⾃⼰设置的为0.0009575,这个值是上⼀个实验忘更改了,但发现结果不错,第⼀次运⾏该代码接近到0.001这么⼩的损失值),这⾥⾯的乘积系数以及判断说多少次没有减少(增加)后决定变换学习率都是难以估计的。

grubbs检验法python

grubbs检验法pythonGrubbs检验(又称格拉布斯检验)是一种用于检测数据集中是否存在异常值(outlier)的统计方法。

在Python中,可以使用SciPy库来进行Grubbs检验。

首先,你需要安装SciPy库,如果你还没有安装的话,可以使用pip命令进行安装:python.pip install scipy.一旦安装完成,你可以使用SciPy中的`scipy.stats`模块来进行Grubbs检验。

以下是一个简单的示例代码,演示了如何在Python中使用Grubbs检验:python.import numpy as np.from scipy.stats import t.def grubbs_test(data):mean = np.mean(data)。

std_dev = np.std(data)。

n = len(data)。

numerator = max(abs(data mean))。

g_calculated = numerator / std_dev.critical_value = t.ppf(1 0.05 / (2 n), n 2)。

threshold = (n 1) / np.sqrt(n)np.sqrt(critical_value 2 / (n 2 + critical_value 2))。

if g_calculated > threshold:return True, max(data)。

else:return False, None.# 示例数据。

data = [10.4, 10.8, 10.6, 10.5, 200.7]# 进行Grubbs检验。

is_outlier, outlier_value = grubbs_test(data)。

if is_outlier:print(f"发现异常值 {outlier_value}")。

else:print("未发现异常值")。

pytorch框架下的参数量化(量化为任意位数或2的幂次方)

pytorch框架下的参数量化(量化为任意位数或2的幂次方)PyTorch是一个开源的深度学习框架,提供了进行神经网络训练和推理的功能。

参数量化是一种优化神经网络模型的技术,可以降低模型的存储需求和计算成本。

在PyTorch框架下,可以对模型的参数进行量化,使其占用更少的存储空间,并加速推理速度。

参数量化是指将浮点数表示的参数转化为整数表示,通常通过缩放和舍入操作实现。

在量化的过程中,可以指定量化的位数或量化为2的幂次方。

下面将详细介绍如何在PyTorch中对模型参数进行量化,并解释其中的原理和优势。

1. PyTorch中的参数量化方法在PyTorch中,可以使用Quantization模块来实现参数量化。

首先,需要将模型转化为量化支持的形式,可以通过将模型实例对象包装在torch.quantization.QuantWrapper类中实现:```pythonimport torchimport torch.nn as nnimport torch.quantizationclass MyModel(nn.Module):def __init__(self):super(MyModel, self).__init__self.conv = nn.Conv2d(3, 64, kernel_size=3, stride=1, padding=1)self.relu = nn.ReLU(inplace=True)def forward(self, x):x = self.conv(x)x = self.relu(x)return xmodel = MyModelquant_model = torch.quantization.QuantWrapper(model)```然后,可以使用torch.quantization.quantize方法对模型参数进行量化:```pythonquantized_model = torch.quantization.quantize(quant_model, default_qconfig=torch.quantization.default_qconfig)```上述代码中,torch.quantization.default_qconfig用于获取默认的量化配置(位数、量化方式等),并应用于量化模型。

permutation_importance()方法

permutation_importance()方法`permutation_importance()` 是一个在 scikit-learn 的 `imbalanced-learn` 库中用于评估模型性能的函数。

这个函数通过打乱特征的顺序来评估模型性能的变化,从而得到每个特征对模型预测的重要性。

具体来说,`permutation_importance()` 函数会对训练数据集中的每一个样本的每一个特征进行随机打乱,然后使用打乱后的数据重新训练模型并评估模型的性能。

通过比较打乱前后的模型性能,我们可以得到每个特征对模型预测的影响。

下面是一个简单的例子:```pythonfrom _sampling import SMOTEfrom import make_classificationfrom import RandomForestClassifierfrom _selection import train_test_splitfrom import accuracy_scorefrom import permutation_importance生成一个不平衡的二分类数据集X, y = make_classification(n_classes=2, class_sep=2,weights=[, ], n_informative=3, n_redundant=1, flip_y=0,n_features=20, n_clusters_per_class=1,n_samples=1000, random_state=10)划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=, random_state=42)使用SMOTE进行过采样处理,解决类别不平衡问题sm = SMOTE(sampling_strategy='auto', random_state=42)X_train_smote, y_train_smote = _resample(X_train, y_train)使用随机森林分类器进行训练clf = RandomForestClassifier(random_state=42)(X_train_smote, y_train_smote)使用测试集进行预测y_pred = (X_test)计算准确率作为评估指标score = accuracy_score(y_test, y_pred)print(f"Accuracy: {score:.3f}")使用permutation_importance方法评估特征的重要性result = permutation_importance(clf, X_test, y_test, n_repeats=10, random_state=42, n_jobs=2)()```在这个例子中,我们首先生成了一个不平衡的二分类数据集,然后使用SMOTE进行过采样处理以解决类别不平衡问题。

用Python制作基数估计器的教程

用Python制作基数估计器的教程用Python制作基数估计器的教程假设你有一个很大的数据集,非常非常大,以至于不能全部存入内存。

这个数据集中有重复的数据,你想找出有多少重复的数据,但数据并没有排序,由于数据量太大所以排序是不切实际的。

你如何来估计数据集中含有多少无重复的数据呢?这在许多应用中是很有用的,比如数据库中的计划查询:最好的查询计划不仅仅取决于总共有多少数据,它也取决于它含有多少无重复的数据。

在你继续读下去之前,我会引导你思考很多,因为今天我们要讨论的算法虽然很简单,但极具创意,它不是这么容易就能想出来的。

一个简单的朴素基数估计器让我们从一个简单的例子开始吧。

假定某人以下列方式来生成数据:生成 n 个充分分散的随机数任意地从中选择一些数字,使其重复某次打乱这些数字我们怎么估计结果数据集中有多少非重复的数字呢?了解到原来的数据集是随机数,且充分分散,一个非常简单的方法是:找出最小的数字。

如果最大的可能的数值是 m,最小的值是 x,我们可以估计大概有 m/x 个非重复的数字在数据集里面。

举个例子,如果我们扫描一个数字在 0 到 1 之间的数据集,发现最小的数字是 0.01。

我们有理由猜想可能数据集里大概有 100 个非重复的数字。

如果我们找到一个更小的最小值的话,可能包含的数据个数可能就更多了。

请注意不管每个数字重复了多少次都没关系,这是很自然的,因为重复多少次并不会影响?min?的输出值.这个过程的优点是非常直观,但同时它也很不精确。

不难举出一个反例:一个只包含少数几个非重复数字的数据集里面有一个很小的数。

同样的一个含有许多非重复数字的数据集含有一个比我们想像中更大的最小值,用这种估计方法也会很不精确。

最后,很少有数据充分分散充分随机的数据集。

但是这个算法原型给了我们一些灵感使得我们有可能达到我们的目的,我们需要更精致一些的算法.基于概率的计数第一处改进来来自 Flajolet 和 Martin 的论文 Probabilistic Counting Algorithms for Data Base Applications。