好程序员-大数据教程Hadoop全分布安装(非HA)

Hadoop完全分布式搭建

完全分布式环境安装(完整亲测)一、安装linu*系统Hadoop需要至少3个节点才能算是完全分布式环境,需要在虚拟机中安装3个linu*操作系统,比较快速的方式是通过安装一个操作系统,再复制2个操作系统。

这一步也可以在最后做,完全配置好一台linu*系统环境之后再克隆,会节省一些时间,看个人的习惯。

过程如下:1、使用VMware的克隆功能2、选择创建完成克隆3、输入主机名称,完成克隆操作。

最好配置每台机器的ip地址,否则每次开机地址都可能发生变化。

通过ifconfig命令查看当前IP地址(因为我使用的是centerOS7.5 所以显示eno16777736 其实和eth0是一样的)修改IP地址登陆图形界面修改固定IP三、配置hosts文件三台机器都配置相同的hosts同时需要把主机名改掉四、增加Hadoop允许账号[rootlocalhost ~]# groupadd hadoop //添加组[rootlocalhost ~]# useradd -s /bin/bash grid -g hadoop -G root//添加用户属于hadoop和root组[rootlocalhost ~]# passwd grid //添加密码更改用户grid 的密码。

新的密码:无效的密码:密码少于8 个字符重新输入新的密码:passwd:所有的身份验证令牌已经成功更新。

[rootlocalhost ~]# su - grid //切换到grid用户[gridlocalhost ~]$五、配置ssh免密码连入1、产生公共秘钥2、复制公共秘钥三台机器都执行3、需要把maste的公钥,写到node1和node2 实现免密码登陆[gridnode2 .ssh]$ scp gridmaster:~/.ssh/id_dsa.pub ./master_dsa.pub//把master的公钥复制到本地The authenticity of host 'master (192.168.0.100)' can't be established.ECDSA key fingerprint is 38:f8:18:b1:3c:e6:c6:a7:52:80:dc:97:3f:ba:de:35.Are you sure you want to continue connecting (yes/no)" yesWarning: Permanently added 'master,192.168.0.100' (ECDSA) to the list of known hosts. gridmaster's password:id_dsa.pub 100% 616 0.6KB/s 00:00[gridnode2 .ssh]$ cat master_dsa.pub >> authorized_keys //master的公钥写入keys [gridnode2 .ssh]$然后在master 输入[gridmaster ~]$ ssh node1 //首次会询问,退出之后再次连接不再询问五、下载并解压hadoop下载hadoop 1.0.1版本使用解压缩命令解压缩六、配置namenode,修改site文件到目前为止,准备工作已经完成,下面开始修改hadoop的配置文件了,即各种site文件,文件存放在/hadoop/conf下,主要配置core-site.*ml、hdfs-site.*ml、mapred-site.*ml这三个文件。

hadoop的安装与配置(完全分布式)

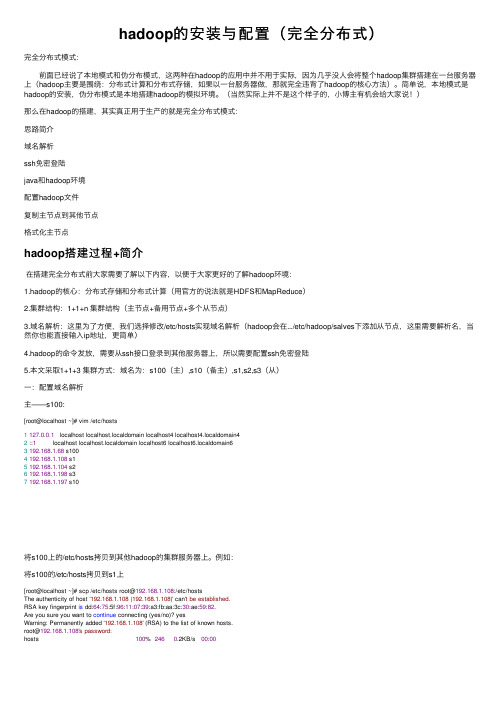

hadoop的安装与配置(完全分布式)完全分布式模式: 前⾯已经说了本地模式和伪分布模式,这两种在hadoop的应⽤中并不⽤于实际,因为⼏乎没⼈会将整个hadoop集群搭建在⼀台服务器上(hadoop主要是围绕:分布式计算和分布式存储,如果以⼀台服务器做,那就完全违背了hadoop的核⼼⽅法)。

简单说,本地模式是hadoop的安装,伪分布模式是本地搭建hadoop的模拟环境。

(当然实际上并不是这个样⼦的,⼩博主有机会给⼤家说!)那么在hadoop的搭建,其实真正⽤于⽣产的就是完全分布式模式:思路简介域名解析ssh免密登陆java和hadoop环境配置hadoop⽂件复制主节点到其他节点格式化主节点hadoop搭建过程+简介在搭建完全分布式前⼤家需要了解以下内容,以便于⼤家更好的了解hadoop环境:1.hadoop的核⼼:分布式存储和分布式计算(⽤官⽅的说法就是HDFS和MapReduce)2.集群结构:1+1+n 集群结构(主节点+备⽤节点+多个从节点)3.域名解析:这⾥为了⽅便,我们选择修改/etc/hosts实现域名解析(hadoop会在.../etc/hadoop/salves下添加从节点,这⾥需要解析名,当然你也能直接输⼊ip地址,更简单)4.hadoop的命令发放,需要从ssh接⼝登录到其他服务器上,所以需要配置ssh免密登陆5.本⽂采取1+1+3 集群⽅式:域名为:s100(主),s10(备主),s1,s2,s3(从)⼀:配置域名解析主——s100:[root@localhost ~]# vim /etc/hosts1127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain42 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain63192.168.1.68 s1004192.168.1.108 s15192.168.1.104 s26192.168.1.198 s37192.168.1.197 s10将s100上的/etc/hosts拷贝到其他hadoop的集群服务器上。

Hadoop的安装与部署(分布式+非高可用)

Hadoop的安装与部署(分布式+⾮⾼可⽤)* 全⽂的命令都是在登录root账号的情况下执⾏。

⼀、硬件环境假设有3台机,IP及主机名如下:192.168.100.105 c1192.168.100.110 c2192.168.100.115 c3⼆、软件环境操作系统:Ubuntu Server 18.04JDK:1.8.0Hadoop:3.3.0/3.3.1* 这⾥的ZooKeeper、Hadoop根⽬录都放在/home/⽬录下三、系统运⾏环境配置四、部署Hadoop* 以下操作在每台机都要执⾏⼀次1.下载Hadoop安装包2.解压安装包这⾥假定下载的是hadoop-3.3.1.tar.gz⽂件,解压到/usr/bin/⽬录tar -xvf hadoop-3.3.1.tar.gz -C /usr/local/把⽬录名也改⼀下mv /usr/local/hadoop-3.3.1 /usr/local/hadoop3.创建⽬录cd /usr/local/hadoopsudo mkdir hdfssudo mkdir hdfs/datanodesudo mkdir hdfs/namenodesudo mkdir hadoop/logssudo mkdir yarnsudo mkdir yarn/logs4.配置环境变量vim ~/.bashrc添加内容export HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbinexport HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoopexport HADOOP_COMMON_HOME=$HADOOP_HOMEexport HADOOP_MAPRED_HOME=$HADOOP_HOMEexport HADOOP_HDFS_HOME=$HADOOP_HOMEexport YARN_HOME=$HADOOP_HOMEexport HDFS_NAMENODE_USER=rootexport HDFS_DATANODE_USER=rootexport HDFS_SECONDARYNAMENODE_USER=root更新环境变量source ~/.bashrc测试hadoop version5.修改Hadoop的配置(1) 进⼊Hadoop的配置⽂件⽬录cd $HADOOP_CONF_DIR或cd /usr/local/hadoop/etc/hadoop/(2) 编辑hadoop-env.sh⽂件vim hadoop-env.sh查看以下内容,如果没有就加上,如果已有就不⽤改。

大数据Hadoop集群安装部署文档

大数据Hadoop集群安装部署文档一、背景介绍大数据时代下,海量数据的处理和分析成为了一个重要的课题。

Hadoop是一个开源的分布式计算框架,能够高效地处理海量数据。

本文将介绍如何安装和部署Hadoop集群。

二、环境准备1.集群规模:本文以3台服务器组成一个简单的Hadoop集群。

2.操作系统:本文以Linux作为操作系统。

三、安装过程1.安装JavaHadoop是基于Java开发的,因此需要先安装Java。

可以通过以下命令安装:```sudo apt-get updatesudo apt-get install openjdk-8-jdk```2.安装Hadoop```export HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HADOOP_HOME/bin```保存文件后,执行`source ~/.bashrc`使配置生效。

3.配置Hadoop集群在Hadoop安装目录中的`etc/hadoop`目录下,有一些配置文件需要进行修改。

a.修改`hadoop-env.sh`文件该文件定义了一些环境变量。

可以找到JAVA_HOME这一行,将其指向Java的安装目录:```export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64```b.修改`core-site.xml`文件```<property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property>```c.修改`hdfs-site.xml`文件```<property><name>dfs.replication</name><value>3</value></property>```其中,`dfs.replication`定义了数据的副本数,这里设置为34.配置SSH免密码登录在Hadoop集群中,各个节点之间需要进行通信。

hadoop实战系列之hadoop安装教程-北风网课件

配置操作系统的环境变量,以便可以在任何位置运行Hadoop命令。

Hadoop安装步骤

1

解压Hadoop软件包

使用解压工具解压下载的Hadoop软件包到目标文件夹。

2

配置Hadoop环境

修改Hadoop配置文件和环境变量,以适应你的环境和需求。

3

启动Hadoop集群

依次启动NameNode和DataNode,然后启动ResourceManager和NodeManager。

常见问题解答

如何解决Hadoop启动失败问题

检查日志和配置文件,确保正确配置并解决可能的故障。

如何解决Hadoop集群无法连接的问题

检查网络设置并确保各个节点之间可以互相通信。

总结

1 Hadoop的优势和劣势

2 安装Hadoop的难点和注意事项

Hadoop具有高性能、可扩展性和容错性,但 也需要大量的配置和维护工作。

4

检验Hadoop集群是否启动成功

运行一些简单的命令来验证Hadoop集群是否正常运行。

Hadoop集群管理工具

Hadoop集群管理工具介绍

介绍各种Hadoop集群管理工具,如Ambari、 Cloudera等。

使用Ambari管理Hadoop集群

详细介绍如何使用Ambari对Hadoop集群进行管理。

Hadoop实战系列之 Hadoop安装教程-北风网 课件

Hadoop是一个开源的分布式计算平台,用于存储和处理大规模数据集。本课 件将介绍Hadoop的安装过程和常见问题解答。

介绍

Hadoop是什么

Hadoop是一个开源的分布式 计算平台,用于存储和处理 大规模数据பைடு நூலகம்。

hadoop完全分布式配置过程详解

hadoop完全分布式配置过程详解Hadoop全分布搭建⼀.今⽇任务hadoop完全分布式系统搭建⼆.任务内容1.准备软件hadoop-2.6.0-cdh5.7.0.tar.gzjdk-8u161-linux-x64.tar.gzCentos-6.5VirtualBox-5.2.18-124319-Win.exe1. 配置过程第⼀步:配置免密登录1. 新建虚拟机,设置静态ip地址,主机名master,ip以及主机名映射1. 配置免密登陆1. 启动ssh服务Service sshd start1. 配置免密登录,更新公钥第⼆步:复制虚拟机,更改ip主机名和ip映射,分别配置56.2 主机名master,56.3 主机名 slaver1,56.4 主机名slaver2第三步:上传jdk和hadoop到 hadoop⽤户⽬录使⽤sftp上传jdk和hadoop的压缩包到hadoop⽤户⽬录下第四步:jdk和hadoop配置1. 解压⽂件1. 配置环境变量1. 配置hadoop⽂件1. core-site.xml2.hdfs-site.Xml1. mapred-site.xml1. Yarn-site.xml1. Slaver1. 将jdk和hadoop⽂件分发到slaver1 和slaver21. 在master格式化hdfs的namenode 并且启动hdfs,使⽤jps验证启动三.遇到问题1.复制虚拟机后需要⼀个个更改ip包括映射等2.配置好之后启动 slaver1 和slaver2 均没有Java环境,但是jdk已配好四.处理⽅式Slaver1 和slaver2 配置成功环境变量但是启动时提⽰没有java环境的问题,解决⽅式是在master配置好之后,启动时显⽰6个进程,表⽰master主机hadoop⽂件已经全部配置,然后使⽤远程将 master配置好的 hadoop⽂件分发到slaver1和slaver2总结:1. 此处配置主机名和ip映射时,直接将所有的全部配置,以便复制虚拟机时不需要继续修改2. 配置java环境时,确保系统本⾝没有已经安装好的jdk安装包,有则删除3. 配置好环境变量,需要使⽤ source使其⽣效4. 分发⽂件时,最好是将master配置好的hadoop⽂件分发过去,避免出现其他问题5. 启动成功后,master有5个进程,slaver都只有2个进程。

简单梳理hadoop安装流程文字

简单梳理Hadoop安装流程

今儿个咱们来简单梳理下Hadoop的安装流程,让各位在四川的兄弟姐妹也能轻松上手。

首先,你得有个Linux系统,比如说CentOS或者Ubuntu,这点很重要。

然后在系统上整个Java环境,Hadoop 是依赖Java运行的。

把JDK下载安装好后,记得配置下环境变量,就是修改`/etc/profile`文件,把Java的安装路径加进去。

接下来,你需要在系统上整个SSH服务,Hadoop集群内部的通信要用到。

安好SSH后,记得配置下无密钥登录,省得每次登录都要输密码,多麻烦。

Hadoop的安装包可以通过官方渠道下载,也可以在网上找现成的。

下载好安装包后,解压到你的安装目录。

然后就开始配置Hadoop的环境变量,跟配置Java环境变量一样,也是在

`/etc/profile`文件里加路径。

配置Hadoop的文件是重点,都在Hadoop安装目录下的`etc/hadoop`文件夹里。

有`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`这些文件需要修改。

比如`core-site.xml`里要设置HDFS的地址和端口,`hdfs-site.xml`里要设置临时目录这些。

最后,就可以开始格式化HDFS了,用`hdfs namenode-format`命令。

然后启动Hadoop,用`start-all.sh`脚本。

如果一

切配置正确,你就可以用`jps`命令看到Hadoop的各个进程在运行了。

这整个过程看似复杂,但只要你跟着步骤来,注意配置文件的路径和内容,相信你也能轻松搞定Hadoop的安装。

hadoop安装教程

hadoop安装教程hadoop的核⼼Hadoop的核⼼就是HDFS和MapReduce,⽽两者只是理论基础,不是具体可使⽤的⾼级应⽤,Hadoop旗下有很多经典⼦项⽬,⽐如HBase、Hive等,这些都是基于HDFS和MapReduce发展出来的。

要想了解Hadoop,就必须知道HDFS和MapReduce是什么。

HDFSHDFS(Hadoop Distributed File System,Hadoop分布式⽂件系统),它是⼀个⾼度容错性的系统,适合部署在廉价的机器上。

HDFS能提供⾼吞吐量的数据访问,适合那些有着超⼤数据集(large data set)的应⽤程序HDFS的设计特点是:1、⼤数据⽂件,⾮常适合上T级别的⼤⽂件或者⼀堆⼤数据⽂件的存储,如果⽂件只有⼏个G甚⾄更⼩就没啥意思了。

2、⽂件分块存储,HDFS会将⼀个完整的⼤⽂件平均分块存储到不同计算器上,它的意义在于读取⽂件时可以同时从多个主机取不同区块的⽂件,多主机读取⽐单主机读取效率要⾼得多得都。

3、流式数据访问,⼀次写⼊多次读写,这种模式跟传统⽂件不同,它不⽀持动态改变⽂件内容,⽽是要求让⽂件⼀次写⼊就不做变化,要变化也只能在⽂件末添加内容。

4、廉价硬件,HDFS可以应⽤在普通PC机上,这种机制能够让给⼀些公司⽤⼏⼗台廉价的计算机就可以撑起⼀个⼤数据集群。

5、硬件故障,HDFS认为所有计算机都可能会出问题,为了防⽌某个主机失效读取不到该主机的块⽂件,它将同⼀个⽂件块副本分配到其它某⼏个主机上,如果其中⼀台主机失效,可以迅速找另⼀块副本取⽂件。

MapReduce通俗说MapReduce是⼀套从海量·源数据提取分析元素最后返回结果集的编程模型,将⽂件分布式存储到硬盘是第⼀步,⽽从海量数据中提取分析我们需要的内容就是MapReduce做的事了。

Hadoop安装教程分布式配置_CentOS6.5/Hadoop2.6.51 创建hadoop⽤户su # 上述提到的以 root ⽤户登录# useradd -m hadoop -s /bin/bash # 创建新⽤户hadoop如下图所⽰,这条命令创建了可以登陆的 hadoop ⽤户,并使⽤ /bin/bash 作为shell。

简单梳理hadoop安装流程

简单梳理hadoop安装流程Hadoop is an open-source software framework used for storing and processing large datasets on clusters of commodity hardware. Hadoop has gained popularity due to its ability to handle massive amounts of data in a distributed computing environment.Hadoop的一个重要特点是可以在廉价硬件上进行大规模数据的存储和处理,因此广受欢迎。

Before you start installing Hadoop, it is essential to check that your system meets the requirements. You will need a Linux system, as Hadoop is primarily designed to run on Unix-based operating systems. Additionally, you should have Java installed on your system since Hadoop is written in Java.在安装Hadoop之前,需要确保系统符合要求,首先需要一台Linux系统,因为Hadoop主要设计用于运行在基于Unix的操作系统上。

此外,系统还需要安装Java,因为Hadoop是用Java编写的。

The installation process of Hadoop can be quite complex, as it involves setting up various configurations and dependencies. However, there are several resources available online that can guideyou through the installation process step by step. It is crucial to follow these instructions carefully to ensure a successful installation. Hadoop的安装过程可能会相当复杂,因为涉及设置各种配置和依赖关系,但是网上有许多资源可以逐步引导您完成安装过程。

hadoop完全分布模式Hadoop集群安装配置

hadoop 完全分布模式Hadoop 集群安装配置本来这篇⽂章该在去年11⽉底写出来的,被各种繁杂的事情所烦扰,再者⽹络上也有⾮常多⽐较完善的配置的⽂章,但是依旧是表述不太清晰。

依旧写个Step By Step 的教程,留待⼰⽤。

Hadoop 的部署环境是经过虚拟化之后的四台主机,OS 是Ubuntu Server10.04。

(XenServer5.6兼容的OS 并不包括Ubuntu ,将Ubuntu 转成PV 也是⼀个折腾的过程,另⽂介绍)。

Hadoop 的版本号依旧是:0.20.2.安装Java 环境如上⼀讲所⽰。

主机名及其IP 地址对应如下:Slave&TaskTracker:dm1,IP:192.168.0.17;(datanode)Slave&TaskTracker:dm2,IP:192.168.0.18;(datanode)Slave&TaskTracker:dm3,IP:192.168.0.9;(datanode)Master&JobTracker:dm4,IP:192.168.0.10;(namenode)Master 是Hadoop 集群的管理节点,重要的配置⼯作都在它上⾯,⾄于它的功能和作⽤请参考。

具体配置步骤如下:⼀.修改各个节点(dm1-dm4)的HostName ,命令如下:如下图所⽰例:⼆.在host 中添加机器的hostname 和IP ,⽤以通讯。

Master 需要知道所有的slave 的信息。

对应的slave 只需要知道Master 和⾃⾝的信息即可。

命令如下:Master(dm4)的hosts 配置应该如下图所⽰:其它的slave(dm3……)的hosts 配置应该如下图所⽰:三.Hadoop 核⼼代码需要配置conf ⽂件夹⾥⾯的core-site.xml,hdfs-site.xml,mapread-site.xml,mapred-site.xml ,hadoop-env.sh 这⼏个⽂件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

好程序员大数据教程Hadoop全分布安装(非HA)

机器名称启动服务

linux11 namenode secondrynamenode datanode

linux12 datanode

linux13 datanode

第一步:更改主机名,临时修改+永久修改

临时修改:hostname linux11

永久修改: vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=linux11

临时修改:hostname linux12

永久修改: vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=linux11

临时修改:hostname linux13

永久修改: vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=linux13

第二步:配置ip地址

1.三台机器关闭NetworkManager服务service NetworkManager stop

2.三台机器禁止开机启动NetworkManager服务chkconfig NetworkManager off

3. vi /etc/sysconfig/network-scripts/ifcfg-eth0

三台机器依次配置成这样

linux11:

ONBOOT=yes

BOOTPROTO=static

IPADDR=192.168.91.11

DNS1=8.8.8.8

GATEWAY=192.168.91.1

NETMASK=255.255.255.0

linux12:

ONBOOT=yes

BOOTPROTO=static

IPADDR=192.168.91.12

DNS1=8.8.8.8

GATEWAY=192.168.91.1

NETMASK=255.255.255.0

linux13:

ONBOOT=yes

BOOTPROTO=static

IPADDR=192.168.91.13

DNS1=8.8.8.8

GATEWAY=192.168.91.1

NETMASK=255.255.255.0

最终结果:

192.168.91.11 linux11

192.168.91.12 linux12

192.168.91.13 linux13

3.三台机器关闭防火墙service iptables stop

4.三台机器设置禁止开机启动防火墙chkconfig iptables off

5.三台机器关闭防火墙service iptables status

显示iptables: Firewall is not running.说明防火墙关闭成功

6.三台机器重启网卡service network restart

第三步配置主机映射

使用命令:vi /etc/hosts

三台机器都改成这样

192.168.91.11 linux11

192.168.91.12 linux12

192.168.91.13 linux13

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 测试:

在linux11上ping linux12 ping linux13

第四步配置免密码登录

linux11:

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

linux12:

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

linux13:

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

在linux11上

ssh-copy-id linux12

ssh-copy-id linux13

测试:测试结果为linux11可以免密码登录到所有机器。

linux12 linux13可以免密码登录本机

例如:在linux11上输入ssh linux11

第五步安装jdk及hadoop(由于使用root用户操作,为了防止对liunx操作不熟悉的人,误删其他文件。

所以没有选择把软件安装在/usr下,而是选择安装在了自己创建的文件目录下)

linux11:

1.在根目录下创建bigdata目录mkdir /bigdata

2.将hadoop安装包tar -zxvf /bigdata/hadoop-2.7.1.tar.gz -C /bigdata/

删除hadoop安装包rm -rf /bigdata/hadoop-2.7.1.tar.gz

3.jdk安装包解压tar -zxvf /bigdata/jdk-8u151-linux-x6

4.gz -C /bigdata/

删除jdk安装包rm -rf /bigdata/jdk-8u151-linux-x64.gz

修改jdk目录的名字为jdk1.8 mv /bigdata/jdk1.8.0_151/ /bigdata/jdk1.8

4.配置环境变量vi /etc/profile

在文件末尾加入如下配置

export JAVA_HOME=/bigdata/jdk1.8

export HADOOP_HOME=/bigdata/hadoop-2.7.1

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/s bin:

第六步:hadoop的配置

1.hadoop-env.sh的配置

使用命令vi /bigdata/hadoop-2.7.1/etc/hadoop/hadoop-env.sh

第25行export JAVA_HOME=改成下面的样子

export JAVA_HOME=/bigdata/jdk1.8

3.hdfs-site.xml的配置

4.slaves文件配置

使用命令vi /bigdata/hadoop-2.7.1/etc/hadoop/slaves 配置成这样

linux11

linux12

linux13

第七步:远程拷贝

1.将bigdata文件分发给linux12 linux13

scp -r /bigdata linux12:/

scp -r /bigdata linux13:/

2.将/etc/profile文件分发给linux12 linux13

scp /etc/profile linux12:/etc

scp /etc/profile linux13:/etc

3.三台机器刷新环境变量source /etc/profile

第八步:格式化namenode

在namenode节点linux11上输入命令hdfs namenode -format

格式化完成后在linux11上启动集群start-dfs.sh

第九步:验证集群是否启动成功

1.在浏览器上输入19

2.168.91.11:50070如果页面能打开显示有3个活跃节点说明成功

2.linux11上输入jps 能看到namenode secondrynamenode datanode三个服务

3.linux12上输入jps 能看到datanode

4.linux12上输入jps 能看到datanode

5.上传个文件至集群hdfs dfs -put /bigdata/jdk1.8 /

6.查看web页面是否存在这个文件

好程序员自2014年开班至今,一直立志培养高薪,高能,高职的程序员人。