多线程级别的并行计算

MATLAB的多线程计算

MATLAB的多线程计算无意中看到了MathWork的大神Loren Shure阿姨的一篇文章,说的是如何让MATLAB更好地利用双核的CPU进行效率更高的并行计算。

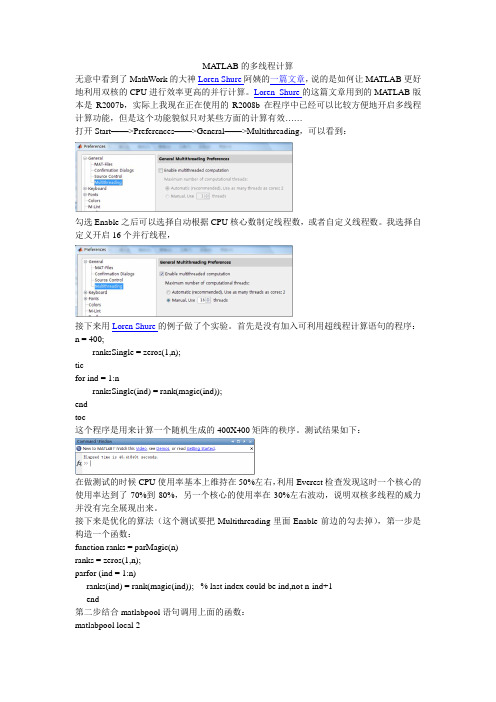

Loren Shure的这篇文章用到的MATLAB版本是R2007b,实际上我现在正在使用的R2008b在程序中已经可以比较方便地开启多线程计算功能,但是这个功能貌似只对某些方面的计算有效……打开Start——>Preferences——>General——>Multithreading,可以看到:勾选Enable之后可以选择自动根据CPU核心数制定线程数,或者自定义线程数。

我选择自定义开启16个并行线程,接下来用Loren Shure的例子做了个实验。

首先是没有加入可利用超线程计算语句的程序:n = 400;ranksSingle = zeros(1,n);ticfor ind = 1:nranksSingle(ind) = rank(magic(ind));endtoc这个程序是用来计算一个随机生成的400X400矩阵的秩序。

测试结果如下:在做测试的时候CPU使用率基本上维持在50%左右,利用Everest检查发现这时一个核心的使用率达到了70%到80%,另一个核心的使用率在30%左右波动,说明双核多线程的威力并没有完全展现出来。

接下来是优化的算法(这个测试要把Multithreading里面Enable前边的勾去掉),第一步是构造一个函数:function ranks = parMagic(n)ranks = zeros(1,n);parfor (ind = 1:n)ranks(ind) = rank(magic(ind)); % last index could be ind,not n-ind+1end第二步结合matlabpool语句调用上面的函数:matlabpool local 2ticranksPar = parMagic(n);toc原理其实很简单,就是利用这个新的matlabpool语句和代替for而使用的parfor函数来规定必须进行多线程计算。

基于线程并行计算的Apriori算法

摘 要: 针对数据挖掘 中经典的 A p r i o r i 算法在计算频繁项 目集时需消耗 大量的时间缺点 , 文中 利用多线程并行计算的特点 , 提 出了基于线程并行计算的 A p r i o r i 算法, 该算法是将统计候选项 目 个数的任务 交给多线程来执行 , 从而达到减少 A p r i o r i 算法的运行时间。通过实验数据分析 , 该算 法对 减 少 A p r i o r i 算 法的运 行 时 间有 很 大的提 高。

Ab s t r ac t : Co n s i d e r i n g t h e Ap r i o r i d a t a mi n i n g a l g o r i t h m i n t h e c l a s s i c c a l c ul a t i o n o f ̄e q ue n t i t e ms e t s r e q u i r e s a l o t o f t i me, us i n g c h a r a c t e r i s ic t s o f mu l t i — t hr e a d e d pa r a l l e l c o mpu t i ng, hr t e a d i s p r o po s e d b a s e d o n t h e Ap r i o r i a l g o r i t h m o f p a r a l l e l c o mp u t i n g, t h i s a l g o r i t h m i s t o ha n d t h e t a s k o f s t a t i s t i c s o f t he H u m— be r o f c a nd i d a t e i t e m o v e r t o mu l t i — t h r e a d t o e x e c u t e, S O a s t o r e d u c e t he r u n n i n g t i me o f t h e Ap r i o r i l— a g o r i t h m. Th r o u g h t h e a n a l y s i s o f t h e e x p e ime r nt a l d a t a, t h e a l g o it r h m h a s i mp r o v e d g r e a t l y t o r e d uc e t h e un r n i n g t i me o f t h e Ap r i o r i a l g o it r h m. Ke y wo r d s: t hr e a d;p a r a l l e l c o mp ut i n g;a p r i o r i a l g o it r h m

计算机的并行计算技术有哪些详解并行计算的架构与应用

计算机的并行计算技术有哪些详解并行计算的架构与应用在现代科技领域,计算机的并行计算技术被广泛应用于许多领域,提供了强大的计算能力和效率。

本文将详细解释并行计算的概念、架构和应用,以及介绍几种常见的并行计算技术。

一、并行计算的概念并行计算是指同时执行多个计算任务的过程,以提高计算机系统的速度和性能。

与传统的串行计算相比,通过并行计算,多个处理器可以同时处理不同的计算任务,从而大大缩短了计算时间。

二、并行计算的架构1. 对称多处理器(SMP)对称多处理器是一种常见的并行计算架构,它包含多个处理器核心(CPU),每个处理器核心都可以访问共享内存。

因此,每个处理器核心都具有相同的权限和能力,并且可以相互通信和协作。

2. 分布式内存计算机(DMC)分布式内存计算机是一种将多个计算机连接在一起,并通过网络进行通信的并行计算架构。

在分布式内存计算机中,每个计算机都有自己的本地内存,并且计算任务被划分为子任务,在多台计算机之间进行并行计算。

3. 向量处理器向量处理器是一种特殊的并行计算架构,其核心思想是通过同时执行多个数据元素来提高计算性能。

向量处理器具有广泛的数据并行能力,并且可以在单个指令中处理多个数据。

三、并行计算的应用1. 科学计算在科学研究领域,许多复杂的计算任务需要大量的计算资源和时间。

通过并行计算技术,科学家可以利用多个处理器来加速大规模的数值模拟、数据分析和计算实验,从而加快科学研究的进程。

2. 数据挖掘与机器学习数据挖掘和机器学习是分析和理解大规模数据集的重要领域。

并行计算技术可以加速数据挖掘算法和机器学习模型的训练和推断过程,减少模型训练时间,提高预测和分类准确性。

3. 图像和视频处理在图像和视频处理领域,许多算法需要处理大量的像素和帧。

通过并行计算技术,可以将图像和视频处理任务分成多个子任务,并在多个处理器上同时处理这些子任务,从而提高图像和视频处理的效率和实时性。

4. 数据库管理和并行查询在大规模数据库管理和查询中,通过并行计算技术可以将查询任务划分为多个子任务,并由多个处理器同时执行这些子任务。

C#多线程开发:并行、并发与异步编程

C#多线程开发:并⾏、并发与异步编程概述现代程序开发过程中不可避免会使⽤到多线程相关的技术,之所以要使⽤多线程,主要原因或⽬的⼤致有以下⼏个:1、业务特性决定程序就是多任务的,⽐如,⼀边采集数据、⼀边分析数据、同时还要实时显⽰数据;2、在执⾏⼀个较长时间的任务时,不能阻塞UI界⾯响应,必须通过后台线程处理;3、在执⾏批量计算密集型任务时,采⽤多线程技术可以提⾼运⾏效率。

传统使⽤的多线程技术有:1. Thread & ThreadPool2. Timer3. BackgroundWorker⽬前,这些技术都不再推荐使⽤了,⽬前推荐采⽤基于任务的异步编程模型,包括并⾏编程和Task的使⽤。

Concurrency并发和Multi-thread多线程不同你在吃饭的时候,突然来了电话。

1. 你吃完饭再打电话,这既不并发也不多线程2. 你吃⼀⼝饭,再打电话说⼀句话,然后再吃饭,再说⼀句话,这是并发,但不多线程。

3. 你有2个嘴巴。

⼀个嘴巴吃饭,⼀个嘴巴打电话。

这就是多线程,也是并发。

并发:表⽰多个任务同时执⾏。

但是有可能在内核是串⾏执⾏的。

任务被分成了多个时间⽚,不断切换上下⽂执⾏。

多线程:表⽰确实有多个处理内核,可同时处理多个任务。

⼀、并发编程:使⽤ThreadPool轮询并发⽅法是使⽤⼀个List(或其他容器)把所有的对象放进去,创建⼀个线程(为了防⽌UI假死,由于这个线程创建后会⼀直执⾏切运算密集,所以使⽤TheadPool和Thread差别不⼤),在这个线程中使⽤foreach(或for)循环依次对每个对象执⾏ReceiveData⽅法,每次执⾏的时候创建⼀个线程池线程来执⾏。

代码如下:使⽤Task轮询并发⼆、并⾏编程:private static bool IsPrimeNumber(int number){if (number < 1){return false;}if (number == 1 && number == 2){return true;}for (int i = 2; i < number; i++){if (number % i == 0){return false;}}return true;} 如果不采⽤并⾏编程,常规实现⽅法:for (int i = 1; i <= 10000; i++){bool b = IsPrimeNumber(i);Console.WriteLine($"{i}:{b}");}采⽤并⾏编程⽅法Parallel.For(1, 10000, x=>{bool b = IsPrimeNumber(x);Console.WriteLine($"{i}:{b}");})Parallel类还有⼀个ForEach⽅法,使⽤和For类似。

用Java多线程实现DNS并行矩阵算法

j a mu ihe d a h a t s r d ma r . l l ain ai mei s a l- ra s te p s e e tx mu i i t rh t ' v tt i i・ t c o p t c

s e d r n o h ig e CPU p e u n t e sn l wa o o . s t o lw

i n me c 1 omp t g.Th s r c l d c b t e NS p r l l d n u  ̄ a. - c ui n i a t aB es r e h DI i i aal i ee

mar 。 lpyn lonh an ar tan i e nain o hs i ti mut lig ag t m d c r ou mplme tt fti n x i y o

1 引言

数值计算 、工程计算等领域。矩阵运 算,特别是在矩阵维数很 大的时候,运 算量是惊人的。所以长久以来。科研人员都在试 图研 究各种不同的算法 ,以减少矩阵乘法的运 算量。 在单处理机上 ,人们 已经研究出了很多成熟的算法。~个典型 的串行矩阵乘法算法的基本思想并不复杂:矩阵乘法就是 一串简单 内积的计算。两个 n 向量 的内积需 n次乘法 和 n 1 维 ・ 次加法 ,算法 复杂度为 0 n 。矩阵 向量乘法需完成 m 个 内积计算。所 以算法复 () 杂度 为 0 mn 。矩阵相乘又需完成 k个矩 阵向量乘法 。所 以算法 ( ) 复杂度为 O( l) mlC 。如 果矩阵 是 n维方阵 ,那 么复杂度 就 为 0( l n

LabVIEW编程中的并行处理与多线程技术探讨

LabVIEW编程中的并行处理与多线程技术探讨在LabVIEW编程中,并行处理和多线程技术是非常重要的概念。

通过合理地应用这些技术,可以显著提高程序的性能和响应速度。

本文将深入探讨LabVIEW编程中的并行处理和多线程技术。

一、并行处理的概念和优势在计算机科学中,"并行处理"指的是同时执行多个任务或处理多个数据的能力。

在LabVIEW中,我们可以通过并行处理来提高程序的效率和性能。

并行处理的一个主要优势是可以充分利用现代多核处理器的计算能力。

通过将任务分解为多个并行的子任务,每个子任务都在不同的处理器核心上执行,从而在同一时间内完成更多的工作。

此外,并行处理还能够提高程序的响应速度。

通过将计算密集型任务与其他任务分开处理,可以避免因为某个任务的繁忙而导致整个程序的卡顿。

二、LabVIEW中的多线程技术在LabVIEW中,多线程技术被广泛应用于并行处理。

LabVIEW使用了一种称为"数据流"的编程模型来实现多线程。

在LabVIEW中,程序由一系列的可重入函数组成。

每个函数都有自己的输入和输出。

当一个函数的输入数据准备好时,它就会开始执行,并将结果传递给下一个函数。

由于每个函数都是可重入的,因此多个函数可以并行执行,即多个函数可以同时运行在不同的线程中。

这样,每个函数都可以独立地处理数据,并将结果传递给下一个函数。

三、LabVIEW中的并行循环在LabVIEW中,我们可以使用并行循环结构来实现并行处理。

并行循环结构允许我们将循环体内的任务分发到不同的线程中执行,并在所有线程都完成任务后汇总结果。

通过并行循环,我们可以同时处理多个数据,并充分利用计算机的多核处理能力。

这在处理大量数据或进行复杂计算时特别有用。

并行循环结构还可以通过设置任务的优先级来实现任务的动态调度。

这样,在处理某些重要任务或需要实时响应的任务时,可以优先分配更多的资源给这些任务,从而提高程序的性能和效率。

torch多线程计算d

torch多线程计算d(实用版)目录1.Torch 库简介2.多线程计算的优势3.Torch 库中的多线程计算方法4.实际应用案例5.总结正文1.Torch 库简介Torch 是一种基于 Lua 的科学计算框架,广泛应用于机器学习、计算机视觉和自然语言处理等领域。

Torch 提供了丰富的算法库和 GPU 加速功能,使得研究人员可以快速地进行原型设计和实验。

2.多线程计算的优势多线程计算是一种并行处理技术,可以有效地利用多核 CPU 的计算能力,提高程序的运行效率。

在深度学习领域,多线程计算可以加速模型训练和推理过程,缩短研究周期。

3.Torch 库中的多线程计算方法Torch 库提供了多种多线程计算方法,包括:- torch.nn.DataParallel:用于模型参数的并行计算,可以自动地将模型的权重和偏置进行复制,使得每个设备(CPU 核心)可以独立地进行计算。

- torch.nn.parallel.DistributedDataParallel:用于在多个设备上进行数据并行计算,通过将数据切分为多个部分,每个设备负责计算一部分数据,最后将结果进行合并。

- torch.nn.parallel.MultiDeviceParallel:结合了 DataParallel 和 DistributedDataParallel 的特点,可以在多个设备上进行模型参数和数据的并行计算。

4.实际应用案例以一个简单的 ResNet 模型为例,我们可以使用 Torch 库中的多线程计算方法来加速模型训练过程。

首先,需要将模型的权重和偏置进行复制,然后使用 DataParallel 或 MultiDeviceParallel 将模型的计算过程分布到多个 CPU 核心上。

在训练过程中,每个核心可以独立地对输入数据进行计算,最后将结果进行合并,从而提高训练速度。

5.总结Torch 库提供了丰富的多线程计算方法,可以帮助研究人员在深度学习领域快速地进行模型训练和推理。

Matlab多线程计算及多核心计算应用说明

关于Matlab多线程计算和多核心计算1.关于多线程计算Matlab是基于单线程单核心的一款软件,在近几年多核心,多线程处理器大规模部署后,其程序设计师才逐步改善matlab内核,让某些常用函数逐步支持多线程运算。

在matlab6.5-matlab 2007b这些版本中,fft, fft2, fftn, ifft, ifft2, ifftn是默认支持多线程运算的,即只要调用这些函数,系统在运算时会开启多线程(计算机硬件须支持)在matlab 2008a-matlab 2009a这些版本中,增加了prod, sum, max, min这几个函数的多线程运算功能,但是matlab内核版本不同会导致这些函数在多线程执行时效率不同。

按照其官方文档的说法,在支持多线程计算的matlab版本中,同样的fft运算可以提速50%。

但是多线程运算有一个缺点:在函数体或程序内部需要调用其他非多线程运算的函数时,执行效率会比较低,基本和不开启多线程运算差不多,也就是说,使用这些支持多线程的函数时,最好不要进行嵌套。

结论:matlab中多线程计算受限于版本以及特定的函数,在运算指定函数时效率较高,建议拥有多核心处理器的机器开启。

开启多线程方法:在命令行下输入:maxNumCompThreads(),括号内为需要开启的线程个数2.关于多核心计算(并行计算和分布式计算)2.1并行计算功能(Parallel Computing Toolbox)Parallel Computing Toolbox是matlab 2008 a开始拥有的新功能,之前的版本仅拥有Distributed Computing Toolbox。

并行计算工具箱里面包含了parfor,spmd,pmode,下面一一介绍(这些功能在分布式计算的应用暂不涉及)2.1.1 Parfor这个是matlab提供的并行计算的for循环,需要matlab pool的支持。

什么情况下使用多线程

什么情况下使用多线程

使用多线程是为了能够同时处理多个任务,提高程序的并发性和响应性。

以下是一些常见的情况下使用多线程的场景。

1.高并发:当需要同时处理大量请求时,使用多线程可以提高系统的并发能力。

例如,一个网络服务器需要同时处理多个客户端请求,每个请求可能会导致服务器执行一些耗时的操作,如读取文件或数据库查询。

在这种情况下,每个请求可以分配一个线程来处理,而不会因为其中一些请求的阻塞而导致其他请求被延迟。

3.并行计算:当需要进行大规模计算或处理复杂算法时,使用多线程可以将计算任务分配给多个处理器或内核,并行执行。

这种方式可以有效地缩短计算时间,提高程序的性能。

例如,图像处理、视频编码、科学计算等领域通常会使用多线程进行并行计算。

4.IO密集型任务:当任务涉及到大量的IO操作时,使用多线程可以充分利用CPU的空闲时间,提高程序的执行效率。

例如,文件的读取和写入、网络通信等操作都可以使用多线程来实现。

5.交互性应用程序:当需要处理用户的输入和响应时,使用多线程可以提供更好的用户体验。

例如,给定一个图形界面应用程序,用户在主线程中进行操作,而与用户界面相关的任务可以在后台线程中执行,以避免在主线程中进行耗时的操作而导致界面冻结。

然而,使用多线程也存在一些潜在的问题和挑战,例如线程之间的同步和互斥、资源竞争、死锁等。

程序员需要仔细考虑这些问题,并采取适当的措施来解决和避免这些问题。

总而言之,使用多线程可以在合适的情况下提高程序的并发性和响应性,但也需要合理使用,并针对具体的需求选择适当的线程模型和同步机制。

超线程技术

超线程技术就是利用特殊的硬件指令,把两个逻辑内核模拟成两个物理芯片,让单个处理器都能使用线程级并行计算,进而兼容多线程操作系统和软件,减少了CPU的闲置时间,提高的CPU的运行效率。

基本信息超线程技术是在一颗CPU同时执行多个程序而共同分享一颗CPU内的资源,理论上要像两颗CPU一样在同一时间执行两个线程,P4处理器需要多加入一个Logical CPU Pointer (逻辑处理单元)。

因此新一代的P4 HT的die的面积比以往的P4增大了5%。

而其余部分如ALU(整数运算单元)、FPU(浮点运算单元)、L2 Cache(二级缓存)则保持不变,这些部分是被分享的。

虽然采用超线程技术能同时执行两个线程,但它并不象两个真正的CPU那样,每个CPU 都具有独立的资源。

当两个线程都同时需要某一个资源时,其中一个要暂时停止,并让出资源,直到这些资源闲置后才能继续。

因此超线程的性能并不等于两颗CPU的性能。

超线程与效能提升一般很多人都会认为,采用超线程技术,就能使得系统效能大幅提升,但是事实真是如此么?不要忘了我们前面说到的超线程技术实现的必要条件,这可是超线程技术发挥应有效能的前提条件。

除了操作系统支持之外,还必须要软件的支持。

从这点我们就可以看出,就目前的软件现状来说,支持双处理器技术的软件毕竟还在少数。

对于大多数软件来说,目前由于设计的原理不同,还并不能从超线程技术上得到直接的超线程技术好处。

因为超线程技术是在线程级别上并行处理命令,按线程动态分配处理器等资源。

该技术的核心理念是“并行度(Parallelism)”,也就是提高命令执行的并行度、提高每个时钟的效率。

这就需要软件在设计上线程化,提高并行处理的能力。

而目前PC上的应用程序几乎没有为此作出相应的优化,采用超线程技术并没不能获得效能的大幅提升。

上面说的只是目前软件支持的现状,操作系统在这个方面则没有太大的问题,毕竟Windows的某些版本、Linux都是支持多处理器的操作系统。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

多线程级别的并行计算

写多线程应用程序最困难的地方在于如何使各线程的工作协调进行。

Windows提供的用于线程间通信的各种机制是很容易掌握的,可是要把它们应用到工作中完成既定的功能时就会遇到这样、那样的困难。

对于常见的“生产者-消费者”模型,只要采取合理同步措施实现数据交换的统一性即可。

这类模型中的多线程往往任务独立,主要两类线程,一类写线程(生产者),一类读线程(消费者)。

但在实际应用中,多核机器往往需要使用多线

如何让多个处理器(多个线程)协作完成一项大规模的任务,涉及到任务的分解和调度。

因此,多核编程技术的关键问题在于如何将计算均匀分摊到各个CPU核上。

并行(Parallel)计算,即空间复用多个处理器,属于线程级别上的协作。

关于多线程协作,参阅王艳平著《Windows程序设计》第3章《Win32程序的执行单元》中的CRapidFinder例程。

该例程演示了如何使用多线程协助完成文件搜索任务。

多进程协助完成任务—分布式计算的滥觞

分布式计算则是进程级别上的协作,它是一种把需要进行大量计算的工程数据分割成小块,由多台计算机分别计算,在上传运算结果后再统一合并得出数据结论的技术。

现代大规模CG视觉特效的渲染系统有很多渲染节点组成,采用领先的分布式渲染技术,系统将自动确定网络中可用的渲染节点和资源,同时将将任务分解到相应渲染节点,自动负载平衡功能可以优化工作流程中每个渲染节点的使用效率。

从《后天》到《2012》,再到《阿凡达》,这些大电影,其数以PB计艰苦卓绝的渲染工作无不依赖于现代分布式集群工作站的协同作战。

线程的池化管理

通常情况下,内存的分配和释放通常都是mallloc和free显式进行的。

对同一块内存的多次释放通常会导致页面错误,而一直不释放又导致内存泄露,并且使系统性能大大下降。

频繁地创建和销毁内存资源是很耗时间的,因为创建一个对象要获取内存资源或者其它更多资源。

malloc/free操纵的是进程堆内存,C/C++运行库不允许两个线程同时从内存堆中分配内存,这种多线程同步操作也是相当耗时的。

对于共享资源,有一个很著名的设计模式:资源池(Resource Pool)。

该模式正是为了解决资源的频繁分配和释放所造成的问题。

如何利用已有对象来服务就是一个需要解决的关键问题,其实这就是一些“池化资源”技术产生的原因。

对于单核PC,多线程微观串行;对于多处理器系统,使用多线程技术可以充分发挥硬件的优势。

理论上,安装了N核CPU的PC,在某一时刻,系统底层所能并发执行的线程个数为N。

然而,线程的数量并不是多多益善。

首先,线程这种内核资源的创建和销毁本身就很耗系统资源;其次,频繁的线程上下文切换也会耗费较多的CPU时钟周期。

借鉴数据库连接池和内存池的池化管理思想,对于线程也可以实行池化管理。

在讨论WinSock的五种I/O模型中,选择模型(select、WSAAsyncSelcet、WSAEventSelect)基于消息轮询或事件等待,对于多用户并发响应往往为每个客户连接创建一个I/O伺服线程。

这种单连接单线程的处理方式,对于中小型服务器较为通用,但对大规模多用户的服务器的高并发需求无能为力。

完成端口模型本质上利用了Win32重叠I/O机制,底层利用完成端口队列对象来管理一个线程池。

关于线程池规模,根据经验为每个处理器创建2个线程,即工作线程数为

一个大规模高并发的服务器对于资源的管理至关重要,因此往往同时使用数据库连接池、内存池和线程池,对关键资源实行池化管理。

一般一个简单线程池至少包含下列组成部分。

线程池管理器(ThreadPoolManager):用于创建并管理线程池

工作线程(WorkThread):线程池中线程

任务接口(Task):每个任务必须实现的接口,以供工作线程调度任务的执行。

任务队列:用于存放没有处理的任务。

提供一种缓冲机制。

基于IOCP使用资源池化技术实现高性能的服务器,参阅王艳平、张越著《Windows网络与通信程序设计》第4章《IOCP与可伸缩网络程序》中的

CIOCPServer系统结构图

参考:

《线程池的介绍及简单实现》

《深入研究线程池》

《一个C++多线程程序开发库》

《一个boost底下的线程池》。