基于Kinect体感器手势控制无人机

基于Kinect骨骼信息提取的机械臂远程体感控制系统设计

基于 Kinect骨骼信息提取的机械臂远程体感控制系统设计作者简介:王静娴,女,生于1999年11月,回族,河北唐山人,江苏大学本科在读,测控技术与仪器专业基金项目:江苏大学第18批大学生科研课题立项资助项目,项目编号:18B089摘要:基于Kinect进行人体骨骼信息提取,进而实现对机械臂的远程体感控制。

主要研究内容为通过Kinect获取人体手势图像信息并进行处理,进而检测到人体的骨骼关节坐标,经无线传输方式传输给上位机,上位机采用LabVIEW平台,由程序处理进行坐标转化,从而控制机械臂的运动,建立机械臂的远程体感控制系统。

经过实验表明,设计的系统可以通过人机交互体感技术对机械臂进行远距离控制,实现机械臂末端执行部件对物体的准确抓取动作。

关键词:Dobot机械臂;人机交互;Kinect;体感控制由于在高压、辐射等恶劣环境下工作会威胁人体健康,因此控制机器人完成在这些特定环境下的工作成为科研人员的关注热点。

传统机器人存在灵活性差、缺乏智能性等缺点,体感机器人应运而生。

而人机交互是体感机器人最重要的技术之一,目前此技术主要分为接触式和非接触式交互。

接触式人机交互常用可接触式传感器,采用可穿戴设备进行控制,然而此类设备会阻碍操作人员的行动,同时成本过高,因此诞生了非接触式交互技术。

将非接触式人机交互技术引入机械臂控制上,通过模仿人体动作来操控机器人,这种体感控制技术具有较大的实用价值,并在一定程度上实现了机器人控制方式的创新,使机器人的控制更加多样灵活。

1.Kinect骨骼信息提取技术1.Kinect简介Kinect是2010年由Microsoft公司推出的一款姿态传感输入设备,不同于传统输入设备,该设备可以实现使用者直接控制终端,实现自然人机交互。

本文采用Kinect V1.0设备,其传感器组具有可编辑性强、成本低等优点。

该组传感器中间镜头是RGB彩色摄像头,左右两镜头分别为红外线发射器和红外线CMOS摄像机所构成的3D深度感应器[1]。

基于Kinect移动机器人导航设计与实现

科技视界

基于 Kinect 移动机器人导航设计与实现

许志强 翟漪璇 韩金鑫 颜义鹏 成 怡 渊天津工业大学袁中国 天津 300387冤

揖摘 要铱本文基于 Kinect 深度摄像头袁结合 2D SLAM 算法设计出了一套精确的轮式移动机器人导航系统遥 该系统主要包 括底盘驱动尧数据采集尧PC 三大部分遥 通过机器人自身携带的 Kinect 深度摄像头对室内环境扫描袁利用 Gmapping 算法构建出 环境地图袁在已构建出的栅格地图基础上袁结合 A* 算法和动态窗口法袁实现机器人的自主定位与导航遥

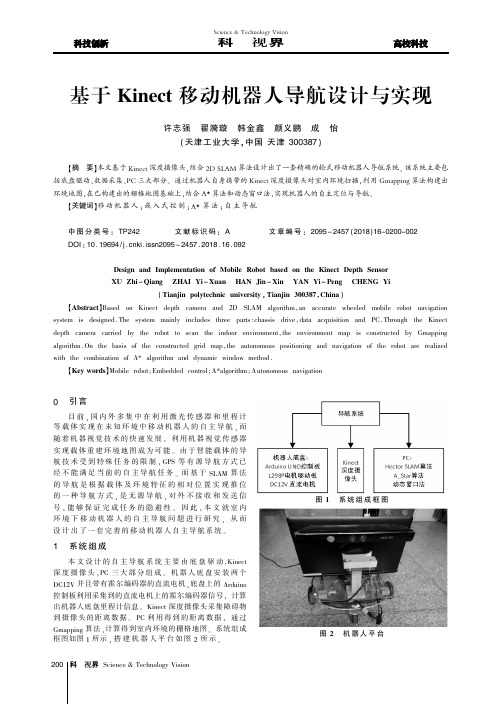

1 系统组成

本 文 设 计 的 自 主 导 航 系 统 主 要 由 底 盘 驱 动 , Kinect 深 度 摄 像 头 袁PC 三 大 部 分 组 成 遥 机 器 人 底 盘 安 装 两 个 DC12V 并且带有霍尔编码器的直流电机袁底盘上的 Arduino 控制板利用采集到的直流电机上的霍尔编码器信号袁 计算 出机器人底盘里程计信息遥 Kinect 深度摄像头采集障碍物 到 摄 像 头 的 距 离 数 据 遥 PC 利 用 得 到 的 距 离 数 据 袁 通 过 Gmapping 算法袁计算得到室内环境的栅格地图遥 系统组成 框图如图 1 所示 袁 搭 建 机 器 人 平 台如 图 2 所示 遥

200 科技视界 Science & Technology Vision

图 1 系统组成框图 图 2 机器人平台

Science & Technology Vision

科技视界

下位机硬件主要由两部分组成院 机器人底盘和 Kinect 深度摄像头遥 机器人底盘基于差速驱动控制袁 由两个 12v DC 电 机 尧 控 制 板 Arduino UNO 尧 电 机 驱 动 板 L298P 遥 上位机是个人电脑遥 上下位机通过串口进行通讯袁将上 位机计算所得脉冲数据传递给下位机袁将下位机编码器 测的里程计数据发送给上位机袁实现数据间的交互,从而 达 到控制机器人导航避障的目的遥

3基于Kinect深度信息的手势识别_王艳

第28卷第1期2013年2月北京信息科技大学学报Journal of Beijing Information Science and Technology UniversityVol.28No.1Feb.2013文章编号:1674-6864(2013)01-0000-05基于Kinect 深度信息的手势识别王艳,张奇志(北京信息科技大学自动化学院,北京100192)摘要:设计了一种基于Kinect 深度信息和双阈值分割的运动手势识别算法。

结合OpenCV 和OpenNI ,在vs2010环境下实现了该算法。

利用Kinect 的深度摄像头获取深度图像;对该图像进行双阈值分割,获取手部图像;再对手部图像进行形态学处理,获取完整的手形;最后,利用OpenNI 的手势生成器GestureGenerator 对手势进行跟踪识别。

利用深度图像进行手势识别,通过双阈值分割,不仅去除了背景干扰,也能去除一部分前景干扰。

用不同颜色点、圆和线的形式表示各种手势,可以清晰地实时显示识别效果。

关键词:手势识别;Kinect ;深度信息;手势生成中图分类号:TP 24文献标志码:A Gesture recognition based on Kinect depth informationWANG Yan ,ZHANG Qi-zhi(School of Automation ,Beijing Information Science and Technology University ,Beijing 100192,China )Abstract :An algorithm of moving gesture recognition based on the depth information of Kinect and dual threshold segmentation is designed.The algorithm is realized under VS2010by integrating OpenCV and OpenNI.Firstly ,the depth camera of Kinect is used to get the depth image.Secondly ,the dual thresholds are used to segment the image to get the image of just hand.Then morphology process is performed for the image to achieve more integrity hand shape.Finally ,the GestureGenerator of OpenNI is utilized to track and recognize the gesture.In this method ,the obstructions of background and part of foreground are removed by dual threshold segmentation.Points ,circles and lines in different colors are used to describe the gestures ,so the results of recognition can be clearly shown in real time.Key words :gesture recognition ;Kinect ;depth information ;gesture generation收稿日期:2012-09-17基金项目:国家自然科学基金资助项目(11172047,11072038);北京市属高等学校人才强教深化计划资助项目(PHR201106131)作者简介:王艳(1987—),女,四川资阳人,硕士研究生,主要从事手势识别方面的研究。

基于Kinect传感器的教学手势识别

基于Kinect传感器的教学手势识别

王宪兵;袁盼盼

【期刊名称】《新型工业化》

【年(卷),期】2016(006)009

【摘要】随着多媒体技术的迅速发展,许多高校采用多媒体计算机系统辅助教学.为了增强课堂的趣味性以及教学的新颖性,将体感交互系统巧妙地应用于多媒体教学.利用微软公司设计的Kinect传感器的骨骼跟踪功能,建立骨骼跟踪模型,通过手势识别实现对PPT的播放控制.建立手势识别库并利用计算简单、方便有效的两点法进行关节点之间的角度计算来实现手势识别,将手势反馈到系统并完成相应的控制指令输出,实现PPT的播放、翻页等基本操作.实验表明,手势控制PPT操作成功率高,能够有效地控制PPT播放.

【总页数】7页(P28-34)

【作者】王宪兵;袁盼盼

【作者单位】湘潭大学信息工程学院,湖南湘潭411100;湘潭大学信息工程学院,湖南湘潭411100

【正文语种】中文

【相关文献】

1.基于Kinect传感器的近场手势识别追踪系统的实现 [J], 王博龙;房建成

2.基于Kinect传感器和HOG特征的静态手势识别 [J], 邹潇;郑庆庆;李冰

3.基于Kinect传感器的静态手势识别与仿真 [J], 葛艳茹;张国伟;孙温和;卢秋红

4.基于Kinect传感器和HOG特征的静态手势识别 [J], 邹潇;郑庆庆;李冰

5.基于Kinect传感器的静态手势识别与仿真 [J], 葛艳茹[1];张国伟[1];孙温和[1];卢秋红[2]

因版权原因,仅展示原文概要,查看原文内容请购买。

基于Kinect和变形雅可比-傅里叶矩的手势识别

基于Kinect和变形雅可比-傅里叶矩的手势识别刘亚瑞;杨文璐【摘要】为了使人机交互变得更加自然,提出利用Kinect体感器获取手势深度图像;利用变形雅可比-傅里叶矩对手势图像进行特征提取;利用最小欧氏距离分类器进行建模、分类,实现手势识别.用Kinect体感器获取手部深度数据流,深度数据结合阈值分割法,可以有效地实现手势的分割.变形雅可比-傅里叶矩是一种不变矩,不变矩具有灰度、平移、旋转和尺度不变性,适合用于多畸变不变图像的特征提取.实验对5种手势进行了测试,平均识别率为95.2%,实验结果表明:该方法具有较高的识别率.【期刊名称】《传感器与微系统》【年(卷),期】2016(035)007【总页数】4页(P48-50,54)【关键词】Kinect;变形雅可比-傅里叶矩;手势识别;自然人机交互【作者】刘亚瑞;杨文璐【作者单位】上海海事大学信息工程学院,上海201306;上海海事大学信息工程学院,上海201306【正文语种】中文【中图分类】TP391在智能计算机的快速发展下,传统的人机交互方式已经不能满足人类的需求,人类从而提出了自然交互界面(natural interactive interface)。

自然人机交互主要通过手势、语音和姿势来实现。

其中,通过视觉通道让计算机感知人的意图和行为是自然人机交互的重要追求目标,而手势是一种最直观的表达方式,所以,在自然人机交互的研究中手势识别技术显得非常重要。

手势识别技术主要包括基于数据手套的手势识别技术和基于视觉的手势识别技术,其中,基于数据手套的手势识别结构复杂、成本昂贵,极大地限制了自然人机交互的进行[1,2]。

基于视觉的手势识别技术[3,4]需要进行手势分割,在复杂背景下手势分割易受周围环境(如背景、光照等)的影响。

在手势识别方面的研究,已经有了一些研究成果,但是他们的研究都存在一些不足。

Liu N等人做出的手势识别系统可以识别出26个字母[5,6],缺点是系统复杂;Apivan Tuntakurn等人用Kinect体感器自带的骨骼流建立了手势识别医学软件[7],但是该系统具有局限性,要求人的身体必须全部在Kinect体感器视野范围内;Li Y在特定手势识别中采用角点检测和凸性检测来识别手势,缺点是识别率易受周围环境的影响,无法识别复杂背景下的手势[8~11]。

基于Kinect传感器的近场手势识别追踪系统的实现

基于Kinect传感器的近场手势识别追踪系统的实现王博龙;房建成【摘要】利用Kinect深度传感器所获取的图像深度信息实现手部从背景中的分割,并通过零均值离散高斯滤波、二值化、取最小外包矩形、欧式距离变换等一系列过程对手势目标进行识别,最后把得到的识别结果显示在电脑上,实现实时追踪.该系统相较其它类似系统具有算法简单,实时性好,实现成本低等特点.【期刊名称】《电子设计工程》【年(卷),期】2014(022)013【总页数】3页(P78-80)【关键词】Kinect;深度信息;手势识别;人机交互;体感【作者】王博龙;房建成【作者单位】北京航空航天大学仪器科学与光电工程学院,北京100191;北京航空航天大学仪器科学与光电工程学院,北京100191【正文语种】中文【中图分类】TN-9手势识别与追踪作为计算机图形学研究的热门内容之一,正开始应用于各类视频交互应用中,包括Microsoft、Nintend、PrimeSense、Asus等知名厂商已经投人大量的研究经费来进行手势追踪的研究和相关设备的开发。

准确而高效手势识别可应用于很多领域,如虚拟现实、人机交互的增强等。

Microsoft在2010年11月推出的Kinect体感游戏设备利用即时动作进行识别让玩家摆脱传统游戏手柄的束缚,通过自己的肢体来控制虚拟人。

而在众多手势识别的应用中,人们更愿意坐着而非站着,近场手势识别在此种体验背景下作为未来交互体验的主要趋势,更是众多交互应用需要解决的首要问题,在此之前,电脑和视频游戏为控制人体运动提供了大量的接口,例如:鼠标、操作杆和按钮等等。

但是,这些接口只是提供了少量的自由度上的控制并且必须自动计算运动细节。

索尼的EyeToy[1]是一个基于视觉的系统,该系统不需要任何的标记,就能够提取出一个拳击或者挥手的简单2D动作,此法实现成本低、实时性好,但只能在2D层面上对手势进行提取,Kinect的深度信息处理则能在3D层面上提取手势,信息更丰富,可扩展性强。

一种基于Kinect的手势识别系统

一种基于Kinect的手势识别系统作者:刘啸宇韩格欣王瑞代丽男薄纯娟来源:《物联网技术》2015年第05期摘要:手势识别系统有着广阔的应用前景,一套稳定、高效的手势识别算法可以为其后的机器学习提供良好基础。

简要分析了计算机图像处理结合Kinect在手势识别领域的应用,并提出了一种结合Kinect深度信息的可行的手势识别方法,最后通过实验验证了该算法的稳定性和效率。

关键词:Kinect;手势识别;特征提取;计算机图像处理中图分类号:TP368 文献标识码:A 文章编号:2095-1302(2015)05-00-030 引言人机交互方式多年来都停留在以键盘和鼠标为中心的传统方式上,然而,随着科技进步,特别是传感器技术和芯片制造技术的进步,工程师们正在不停的探索新的人机交互体验。

已知的人机交互体验包括声音交互、脑电波交互、人体肢体姿态交互、手势交互等。

这其中,基于计算机图像处理技术的手势识别已经拥有了广阔的应用。

手势识别技术可以利用在医疗领用,用于孤独症儿童的治疗;可以应用在沟通领域,用于聋哑患者的手语交流;也可以应用在游戏领域,创造新的游戏人机交互体验。

但是,现行的手势识别系统之所以不够普及,很大一部分在于识别算法的稳定性和快速性得不到保证。

这是因为使用计算机图像处理手段的手势识别系统受到计算机图像处理能力的极大制约。

图像处理,特别是实时图像处理,在实际操作中会受到光照、遮蔽、阴影等因素的制约,每一种因素的变化都会对最终的识别结果造成影响。

因此,如何得到稳定且置信度高的手势识别结果就成了各国计算机图像处理工程师的重要攻克方向。

幸运的是,在2009年6月1日E3 2009大会上首次公布的Kinect设备为这种要求提供了更进一步的保障。

利用Kinect提供的深度信息,结合在计算机图像处理和机器学习领域早已颇有建树的开源计算机图形处理库OPENCV,开发者可以将制约图像处理的环境光因素降到最低,从而开发出稳定可靠的手势识别系统。

基于Kinect的体感交互机械臂

相关程序截图

Kinect前台代码 xaml语言 Kinect后台代码 C#语言

下位机代码用Keil 5环境编译

创新特色性

一、采用了PC端图像识别技术,实现 了体感交互。

二、实现图像处理与下位机的交互,达到 控制机械臂的目的。

三、视觉处理难度大,但是精确度, 灵敏度远超各类光电传感器。

体感交互基本过程获取图像摄像头图像处理识别人体动作姿态pc数据传输串口通信控制机械臂kinect开发环境本次开发使用c语言visualstudio2010netframework40wpf界面深度图像kinect图像处理在pc端获取深度数据以深度图像方式呈现

基于Kinect的体感交互机械臂

用最自然的方式

识别人体动作姿态

PC

串 口 通 信

控制机械臂

Kinect 开发环境

本次开发使用C#语言 Visual Studio 2010 .NET Framework 4.0 WPF界面

Kinect 图像处理

在PC端获取深度数据,以 深度图像方式呈现; 在Visual Studio产生景深 数据,通过灰度值的不同, 代表深度数据的大小。

与机器对话

体感交互

让机器读懂我们 的身体语言。

用我们的手势和 姿态控制机械。

Kinect 简介

Kinect是微软推出的

一款图像识别设备,可用于 体感游戏或PC开发。

Kinect利用其独有的红

外深度摄像头,可以将二维 的图像数据扩展至三维。

体感交互基本过程

数据传输

摄 像 头

获取图像

图 像 处 理

深Hale Waihona Puke 图像Kinect 图像处理

通过扫描深度图像, 有效的将人体与背 景分离,识别人体 轮廓以及骨骼结点, 实时追踪人体动作 与姿态。

Kinect开发——手势识别(上)

Kinect开发——⼿势识别(上)像点击(clicks)是GUI平台的核⼼,轻点(taps)是触摸平台的核⼼那样,⼿势(gestures)是Kinect应⽤程序的核⼼关于⼿势的定义的中⼼在于⼿势能够⽤来交流,⼿势的意义在于讲述⽽不是执⾏在⼈机交互领域,⼿势通常被作为传达⼀些简单的指令⽽不是交流某些事实、描述问题或者陈述想法使⽤⼿势操作电脑通常是命令式的,这通常不是⼈们使⽤⼿势的⽬的。

例如,挥⼿(wave)这⼀动作,在现实世界中通常是打招呼的⼀种⽅式,但是这种打招呼的⽅式在⼈机交互中却不太常⽤。

通常第⼀次写程序通常会显⽰“hello”,但我们对和电脑打招呼并不感兴趣。

但是,在⼀个繁忙的餐馆,挥⼿这⼀⼿势可能就有不同的含义了。

当向服务员招收时,可能是要引起服务员注意,需要他们提供服务。

在计算机中,要引起计算机注意有时候也有其特殊意义,⽐如,计算机休眠时,⼀般都会敲击键盘或者移动⿏标来唤醒,以提醒计算机“注意”。

当使⽤Kinect时,可以使⽤更加直观的⽅式,就⾏少数派报告阿汤哥那样,抬起双⼿,或者简单的朝计算机挥挥⼿,计算机就会从休眠状态唤醒。

我们想要使⽤的任何Kinect⼿势必须基于应⽤程序的⽤户和应⽤程序的设计和开发者之间就某种⼿势代表的含义达成⼀致。

⾃然⽤户界⾯是⼀系列技术的合计,他包括:语⾳识别,多点触控以及类似Kinect的动感交互界⾯,他和Windows和Macs操作系统中⿏标和键盘交互这种很常见图形交互界⾯不同NUI界⾯的设计充分利⽤了⽤户预先就会的技能,⽤户和UI进⾏交互感到很⾃然,使得他们甚⾄忘了是从哪⾥学到这些和UI进⾏交互所需的技能的⾃然⽤户界⾯的依赖于先验知识和不需要媒介的交互这两个特征是每⼀种NUI界⾯的共同特征图形⽤户界⾯中按钮的⼀个通常的特征是他提供了⼀个悬浮状态来指⽰⽤户光标已经悬停在的按钮上⽅的正确位置。

这种悬浮状态将点(click)这个动作离散开来。

悬浮状态可以为按钮提供⼀些额外的信息。

基于Kinect深度信息的动态手势识别

基于Kinect深度信息的动态手势识别

郭晓利;杨婷婷;张雅超

【期刊名称】《东北电力大学学报》

【年(卷),期】2016(036)002

【摘要】针对复杂动态手势识别问题,本文首先通过体感传感器Kinect获取人体深度图像,利用阈值分割法分割出手势深度图像,然后建立由隐马尔可夫模型( HMM)和模糊神经网络( FNN)相结合的HMM-FNN模型进行动态手势识别。

本文的动态手势主要是针对虚拟变电站中对设备的常用操作手势来进行人机交互研究的。

HMM-FNN模型将复杂动态手势特征分解为三个子特征序列,分别建立HMM模型,然后进行模糊推理对手势进行分类识别。

经实验验证,HMM-FNN模型能快速有效识别复杂动态手势,且鲁棒性强,识别效果明显优于HMM模型。

【总页数】5页(P90-94)

【作者】郭晓利;杨婷婷;张雅超

【作者单位】东北电力大学信息工程学院,吉林吉林132012;东北电力大学信息工程学院,吉林吉林132012;国网吉林省电力有限公司吉林供电公司,吉林吉林130021

【正文语种】中文

【中图分类】TP391

【相关文献】

1.基于Kinect深度信息的手势识别 [J], 王艳;张奇志

2.基于Kinect传感器深度信息的动态手势识别 [J], 陶丽君;李翠华;张希婧;李胜睿

3.基于Kinect深度信息的手指检测与手势识别 [J], 郑斌珏;赵辽英;王毅轩;

4.基于深度信息的动态手势识别综述 [J], 陈甜甜;姚璜;左明章;田元;杨梦婷

5.基于Kinect的动态手势识别研究 [J], 邵天培;蒋刚;留沧海

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于Kinect体感器手势控制无人机

作者:李梦曾林鹏黄旭阳

来源:《无线互联科技》2019年第05期

摘要:本设计通过电子技术、机械装置设置和应用程序编写来设计体感无人机,以

STC15W贴片单片机为无人机的控制核心,分为无人机模块、Kinect传感器模块、地面站模块和控制程序模块,用Kinect传感器作为用户肢体采集的核心部件,通过对用户动作的采集,用程序来识别出用戶的当前动作,传输指令到地面站,再发送给无人机,实现无人机的体感控制。

同时,为了地面人员的安全,对一些危险姿态采用了一定的安全措施,使新手用户在使用时,不会因为操作不当造成不必要的伤害,并且由遥控器到体感这一控制系统的变化,提高了无人机操作的乐趣。

关键词:无人机;Kinect传感器;体感

近年来,无人机在民用方面的应用越来越多,各国在无人机的民用方面逐渐开放。

引用大疆创新创始人汪滔的话:“人类对于飞行的梦想与生俱来。

”随着无人机的迅速发展,无人机也越来越常见。

而无论是工业级无人机还是消费级无人机,绝大多数无人机都配备有遥控器。

遥控器提供精准操作方式的同时,也让小白用户望而却步。

有人说,遥控器是无人机的痛点。

现实也是如此,而体感手势操作不仅是一种新的操控方式,更是降低了操控的难度。

手朝上升空,手朝下降低,伸左手朝左,伸右手朝右等。

不同手势对应不同的无人机操作。

新的操作方式,不仅添加了无人机的可玩性,还更利于新手入门。

这种操作方式极大地降低了操控的难度,也更利于新手掌握无人机飞行时的方向感,提高学习无人机飞行的效率。

1 体感无人机设计方法

本设计是通过电子技术、机械装置设置和应用程序编写来设计体感无人机,无人机主要分为无人机模块、Kinect传感器模块、地面站模块和控制程序模块,由这几个模块来实现体感无人机的功能,无人机的总体控制原理如图1所示。

1.1 无人机模块

无人机模块设计的目的是实现体感无人机可以成功起飞升空,并在空中停留一定的时间,以及可以完成空中的前后左右运动。

在满足微型旋翼无人机系统稳定、可靠运行的情况下,应尽量减少开发过程中带来的风险,降低开发成本。

因此,应尽量选择低功耗、高性能、性价比高的电子元器件[1]。

所以我们选用STC15W贴片芯片作为单片机、选用MPU-6050陀螺仪、无线2.4 G模块LT8910、设计4轴电机模块、并配置下载和电池模块。

MPU-6000的角速度全格感测范围为±250、±500、±1 000与±2 000°/sec(dps),可准确追踪快速与慢速动作,并且,用户可程式控制的加速器全

格感测范围为±2 g,±4 g,±8 g与±16 g,对姿态的变化较为敏感,符合我们的制作需求。

在STC15W中下载编写的源程序,通过陀螺仪监测无人机的姿态状况,返回无人机的姿态状态到单片机,如果无人机有所倾斜,则陀螺仪就会传回数据,通过对数据的判断,可以判断出无人机向哪一侧倾斜,然后由主芯片控制电机模块的4个电机的转速,高度较低的一侧电机输出增加,转速加快,通过一直判断无人机的姿态,返回姿态数据给单片机,从而控制无人机的平衡。

同时,无线模块接收到地面站的信号,会将信号传输到单片机,然后由单片机控制4个电机,来完成前后左后上下等动作。

1.2 Kinect传感器模块

Kinect是由微软公司开发,可以使用肢体动作来操作各种软件、硬件的一套平台。

如图2所示,它共有3个镜头,分别位于Kinect的两侧和中间位置。

其中,中间的镜头是基于RGB 的三基色普通摄像机,作用是用来采集彩色影像。

而左边的镜头为微红外线发射装置,右边的镜头是微红外线(CMOS)摄像机构成的3D立体结构光深度感应装置,是用来采集深度数据的实物距离[2]。

通过传感器捕捉人物的肢体动作,通过深度摄像功能,拍摄出运用深浅体现远近的图片,获得突出手和手臂的动作的图片,通过算法,去除其他部分,分割出手部动作,通过识别手势的一些基本特征来进行编号,手指向上则上升,向下则下降,如果手部颜色由深到浅则是拉近,由浅到深则是远离,手指向左和向右对应的无人机飞行方向也是向左向右。

1.3 地面站模块

地面站模块设计的目的是实现地面控制终端和无人机之间的无线通信,使得两者之间有相互的运动控制和状态反馈以及图像的传输与显示。

在无人机起飞、飞行、降落的过程中与无人机的飞行控制系统进行实时通讯,保证无人机是在地面控制终端的控制之下。

在确定地面控制指令的情况下,地面站通过无线链路,在串口通信协议的基础上,将人所发出的指令传输至无人机的飞行控制系统,使得无人机做出相应的动作。

与此同时,无人机的飞行控制系统也将无人机上各种传感器所得的姿态环境参数数据回传至地面站,并通过地面站的显示程序和显示器进行显示。

使得操作者可以实时看到无人机的具体运行状态以及对无人机的姿态进行相应的调整。

在此设计中,地面站连接电脑串口,在电脑程序判断出来人的手势动作后,串口输出前后左右上下等指令,通过地面站把指令转换成无线信号的方式发送出去,从而控制无人机的飞行,同时也增加了无人机的控制距离。

同时,无人机的飞行状态也可以发送回地面站,再通过地面站传回电脑,在电脑上显示一些飞行的参数,比如高度和角度等。

1.4 控制程序模块

控制程序模块设计的目的是实现Kinect传感器模块、地面站模块和无人机模块之间的协调控制,使得整体的系统具有良好的完整性和良好的协调性。

在控制模块中,使用了C语言程序进行编程,对Kinect传感器模块所返回的图像进行程序内的算法处理,得到相应的手势动作,通过手势动作的辨别得到相应的飞行控制指令,通过电脑串口将执行指令传送至地面站模块,之后控制地面站模块与无人机飞行控制系统进行无线链路的串口通信,将指令传送至无人机飞行控制系统,飞行控制系统再控制无人机上的电机,完成指定的飞行动作。

并同时通过地面站模块来读取无人机飞控所回传的相应的无人机姿态和环境数据,并显示在控制程序的前面板界面上。

在电脑程序接收到一些极端姿态信息(比如连续翻转,机身翻转1 s以上默认为姿态危险)的时候,那么电脑程序会发送紧急停止指令,通过地面站发送出去,从而使无人机螺旋桨瞬间停止,从而保证地面人员的安全。

在人的动作指令没有发送时,无人机将会自动悬停于空中。

控制程序在保证无人机受到操控者控制以及回传数据显示的同时,也保证了3个系统模块的实时同步性,以及无人机操作的安全性,这也是系统整体联动协作的基础。

2 结语

在本项目中,Kinect体感器手势控制无人机摆脱了传统的遥控器操控方式,为入门级新手提供更加简单的控制方法,降低了操控的难度。

手朝上升空,手朝下降低,伸左手朝左,伸右手朝右等。

不同手势对应不同的无人机操作。

新的操作方式,添加了无人机的可玩性,从遥控器转化为肢体动作,降低了上手难度。

[参考文献]

[1]张翔,吴嘉敏,王慧,等.微型旋翼无人机系统的设计与实现[J].电脑与电信,2017(12):5-9.

[2]杨琼楠,张苗苗,杨聪锟,等.基于Kinect手势识别的智能小车控制系统设计[J].国外电子测量技术,2018(9):85-89.。