pbs torque 安装过程

GPU集群Torque排队系统使用手册

GPU集群Torque排队系统使⽤⼿册多媒体计算与通讯实验室GPU集群Torque排队系统使⽤⼿册袁平波 2016.5.20本实验室新购进24块K80 tesla GPU。

为了充分利⽤GPU计算资源,我们利⽤Torque来管理同学们的计算任务队列。

头结点的IP是192.168.17.240。

下⾯说明使⽤本GPU集群的⼏个步骤。

1.申请帐号.本集群有⼀个头结点和多个服务结点构成,因此提交计算作业需要在头结点上拥有帐号,需要使⽤集群的学⽣需要给我发⼀个申请邮件,同时cc给⾃⼰的导师,在导师批准后相应的帐号会被建⽴。

2.建⽴job脚本⽂件Torque管理系统不能直接提交⼆进制可执⾏⽂件,需要编写⼀个⽂本的脚本⽂件,来描述相关参数情况。

⼀个⽰例脚本⽂件myjob1.pbs如下:#PBS -N myjob1#PBS -o /home/username/myjob1.out#PBS -e /home/username/myjob1.err#PBS -l nodes=1:gpus=1:S#PBS -r ycd $PBS_O_WORKDIRecho Time is `date`echo Directory is $PWDecho This job runs on following nodes:cat $PBS_NODEFILEcat $PBS_GPUFILE./my_proc脚本⽂件中定义的参数默认是以#PBS开头的。

其中:-N 定义的是job名称,可以随意。

-o 定义程序运⾏的标准输出⽂件,如程序中printf打印信息,相当于stdout;-e 定义程序运⾏时的错误输出⽂件,相当于stderr。

-l 定义了申请的结点数和gpus数量。

nodes=1代表⼀个结点,⼀般申请⼀个结点,除⾮采⽤mpi并⾏作业;gpus=1定义了申请的GPU数量,根据应⽤实际使⽤的gpu数量来确定,S表⽰job类型,后⾯有详细描述。

曙光作业管理-调度系统安装配置手册

Torque + Maui配置手册之抛砖引玉篇本文将以应用于实际案例(南航理学院、复旦大学物理系、宁波气象局)中的作业调度系统为例,简单介绍一下免费开源又好用的Torque+Maui如何在曙光服务器上进行安装和配置,以及针对用户特定需求的常用调度策略的设定情况,以便可以起到抛砖引玉的作用,使更多的人关注MAUI这个功能强大的集群调度器(后期将推出SGE+MAUI版本)。

本文中的涉及的软件版本Torque 版本:2.1.7 maui版本:3.2.6p17。

1. 集群资源管理器Torque1.1.从源代码安装Torque其中pbs_server安装在node33上,TORQUE有两个主要的可执行文件,一个是主节点上的pbs_server,一个是计算节点上的pbs_mom,机群中每一个计算节点(node1~node16)都有一个pbs_mom负责与pbs_server通信,告诉pbs_server该节点上的可用资源数以及作业的状态。

机群的NFS共享存储位置为/home,所有用户目录都在该目录下。

1.1.1.解压源文件包在共享目录下解压缩torque# tar -zxf torque-2.1.17.tar.gz假设解压的文件夹名字为: /home/dawning/torque-2.1.71.1.2.编译设置#./configure --enable-docs --with-scp --enable-syslog其中,默认情况下,TORQUE将可执行文件安装在/usr/local/bin和/usr/local/sbin下。

其余的配置文件将安装在/var/spool/torque下默认情况下,TORQUE不安装管理员手册,这里指定要安装。

默认情况下,TORQUE使用rcp来copy数据文件,官方强烈推荐使用scp,所以这里设定--with-scp.默认情况下,TORQUE不允许使用syslog,我们这里使用syslog。

Linux并行集群的搭建PBS

Linux并行集群的搭建PBSLinux并行集群的搭建实验环境OS:CentOS 5.10 x86_64(一台admin,两台计算节点)主机名和和IP对应关系如下admin: 192.168.78.11node1:192.168.78.12node2:192.168.78.13软件版本:PBStorque-3.0.6.tar.gzmaui-3.3.1.tar.gzopenmpi-1.8.1.tar.bz2并行软件:apoa1.tar.gzNAMD_2.9_Linux-x86_64-multicore.tar.gz一:环境配置1.修改hosts文件,添加内容如下192.168.78.11 admin192.168.78.12 node1192.168.78.13 node22.设置无密码访问ssh-keygen一直按enter键即可,进入.ssh目录生成认证密码,并设置权限[root@admin ~]#cd.ssh/[**************]#lsid_rsa id_rsa.pub[**************]#cpid_rsa.pubauthorized_keys[**************]#chmod600authorized_keys[**************]#lltotal 12-rw------- 1rootroot 394 Aug 23 03:52 authorized_keys-rw------- 1rootroot 1675 Aug 23 03:50 id_rsa-rw-r--r-- 1rootroot 394 Aug 23 03:50 id_rsa.pub3.然后复制.ssh目录到所有计算节点[root@admin~]# for i in 1 2 ; do scp -r /root/.ssh node$i:/ro ot/ ; done第一次要输入两台计算节点的root密码,以后都是无密码访问了4.复制hosts文件到所有计算节点[root@admin ~]#for i in 1 2 ; do scp /etc/hosts node$i:/etc/ ; done5.配置nfs服务把管理节点上的/export作为共享目录[root@admin~]#mkdir -p /export/{apps,home,scripts,sourc e} //其中apps为软件共享目录,home为共享家目录[root@admin ~]#cat /etc/exports/export 192.168.78.0/255.255.255.0(rw,sync)6.启动nfs服务并检查启动是否成功[root@admin~]#chkconfig portmap on ; /etc/init.d/portma p startStartingportmap: [ OK ][root@admin~]#chkconfig nfs on ; /etc/init.d/nfs start[root@admin~]#showmount -e localhostExport listforlocalhost:/export 192.168.78.0/255.255.255.0[root@admin ~]#7.配置autofs[root@admin ~]#cat /etc/auto.master/home/etc/auto.home --timeout=1200/share/ec/auto.share --timeout=1200[root@admin ~]#cat /etc/auto.share* admin:/export/&[root@admin ~]#cat /etc/auto.home* -nfsvers=3 admin:/export/home/&[root@admin ~]#8.启动autofs服务[root@admin~]#chkconfig autofs on ; /etc/init.d/autofs star t9.复制auto.master auto.share auto.home到所有计算节点[root@admin ~]#for i in 1 2; do scp /etc/auto.master node$i: /etc/; done[root@admin ~]#for i in 1 2; do scp /etc/auto.share node$i:/ etc/; done[root@admin ~]#for i in 1 2; do scp /etc/auto.home node$i: /etc/; done10.启动autofs服务[root@admin ~]#for i in 1 2; do ssh node$i /etc/init.d/autof s start; done[root@admin ~]#for i in 1 2; do ssh node$i chkconfig autofs on; done11.配置NIS服务[root@admin ~]#yum -y install ypserv[root@admin~]#nisdomainname [root@admin~]#echo "NISDOMAIN=">>/etc /sysconfig/network[root@admin ~]#cp /usr/share/doc/ypserv-2.19/securenets /var/yp/[root@admin ~]#vi /var/yp/securenets修改后内容如下[root@admin~]#grep -v "^#" /var/yp/securenets255.0.0.0 127.0.0.0255.255.255.0 192.168.78.0[root@admin ~]#12.启动NIS服务[root@admin~]#/etc/init.d/ypserv start ;chkconfig ypserv o nStarting YP servers ervices: [ OK ][root@admin~]#/etc/init.d/yppasswdd start ;chkconfig yppa sswdd onStarting YP passwd service: [ OK ][root@admin ~]#13.修改/etc/default/useradd文件把HOME=/home更改为HOME=/export/home14.在/etc/skel目录下创建.ssh目录并在.ssh目录下建立一个名为config的文件,设置如下[root@admin~]#mkdir /etc/skel/.ssh[root@admin~]#touch /etc/skel/.ssh/config[root@admin ~]#cat /etc/skel/.ssh/configStrictHostKeyChecking noUserKnownHostsFile /dev/null[root@admin~]#chmod 600 /etc/skel/.ssh/config15.创建用于同步用户的命令◆在/usr/local/sbin目录下创建了一个名为sync_users的脚本,内容如下:#!/bin/bashYPINIT=/usr/lib64/yp/ypinitfor USER in $(sed -n '/export/p' /etc/passwd | awk -F ":" '{pri nt$1}')doif [ -z "$USER" ]; then$YPINIT -melseusermod -d /home/$USER $USERfidone$YPINIT -m◆赋予可执行权限chmod 755/usr/local/sbin/sync_users◆以后执行sync_users命令就可以同步新创建的用户16.创建一个测试用户linuxidc,并同步该用户[root@admin~]#useradd linuxidc[root@admin~]#echo linuxidc | passwd --stdin linuxidc[root@admin~]#sync_users注:以后每添加一个新用户,都需要执行sync_users命令17. 配置NIS客户端,在所有计算节点上安装ypbind,RHEL默认已经安装[root@admin~]# for i in 1 2; do ssh node$i auth-config --en able-nis --nisdomain= \--nisserver=admin --update; done18.验证NIS服务配置是否正确[root@node1~]#ypcat passwdlinuxidc:$1$tsPKQvPP$Kwom9qG/DNR1w/Lq./cQV.:500:500:: /home/linuxidc:/bin/bash[root@admin ~]#for i in 1 2; do ssh node$i id linuxidc; done uid=500(linuxidc) gid=500(linuxidc) groups=500(linuxidc)uid=500(linuxidc) gid=500(linuxidc) groups=500(linuxidc)有上面输出可知,NIS服务配置正确二:安装和配置torque(管理节点)1.首先安装openmpi[root@adminparallel]#tar xjvf openmpi-1.8.1.tar.bz2 -C /usr/ local/src/[root@adminparallel]#cd /usr/local/src/openmpi-1.8.1/[*********************.1]#./configure--prefix=/share/ap ps/openmpi[*********************.1]#make[*********************.1]#makeinstall[*********************.1]#cp-r examples/ /share/apps/ openmpi2.添加环境变量,在/share/scripts目录先建立了一个Path.sh,以后也方便计算节点添加环境变量[root@adminscripts]#pwd/share/scripts[root@adminscripts]#cat Path.sh#!/bin/bashgrep openmpi /etc/profile || cat >>/etc/profile <<EOFexport PATH=/share/apps/openmpi/bin:\$PATHexport LD_LIBRARY_PATH=/share/apps/openmpi/lib:\$LD_LI BRARY_PATHEOF[root@adminscripts]#[root@adminscripts]#sh Path.sh[root@adminscripts]#source /etc/profile3.测试openmpi是否安装成功[root@adminscripts]#which mpirun/share/apps/openmpi/bin/mpirun[root@adminscriptss]#which mpiexec/share/apps/openmpi/bin/mpiexec4.安装torque[root@adminparallel]#tar xzvf torque-3.0.6.tar.gz -C /share/ source/[root@adminparallel]#cd /share/source/torque-3.0.6/[********************.6]#./configure--enable-syslog --e nable-nvidia-gpus --enable-cpuset --disable-gui --with-rcp=scp --with-sendmail[********************.6]#make[********************.6]#makeinstall[********************.6]#pwd/share/source/torque-3.0.6[********************.6]#catinstall.shcd /share/source/torque-3.0.6make install[********************.6]#5.初始化torque创建默认队列[********************.6]#./torque.setuproot initializingTORQUE(admin: root@admin)PBS_Server admin:Create mode and server database exists, do you wishtocontinue y/(n)?yroot 26351 1 0 06:44? 00:00:00 pbs_server -t create Max openservers:10239Max openservers:10239[********************.6]#6.查看创建的默认队列batch[********************.6]#qmgr-c"ps"## Create queues and set their attributes.### Create and define queue batch#create queue batchset queue batch queue_type = Executionset queue batch resources_default.nodes = 1set queue batch resources_default.walltime= 01:00:00set queue batch enabled = Trueset queue batch started = True## Set server attributes.#set server scheduling = Trueset server acl_hosts = adminset server admins= root@adminset server operators = root@adminset server default_queue = batchset server log_events = 511set server mail_from = admset server scheduler_iteration = 600set server node_check_rate = 150set server tcp_timeout = 6set server mom_job_sync = Trueset server keep_completed = 300[********************.6]#7.更改队列batch部分属性,以满足实际需求[********************.6]#qmgr-c"sqbatchresources_de fault.walltime=24:00:00"[********************.6]#qmgr-c"ssquery_other_jobs=t rue"8.建立mom配置文件,用于复制到所有计算节点[root@adminmom_priv]#pwd/var/spool/torque/mom_priv[root@adminmom_priv]#cat config$pbsserver admin$logevent 2259.创建节点信息文件[root@adminserver_priv]#pwd/var/spool/torque/server_priv[root@adminserver_priv]#cat nodesnode1node2[root@adminserver_priv]#10.查看目前节点信息均为down状态[root@adminserver_priv]#pbsnodes -anode1state = downnp = 1ntype = clustermom_service_port = 15002mom_admin_port = 15003gpus = 0node2state = downnp = 1ntype = clustermom_service_port = 15002mom_admin_port = 15003gpus = 0[root@adminserver_priv]#11.复制pbs_server启动脚本,并设置开机自动启动[********************.6]#pwd/share/apps/torque-3.0.6[********************.6]#cpcontrib/init.d/pbs_server/etc /init.d/[********************.6]#chmod755/etc/init.d/pbs_serve r[********************.6]#chkconfigpbs_serveron12.复制pbs_mom脚本,方便复制到计算节点[********************.6]#cpcontrib/init.d/pbs_mom/etc/ init.d/13.安装maui[root@adminparallel]#tar xzvf maui-3.3.1.tar.gz -C /usr/local /src/[root@admin ~]#cd /usr/local/src/maui-3.3.1/[******************.1]#./configure--prefix=/usr/local/ma ui --with-pbs=/usr/local[******************.1]#make[******************.1]#makeinstall14.复制maui启动脚本,设置正确路径,并设置为开机启动[******************.1]#cpetc/maui.d/etc/init.d/mauid[******************.1]#vi/etc/init.d/mauid更改MAUI_PREFIX=/opt/maui为MAUI_PREFIX=/usr/local/m aui[******************.1]#chmod755/etc/init.d/mauid[******************.1]#chkconfigmauidon15.启动maui调度服务[******************.1]#/etc/init.d/mauidstartStartingMAUIScheduler: [ OK ][******************.1]#16.添加maui命令环境变量[******************.1]#vi/etc/profileexport PATH=/share/apps/openmpi/bin:/usr/local/maui/bin: $PATH[******************.1]#source/etc/profile17.安装并行软件到共享目录[root@adminnamd]#tar xzvf NAMD_2.9_Linux-x86_64-multi core.tar.gz -C /share/apps/[root@adminnamd]#tar xzvf apoa1.tar.gz -C /share/apps/ [root@adminapps]#pwd/share/apps[root@adminapps]#mv NAMD_2.9_Linux-x86_64-multicore/ namd18.添加namd命令环境变量,同时也添加到Path.sh方便计算节点添加环境变量[******************.1]#vi/etc/profileexport PATH=/share/apps/openmpi/bin:/usr/local/maui/bin: /share/apps/namd:$PATH[******************.1]#source/etc/profile[root@adminscripts]#which namd2/share/apps/namd/namd2[root@adminscripts]#cat Path.sh#!/bin/bashgrep openmpi /etc/profile || cat >>/etc/profile <<EOFexport PATH=/share/apps/openmpi/bin:/share/apps/namd:\$PATHEOF[root@adminscripts]#至此管理端配置完成三:计算节点配置torque1.计算节点安装torque[root@admin ~]#for i in 1 2; do ssh node$i sh /share/source /torque-3.0.6/install.sh; done2.复制mom配置文件到计算节点[root@admin ~]#for i in 1 2; do scp /var/spool/torque/mom _priv/confignode$i:/var/spool/torque/mom_priv/; done3.复制mom启动脚本到计算节点,启动pbs_mom服务,并设置开机启动[root@admin ~]#for i in 1 2; do scp /etc/init.d/pbs_mom no de$i:/etc/init.d/; done[root@admin ~]#for i in 1 2; do ssh node$i /etc/init.d/pbs_ mom start; doneStartingTORQUEMom: [ OK ]StartingTORQUEMom: [ OK ][root@admin ~]#for i in 1 2; do ssh node$i chkconfig pbs_m om on; done4.设置环境变量[root@admin ~]#for i in 1 2; do ssh node$i sh /share/scripts /Path.sh; done5.测试环境变量设置是否正确[root@admin ~]#for i in 1 2; do ssh node$i which mpirun; d one/share/apps/openmpi/bin/mpirun/share/apps/openmpi/bin/mpirun[root@admin ~]#for i in 1 2; do ssh node$i which namd2; d one/share/apps/namd/namd2/share/apps/namd/namd2[root@admin ~]#6.此时再观察计算节点状态,已经变成free了,即可以提交任务到计算节点了[root@adminapps]#pbsnodes -anode1state = freenp = 1ntype = clusterstatus=rectime=1408751492,varattr=,jobs=,state=free,netlo ad=12996103,gres=,loadave=0.01,ncpus=1,physmem=1024932 kb,availmem=2082428kb,totmem=2165536kb,idletime=0,nuser s=0,nsessions=0,uname=Linuxnode12.6.18-371.el5 #1 SMP Tue Oct 1 08:35:08 EDT 2013 x86_64,opsys=linuxmom_service_port = 15002mom_admin_port = 15003gpus = 0node2state = freenp = 1ntype = clusterstatus=rectime=1408751482,varattr=,jobs=,state=free,netlo ad=12983275,gres=,loadave=0.03,ncpus=1,physmem=1024932 kb,availmem=2082444kb,totmem=2165536kb,idletime=0,nuser s=0,nsessions=0,uname=Linuxnode22.6.18-371.el5 #1 SMP Tue Oct 1 08:35:08 EDT 2013 x86_64,opsys=linuxmom_service_port = 15002mom_admin_port = 15003gpus = 0[root@adminapps]#四:验证并行集群是否搭建成功1.在管理节点上以建立的linuxidc用户登录,首先设置节点间无密码互访,操作和root用户一样,只是不需要复制.ssh目录2.复制namd用软件apoa1到当前目录下[linuxidc@admin ~]$cp -r /share/apps/apoa1/ ./3.创建PBS脚本[linuxidc@admin~]$touch test.pbs脚本内容如下[linuxidc@admin ~]$cat test.pbs#!/bin/bash#PBS -N linuxidcjob1#PBS -j oe#PBS -l nodes=2:ppn=1NP=`cat $PBS_NODEFILE | wc -l`echo "This job's id is $PBS_JOBID@$PBS_QUEUE"echo "This job's workdir is $PBS_O_WORKDIR"echo "This job is running on following nodes:"cat $PBS_NODEFILEecho "This job begins at:" `date`echoechocd $PBS_O_WORKDIRmpirun -np $NP-machinefile $PBS_NODEFILE namd2 apoa1 /apoa1.namdechoechoecho "This job stops at:" `date`[linuxidc@admin ~]$4.提交任务[linuxidc@admin ~]$qsub test.pbs5.查看作业运行状态[linuxidc@admin~]$qstatJobid Name User Time UseS Queue -------------------------------------------------------- -------- - -----1.admin linuxidcjob1 linuxidc 0 R b atch[linuxidc@admin~]$qstat -nadmin:Req'd Req'd ElapJobID Username Queue Jobname SessID NDS TSK Memory Time S Time--------------------------------------- ---------------- ------ ----- ------ ------ ----- - -----1.admin linuxidc batch linuxidcjob1 66762 2 -- 24:00 R --node2/0+node1/0[linuxidc@admin ~]$由上面可知作业已经在node1和node2上运行了至此,linux并行集群搭建完成。

实时数据库Buffer机器安装步骤

中国石油炼油与化工运行系统二期推广项目 PHD Buffer机器安装说明孙浩 2008年3月19日Buffer机器安装步骤Oracle客户端的安装 Oracle客户端的网络服务配置 ODBC的配置 PHD Server的安装 TPI以及Desktop工具的安装 PHD Server的相关配置,以及TPI的使用 PHDManager的主要命令中国石油炼油与化工运行系统吉林石化项目组© 2007 BearingPoint, Inc.2Oracle 9i客户端的安装1基本上是默认 安装选择Custom 安装选择安装的插件有六个 Oracle Network Utilities SQL*Plus Oracle Windows Interfaces Oracle Call Interfaces Oracle9i Windows Documentation (optional) Oracle Universal Installer中国石油炼油与化工运行系统吉林石化项目组© 2007 BearingPoint, Inc.3Oracle客户端的网络服务配置Oracle客户端的安装过程中有个网络服务配置界面,可以 先忽略,在安装完毕后再进行配置,网络服务配置入口如 下图所示:中国石油炼油与化工运行系统吉林石化项目组© 2007 BearingPoint, Inc.4Oracle客户端的网络服务配置1选择网络服务 配置填入UNF填入Oracle服 务器的IP中国石油炼油与化工运行系统吉林石化项目组© 2007 BearingPoint, Inc.5Oracle客户端的网络服务配置1选择测试网络 服务测试成功后进 行下一步网络服务名为 UNIFORMANCE配置完成,如果机器加入了域,则网络服务名 会变为UNIFORMANCE.域名,可以进入 Oracle的安装路径下,例如: D:\oracle\ora92\network\ADMIN,用 写字板打开该目录下的tnsnames.ora文 件,进行手工编辑将后缀的域名去掉,只保留 UNIFORMANCE中国石油炼油与化工运行系统吉林石化项目组© 2007 BearingPoint, Inc.6ODBC的配置1添加新的 ODBC连接 选择Oracle数 据连接填写相关项目 内容测试连接,如果 通过则点击 OK按钮保存中国石油炼油与化工运行系统吉林石化项目组© 2007 BearingPoint, Inc.7PHD Server的安装1License参见 License文件可以选择安 装目录填写用户名和密码,可以直 接用本地管理员用户, 也可以选择域用户或者 新建用户,建议使用本 地管理员用户执行下一步直 至安装结束中国石油炼油与化工运行系统吉林石化项目组© 2007 BearingPoint, Inc.8TPI以及Desktop工具的安装TPI及Desktop工具安装比较简单,简单的执行默认安装即 可,也可以选择自定义安装,中间过程需要的License请参 考License文件。

torque安装步骤

一、创建新用户eradd hero2.passwd hero二、配置ssh无密码互登陆1.用新建用户在各节点上输入ssh-keygen,将目录下产生的id_rsa.pub复制并改名:cp id_rsa.pub authorized_keys2.每台设备通过ssh-copy-id root@X.X.X.X把本地主机的公钥复制到远程主机的authorized_keys3.ssh本机、对方主机检查是否为无密码登陆4./etc/init.d/iptables stop //关闭防火墙chkconfig iptables off //永久关闭防火墙三、修改主机名1.hostname newname//通过hostname查看发现主机名变为newname2.vi /etc/sysconfig/network 将里面的HOSTNAME修改成HOSTNAME=newname //永久修改hostname三、安装torque1.tar zxvf torque-4.1.2.tar.gz 解压缩2.用hero执行sudo ./configure执行时会报错,需先添加sudo 文件的写权限,命令是:chmod u+w /etc/sudoers,编辑sudoers文件:vi /etc/sudoers。

找到这行 root ALL=(ALL) ALL,在他下面添加hero ALL=(ALL) ALL3.进入torque-4.1.2目录下: ./configure //查看安装环境4.系统会出现检测结果,出现no提示的组件需要手动下载。

直到所需组件全部安装完成后,会出现Ready for 'make'的提示。

hero@master$sudo ./configure5.输入make进行源代码编译hero@master$sudo make6.切换回root用户进行安装root# make install四、修改/etc/hosts在每台设备上 vi/etc/hosts192.168.0.200 master192.168.0.201 node1192.168.0.202 node2五、配置master设备1.[root@master]# ./torque.setup root2.[root@master]#cd /var/spool/torque/server_priv[root@master]#vi nodesnode1 np=64node2 np=64node3 np=64(注释:每行代表一个节点,np 为该节点的cpu核数目,这里服务器node1也作为计算节点。

集群资源管理器Torque安装配置

集群资源管理器Torque安装配置Torque有三个重要的可执行文件,运行在主节点上的pbs_server和pbs_sched(对于比较简单的情况,这里使用这个Torque自带的调度器)及运行在计算节点上的pbs_mom,提交任务前要先启动这三个服务。

为方便阅读,命令及在需要编辑文件的内容以兰色字体显示。

如果没有说明路径,操作(如cp)是在/root/software/torque-2.5.4进行的。

1.编译安装1.1 解压源文件包假设解压的文件放在/root/software# cd /root/software# tar -xvf torque-2.5.4.tar.gz1.2 编译配置# cd torque-2.5.4#./configure --enable-docs --with-scp --enable-syslog --with-default-server=xxx(headnode-name)其中,默认情况下,TORQUE将可执行文件安装在/usr/local/bin和/usr/local/sbin下。

其余的配置文件将安装在/var/spool/torque下(其实直接./configure应该也可以)。

1.3 编译安装# make# make install2.参数设置2.1在Server端设置队列管理员在torque的安装源文件根目录中,执行#./torque.setup root上面的命令以root作为torque的管理员账号创建作业队列,也可以指定其它的用户作管理员。

如果此处添加失败,有可能是机器用户名不对,执行这步之前要确认用户名,如果出现BS_Server: LOG_ERROR::pbsd_main, unable to determine local server hostname - gethostbyname(pbsmaster.localdomain) failed, h_errno=1解决方法:add a line in /etc/host:192.168.1.101 pbsmaster pbsmaster.localdomain2.2 Server端资源管理配置(指定计算节点)为了让pbs_server与每个计算节点进行通信,它需要知道要和那些机器联络,集群中的每个计算节点都必须在nodes 文件中指定,一行一个节点,对于只有一个节点的情况只用增加一行就行。

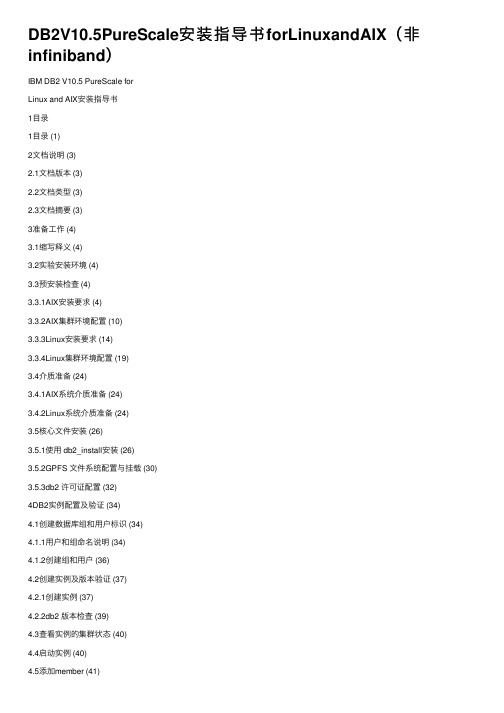

DB2V10.5PureScale安装指导书forLinuxandAIX(非infiniband)

DB2V10.5PureScale安装指导书forLinuxandAIX(⾮infiniband)IBM DB2 V10.5 PureScale forLinux and AIX安装指导书1⽬录1⽬录 (1)2⽂档说明 (3)2.1⽂档版本 (3)2.2⽂档类型 (3)2.3⽂档摘要 (3)3准备⼯作 (4)3.1缩写释义 (4)3.2实验安装环境 (4)3.3预安装检查 (4)3.3.1AIX安装要求 (4)3.3.2AIX集群环境配置 (10)3.3.3Linux安装要求 (14)3.3.4Linux集群环境配置 (19)3.4介质准备 (24)3.4.1AIX系统介质准备 (24)3.4.2Linux系统介质准备 (24)3.5核⼼⽂件安装 (26)3.5.1使⽤ db2_install安装 (26)3.5.2GPFS ⽂件系统配置与挂载 (30)3.5.3db2 许可证配置 (32)4DB2实例配置及验证 (34)4.1创建数据库组和⽤户标识 (34)4.1.1⽤户和组命名说明 (34)4.1.2创建组和⽤户 (36)4.2创建实例及版本验证 (37)4.2.1创建实例 (37)4.2.2db2 版本检查 (39)4.3查看实例的集群状态 (40)4.4启动实例 (40)4.5添加member (41)4.6添加CF (42)4.7为实例配置 TCP/IP 通信 (43)4.7.1更新 services ⽂件 (43)4.7.2更新数据库管理器配置 (44)4.8配置 DB2 服务器通信 (44)5数据库创建 (44)5.1实例注册变量设置 (44)5.1.1注册变量设置 (44)5.1.2注册变量检查 (45)5.2创建SAMPLE数据库 (45)2⽂档说明2.1⽂档版本⽂档历史2.2⽂档类型2.3⽂档摘要本⽂档描述数据库产品 DB2 V10.5.0.4 PureScale在Linux 和 Unix平台的安装、配置等内容。

集群资源管理器Torque安装配置

集群资源管理器Torque安装配置集群资源管理器T orque安装配置Torque有三个重要的可执行文件,运行在主节点上的pbs_server 和pbs_sched(对于比较简单的情况,这里使用这个Torque自带的调度器)及运行在计算节点上的pbs_mom,提交任务前要先启动这三个服务。

为方便阅读,命令及在需要编辑文件的内容以兰色字体显示。

如果没有说明路径,操作(如cp)是在/root/software/torque-2.5.4进行的。

1.编译安装1.1 解压源文件包假设解压的文件放在/root/software# cd /root/software# tar -xvf torque-2.5.4.tar.gz1.2 编译配置# cd torque-2.5.4#./configure --enable-docs --with-scp --enable-syslog --with-default-server=xxx(headnode-name)其中,默认情况下,TORQUE将可执行文件安装在/usr/local/bin 和/usr/local/sbin下。

其余的配置文件将安装在/var/spool/torque下(其实直接./configure应该也可以)。

1.3 编译安装# make# make install2.参数设置2.1在Server端设置队列管理员在torque的安装源文件根目录中,执行#./torque.setup root上面的命令以root作为torque的管理员账号创建作业队列,也可以指定其它的用户作管理员。

如果此处添加失败,有可能是机器用户名不对,执行这步之前要确认用户名,如果出现BS_Server: LOG_ERROR::pbsd_main, unable to determine local server hostname - gethostbyname(pbsmaster.localdomain) failed, h_errno=1解决方法:add a line in /etc/host:192.168.1.101 pbsmaster pbsmaster.localdomain2.2 Server端资源管理配置(指定计算节点)为了让pbs_server与每个计算节点进行通信,它需要知道要和那些机器联络,集群中的每个计算节点都必须在nodes 文件中指定,一行一个节点,对于只有一个节点的情况只用增加一行就行。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

单机安装torque PBS过程

(广石化应用物理系 XU)

去torque官网下载安装包,以最新的6.1.1为例。

使用系统为最新的centos7。

首先设置 hostname。

Vi /etc/hosts

修改成如下:(我的hostname是wuzhou509)

127.0.0.1 wuzhou509 wuzhou509 localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 Vi /etc/hostname

修改成wuzhou509

然后,重新登录。

输入命令 hostname ,看是否修改成功。

解压torque

./configure (如果要改目录,在这里加参数)

Make

Make install

如何提示缺少/etc/lib/ld 那是因为有些依赖包没装。

∙libxml2-devel package (package name may vary)

∙openssl-devel package (package name may vary)

∙Tcl/Tk version 8 or later if you plan to build the GUI portion of TORQUE or use a Tcl based scheduler

∙If your configuration uses cpusets, you must install libhwloc; the corresponding hwloc-devel package is also required. See 4.6 Linux Cpuset Support.

用 yum install libtool openssl-devel libxml2-devel boost-devel gcc gcc-c++

安装上面的东西。

安装完成后。

设置。

Red Hat 6-based systems

[root]# cp contrib/init.d/trqauthd /etc/init.d/

[root]# chkconfig --add trqauthd

[root]# echo /usr/local/lib > /etc/ld.so.conf.d/torque.conf

[root]# ldconfig

[root]# service trqauthd start

SUSE 11-based systems

[root]# cp contrib/init.d/suse.trqauthd /etc/init.d/trqauthd

[root]# chkconfig --add trqauthd

[root]# echo /usr/local/lib > /etc/ld.so.conf.d/torque.conf

[root]# ldconfig

[root]# service trqauthd start

Red Hat 7-based and SUSE 12-based systems

[root]# cp contrib/systemd/trqauthd.service /usr/lib/systemd/system/

[root]# systemctl enable trqauthd.service

[root]# echo /usr/local/lib > /etc/ld.so.conf.d/torque.conf

[root]# ldconfig

[root]# systemctl start trqauthd.service

接下来继续:

1.Verify that the /var/spool/torque/server_name file exists and contains

the correct name of the server.

[root]# echo <pbs_server's_hostname>>/var/spool/torque/server_name

2.By default, TORQUE installs all binary files

to /usr/local/bin and /usr/local/sbin. Make sure the path environment variable includes these directories for both the installation user and the root user.

[root]# export PATH=/usr/local/bin/:/usr/local/sbin/:$PATH

3.Initialize serverdb by executing the torque.setup script.

[root]# ./torque.setup root

这一步如果出错,检查hostname是否按照上面修改hosts

新建 /var/spool/torque/server_priv/nodes

内容为:wuzhou509 np=32 all

新建/var/spool/torque/mom_priv/config 内容为:

$pbsserver wuzhou509 # hostname running pbs server

$logevent 225 # bitmap of which events to log

修改walltime

qmgr-c "set queue batch resources_default.walltime=900:00:00"

然后qterm

填加自动启动:

* If RHEL distribution, do the following *

[root]# cp contrib/init.d/pbs_server contrib/init.d/pbs_mom contrib/init.d/pbs_sched /etc/init.d

[root]# chkconfig --add pbs_server

[root]# chkconfig --add pbs_sched

[root]# chkconfig --add pbs_mom

[root]# service pbs_server restart

[root]# service pbs_sched restart

[root]# service pbs_mom start

完成。