第7章无约束优化问题

无约束最优化方法直接搜索法课件

x2

S(1)

S2(1

)

(1)

X3 X2 (1)

X* X2 (2) X1 (2)

S(2)

X0 (1)

X 1 (1)

S1(1) x1

• 鲍威尔基本算法的缺点

鲍威尔基本算法仅具有理论意义,不要说对于一般的 函数,就是对于二次函数,它也可能失效。因为在迭代过程 中的n个搜索方向有时会变成线性相关,而不能形成共轭方向, 从而张不成n维空间,导致随后的迭代搜索在降维(“退化”) 的空间中进行,可能求不到极小点,故需进行改进。

x 2 XL X2

Xn+3 Xn+2

Xn+1

Xห้องสมุดไป่ตู้ XH

X1 XG x1

6)扩张:当 fn+2 < f L 时,取扩张点Xn+3 ,即

Xn+3 = Xn+1 + (Xn+2 – Xn+1)

( =1.2~2.0 )

并计算 fn+3 = f (Xn+3 ) 。 若 fn+3 < fn+2 ,则以Xn+3 代替 X H , fn+3 代替 fH ,构造一个新的单纯形;否则,以 X n+2 代 替XH , fn+2 代替fH ,构造新的单纯形;然后返回到 3)。

鲍威尔条件:

若 f 3 < f 1, ( f1 - 且2f2 + f3) (f1 - f2 - △m(k))2 < 0.5 △m(k) (f1 - f3 )2 同时成立,则用 S ( k ) 替代 S m ( k ) ;否则,仍用 就是鲍威尔修正算法,通常所说的鲍威尔算法就是指这一修正算法。

• 鲍威尔算法的计算步骤及算法框图

牛顿法无约束最优化证明

牛顿法无约束最优化证明牛顿法是一种常用的非线性优化方法,它通过逐步逼近最优解来求解无约束最优化问题。

本文将介绍牛顿法的数学原理及其证明过程。

首先,我们考虑一个无约束的最优化问题,即:min f(x)其中,f(x)为目标函数,x为优化变量。

我们的目标是找到一个x,使得f(x)最小。

牛顿法的基本思想是通过求解目标函数的局部二次近似来逐步逼近最优解。

具体来说,我们首先选取一个初始点x0,然后利用目标函数的一、二阶导数信息,计算出目标函数在x0处的局部二次近似:f(x) ≈ f(x0) + f(x0)·(x-x0) + 1/2(x-x0)T·H(x0)·(x-x0) 其中,f(x0)为目标函数在x0处的梯度,H(x0)为目标函数在x0处的黑塞矩阵。

我们将局部二次近似表示为:Q(x) = f(x0) + f(x0)·(x-x0) + 1/2(x-x0)T·H(x0)·(x-x0) 然后,我们将Q(x)的导数置为零,得到如下方程:H(x0)·(x-x0) = -f(x0)接着,我们解出上述方程的解x1,将x1作为新的近似点,重复上述步骤,迭代求解,直到收敛于最优解。

接下来,我们来证明牛顿法的收敛性。

我们假设目标函数f(x)满足如下条件:1. f(x)是二次可微的凸函数。

2. H(x)是正定的。

在这种情况下,我们可以证明牛顿法是线性收敛的。

具体来说,设xk为牛顿法第k次迭代的近似解,x*为最优解,则有:f(xk+1) - f(x*) ≤ C·(f(xk) - f(x*))2其中,C>0是一个常数。

这个式子表明,每次迭代后,算法的误差都会平方级别的减小。

证明过程比较复杂,需要利用函数的泰勒展开式、中值定理等工具。

具体证明过程可以参考相关数学文献。

综上所述,牛顿法是一种有效的无约束最优化方法,其收敛速度较快,但需要满足一定的条件才能保证收敛性。

无约束问题的最优化条件

f

(x)

f

(xk ) f

(xk )T

(x

xk )

1 (x 2

xk )T 2

f

(xk )(x

xk )

Q(k) (x)

f

(xk ) f

(xk )T (x xk )

1 2

(

x

xk

)T

2

f

(xk )(x xk )

令

Q(k) (x) x

0

f

( xk

)

2

f

(

xk

)(

x

xk

)

0

x xk (2 f (xk ))1f (xk ) xk Gk1gk

k 满足:

f (xk

dk ) 0

T f (xk k dk )gdk 0

ห้องสมุดไป่ตู้

d

T k 1

gd

k

0

14

a

5.3 牛顿法

自动化学院

15

a

一、牛顿迭代公式

牛顿法的基本思想是利用目标函数在当前迭代点 xk 处 的二次近似的极小点作为 f (x) 的近似极小点。

16

a

设 xk 是当前迭代点, 2 f (xk ) 正定,

5.1 无约束问题的 最优性条件

自动化学院

1

a

一、极小点的概念

1.局部极小点 2.严格局部极小点 3.全局(总体)极小点 4.严格全局(总体)极小点。 注:在非线性规划中,大多数算法都致力于求最优化 问题的局部极小点,一般求全局极小点极为困难,仅 当问题为凸规划时,局部极小为全局极小。

2

a

二、无约束问题最优性条件

的极小值,0.01,x(0)(0,0)T ,只迭代一次

无约束常用优化方法

步长 ,作前进(或后退)试探.如试探成功(目

标函数值有所减小),则按步长序列

,加

大步长(注意每次加大步长都是由初始点算起),直

至试探失败(目标函数值比前一次的有所增加)时,

则取其前一次的步长作为沿这个坐标轴方向搜索的最

优步长,并计算出该方向上的终止点,而后以这个终

止点为始点再进行下一坐标轴方向的搜索,并重复上

处

显然 是二次函数,并且还是正定二次函数,所以 是凸函数且存在唯一全局极小点.为求此极小点,令

即可解得

即

(5.9)

对照基本迭代公式,易知,式(5.9)中的搜索方向

步长因子

方向

是直指点 处近似二次函数

的极小点的方向.此时称此方向为从点 出发的

Newton方向.从初始点开始,每一轮从当前迭代点出发,

沿Newton方向并取步长 的算法称为Newton法.

另外,共轭梯度法不要求精确的直线搜 索.但是,不精确的直线搜索可能导致迭代 出来的向量不再共轭,从而降低方法的效 能.克服的办法是,重设初始点,即把经过 n次迭代得到的Xn作为初始点重新迭代.

五、坐标轮换法

在坐标轮换法中,沿各个坐标轴方向进行一维搜索

时,常选用最优步长法或加速步长法.加速步长法从

初始点出发,沿搜索(坐标轴)方向先取一个较小的

三、共轭方向法

1、概念

通常,我们把从任意点

出发,依次沿某组共轭

方向进行一维搜索的求解最优化问题的方法,叫做共

轭方向法.

2、特点

• 一般地,在n维空间中可以找出n个互相共轭的方向,对于n元正 定二次函数,从任意初始点出发,顺次沿这n个共轭方向最多作n 次直线搜索就可以求得目标函数的极小点.这就是共轭方向法的 算法形成的基本思想.

最优化方法 powell法求解无约束优化问题

数学与计算科学学院实验报告

实验项目名称powell法求解无约束优化问题

所属课程名称最优化方法

实验类型算法编程

实验日期

班级

学号

姓名

成绩

附录1:源程序

附录2:实验报告填写说明

1.实验项目名称:要求与实验教学大纲一致。

2.实验目的:目的要明确,要抓住重点,符合实验教学大纲要求。

3.实验原理:简要说明本实验项目所涉及的理论知识。

4.实验环境:实验用的软、硬件环境。

5.实验方案(思路、步骤和方法等):这是实验报告极其重要的内容。

概括整个实验过程。

对于验证性实验,要写明依据何种原理、操作方法进行实验,要写明需要经过哪几个步骤来实现其操作。

对于设计性和综合性实验,在上述内容基础上还应该画出流程图、设计思路和设计方法,再配以相应的文字说明。

对于创新性实验,还应注明其创新点、特色。

6.实验过程(实验中涉及的记录、数据、分析):写明具体实验方案的具体实施步骤,包括实验过程中的记录、数据和相应的分析。

7.实验结论(结果):根据实验过程中得到的结果,做出结论。

8.实验小结:本次实验心得体会、思考和建议。

9.指导教师评语及成绩:指导教师依据学生的实际报告内容,给出本次实验报告的评价。

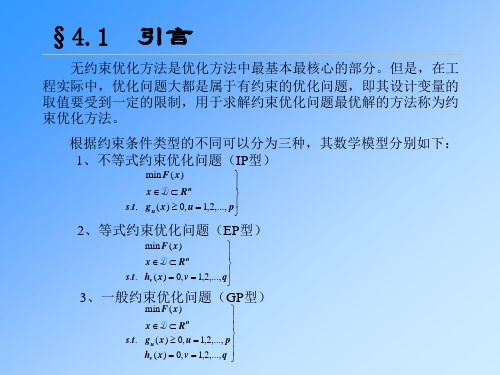

约束问题的最优化方法

m

⑤ .Φ ( x, r ) = f ( x) − r ∑ ln[− g u ( x)]

(k )

其中:惩罚(加权)因子 降低系数 c:

r ( 0 ) > r (1) > ....r ( k )

0< c <1

r ( k −1) ⋅ c = r ( k )

xk * → x *

当lim r ( k ) → 0

x ∈ D ⊂ Rn s.t. g u ( x ) ≥ 0, u = 1,2,..., p hv ( x ) = 0, v = 1,2,..., q min F ( x )

一. 约束优化问题解法分类: 约束优化方法按求解原理的不同可以分为直接法和间接法两类。

直接解法:随机方向搜索法、复合形法、可行方向法

其中:g u ( x) ≥ 0, u = 1,2,...m

③ .Φ ( x, r ) = f ( x) − ∑ ru ( k )

(k ) u =1

m

1 g u ( x)

④ .Φ ( x, r ) = f ( x) + r

(k )

(k )

(k )

1 ∑ 2 u =1 [ g u ( x )]

m u =1

k →∞

则Φ ( x, r ( k ) ) → f ( x) ,

) x12 + x22 例: 用内点法求 min f ( x=

s.t. g ( x ) = 1 − x1 ≤ 0

的约束最优解。

2 解: 首先构造内点惩罚函数:φ ( x , r ) = x12 + x2 − r k ln( x1 − 1)

(k ) u =1 m

lim r2 H [hv ( x ( k ) )] = 0

凸优化之无约束优化(一维搜索方法:二分法、牛顿法、割线法)

凸优化之⽆约束优化(⼀维搜索⽅法:⼆分法、⽜顿法、割线法)1、⼆分法(⼀阶导)⼆分法是利⽤⽬标函数的⼀阶导数来连续压缩区间的⽅法,因此这⾥除了要求 f 在 [a0,b0] 为单峰函数外,还要去 f(x) 连续可微。

(1)确定初始区间的中点 x(0)=(a0+b0)/2 。

然后计算 f(x) 在 x(0) 处的⼀阶导数 f'(x(0)),如果 f'(x(0)) >0 , 说明极⼩点位于 x(0)的左侧,也就是所,极⼩点所在的区间压缩为[a0,x(0)];反之,如果 f'(x(0)) <0,说明极⼩点位于x(0)的右侧,极⼩点所在的区间压缩为[x(0),b0];如果f'(x(0)) = 0,说明就是函数 f(x) 的极⼩点。

(2)根据新的区间构造x(1),以此来推,直到f'(x(k)) = 0,停⽌。

可见经过N步迭代之后,整个区间的总压缩⽐为(1/2)N,这⽐黄⾦分割法和斐波那契数列法的总压缩⽐要⼩。

1 #ifndef _BINARYSECTION_H_2#define _BINARYSECTION_H_34 typedef float (* PtrOneVarFunc)(float x);5void BinarySectionMethod(float a, float b, PtrOneVarFunc fi, float epsilon);67#endif1 #include<iostream>2 #include<cmath>3 #include "BinarySection.h"45using namespace std;67void BinarySectionMethod(float a, float b, PtrOneVarFunc tangent, float epsilon)8 {9float a0,b0,middle;10int k;11 k = 1;12 a0 = a;13 b0 = b;14 middle = ( a0 + b0 )/2;1516while( abs(tangent(middle)) - epsilon > 0 )17 {18 #ifdef _DEBUG19 cout<<k++<<"th iteration:x="<<middle<<",f'("<<middle<<")="<<tangent(middle)<<endl;20#endif2122if( tangent(middle) > 0)23 {24 b0 = middle;25 }26else27 {28 a0 = middle;29 }30 middle =( a0+b0)/2;31 }3233 cout<<k<<"th iteration:x="<<middle<<",f'("<<middle<<")="<<tangent(middle)<<endl;34 }1 #include<iostream>2 #include "BinarySection.h"345float TangentFunctionofOneVariable(float x)6 {7return14*x-5;//7*x*x-5*x+2;8 }910int main()11 {12 BinarySectionMethod(-50, 50, TangentFunctionofOneVariable, 0.001);13return0;14 }1th iteration:x=0,f'(0)=-52th iteration:x=25,f'(25)=3453th iteration:x=12.5,f'(12.5)=1704th iteration:x=6.25,f'(6.25)=82.55th iteration:x=3.125,f'(3.125)=38.756th iteration:x=1.5625,f'(1.5625)=16.8757th iteration:x=0.78125,f'(0.78125)=5.93758th iteration:x=0.390625,f'(0.390625)=0.468759th iteration:x=0.195312,f'(0.195312)=-2.2656210th iteration:x=0.292969,f'(0.292969)=-0.89843811th iteration:x=0.341797,f'(0.341797)=-0.21484412th iteration:x=0.366211,f'(0.366211)=0.12695313th iteration:x=0.354004,f'(0.354004)=-0.043945314th iteration:x=0.360107,f'(0.360107)=0.041503915th iteration:x=0.357056,f'(0.357056)=-0.001220716th iteration:x=0.358582,f'(0.358582)=0.020141617th iteration:x=0.357819,f'(0.357819)=0.0094604518th iteration:x=0.357437,f'(0.357437)=0.0041198719th iteration:x=0.357246,f'(0.357246)=0.0014495820th iteration:x=0.357151,f'(0.357151)=0.0001144412、⽜顿法(⼆阶导)前提:f 在 [a0,b0] 为单峰函数,且[a0,b0] 在极⼩点附近,不能离的太远否则可能⽆法收敛。

单目标无约束优化问题的数学模型

单目标无约束优化问题的数学模型说起单目标无约束优化问题,那可真的是一个充满挑战又让人头大的玩意儿。

听起来是不是很高深?别担心,慢慢来,我们一点一点捋清楚它的来龙去脉。

简单说,这个问题就是在给定的条件下,找出一个最优解,换句话说,如何在某些约定俗成的框架内做到最好、最强、最牛。

比如说,咱们想要跑得快,但又不能随便穿双拖鞋,得穿合适的跑鞋,这就是在“没有任何限制”的情况下,选出最适合的“最佳状态”。

咱们得弄清楚,所谓的“单目标”是什么意思。

就是你只有一个目标,专心致志地冲这个目标去。

你可以想象一下,这就像你在做一道数学题,题目清晰写着:求一个数,这个数最好能满足某些条件。

你也不能多想,眼睛就盯着这个目标走。

听着是不是有点像考试那种,老师说了:做对一道题,你就能加分,剩下的暂时不管。

是不是挺简单?不过,事儿可没那么简单。

这个“目标”得有点实际意义,得是真正有用的,比如,跑步速度、成本最小化、利润最大化这些,咱可不能随便给个“目标”就行。

然后啊,说到“无约束”优化,大家可能会想:“没有约束?那岂不是可以做任何事?”别高兴太早。

无约束的意思不是说你可以乱来,而是说在求解过程中,你的解答不受外部条件的限制。

你想选哪个方向就选哪个,不用再被一些“死板”的规则拴住手脚。

假设你要找一个商场,商场的大小、停车场的多少都不管,它就是目标,你只管去。

自由吗?是自由,但要明白自由不等于胡乱选择,得找那个能让你达到目标的最合适的地方。

接下来的关键问题是,如何找到最优解?哦哟,这可真不是一件容易的事。

你得有点本事,得懂得怎么从一堆选择中挑出那个最“牛”的。

比如跑步吧,你可能想,能跑得快就是最优解。

可真到了跑步这事上,你可能得考虑,哪条路最短,风速如何,甚至风景好不好。

这些都得考虑进去,反正你不能只盯着一个目标。

这里面其实就是用“目标函数”来表达,你的目标就是要在某些条件下最大化或者最小化某个数值——就像你看电影,想找到评分最高的那部电影一样,你就是用一个标准来决定哪部最好看。

无约束优化之坐标轮换法

无约束优化方法——坐标轮换法一.基本原理坐标轮换法是每次允许一个变量变化,其余变量保持不变,即沿坐标方向轮流进行搜索的寻优方法。

它把多变量的优化问题轮流的转化成单变量的优化问题,因此又称变量轮换法。

在搜索的过程中可以不需要目标函数的导数,只需目标函数值信息。

它比利用目标函数导数建立搜索方向的方法简单的多。

以二元函数飞f(x1,x2)为例说明坐标轮换法的寻优过程。

从初始点x00出发,沿第一个坐标方向搜索,即d10=e1得x10=x00+a01*d01按照一维搜索方法确定最佳步长因子a01满足minf(x00+a*d01),然后从x01出发沿d02=e2方向搜索得x02=x01+a02*d02,其中步长因子a02满足minf(x01+a*d02),x02为一轮(k=0)的终点。

检验始、终点之间的距离是否满足精度要求,即判断||x02-x00||<e的条件是否满足。

若满足则x*=x02,否则令x10=x02,重新一次沿坐标方向进行下一轮的搜索。

对于n个变量的函数,若在第k 轮沿第i个坐标方向dki进行搜索,其迭代公式为xki=xk(i-1)+aki+dki(k=0,1,2…,i=0,1,2…n)其中搜索方向取坐标方向,即dki=ei(i=1,…n)。

若||xkn-x00||<e,则x*=xkn,否则x(k+1)0=xkn,进行下一轮搜索,一直到满足精度为止。

注:上述xki中,其中k为上标,i为下标二.例题及程序1.用坐标轮换法求f(1x,2x)=10(1x+2x-5)^2+(1x-2x)^2极小值2.程序(1)function y=f(x)y=10*(x(1)+x(2)-5)^2+(x(1)-x(2))^2; ………………………..%定义f文件(2)d1=e1;syms a1;x1=x0+a1*d1;y1=f(x1);z1=diff(y1,a1);subs(z1);a1=solve(z1);%求沿e1方向最佳步长x1=x0+a1*d1;d2=e2;syms a2;x2=x1+a2*d2;y2=f(x2);z2=diff(y2,a2);subs(z2);a2=solve(z2);%求沿e2方向最佳步长x2=x1+a2*d2;m=x2-x0;m=double(m);t=norm(m); ……….%定义f2文件(3)x0=[0;0];e=0.001;e1=[1;0];e2=[0;1];f2; ………………%定义f3文件(4)f3;while (t>=e)x0=x2;f2;endx2=double(x2);xo=x2;xo…………………%定义f4文件三.程序框图四.计算结果及说明运用MATLAB运算结果如上所示,运算结果比较精确,跟课本上用鲍威尔方法计算结果比较相近。

无约束问题的最优化条件

即,在算法每次迭代中,求解信赖域子问题:

1 T min (d ) f ( xk ) g k d d Gk d 2

(k ) T

s.t

d hk

在信赖域算法中,信赖域半径 hk 采用自适应方式调整, 若

(k )

(d ) 与 f ( xk d ) 近似程度好,则 hk 尽可能取大,

T (0)

2)方向

d

(0)

(G( x )) f ( x ) 1, 3 2

(0) 1 (0)

T

3)求最优步长

x

(0) dFra bibliotek(0)代入目标函数得:

(1)

1 0 3 3 0 2 2

(0)

三、最速下降算法收敛性定理

定理 5 设 f C1 (一阶连续可微), S x f ( x ) f ( x0 )

有界,则由最速下降法得到的迭代点列 xk 具有如下性质: 1) 数列 f ( xk ) 严格单调下降; 2) xk 的任何极限点(聚点) x 都是 f ( x ) 的驻点,

T k 1

d k 0

5.3 牛顿法

自动化学院

一、牛顿迭代公式

牛顿法的基本思想是利用目标函数在当前迭代点 xk 处 的二次近似的极小点作为 f ( x ) 的近似极小点。

设 xk 是当前迭代点, 2 f ( xk ) 正定,

1 f ( x) f ( xk ) f ( xk ) ( x xk ) ( x xk )T 2 f ( xk )( x xk ) 2 1 (k ) T Q ( x) f ( xk ) f ( xk ) ( x xk ) ( x xk )T 2 f ( xk )( x xk ) 2

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Matlab设计与优化

注意:

1.对于求解平方和的问题,fminunc函数 不是最好的选择,用lsqnonlin函数效果更 佳。

2.使用大型方法时,必须通过将options. GradObj设置为'on'来提供梯度信息,否 则将给出警告信息。

唯一极小 (全局极小)

f 0.298

f 0

f (x1 x2 ) 2x12 2x1x2 x22 3x1 x2

多局部极小

f 0.298

搜索过程 minMaft(laxb1 设x计2 )与优10化0 (x2 x12 )2 (1 x1)2

x1 x2 f

-1 1 4.00 -0.79 0.58 3.39 -0.53 0.23 2.60 -0.18 0.00 1.50 0.09 -0.03 0.98 0.37 0.11 0.47 0.59 0.33 0.20 0.80 0.63 0.05 0.95 0.90 0.003 0.99 0.99 1E-4 0.999 0.998 1E-5

第7章 无约束优化问题

最优化数学模型的不带约束条件形式;

优化问题一般指:寻找 x* (x1*, x2*, , xn* )T D

使 z f (x1*, x2*, , xn*)为目标函数f在可行域上的

最小值(或最大值).

称为最优解, x*

f (x1*, x2*, , xn* )

称为最优值.

Matlab设计与优化

Matlab设计与优化

关于fminbnd函数

算法: fminbnd是一个M文件。其算法基于黄金分割法和二次插值 法。 局限性: 1.目标函数必须是连续的。 2.fminbnd函数可能只给出局部最优解。 3.当问题的解位于区间边界上时,fminbnd函数的收敛速度 常常很慢。此时,fmincon函数的计算速度更快,计算精度 更高。 4.fminbnd函数只用于实数变量。 参见:

4.7124

即区间(0,2π)上函数sin(x)的最小值点位于 x=4.7124处。

最小值处的函数值为: y = sin(x) y=

-1.0000

Matlab设计与优化

7.2 无约束非线性规划问题

7.2.1 数学原理及模型 1.数学模型 2.算法介绍

Matlab设计与优化

7.2.2 MATLAB工具箱中的基本函数

用options参数指定的优化参数进行最小化。 (3)[x,fval]= fminbnd(...) 回解x处目标函数的值 (4)[x,fval,exitflag]= fminbnd(...) 返回exitflag值描述fminbnd函数的退出条件。 (5)[x,fval,exitflag,output]= fminbnd(...) 返回包含优化信息的结构输出。

0.9997 0.9998 1E-8

最优点 (1 1) 初始点 (-1 1)

Matlab设计与优化

7.1 一维优化问题

7.1.1 数学原理及模型 1.数学模型

一元函数无约束优化问题: min f(x) x1 x x2

2.相关函数: fminbnd 功能:找到固定区间内单变量函数的最小值。

最优解有严格与非严格和全局与局部之分.优化模型的最优 解是指全局最优解.

一维函数的最优解图示 这里指出:最优化方法解出的多是优化模型的局部最优解.

由于最优化方法多为迭代法,所以取不同的初始点一般会 得到一个或多个局部最优解,然后再从这些局部最优解中 找出“全局”最优解.

Matlab设计与优化

Matlab设计与优化

MFamtilanbb设n计d与(优)化 语法

1. 一元函数无约束优化问题: min f(x) x1 x x2

常用格式如下:

(1)x= fminbnd (fun,x1,x2)

返回区间{x1,x2}上fun参数描述的标量函数的最小值x。

(2)x= fminbnd (fun,x1,x2 ,options)

在MATLAB优化工具箱函数中,有以下 两个函数用来求解上述问题:

Fminunc fminsearch

Matlab设计与优化

fminunc函数

功能:求多变量无约束函数的最小值。 语法格式: x = fminunc(fun,x0) x = fminunc(fun,x0,options) x = fminunc(fun,x0,options,P1,P2,...) [x,fval] = fminunc(...) [x,fval,exitflag] = fminunc(...) [x,fval,exitflag,output] = fminunc(...) [x,fval,exitflag,output,grad] = fminunc(...) [x,fval,exitflag,output,grad,hessian] = fminunc(...) 描述:

Matlab设计与优化

fminunc算法:

大型优化算法 若用户在fun函数中提供梯度信息,则缺省 时函数将选择大型优化算法,计算中的每一次迭代涉及到 用PCG法求解大型线性系统得到的近似解。

中型优化算法 此时fminunc函数的参数rgeScale 设置为'off'。该算法采用的是基于二次和三次混合插值一 维搜索法的BFGS拟牛顿法。该法通过BFGS公式来更新 Hessian矩阵。通过将HessUpdate参数设置为'dfp',可以 用DFP公式来求得Hessian矩阵逆的近似。通过将 HessUpdate参数设置为'steepdesc',可以用最速下降法来 更新Hessian矩阵。但一般不建议使用最速下降法。

fminsearch, fmincon, fminunc, optimset, inline

Matlab设计与优化

7.1.3 应用实例分析

例:容积最大化问题

对边长为5m的正方形钢板,在4个角处 剪去相等的正方形以制成方形无盖的容 器,问如何剪法使得容器的容积最大?

Matlab设计与优化

例2

在区间(0,2π)上求函数sin(x)的最小值: x = fminbnd(@sin,0,2*pi) x=