数据结构 栈十进制转八进制的算法详解(已测试过)

十进制转换为八进制的方法

十进制转换为八进制的方法十进制转换为八进制是数值计算中常见的操作之一,它将十进制表示的数值转换为八进制表示的数值。

八进制是一种基数为8的进位制数,采用0-7这8个数字来表示数值。

下面详细介绍十进制转换为八进制的方法:一、原理转换方法的基础原理是:十进制数值不断除以8,每除一次,取余数。

将按照求得的余数,从后向前依次写出,就是八进制表示的数值。

举例说明如下:将十进制数值63转换为八进制表示的数值,过程如下:- 第一步:63 ÷8 = 7...余5- 第二步:7 ÷8 = 0...余7- 第三步:从最后一步至第一步依次写下余数,即为75。

这样,十进制数值63就转换为了八进制表示的数值75。

二、步骤具体的十进制转换为八进制的步骤为:1.确定要转换的十进制数值;2.不断地用8去除十进制数值,直到商数为0,得到余数序列;3.将余数序列从后向前排列,得到八进制表示的数值。

三、举例以将十进制数值312转换为八进制表示的数值为例进行说明:(1)312 ÷8 = 39 ... 余0(2)39 ÷8 = 4 ... 余7(3)4 ÷8 = 0 ... 余4故应将十进制数值312转换为八进制表示的数值为0474。

四、注意事项在十进制转换为八进制的过程中,需注意以下事项:1.如果十进制数值是0,那么在转换为八进制形式时,直接写0即可;2.对于其他的十进制数值,余数只能是0~7之间的一个数字,因为八进制数系只包含这些数字;3.余数序列的写法与八进制表示的数值的读法是相反的,需要注意区分,不要误解;4.除法得到的小数部分需要忽略,只记录整数部分余数序列;5.若转换的数比较大,可以使用计算器或编程语言等工具来完成转换操作。

总结:以上就是十进制转换为八进制的方法,需要把要转换的十进制数不断地除以8,每次取余数,从后向前依次写出,就得到了八进制表示的数值。

具体使用的过程中需要注意余数的区间范围和序列的写法等问题。

十进制转换为八进制的方法

十进制转换为八进制的方法以十进制转换为八进制的方法为标题,写一篇文章在日常生活和计算机领域中,我们经常需要将十进制数转换为其他进制数以满足特定的需求。

其中,将十进制数转换为八进制数是一种常见的转换方式。

本文将介绍如何将十进制数转换为八进制数的方法。

我们需要了解十进制和八进制的概念。

十进制是我们常用的计数方式,使用0-9这十个数字来表示。

而八进制则使用0-7这八个数字来表示。

十进制数的一个特点是每一位上的权重都是10的幂次方。

而八进制数的一个特点是每一位上的权重都是8的幂次方。

接下来,我们以一个具体的例子来说明十进制转换为八进制的方法。

假设我们要将十进制数37转换为八进制数。

第一步,我们需要找到最大的8的幂次方,使得该幂次方小于或等于37。

在本例中,最大的8的幂次方为8^1,即8。

因为8^1=8,小于37。

第二步,我们将37除以8,得到商4和余数5。

其中,商代表了8进制数的最高位,而余数则代表了8进制数的最低位。

在本例中,商为4,余数为5。

第三步,我们将商继续除以8,得到商0和余数4。

同样地,商代表了8进制数的次高位,余数代表了次低位。

第四步,我们将上述的余数按照从下往上的顺序排列,得到最终的八进制数。

在本例中,37的八进制表示为54。

通过以上的步骤,我们成功地将十进制数37转换为八进制数54。

除了以上的方法,我们还可以通过不断除以8并记录余数的方式来进行转换。

具体步骤如下:1. 将十进制数不断除以8,直到商为0为止。

2. 每次除法运算得到的余数就是八进制数的一位。

3. 将得到的余数按照从下往上的顺序排列,即可得到最终的八进制数。

这种方法更加直观,可以一步步地得到八进制数的每一位。

除了将十进制数转换为八进制数,我们还可以将八进制数转换为十进制数。

具体方法如下:1. 将八进制数的每一位乘以8的幂次方,并相加。

2. 幂次方的起始值为0,对应八进制数的最低位。

3. 依次递增幂次方的值,直到计算完所有的位。

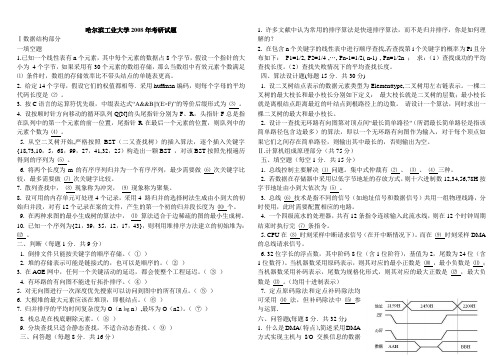

哈工大计算机考研真题2003-2008

哈尔滨工业大学2008年考研试题Ⅰ数据结构部分一填空题1.已知一个线性表有n个元素,其中每个元素的数据占8个字节,假设一个指针的大小为4个字节,如果采用有30个元素的数组存储,那么当数组中有效元素个数满足⑴条件时,数组的存储效率比不带头结点的单链表更高。

2. 给定14个字母,假设它们的权值都相等.采用huffman编码,则每个字母的平均代码长度是⑵。

3. 按C语言的运算符优先级,中缀表达式“A&&B||!(E>F)”的等价后缀形式为⑶。

4. 设按顺时针方向移动的循环队列Q[N]的头尾指针分别为F、R,头指针F总是指在队列中的第一个元素的前一位置,尾指针R在最后一个元素的位置,则队列中的元素个数为⑷。

5. 从空二叉树开始,严格按照BST(二又查找树)的插入算法,逐个插入关键字{18,73,10,5,68,99,27,41,32,25)构造出一颗BST ,对该BST按照先根遍历得到的序列为⑸。

6. 将两个长度为m的有序序列归并为一个有序序列,最少需要做⑹次关键字比较,最多需要做⑺次关键字比较。

7. 散列查找中,⑻现象称为冲突,⑼现象称为聚集。

8. 设可用的内存单元可处理4个记录,采用4 路归并的选择树法生成由小到大的初始归并段,对有12个记录在案的文件,产生的第一个初的归并段长度为⑽个。

9. 在两种求图的最小生成树的算法中,⑾算法适合于边稀疏的图的最小生成树。

10. 已知一个序列为{21,39,35,12,17,43},则利用堆排序方法建立的初始堆为:⑿。

二、判断(每题1分.共9分)1. 倒排文件只能按关键字的顺序存储。

(①)2. 堆的存储表示可能是链接式的,也可以是顺序的。

(②)3. 在AOE网中,任何一个关键活动的延迟,都会使整个工程延迟。

(③)4. 有环路的有向图不能进行拓扑排序。

(④)5. 对无向图进行一次深度优先搜索可以访问到图中的所有顶点。

(⑤)6. 大根堆的最大元素应该在堆顶,即根结点。

十进制转成八进制的方法

十进制转成八进制的方法要将十进制数转换为八进制数,需要了解十进制和八进制的基本概念以及具体的转换方法。

这篇文章将介绍十进制转八进制的原理、步骤和实例,并给出一些实用的指导意义。

一、十进制和八进制的基本概念十进制是我们日常生活中最常用的数字系统,使用0-9这10个数字来表示。

而八进制是一种较少使用的数字系统,使用0-7这8个数字来表示。

二、十进制转八进制的原理十进制转八进制的原理是将十进制数按照每次除以8的方式进行计算,直到商为0为止。

将每一次的余数从下往上排列,即可得到八进制数。

三、十进制转八进制的步骤1. 将给定的十进制数除以8,得到商和余数。

2. 将余数记录下来,并将商作为下一次计算的被除数。

3. 重复以上步骤,直到商为0。

4. 将所有的余数从下往上排列,即为转换后的八进制数。

四、实例演示假设我们需要将十进制数47转换为八进制数:1. 47 ÷ 8 = 5 ... 7。

将余数7记录下来。

2. 5 ÷ 8 = 0 ... 5。

将余数5记录下来。

3. 商为0,计算结束。

4. 将所有的余数从下往上排列,得到八进制数57。

即47(十进制)= 57(八进制)。

五、转换的指导意义1. 八进制数在计算机领域中得到广泛应用,因为计算机以二进制数为基础,八进制数可以更好地表示二进制数。

2. 十进制转八进制的方法通过除以8的方式非常简单易懂,是初学者入门的基础知识。

3. 对于需要频繁进行进制转换的人来说,掌握十进制转八进制的方法可以提高计算的效率。

4. 在解决一些特定问题时,八进制数的特性可以简化问题的计算和处理过程。

总结:本文介绍了十进制转八进制的基本概念、原理、步骤和实例,并指出了转换的指导意义。

掌握十进制转八进制的方法对于计算机领域的学习和实践都非常重要。

希望读者通过本文的介绍,能够对十进制转八进制有更深入的了解,并能够灵活运用于实际问题中。

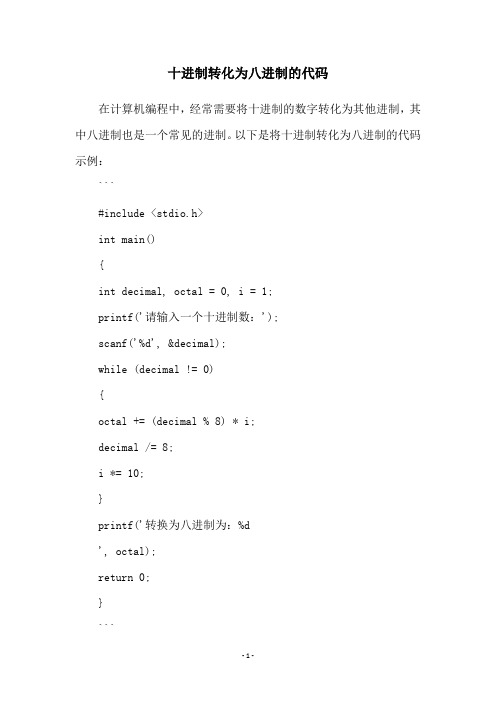

十进制转化为八进制的代码

十进制转化为八进制的代码

在计算机编程中,经常需要将十进制的数字转化为其他进制,其中八进制也是一个常见的进制。

以下是将十进制转化为八进制的代码示例:

```

#include <stdio.h>

int main()

{

int decimal, octal = 0, i = 1;

printf('请输入一个十进制数:');

scanf('%d', &decimal);

while (decimal != 0)

{

octal += (decimal % 8) * i;

decimal /= 8;

i *= 10;

}

printf('转换为八进制为:%d

', octal);

return 0;

}

```

以上代码首先要求用户输入一个十进制数,然后通过循环将该数转化为八进制。

具体实现中,通过不断取余数和整除来得到八进制数的每一位,并将其乘以相应的位数加到最终结果中。

最后,将转化后的八进制数输出到屏幕上。

数据结构课程设计进制转换

数据结构课程设计设计说明书进制转换的实现学生JUGG学号¥ #…班级Dota all star ------------------成绩___________ 优秀__________ 指导教师Puckdota科学与技术天灾元年3月14日数据结构课程设计评阅书Dota all star设计题目:___________________________ 进制转换的实现________________________________________________ 完成期限:自_天灾元年年二月J 日至_近卫戊年_年_______________________ 月J4 ______ 日共2周设计依据、要求及主要容(可另加附页):进制数制是人们利用符号进行计数的科学方法。

数制有很多种,在计算机中常用的数制有:十进制,二进制、八进制和十六进制。

十六进制数有两个基本特点:它由十六个字符0〜9以及A, B, C, D,E, F组成(它们分别表示十进制数0〜15),十六进制数运算规律是逢十六进一,例如:十六进制数4AC8 可写成(4AC8)16,或写成4AC8H要求:(1)输入一个十进制数N,将它转换成R进制数输出,并可以进行逆转换。

(2)输入数据包含多个测试实例,每个测试实例包含两个整数N(32位整数)和R (2<=R<=16,R<>10)。

(3)为每个测试实例输出转换后的数,每个输出占一行。

如果R大于10,则对应的数字规则参考16进制(比如,10用A表示,等等)。

(4)界面友好。

指导教师(签字):___________________ 教研室主任(签字):_________________________批准日期:年月日摘要由于数制计算和不同数制之间转换的需要,设计了一个10 进制转换其它进制(36 进制以)及逆转换的软件,该软件具有简单的将10进制数转换成2、8、16 进制数以及较复杂的高进制数的转换和逆转功能。

将十进制转换成八进制的方法

将十进制转换成八进制的方法嘿,朋友们!今天咱来唠唠怎么把十进制转成八进制。

这事儿啊,就好比你有一堆糖果,要把它们重新分组一样。

十进制嘛,咱平时用得可多啦,什么 10、20、100 呀,都是十进制的数。

那八进制呢,就是用 0 到 7 这几个数字来表示。

你想啊,十进制就像是走在一条直直的大道上,每走一段就是一个新的数。

而八进制呢,就像是走进了一个有八个房间的屋子,每个房间都有特定的意义。

那怎么转换呢?嘿嘿,这就有门道啦!咱可以用除法呀。

就拿一个十进制数来说吧,比如 50。

咱就用 50 除以 8,得到商是 6,余数是 2。

这时候,余数 2 就是八进制数的最后一位。

然后呢,把商 6 再除以 8,又得到商 0,余数 6。

那这个 6 就是八进制数的前面一位啦。

所以 50 转成八进制就是 62 呀!是不是挺有意思的?这就好像你分苹果,先把一堆苹果分成 8 份,剩下几个就是最后一位,然后再把分好的份数继续分,依次类推。

再比如说 100 吧,除以 8 得到商 12,余数 4,然后 12 除以 8 得到商1,余数 4,最后 1 除以 8 得到商 0,余数 1。

那 100 转成八进制就是 144 啦!哎呀呀,这转换过程就像是一场有趣的游戏,你得仔细算,可不能马虎哟!不然就像搭积木没搭稳,一下子就垮啦。

其实啊,学会了这个,你就掌握了一种神奇的魔法,可以在十进制和八进制的世界里自由穿梭。

你想想,当别人还在迷糊的时候,你已经能轻松转换啦,那多牛啊!而且呀,这在很多地方都有用呢。

比如在计算机编程里,八进制可是经常用到的哦。

你要是不懂这个,那可就有点跟不上节奏啦。

所以啊,朋友们,赶紧把这个小技巧学会吧,以后说不定啥时候就能派上大用场呢!让我们一起在数字的海洋里畅游,把十进制和八进制都玩得团团转!这多带劲呀!就这么着吧,大家快去试试吧!。

C语言顺序栈实现十进制转换为二进制,八进制,十六进制

运转结果:代码:#include <stdio.h>#include <stdlib.h>#define MAX 20typedef struct {int data[MAX];int top;}SeqStack;SeqStack* Init(){SeqStack *s;s = (SeqStack *)malloc(sizeof(SeqStack));s->top = -1;return s;}void Destroy(SeqStack *s){free(s);}bool IsFull(SeqStack *s){return (s->top == MAX - 1) ? true :false;}bool IsEmpty(SeqStack *s){return (s->top == -1) ? true :false;}void Push(SeqStack *s, int a){if (IsFull(s)){printf("The stack is full, failed to push!\n");return;}s->top++;s->data[s->top] =a;}int Pop(SeqStack *s){int e;if (IsEmpty(s)){printf("The stack is empty, failed to pop!\n");return NULL;}e = s->data[s->top]; s->top--;return e;}int ReadTop(SeqStack *s){return s->data[s->top];}void Print(SeqStack *s){int temp = s->top;if (IsEmpty(s)){printf("The stack is empty!\n");return;}printf(" 变换后的结果 :\n");while (temp >= 0){if (s->data[temp]<10)printf("%d ", s->data[temp]);else {if (s->data[temp] = 10)printf("a");else if (s->data[temp] = 11)printf("b");else if (s->data[temp] = 12)printf("c");else if (s->data[temp] = 13)printf("d");else if (s->data[temp] = 14)printf("e");else printf("f");}temp--;}printf("\n");}int main(){int m,c,d,n;SeqStack *s;s = Init();}printf(" 请输入要变换的十进制数:");scanf("%d", &m);printf("\n");printf(" 请输入变换进制:\n");printf("******************************\n");printf("* 请选择一个你要变换的进制*\n"); printf("*1. 二进制 *\n");printf("*2. 八进制 *\n");printf("*3. 十六进制 *\n");printf("******************************\n"); scanf("%d",&d);printf("\n");if (d == 1)n = 2;else if (d == 2)n = 8;else if (d == 3)n = 16;else printf(" 输入有误! ");while (m){c =m%n;m = m / n;Push(s, c);}Print(s);Destroy(s);。

1.将目标程序(.OBJ)转换成可执行文件(.EXE)的程序称为______。

1.将目标程序(.OBJ)转换成可执行文件(.EXE)的程序称为______。

A、编辑程序B、编译程序C、链接程序D、汇编程序将目标程序(.OBJ)转换成可执行文件(.EXE)的程序称为链接程序。

2.调制解调器(Modem)的功能是______。

A、将计算机的数字信号转换成模拟信号B、将模拟信号转换成计算机的数字信号C、将数字信号与模拟信号互相转换D、为了上网与接电话两不误调制解调器是实现数字信号和模拟信号转换的设备。

例如,当个人计算机通过电话线路连入Internet 网时,发送方的计算机发出的数字信号,要通过调制解调器换成模拟信号在电话网上传输,接收方的计算机则要通过调制解调器,将传输过来的模拟信号转换成数字信号。

3.下列说法中正确的是______。

A、计算机体积越大,功能越强B、微机CPU主频越高,其运算速度越快C、两个显示器的屏幕大小相同,它们的分辨率也相同D、激光打印机打印的汉字比喷墨打印机多主频是指在计算机系统中控制微处理器运算速度的时钟频率,它在很大程度上决定了微处理器的运算速度。

一般来说,主频越高,运算速度就越快。

4.若网络的各个节点均连接到同一条通信线路上,且线路两端有防止信号反射的装置,这种拓扑结构称为______。

A、总线型拓扑B、星型拓扑C、树型拓扑D、环型拓扑总线型拓扑的网络中各个结点由一根总线相连,数据在总线上由一个结点传向另一个结点。

5.一个完整的计算机软件应包含______。

A、系统软件和应用软件B、编辑软件和应用软件C、数据库软件和工具软件D、程序、相应数据和文档软件是指运行在计算机硬件上的程序、运行程序所需的数据和相关文档的总称。

6.下列叙述中,错误的是______。

A、硬盘在主机箱内,它是主机的组成部分B、硬盘属于外部存储器C、硬盘驱动器既可做输入设备又可做输出设备用D、硬盘与CPU之间不能直接交换数据硬盘、软盘和光盘存储器等都属于外部存储器,它们不是主机的组成部分。

十进制转八进制C++源代码

C++源代码文辑代码名称:十进制转换为八进制编程工具: Microsoft Visual C++ 6.0 作者:长风夜雨#define STACKINCREMENT 10;#define OVERFLOW 0#define OK 1#define ERROR 0typedefstruct{int *base;int *top;intstacksize;} SqStack;intInitStack (SqStack *S){// 构造一个空栈SS->base = (int *)malloc( 100 * sizeof(int));if (!S->base) return OVERFLOW; //存储分配失败S->top = S->base;S->stacksize = STACK_INIT_SIZE;return OK;};int Push (SqStack *S, int e){if (S->top - S->base >= S->stacksize) //栈满,追加存储空间{S->base = (int *) realloc( S->base,(S->stacksize + 10) *sizeof (int));if (!S->base) return OVERFLOW; //存储分配失败S->top = S->base + S->stacksize;S->stacksize += STACKINCREMENT;};*S->top++ = e;return OK;};int Pop (SqStack *S, int *e){ // 若栈不空,则删除S的栈顶元素,// 用e返回其值,并返回OK;// 否则返回ERRORif (S->top == S->base) return ERROR;*e = *--S->top;return OK;};boolStackEmpty(SqStack *S){if (S->top - S->base == 0){return 1;}else{return 0;};};void conversion (){SqStack S;int N, e;InitStack(&S);printf ( "Please input the num\n"); scanf ("%d",&N);while (N){Push(&S, N % 8);N = N/8;};while (!StackEmpty(&S)){Pop(&S, &e);printf ( "%d", e );};printf ( "\n");} // conversionvoid main(){conversion();}附:一个超低价虚拟业务联盟网站:http://xuni588.wdwd.co m。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验目的

建立栈实现十进制转八进制

实验内容

编程序并上机调试运行。

建立栈实现十进制转八进制

1.编写程序

//十进制转八进制

#include<stdio.h>

#include<stdlib.h>

#include<malloc.h>

#define STACK_INIT_SIZE 100

#define STACKINCREMENT 10

typedef struct {

int *base;

int *top;

int stacksize;

}sqstack;

int initstack (sqstack *s)

{s->base=(int *)malloc(STACK_INIT_SIZE * sizeof(int));

if(!s->base)

exit(0);

s->top=s->base;

s->stacksize =STACK_INIT_SIZE ;

return 0;

}//构造一个空栈s

int push(sqstack *s,int e)

{ if((s->top-s->base)>=s->stacksize){

s->base=(int*)realloc(s->base,(s->stacksize + STACKINCREMENT )*sizeof(int));

if(!(s->base)) exit(1);

s->top=s->base+s->stacksize;

s->stacksize+=STACKINCREMENT;

}

*s->top++=e;

return 0;

}//插入新的元素e为新的栈顶元素

int stackempty (sqstack *s)

{if(s->top==s->base)

return 1;

else return 0;

}//若栈s为空栈,则返回1,否则返回0

int pop (sqstack *s,int *e)

{if(s->top==s->base)

return 1;

*e=*--s->top;

return 0;

}//若栈不为空,则删除s的栈顶元素,用e返回其值,返回OK,否则返回ERROR

void conversion (int n)

{ sqstack s;

int e;

initstack(&s);

printf("请输入一个十进制数:\n");

scanf("%d",&n);

while (n){

push(&s,n%8);

n=n/8;

}

printf("\n");

printf("该数的八进制数为:\n");

while(!stackempty(&s)){

pop(&s,&e);

printf("%d",e);

}

printf("\n");

}//对于输入的任意一个非负十进制整数,打印出与其等值的八进制数int main()

{

int n;

//sqstack *s;

// initstack(s);

conversion (n);

return 0;

}//主函数

运行程序:

程序解析:

1.首先是将程序的开头写好,要有#include<stdlib.h>,然后定义STACK_INIT_SIZE 为100 ,STACKINCREMENT为10。

定义栈顶和栈底都为int型,并且stacksize为int型。

2.构建一个空栈。

建立一个空栈,但建立不成功是就强制退出,建立成功时就使栈顶和栈顶指向同一个点,并且分配预定长度的节给stacksize。

3.插入新的元素e为新的栈顶元素

插入一个新的元素到栈里,如果长度超过栈的长度,则重新分配新的空间给sqstack。

如果栈底部存在则发生错误,意外退出。

然后让e插入成为新的栈顶元素。

4.判断栈是否为空栈。

该函数用stackempty表示,如果栈顶等于栈底,则栈为空栈,返回1,否则返回0.

5.取出栈顶元素

若栈为空,则返回1,若栈不为空,则让e指向s的栈顶元素,删除s的栈顶元素,用e返回其值。

6.建立conversion函数

定义一个空栈s,然后scanf输入一个数,当该数不为0时,就执行push函数和n=n/8,如果n=0则跳出循环。

然后当栈不为空时,将栈顶一个一个取出,得到的为原十进制数的八进制数。

7.建立main函数。

这里的main函数只要三句话就够了。

定义n,和调用conversion函数,return 0.。